Kopieren von Daten aus einem HTTP-Endpunkt mit Azure Data Factory oder Azure Synapse Analytics

GILT FÜR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tipp

Testen Sie Data Factory in Microsoft Fabric, eine All-in-One-Analyselösung für Unternehmen. Microsoft Fabric deckt alle Aufgaben ab, von der Datenverschiebung bis hin zu Data Science, Echtzeitanalysen, Business Intelligence und Berichterstellung. Erfahren Sie, wie Sie kostenlos eine neue Testversion starten!

In diesem Artikel wird beschrieben, wie Sie die Kopieraktivität in Azure Data Factory und Azure Synapse Analytics verwenden, um Daten von einem HTTP-Endpunkt zu kopieren. Dieser Artikel baut auf dem Artikel zur Kopieraktivität auf, der eine allgemeine Übersicht über die Kopieraktivität enthält.

Die Unterschiede zwischen diesem HTTP-Connector, dem REST-Connector und dem Webtabellenconnector sind die folgenden:

- REST-Connector: Dieser unterstützt insbesondere das Kopieren von Daten aus RESTful-APIs.

- HTTP-Connector: Dieser dient allgemein dazu, Daten von jedem HTTP-Endpunkt abzurufen, z. B. um Dateien herunterzuladen. Solange der REST-Connector noch nicht verfügbar ist, verwenden Sie möglicherweise den HTTP-Connector, um Daten aus RESTful-APIs zu kopieren. Dieser wird unterstützt, umfasst jedoch weniger Funktionen als der REST-Connector.

- Webtabellenconnector: Dieser extrahiert Tabelleninhalte aus einer HTML-Webseite.

Unterstützte Funktionen

Für den HTTP-Connector werden die folgenden Funktionen unterstützt:

| Unterstützte Funktionen | IR |

|---|---|

| Kopieraktivität (Quelle/-) | ① ② |

| Lookup-Aktivität | ① ② |

① Azure Integration Runtime ② Selbstgehostete Integration Runtime

Eine Liste der Datenspeicher, die als Quellen/Senken unterstützt werden, finden Sie unter Unterstützte Datenspeicher.

Sie können diesen HTTP-Connector für die folgenden Aufgaben verwenden:

- Abrufen von Daten von einem HTTP/HTTPS-Endpunkt mithilfe der HTTP-Methoden GET oder POST.

- Abrufen von Daten mithilfe eines der folgenden Authentifizierungstypen: Anonym, Standard, Digest, Windows, Clientzertifikat.

- Kopieren der HTTP-Antwort im jeweiligen Zustand oder Analysieren der HTTP-Antwort mit den unterstützten Dateiformaten und Codecs für die Komprimierung.

Tipp

Um eine HTTP-Anforderung für den Datenabruf zu testen, bevor Sie den HTTP-Connector konfigurieren, informieren Sie sich über die API-Spezifikation für Header- und Textanforderungen. Sie können Tools wie Visual Studio, Invoke-RestMethod in PowerShell oder einen Webbrowser zum Überprüfen verwenden.

Voraussetzungen

Wenn sich Ihr Datenspeicher in einem lokalen Netzwerk, in einem virtuellen Azure-Netzwerk oder in einer virtuellen privaten Amazon-Cloud befindet, müssen Sie eine selbstgehostete Integration Runtime konfigurieren, um eine Verbindung herzustellen.

Handelt es sich bei Ihrem Datenspeicher um einen verwalteten Clouddatendienst, können Sie die Azure Integration Runtime verwenden. Ist der Zugriff auf IP-Adressen beschränkt, die in den Firewallregeln genehmigt sind, können Sie Azure Integration Runtime-IPs zur Positivliste hinzufügen.

Sie können auch das Feature managed virtual network integration runtime (Integration Runtime für verwaltete virtuelle Netzwerke) in Azure Data Factory verwenden, um auf das lokale Netzwerk zuzugreifen, ohne eine selbstgehostete Integration Runtime zu installieren und zu konfigurieren.

Weitere Informationen zu den von Data Factory unterstützten Netzwerksicherheitsmechanismen und -optionen finden Sie unter Datenzugriffsstrategien.

Erste Schritte

Sie können eines der folgenden Tools oder SDKs verwenden, um die Kopieraktivität mit einer Pipeline zu verwenden:

- Das Tool „Daten kopieren“

- Azure-Portal

- Das .NET SDK

- Das Python SDK

- Azure PowerShell

- Die REST-API

- Die Azure Resource Manager-Vorlage

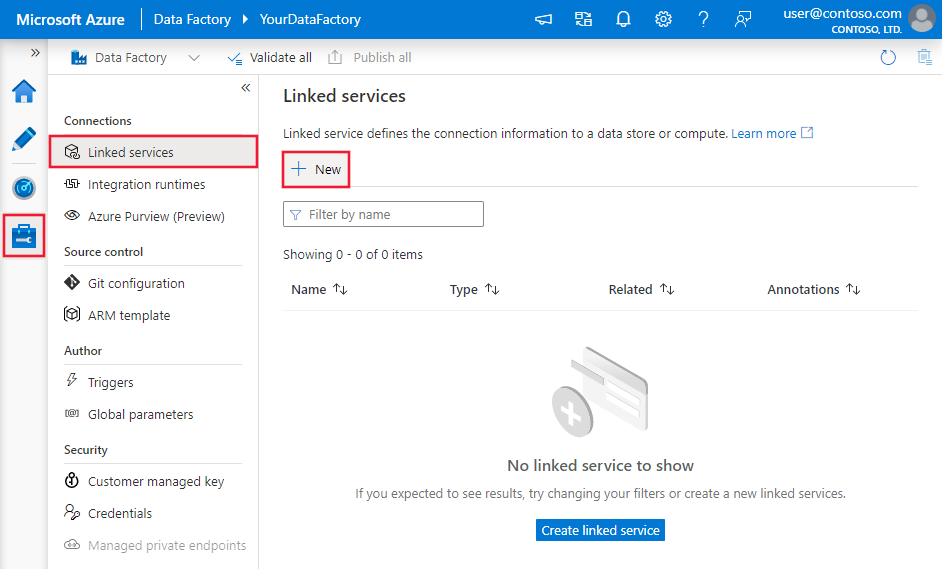

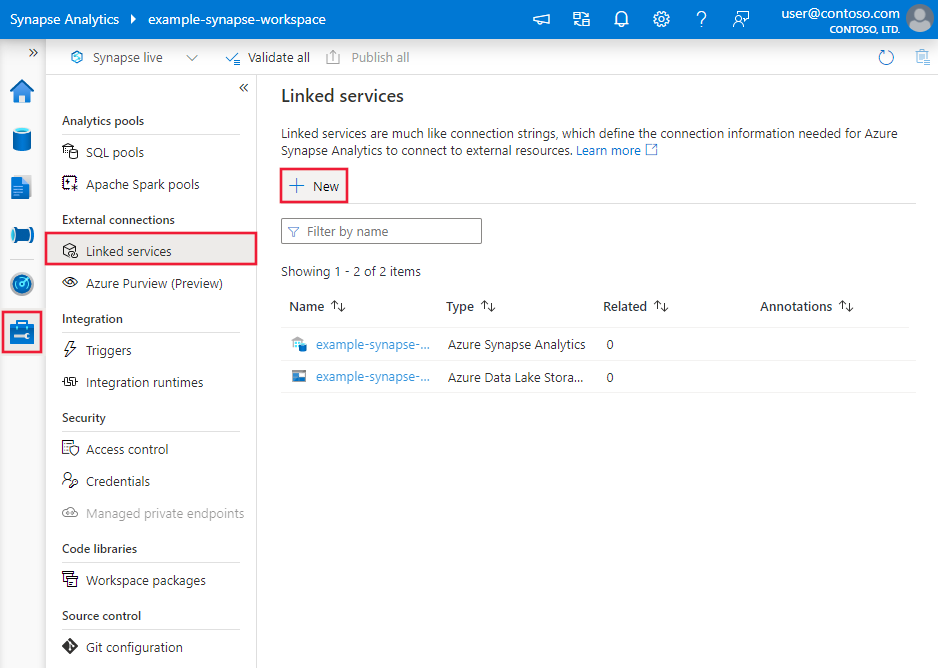

Erstellen eines verknüpften Diensts mit einer HTTP-Quelle über die Benutzeroberfläche

Verwenden Sie die folgenden Schritte, um einen verknüpften Dienst mit einer HTTP-Quelle auf der Azure-Portal Benutzeroberfläche zu erstellen.

Navigieren Sie in Ihrem Azure Data Factory- oder Synapse-Arbeitsbereich zu der Registerkarte „Verwalten“, wählen Sie „Verknüpfte Dienste“ aus und klicken Sie dann auf „Neu“:

Suchen Sie nach HTTP, und wählen Sie den HTTP-Connector aus.

Konfigurieren Sie die Dienstdetails, testen Sie die Verbindung, und erstellen Sie den neuen verknüpften Dienst.

Details zur Connector-Konfiguration

In den folgenden Abschnitten finden Sie Details zu den Eigenschaften, mit denen Sie die Entitäten definieren können, die spezifisch für den HTTP-Connector sind.

Eigenschaften des verknüpften Diensts

Folgende Eigenschaften werden für den mit HTTP verknüpften Dienst unterstützt:

| Eigenschaft | Beschreibung | Erforderlich |

|---|---|---|

| type | Die type-Eigenschaft muss auf HttpServer festgelegt werden. | Ja |

| url | Die Basis-URL zum Webserver. | Ja |

| enableServerCertificateValidation | Geben Sie an, ob die Überprüfung des TLS-/SSL-Zertifikats des Servers aktiviert werden soll, wenn eine Verbindung mit einem HTTP-Endpunkt hergestellt wird. Wenn der HTTPS-Server ein selbstsigniertes Zertifikat verwendet, legen Sie diese Eigenschaft auf FALSE fest. | Nein (der Standardwert ist TRUE) |

| authenticationType | Gibt den Authentifizierungstyp an. Zulässige Werte: Anonymous, Basic, Digest, Windows und ClientCertificate. Außerdem können Sie Authentifizierungsheader in der authHeader-Eigenschaft konfigurieren. Weitere Eigenschaften und JSON-Beispiele für diese Authentifizierungstypen, finden Sie in den Abschnitten, die auf diese Tabelle folgen. |

Ja |

| authHeaders | Zusätzliche HTTP-Anforderungsheader für die Authentifizierung. Wenn Sie beispielsweise die Authentifizierung mit einem API-Schlüssel verwenden möchten, können Sie als Authentifizierungstyp „Anonym“ auswählen und im Header den API-Schlüssel angeben. |

Nein |

| connectVia | Die Integration Runtime, die zum Herstellen einer Verbindung mit dem Datenspeicher verwendet werden soll. Weitere Informationen finden Sie im Abschnitt Voraussetzungen. Wenn keine Option angegeben ist, wird die standardmäßige Azure Integration Runtime verwendet. | Nein |

Verwenden der Authentifizierung des Typs „Basic“, „Digest“ oder „Windows“

Legen Sie die authenticationType-Eigenschaft auf Basic, Digest oder Windows fest. Geben Sie zusätzlich zu den im vorherigen Abschnitt beschriebenen generischen Eigenschaften die folgenden Eigenschaften an:

| Eigenschaft | Beschreibung | Erforderlich |

|---|---|---|

| userName | Der Benutzername, der für den Zugriff auf den HTTP-Endpunkt verwendet werden soll. | Ja |

| password | Das Kennwort für den Benutzer (der Wert userName). Markieren Sie dieses Feld als Typ SecureString, um es sicher zu speichern. Sie können auch auf ein Geheimnis verweisen, das in Azure Key Vault gespeichert ist. | Ja |

Beispiel

{

"name": "HttpLinkedService",

"properties": {

"type": "HttpServer",

"typeProperties": {

"authenticationType": "Basic",

"url" : "<HTTP endpoint>",

"userName": "<user name>",

"password": {

"type": "SecureString",

"value": "<password>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Verwenden der ClientCertificate-Authentifizierung

Um ClientCertificate-Authentifizierung zu verwenden, legen Sie die Eigenschaft authenticationType auf ClientCertificate fest. Geben Sie zusätzlich zu den im vorherigen Abschnitt beschriebenen generischen Eigenschaften die folgenden Eigenschaften an:

| Eigenschaft | Beschreibung | Erforderlich |

|---|---|---|

| embeddedCertData | Base64-codierte Zertifikatdaten. | Geben Sie embeddedCertData oder certThumbprint an. |

| certThumbprint | Der Fingerabdruck des Zertifikats, das im Zertifikatspeicher Ihres Computers für die selbstgehostete Integration Runtime installiert wurde. Ist nur anwendbar, wenn für die connectVia-Eigenschaft eine Integration Runtime vom Typ „selbstgehostet“ angegeben wird. | Geben Sie embeddedCertData oder certThumbprint an. |

| password | Das Kennwort, das dem Zertifikat zugeordnet ist. Markieren Sie dieses Feld als Typ SecureString, um es sicher zu speichern. Sie können auch auf ein Geheimnis verweisen, das in Azure Key Vault gespeichert ist. | Nein |

Wenn Sie certThumbprint für die Authentifizierung verwenden und das Zertifikat im persönlichen Speicher des lokalen Computers installiert wird, erteilen Sie der selbstgehosteten Integration Runtime Leseberechtigungen:

- Öffnen Sie die Microsoft Management Console (MMC). Fügen Sie das für Lokaler Computer vorgesehene Snap-In Zertifikate hinzu.

- Erweitern Sie Zertifikate>Persönlich, und wählen Sie dann Zertifikate aus.

- Klicken Sie im persönlichen Speicher mit der rechten Maustaste auf das Zertifikat, und wählen Sie dann Alle Aufgaben>Private Schlüssel verwalten aus.

- Fügen Sie auf der Registerkarte Sicherheit das Benutzerkonto hinzu, unter dem der Hostdienst der Integration Runtime (DIAHostService) mit Lesezugriff auf das Zertifikat ausgeführt wird.

- Der HTTP-Connector lädt nur vertrauenswürdige Zertifikate. Wenn Sie ein selbstsigniertes oder nicht von der integrierten Zertifizierungsstelle ausgestelltes Zertifikat verwenden, muss das Zertifikat auch in einem der folgenden Speicher installiert werden, um die Vertrauensstellung zu aktivieren:

- Vertrauenswürdige Personen

- Stammzertifizierungsstellen von Drittanbietern

- Trusted Root Certification Authorities

Beispiel 1: Verwenden von „certThumbprint“

{

"name": "HttpLinkedService",

"properties": {

"type": "HttpServer",

"typeProperties": {

"authenticationType": "ClientCertificate",

"url": "<HTTP endpoint>",

"certThumbprint": "<thumbprint of certificate>"

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Beispiel 2: Verwenden von „embeddedCertData“

{

"name": "HttpLinkedService",

"properties": {

"type": "HttpServer",

"typeProperties": {

"authenticationType": "ClientCertificate",

"url": "<HTTP endpoint>",

"embeddedCertData": "<Base64-encoded cert data>",

"password": {

"type": "SecureString",

"value": "password of cert"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Verwenden von Authentifizierungsheadern

Darüber hinaus können Sie neben den integrierten Authentifizierungstypen auch Anforderungsheader für die Authentifizierung konfigurieren.

Beispiel: Verwenden der Authentifizierung mit API-Schlüssel

{

"name": "HttpLinkedService",

"properties": {

"type": "HttpServer",

"typeProperties": {

"url": "<HTTP endpoint>",

"authenticationType": "Anonymous",

"authHeader": {

"x-api-key": {

"type": "SecureString",

"value": "<API key>"

}

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Dataset-Eigenschaften

Eine vollständige Liste mit den Abschnitten und Eigenschaften, die zum Definieren von Datasets zur Verfügung stehen, finden Sie im Artikel zu Datasets.

Azure Data Factory unterstützt die folgenden Dateiformate. Informationen zu formatbasierten Einstellungen finden Sie in den jeweiligen Artikeln.

- Avro-Format

- Binärformat

- Textformat mit Trennzeichen

- Excel-Format

- JSON-Format

- ORC-Format

- Parquet-Format

- XML-Format

Folgende Eigenschaften werden für HTTP unter den location-Einstellungen in formatbasierten Datasets unterstützt:

| Eigenschaft | Beschreibung | Erforderlich |

|---|---|---|

| type | Die „type“-Eigenschaft unter location im Dataset muss auf HttpServerLocation festgelegt werden. |

Ja |

| relativeUrl | Eine relative URL zu der Ressource, die die Daten enthält. Der HTTP-Connector kopiert Daten aus der kombinierten URL: [URL specified in linked service][relative URL specified in dataset]. |

Nein |

Hinweis

Die unterstützte Nutzlastgröße für HTTP-Anforderungen beträgt etwa 500 KB. Wenn die Nutzlast, die Sie an Ihre Webendpunkt übergeben möchten, größer als 500 KB ist, sollten Sie eine Aufteilung der Nutzlast in kleinere Blöcke erwägen.

Beispiel:

{

"name": "DelimitedTextDataset",

"properties": {

"type": "DelimitedText",

"linkedServiceName": {

"referenceName": "<HTTP linked service name>",

"type": "LinkedServiceReference"

},

"schema": [ < physical schema, optional, auto retrieved during authoring > ],

"typeProperties": {

"location": {

"type": "HttpServerLocation",

"relativeUrl": "<relative url>"

},

"columnDelimiter": ",",

"quoteChar": "\"",

"firstRowAsHeader": true,

"compressionCodec": "gzip"

}

}

}

Eigenschaften der Kopieraktivität

Dieser Abschnitt enthält eine Liste der Eigenschaften, die die HTTP-Quelle unterstützt.

Eine vollständige Liste mit den verfügbaren Abschnitten und Eigenschaften zum Definieren von Aktivitäten finden Sie unter Pipelines.

HTTP als Quelle

Azure Data Factory unterstützt die folgenden Dateiformate. Informationen zu formatbasierten Einstellungen finden Sie in den jeweiligen Artikeln.

- Avro-Format

- Binärformat

- Textformat mit Trennzeichen

- Excel-Format

- JSON-Format

- ORC-Format

- Parquet-Format

- XML-Format

Folgende Eigenschaften werden für HTTP unter den storeSettings-Einstellungen in der formatbasierten Kopierquelle unterstützt:

| Eigenschaft | Beschreibung | Erforderlich |

|---|---|---|

| type | Die „type“-Eigenschaft unter storeSettings muss auf HttpReadSettings festgelegt werden. |

Ja |

| requestMethod | Die HTTP-Methode. Zulässige Werte sind Get (Standardwert) und Post. |

Nein |

| additionalHeaders | Zusätzliche HTTP-Anforderungsheader | Nein |

| requestBody | Der Text der HTTP-Anforderung. | Nein |

| httpRequestTimeout | Das Timeout (der Wert TimeSpan) für die HTTP-Anforderung, um eine Antwort zu empfangen. Bei diesem Wert handelt es sich um das Timeout zum Empfangen einer Antwort, nicht um das Timeout zum Lesen von Antwortdaten. Der Standardwert ist 00:01:40. | Nein |

| maxConcurrentConnections | Die Obergrenze gleichzeitiger Verbindungen mit dem Datenspeicher während der Aktivitätsausführung. Geben Sie diesen Wert nur an, wenn Sie die Anzahl der gleichzeitigen Verbindungen begrenzen möchten. | Nein |

Beispiel:

"activities":[

{

"name": "CopyFromHTTP",

"type": "Copy",

"inputs": [

{

"referenceName": "<Delimited text input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "DelimitedTextSource",

"formatSettings":{

"type": "DelimitedTextReadSettings",

"skipLineCount": 10

},

"storeSettings":{

"type": "HttpReadSettings",

"requestMethod": "Post",

"additionalHeaders": "<header key: header value>\n<header key: header value>\n",

"requestBody": "<body for POST HTTP request>"

}

},

"sink": {

"type": "<sink type>"

}

}

}

]

Eigenschaften der Lookup-Aktivität

Ausführliche Informationen zu den Eigenschaften finden Sie unter Lookup-Aktivität.

Legacy-Modelle

Hinweis

Die folgenden Modelle werden aus Gründen der Abwärtskompatibilität weiterhin unverändert unterstützt. Es wird jedoch empfohlen, in Zukunft das in den obigen Abschnitten erwähnte neue Modell zu verwenden, da das neue Modell nun von der Benutzeroberfläche für die Dokumenterstellung generiert wird.

Legacy-Datasetmodell

| Eigenschaft | Beschreibung | Erforderlich |

|---|---|---|

| type | Die type-Eigenschaft des Datasets muss auf HttpFile festgelegt werden. | Ja |

| relativeUrl | Eine relative URL zu der Ressource, die die Daten enthält. Wenn die Eigenschaft nicht angegeben ist, wird nur die URL verwendet, die in der Definition des verknüpften Diensts angegeben ist. | Nein |

| requestMethod | Die HTTP-Methode. Zulässige Werte sind Get (Standardwert) und Post. | Nein |

| additionalHeaders | Zusätzliche HTTP-Anforderungsheader | Nein |

| requestBody | Der Text der HTTP-Anforderung. | Nein |

| format | Wenn Sie Daten vom HTTP-Endpunkt im vorliegenden Zustand abrufen möchten, ohne diese analysieren und in einen dateibasierten Speicher kopieren zu müssen, überspringen Sie den Abschnitt format in den Definitionen des Eingabe- und Ausgabedatasets. Wenn der HTTP-Antwortinhalt während des Kopierens analysiert werden soll, werden die folgenden Dateiformattypen unterstützt: TextFormat, JsonFormat, AvroFormat, OrcFormat und ParquetFormat. Legen Sie die type-Eigenschaft unter format auf einen dieser Werte fest. Weitere Informationen finden Sie unter JSON-Format, Textformat, Avro-Format, Orc-Format und Parquet-Format. |

Nein |

| compression | Geben Sie den Typ und den Grad der Komprimierung für die Daten an. Weitere Informationen finden Sie unter Unterstützte Dateiformate und Codecs für die Komprimierung. Unterstützte Typen: GZip, Deflate, BZip2 und ZipDeflate. Folgende Ebenen werden unterstützt: Optimal und Fastest. |

Nein |

Hinweis

Die unterstützte Nutzlastgröße für HTTP-Anforderungen beträgt etwa 500 KB. Wenn die Nutzlast, die Sie an Ihre Webendpunkt übergeben möchten, größer als 500 KB ist, sollten Sie eine Aufteilung der Nutzlast in kleinere Blöcke erwägen.

Beispiel 1: Verwenden der Get-Methode (Standard)

{

"name": "HttpSourceDataInput",

"properties": {

"type": "HttpFile",

"linkedServiceName": {

"referenceName": "<HTTP linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"relativeUrl": "<relative url>",

"additionalHeaders": "Connection: keep-alive\nUser-Agent: Mozilla/5.0\n"

}

}

}

Beispiel 2: Verwenden der POST-Methode

{

"name": "HttpSourceDataInput",

"properties": {

"type": "HttpFile",

"linkedServiceName": {

"referenceName": "<HTTP linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"relativeUrl": "<relative url>",

"requestMethod": "Post",

"requestBody": "<body for POST HTTP request>"

}

}

}

Legacy-Kopieraktivität: Quellenmodell

| Eigenschaft | Beschreibung | Erforderlich |

|---|---|---|

| type | Die type-Eigenschaft der Quelle der Kopieraktivität muss auf HttpSource festgelegt werden. | Ja |

| httpRequestTimeout | Das Timeout (der Wert TimeSpan) für die HTTP-Anforderung, um eine Antwort zu empfangen. Bei diesem Wert handelt es sich um das Timeout zum Empfangen einer Antwort, nicht um das Timeout zum Lesen von Antwortdaten. Der Standardwert ist 00:01:40. | Nein |

Beispiel

"activities":[

{

"name": "CopyFromHTTP",

"type": "Copy",

"inputs": [

{

"referenceName": "<HTTP input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "HttpSource",

"httpRequestTimeout": "00:01:00"

},

"sink": {

"type": "<sink type>"

}

}

}

]

Zugehöriger Inhalt

Eine Liste der Datenspeicher, die die Kopieraktivität als Quellen und Senken unterstützt, finden Sie unter Unterstützte Datenspeicher und Formate.