Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Dieser Artikel hilft Ihnen, einen hierarchischer Namespace zu aktivieren und Funktionen wie Sicherheit auf Datei- und Verzeichnisebene und schnellere Vorgänge zu nutzen. Diese Funktionen werden häufig in Big Data-Analyseworkloads verwendet und zusammen als Azure Data Lake Storage bezeichnet.

Weitere Informationen zu diesen Funktionen und zur Bewertung der Auswirkungen dieses Upgrades auf Workloads, Anwendungen, Kosten, Dienstintegrationen, Tools, Funktonen und Dokumentation finden Sie unter Upgraden von Azure Blob Storage mit Azure Data Lake Storage-Funktionen.

Wichtig

Ein Upgrade ist eine unidirektionale Aktion. Nachdem Sie das Upgrade durchgeführt haben, gibt es keine Möglichkeit, Ihr Konto wiederherzustellen. Wir empfehlen Ihnen, das Upgrade in einer Nichtproduktionsumgebung zu testen.

Vorbereiten des Upgrades

So bereiten Sie ein Upgrade Ihres Speicherkontos auf Data Lake Storage vor

Überprüfen der Featureunterstützung

Ihr Speicherkonto ist möglicherweise für die Verwendung von Features konfiguriert, die in Data Lake Storage-fähigen Konten noch nicht unterstützt werden. Wenn Ihr Konto solche Features verwendet, besteht das Upgrade den Validierungsschritt nicht. Informationen zum Identifizieren nicht unterstützter Features finden Sie im Artikel Unterstützung von Blob-Storage-Funktionen in Azure Storage-Konten. Wenn Sie solche Features in Ihrem Konto verwenden, deaktivieren Sie sie, bevor Sie mit dem Upgrade beginnen.

Die folgenden Features werden für Data Lake Storage-Konten, aber nicht vom Upgradeprozess unterstützt:

- Blobmomentaufnahmen

- Verschlüsselungsbereiche

- Unveränderlicher Speicher

- Vorläufiges Löschen für Blobs

- Vorläufiges Löschen für Container

Wenn für Ihr Speicherkonto solche Features aktiviert sind, müssen Sie sie vor dem Upgrade deaktivieren. Wenn Sie die Verwendung der Features nach Abschluss des Upgrades fortsetzen möchten, aktivieren Sie sie wieder.

In einigen Fällen müssen Sie Zeit für Bereinigungsvorgänge einplanen, nachdem ein Feature vor dem Upgrade deaktiviert wurde. Ein Beispiel ist das Feature zum vorläufigen Löschen von Blobs. Sie müssen das vorläufige Löschen von Blobs deaktivieren und dann alle vorläufig gelöschten Blobs ablaufen lassen, bevor Sie ein Upgrade für das Konto ausführen.

Entfernen von Seitenblobs aus dem Speicherkonto

Sie können kein Speicherkonto upgraden, das Seitenblobs enthält. Vergewissern Sie sich, dass alle Seitenblobs aus dem Speicherkonto entfernt wurden, bevor Sie das Upgrade ausführen.

Sicherstellen, dass die Segmente jedes Blobpfads benannt sind

Der Migrationsprozess erstellt ein Verzeichnis für jedes Pfadsegment eines Blobs. Data Lake Storage-Verzeichnisse müssen einen Namen haben. Daher muss für eine erfolgreiche Migration jedes Pfadsegment in einem virtuellen Verzeichnis einen Namen aufweisen. Die gleiche Anforderung gilt für Segmente, die nur mit einem Leerzeichen benannt werden. Wenn alle Pfadsegmente entweder unnamed (//) oder nur mit einem Leerzeichen (_) benannt sind, müssen Sie diese Blobs vor der Migration in einen neuen Pfad kopieren, der diesen Benennungsanforderungen entspricht.

Verhindern von Schreibaktivitäten im Speicherkonto

Beim Upgrade kann ein Fehler auftreten, wenn eine Anwendung während des Upgrades in das Speicherkonto schreibt. So verhindern Sie eine solche Schreibaktivität

Versetzen Sie alle Anwendungen oder Dienste in einen inaktiven Status, die Schreibvorgänge durchführen könnten.

Geben Sie bestehende Leases für Container und Blobs im Speicherkonto frei oder lösen Sie sie auf.

Nachdem das Upgrade abgeschlossen ist, unterbrechen Sie die von Ihnen erstellten Leases, um den Schreibzugriff auf die Container und Blobs fortzusetzen.

Warnung

Das Unterbrechen einer aktiven Lease ohne ordnungsgemäße Deaktivierung von Anwendungen oder virtuellen Computern, die derzeit auf diese Ressourcen zugreifen, kann zu unerwarteten Ergebnissen führen. Stellen Sie sicher, dass Sie alle aktuellen Schreibaktivitäten in einen inaktiven Status versetzen, bevor Sie aktuelle Leases unterbrechen.

Nehmen Sie alle geplanten Änderungen an den Namen archivierter Blobs vor

Wenn Sie beabsichtigen, den Namen eines archivierten Blobs oder eines übergeordneten Verzeichnisses zu ändern, das zum archivierten Blob führt, nehmen Sie diese Änderungen vor dem Upgrade vor. Wenn Sie den Namen eines archivierten Blobs oder eines übergeordneten Verzeichnisses ändern, das nach dem Upgrade zum archivierten Blob führt, können Sie ihn nicht rehydratisieren. Dies ist eine temporäre Einschränkung der aktuellen Version.

Durchführen des Upgrades

Melden Sie sich zunächst beim Azure-Portal an.

Suchen Sie nach Ihrem Speicherkonto, und zeigen Sie die Kontoübersicht an.

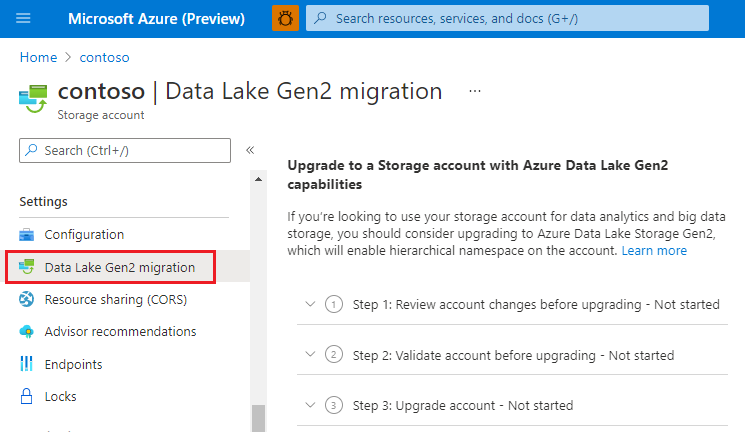

Wählen Sie Data Lake Gen2-Migration aus.

Die Konfigurationsseite Upgrade auf ein Speicherkonto mit Azure Data Lake Gen2-Funktionen wird angezeigt.

Erweitern Sie den Abschnitt Schritt 1: Überprüfen von Kontoänderungen vor dem Upgrade und klicken Sie auf Änderungen überprüfen und zustimmen.

Aktivieren Sie auf der Seite Kontoänderungen überprüfen das Kontrollkästchen, und klicken Sie dann auf Änderungen zustimmen.

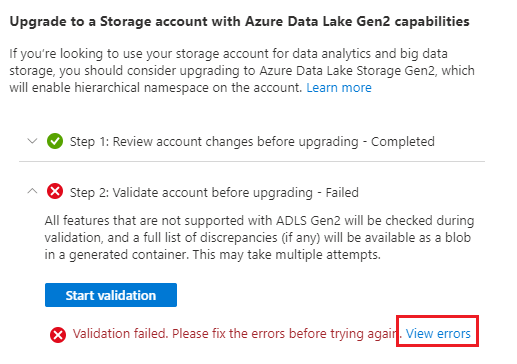

Erweitern Sie den Abschnitt Schritt 2: Überprüfen des Kontos vor dem Upgrade und klicken Sie dann auf Überprüfung starten.

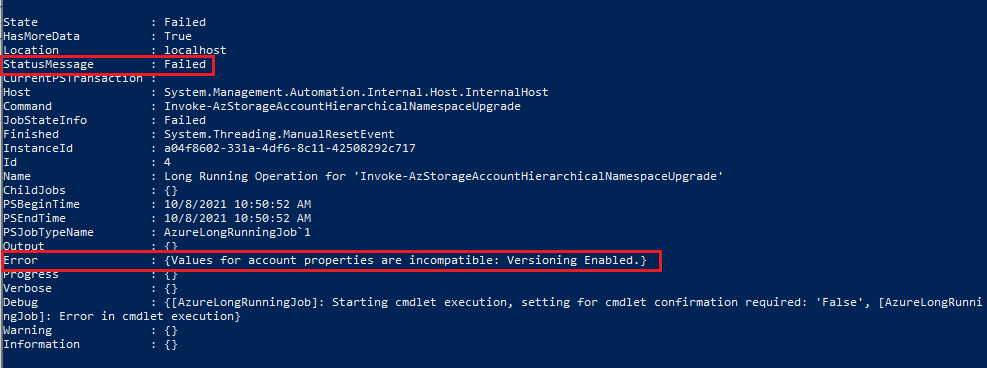

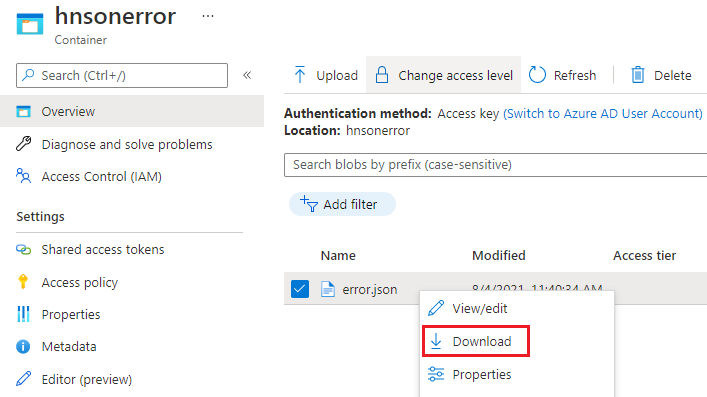

Wenn bei der Überprüfung ein Fehler auftritt, wird auf der Seite ein Fehler angezeigt. In einigen Fällen wird ein Link Fehler anzeigen angezeigt. Wenn dieser Link angezeigt wird, wählen Sie ihn aus.

Wählen Sie dann im Kontextmenü der Datei error.json die Option Herunterladenaus.

Öffnen Sie die heruntergeladene Datei, um zu ermitteln, warum der Überprüfungsschritt für das Konto nicht erfolgreich war. Der folgende JSON-Code gibt an, dass eine inkompatibles Funktion für das Konto aktiviert ist. In diesem Fall würden Sie die Funktion deaktivieren und dann den Überprüfungsprozess erneut starten.

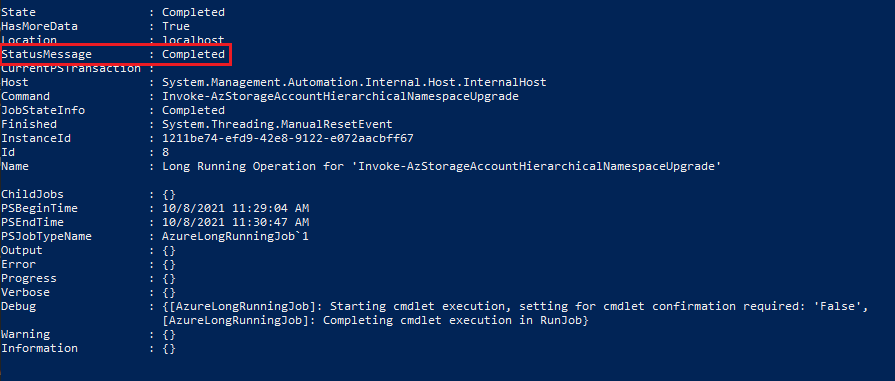

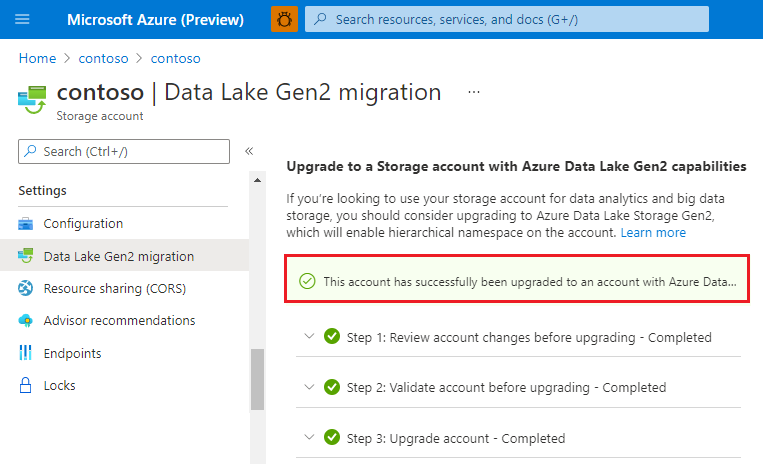

{ "startTime": "2021-08-04T18:40:31.8465320Z", "id": "45c84a6d-6746-4142-8130-5ae9cfe013a0", "incompatibleFeatures": [ "Blob Delete Retention Enabled" ], "blobValidationErrors": [], "scannedBlobCount": 0, "invalidBlobCount": 0, "endTime": "2021-08-04T18:40:34.9371480Z" }Nachdem Ihr Konto erfolgreich überprüft wurde, erweitern Sie den Abschnitt Schritt 3: Upgradekonto und klicken Sie dann auf Upgrade starten.

Wichtig

Schreibvorgänge sind während des Upgrades Ihres Kontos deaktiviert. Lesevorgänge sind nicht deaktiviert, aber wir empfehlen dringend, dass Sie Lesevorgänge anhalten, da diese den Upgrade-Prozess destabilisieren könnten.

Wenn die Migration erfolgreich abgeschlossen wurde, wird eine Meldung ähnlich der folgenden angezeigt.

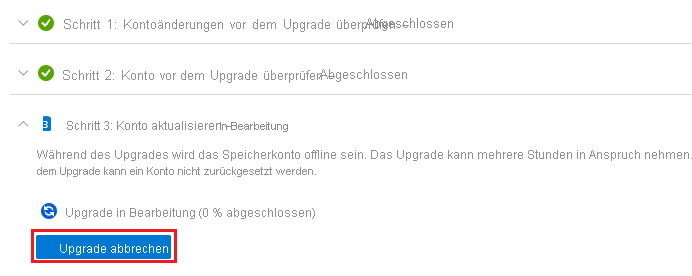

Abbrechen des Upgrades

Sie können die Migration beenden, bevor sie abgeschlossen ist.

Um das Upgrade zu beenden, bevor es abgeschlossen ist, wählen Sie Upgrade abbrechen aus, während das Upgrade ausgeführt wird.

Migrieren von Daten, Workloads und Anwendungen

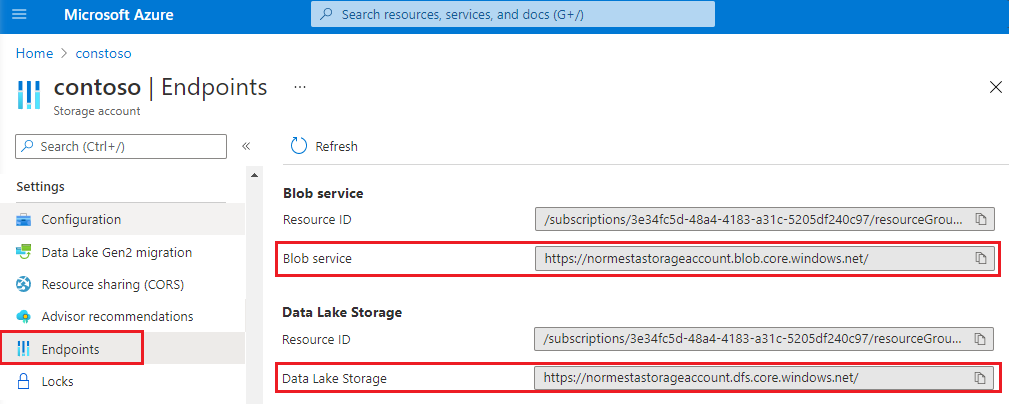

Konfigurieren Sie die Dienste in Ihren Workloads so, dass sie entweder auf den Blob-Dienstendpunkt oder den Data Lake Storage-Endpunkt verweisen.

Stellen Sie sicher, das Hadoop-Workloads, die den Windows Azure Storage Blob-Treiber oder den WASB-Treiber verwenden, so geändert werden, dass sie den Azure Blob File System (ABFS)-Treiber verwenden. Anders als der WASB-Treiber, der Anforderungen an den Endpunkt des Blob-Dienstes stellt, stellt der ABFS-Treiber Anforderungen an den Data Lake Storage-Endpunkt Ihres Kontos.

Testen Sie die benutzerdefinierten Anwendungen, um sicherzustellen, dass sie wie erwartet mit Ihrem aktualisierten Konto funktionieren.

Der Zugriff mit mehreren Protokollen auf Data Lake Storage ermöglicht es den meisten Anwendungen, Blob-APIs weiterhin ohne Änderungen zu verwenden. Wenn Probleme auftreten oder Sie APIs verwenden möchten, um mit Verzeichnisvorgängen und ACLs zu arbeiten, sollten Sie einen Teil Ihres Codes verschieben, um Data Lake Storage-APIs zu verwenden. Weitere Informationen finden Sie in den Anleitungen für .NET, Java, Python, Node.js und REST.

Testen Sie alle benutzerdefinierten Skripts, um sicherzustellen, dass sie wie erwartet mit Ihrem aktualisierten Konto funktionieren.

Wie bei Blob-APIs funktionieren viele Ihrer Skripts wahrscheinlich, ohne dass Sie sie ändern müssen. Aktualisieren Sie Skripts aber bei Bedarf für die Verwendung der PowerShell-Cmdlets und Azure CLI-Befehle für Data Lake Storage.