Artikulierte Hand und Eye Tracking in Unity

HoloLens 2 hat einige neue und spannende Funktionen eingeführt, z. B. Artikulierte Hand und Eye Tracking.

Die einfachste Möglichkeit, die neue Funktion in Unity zu nutzen, ist MRTK. Es gibt auch einige Beispielszenen, die Ihnen bei den ersten Schritten helfen.

Bausteine, die Hände, Augen und andere in MRTK unterstützen

MRTK v2 bietet eine Reihe von UI-Steuerelementen und Bausteinen, mit denen Sie Ihre Entwicklung beschleunigen können.

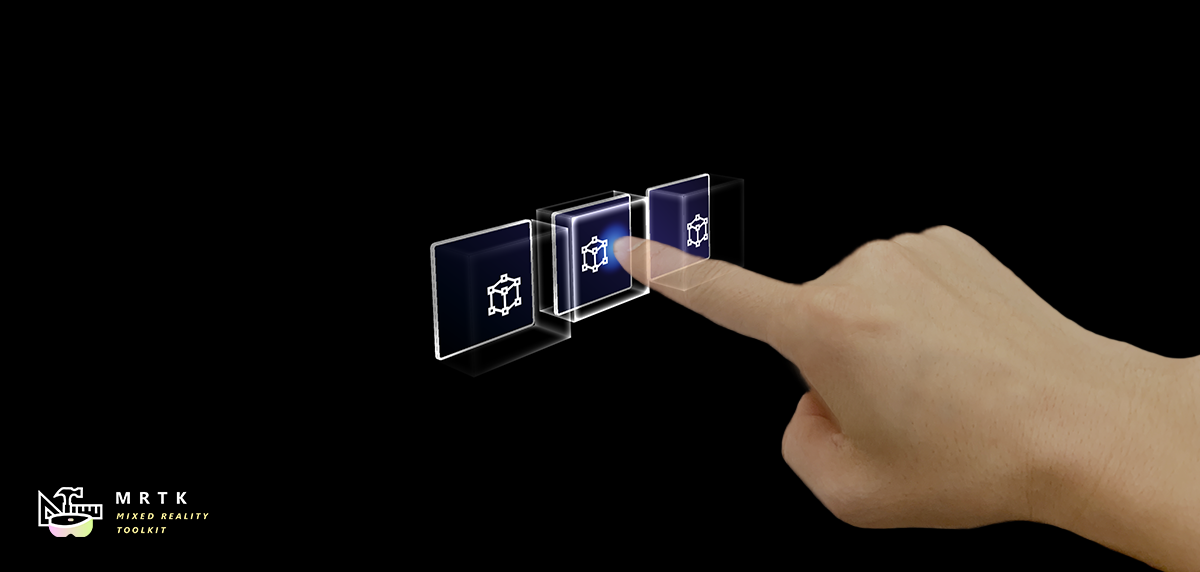

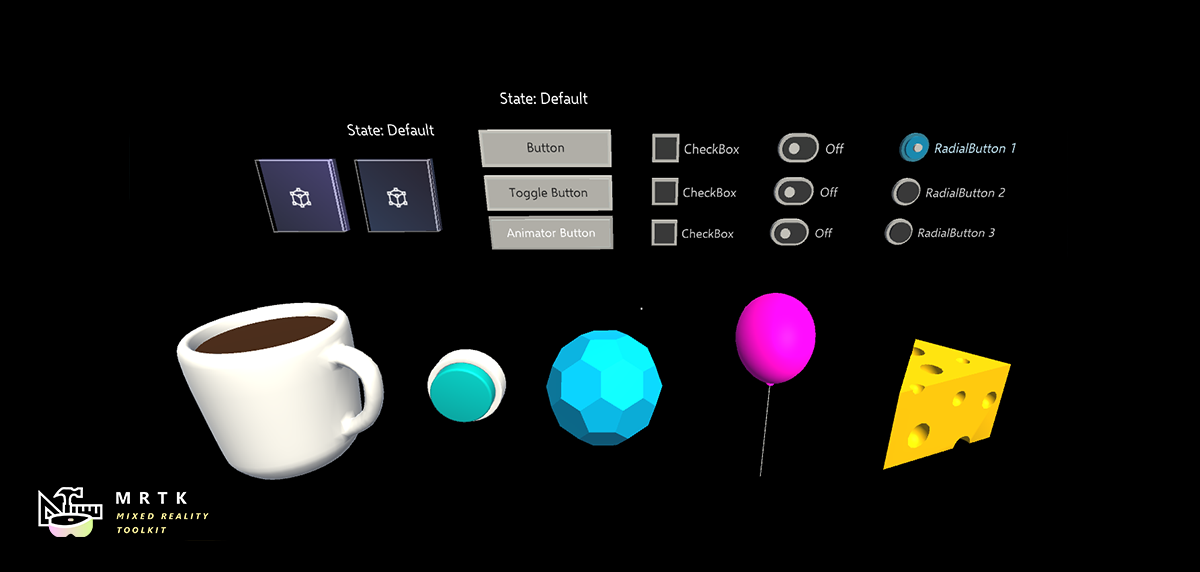

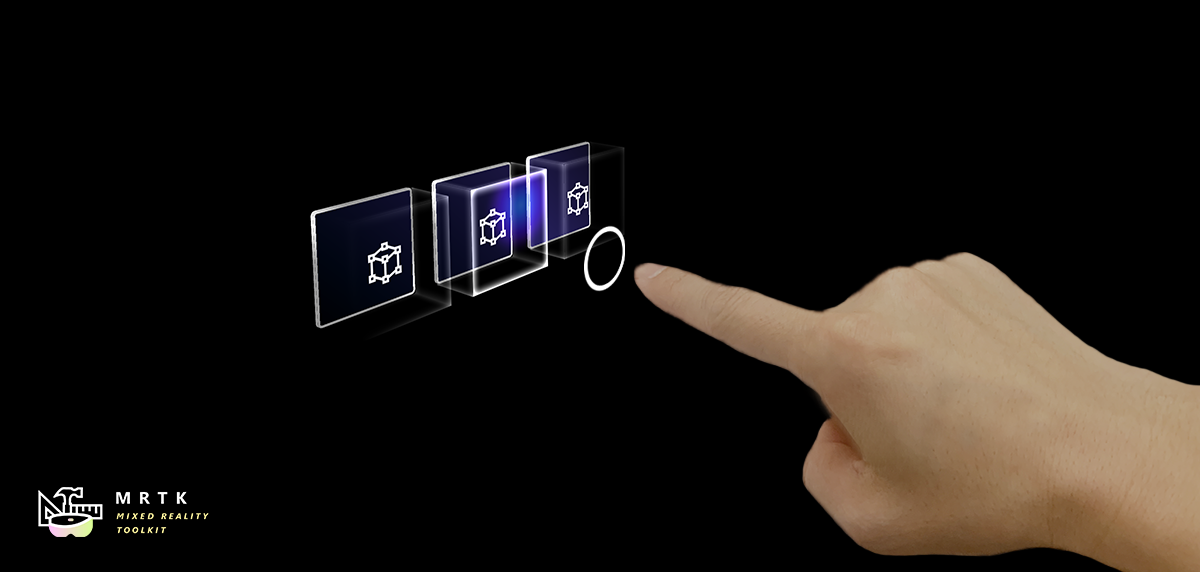

Knopf Knopf |

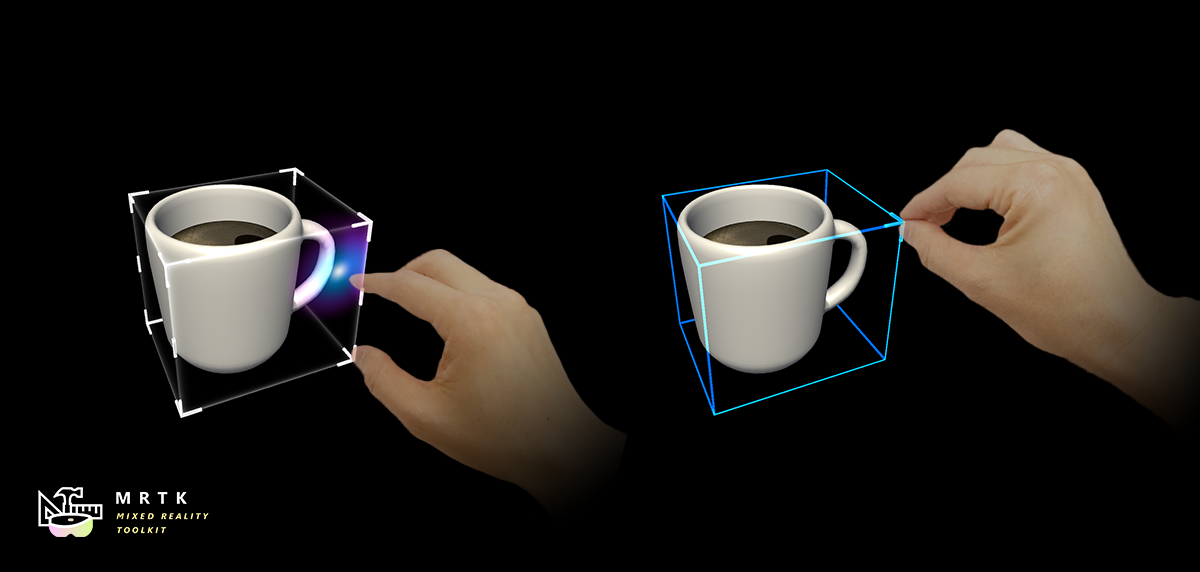

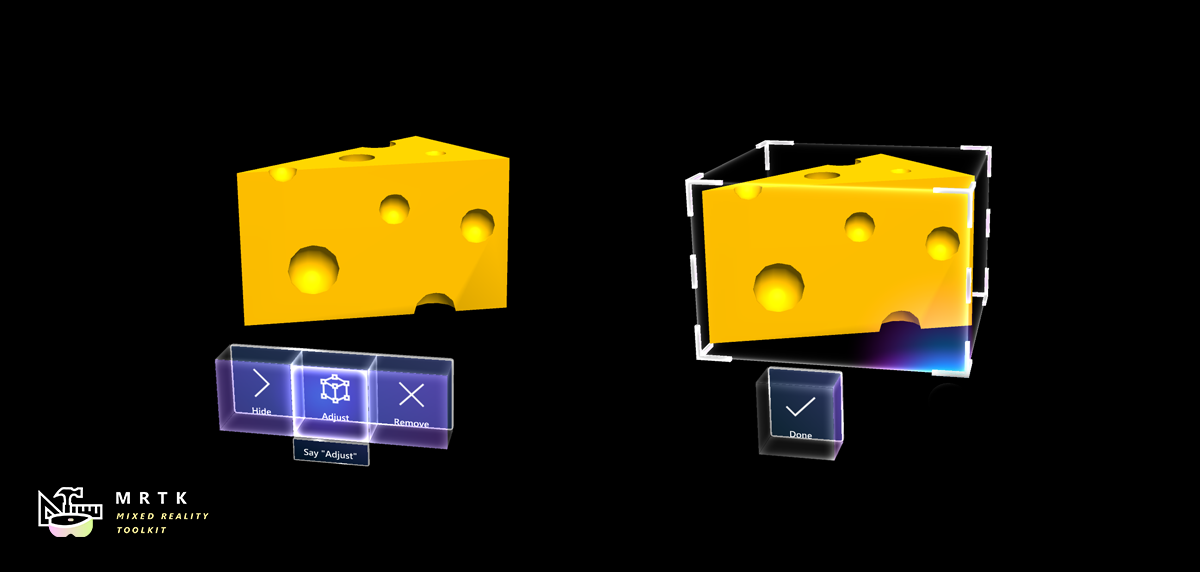

Begrenzungsrahmen Begrenzungsrahmen |

Manipulationshandler Manipulationshandler |

|---|---|---|

| Ein Schaltflächensteuerelement, das verschiedene Eingabemethoden unterstützt, einschließlich der handgelenkten Hand von HoloLens2 | Standard Benutzeroberfläche zum Bearbeiten von Objekten im 3D-Raum | Skript zum Manipulieren von Objekten mit einer oder zwei Händen. |

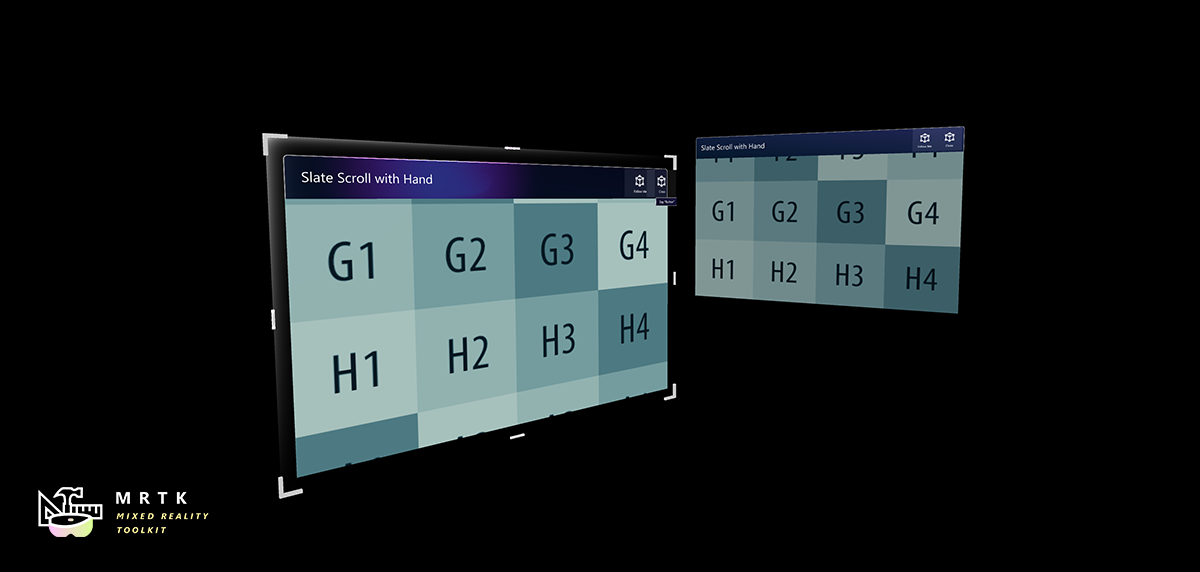

Schiefer Schiefer |

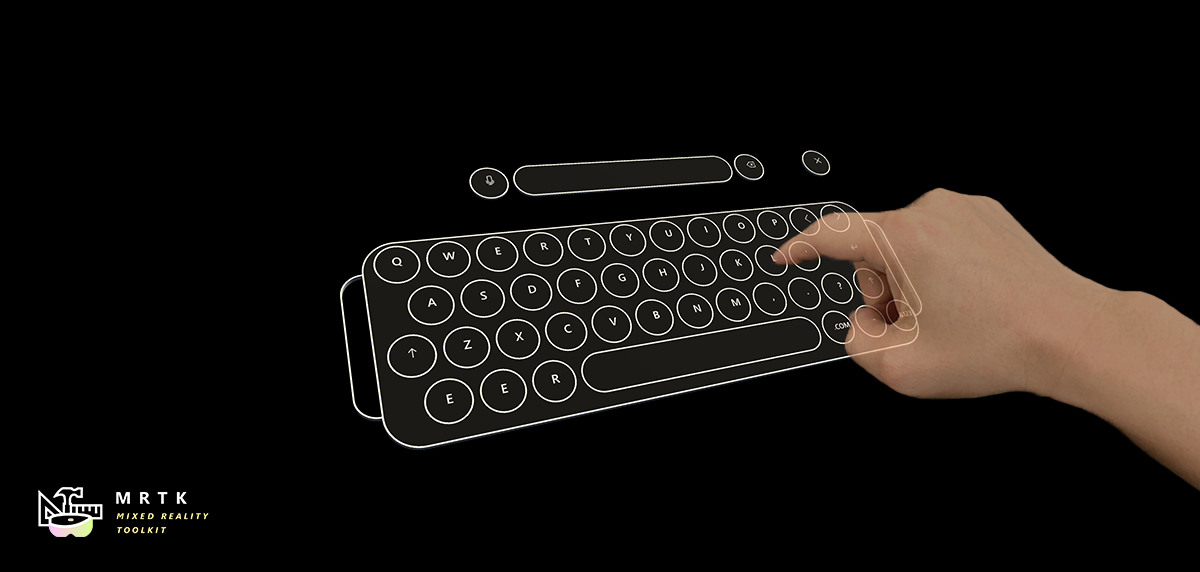

Systemtastatur Systemtastatur |

Interagierbar Interagierbar |

| 2D-Formatebene, die das Scrollen mit gestikulierter Handeingabe unterstützt | Beispielskript für die Verwendung der Systemtastatur in Unity | Ein Skript, um Objekte interaktionsfähig zu machen, mit visuellen Zuständen und Designunterstützung. |

Löser Löser |

Object-Auflistung Object-Auflistung |

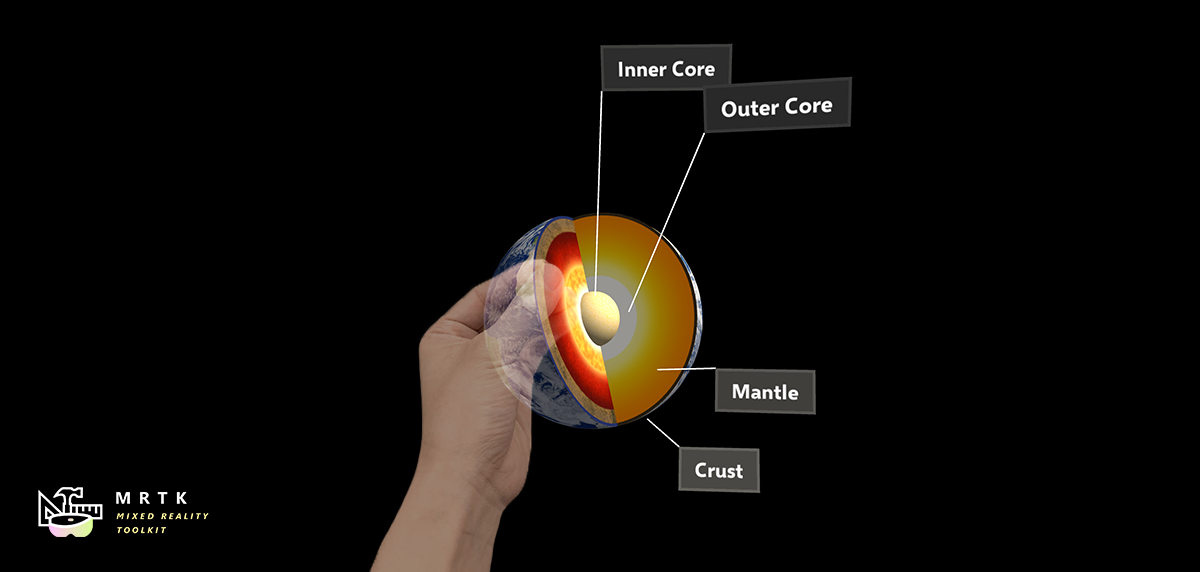

Quickinfo Quickinfo |

| Verschiedene Objektpositionierungsverhalten wie Tag-Entlang, Body-Lock, Konstante Ansichtsgröße und Oberflächenmagnetismus | Skript für das Layout eines Arrays von Objekten in einer dreidimensionalen Form | Anmerkungs-UI mit flexiblem Anker-/Pivotsystem, das zum Bezeichnen von Bewegungscontrollern und Objekten verwendet werden kann. |

App-Leiste App-Leiste |

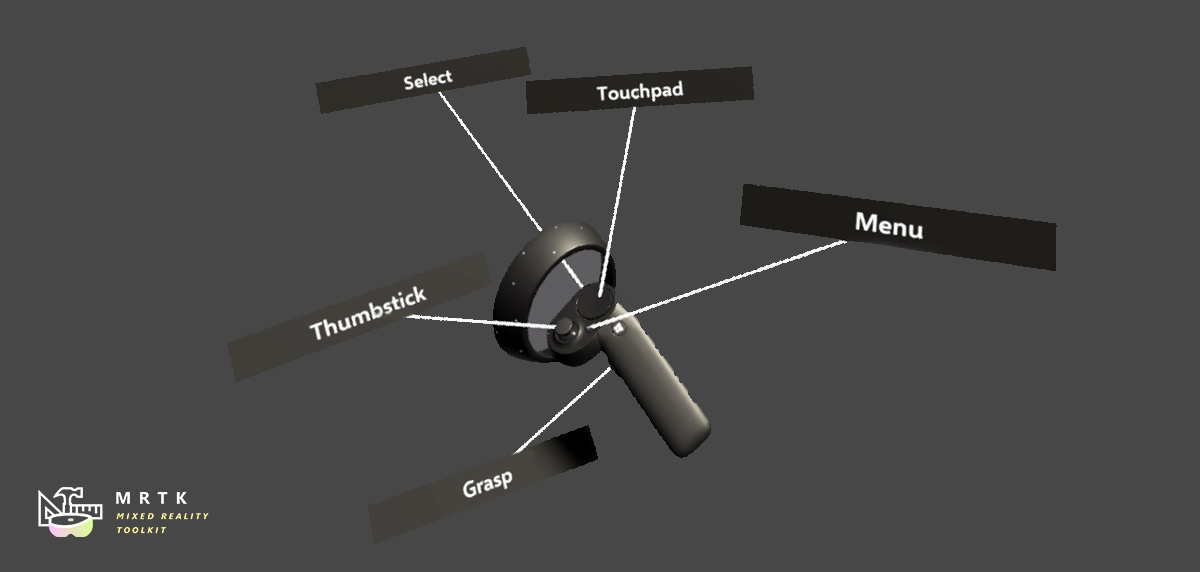

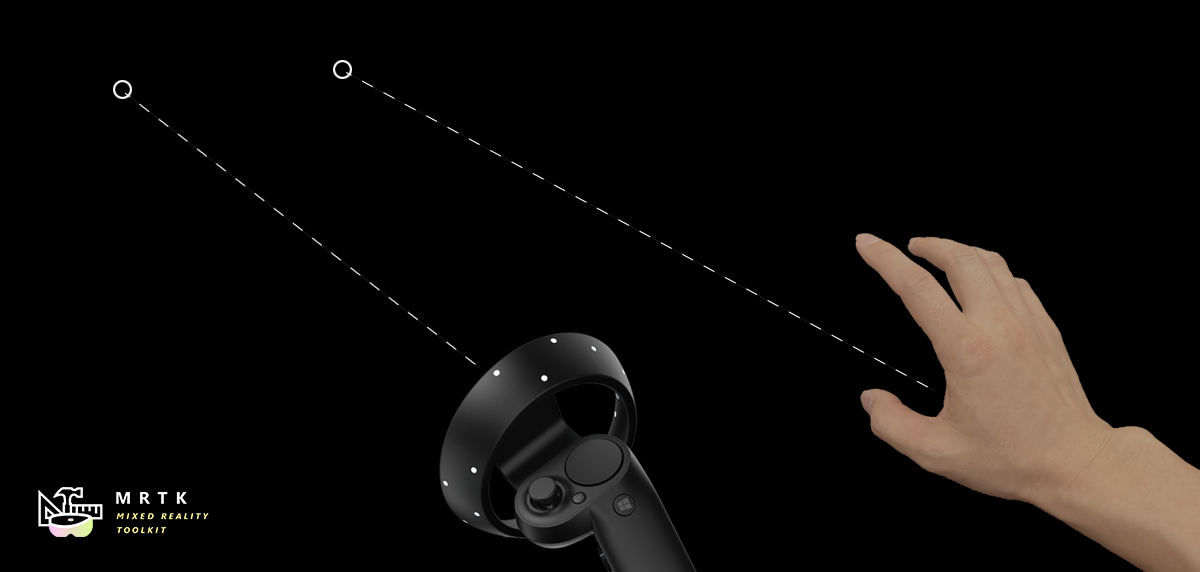

Zeiger Zeiger |

Fingerspitzenvisualisierung Fingerspitzenvisualisierung |

| Benutzeroberfläche für die manuelle Aktivierung von Bounding Box | Erfahren Sie mehr über verschiedene Typen von Zeigern. | Visuelle Angebote auf der Fingerspitze, was das Vertrauen für die direkte Interaktion verbessert |

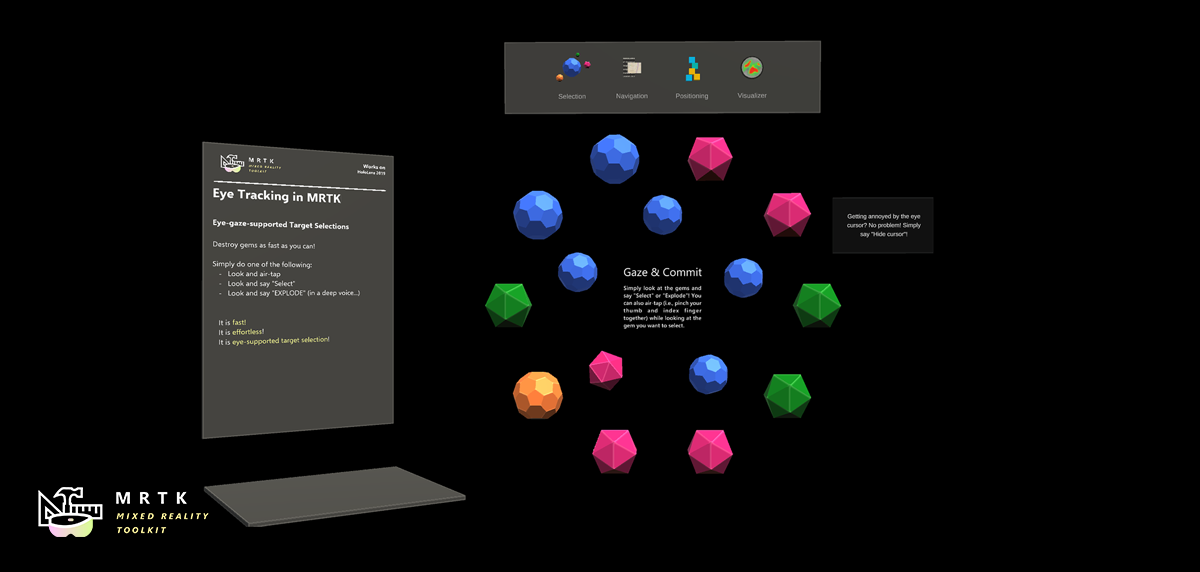

Eye Tracking: Zielauswahl Eye Tracking: Zielauswahl |

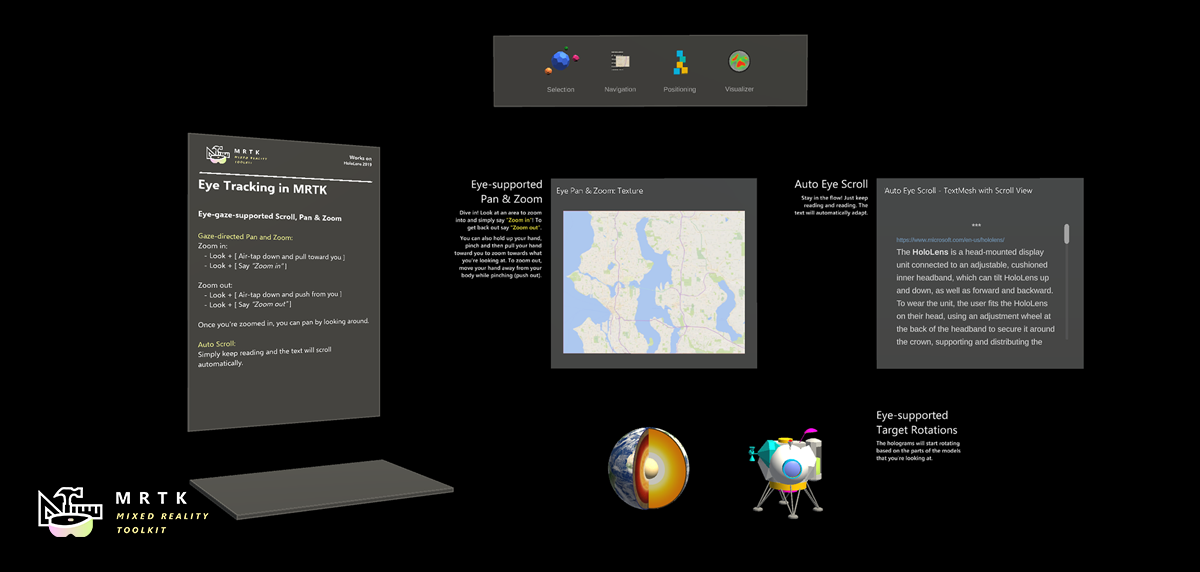

Eye Tracking: Navigation Eye Tracking: Navigation |

|

| Kombinieren Sie Augen- und Spracheingaben, um Hologramme in Ihrer Szene schnell und mühelos auszuwählen. | Informationen zum automatischen Scrollen von Text oder Zoomen in fokussierte Inhalte basierend auf dem, was Sie betrachten | Beispiele für protokollierung, laden und visualisieren, was Benutzer in Ihrer App betrachtet haben |

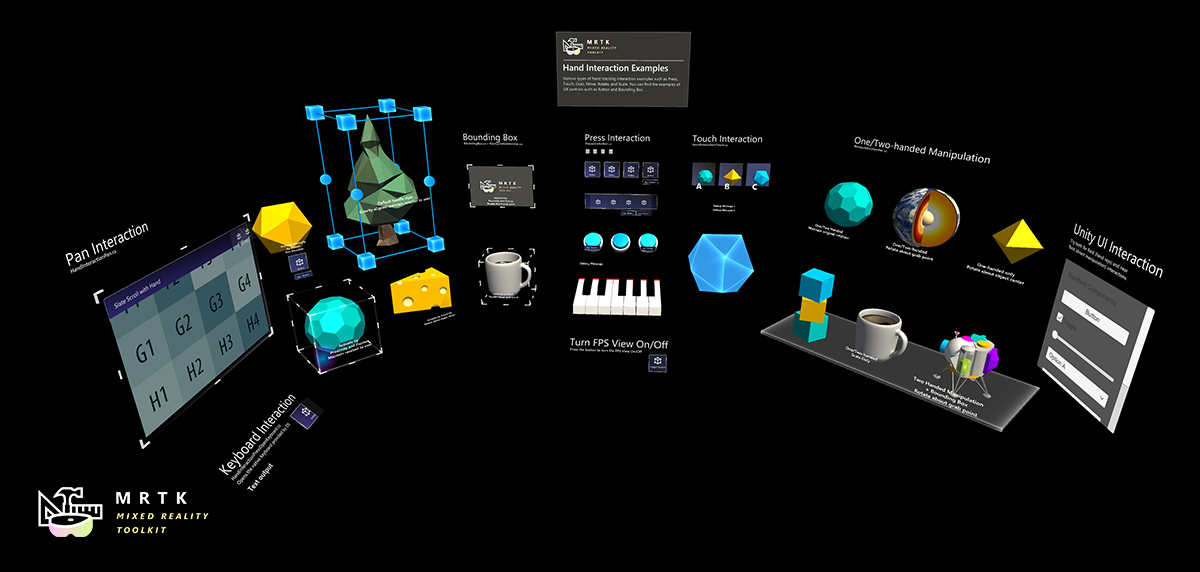

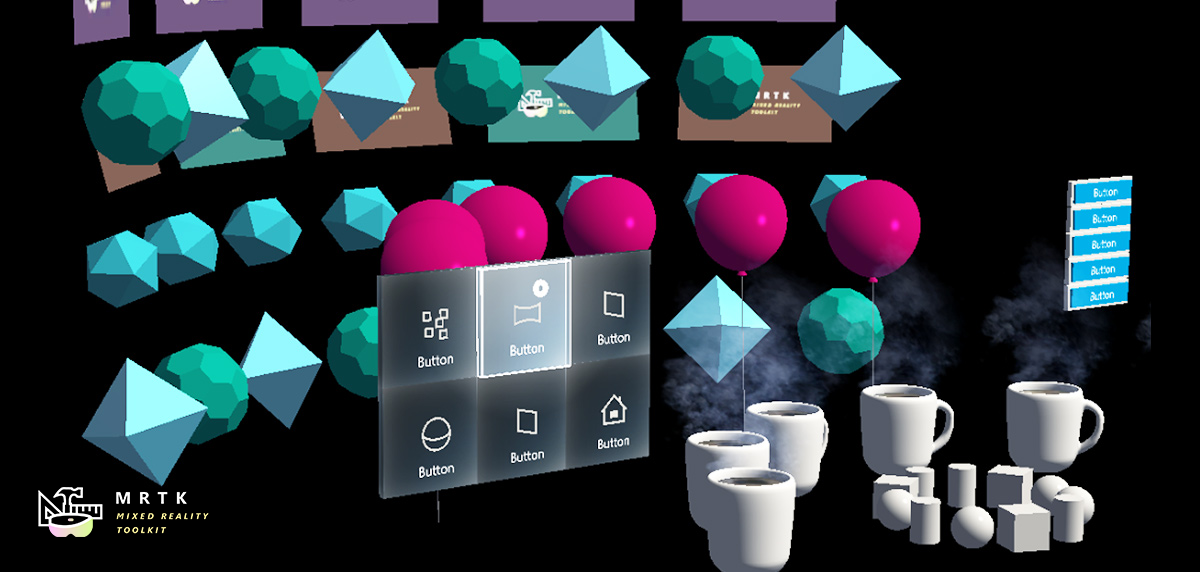

Beispielszenen

Erkunden Sie die verschiedenen Arten von Interaktionen und Benutzeroberflächen-Steuerelementen des MRTK in dieser Beispielszene.

Weitere Beispielszenen finden Sie im GitHub des Mixed Reality-Toolkits unter dem Ordner "Assets/MixedRealityToolkit.Examples/Demos".

Nächster Entwicklungsprüfpunkt

Wenn Sie die Unity-Entwicklungsreise verfolgt haben, die wir eingerichtet haben, befinden Sie sich mitten in der Erkundung der MRTK-Kernbausteine. Von hier aus können Sie mit dem nächsten Baustein fortfahren:

Oder fahren Sie mit den Funktionen und APIs der Mixed Reality-Plattform fort:

Sie können jederzeit zu den Prüfpunkten für die Unity-Entwicklung zurückkehren.