Machine Learning: evaluar

Importante

El soporte técnico de Machine Learning Studio (clásico) finalizará el 31 de agosto de 2024. Se recomienda realizar la transición a Azure Machine Learning antes de esa fecha.

A partir del 1 de diciembre de 2021 no se podrán crear recursos de Machine Learning Studio (clásico). Hasta el 31 de agosto de 2024, puede seguir usando los recursos de Machine Learning Studio (clásico) existentes.

- Consulte la información acerca de traslado de proyectos de aprendizaje automático de ML Studio (clásico) a Azure Machine Learning.

- Más información sobre Azure Machine Learning.

La documentación de ML Studio (clásico) se está retirando y es posible que no se actualice en el futuro.

En este artículo se describen los módulos de Machine Learning Studio (clásico) que puede usar para evaluar un modelo de Aprendizaje automático. La evaluación del modelo se realiza una vez completado el entrenamiento, para medir la precisión de las predicciones y evaluar el ajuste del modelo.

Nota

Se aplica a: solo Machine Learning Studio (clásico)

Hay módulos para arrastrar y colocar similares en el diseñador de Azure Machine Learning.

En este artículo también se describe el proceso general de Machine Learning Studio (clásico) para la creación, el entrenamiento, la evaluación y la puntuación del modelo.

Creación y uso de modelos de aprendizaje automático en Machine Learning Studio (clásico)

El flujo de trabajo típico para el aprendizaje automático incluye estas fases:

- Elija un algoritmo adecuado y establezca las opciones iniciales.

- Entrene el modelo mediante datos compatibles.

- Cree predicciones mediante nuevos datos basados en los patrones del modelo.

- Evalúe el modelo para determinar si las predicciones son precisas, la cantidad de error y si se produce un sobreajuste.

Machine Learning Studio (clásico) admite un marco flexible y personalizable para el aprendizaje automático. Cada tarea de este proceso se realiza mediante un tipo específico de módulo. El módulo se puede modificar, agregar o quitar sin interrumpir el resto del experimento.

Use los módulos de esta categoría para evaluar un modelo existente. La evaluación del modelo normalmente requiere algún tipo de conjunto de datos de resultados. Si no tiene un conjunto de datos de evaluación, puede generar resultados mediante la puntuación. También puede usar un conjunto de datos de prueba o algún otro conjunto de datos que contengan "verdad básica" o resultados esperados conocidos.

Más información sobre la evaluación del modelo

En general, al evaluar un modelo, las opciones dependen del tipo de modelo que está evaluando y de la métrica que desea usar. En estos temas se enumeran algunas de las métricas usadas con más frecuencia:

Machine Learning Studio (clásico) también proporciona una variedad de visualizaciones, según el tipo de modelo que use y cuántas clases predice el modelo. Para obtener ayuda para encontrar estas visualizaciones, consulte Visualización de métricas de evaluación.

La interpretación de estas estadísticas a menudo requiere una mayor comprensión del algoritmo concreto en el que se entrenó el modelo. Para obtener una buena explicación de cómo evaluar un modelo y cómo interpretar los valores que se devuelven para cada medida, consulte Cómo evaluar el rendimiento del modelo en Machine Learning.

Lista de módulos

La categoría Machine Learning - Evaluate incluye los siguientes módulos:

Modelo de validación cruzada: valida cruzadamente las estimaciones de parámetros para los modelos de clasificación o regresión mediante la creación de particiones de los datos.

Use el módulo Validar modelo cruzado si desea probar la validez del conjunto de entrenamiento y el modelo. La validación cruzada divide los datos en plegamientos y, a continuación, prueba varios modelos en combinaciones de plegamientos.

Evaluar modelo: evalúa un modelo de clasificación puntuada o regresión mediante métricas estándar.

En la mayoría de los casos, usará el módulo genérico Evaluate Model (Evaluar modelo ). Esto es especialmente cierto si el modelo se basa en uno de los algoritmos de clasificación o regresión admitidos.

Evaluar recomendador: evalúa la precisión de las predicciones del modelo de recomendación.

Para los modelos de recomendación, use el módulo Evaluar recomendador .

Tareas relacionadas

- Para los modelos de agrupación en clústeres, use el módulo Asignar datos a clústeres . A continuación, use las visualizaciones de ese módulo para ver los resultados de la evaluación.

- Puede crear métricas de evaluación personalizadas. Para crear métricas de evaluación personalizadas, proporcione código de R en el módulo Ejecutar script R o código de Python en el módulo Ejecutar script de Python . Esta opción es útil si desea usar métricas publicadas como parte de bibliotecas de código abierto o si desea diseñar su propia métrica para medir la precisión del modelo.

Ejemplos

Interpretar los resultados de la evaluación del modelo de aprendizaje automático es un arte. Requiere comprender los resultados matemáticos, además de los datos y los problemas empresariales. Se recomienda revisar estos artículos para obtener una explicación de cómo interpretar los resultados en diferentes escenarios:

- Elija parámetros para optimizar los algoritmos en Machine Learning

- Interpretar los resultados del modelo en Machine Learning

- Evaluar el rendimiento del modelo en Machine Learning

Notas técnicas

Esta sección contiene detalles de implementación, sugerencias y respuestas a las preguntas más frecuentes.

Visualización de métricas de evaluación

Obtenga información sobre dónde buscar en Machine Learning Studio (clásico) para buscar los gráficos de métricas de cada tipo de modelo.

Modelos de clasificación de dos clases

La vista predeterminada para los modelos de clasificación binaria incluye un gráfico ROC interactivo y una tabla de valores para las métricas principales.

Tiene dos opciones para ver los modelos de clasificación binaria:

- Haga clic con el botón derecho en la salida del módulo y, a continuación, seleccione Visualizar.

- Haga clic con el botón derecho en el módulo, seleccione Resultados de evaluación y, a continuación, seleccione Visualizar.

También puede usar el control deslizante para cambiar el valor de umbral de probabilidad. El umbral determina si se debe aceptar un resultado como true o no. A continuación, puede ver cómo cambian estos valores.

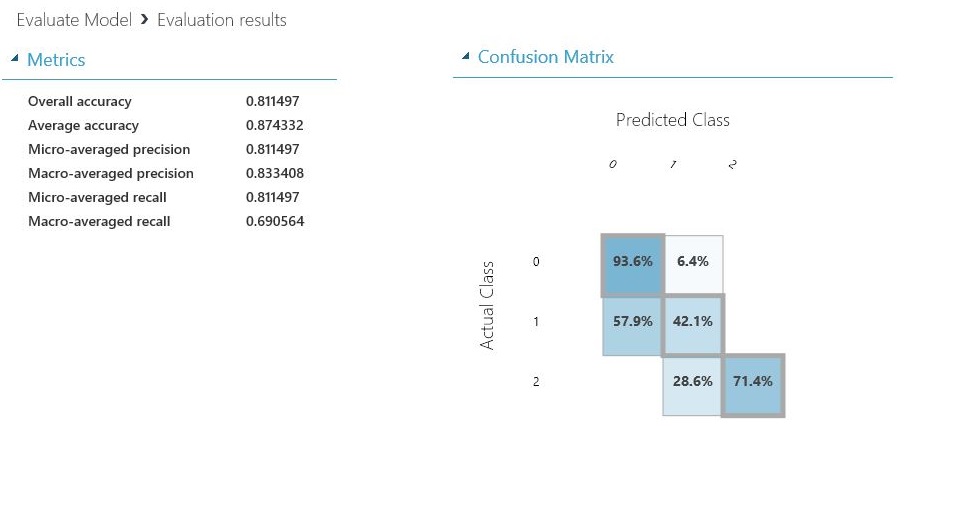

Modelos de clasificación multiclase

La vista de métricas predeterminada para los modelos de clasificación de varias clases incluye una matriz de confusión para todas las clases y un conjunto de métricas para el modelo en su conjunto.

Tiene dos opciones para ver los modelos de clasificación de varias clases:

- Haga clic con el botón derecho en la salida del módulo y, a continuación, seleccione Visualizar.

- Haga clic con el botón derecho en el módulo, seleccione Resultados de evaluación y, a continuación, seleccione Visualizar.

Por motivos de simplicidad, estos son los dos resultados, que se muestran en paralelo:

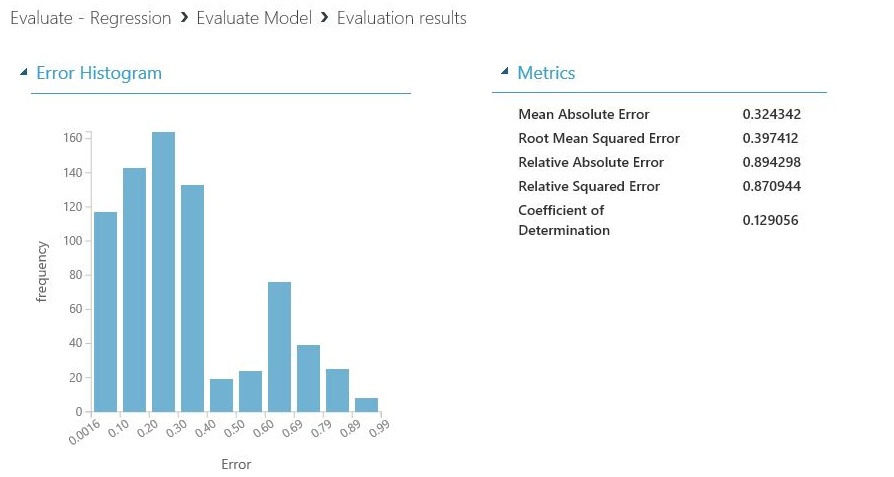

Modelos de regresión

La vista de métricas de los modelos de regresión varía en función del tipo de modelo que haya creado. La vista de métricas se basa en las interfaces de algoritmo subyacente y en la mejor opción para las métricas del modelo.

Tiene dos opciones para ver los modelos de regresión:

- Para ver las métricas de precisión en una tabla, haga clic con el botón derecho en la salida del módulo Evaluar modelo y, a continuación, seleccione Visualizar.

- Para ver un histograma de error con los valores, haga clic con el botón derecho en el módulo, seleccione Resultados de evaluación y, a continuación, seleccione Visualizar.

La vista Histograma de error puede ayudarle a comprender cómo se distribuye el error. Se proporciona para los siguientes tipos de modelo e incluye una tabla de métricas predeterminadas, como el error cuadrático medio raíz (RMSE).

- Boosted Decision Tree Regression (Regresión del árbol de decisión ampliado)

- Regresión lineal

- Regresión de red neuronal

Los siguientes modelos de regresión generan una tabla de métricas predeterminadas, junto con algunas métricas personalizadas:

- Regresión lineal bayesiana

- Regresión de bosque de decisión

- Regresión rápida de bosque por cuantiles

- Regresión ordinal

Sugerencias para trabajar con los datos

Para extraer los números sin copiar y pegar desde la interfaz de usuario de Machine Learning Studio (clásico), puede usar la nueva biblioteca de PowerShell para Machine Learning. Puede obtener metadatos y otra información para un experimento completo o desde módulos individuales.

Para extraer valores de un módulo Evaluar modelo , debe agregar un comentario único al módulo para facilitar la identificación. A continuación, use el cmdlet Download-AmlExperimentNodeOutput para obtener las métricas y sus valores de la visualización en formato JSON.

Para más información, consulte Creación de modelos de aprendizaje automático mediante PowerShell.