Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

Importante

El soporte técnico de Machine Learning Studio (clásico) finalizará el 31 de agosto de 2024. Se recomienda realizar la transición a Azure Machine Learning antes de esa fecha.

A partir del 1 de diciembre de 2021 no se podrán crear recursos de Machine Learning Studio (clásico). Hasta el 31 de agosto de 2024, puede seguir usando los recursos de Machine Learning Studio (clásico) existentes.

- Consulte la información acerca de traslado de proyectos de aprendizaje automático de ML Studio (clásico) a Azure Machine Learning.

- Más información sobre Azure Machine Learning.

La documentación de ML Studio (clásico) se está retirando y es posible que no se actualice en el futuro.

Carga datos de orígenes externos en la Web; desde varias formas de almacenamiento basado en la nube en Azure, como tablas, blobs y bases de datos de SQL; y desde bases de datos SQL Server locales

Categoría: Entrada y salida de datos

Nota

Se aplica a: solo Machine Learning Studio (clásico)

Hay módulos para arrastrar y colocar similares en el diseñador de Azure Machine Learning.

Información general sobre el módulo

En este artículo se describe cómo usar el módulo Importar datos en Machine Learning Studio (clásico) para cargar datos en un experimento de aprendizaje automático desde los servicios de datos en la nube existentes.

El módulo ahora cuenta con un asistente para ayudarle a elegir una opción de almacenamiento y seleccionar entre las suscripciones y las cuentas existentes para configurar rápidamente todas las opciones. ¿Necesita editar una conexión de datos existente? Ningún problema, el asistente carga todos los detalles de configuración anteriores para que no tenga que volver a empezar desde cero.

Después de definir los datos que desea y conectarse al origen, Importar datos deduce el tipo de datos de cada columna en función de los valores que contiene y carga los datos en el área de trabajo de Machine Learning Studio (clásico). La salida de Importación de datos es un conjunto de datos que puede utilizarse con todos los experimentos.

Importante

Actualmente, hay limitaciones en los tipos de cuentas de almacenamiento que se admiten. Para obtener más información, vea Notas técnicas.

Si los datos de origen cambian, puede actualizar el conjunto de datos y agregar nuevos datos mediante la nueva ejecución de Importar datos. Sin embargo, si no desea volver a leer el origen cada vez que ejecute el experimento, seleccione TRUE para la opción Use cached results (Utilizar resultados almacenados en caché). Cuando se selecciona esta opción, el módulo comprueba si el experimento se ha ejecutado anteriormente con el mismo origen y las mismas opciones de entrada. Si se encuentra una ejecución anterior, se usan los datos de la memoria caché, en lugar de volver a cargar los datos desde el origen.

Nota

Este módulo se denominaba lector anteriormente. Si anteriormente usó el módulo Lector en un experimento, se le cambia el nombre de Import Data (Importar datos ) al actualizar el experimento.

Orígenes de datos

El módulo Importar datos admite los siguientes orígenes de datos. Haga clic en los vínculos para obtener instrucciones detalladas y ejemplos del uso de cada origen de datos.

Si no está seguro de cómo o dónde debe almacenar los datos, consulte esta guía para escenarios de datos comunes en el proceso de ciencia de datos: Escenarios para el análisis avanzado en Machine Learning.

| Origen de datos | Uso con |

|---|---|

| Dirección URL web a través de HTTP | La obtención de datos que se hospedan en una dirección URL web que usa HTTP y que se ha proporcionado en los formatos CSV, TSV, ARFF o SvmLight |

| Consulta de Hive | Obtenga datos del almacenamiento distribuido en Hadoop. Especifique los datos que desee mediante el lenguaje HiveQL. |

| Azure SQL Database | Obtener datos de Azure SQL Database o de Azure SQL Data Warehouse |

| Azure Table | Obtención de datos almacenados en Azure Table Service |

| Importación desde Azure Blob Storage | La obtención de datos que se almacenan en Azure Blob service |

| Proveedores de fuentes de distribución de datos | Obtención de datos expuestos como fuente en formato OData |

| Importar desde la base de datos de SQL Server local | Obtención de datos de una base de datos de SQL Server local mediante la puerta de enlace de Microsoft Administración de datos |

| Azure Cosmos DB | Obtenga los datos almacenados en formato JSON en Azure Cosmos DB. |

Sugerencia

¿Necesita importar datos en formato JSON? Tanto R como Python admiten API REST, por lo que use los módulos Execute Python Script (Ejecutar script de Python) o Execute R Script (Ejecutar script de R) para analizar los datos y guardarlos como un conjunto de datos de Azure ML.

O bien, use la API de SQL DB para CosmosDB, que admite varios almacenes JSON, incluidos MongoDB, para leer los datos mediante la opción Importar desde Azure Cosmos DB. Para más información, consulte Importación desde Azure Cosmos DB.

Procedimiento para usar la importación de datos

Agregue el módulo Importación de datos al experimento. Puede encontrar este módulo en la categoría Entrada y salida de datos en Studio (clásico).

Haga clic en Launch Data Import Wizard (Iniciar el asistente para la importación de datos) para configurar el origen de datos mediante un asistente.

El asistente obtiene el nombre de cuenta y las credenciales y le ayuda a configurar otras opciones. Si va a editar una configuración existente, primero carga los valores actuales.

Si no desea usar el asistente, haga clic en Origen de datosy elija el tipo de almacenamiento basado en la nube que lee.

La configuración adicional depende del tipo de almacenamiento que elija, y si el almacenamiento está protegido o no. Es posible que deba proporcionar el nombre de cuenta, el tipo de archivo o las credenciales. Algunos orígenes no requieren autenticación; en otros casos, es posible que necesite saber el nombre de la cuenta, una clave o el nombre del contenedor.

Para más información, consulte la lista de orígenes de datos.

Seleccione la opción Usar resultados almacenados en caché si desea almacenar en caché el conjunto de datos para volver a usarse en ejecuciones sucesivas.

Suponiendo que no ha habido ningún otro cambio en los parámetros del módulo, el experimento carga los datos solo la primera vez que se ejecuta el módulo y, a partir de entonces, usa una versión almacenada en caché del conjunto de datos.

Anule la selección de esta opción si tiene que volver a cargar los datos cada vez que ejecute el experimento.

Ejecute el experimento.

Cuando Import Data carga los datos en Studio (clásico), deduce el tipo de datos de cada columna en función de los valores que contiene, ya sea numéricos o categóricos.

Si el encabezado está presente, se utiliza para asignar nombres a las columnas del conjunto de datos de salida.

Si no existe ningún encabezado de columna en los datos, se generan nuevos nombres de columna con el formato col1, col2... ,coln.

Results

Cuando haya terminado la importación, haga clic en el conjunto de datos de salida y seleccione Visualizar para ver si los datos se han importado correctamente.

Si desea guardar los datos para su reutilización, en lugar de importar un nuevo conjunto de datos cada vez que se ejecute el experimento, haga clic con el botón derecho en la salida y seleccione Guardar como conjunto de datos. Escriba un nombre para el conjunto de datos. El conjunto de datos guardado conserva los datos en el momento de guardar y los datos no se actualizan cuando se vuelve a ejecutar el experimento, incluso si cambia el conjunto de datos del experimento. Esto puede ser útil para tomar instantáneas de datos.

Después de importar los datos, es posible que tenga que realizar algunos preparativos adicionales para el modelado y análisis:

Generar resúmenes estadísticos de los datos, mediante Summarize Data o Compute Elementary Statistics.

Use Editar metadatos para cambiar los nombres de columna, para controlar una columna como un tipo de datos diferente, o para indicar que algunas columnas son etiquetas o características.

Use Seleccionar columnas de conjunto de datos para seleccionar un subconjunto de columnas para transformar o usar en el modelado. Las columnas transformadas o eliminadas se pueden volver a unir fácilmente al conjunto de datos original mediante el módulo Agregar columnas o el módulo Combinar datos .

Use Partición y muestra para dividir el conjunto de datos, realizar un muestreo u obtener las primeras n filas.

Use Apply SQL Transformation (Aplicar SQL Transformación) para agregar datos, filtrar o transformar mediante instrucciones SQL.

Use estos módulos para limpiar columnas de texto y generar nuevas características de texto:

- Preprocesamiento de texto

- Extracción de características de n-gramas a partir de texto

- Reconocimiento de entidades con nombre

- Ejecute script de Python para implementar NLP personalizado basado en nltk.

Notas técnicas

En esta sección se proporciona una lista de problemas conocidos con el módulo Importar datos , así como información general de solución de problemas no específica de un tipo de origen.

Tipos de cuenta admitidos

Con frecuencia, Azure publica nuevos servicios o nuevos tipos de almacenamiento; sin embargo, normalmente hay un retraso mientras la compatibilidad con los nuevos tipos de cuenta se implementa en Machine Learning Studio (clásico).

Actualmente, Machine Learning admite todas las cuentas de almacenamiento de uso general, excepto las que usan almacenamiento con redundancia de zona (ZRS).

Se admiten el almacenamiento con redundancia local (LRS) y las opciones de almacenamiento con redundancia geográfica.

Se admiten blobs en bloques, pero los blobs en anexos no.

Preguntas y problemas comunes

En esta sección se describen algunos problemas conocidos, preguntas comunes y soluciones alternativas.

Los encabezados deben ser filas únicas

Si va a importar desde archivos CSV, tenga en cuenta que Machine Learning permite una sola fila de encabezado. No se pueden insertar encabezados de varias líneas.

Separadores personalizados admitidos en la importación, pero no en la exportación

El módulo Importar datos admite la importación de datos que usa separadores de columna alternativos, como el punto y coma (;), que a menudo se usa en Europa. Al importar datos de archivos CSV en almacenamiento externo, seleccione la opción CSV con codificaciones y elija una codificación compatible.

Sin embargo, no puede generar separadores alternativos al preparar los datos para la exportación mediante el módulo Convertir en CSV .

Separación deficiente de columnas en datos de cadena que contienen comas

Casi todos los caracteres que se pueden especificar como separadores de columnas (pestañas, espacios, comas, etc.) también se pueden encontrar aleatoriamente en campos de texto. La importación de texto de CSV siempre requiere precaución para evitar separar el texto en columnas nuevas innecesarias. Es un problema común en el procesamiento de texto que probablemente haya encontrado y controlado de maneras diferentes.

También pueden producirse problemas al intentar exportar una columna de datos de cadena que contiene comas. Machine Learning no admite ningún tratamiento especial ni traducción especial de dichos datos, como cadenas envolventes entre comillas. Además, no puede usar caracteres de escape antes de una coma para asegurarse de que las comas se controlan como un carácter literal. Como consecuencia, se crean nuevos campos en el archivo de salida para cada coma que se encuentre en el campo de cadena.

Para evitar problemas en la exportación, use el módulo Preprocesar texto para quitar los caracteres de puntuación de los campos de cadena.

También puede usar un script de R personalizado o un script de Python para procesar texto complejo y asegurarse de que los datos se pueden importar o exportar correctamente.

Codificación UTF-8 necesaria

Machine Learning requiere codificación UTF-8. Si los datos que va a importar usan una codificación diferente o se exportó desde un origen de datos que usa una codificación predeterminada diferente, pueden aparecer varios problemas en el texto.

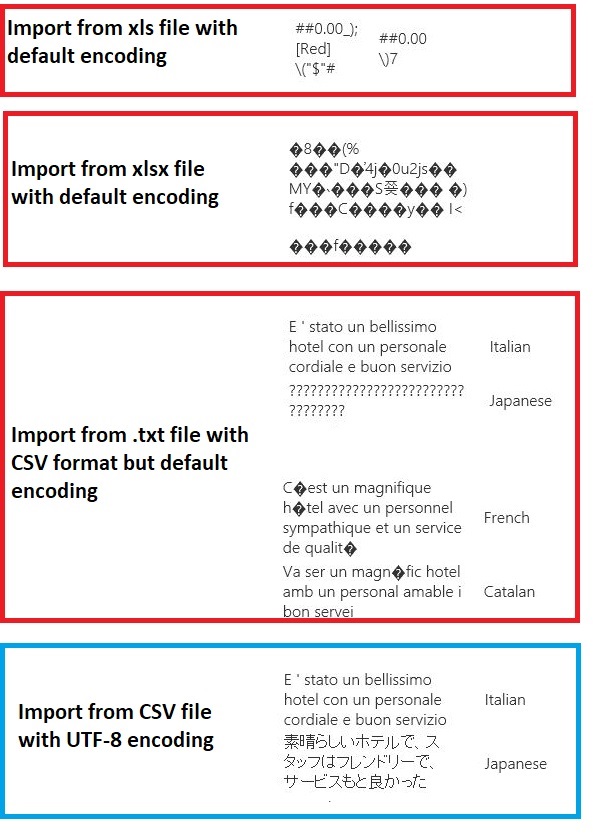

Por ejemplo, la siguiente imagen contiene el mismo conjunto de datos multilanguage exportado desde Excel y, a continuación, importado en Machine Learning en cuatro combinaciones diferentes de tipo de archivo y codificación.

En el tercer ejemplo se representan los datos que se han perdido durante el guardado de Excel en formato CSV, ya que la codificación correcta no se especificó en ese momento. Por lo tanto, si tiene problemas, asegúrese de comprobar no solo el archivo desde el que está importando, pero si el archivo se exportó correctamente desde el origen.

El conjunto de datos no tiene nombres de columna

Si el conjunto de datos que va a importar no tiene nombres de columna, asegúrese de especificar una de las opciones "sin encabezado". Al hacerlo, Import Data agrega nombres de columna predeterminados con el formato Col1, Col2, etc. Más adelante, use Editar metadatos para corregir los nombres de columna.

Si va a exportar un conjunto de datos a un archivo CSV, use Editar metadatos para agregar nombres de columna antes de convertirlo o exportarlo.

Soluciones alternativas para orígenes de datos no admitidos

Si necesita obtener datos de un origen que no está en la lista, hay varias soluciones alternativas que puede probar:

Para cargar datos desde un archivo en el equipo, haga clic en Nuevo en Studio (clásico), seleccione Conjunto de datos y, a continuación, seleccione Desde archivo local. Busque el archivo y especifique el formato (TSV, CSV, etc.). Para más información, consulte Importación de datos de entrenamiento en Studio (clásico).

Use R o Python. Puede usar el módulo Ejecutar script R con un paquete de R adecuado para obtener datos de otras bases de datos en la nube.

El módulo Ejecutar script de Python también permite leer y convertir datos de diversos orígenes. Consulte estos ejemplos de científicos de datos de Microsoft en la Galería de inteligencia de Cortana:

Carga de archivos que no son de texto desde Azure Blob Storage

Obtención de datos de clústeres de AWS. Puede ejecutar una consulta en un clúster genérico de Hive con WebHCat o el punto de conexión HCatalog habilitado. O bien, publique como una página y lea desde la dirección URL web.

Obtener datos de MongoDB. La utilidad de migración de datos para Azure Cosmos DB admite una amplia variedad de orígenes y formatos. Para más información y ejemplos, consulte Azure Cosmos DB: Herramienta de migración de datos.

Para obtener más ideas y soluciones alternativas, consulte el foro de Machine Learning o azure AI Gallery.

Parámetros del módulo

Cada origen de datos debe configurarse con diferentes opciones. En esta tabla solo se enumeran las opciones que son comunes a todos los orígenes de datos.

| Nombre | Intervalo | Tipo | Valor predeterminado | Descripción |

|---|---|---|---|---|

| Origen de datos | List | Origen de datos o receptor | Servicio Blob del Almacenamiento de Azure | El origen de datos puede ser HTTP, HTTPS anónimo, un archivo en Blob service o Table service, una base de datos de SQL en Azure, un Azure SQL Data Warehouse, una tabla de Hive o un punto de conexión de OData. |

| Uso de resultados almacenados en caché | TRUE/FALSE | Boolean | FALSE | Si es TRUE, el módulo comprobará si el experimento se ha ejecutado anteriormente con las mismas opciones de entrada y origen, y si se encuentra una ejecución anterior, se usan los datos de la memoria caché. Si se encuentran false o si se encuentran cambios, los datos se volverán a cargar desde el origen. |

Salidas

| Nombre | Tipo | Descripción |

|---|---|---|

| Conjunto de datos de resultados | Tabla de datos | Conjunto de datos con datos descargados |

Excepciones

| Excepción | Descripción |

|---|---|

| Error 0027 | Se produce una excepción cuando dos objetos tienen que ser del mismo tamaño pero no lo son. |

| Error 0003 | Se produce una excepción si una o varias de las entradas son nulas o están vacías. |

| Error 0029 | Se produce una excepción cuando se pasa un URI no válido. |

| Error 0030 | Se produce una excepción cuando no es posible descargar un archivo. |

| Error 0002 | Se produce una excepción si uno o más parámetros no se pudieron analizar o convertir del tipo especificado al tipo requerido por el método de destino. |

| Error 0009 | Se produce una excepción si se especifica incorrectamente el nombre de la cuenta de almacenamiento de Azure o el nombre del contenedor. |

| Error 0048 | Se produce una excepción cuando no es posible abrir un archivo. |

| Error 0015 | Se produce una excepción si se ha producido un error en la conexión de base de datos. |

| Error 0046 | Se produce una excepción si no es posible crear el directorio en la ruta de acceso especificada. |

| Error 0049 | Se produce una excepción cuando no es posible analizar un archivo. |

Para obtener una lista de errores específicos de los módulos de Studio (clásico), consulte códigos de error Machine Learning.

Para obtener una lista de excepciones de API, consulte Machine Learning códigos de error de la API REST.

Consulte también

Entrada y salida de datos

Conversiones de formato de datos

Export Data

Lista de módulos A-Z