Muistiinpano

Tämän sivun käyttö edellyttää valtuutusta. Voit yrittää kirjautua sisään tai vaihtaa hakemistoa.

Tämän sivun käyttö edellyttää valtuutusta. Voit yrittää vaihtaa hakemistoa.

Näissä opetusohjelmissa esitellään Fabric-tietojenkäsittelykokemuksen kattava skenaario. Ne kattavat jokaisen vaiheen, alkaen

- Tietojen käsittely

- Tietojen puhdistus

- Tietojen valmistelu

vastaanottaja

- Koneoppimismallin harjoittaminen

- Merkityksellisten tietojen luominen

voit käsitellä merkityksellisten tietojen kulutusta visualisointityökaluilla, kuten Power BI:llä.

Jos olet uusi Microsoft Fabric -käyttäjä, vieraile osoitteessa What is Microsoft Fabric?.

Johdanto

Datatiedeprojektin elinkaari sisältää yleensä seuraavat vaiheet:

- Liiketoimintasääntöjen ymmärtäminen

- Tietojen hankinta

- Tietojen tutkiminen, siistiminen, valmisteleminen ja visualisointi

- Harjoita malli ja seuraa kokeilua

- Mallin pisteytys ja merkityksellisten tietojen luominen

Vaiheet etenevät usein iteratiivisesti. Kunkin vaiheen tavoitteet ja onnistumisen ehdot riippuvat yhteistyöstä, tietojen jakamisesta ja dokumentaatiosta. Fabric-datatieteen käyttökokemus sisältää useita alkuperäisiä ominaisuuksia, jotka mahdollistavat saumattoman yhteistyön, tietojen hankinnan, jakamisen ja kulutuksen.

Näillä opetusohjelmilla annat roolisi datatieteilijälle, jonka täytyy tutkia, puhdistaa ja muuntaa tietojoukkoa, joka sisältää 10 000 pankkiasiakkaan vaihtuvuustilan. Sen jälkeen luot koneoppimismallin ennustaaksesi, ketkä pankkiasiakkaat todennäköisesti lähtevät.

Voit suorittaa opetusohjelmissa seuraavat toimet:

- Fabric-muistikirjojen käyttäminen tietojenkäsittelyskenaarioita varten

- Käytä Apache Sparkiä tietojen käyttämiseen Fabric Lakehousessa

- Aiemmin luotujen tietojen lataaminen Lakehouse Delta -taulukoista

- Apache Spark- ja Python-pohjaisten työkalujen käyttö tietojen siistimiseen ja muuntamiseen

- Luo kokeita ja suorituksia eri koneoppimismallien harjoittamiseksi

- MLflow'n ja Fabric-käyttöliittymän avulla voit rekisteröidä ja seurata harjoitettuja malleja

- Suorita pisteytys mittakaavassa ja tallenna ennusteet ja tunnistustulokset Lakehouse-talolle

- Ennusteiden visualisointi DirectLakella Power BI:ssä

Arkkitehtuuri

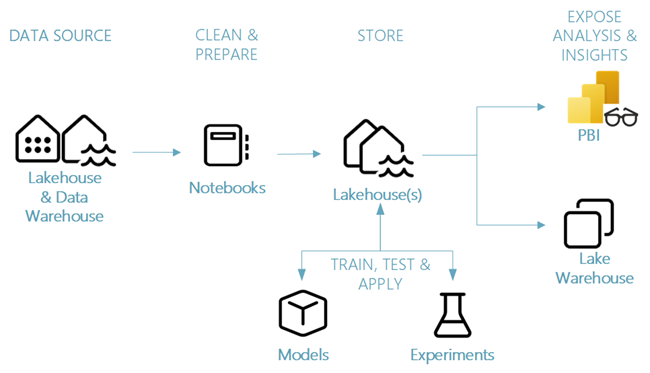

Tässä opetusohjelmasarjassa esitellään yksinkertaistettu päästä päähän -datatiedeskenaario, johon liittyy:

- Tietojen käsittely ulkoisesta tietolähteestä.

- Tietojen tarkasteleminen ja puhdistaminen.

- Koneoppimismallin harjoittaminen ja rekisteröinti.

- Erän pisteytys ja ennusteiden tallentaminen.

- Ennustetuloksen visualisointi Power BI:ssä.

Datatiedeskenaarion eri osat

Tietolähteet : Kun haluat käsitellä tietoja Fabricilla, voit muodostaa helposti ja nopeasti yhteyden Azure Data Servicesiin, muihin pilviympäristöihin ja paikallisiin tietoresursseihin. Fabric Notebooks -muistikirjojen avulla voit käsitellä tietoja seuraavista resursseista:

- Sisäiset Lakehouset

- Tietovarastot

- Semantic models

- Useita Apache Spark -tietolähteitä

- Eri tietolähteet, jotka tukevat Pythonia

Tässä opetusohjelmasarjassa keskitytään tietojen käsittelyön ja lakehousesta lataamiseen.

Tutki, siisti ja valmistele – Fabric-datatiede tukee tietojen siistimistä, muuntamista, tutkimista ja esitelmää. Se käyttää sisäisiä Spark-kokemuksia ja Python-pohjaisia työkaluja, kuten Data Wrangler - ja SemPy-kirjastoa. Tässä opetusohjelmassa esitellään tietojen tarkasteleminen Python-kirjaston seaborn avulla sekä tietojen siistiminen ja valmistelu Apache Sparkin avulla.

Mallit ja kokeilut – Fabricilla voit kouluttaa, arvioida ja pisteillä koneoppimismalleja valmiilla kokeilla. MLflow tarjoaa saumattoman integraation Fabric-mallikohteiden mallintamiseen, jotta voit rekisteröidä ja ottaa käyttöön malleja sekä seurata kokeita. Fabric tarjoaa muita toimintoja mallin ennustamiseen suuressa mittakaavassa sekä kehittää ja jakaa merkityksellisiä liiketoimintatietoja.

Tallennus - Fabric standardoi Delta Lake -järvellä, mikä tarkoittaa, että kaikki Fabric-moottorit voivat käsitellä samaa tietojoukkoa, joka on tallennettu lakehouse-järveen. Tallennuskerrokseen voi tallentaa sekä jäsennettyjä että jäsentämättömiä tietoja, jotka tukevat sekä tiedostopohjaista tallennustilaa että taulukkomuotoa. Voit helposti käyttää tietojoukkoja ja tallennettuja tiedostoja kaikkien Fabric-käyttökokemuskohteiden, kuten muistikirjojen ja putkien, kautta.

Paljasta analyysit ja merkitykselliset tiedot – Power BI, joka on alan johtava liiketoimintatietojen työkalu, voi käyttää Lakehouse-tietoja raporttien ja visualisointien luontia varten. Muistikirjaresursseissa Python- tai Spark-alkuperäisissä visualisointikirjastoissa

matplotlibseabornplotly- jne.

voi visualisoida lakehouse-järjestelmässä säilyneet tiedot. SemPy-kirjasto tukee myös tietojen visualisointia. Tämä kirjasto tukee monipuolisia tehtäväkohtaisia visualisointeja

- Semanttinen tietomalli

- Riippuvuudet ja niiden rikkomukset

- Luokitus- ja regression käyttötapaukset