Sécuriser un environnement d’entraînement Azure Machine Learning à l’aide de réseaux virtuels (SDKv1)

S’APPLIQUE À :  SDK Python azureml v1

SDK Python azureml v1

Dans cet article, vous allez apprendre à sécuriser les environnements d’entraînement à l’aide d’un réseau virtuel dans Azure Machine Learning en utilisant le Kit de développement logiciel (SDK) Python v1.

L’instance de calcul et le cluster de calcul Azure Machine Learning peuvent être utilisés pour entraîner des modèles de manière sécurisée dans un réseau virtuel. Quand vous planifiez votre environnement, vous pouvez configurer le cluster/l’instance de calcul avec ou sans adresse IP publique. Les différences générales entre les deux sont les suivantes :

- Aucune IP publique : réduit les coûts, car n’a pas les mêmes besoins de ressources réseau. Améliore la sécurité en supprimant l’exigence de trafic entrant à partir d’Internet. Toutefois, des changements de configuration supplémentaires sont nécessaires pour permettre l’accès sortant vers les ressources nécessaires (Microsoft Entra ID, Azure Resource Manager, etc.).

- IP publique : fonctionne par défaut, mais coûte plus cher en raison des ressources réseau Azure supplémentaires. Nécessite une communication entrante du service Azure Machine Learning sur l’Internet public.

Le tableau suivant contient les différences entre ces configurations :

| Configuration | Avec une IP publique | Sans IP publique |

|---|---|---|

| Trafic entrant | Étiquette de service AzureMachineLearning. |

Aucun |

| Trafic sortant | Par défaut, peut accéder à l’Internet public sans restriction. Vous pouvez restreindre ce à quoi il peut accéder en utilisant un groupe de sécurité réseau ou un pare-feu. |

Par défaut, il ne peut pas accéder à Internet. S’il peut toujours envoyer du trafic sortant à Internet, c’est en raison de l’accès sortant par défaut d’Azure et parce que vous avez un groupe de sécurité réseau qui autorise le trafic sortant vers Internet. Nous ne recommandons pas d’utiliser l’accès sortant par défaut. Si vous avez besoin d’un accès sortant à Internet, nous vous recommandons d’utiliser plutôt une passerelle NAT de réseau virtuel ou un pare-feu si vous devez router le trafic sortant vers les ressources nécessaires sur Internet. |

| Ressources réseau Azure | Adresse IP publique, équilibreur de charge, interface réseau | None |

Vous pouvez également utiliser Azure Databricks ou HDInsight pour entraîner des modèles dans un réseau virtuel.

Conseil

Vous pouvez utiliser des réseaux virtuels managés d’Azure Machine Learning au lieu de suivre les étapes décrites dans cet article. Avec un réseau virtuel managé, Azure Machine Learning gère le travail d’isolement réseau pour votre espace de travail et vos calculs managés. Vous pouvez également ajouter des points de terminaison privés pour les ressources dont l’espace de travail a besoin, par exemple un compte de stockage Azure. Pour plus d’informations, consultez Isolement réseau managé d’espace de travail.

Notes

Pour plus d’informations sur l’utilisation du Studio Azure Machine Learning et du Kit de développement logiciel (SDK) Python v2, consultez Sécuriser l’environnement de formation (v2).

Pour obtenir un tutoriel sur la création d’un espace de travail sécurisé, consultez le Tutoriel : Créer un espace de travail sécurisé sur le Portail Azure ou les articles Modèle Bicep ou Modèle Terraform.

Dans cet article, vous découvrirez comment sécuriser les ressources de calcul d’entraînement dans un réseau virtuel :

- Cluster de calcul Azure Machine Learning

- Instance de calcul Azure Machine Learning

- Azure Databricks

- Machine virtuelle

- Cluster HDInsight

Important

Les éléments marqués « préversion » dans cet article sont actuellement en préversion publique. La préversion est fournie sans contrat de niveau de service et n’est pas recommandée pour les charges de travail en production. Certaines fonctionnalités peuvent être limitées ou non prises en charge. Pour plus d’informations, consultez Conditions d’Utilisation Supplémentaires relatives aux Évaluations Microsoft Azure.

Prérequis

Lisez l’article Vue d’ensemble de la sécurité réseau pour comprendre les scénarios courants des réseaux virtuels et l’architecture globale des réseaux virtuels.

Un réseau virtuel et un sous-réseau existants à utiliser avec vos ressources de calcul. Le VNet doit être dans le même abonnement que votre espace de travail Azure Machine Learning.

- Nous vous recommandons de placer les comptes de stockage utilisés par votre espace de travail et vos travaux d’entraînement dans la même région Azure que vous utilisez pour vos clusters et vos instances de calcul. S’ils ne sont pas dans la même région Azure, vous pouvez avoir des coûts de transfert de données et une plus grande latence réseau.

- Vérifiez que la communication WebSocket est autorisée vers

*.instances.azureml.netet*.instances.azureml.msdans votre VNet. Les WebSockets sont utilisés par Jupyter sur les instances de calcul.

Un sous-réseau existant dans le réseau virtuel. Ce sous-réseau est utilisé pour la création de clusters et d’instances de calcul.

- Vérifiez que le sous-réseau n’est pas délégué à d’autres services Azure.

- Vérifiez que le sous-réseau contient suffisamment d’adresses IP libres. Chaque instance de calcul nécessite une adresse IP. Chaque nœud au sein d’un cluster de calcul nécessite une adresse IP.

Si vous avez votre propre serveur DNS, nous vous recommandons d’utiliser le transfert DNS pour résoudre les noms de domaine complets (FQDN) des clusters et des instances de calcul. Pour plus d’informations, consultez Utiliser un DNS personnalisé avec Azure Machine Learning.

Pour déployer des ressources dans un réseau virtuel ou un sous-réseau, votre compte d’utilisateur doit disposer d’autorisations pour les actions suivantes dans le contrôle d’accès en fonction du rôle Azure (Azure RBAC) :

- « Microsoft.Network/*/read » sur la ressource de réseau virtuel. Cette autorisation n’est pas nécessaire pour les déploiements de modèles Azure Resource Manager (ARM).

- « Microsoft.Network/virtualNetworks/join/action » sur la ressource de réseau virtuel.

- "Microsoft.Network/virtualNetworks/subnets/join/action" sur la ressource de sous-réseau.

Pour plus d’informations sur Azure RBAC avec la mise en réseau, consultez Rôles intégrés pour la mise en réseau.

Limites

Cluster/instance de calcul Azure Machine Learning

Les clusters de calcul peuvent être créés dans une région ou un réseau virtuel différent de celui de votre espace de travail. Toutefois, cette fonctionnalité est disponible uniquement à l’aide du SDK v2, de l’interface CLI v2 ou du studio. Pour plus d’informations, consultez la version v2 des environnements d’entraînement sécurisés.

Le déploiement de cluster/d’instance de calcul dans un réseau virtuel n’est pas pris en charge avec Azure Lighthouse.

Le port 445 doit être ouvert pour les communications dans le réseau privé entre vos instances de calcul et le compte de stockage par défaut pendant l’entraînement. Par exemple, si vos calculs et le compte de stockage se trouvent dans deux réseaux virtuels distincts, ne bloquez pas le port 445 sur le réseau virtuel du compte de stockage.

Azure Databricks

- Le réseau virtuel doit être dans les mêmes abonnement et région que l’espace de travail Azure Machine Learning.

- Si le ou les comptes de stockage Azure pour l’espace de travail sont également sécurisés dans un réseau virtuel, ils doivent se trouver dans le même réseau virtuel que le cluster Azure Databricks.

- Outre les sous-réseaux databricks-private et databricks-public utilisés par Azure Databricks, le sous-réseau default créé pour le réseau virtuel est également requis.

- Azure Databricks n’utilise pas de point de terminaison privé pour communiquer avec le réseau virtuel.

Pour plus d’informations sur l’utilisation d’Azure Databricks dans un réseau virtuel, consultez Déployer des Azure Databricks dans votre réseau virtuel Azure.

Azure HDInsight ou machine virtuelle

- Azure Machine Learning prend uniquement en charge les machines virtuelles exécutant Ubuntu.

Cluster/instance de calcul sans IP publique

Important

Si vous utilisez des instances de calcul ou des clusters de calcul configurés pour ne pas utiliser d’IP publique et que vous n’être pas inscrit à la préversion, vous devez les supprimer et les recréer après le 20 janvier 2023 (quand la fonctionnalité sera mise à disposition générale).

Si vous avez utilisé la préversion qui n’utilise pas d’IP publique, vous devez peut-être également modifier le trafic entrant et sortant que vous autorisez, car les exigences ont changé pour la disponibilité générale :

- Exigences de trafic sortant : deux trafics sortants supplémentaires, utilisés uniquement pour la gestion des clusters et des instances de calcul. La destination de ces étiquettes de service appartient à Microsoft :

AzureMachineLearningbalise de service sur le port UDP 5831.BatchNodeManagementbalise de service sur le port TCP 443.

Les configurations suivantes s’ajoutent à celles listées dans la section Prérequis et sont propres à la création de clusters/instances de calcul configurés pour ne pas utiliser d’IP publique :

Vous devez utiliser un point de terminaison privé d’espace de travail pour la ressource de calcul afin de communiquer avec les services Azure Machine Learning à partir du réseau virtuel. Pour plus d’informations, consultez Configurer un point de terminaison privé pour un espace de travail Azure Machine Learning.

Dans votre VNet, autorisez le trafic sortant vers les étiquettes de service ou les noms de domaine complets (FQDN) suivants :

Balise du service Protocol Port Notes AzureMachineLearningTCP

UDP443/8787/18881

5831Communication avec le service Azure Machine Learning. BatchNodeManagement.<region>ANY 443 Remplacez <region>par la région Azure qui contient votre espace de travail Azure Machine Learning. Communication avec Azure Batch. L’instance de calcul et le cluster de calcul sont implémentés avec le service Azure Batch.Storage.<region>TCP 443 Remplacez <region>par la région Azure qui contient votre espace de travail Azure Machine Learning. Cette étiquette de service est utilisée pour communiquer avec le compte de stockage Azure utilisé par Azure Batch.Important

L’accès sortant vers

Storage.<region>peut être utilisé pour exfiltrer des données de votre espace de travail. À l’aide d’une stratégie de point de terminaison de service, vous pouvez atténuer cette vulnérabilité. Pour plus d’informations, consultez l’article Prévention de l’exfiltration de données Azure Machine Learning.FQDN Protocol Port Notes <region>.tundra.azureml.msUDP 5831 Remplacez <region>par la région Azure qui contient votre espace de travail Azure Machine Learning.graph.windows.netTCP 443 Communication avec Microsoft API Graph. *.instances.azureml.msTCP 443/8787/18881 Communication avec Azure Machine Learning. *.<region>.batch.azure.comANY 443 Remplacez <region>par la région Azure qui contient votre espace de travail Azure Machine Learning. Communication avec Azure Batch.*.<region>.service.batch.azure.comANY 443 Remplacez <region>par la région Azure qui contient votre espace de travail Azure Machine Learning. Communication avec Azure Batch.*.blob.core.windows.netTCP 443 Communication avec le stockage Blob Azure. *.queue.core.windows.netTCP 443 Communication avec le stockage File d’attente Azure. *.table.core.windows.netTCP 443 Communication avec le stockage Table Azure. Créez un pare-feu et des règles de trafic sortant, ou une passerelle NAT et des groupes de services réseau pour autoriser le trafic sortant. Comme le calcul n’a pas d’adresse IP publique, il ne peut pas communiquer avec les ressources sur l’Internet public sans cette configuration. Par exemple, il ne peut pas communiquer avec Microsoft Entra ID ou Azure Resource Manager. L’installation de packages Python à partir de sources publiques nécessite également cette configuration.

Pour plus d’informations sur le trafic sortant utilisé par Azure Machine Learning, consultez les articles suivants :

Utilisez les informations suivantes pour créer un cluster ou une instance de calcul sans adresse IP publique :

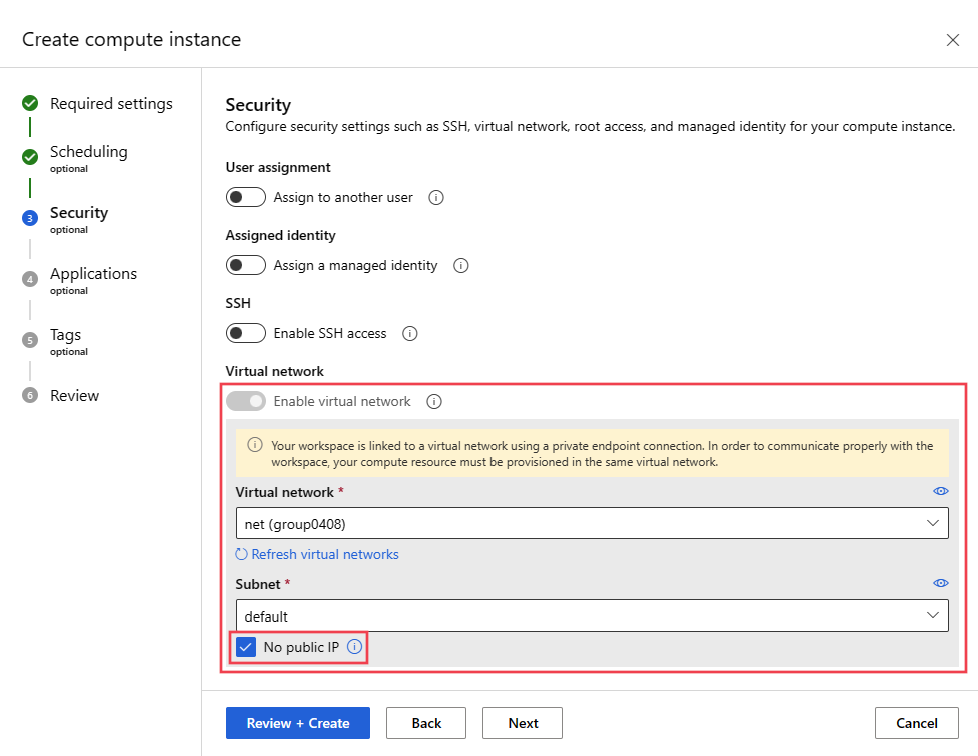

Pour créer une instance de calcul ou un cluster de calcul sans IP publique, utilisez l’interface utilisateur Azure Machine Learning Studio pour créer la ressource :

Connectez-vous à Azure Machine Learning Studio, puis sélectionnez votre abonnement et votre espace de travail.

Sélectionnez la page Calcul dans la barre de navigation gauche.

Sélectionnez + Nouveau dans la barre de navigation de l’instance de calcul ou du cluster de calcul.

Configurez la taille VM et ce dont vous avez besoin, puis sélectionnez Suivant.

Dans Paramètres avancés, sélectionnez Activer le réseau virtuel, votre réseau virtuel et votre sous-réseau, puis sélectionnez l’option Aucune IP publique sous la section VNet/sous-réseau.

Conseil

Vous pouvez également utiliser le SDK Azure Machine Learning v2 ou l’extension Azure CLI pour ML v2. Pour plus d’informations sur la création d’un cluster ou d’une instance de calcul sans IP publique, consultez la version v2 de l’article Sécuriser un environnement d’entraînement Azure Machine Learning.

Cluster/instance de calcul avec IP publique

Les configurations suivantes s’ajoutent à celles listées dans la section Prérequis et sont propres à la création de clusters/instances de calcul qui ont une IP publique :

Si vous placez plusieurs clusters/instances de calcul dans un réseau virtuel, vous devez peut-être demander une augmentation du quota pour une ou plusieurs de vos ressources. L’instance ou le cluster de calcul Machine Learning alloue automatiquement des ressources réseau au groupe de ressources qui contient le réseau virtuel. Pour chaque instance ou cluster de calcul, le service alloue les ressources suivantes :

Un groupe de sécurité réseau (NSG) est créé automatiquement. Ce NSG autorise le trafic TCP entrant sur le port 44224 à partir de l’étiquette de service

AzureMachineLearning.Important

L’instance de calcul et le cluster de calcul créent automatiquement un groupe de sécurité réseau avec les règles requises.

Si vous disposez d’un autre groupe de sécurité réseau au niveau du sous-réseau, les règles du groupe de sécurité réseau au niveau du sous-réseau ne doivent pas entrer en conflit avec les règles du groupe de sécurité réseau créé automatiquement.

Pour savoir comment les groupes de sécurité réseau filtrent votre trafic réseau, consultez Comment les groupes de sécurité réseau filtrent le trafic réseau.

Un seul équilibreur de charge

Pour les clusters de calcul, ces ressources sont supprimées chaque fois que le cluster effectue un scale-down à 0 nœud et créées chaque fois que le cluster effectue un scale-up.

Pour une instance de calcul, ces ressources sont conservées jusqu’à ce que l’instance soit supprimée. L’arrêt de l’instance ne supprime pas les ressources.

Important

Ces ressources sont limitées par les quotas de ressources de l’abonnement. Si le groupe de ressources du réseau virtuel est verrouillé, la suppression de l’instance/du cluster de calcul échoue. L’équilibreur de charge ne peut pas être supprimé tant que l’instance/le cluster de calcul n’a pas été supprimé. Vérifiez également qu’aucune affectation Azure Policy n’interdit la création de groupes de sécurité réseau.

Dans votre VNet, autorisez le trafic TCP entrant sur le port 44224 à partir de l’étiquette de service

AzureMachineLearning.Important

Le cluster/l’instance de calcul reçoit une adresse IP attribuée dynamiquement au moment de sa création. Comme l’adresse n’est pas connue avant la création et qu’un accès entrant est nécessaire dans le cadre du processus de création, vous ne pouvez pas l’attribuer de manière statique sur votre pare-feu. À la place, si vous utilisez un pare-feu avec le VNet, vous devez créer une route définie par l’utilisateur pour autoriser ce trafic entrant.

Dans votre VNet, autorisez le trafic sortant vers les étiquettes de service suivantes :

Balise du service Protocol Port Notes AzureMachineLearningTCP

UDP443/8787/18881

5831Communication avec le service Azure Machine Learning. BatchNodeManagement.<region>ANY 443 Remplacez <region>par la région Azure qui contient votre espace de travail Azure Machine Learning. Communication avec Azure Batch. L’instance de calcul et le cluster de calcul sont implémentés avec le service Azure Batch.Storage.<region>TCP 443 Remplacez <region>par la région Azure qui contient votre espace de travail Azure Machine Learning. Cette étiquette de service est utilisée pour communiquer avec le compte de stockage Azure utilisé par Azure Batch.Important

L’accès sortant vers

Storage.<region>peut être utilisé pour exfiltrer des données de votre espace de travail. À l’aide d’une stratégie de point de terminaison de service, vous pouvez atténuer cette vulnérabilité. Pour plus d’informations, consultez l’article Prévention de l’exfiltration de données Azure Machine Learning.FQDN Protocol Port Notes <region>.tundra.azureml.msUDP 5831 Remplacez <region>par la région Azure qui contient votre espace de travail Azure Machine Learning.graph.windows.netTCP 443 Communication avec Microsoft API Graph. *.instances.azureml.msTCP 443/8787/18881 Communication avec Azure Machine Learning. *.<region>.batch.azure.comANY 443 Remplacez <region>par la région Azure qui contient votre espace de travail Azure Machine Learning. Communication avec Azure Batch.*.<region>.service.batch.azure.comANY 443 Remplacez <region>par la région Azure qui contient votre espace de travail Azure Machine Learning. Communication avec Azure Batch.*.blob.core.windows.netTCP 443 Communication avec le stockage Blob Azure. *.queue.core.windows.netTCP 443 Communication avec le stockage File d’attente Azure. *.table.core.windows.netTCP 443 Communication avec le stockage Table Azure.

S’APPLIQUE À :  SDK Python azureml v1

SDK Python azureml v1

import datetime

import time

from azureml.core.compute import ComputeTarget, ComputeInstance

from azureml.core.compute_target import ComputeTargetException

# Choose a name for your instance

# Compute instance name should be unique across the azure region

compute_name = "ci{}".format(ws._workspace_id)[:10]

# Verify that instance does not exist already

try:

instance = ComputeInstance(workspace=ws, name=compute_name)

print('Found existing instance, use it.')

except ComputeTargetException:

compute_config = ComputeInstance.provisioning_configuration(

vm_size='STANDARD_D3_V2',

ssh_public_access=False,

vnet_resourcegroup_name='vnet_resourcegroup_name',

vnet_name='vnet_name',

subnet_name='subnet_name',

# admin_user_ssh_public_key='<my-sshkey>'

)

instance = ComputeInstance.create(ws, compute_name, compute_config)

instance.wait_for_completion(show_output=True)

Une fois le processus de création terminé, vous pouvez entraîner votre modèle. Pour plus d’informations, consultez Sélectionner et utiliser une cible de calcul pour l’entraînement.

Azure Databricks

- Le réseau virtuel doit être dans les mêmes abonnement et région que l’espace de travail Azure Machine Learning.

- Si le ou les comptes de stockage Azure pour l’espace de travail sont également sécurisés dans un réseau virtuel, ils doivent se trouver dans le même réseau virtuel que le cluster Azure Databricks.

- Outre les sous-réseaux databricks-private et databricks-public utilisés par Azure Databricks, le sous-réseau default créé pour le réseau virtuel est également requis.

- Azure Databricks n’utilise pas de point de terminaison privé pour communiquer avec le réseau virtuel.

Pour obtenir des informations spécifiques sur l’utilisation d’Azure Databricks avec un réseau virtuel, consultez Déployer des Azure Databricks dans votre réseau virtuel Azure.

Accès Internet public requis pour entraîner les modèles

Important

Les sections précédentes de cet article décrivent les configurations nécessaires pour créer des ressources de calcul, et les informations de configuration de cette section sont nécessaires pour utiliser ces ressources afin d’entraîner des modèles.

Azure Machine Learning nécessite un accès entrant et sortant à l’Internet public. Les tableaux suivants fournissent une vue d’ensemble de l’accès requis et de son rôle. Pour les balises de service se terminant par .region, remplacez region par la région Azure qui contient votre espace de travail. Par exemple, Storage.westus:

Conseil

L’onglet obligatoire liste la configuration entrante et sortante nécessaire. L’onglet situationnel liste les configurations entrantes et sortantes facultatives nécessaires pour des configurations spécifiques que vous pouvez être amené à activer.

| Sens | Protocole et ports |

Balise du service | Objectif |

|---|---|---|---|

| Règle de trafic sortant | TCP : 80, 443 | AzureActiveDirectory |

Authentification à l’aide de Microsoft Entra ID. |

| Règle de trafic sortant | TCP : 443, 18881 UDP : 5831 |

AzureMachineLearning |

Utilisation d’Azure Machine Learning Services. Python intellisense dans les notebooks utilise le port 18881. La création, la mise à jour et la suppression d’une instance de calcul Azure Machine Learning utilisent le port 5831. |

| Règle de trafic sortant | ANY : 443 | BatchNodeManagement.region |

Communication avec le back-end Azure Batch pour les clusters/instances de calcul Azure Machine Learning. |

| Règle de trafic sortant | TCP : 443 | AzureResourceManager |

Création de ressources Azure avec Azure Machine Learning, Azure CLI et le SDK Azure Machine Learning. |

| Règle de trafic sortant | TCP : 443 | Storage.region |

Accédez aux données stockées dans le compte Stockage Azure pour le cluster et l’instance de calcul. Pour plus d’informations sur la prévention de l’exfiltration de données sur ce trafic sortant, consultez Protection contre l’exfiltration de données. |

| Règle de trafic sortant | TCP : 443 | AzureFrontDoor.FrontEnd* Non nécessaire dans Microsoft Azure géré par 21Vianet. |

Point d’entrée global pour Azure Machine Learning studio. Stockez des images et des environnements pour AutoML. Pour plus d’informations sur la prévention de l’exfiltration de données sur ce trafic sortant, consultez Protection contre l’exfiltration de données. |

| Règle de trafic sortant | TCP : 443 | MicrosoftContainerRegistry.regionNotez que cette étiquette a une dépendance sur l’étiquette AzureFrontDoor.FirstParty |

Accès aux images Docker fournies par Microsoft. Configuration du routeur Azure Machine Learning pour Azure Kubernetes Service. |

Conseil

Si vous avez besoin des adresses IP au lieu des balises de service, utilisez l’une des options suivantes :

- Téléchargez une liste à partir des Plages d’adresses IP et Balises de service.

- Utilisez la commande az network list-service-tags Azure CLI.

- Utilisez la commande Get-AzNetworkServiceTag Azure PowerShelI.

Les adresses IP peuvent périodiquement changer.

Vous devrez peut-être également autoriser le trafic sortant vers des sites Visual Studio Code et non-Microsoft pour l’installation des packages requis par votre projet Machine Learning. Le tableau suivant répertorie les référentiels couramment utilisés pour l’apprentissage automatique :

| Nom de l’hôte | Objectif |

|---|---|

anaconda.com*.anaconda.com |

Utilisé pour installer les packages par défaut. |

*.anaconda.org |

Utilisé pour récupérer les données des dépôts. |

pypi.org |

Utilisé pour lister les dépendances de l’index par défaut, le cas échéant, et si l’index n’a pas été remplacé par les paramètres utilisateur. Si l’index a été remplacé, vous devez également autoriser *.pythonhosted.org. |

cloud.r-project.org |

Utilisé lors de l’installation des packages CRAN pour le développement R. |

*.pytorch.org |

Utilisé par certains exemples basés sur PyTorch. |

*.tensorflow.org |

Utilisé par certains exemples basés sur Tensorflow. |

code.visualstudio.com |

Obligatoire pour télécharger et installer Visual Studio Code Desktop. Cela n’est pas obligatoire pour Visual Studio Code Web. |

update.code.visualstudio.com*.vo.msecnd.net |

Utilisé pour récupérer les bits du serveur Visual Studio Code qui sont installés sur l’instance de calcul par le biais d’un script d’installation. |

marketplace.visualstudio.comvscode.blob.core.windows.net*.gallerycdn.vsassets.io |

Obligatoire pour télécharger et installer les extensions Visual Studio Code. Ces hôtes activent la connexion à distance pour calculer les instances fournies par l’extension Azure ML pour Visual Studio Code. Pour plus d’informations, consultez Se connecter à une instance de calcul Azure Machine Learning dans Visual Studio Code |

raw.githubusercontent.com/microsoft/vscode-tools-for-ai/master/azureml_remote_websocket_server/* |

Utilisé pour récupérer les bits du serveur websocket installés sur l’instance de calcul. Le serveur websocket est utilisé pour transmettre les requêtes du client Visual Studio Code (application de bureau) au serveur Visual Studio Code s’exécutant sur l’instance de calcul. |

Notes

Lors de l’utilisation de l’extension Visual Studio Code d’Azure Machine Learning, un accès aux dépôts publics est nécessaire à l’instance de calcul distante pour installer les packages demandés par l’extension. Lorsqu’un proxy est nécessaire à l’instance de calcul pour accéder à ces dépôts publics ou à Internet, vous devez définir et exporter les variables d’environnement HTTP_PROXY et HTTPS_PROXY dans le fichier ~/.bashrc de l’instance de calcul. Vous pouvez automatiser ce processus lors de l’approvisionnement en utilisant un script personnalisé.

Lorsque vous utilisez Azure Kubernetes Service (AKS) avec Azure Machine Learning, le trafic suivant doit être autorisé vers le réseau virtuel AKS :

- Exigences générales en entrée/sortie pour AKS, comme décrit dans l’article Restreindre le trafic sortant dans Azure Kubernetes Service.

- Sortant vers mcr.microsoft.com.

- Lors du déploiement d’un modèle sur un cluster AKS, suivez les instructions de l’article Déployer des modèles ML dans Azure Kubernetes Service.

Pour plus d’informations sur l’utilisation d’une solution de pare-feu, consultez Utiliser un pare-feu avec Azure Machine Learning.

Étapes suivantes

Cet article fait partie d’une série sur la sécurisation d’un workflow Azure Machine Learning. Consultez les autres articles de cette série :