Traiter des données à la périphérie avec des pipelines de la préversion du Processeur de données Azure IoT

Important

Opérations Azure IoT (préversion) – activé parc Azure Arc est actuellement en PRÉVERSION. Vous ne devez pas utiliser ce logiciel en préversion dans des environnements de production.

Pour connaître les conditions juridiques qui s’appliquent aux fonctionnalités Azure en version bêta, en préversion ou plus généralement non encore en disponibilité générale, consultez l’Avenant aux conditions d’utilisation des préversions de Microsoft Azure.

Les ressources industrielles génèrent des données dans de nombreux formats différents et utilisent différents protocoles de communication. Cette diversité de sources de données, associée à différents schémas et mesures unitaires, rend difficile l’utilisation et l’analyse efficace des données industrielles brutes. En outre, pour des raisons de conformité, de sécurité et de performances, vous ne pouvez pas charger tous les jeux de données dans le cloud.

Le traitement de ces données nécessite traditionnellement une engineering données coûteuse, complexe et fastidieuse. La préversion du Processeur de données Azure IoT est un service de traitement de données configurable qui peut gérer les complexités et la diversité des données industrielles. Utilisez Data Processor pour rendre les données provenant de sources disparates plus compréhensibles, plus utilisables et plus précieuses.

Présentation de la préversion du Processeur de données Azure IoT

La préversion d’Azure IoT Data Processor est un composant facultatif de la préversion d’Opérations Azure IoT. Data Processor vous permet d’agréger, d’enrichir, de normaliser et de filtrer les données provenant de vos appareils. Data Processor est un moteur de traitement de données basé sur un pipeline qui vous permet de traiter les données à la périphérie avant de les envoyer aux autres services en périphérie ou dans le cloud :

Data Processor ingère les données de flux en temps réel provenant de sources telles que les serveurs d’agents utilisateurs OPC, les historiens et d’autres systèmes industriels. Le service normalise ces données en convertissant différents formats de données en format standardisé et structuré, ce qui facilite leur interrogation et leur analyse. Data Processor peut également contextualiser les données, les enrichir avec des données de référence ou des dernières valeurs connues (LKV) afin de fournir une vue complète de vos opérations industrielles.

La sortie de Data Processor consiste en des données propres, enrichies et standardisées, qui sont prêtes pour les applications en aval, telles que les outils d’analyse et d’insights en temps réel. Data Processor réduit considérablement le temps nécessaire pour transformer les données brutes en insights exploitables.

Les fonctionnalités clés de Data Processors sont les suivantes :

Normalisation flexible des données pour convertir plusieurs formats de données en une structure standardisée.

Enrichissement des flux de données avec des données de référence ou des valeurs LKV pour améliorer le contexte et les insights.

Intégration de Microsoft Fabric pour simplifier l’analyse des données propres.

Possibilité de traiter les données de différentes sources et de les publier dans différentes destinations.

En tant que plateforme de traitement des données indépendante des données, Data Processor peut ingérer des données dans n’importe quel format, les traiter, puis les écrire dans une destination. Pour prendre en charge ces fonctionnalités, Data Processor peut désérialiser et sérialiser différents formats. Par exemple, il peut effectuer une sérialisation en parquet afin d’écrire des fichiers dans Microsoft Fabric.

Stratégies de nouvelles tentatives automatiques et configurables pour gérer les erreurs temporaires pendant l’envoi de données à des destinations cloud.

Déployer Data Processor

Par défaut, Data Processor n’est pas inclus dans un déploiement de la préversion d’Opérations Azure IoT. Si vous envisagez d’utiliser Data Processor, vous devez l’inclure lorsque vous déployez la préversion d’Opérations Azure IoT. Vous ne pouvez pas l’ajouter ultérieurement. Pour déployer Data Processor, utilisez l’argument --include-dp lorsque vous exécutez la commande az iot ops init. Pour plus d’informations, consultez Déployer les extensions de la préversion d’Opérations Azure IoT sur un cluster Kubernetes.

Qu’est-ce qu’un pipeline ?

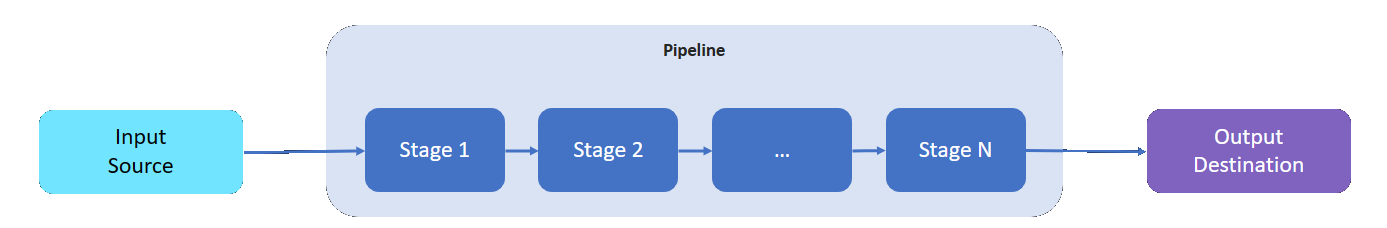

Un pipeline Data Processor a une source d’entrée dans laquelle il lit les données, une destination dans laquelle il écrit les données traitées et un nombre variable d’index intermédiaires pour traiter les données.

Les index intermédiaires représentent les différentes fonctionnalités de traitement des données disponibles :

- Vous pouvez ajouter autant d’index intermédiaires que nécessaire à un pipeline.

- Vous pouvez ordonner les index intermédiaires d’un pipeline selon vos besoins. Vous pouvez réorganiser les index après avoir créé un pipeline.

- Chaque index respecte une interface d’implémentation définie et un contrat de schéma d’entrée/de sortie.

- Chaque index est indépendant des autres index du pipeline.

- Tous les index fonctionnent dans l’étendue d’une partition. Les données ne sont pas partagées entre différentes partitions.

- Les données passent d’une index au suivant uniquement.

Les pipelines Data Processor peuvent utiliser les index suivants :

| Étape | Description |

|---|---|

| Source : MQ | Récupère les données d’un MQTT broker. |

| Source : point de terminaison HTTP | Récupère les données d’un point de terminaison HTTP. |

| Source : SQL | Récupère les données d’une base de données Microsoft SQL Server. |

| Source - InfluxDB | Récupère les données d’une base de données InfluxDB. |

| Filter | Filtre les données qui circulent dans l’index. Par exemple, filtrez n’importe quel message avec une température en dehors de la plage 50F-150F. |

| Transformer | Normalise la structure des données. Par exemple, modifiez la structure de {"Name": "Temp", "value": 50} à {"temp": 50}. |

| LKV | Stocke les valeurs de métriques sélectionnées dans un magasin LKV. Par exemple, stockez uniquement les mesures de température et d’humidité dans LKV et ignorez le reste. Un index suivant peut enrichir un message avec les données LKV stockées. |

| Enrichissement | Enrichit les messages avec les données du magasin de données de référence. Par exemple, ajoutez un nom d’opérateur et un numéro de lot à partir du jeu de données d’opérations. |

| Regroupement | Agrège les valeurs qui circulent dans l’index. Par exemple, la transmission des valeurs de température toutes les 100 millisecondes entraîne l’émission d’une métrique de température moyenne toutes les 30 secondes. |

| Appel | Effectue un appel à un service HTTP ou gRPC externe. Par exemple, appelez une fonction Azure pour convertir un format de message personnalisé en JSON. |

| Destination : MQ | Écrit vos données traitées, nettoyées et contextualisées dans une rubrique MQTT. |

| Destination : référence | Écrit vos données traitées dans le magasin de références intégré. D’autres pipelines peuvent utiliser le magasin de références pour enrichir leurs messages. |

| Destination : gRPC | Envoie vos données traitées, nettoyées et contextualisées à un point de terminaison gRPC. |

| Destination - HTTP | Envoie vos données traitées, nettoyées et contextualisées à un point de terminaison HTTP. |

| Destination : lakehouse Fabric | Envoie vos données traitées, nettoyées et contextualisées à un lakehouse Microsoft Fabric dans le cloud. |

| Destination : Azure Data Explorer | Envoie vos données traitées, nettoyées et contextualisées à un point de terminaison Azure Data Explorer dans le cloud. |

Étape suivante

Pour tester les pipelines Data Processor, consultez les guides de démarrage rapide Opérations Azure IoT.

Pour en savoir plus sur Data Processor, consultez :

Commentaires

Prochainement : Tout au long de l'année 2024, nous supprimerons progressivement les GitHub Issues en tant que mécanisme de retour d'information pour le contenu et nous les remplacerons par un nouveau système de retour d'information. Pour plus d’informations, voir: https://aka.ms/ContentUserFeedback.

Soumettre et afficher des commentaires pour