Options permettant d’obtenir des données dans le Fabric Lakehouse

L’expérience d’obtention des données couvre tous les scénarios utilisateur permettant d’envoyer des données dans le lakehouse, comme :

- Connexion à des SQL Server existants et copie de données dans la table Delta sur le lakehouse.

- Chargement de fichiers depuis votre ordinateur.

- Copie et fusion de plusieurs tables d’autres lakehouses dans une nouvelle table Delta.

- Connexion à une source de streaming pour expédier des données dans un lakehouse.

- Référencement de données sans les copier à partir d’autres lakehouses internes ou sources externes.

Différentes façons de charger des données dans un lakehouse

Dans Microsoft Fabric, vous pouvez obtenir des données dans un lakehouse de plusieurs façons :

- Chargez des fichiers à partir d’un ordinateur local

- Exécutez un outil de copie dans les pipelines

- Configurez un flux de données

- Bibliothèques Apache Spark dans le code de notebook

- Diffuser des événements en temps réel avec Eventstream

- Obtenir des données à partir d’Eventhouse

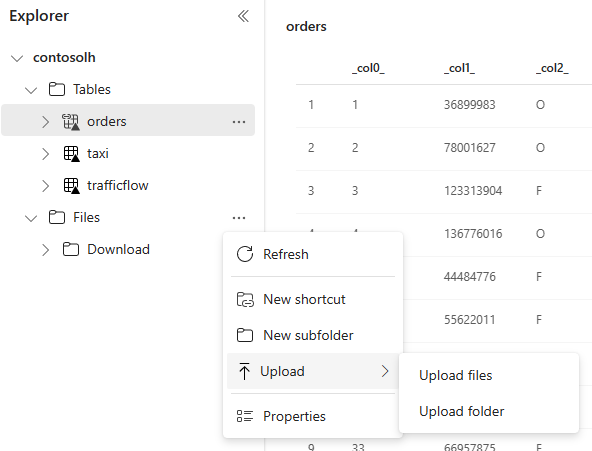

Chargement de fichiers locaux

Vous pouvez également charger des données stockées sur votre ordinateur local. Vous pouvez le faire directement dans l’explorateur Lakehouse.

Outil de copie dans les pipelines

L’outil Copier est une solution d’intégration de données hautement évolutive qui vous permet de vous connecter à différentes sources de données et de charger les données au format d’origine ou de les convertir en table Delta. L’outil Copier fait partie des activités de pipelines que vous pouvez modifier de plusieurs manières, comme la planification ou le déclenchement en fonction d’un évènement. Pour plus d'informations, voir Comment copier des données à l'aide de l'activité Copy.

Flux de données

Pour les utilisateurs qui connaissent les flux de données Power BI, le même outil est disponible pour charger des données dans votre lakehouse. Vous pouvez y accéder rapidement à partir de l’option « Obtenir des données » de l’explorateur Lakehouse et expédier des données depuis plus de 200 connecteurs. Pour plus d’informations, consultez Démarrage rapide : créer votre premier flux de données pour obtenir et transformer des données.

Code de notebook

Vous pouvez utiliser les bibliothèques Spark disponibles pour vous connecter directement à une source de données, charger les données dans une trame de données, puis l’enregistrer dans un lakehouse. Cette méthode est le moyen le plus ouvert de charger des données dans le lakehouse, entièrement géré par le code utilisateur.

Remarque

Les tables Delta externes créées avec le code Spark ne seront pas visibles pour un point de terminaison d’analytique SQL. Utilisez des raccourcis dans l’espace Table pour rendre les tables Delta externes visibles par un point de terminaison d’analytique SQL. Pour savoir comment créer un raccourci, consultez Créer un raccourci vers des fichiers ou des tables.

Diffuser des événements en temps réel avec Eventstream

Avec Eventstream, vous pouvez obtenir, traiter et acheminer des événements en temps réel à partir d’un large éventail de sources.

Pour savoir comment ajouter lakehouse comme destination pour Eventstream, consultez Obtenir des données à partir d’Eventstream dans un lakehouse.

Pour optimiser les performances de diffusion en continu, vous pouvez diffuser des données d’Eventstream dans un Eventhouse, puis activer la disponibilité OneLake.

Obtenir des données à partir d’Eventhouse

Lorsque vous activez la disponibilité de OneLake sur les données d’un Eventhouse, une table Delta est créée dans OneLake. Cette table Delta est accessible par un lakehouse à l’aide d’un raccourci. Pour plus d'informations, consultez Raccourcis OneLake. Pour plus d’informations, consultez Disponibilité d’Eventhouse OneLake.

Considérations à prendre en compte lors du choix de l’approche de chargement des données

| Cas d’utilisation | Recommandation |

|---|---|

| Chargement de petit fichier à partir d’un ordinateur local | Utiliser le chargement de fichier local |

| Quantité peu élevée de données ou connecteur spécifique | Utiliser les flux de données |

| Source de données volumineuse | Utiliser l’outil Copier dans les pipelines |

| Transformations de données complexes | Utiliser le code de notebook |

| Diffusion de données | Utilisez Eventstream pour diffuser des données dans Eventhouse ; activez la disponibilité de OneLake et créez un raccourci à partir de Lakehouse |

| Données de série chronologique | Obtenir des données à partir d’Eventhouse |

Contenu connexe

- Explorez les données de votre Lakehouse avec un carnet

- Démarrage rapide : créer votre premier pipeline pour copier des données

- Comment copier des données à l'aide de l'activité Copy

- Déplacer les données depuis une base de données Azure SQL vers un Lakehouse via l’assistant de copie

- Ajouter une destination lakehouse à un flux d’événements

- Disponibilité de OneLake dans un Eventhouse