Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Les flux de données sont une technologie de préparation des données en libre-service, basée sur le cloud. Dans cet article, vous créez votre premier flux de données, vous obtenez des données pour votre flux de données, puis vous transformez les données et publiez le flux de données.

Prérequis

Les prérequis suivants sont requis avant de commencer :

- Un compte de locataire Microsoft Fabric avec un abonnement actif. Créez un compte gratuit.

- Vérifiez que vous disposez d’un espace de travail avec Microsoft Fabric : Créer un espace de travail.

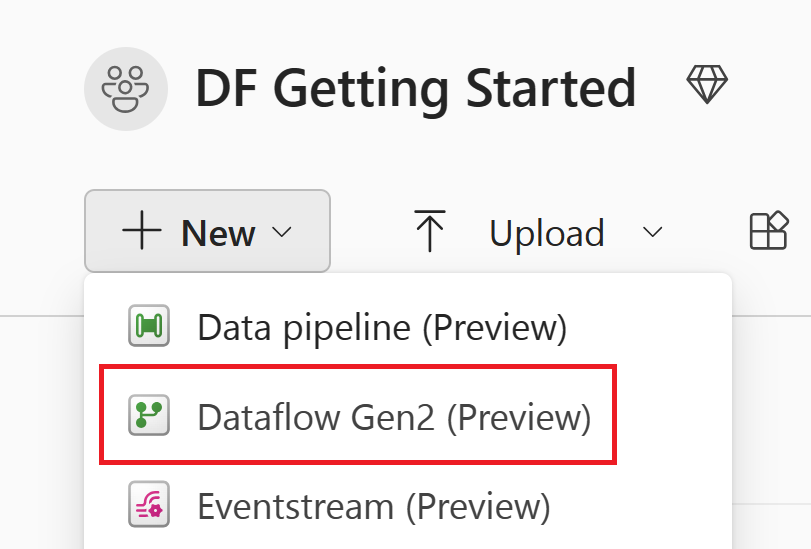

Créer un flux de données

Dans cette section, vous créez votre premier flux de données.

Accédez à votre espace de travail Microsoft Fabric.

Sélectionnez +Nouvel élément, puis sélectionnez Dataflow Gen2.

Obtenir des données

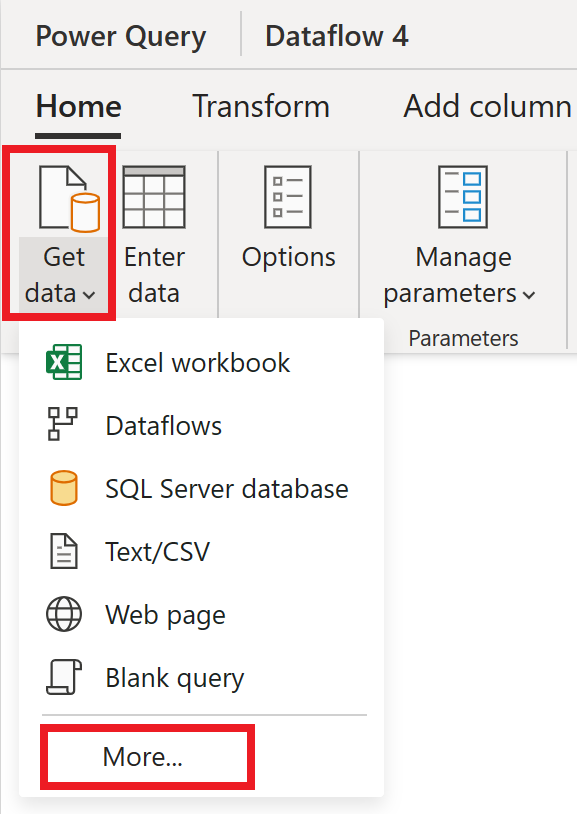

Nous allons maintenant obtenir des données. Dans cet exemple, vous obtenez des données à partir d’un service OData. Procédez comme suit pour obtenir des données dans votre flux de données.

Dans l’éditeur de flux de données, sélectionnez Obtenir des données, puis Plus.

Dans Choisir une source de données, sélectionnez Afficher plus.

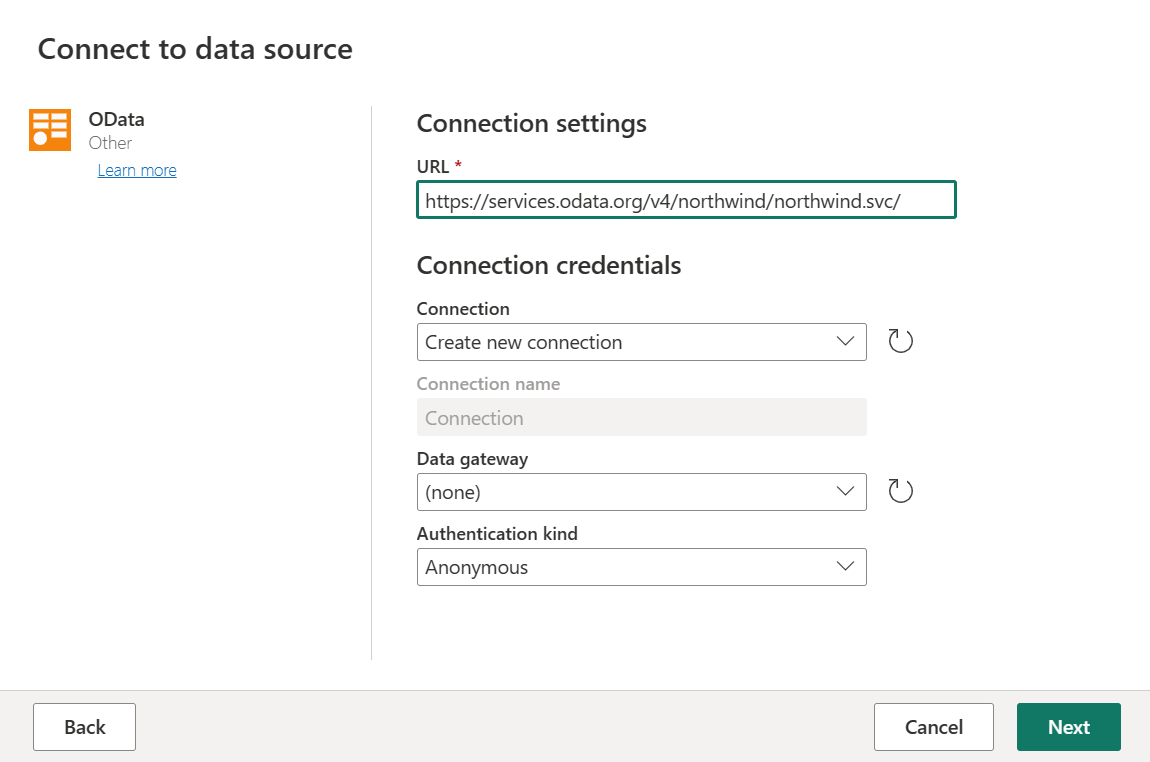

Dans Nouvelle source, sélectionnez Autre>OData comme source de données.

Entrez l’URL

https://services.odata.org/v4/northwind/northwind.svc/, puis sélectionnez Suivant.

Sélectionnez les tables Commandes et Clients, puis cliquez sur Créer.

Vous pouvez en savoir plus sur l’expérience et les fonctionnalités d’obtention de données dans la vue d’ensemble de l’obtention des données.

Appliquer des transformations et publier

Vous avez chargé vos données dans votre premier dataflow. Félicitations ! Maintenant, il est temps d’appliquer quelques transformations pour intégrer ces données dans la forme dont nous avons besoin.

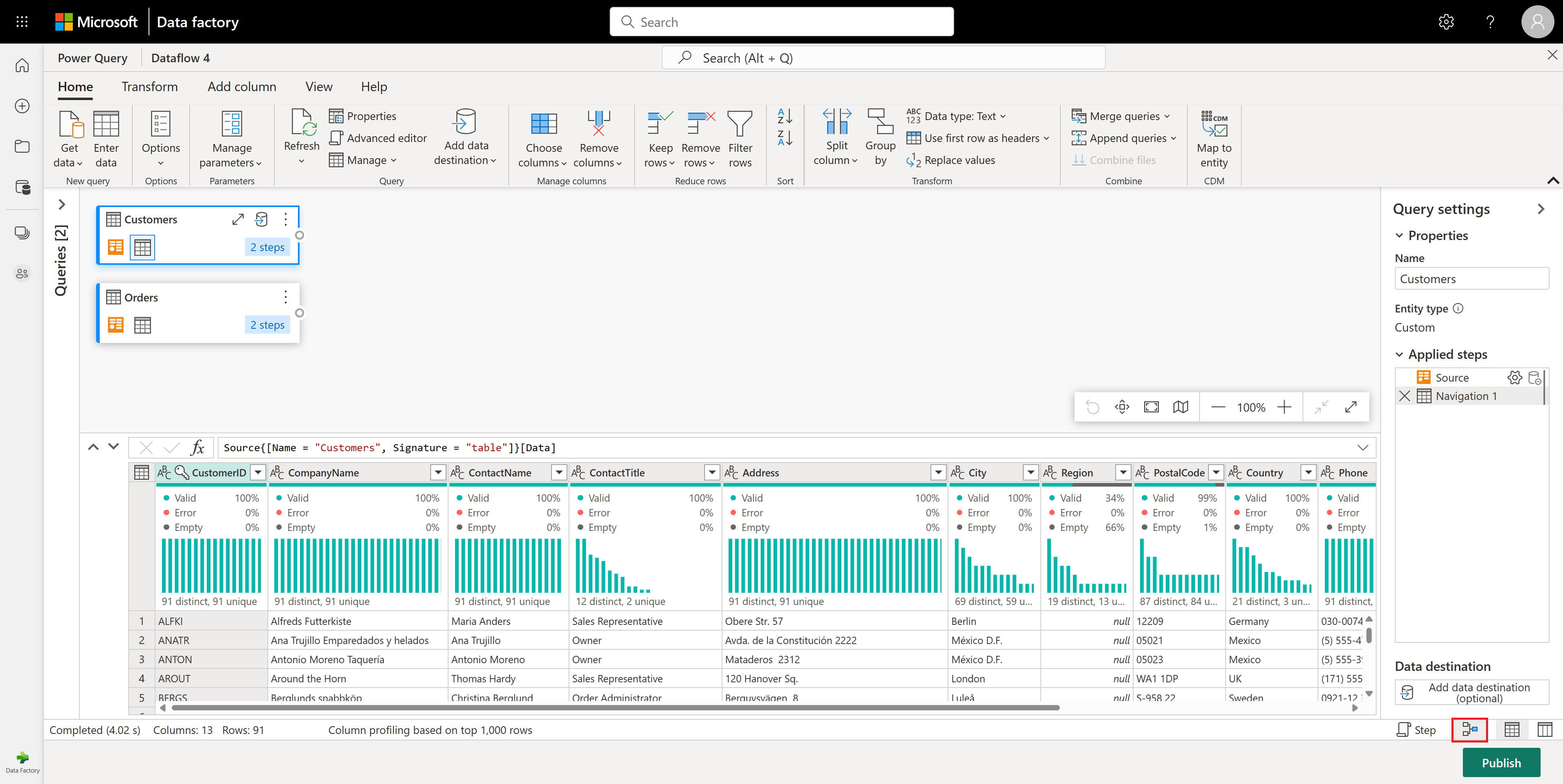

Vous transformez les données dans l’éditeur Power Query. Vous trouverez une vue d’ensemble détaillée de l’éditeur Power Query sur l’interface utilisateur power Query, mais cette section vous guide dans les étapes de base :

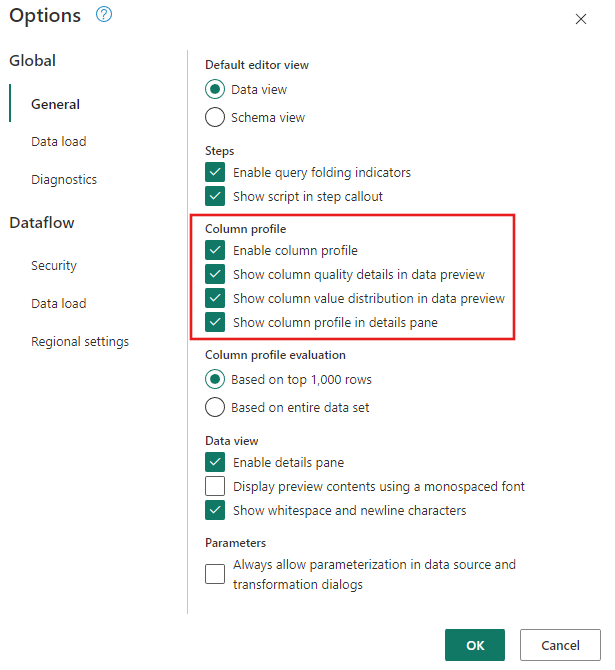

Vérifiez que les outils de profilage des données sont activés. Accédez à d’accueil>Options>Options globales, puis sélectionnez toutes les options sous Profil de colonne.

Veillez également à activer la vue diagramme à l’aide des configurations de disposition sous l’onglet Affichage dans le ruban de l’éditeur Power Query, ou en sélectionnant l’icône d’affichage de diagramme en bas à droite de la fenêtre Power Query.

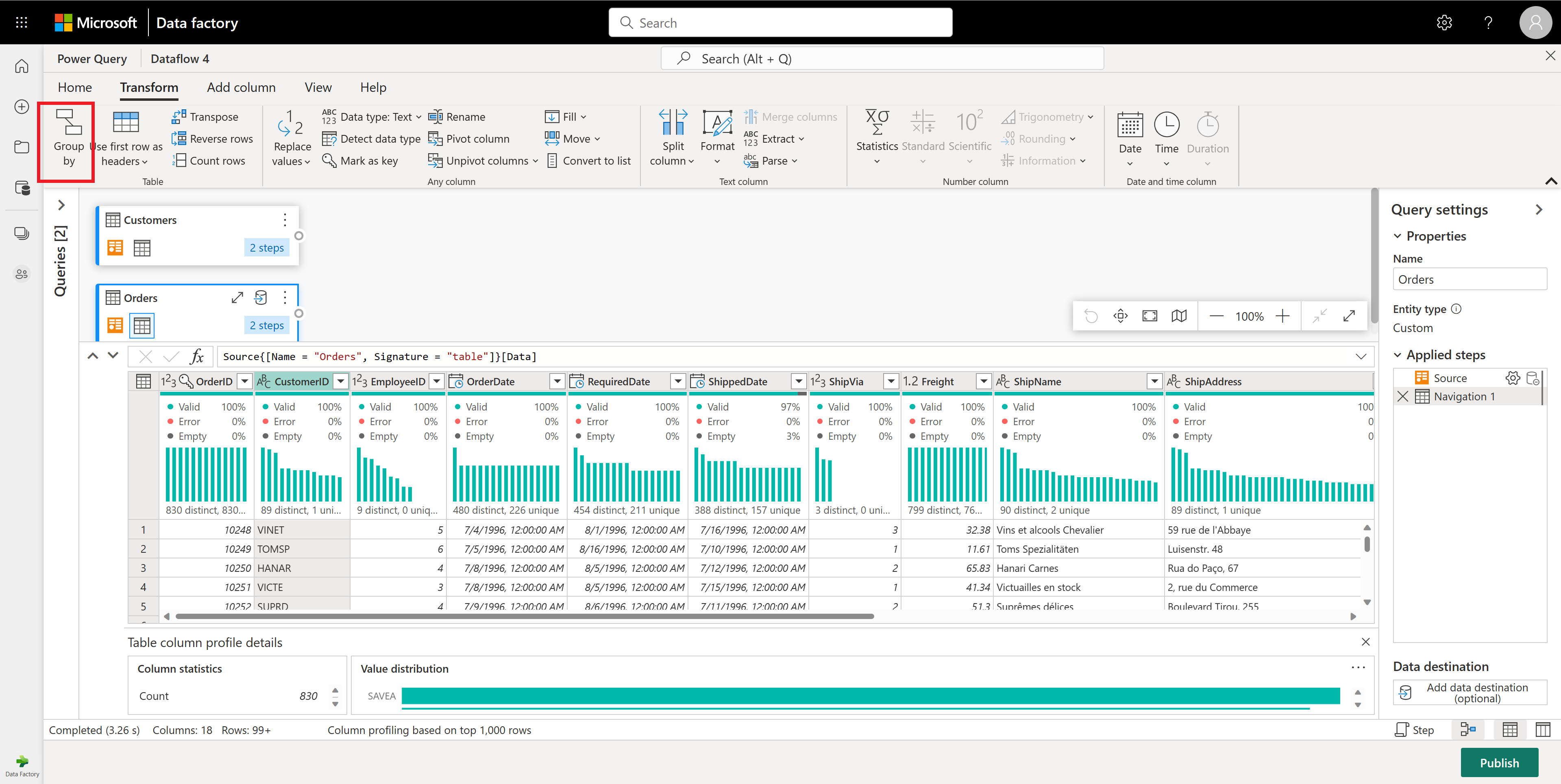

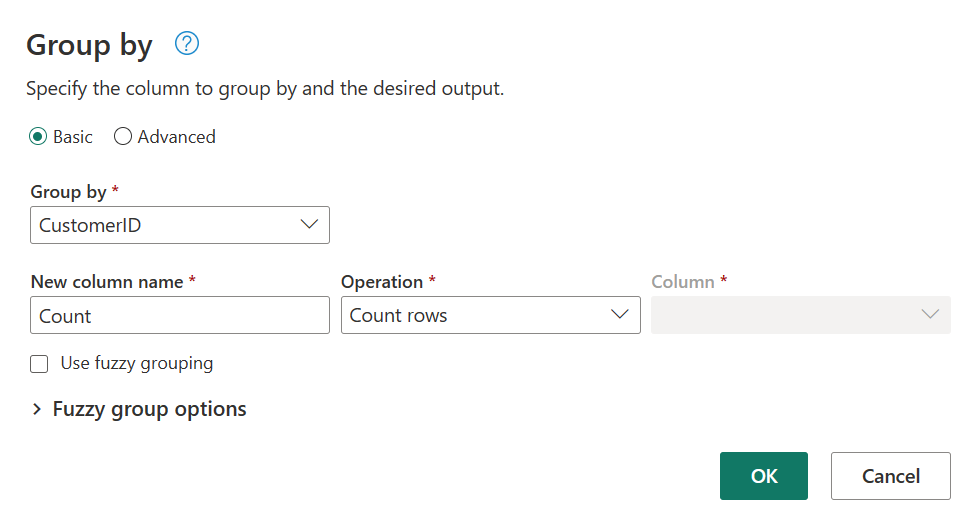

Dans la table Commandes, calculez le nombre total de commandes par client : sélectionnez la colonne CustomerID dans l’aperçu des données, puis sélectionnez Regrouper par sous l’onglet Transformation du ruban.

Vous effectuez un compte des lignes en tant qu’agrégation dans Regrouper par. Vous pouvez en savoir plus sur les fonctionnalités group by dans le regroupement ou la synthèse des lignes.

Après avoir groupé les données dans la table Commandes, nous obtenons une table avec deux colonnes : CustomerID et Compte.

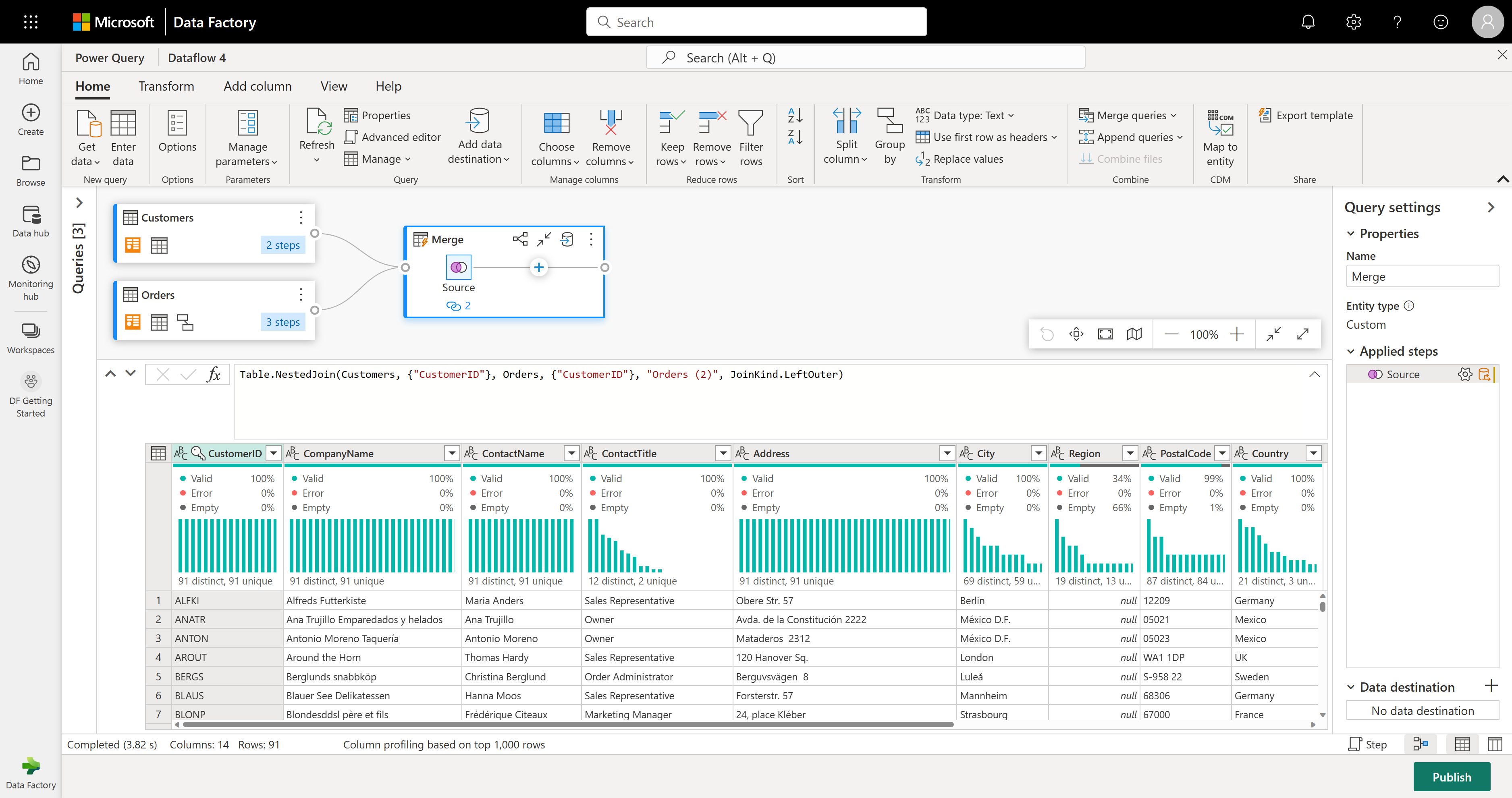

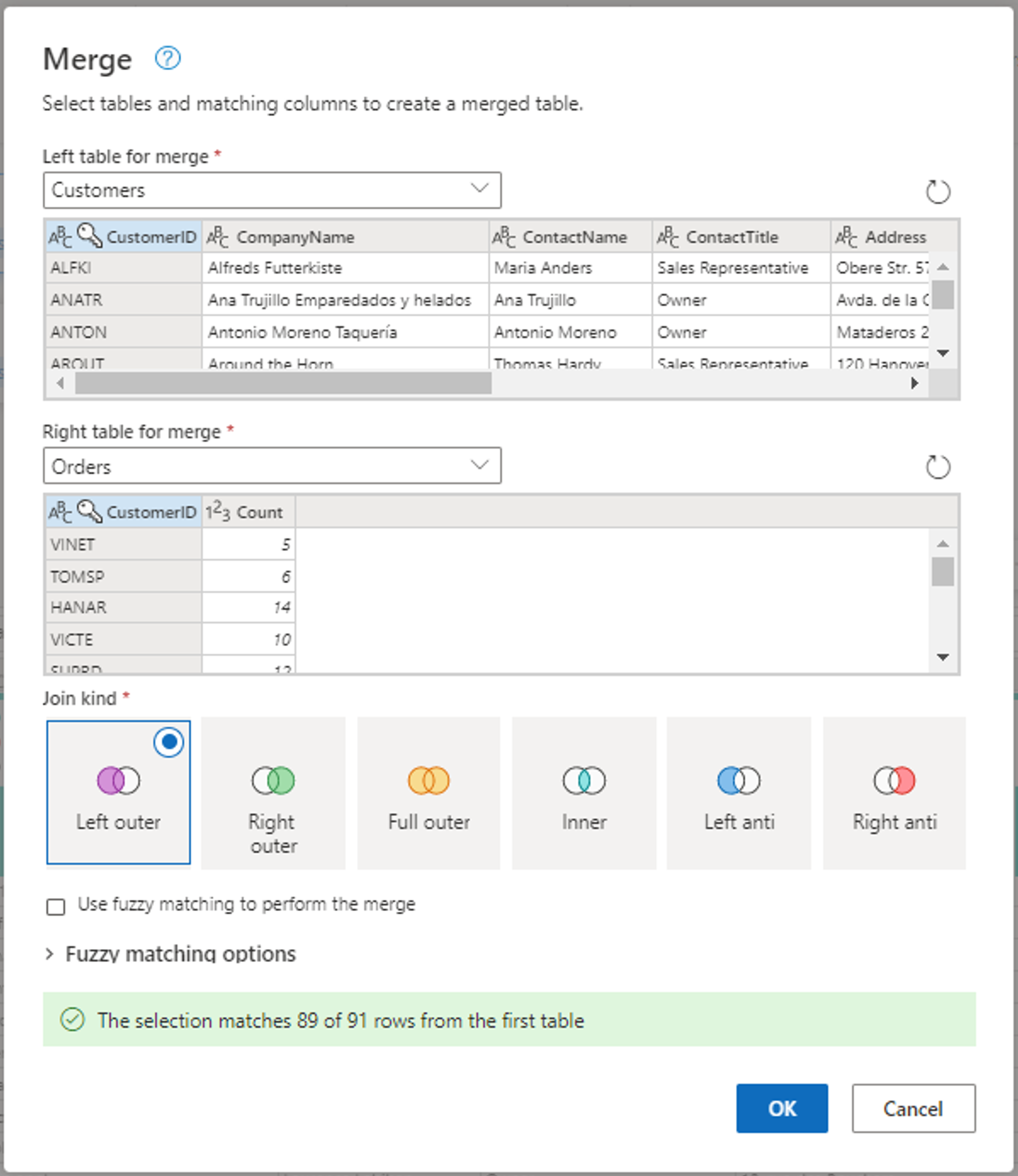

Ensuite, vous souhaitez combiner des données de la table Customers avec le nombre de commandes par client : sélectionnez la requête Clients dans la vue diagramme et utilisez le menu « ⋮ » pour accéder aux requêtes de fusion en tant que nouvelle transformation.

Configurez l’opération de fusion en sélectionnant CustomerID comme colonne correspondante dans les deux tables. Sélectionnez ensuite Ok.

Capture d’écran de la fenêtre Fusionner, avec la table de gauche pour la fusion définie sur la table Clients et la table de droite pour la fusion définie sur la table Commandes. La colonne CustomerID est sélectionnée pour les tables Clients et Commandes. En outre, l’option Type de jointure est définie sur Externe gauche. Toutes les autres sélections sont définies sur leur valeur par défaut.

Il existe maintenant une nouvelle requête avec toutes les colonnes de la table Customers et une colonne avec des données imbriquées de la table Orders.

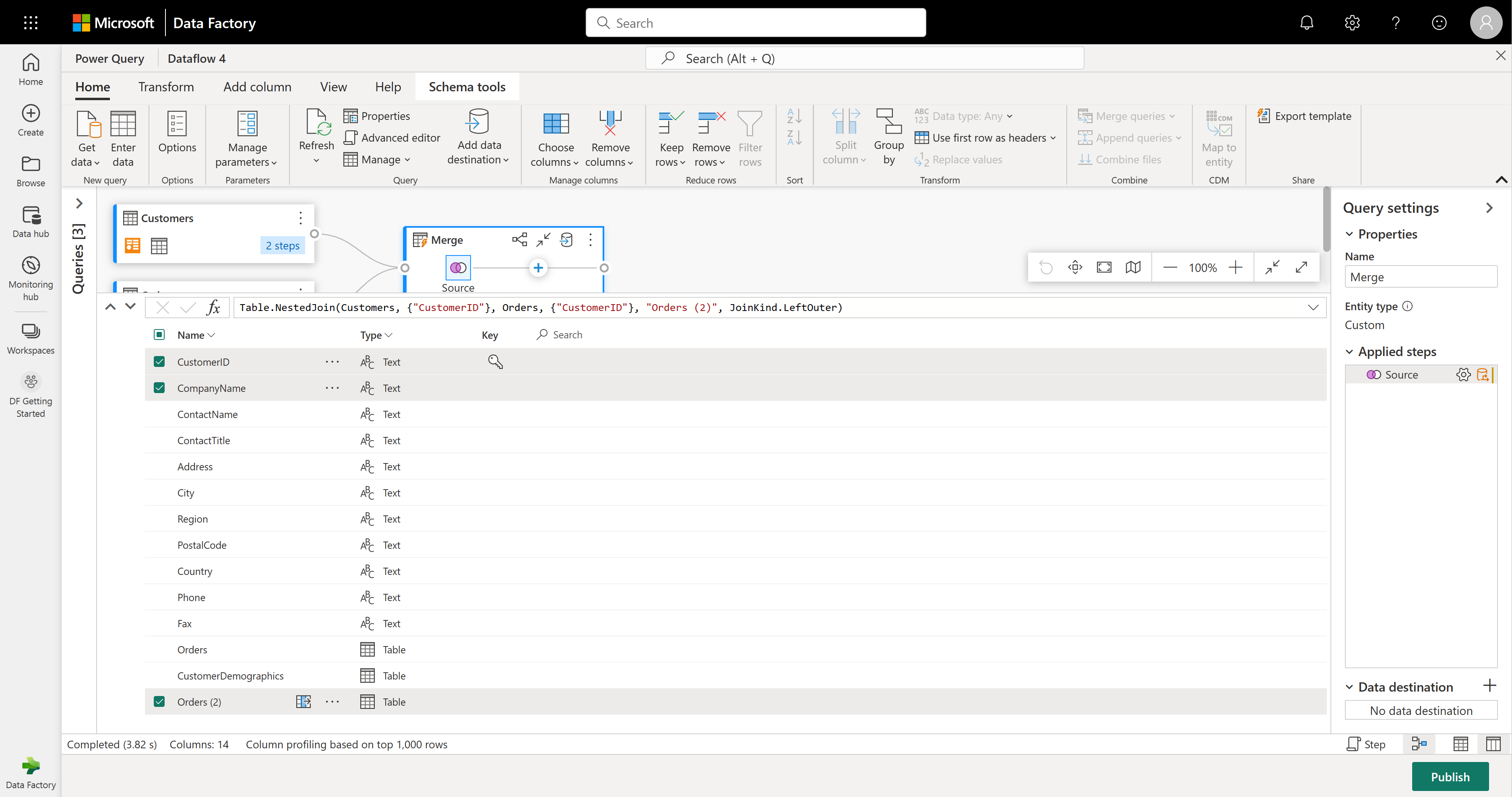

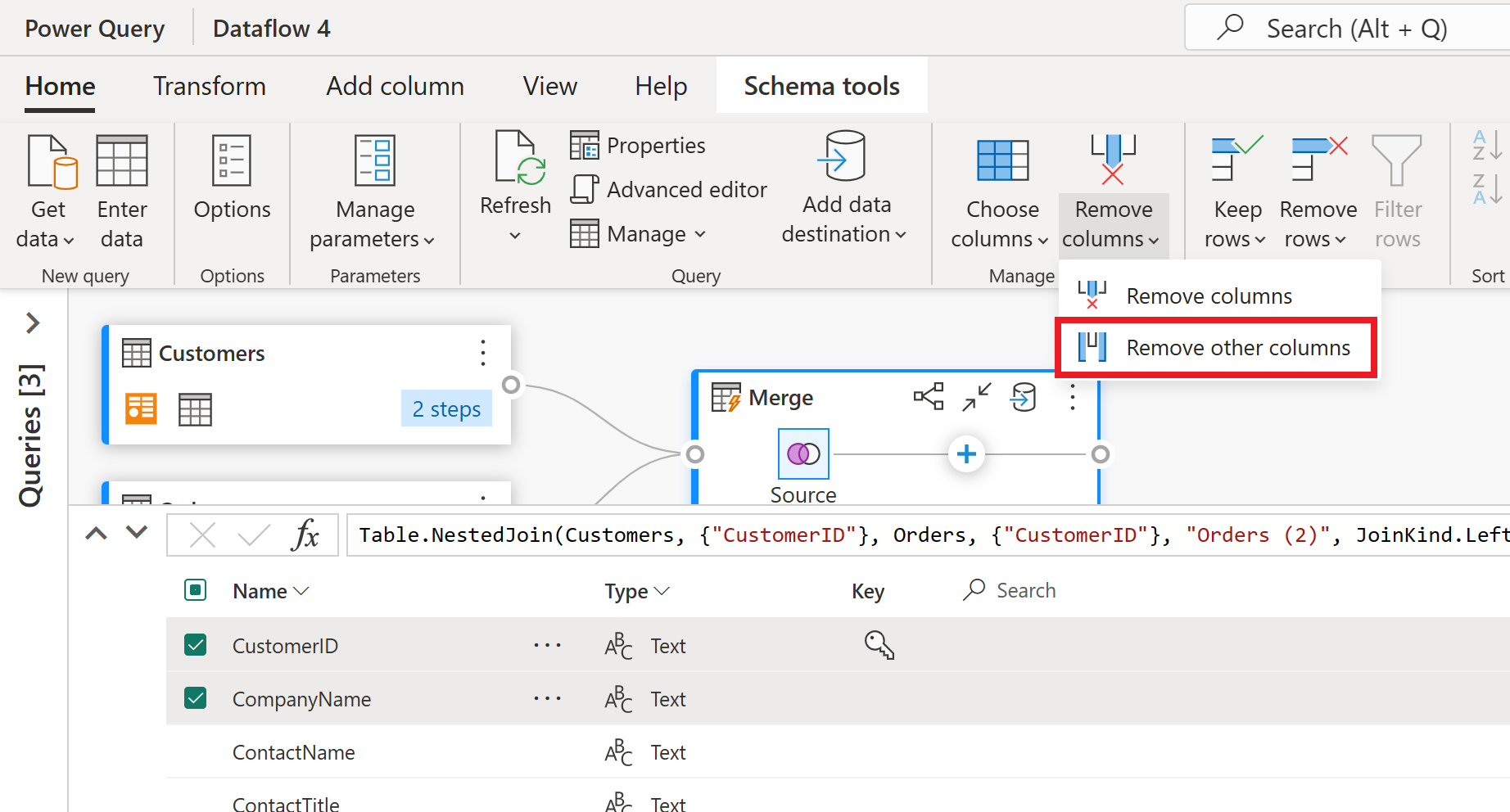

Nous allons nous concentrer sur quelques colonnes du tableau Customers. Pour ce faire, activez l’affichage de schéma en sélectionnant le bouton d’affichage de schéma dans le coin inférieur droit de l’éditeur de flux de données.

En mode Schéma, vous verrez toutes les colonnes de votre table. Sélectionnez CustomerID, CompanyName et Orders (2). Ensuite, accédez à l’onglet Outils de schéma , sélectionnez Supprimer les colonnes, puis sélectionnez Supprimer d’autres colonnes. Cela conserve uniquement les colonnes souhaitées.

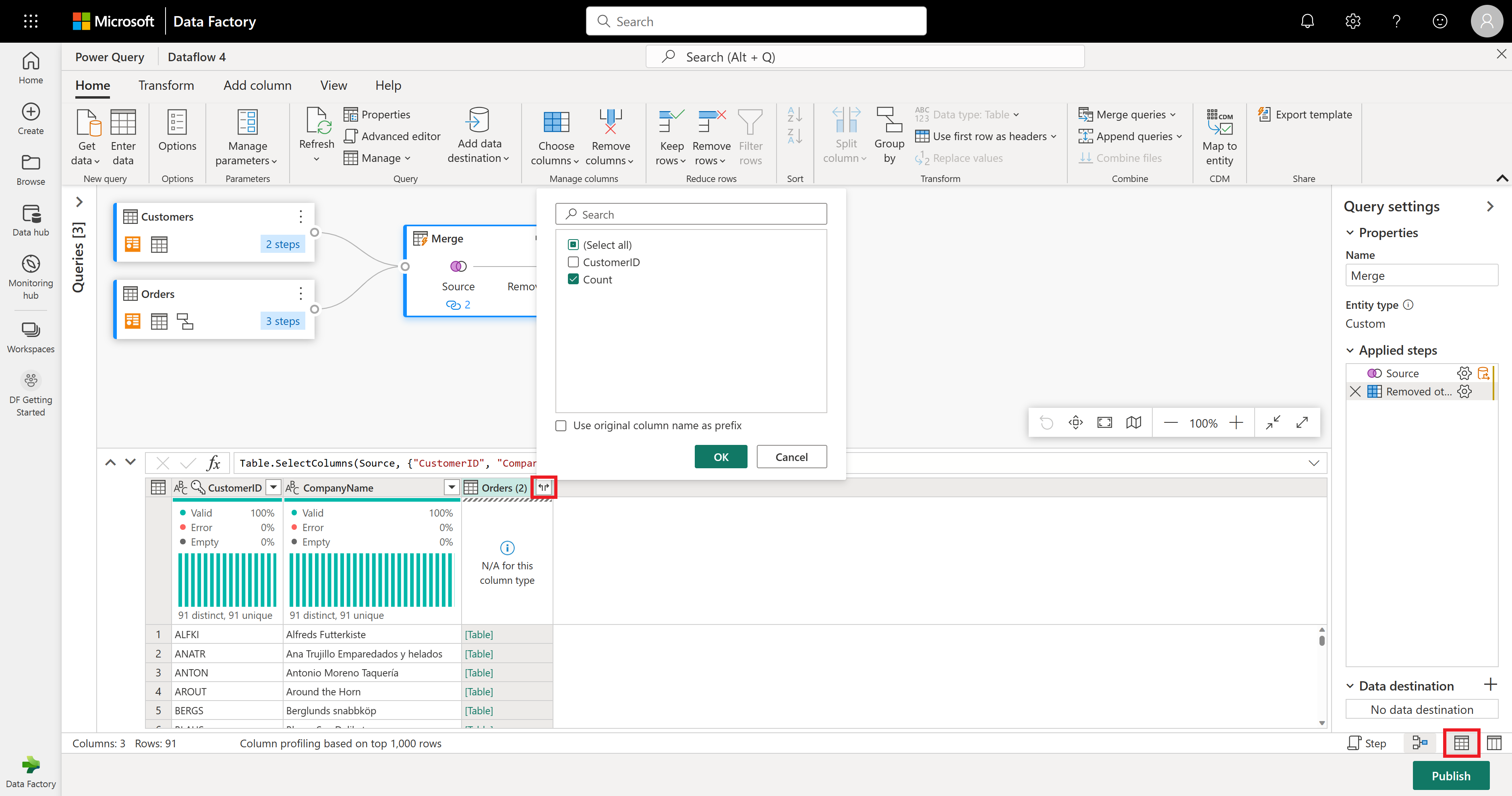

La colonne Orders (2) contient des détails supplémentaires de l’étape de fusion. Pour afficher et utiliser ces données, sélectionnez le bouton Afficher la vue données dans le coin inférieur droit, en regard de l’affichage du schéma. Ensuite, dans l'en-tête de la colonne Orders (2), sélectionnez l'icône Développer la colonne et choisissez la colonne Count. Cela ajoute le nombre de commandes pour chaque client à votre table.

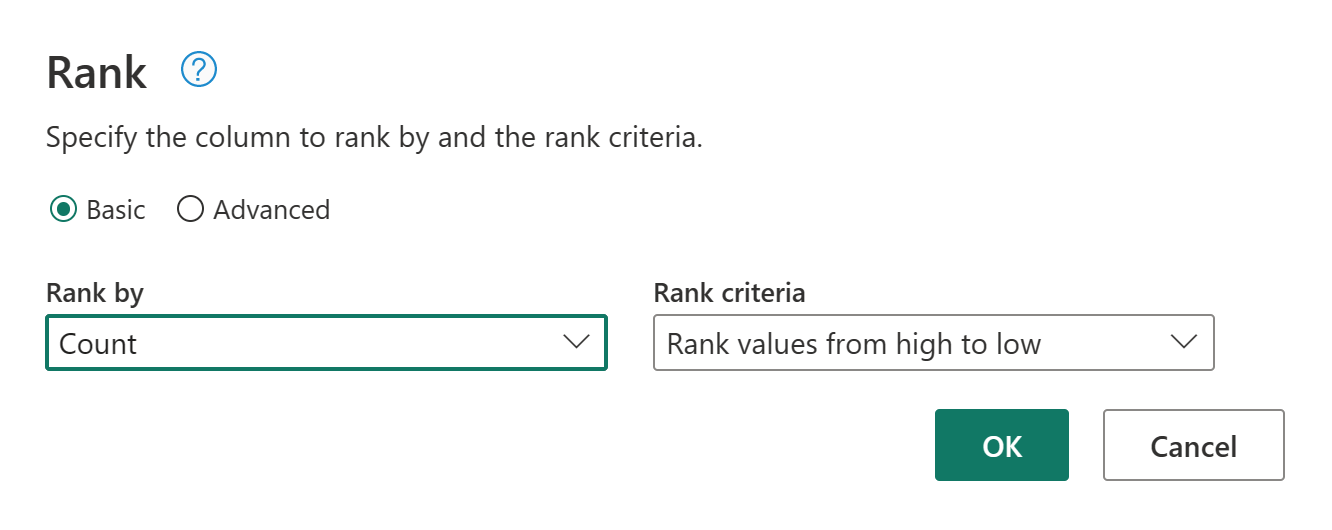

Nous allons maintenant classer vos clients en fonction du nombre de commandes qu’ils ont effectuées. Sélectionnez la colonne Count , puis accédez à l’onglet Ajouter une colonne, puis sélectionnez Colonne De classement. Cela ajoute une nouvelle colonne montrant le classement de chaque client en fonction de son nombre de commandes.

Conservez les paramètres par défaut dans Colonne de rang. Sélectionnez ensuite OK pour appliquer cette transformation.

À présent, renommez la requête obtenue en Clients classés à l’aide du volet Paramètres de la requête sur le côté droit de l’écran.

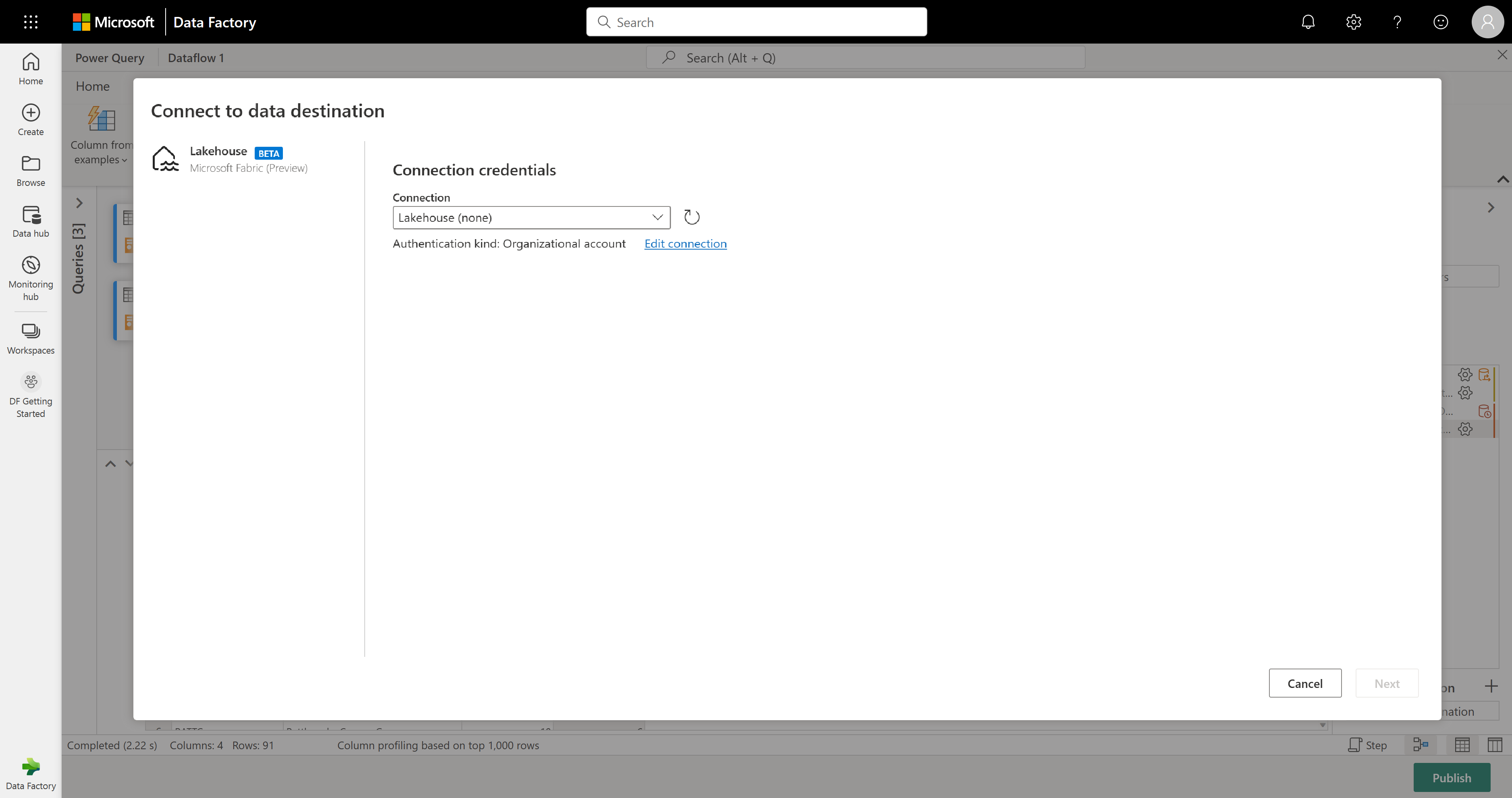

Vous êtes prêt à définir l’emplacement de vos données. Dans le volet Paramètres de requête , faites défiler vers le bas et sélectionnez Choisir la destination des données.

Vous pouvez envoyer vos résultats à un "lakehouse" si vous en avez un, ou ignorer cette étape sinon. Ici, vous pouvez choisir le lakehouse et la table que vous souhaitez utiliser pour vos données, et décider si vous souhaitez ajouter de nouvelles données (Append) ou remplacer celles qui s'y trouvent (Remplacer).

Votre flux de données est maintenant prêt à être publié. Passez en revue les requêtes dans la vue des diagrammes, puis sélectionnez Publier.

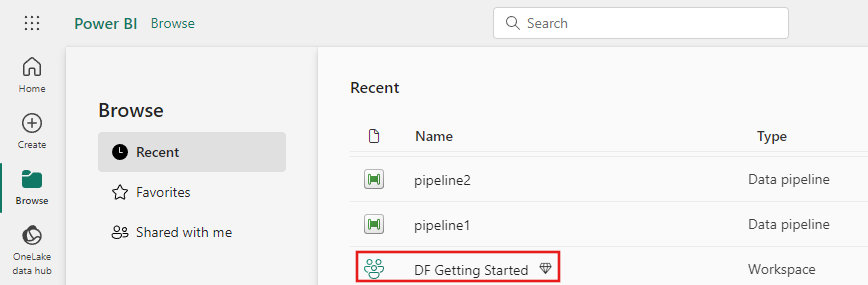

Sélectionnez Publier dans le coin inférieur droit pour enregistrer votre dataflow. Vous revenez à votre espace de travail, où une icône spinner en regard de votre nom de flux de données affiche sa publication. Lorsque le spinner disparaît, votre dataflow est prêt à s’actualiser !

Important

La première fois que vous créez un Dataflow Gen2 dans un espace de travail, Fabric configure certains éléments d’arrière-plan (Lakehouse et Warehouse) qui aident votre flux de données à s’exécuter. Ces éléments sont partagés par tous les flux de données dans l’espace de travail et vous ne devez pas les supprimer. Ils ne sont pas destinés à être utilisés directement et ne sont généralement pas visibles dans votre espace de travail, mais vous pouvez les voir dans d’autres endroits tels que Notebooks ou l’analytique SQL. Recherchez les noms qui commencent par

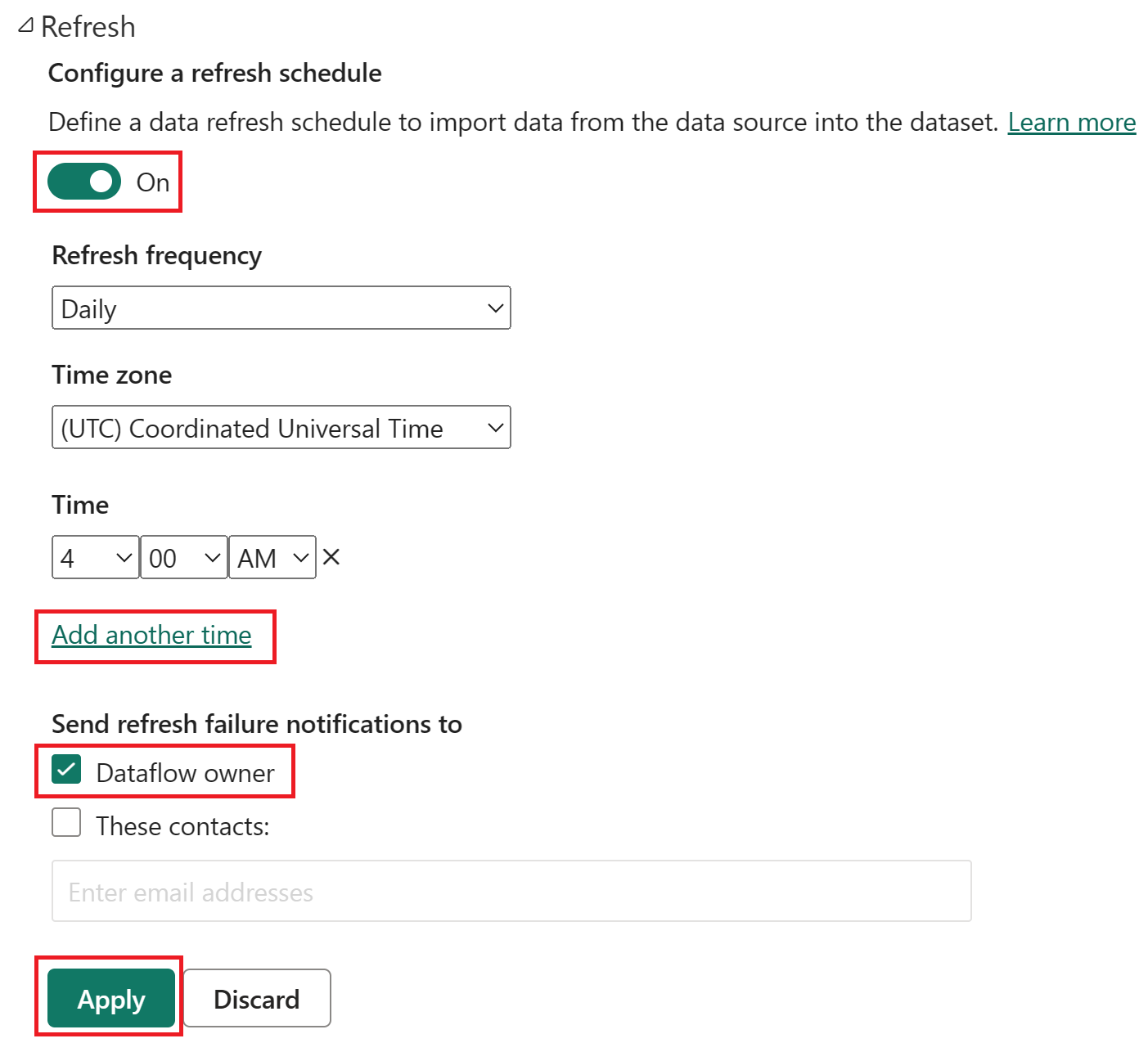

DataflowStagingpour les repérer.Dans votre espace de travail, sélectionnez l’icône Planifier l’actualisation.

Activez l’actualisation planifiée, sélectionnez Ajouter un autre horaire, puis configurez l’actualisation comme illustré dans la capture d’écran suivante.

Capture d’écran des options d’actualisation planifiée, avec l’actualisation planifiée activée, la fréquence d’actualisation définie sur Quotidienne, le fuseau horaire défini sur l’heure universelle coordonnée et l’horaire défini sur 4h00. Le bouton activé, la sélection Ajouter un autre horaire, le propriétaire du flux de données et le bouton appliquer sont tous mis en évidence.

Nettoyer les ressources

Si vous ne prévoyez pas de continuer à utiliser ce flux de données, supprimez-le en effectuant les étapes suivantes :

Accédez à votre espace de travail Microsoft Fabric.

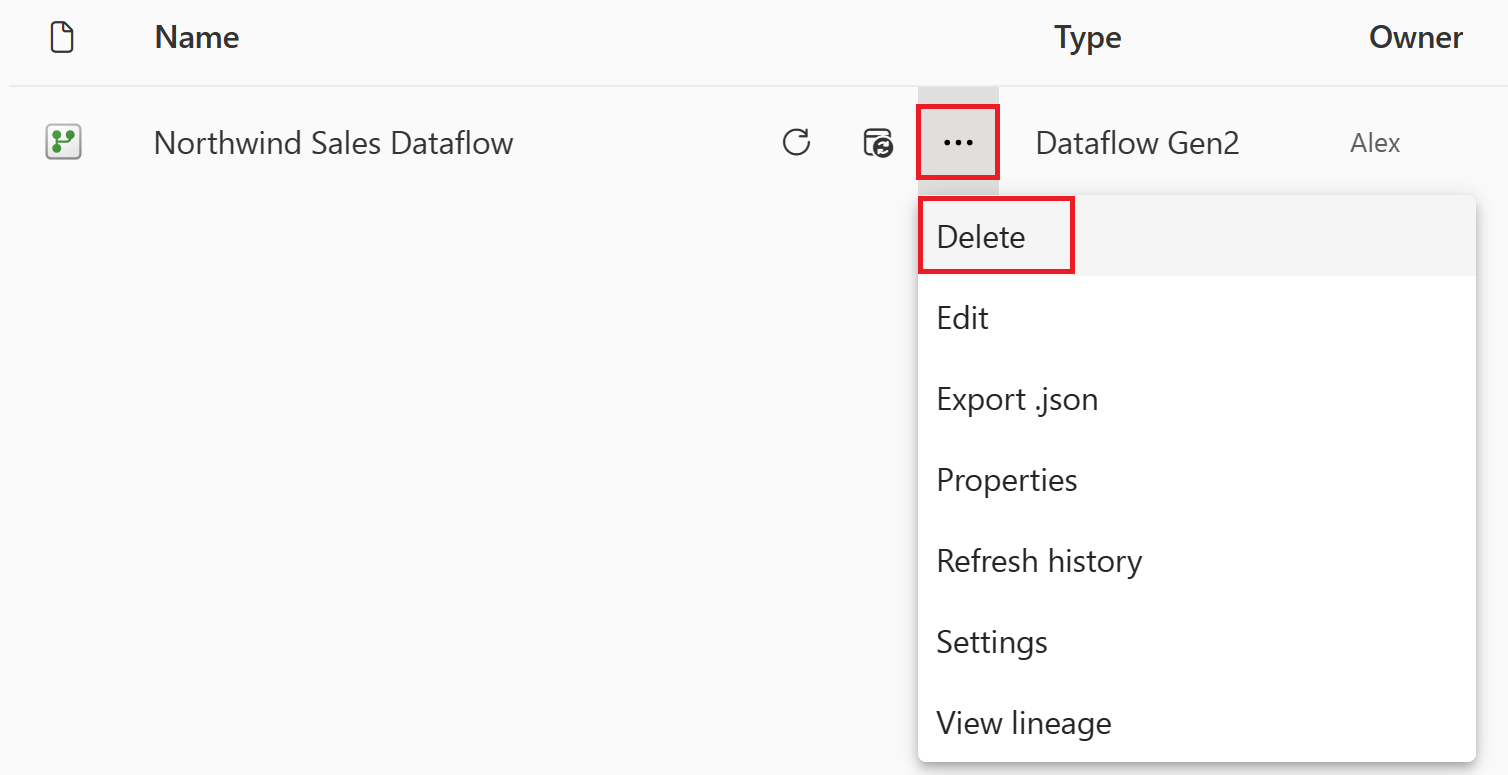

Sélectionnez les ellipses verticales en regard du nom de votre flux de données, puis sélectionnez Supprimer.

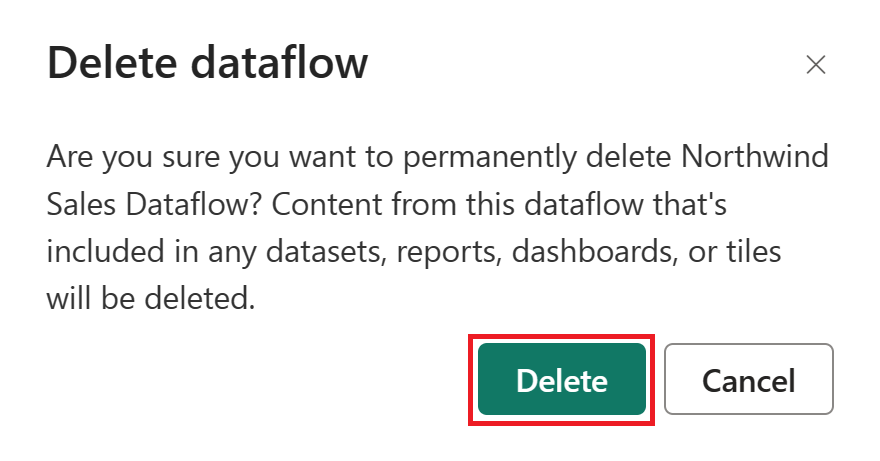

Sélectionnez Supprimer pour confirmer la suppression de votre flux de données.

Contenu connexe

Le flux de données de cet exemple vous montre comment charger et transformer des données dans Flux de données Gen2. Vous avez appris à :

- Créer un Flux de données Gen2.

- Transformer les données.

- Configurez les paramètres de destination pour les données transformées.

- Exécutez et planifiez votre pipeline.

Passez à l’article suivant pour découvrir comment créer votre premier pipeline.