Connecteurs Power Query (préversion - mis hors service)

Important

La prise en charge des connecteurs Power Query a été introduite en tant que préversion publique contrôlée sous Conditions d’utilisation supplémentaires des Préversions Microsoft Azure, mais est maintenant abandonnée. Si vous avez une solution de recherche qui utilise un connecteur Power Query, migrez vers une autre solution.

La préversion des connecteurs Power Query a été annoncée en mai 2021 et ne passera pas en disposition générale. Les conseils de migration suivants sont disponibles pour Snowflake et PostgreSQL. Si vous utilisez un autre connecteur et que vous avez besoin d’instructions de migration, utilisez les informations de contact par e-mail fournies dans votre préversion pour demander de l’aide ou ouvrir un ticket auprès du support Azure.

- Un compte de stockage Azure. Si vous n’en avez pas, créez un compte de stockage.

- Fabrique Azure Data Factory. Si vous n’en avez pas, créez une fabrique de données. Consultez Tarification Pipeline de données avant l’implémentation pour comprendre les coûts associés. Consultez également Comprendre les tarifs Data Factory à travers des exemples

Cette section explique comment copier des données d’une base de données Snowflake vers un index Recherche cognitive Azure. Il n’existe aucun processus d’indexation directe de Snowflake vers Recherche cognitive Azure. Cette section inclut donc une phase intermédiaire qui copie le contenu de la base de données dans un conteneur d’objets blob Stockage Azure. Vous indexerez ensuite à partir de ce conteneur intermédiaire à l’aide d’un pipeline Data Factory.

Accédez à Snowflake et connectez-vous à votre compte Snowflake. Un compte Snowflake ressemble à https://< nom_compte.snowflakecomputing.com>.

Une fois connecté, collectez les informations suivantes à partir du volet gauche. Vous utiliserez ces informations à l’étape suivante :

- Dans Data, sélectionnez Databases et copiez le nom de la source de base de données.

- Dans Administration, sélectionnez Utilisateurs & Rôles et copiez le nom de l’utilisateur. Vérifiez que l’utilisateur dispose d’autorisations de lecture.

- Dans Admin, sélectionnez Accounts et copiez la valeur LOCATOR du compte.

- À partir de l’URL Snowflake, similaire à

https://app.snowflake.com/<region_name>/xy12345/organization), copiez le nom de la région. Par exemple, danshttps://app.snowflake.com/south-central-us.azure/xy12345/organization, le nom de la région estsouth-central-us.azure. - Dans Admin, sélectionnez Warehouses et copiez le nom de l’entrepôt associé à la base de données que vous utiliserez comme source.

Connectez-vous à Azure Data Factory Studio avec votre compte Azure.

Sélectionnez votre fabrique de données, puis Continuer.

Dans le menu de gauche, sélectionnez l’icône Gérer.

Sous Services liés, sélectionnez Nouveau.

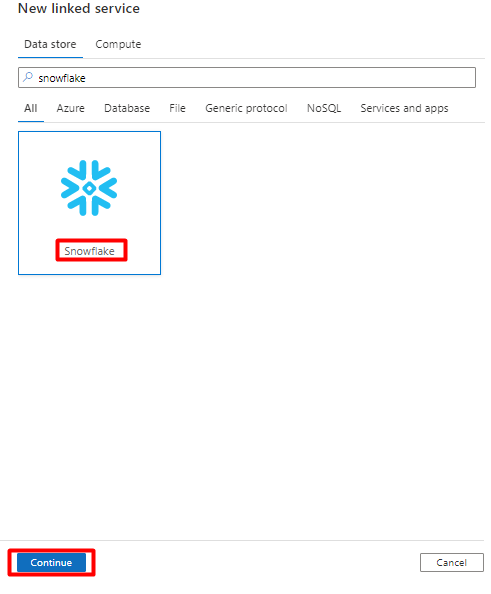

Dans le volet droit, dans la recherche de magasin de données, entrez « snowflake ». Sélectionnez la vignette Snowflake, puis Continuer.

Remplissez le formulaire Nouveau service lié avec les données que vous avez collectées à l’étape précédente. Le Nom du compte inclut une valeur LOCATOR et la région (par exemple :

xy56789south-central-us.azure).

Une fois le formulaire rempli, sélectionnez Tester la connexion.

Si le test réussit, sélectionnez Créer.

Dans le menu de gauche, sélectionnez l’icône Créer.

Sélectionnez Jeux de données, puis sélectionnez le menu

...Actions de jeux de données.

Sélectionnez Nouveau jeu de données.

Dans le volet droit, dans la recherche de magasin de données, entrez « snowflake ». Sélectionnez la vignette Snowflake, puis Continuer.

Dans Définir les propriétés :

- Sélectionnez le service lié que vous avez créé à l’Étape 2.

- Sélectionnez la table que vous souhaitez importer, puis OK.

Sélectionnez Enregistrer.

Créez un index dans votre service Recherche cognitive Azure avec le même schéma que celui configuré actuellement pour vos données Snowflake.

Vous pouvez réaffecter l’index que vous utilisez actuellement pour le connecteur Power Snowflake. Dans le portail Azure, recherchez l’index, puis sélectionnez Définition d’index (JSON). Sélectionnez la définition et copiez-la dans le corps de votre nouvelle requête d’index.

Dans le menu de gauche, sélectionnez l’icône Gérer.

Sous Services liés, sélectionnez Nouveau.

Dans le volet droit, dans la recherche de magasin de données, entrez « recherche ». Sélectionnez la vignette Recherche Azure, puis Continuer.

Renseignez les valeurs de Nouveau service lié :

- Choisissez l’abonnement Azure dans lequel réside votre service Recherche cognitive Azure.

- Choisissez le service Recherche cognitive Azure qui a votre indexeur de connecteur Power Query.

- Sélectionnez Create (Créer).

Dans le menu de gauche, sélectionnez l’icône Créer.

Sélectionnez Jeux de données, puis sélectionnez le menu

...Actions de jeux de données.

Sélectionnez Nouveau jeu de données.

Dans le volet droit, dans la recherche de magasin de données, entrez « recherche ». Sélectionnez la vignette Recherche Azure, puis Continuer.

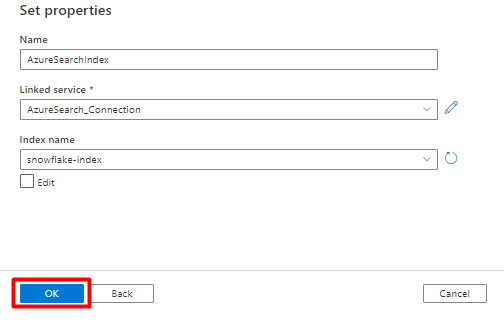

Dans Définir les propriétés :

Sélectionnez Enregistrer.

Dans le menu de gauche, sélectionnez l’icône Gérer.

Sous Services liés, sélectionnez Nouveau.

Dans le volet droit, dans la recherche de magasin de données, entrez « stockage ». Sélectionnez la vignette Stockage Blob Azure, puis Continuer

Renseignez les valeurs de Nouveau service lié :

Choisissez le type d’authentification : URI SAS. Seul ce type d’authentification peut être utilisé pour importer des données de Snowflake dans Stockage Blob Azure.

Générez une URL SAS pour le compte de stockage que vous utiliserez pour la préproduction. Collez l’URL SAS d’objet blob dans le champ URL SAS.

Sélectionnez Create (Créer).

Dans le menu de gauche, sélectionnez l’icône Créer.

Sélectionnez Jeux de données, puis sélectionnez le menu

...Actions de jeux de données.

Sélectionnez Nouveau jeu de données.

Dans le volet droit, dans la recherche de magasin de données, entrez « stockage ». Sélectionnez la vignette Stockage Blob Azure, puis Continuer

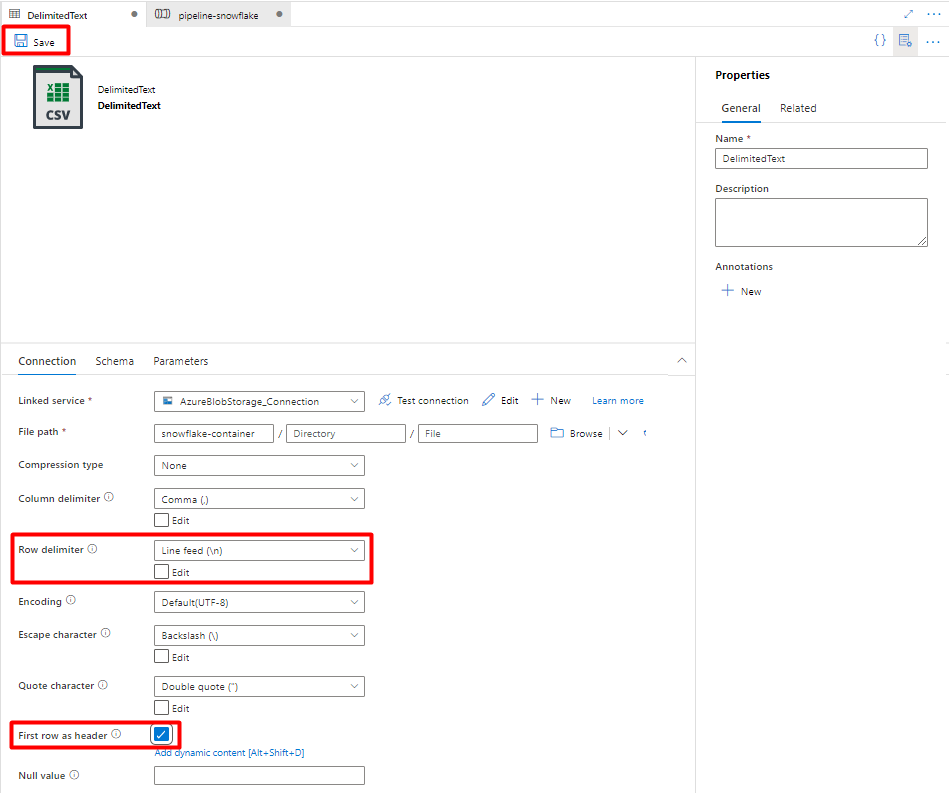

Sélectionnez le format DelimitedText, puis Continuer.

Dans Définir les propriétés :

Sous Service lié, sélectionnez le service lié créé à l’Étape 7.

Sous Chemin de fichier, choisissez le conteneur qui sera le récepteur du processus intermédiaire, puis sélectionnez OK.

Dans Délimiteur de lignes, sélectionnez Saut de ligne (\n).

Cochez la case Utiliser la première ligne comme en-tête.

Sélectionnez Enregistrer.

Dans le menu de gauche, sélectionnez l’icône Créer.

Sélectionnez Pipelines, puis le menu

...Actions de pipelines.

Sélectionnez Nouveau pipeline.

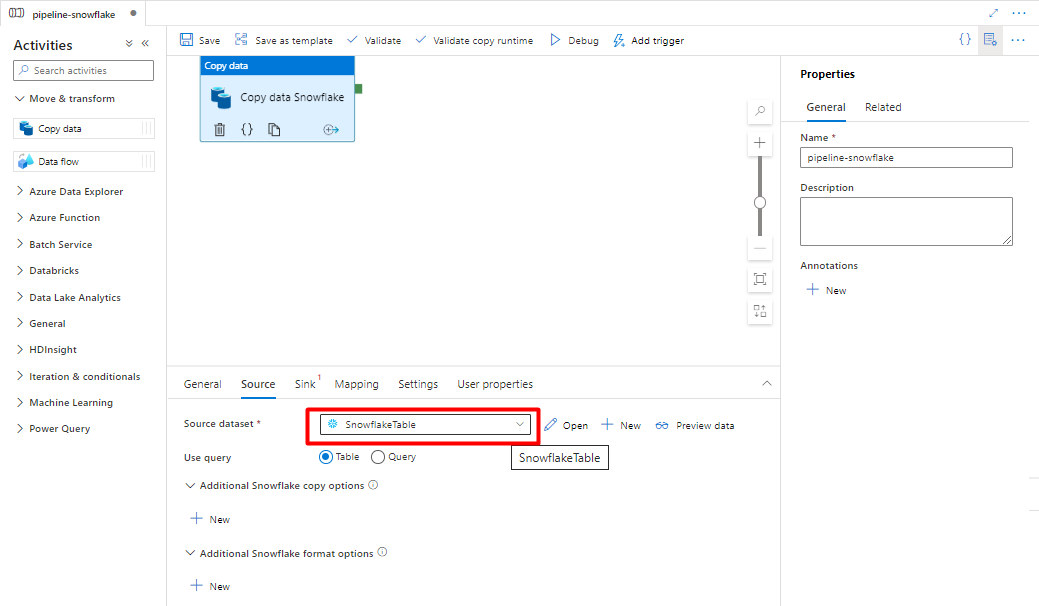

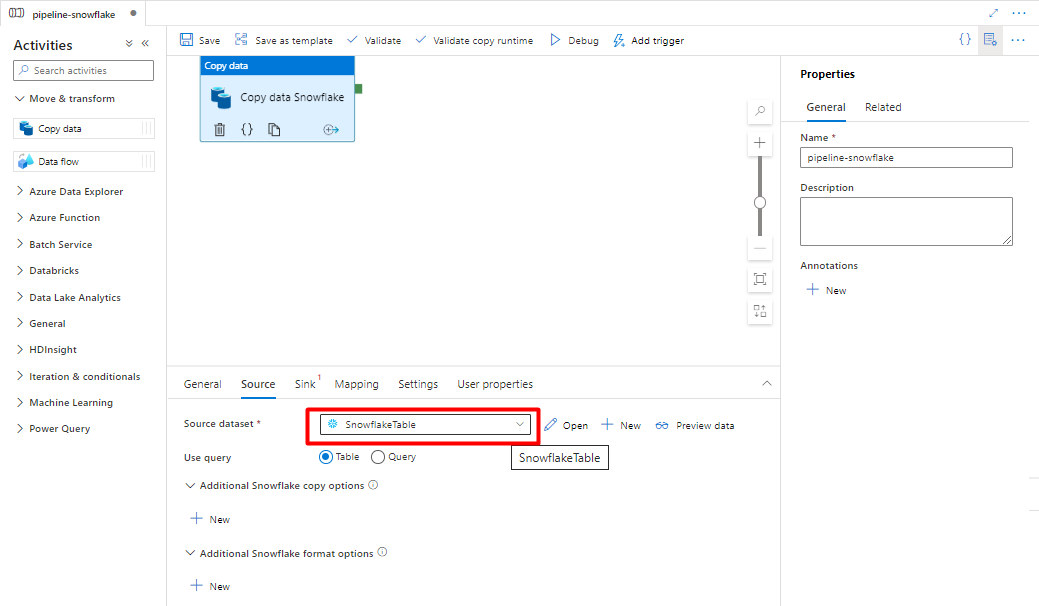

Créez et configurez les activités Data Factory qui copient de Snowflake vers le conteneur Stockage Azure :

Développez Déplacer & section transformer et faites glisser-déplacer l’activité Copier des données dans le canevas de l’éditeur de pipeline vide.

Ouvrez l’onglet Général. Acceptez les valeurs par défaut, sauf si vous devez personnaliser l’exécution.

Sous l’onglet Source, sélectionnez votre table Snowflake. Conservez les valeurs par défaut des options restantes.

Sous l’onglet Récepteur :

Sélectionnez le jeu de données Stockage DelimitedText créé à l’Étape 8.

Dans Extension de fichier, ajoutez .csv.

Conservez les valeurs par défaut des options restantes.

Sélectionnez Enregistrer.

Configurez les activités qui copient de Stockage Blob Azure vers un index de recherche :

Développez Déplacer & section transformer et faites glisser-déplacer l’activité Copier des données dans le canevas de l’éditeur de pipeline vide.

Sous l’onglet Général, acceptez les valeurs par défaut, sauf si vous devez personnaliser l’exécution.

Sous l’onglet Source :

- Sélectionnez le jeu de données Stockage DelimitedText créé à l’Étape 8.

- Dans Type de chemin de fichier, sélectionnez Chemin de fichier générique.

- Conservez les valeurs par défaut pour tous les champs restants.

Sous l’onglet Récepteur, sélectionnez votre index Recherche cognitive Azure. Conservez les valeurs par défaut des options restantes.

Sélectionnez Enregistrer.

Dans l’éditeur de canevas de pipeline, sélectionnez le petit carré vert au bord de la vignette d’activité du pipeline. Faites-le glisser vers l’activité « Index de compte de stockage vers Recherche cognitive Azure » pour définir l’ordre d’exécution.

Sélectionnez Enregistrer.

Sélectionnez Ajouter un déclencheur pour planifier l’exécution du pipeline, puis Nouveau/Modifier.

Dans la liste déroulante Choisir un déclencheur, sélectionnez Nouveau.

Passez en revue les options de déclencheur pour exécuter le pipeline, puis sélectionnez OK.

Sélectionnez Enregistrer.

Sélectionnez Publier.

Cette section explique comment copier des données d’une base de données PostgreSQL vers un index Recherche cognitive Azure. Il n’existe aucun processus d’indexation directe de PostgreSQL vers Recherche cognitive Azure. Cette section inclut donc une phase intermédiaire qui copie le contenu de la base de données dans un conteneur d’objets blob Stockage Azure. Vous indexerez ensuite à partir de ce conteneur intermédiaire à l’aide d’un pipeline Data Factory.

Connectez-vous à Azure Data Factory Studio avec votre compte Azure.

Choisissez votre fabrique de données, puis sélectionnez Continuer.

Dans le menu de gauche, sélectionnez l’icône Gérer.

Sous Services liés, sélectionnez Nouveau.

Dans le volet droit, dans la recherche de magasin de données, entrez « postgresql ». Sélectionnez la vignette PostgreSQL qui représente l’emplacement de votre base de données PostgreSQL (Azure ou autre), puis sélectionnez Continuer. Dans cet exemple, la base de données PostgreSQL se trouve dans Azure.

Renseignez les valeurs de Nouveau service lié :

Pour Méthode de sélection de compte, sélectionnez Entrer manuellement.

Dans la page Vue d’ensemble de votre base de données Azure Database pour PostgreSQL du portail Azure, collez les valeurs suivantes dans leur champ respectif :

- Ajoutez Nom du serveur à Nom de domaine complet.

- Ajoutez Nom d’utilisateur administrateur à Nom d’utilisateur.

- Ajoutez Base de données à Nom de la base de données.

- Entrez le mot de passe du nom d’utilisateur administrateur dans Mot de passe du nom d’utilisateur.

- Sélectionnez Create (Créer).

Dans le menu de gauche, sélectionnez l’icône Créer.

Sélectionnez Jeux de données, puis sélectionnez le menu

...Actions de jeux de données.

Sélectionnez Nouveau jeu de données.

Dans le volet droit, dans la recherche de magasin de données, entrez « postgresql ». Sélectionnez la vignette Azure PostgreSQL. Sélectionnez Continuer.

Renseignez les valeurs dans Définir les propriétés :

Choisissez le service lié PostgreSQL créé à l’Étape 1.

Sélectionnez la table à importer/indexer.

Sélectionnez OK.

Sélectionnez Enregistrer.

Créez un index dans votre service Recherche cognitive Azure avec le même schéma que celui utilisé pour vos données PostgreSQL.

Vous pouvez réaffecter l’index que vous utilisez actuellement pour le connecteur Power PostgreSQL. Dans le portail Azure, recherchez l’index, puis sélectionnez Définition d’index (JSON). Sélectionnez la définition et copiez-la dans le corps de votre nouvelle requête d’index.

Dans le menu de gauche, sélectionnez l’icône Gérer.

Sous Services liés, sélectionnez Nouveau.

Dans le volet droit, dans la recherche de magasin de données, entrez « recherche ». Sélectionnez la vignette Recherche Azure, puis Continuer.

Renseignez les valeurs de Nouveau service lié :

- Choisissez l’abonnement Azure dans lequel réside votre service Recherche cognitive Azure.

- Choisissez le service Recherche cognitive Azure qui a votre indexeur de connecteur Power Query.

- Sélectionnez Create (Créer).

Dans le menu de gauche, sélectionnez l’icône Créer.

Sélectionnez Jeux de données, puis sélectionnez le menu

...Actions de jeux de données.

Sélectionnez Nouveau jeu de données.

Dans le volet droit, dans la recherche de magasin de données, entrez « recherche ». Sélectionnez la vignette Recherche Azure, puis Continuer.

Dans Définir les propriétés :

Sélectionnez Enregistrer.

Dans le menu de gauche, sélectionnez l’icône Gérer.

Sous Services liés, sélectionnez Nouveau.

Dans le volet droit, dans la recherche de magasin de données, entrez « stockage ». Sélectionnez la vignette Stockage Blob Azure, puis Continuer

Renseignez les valeurs de Nouveau service lié :

Choisissez le Type d’authentification : URI SAS. Seule cette méthode peut être utilisée pour importer des données de PostgreSQL vers Stockage Blob Azure.

Générez une URL SAS pour le compte de stockage que vous utiliserez pour la préproduction, et copiez l’URL SAS d’objet blob dans le champ URL SAS.

Sélectionnez Create (Créer).

Dans le menu de gauche, sélectionnez l’icône Créer.

Sélectionnez Jeux de données, puis sélectionnez le menu

...Actions de jeux de données.

Sélectionnez Nouveau jeu de données.

Dans le volet droit, dans la recherche de magasin de données, entrez « stockage ». Sélectionnez la vignette Stockage Blob Azure, puis Continuer

Sélectionnez le format DelimitedText, puis Continuer.

Dans Délimiteur de lignes, sélectionnez Saut de ligne (\n).

Cochez la case Utiliser la première ligne comme en-tête.

Sélectionnez Enregistrer.

Dans le menu de gauche, sélectionnez l’icône Créer.

Sélectionnez Pipelines, puis le menu

...Actions de pipelines.

Sélectionnez Nouveau pipeline.

Créez et configurez les activités Data Factory qui copient de PostgreSQL vers le conteneur Stockage Azure :

Développez La section Déplacer & transformer et faites glisser-déplacer l’activité Copier des données dans le canevas de l’éditeur de pipeline vide.

Ouvrez l’onglet Général et acceptez les valeurs par défaut, sauf si vous devez personnaliser l’exécution.

Sous l’onglet Source, sélectionnez votre table PostgreSQL. Conservez les valeurs par défaut des options restantes.

Sous l’onglet Récepteur :

Sélectionnez le jeu de données PostgreSQL Stockage DelimitedText configuré à l’Étape 7.

Dans Extension de fichier, ajoutez .csv.

Conservez les valeurs par défaut des options restantes.

Sélectionnez Enregistrer.

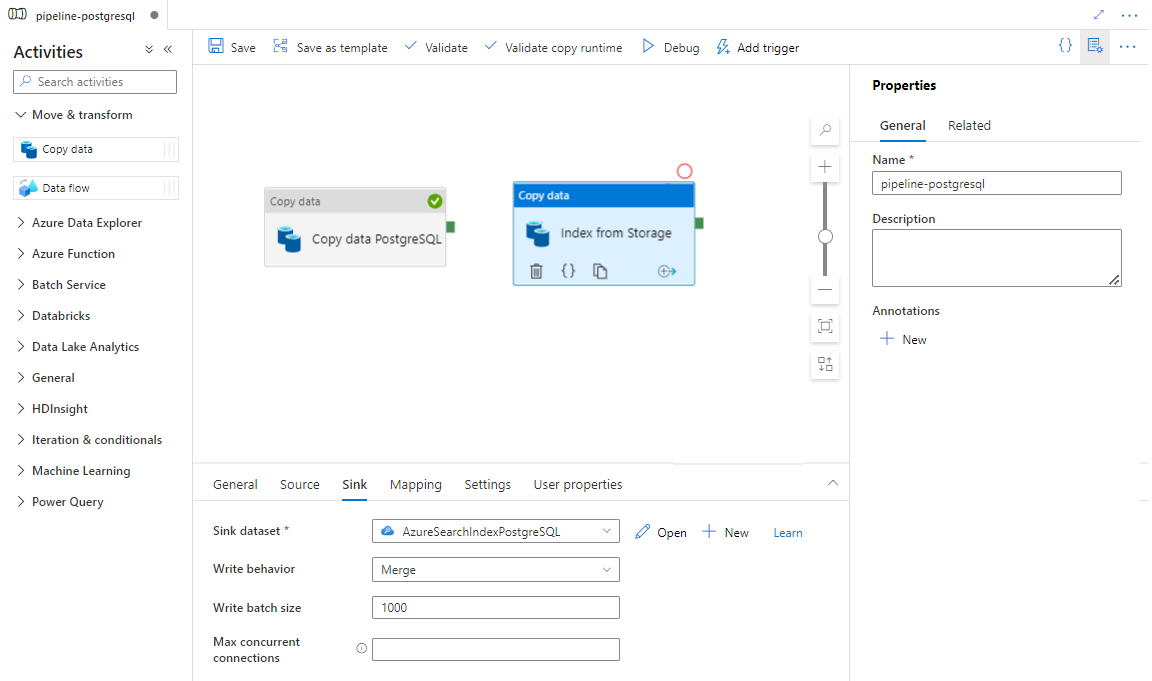

Configurez les activités qui copient de Stockage Azure vers un index de recherche :

Développez La section Déplacer & transformer et faites glisser-déplacer l’activité Copier des données dans le canevas de l’éditeur de pipeline vide.

Sous l’onglet Général, conservez les valeurs par défaut, sauf si vous devez personnaliser l’exécution.

Sous l’onglet Source :

- Sélectionnez le jeu de données source Stockage configuré à l’Étape 7.

- Dans le champ Type de chemin de fichier, sélectionnez Chemin de fichier générique.

- Conservez les valeurs par défaut pour tous les champs restants.

Sous l’onglet Récepteur, sélectionnez votre index Recherche cognitive Azure. Conservez les valeurs par défaut des options restantes.

Sélectionnez Enregistrer.

Dans l’éditeur de canevas de pipeline, sélectionnez le petit carré vert au bord de l’activité du pipeline. Faites-le glisser vers l’activité « Index de compte de stockage vers Recherche cognitive Azure » pour définir l’ordre d’exécution.

Sélectionnez Enregistrer.

Sélectionnez Ajouter un déclencheur pour planifier l’exécution du pipeline, puis Nouveau/Modifier.

Dans la liste déroulante Choisir un déclencheur, sélectionnez Nouveau.

Passez en revue les options de déclencheur pour exécuter le pipeline, puis sélectionnez OK.

Sélectionnez Enregistrer.

Sélectionnez Publier.

Un connecteur Power Query est utilisé avec un indexeur de recherche pour automatiser l’ingestion des données à partir de différentes sources de données, y compris celles sur d’autres fournisseurs de cloud. Il utilise Power Query pour récupérer les données.

Les sources de données prises en charge dans la préversion sont les suivantes :

- Amazon Redshift

- Elasticsearch

- PostgreSQL

- Objets Salesforce

- Rapports Salesforce

- Smartsheet

- Snowflake

Les connecteurs Power Query sont utilisés dans les indexeurs. Dans Recherche cognitive Azure, un indexeur est un analyseur qui extrait les données et les métadonnées pouvant faire l’objet d’une recherche à partir d’une source de données externe et remplit un index en fonction des mappages champ à champ entre l’index et votre source de données. Cette approche est parfois appelée « modèle d’extraction », car le service extrait des données sans que vous ayez à écrire un code qui ajoute des données à un index. Les indexeurs offrent aux utilisateurs un moyen pratique d’indexer le contenu de leur source de données sans avoir à écrire leur propre analyseur ou modèle de transmission de type push.

Les indexeurs qui référencent les sources de données Power Query proposent le même niveau de prise en charge des ensembles de compétences, des planifications, de la logique de détection des modifications de la limite supérieure et de la plupart des paramètres pris en charge par d’autres indexeurs.

Bien que vous ne puissiez plus utiliser cette fonctionnalité, elle avait les exigences suivantes en préversion :

Le service Recherche cognitive Azure dans une région prise en charge.

Inscription en préversion. Cette fonctionnalité doit être activée sur le serveur principal.

Compte Stockage Blob Azure, utilisé comme intermédiaire pour vos données. Les données circuleront de votre source de données vers Stockage Blob, puis vers l’index. Cette exigence existe uniquement pour la préversion contrôlée initiale.

La préversion était disponible uniquement sur les services de recherche dans les régions suivantes :

- USA Centre

- USA Est

- USA Est 2

- Centre-Nord des États-Unis

- Europe Nord

- États-Unis - partie centrale méridionale

- Centre-USA Ouest

- Europe Ouest

- USA Ouest

- USA Ouest 2

Cette section décrit les limites spécifiques à la version actuelle de la préversion.

L’extraction de données binaires à partir de votre source de données n’est pas prise en charge.

La session de débogage n’est pas prise en charge.

Le portail Azure prend en charge les connecteurs Power Query. En analysant les données et en lisant les métadonnées dans le conteneur, l’Assistant Importation de données peut créer un index par défaut, mapper des champs sources aux champs d’index cibles et charger l’index en une seule opération. Selon la taille et la complexité de la source de données, vous pouvez obtenir un index de recherche en texte intégral opérationnel en quelques minutes.

La vidéo suivante montre comment configurer un connecteur Power Query dans Recherche cognitive Azure.

Assurez-vous que votre source de données contient des données. L’Assistant Importation de données lit les métadonnées et effectue un échantillonnage des données pour déduire un schéma d’index, mais il charge également des données à partir de votre source de données. Si les données sont manquantes, l’Assistant s’arrête et renvoie une erreur.

Une fois que votre demande d’accès à la préversion aura été approuvée, l’équipe de Recherche cognitive Azure vous fournira un lien vers le portail Azure qui utilise un indicateur de fonctionnalité afin que vous puissiez accéder aux connecteurs Power Query. Ouvrez cette page et démarrez l’Assistant à partir de la barre de commandes dans la page du service Recherche cognitive Azure en sélectionnant Importer des données.

Il existe quelques sources de données à partir desquelles vous pouvez extraire des données à l’aide de cette préversion. Toutes les sources de données qui utilisent Power Query incluent une mention « Alimenté par Power Query » sur leur vignette. Sélectionnez votre source de données.

Une fois que vous avez sélectionné votre source de données, sélectionnez Suivant : Configurer vos données pour passer à la section suivante.

Lors de cette étape, vous allez configurer votre connexion. Chaque source de données nécessitera des informations différentes. Pour quelques sources de données, la documentation de Power Query fournit plus de détails sur la façon de vous connecter à vos données.

Une fois que vous avez fourni vos informations d’identification de connexion, sélectionnez Suivant.

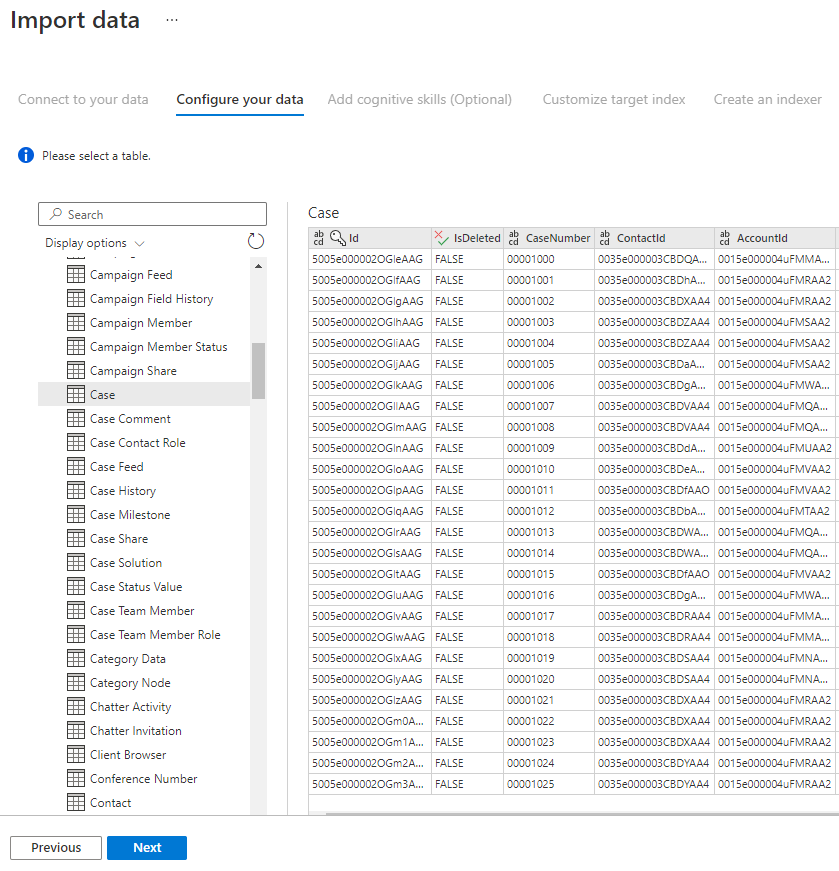

L’Assistant Importation affiche un aperçu des différentes tables disponibles dans votre source de données. Lors de cette étape, vous allez sélectionner une table qui contient les données que vous souhaitez importer dans votre index.

Une fois que vous avez sélectionné votre table, sélectionnez Suivant.

Les connecteurs Power Query vous offrent une expérience d’interface utilisateur enrichie qui vous permet de manipuler vos données pour que vous puissiez envoyer les bonnes données à votre index. Vous pouvez supprimer des colonnes, filtrer les lignes et bien plus encore.

Il n’est pas nécessaire de transformer vos données avant de les importer dans Recherche cognitive Azure.

Pour plus d’informations sur la transformation des données avec Power Query, consultez Utilisation de Power Query dans Power BI Desktop.

Une fois les données transformées, sélectionnez Suivant.

La préversion des connecteurs Power Query vous oblige actuellement à fournir un compte de stockage BLOB. Cette étape existe uniquement pour la préversion contrôlée initiale. Ce compte de stockage BLOB servira de stockage temporaire pour les données qui passent de votre source de données à un index Recherche cognitive Azure.

Nous vous recommandons de fournir une chaîne de connexion de compte de stockage avec accès complet :

{ "connectionString" : "DefaultEndpointsProtocol=https;AccountName=<your storage account>;AccountKey=<your account key>;" }

Vous pouvez obtenir la chaîne de connexion sur le portail Azure en sélectionnant le panneau du compte de stockage > Paramètres > Clés (pour les comptes de stockage Classic) ou en sélectionnant Paramètres > Clés d’accès (pour les comptes de stockage ARM).

Une fois que vous avez fourni un nom de source de données et une chaîne de connexion, sélectionnez « Suivant : Ajouter des compétences cognitives (facultatif) ».

L’enrichissement par IA est une extension des indexeurs qui peut être utilisée pour faciliter la recherche dans votre contenu.

Vous pouvez ajouter des enrichissements qui améliorent votre scénario. Lorsque vous avez terminé, sélectionnez Suivant : Personnaliser l’index cible.

Sur la page Index, vous devez voir une liste de champs avec un type de données et une série de cases à cocher permettant de définir les attributs de l’index. L’Assistant peut générer une liste de champs basée sur les métadonnées et en échantillonnant les données sources.

Vous pouvez sélectionner des attributs en bloc en cochant la case en haut d’une colonne d’attribut. Choisissez Récupérable et Possibilité de recherche pour chaque champ qui doit être retourné vers une application cliente et soumis à un traitement de recherche de texte intégral. Vous remarquerez que les entiers ne peuvent pas être recherchés en texte intégral ou partiel (les nombres sont évalués textuellement et sont généralement utiles dans les filtres).

Pour plus d’informations, passez en revue la description des attributs d’index et des analyseurs de langage.

Prenez un moment pour passer en revue vos sélections. Une fois que vous exécutez l’Assistant, des structures de données physiques sont créées et vous ne pourrez pas modifier la plupart des propriétés de ces champs sans supprimer et recréer tous les objets.

Lorsque vous avez terminé, sélectionnez Suivant : Créer un indexeur.

La dernière étape consiste à créer l’indexeur. Le fait de nommer l’indexeur lui permet d’exister comme ressource autonome, que vous pouvez planifier et gérer indépendamment de l’objet index et de l’objet source de données, créés dans la même séquence de l’Assistant.

La sortie de l’Assistant Importation de données est un indexeur qui analyse votre source de données et importe les données que vous avez sélectionnées dans un index sur Recherche cognitive Azure.

Lors de la création de l’indexeur, vous pouvez choisir d’exécuter l’indexeur selon une planification et d’ajouter la détection des modifications. Pour ajouter la détection des modifications, désignez une colonne « Limite supérieure ».

Une fois que vous avez terminé de renseigner cette page, sélectionnez Envoyer.

Cette stratégie de détection des modifications s’appuie sur une colonne « Limite supérieure » qui capture la version ou l’heure pour laquelle une ligne a été mise à jour.

- Toutes les insertions spécifient une valeur pour la colonne.

- Toutes les mises à jour d'un élément modifient également la valeur de la colonne.

- La valeur de cette colonne augmente à chaque insertion ou mise à jour.

Les noms de champs d’un index Recherche cognitive Azure doivent répondre à certaines exigences. L’une de ces exigences est que certains caractères tels que « / » ne sont pas autorisés. Si un nom de colonne dans votre base de données ne répond pas à ces exigences, la détection du schéma de l’index ne reconnaîtra pas votre colonne comme un nom de champ valide et vous ne verrez pas cette colonne listée comme un champ suggéré pour votre index. Normalement, l’utilisation de mappages de champs résoudrait ce problème, mais les mappages de champs ne sont pas pris en charge par le portail.

Pour indexer le contenu d’une colonne de votre table dont le nom de champ n’est pas pris en charge, renommez la colonne pendant la phase « Transformer vos données » du processus d’importation de données. Par exemple, vous pouvez renommer une colonne nommée « Code de facturation/code postal » en « codepostal ». En renommant la colonne, la détection du schéma de l’index la reconnaîtra comme un nom de champ valide et l’ajoutera comme suggestion à votre définition d’index.

Cet article a expliqué comment extraire des données à l’aide des connecteurs Power Query. Cette fonctionnalité d’évaluation étant abandonnée, il a également expliqué comment migrer des solutions existantes vers un scénario pris en charge.

Pour en savoir plus sur les indexeurs, consultez Indexeurs dans Recherche cognitive Azure.