Ajánlott eljárások a fájlok data lake-be való írásához adatfolyamokkal

A következőkre vonatkozik: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tipp.

Próbálja ki a Data Factoryt a Microsoft Fabricben, amely egy teljes körű elemzési megoldás a nagyvállalatok számára. A Microsoft Fabric az adattovábbítástól az adatelemzésig, a valós idejű elemzésig, az üzleti intelligenciáig és a jelentéskészítésig mindent lefed. Ismerje meg, hogyan indíthat új próbaverziót ingyenesen!

Ha még csak ismerkedik az Azure Data Factory használatával, olvassa el az Azure Data Factory használatának első lépéseit ismertető cikket.

Ebben az oktatóanyagban megismerheti azokat az ajánlott eljárásokat, amelyek a fájlok ADLS Gen2-be vagy az Azure Blob Storage-ba adatfolyamok használatával történő írásakor alkalmazhatók. A parquet-fájlok olvasásához és az eredmények mappákban való tárolásához hozzá kell férnie egy Azure Blob Storage-fiókhoz vagy az Azure Data Lake Store Gen2-fiókhoz.

Előfeltételek

- Azure-előfizetés. Ha nem rendelkezik Azure-előfizetéssel, mindössze néhány perc alatt létrehozhat egy ingyenes Azure-fiókot a virtuális gép létrehozásának megkezdése előtt.

- Egy Azure Storage-fiók. Az ADLS-tárolót forrás- és fogadóadattárként használja. Ha még nem rendelkezik tárfiókkal, tekintse meg az Azure Storage-fiók létrehozásának lépéseit ismertető cikket.

Az oktatóanyag lépései feltételezik, hogy rendelkezik

Adat-előállító létrehozása

Ebben a lépésben létrehoz egy adat-előállítót, és megnyitja a Data Factory UX-t egy folyamat létrehozásához az adat-előállítóban.

Nyissa meg a Microsoft Edge-et vagy a Google Chrome-ot. A Data Factory felhasználói felülete jelenleg csak a Microsoft Edge és a Google Chrome böngészőkben támogatott.

A bal oldali menüben válassza az Erőforrás-integrációs>>adat-előállító létrehozása lehetőséget

Az Új adat-előállító lap Név területén adja meg az ADFTutorialDataFactory nevet

Válassza ki azt az Azure-előfizetést, amelyben az adat-előállítót létre szeretné hozni.

Erőforráscsoport: hajtsa végre a következő lépések egyikét:

a. Kattintson a Meglévő használata elemre, majd a legördülő listából válasszon egy meglévő erőforráscsoportot.

b. Válassza az Új létrehozása lehetőséget, és adja meg egy erőforráscsoport nevét. Az erőforráscsoportokról az Azure-erőforrások kezelése erőforráscsoportok használatával című témakörben olvashat.

A Verzió résznél válassza a V2 értéket.

A Hely területen válassza ki az adat-előállító helyét. A legördülő listán csak a támogatott helyek jelennek meg. Az adat-előállító által használt adattárak (például az Azure Storage és az SQL Database) és a számítások (például az Azure HDInsight) más régiókban is lehetnek.

Select Create.

A létrehozás befejezése után megjelenik az értesítés az Értesítések központban. Válassza az Ugrás az erőforrásra lehetőséget a Data Factory lapra való navigáláshoz.

A Data Factory felhasználói felületének külön lapon történő elindításához válassza a Létrehozás és figyelés csempét.

Folyamat létrehozása adatfolyam-tevékenységgel

Ebben a lépésben egy adatfolyam-tevékenységet tartalmazó folyamatot fog létrehozni.

Az Azure Data Factory kezdőlapján válassza az Orchestrate lehetőséget.

A folyamat Általános lapján adja meg a DeltaLake nevet a folyamat nevéhez.

A gyári felső sávon húzza be a Adatfolyam hibakeresési csúszkát. A hibakeresési mód lehetővé teszi az átalakítási logika interaktív tesztelését egy élő Spark-fürtön. Adatfolyam fürtök bemelegedése 5-7 percet vesz igénybe, és a felhasználóknak ajánlott először bekapcsolniuk a hibakeresést, ha Adatfolyam fejlesztést terveznek. További információ: Hibakeresési mód.

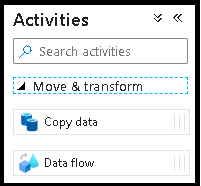

A Tevékenységek panelen bontsa ki az Áthelyezés és átalakítás harmonika elemet. Húzza a Adatfolyam tevékenységet a panelről a folyamatvászonra.

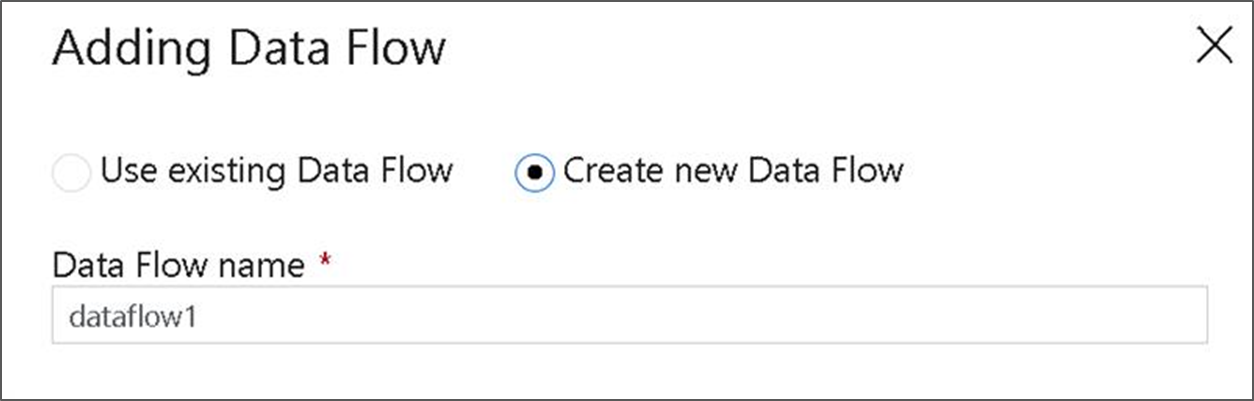

A Hozzáadás Adatfolyam előugró ablakban válassza az Új Adatfolyam létrehozása lehetőséget, majd adja meg az adatfolyam DeltaLake nevét. Kattintson a Befejezés gombra, ha elkészült.

Átalakítási logika létrehozása az adatfolyam-vásznon

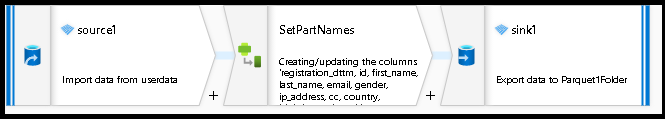

Minden forrásadatot (ebben az oktatóanyagban Parquet-fájlforrást fogunk használni) fogjuk használni, és fogadó-átalakítással parquet formátumban fogjuk lehozni az adatokat a data lake ETL leghatékonyabb mechanizmusainak használatával.

Oktatóanyag célkitűzései

- Válasszon ki bármelyik forrásadatkészletet egy új adatfolyamban 1. Adatfolyamok használata a fogadó adatkészlet hatékony particionálásához

- Particionált adatok leosztása az ADLS Gen2-beli tómappákban

Kezdés egy üres adatfolyam-vászonról

Először is állítsuk be az adatfolyam-környezetet az ADLS Gen2-ben az alábbiakban ismertetett összes mechanizmushoz

- Kattintson a forrásátalakításra.

- Kattintson az adathalmaz melletti új gombra az alsó panelen.

- Válasszon egy adatkészletet, vagy hozzon létre egy újat. Ebben a bemutatóban egy Felhasználói adatok nevű Parquet-adatkészletet fogunk használni.

- Származtatott oszlop transzformáció hozzáadása. Ezzel a módszerrel dinamikusan állíthatja be a kívánt mappaneveket.

- Fogadóátalakítás hozzáadása.

Hierarchikus mappakimenet

Nagyon gyakori, hogy az adatok egyedi értékeit használva mappahierarchiákat hoz létre az adatok particionálásához a tóban. Ez egy nagyon optimális módszer az adatok rendszerezésére és feldolgozására a tóban és a Sparkban (az adatfolyamok mögötti számítási motorban). A kimenet ilyen módon történő rendszerezésének azonban kisebb teljesítményköltsége lesz. A folyamat teljes teljesítményének kis mértékű csökkenését várhatja a fogadóban ezzel a mechanizmussal.

- Térjen vissza az adatfolyam-tervezőhöz, és szerkessze a fenti adatfolyam-létrehozást. Kattintson a fogadó transzformációjára.

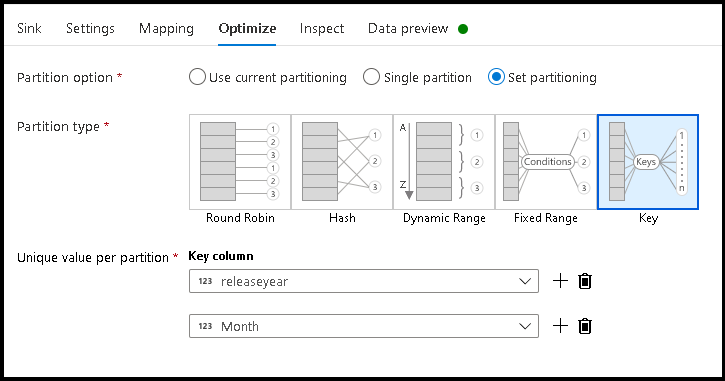

- Kattintson a Particionálási kulcs beállítása optimalizálása >> elemre

- Válassza ki a hierarchikus mappastruktúra beállításához használni kívánt oszlop(ok)t.

- Az alábbi példában a mappaelnevezés oszlopai az év és a hónap nevet használják. Az eredmények az űrlap

releaseyear=1990/month=8mappái lesznek. - Amikor egy adatfolyam-forrás adatpartícióihoz fér hozzá, csak a fenti

releaseyearlegfelső szintű mappára mutat, és minden további mappához helyettesítő karaktermintát használ, például:**/**/*.parquet - Ha módosítani szeretné az adatértékeket, vagy akár szintetikus értékeket is létre szeretne hozni a mappanevekhez, a Származtatott oszlop átalakításával hozza létre a mappanevekben használni kívánt értékeket.

Névmappa adatértékként

Az ADLS Gen2-t használó, a kulcs-/értékparticionálással nem azonos előnyöket nyújtó, a lake data esetében valamivel jobban teljesítő fogadó technika.Name folder as column data Míg a hierarchikus struktúra kulcsparticionálási stílusa lehetővé teszi az adatszeletek könnyebb feldolgozását, ez a technika egy lapított mappastruktúra, amely gyorsabban tud adatokat írni.

- Térjen vissza az adatfolyam-tervezőhöz, és szerkessze a fenti adatfolyam-létrehozást. Kattintson a fogadó transzformációjára.

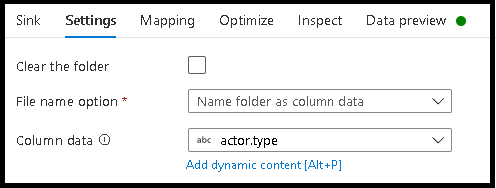

- Kattintson a Partíciókészlet optimalizálása > az aktuális particionálás > használata elemre.

- Kattintson a Gépház > Név mappára oszlopadatokként.

- Válassza ki a mappanevek létrehozásához használni kívánt oszlopot.

- Ha módosítani szeretné az adatértékeket, vagy akár szintetikus értékeket is létre szeretne hozni a mappanevekhez, a Származtatott oszlop átalakításával hozza létre a mappanevekben használni kívánt értékeket.

Névfájl adatértékként

A fenti oktatóanyagokban felsorolt technikák jól használhatók mappakategóriák létrehozására a data lake-ben. Az ilyen technikák által alkalmazott alapértelmezett fájlelnevezési séma a Spark-végrehajtói feladatazonosító használata. Előfordulhat, hogy a kimeneti fájl nevét egy adatfolyam szöveggyűjtőjében szeretné beállítani. Ez a technika csak kis fájlokhoz javasolt. A partíciófájlok egyetlen kimeneti fájlba való egyesítésének folyamata egy hosszú ideig futó folyamat.

- Térjen vissza az adatfolyam-tervezőhöz, és szerkessze a fenti adatfolyam-létrehozást. Kattintson a fogadó transzformációjára.

- Kattintson az Optimalizálási beállítás particionálási > egypartícióra > elemre. Ez az egyetlen partíciókövetelmény szűk keresztmetszetet okoz a végrehajtási folyamatban a fájlok egyesítésekor. Ez a beállítás csak kis méretű fájlok esetén ajánlott.

- Kattintson a Gépház > Név fájlra oszlopadatokként.

- Válassza ki a fájlnevek létrehozásához használni kívánt oszlopot.

- Ha módosítani szeretné az adatértékeket, vagy akár szintetikus értékeket is létre szeretne hozni a fájlnevekhez, a Származtatott oszlop átalakításával hozza létre a fájlnevekben használni kívánt értékeket.

Kapcsolódó tartalom

Visszajelzés

Hamarosan elérhető: 2024-ben fokozatosan kivezetjük a GitHub-problémákat a tartalom visszajelzési mechanizmusaként, és lecseréljük egy új visszajelzési rendszerre. További információ: https://aka.ms/ContentUserFeedback.

Visszajelzés küldése és megtekintése a következőhöz: