Pacemaker beállítása SUSE Linux Enterprise Serveren az Azure-ban

Ez a cikk bemutatja, hogyan állíthatja be a Pacemakert az Azure-beli SUSE Linux Enterprise Serveren (SLES).

Áttekintés

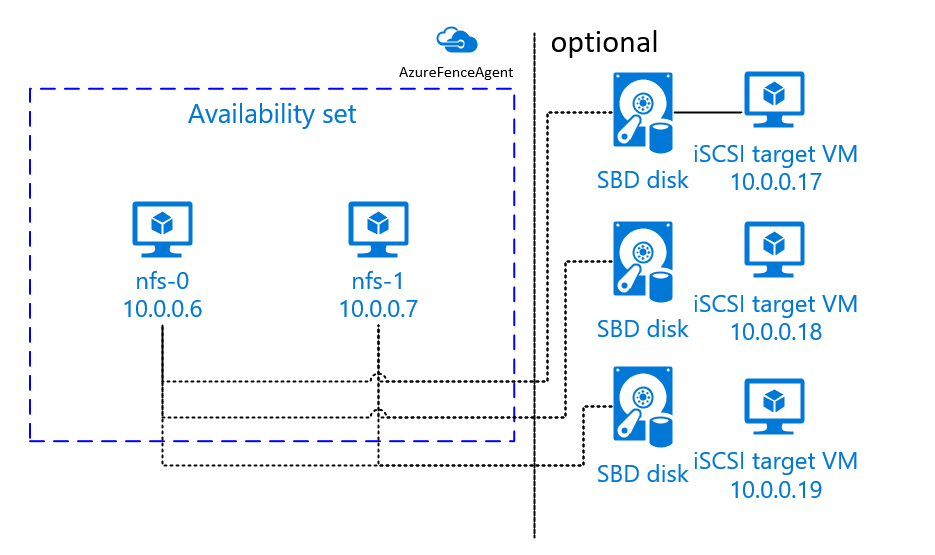

Az Azure-ban két lehetőség van a kerítés beállítására a Pacemaker-fürtben az SLES-hez. Használhat egy Azure-beli kerítésügynököt, amely újraindít egy sikertelen csomópontot az Azure API-kkal, vagy használhat SBD-eszközt.

SBD-eszköz használata

Az SBD-eszközt két lehetőség egyikével konfigurálhatja:

SBD iSCSI-célkiszolgálóval:

Az SBD-eszközhöz legalább egy további virtuális gép (VM) szükséges, amely iSCSI-célkiszolgálóként működik, és SBD-eszközt biztosít. Ezek az iSCSI-célkiszolgálók azonban megoszthatók más Pacemaker-fürtekkel. Az SBD-eszközök használatának előnye, hogy ha már SBD-eszközöket használ a helyszínen, nem kell módosítani a Pacemaker-fürt működését.

A Pacemaker-fürtökhöz legfeljebb három SBD-eszközt használhat, hogy egy SBD-eszköz elérhetetlenné váljon (például az iSCSI-tárolókiszolgáló operációs rendszerének javítása során). Ha pacemakerenként több SBD-eszközt szeretne használni, mindenképpen telepítsen több iSCSI-tárolókiszolgálót, és csatlakoztassa az egyes iSCSI-tárolókiszolgálókról egy SBD-t. Javasoljuk, hogy használjunk egy SBD-eszközt vagy háromat. A Pacemaker nem tudja automatikusan elkerítéssel beállítani a fürtcsomópontot, ha csak két SBD-eszköz van konfigurálva, és az egyik nem érhető el. Ha azt szeretné, hogy egy iSCSI-célkiszolgáló leállásakor el lehessen végezni a kerítést, három SBD-eszközt kell használnia, és ezért három iSCSI-célkiszolgálót kell használnia. Ez a legrugalmasabb konfiguráció SBD-k használatakor.

Fontos

Linux Pacemaker fürtözött csomópontok és SBD-eszközök tervezésekor és telepítésekor ne engedélyezze a virtuális gépek és az SBD-eszközöket üzemeltető virtuális gépek közötti útválasztást bármely más eszközön, például hálózati virtuális berendezésen (NVA) keresztül.

A karbantartási események és az NVA egyéb problémái negatív hatással lehetnek a fürt általános konfigurációjának stabilitására és megbízhatóságára. További információ: Felhasználó által definiált útválasztási szabályok.

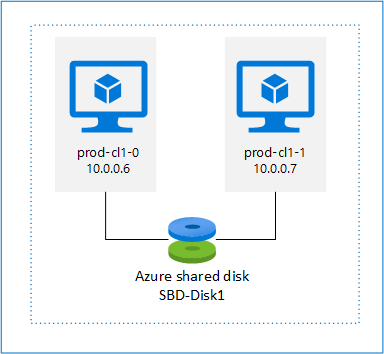

SBD azure-beli megosztott lemezzel:

Az SBD-eszközök konfigurálásához legalább egy Megosztott Azure-lemezt kell csatolnia a Pacemaker-fürt részét képező összes virtuális géphez. Az Azure-beli megosztott lemezt használó SBD-eszköz előnye, hogy nem kell további virtuális gépeket üzembe helyeznie.

Íme néhány fontos szempont az SBD-eszközökkel kapcsolatban az Azure-beli megosztott lemez használatakor:

- A Prémium SSD-vel rendelkező Azure-beli megosztott lemezek SBD-eszközként támogatottak.

- Az Azure-beli megosztott lemezt használó SBD-eszközök támogatottak a magas rendelkezésre állású SLES 15 SP01 és újabb verziókban.

- Az Azure premium megosztott lemezt használó SBD-eszközöket helyileg redundáns tárolás (LRS) és zónaredundáns tárolás (ZRS) támogatja.

- Az üzembe helyezés típusától függően SBD-eszközként válassza ki az Azure-beli megosztott lemez megfelelő redundáns tárolóját.

- Az LRS-t használó SBD-eszközök az Azure prémium szintű megosztott lemezéhez (skuName – Premium_LRS) csak a rendelkezésre állási csoportban való üzembe helyezés esetén támogatottak.

- Egy ZRS-t használó SBD-eszköz használata prémium szintű megosztott Azure-lemezhez (skuName – Premium_ZRS) ajánlott a rendelkezésre állási zónákban való üzembe helyezéskor.

- A felügyelt lemezekhez készült ZRS jelenleg nem érhető el minden rendelkezésre állási zónával rendelkező régióban. További információkért tekintse át a ZRS "Korlátozások" szakaszát a felügyelt lemezek redundanciáinak beállításai között.

- Az SBD-eszközökhöz használt Azure-beli megosztott lemeznek nem kell nagynak lennie. A maxShares érték határozza meg, hogy hány fürtcsomópont használhatja a megosztott lemezt. Használhat például P1 vagy P2 lemezméreteket az SBD-eszközhöz kétcsomópontos fürtön, például SAP ASCS/ERS vagy SAP HANA vertikális felskálázáson.

- Ha a HANA-beli rendszerreplikációval (HSR) és a Pacemakerrel végzett HANA-felskálázáshoz azure-beli megosztott lemezt használhat az olyan fürtökben lévő SBD-eszközökhöz, amelynek replikációs helye legfeljebb négy csomópontot tartalmazhat a maxShares jelenlegi korlátja miatt.

- Nem javasoljuk, hogy azure-beli megosztott lemez SBD-eszközt csatoljon Pacemaker-fürtökhöz.

- Ha több Azure-beli megosztott lemez SBD-eszközt használ, ellenőrizze a virtuális géphez csatlakoztatható adatlemezek maximális számát.

- Az Azure-beli megosztott lemezek korlátozásairól további információt az Azure megosztott lemez dokumentációjának "Korlátozások" szakaszában talál.

Azure-beli kerítésügynök használata

A kerítést egy Azure-beli kerítésügynök használatával állíthatja be. Az Azure kerítésügynökhöz felügyelt identitásokra van szükség a fürt virtuális gépeihez, vagy egy szolgáltatásnévhez, amely az Azure API-kkal kezeli a sikertelen csomópontok újraindítását. Az Azure kerítésügynök nem igényel további virtuális gépek üzembe helyezését.

SBD iSCSI-tárolókiszolgálóval

Ha olyan SBD-eszközt szeretne használni, amely iSCSI-célkiszolgálót használ a kerítéshez, kövesse a következő szakaszok utasításait.

Az iSCSI-tárolókiszolgáló beállítása

Először létre kell hoznia az iSCSI-cél virtuális gépeket. Az iSCSI-célkiszolgálókat több Pacemaker-fürttel is megoszthatja.

Helyezzen üzembe új SLES 12 SP3 vagy újabb virtuális gépeket, és csatlakozzon hozzájuk SSH-n keresztül. A gépeknek nem kell nagynak lenniük. A virtuális gépek Standard_E2s_v3 vagy Standard_D2s_v3 mérete elegendő. Ügyeljen arra, hogy prémium szintű tárolót használjon az operációsrendszer-lemezhez.

Az iSCSI-cél virtuális gépeken futtassa a következő parancsokat:

a. Frissítse az SLES-t.

sudo zypper updateFeljegyzés

Előfordulhat, hogy az operációs rendszer frissítését vagy frissítését követően újra kell indítania az operációs rendszert.

b. Csomagok eltávolítása.

A targetcli és az SLES 12 SP3 ismert problémáinak elkerülése érdekében távolítsa el a következő csomagokat. Figyelmen kívül hagyhatja a nem található csomagok hibáit.

sudo zypper remove lio-utils python-rtslib python-configshell targetclic. Telepítse az iSCSI-célcsomagokat.

sudo zypper install targetcli-fb dbus-1-pythond. Engedélyezze az iSCSI-célszolgáltatást.

sudo systemctl enable targetcli sudo systemctl start targetcli

iSCSI-eszköz létrehozása az iSCSI-tárolókiszolgálón

Az SAP-rendszerek által használni kívánt fürtök iSCSI-lemezeinek létrehozásához futtassa az alábbi parancsokat az összes iSCSI-cél virtuális gépen. A példában több fürthöz készült SBD-eszközök jönnek létre. Bemutatja, hogyan használna egy iSCSI-célkiszolgálót több fürthöz. Az SBD-eszközök az operációsrendszer-lemezre kerülnek. Győződjön meg arról, hogy van elég hely.

- nfs: Azonosítja az NFS-fürtöt.

- ascsnw1: Az NW1 ASCS-fürtje.

- dbnw1: Azonosítja az NW1 adatbázisfürtöt.

- nfs-0 és nfs-1: Az NFS-fürtcsomópontok gazdagépneve.

- nw1-xscs-0 és nw1-xscs-1: Az NW1 ASCS-fürtcsomópontok állomásneve.

- nw1-db-0 és nw1-db-1: Az adatbázisfürt csomópontjainak állomásneve.

Az alábbi utasításokban cserélje le a fürtcsomópontok és az SAP-rendszer SID-azonosítójának gazdanevét.

Hozza létre az összes SBD-eszköz gyökérmappáját.

sudo mkdir /sbdHozza létre az SBD-eszközt az NFS-kiszolgálóhoz.

sudo targetcli backstores/fileio create sbdnfs /sbd/sbdnfs 50M write_back=false sudo targetcli iscsi/ create iqn.2006-04.nfs.local:nfs sudo targetcli iscsi/iqn.2006-04.nfs.local:nfs/tpg1/luns/ create /backstores/fileio/sbdnfs sudo targetcli iscsi/iqn.2006-04.nfs.local:nfs/tpg1/acls/ create iqn.2006-04.nfs-0.local:nfs-0 sudo targetcli iscsi/iqn.2006-04.nfs.local:nfs/tpg1/acls/ create iqn.2006-04.nfs-1.local:nfs-1Hozza létre az SBD-eszközt az SAP System NW1 ASCS-kiszolgálója számára.

sudo targetcli backstores/fileio create sbdascsnw1 /sbd/sbdascsnw1 50M write_back=false sudo targetcli iscsi/ create iqn.2006-04.ascsnw1.local:ascsnw1 sudo targetcli iscsi/iqn.2006-04.ascsnw1.local:ascsnw1/tpg1/luns/ create /backstores/fileio/sbdascsnw1 sudo targetcli iscsi/iqn.2006-04.ascsnw1.local:ascsnw1/tpg1/acls/ create iqn.2006-04.nw1-xscs-0.local:nw1-xscs-0 sudo targetcli iscsi/iqn.2006-04.ascsnw1.local:ascsnw1/tpg1/acls/ create iqn.2006-04.nw1-xscs-1.local:nw1-xscs-1Hozza létre az SBD-eszközt az SAP System NW1 adatbázisfürtjének.

sudo targetcli backstores/fileio create sbddbnw1 /sbd/sbddbnw1 50M write_back=false sudo targetcli iscsi/ create iqn.2006-04.dbnw1.local:dbnw1 sudo targetcli iscsi/iqn.2006-04.dbnw1.local:dbnw1/tpg1/luns/ create /backstores/fileio/sbddbnw1 sudo targetcli iscsi/iqn.2006-04.dbnw1.local:dbnw1/tpg1/acls/ create iqn.2006-04.nw1-db-0.local:nw1-db-0 sudo targetcli iscsi/iqn.2006-04.dbnw1.local:dbnw1/tpg1/acls/ create iqn.2006-04.nw1-db-1.local:nw1-db-1Mentse a célcli-módosításokat.

sudo targetcli saveconfigEllenőrizze, hogy minden megfelelően van-e beállítva.

sudo targetcli ls o- / .......................................................................................................... [...] o- backstores ............................................................................................... [...] | o- block ................................................................................... [Storage Objects: 0] | o- fileio .................................................................................. [Storage Objects: 3] | | o- sbdascsnw1 ................................................ [/sbd/sbdascsnw1 (50.0MiB) write-thru activated] | | | o- alua .................................................................................... [ALUA Groups: 1] | | | o- default_tg_pt_gp ........................................................ [ALUA state: Active/optimized] | | o- sbddbnw1 .................................................... [/sbd/sbddbnw1 (50.0MiB) write-thru activated] | | | o- alua .................................................................................... [ALUA Groups: 1] | | | o- default_tg_pt_gp ........................................................ [ALUA state: Active/optimized] | | o- sbdnfs ........................................................ [/sbd/sbdnfs (50.0MiB) write-thru activated] | | o- alua .................................................................................... [ALUA Groups: 1] | | o- default_tg_pt_gp ........................................................ [ALUA state: Active/optimized] | o- pscsi ................................................................................... [Storage Objects: 0] | o- ramdisk ................................................................................. [Storage Objects: 0] o- iscsi ............................................................................................. [Targets: 3] | o- iqn.2006-04.ascsnw1.local:ascsnw1 .................................................................. [TPGs: 1] | | o- tpg1 ................................................................................ [no-gen-acls, no-auth] | | o- acls ........................................................................................... [ACLs: 2] | | | o- iqn.2006-04.nw1-xscs-0.local:nw1-xscs-0 ............................................... [Mapped LUNs: 1] | | | | o- mapped_lun0 ............................................................ [lun0 fileio/sbdascsnw1 (rw)] | | | o- iqn.2006-04.nw1-xscs-1.local:nw1-xscs-1 ............................................... [Mapped LUNs: 1] | | | o- mapped_lun0 ............................................................ [lun0 fileio/sbdascsnw1 (rw)] | | o- luns ........................................................................................... [LUNs: 1] | | | o- lun0 .......................................... [fileio/sbdascsnw1 (/sbd/sbdascsnw1) (default_tg_pt_gp)] | | o- portals ..................................................................................... [Portals: 1] | | o- 0.0.0.0:3260 ...................................................................................... [OK] | o- iqn.2006-04.dbnw1.local:dbnw1 ...................................................................... [TPGs: 1] | | o- tpg1 ................................................................................ [no-gen-acls, no-auth] | | o- acls ........................................................................................... [ACLs: 2] | | | o- iqn.2006-04.nw1-db-0.local:nw1-db-0 ................................................... [Mapped LUNs: 1] | | | | o- mapped_lun0 .............................................................. [lun0 fileio/sbddbnw1 (rw)] | | | o- iqn.2006-04.nw1-db-1.local:nw1-db-1 ................................................... [Mapped LUNs: 1] | | | o- mapped_lun0 .............................................................. [lun0 fileio/sbddbnw1 (rw)] | | o- luns ........................................................................................... [LUNs: 1] | | | o- lun0 .............................................. [fileio/sbddbnw1 (/sbd/sbddbnw1) (default_tg_pt_gp)] | | o- portals ..................................................................................... [Portals: 1] | | o- 0.0.0.0:3260 ...................................................................................... [OK] | o- iqn.2006-04.nfs.local:nfs .......................................................................... [TPGs: 1] | o- tpg1 ................................................................................ [no-gen-acls, no-auth] | o- acls ........................................................................................... [ACLs: 2] | | o- iqn.2006-04.nfs-0.local:nfs-0 ......................................................... [Mapped LUNs: 1] | | | o- mapped_lun0 ................................................................ [lun0 fileio/sbdnfs (rw)] | | o- iqn.2006-04.nfs-1.local:nfs-1 ......................................................... [Mapped LUNs: 1] | | o- mapped_lun0 ................................................................ [lun0 fileio/sbdnfs (rw)] | o- luns ........................................................................................... [LUNs: 1] | | o- lun0 .................................................. [fileio/sbdnfs (/sbd/sbdnfs) (default_tg_pt_gp)] | o- portals ..................................................................................... [Portals: 1] | o- 0.0.0.0:3260 ...................................................................................... [OK] o- loopback .......................................................................................... [Targets: 0] o- vhost ............................................................................................. [Targets: 0] o- xen-pvscsi ........................................................................................ [Targets: 0]

Az iSCSI-célkiszolgáló SBD-eszközének beállítása

Csatlakozzon a fürt utolsó lépésében létrehozott iSCSI-eszközhöz. Futtassa a következő parancsokat a létrehozni kívánt új fürt csomópontján.

Feljegyzés

- [A]: Minden csomópontra vonatkozik.

- [1]: Csak az 1. csomópontra vonatkozik.

- [2]: Csak a 2. csomópontra vonatkozik.

[A] Telepítse az iSCSI-csomagot.

sudo zypper install open-iscsi[A] Csatlakozzon az iSCSI-eszközökhöz. Először engedélyezze az iSCSI- és SBD-szolgáltatásokat.

sudo systemctl enable iscsid sudo systemctl enable iscsi sudo systemctl enable sbd[1] Módosítsa a kezdeményező nevét az első csomóponton.

sudo vi /etc/iscsi/initiatorname.iscsi[1] Módosítsa a fájl tartalmát úgy, hogy megfeleljen az iSCSI-tárolókiszolgálón (például az NFS-kiszolgálón) az iSCSI-eszköz létrehozásakor használt hozzáférés-vezérlési listáknak (ACL-eknek).

InitiatorName=iqn.2006-04.nfs-0.local:nfs-0[2] Módosítsa a kezdeményező nevét a második csomóponton.

sudo vi /etc/iscsi/initiatorname.iscsi[2] Módosítsa a fájl tartalmát az iSCSI-tárolókiszolgálón az iSCSI-eszköz létrehozásakor használt ACL-ek szerint.

InitiatorName=iqn.2006-04.nfs-1.local:nfs-1[A] Indítsa újra az iSCSI szolgáltatást a módosítás alkalmazásához.

sudo systemctl restart iscsid sudo systemctl restart iscsi[A] Csatlakoztassa az iSCSI-eszközöket. Az alábbi példában a 10.0.0.17 az iSCSI-célkiszolgáló IP-címe, a 3260 pedig az alapértelmezett port. Az iqn.2006-04.nfs.local:nfs az első parancs

iscsiadm -m discoveryfuttatásakor felsorolt célnevek egyike.sudo iscsiadm -m discovery --type=st --portal=10.0.0.17:3260 sudo iscsiadm -m node -T iqn.2006-04.nfs.local:nfs --login --portal=10.0.0.17:3260 sudo iscsiadm -m node -p 10.0.0.17:3260 -T iqn.2006-04.nfs.local:nfs --op=update --name=node.startup --value=automatic[A] Ha több SBD-eszközt szeretne használni, csatlakozzon a második iSCSI-célkiszolgálóhoz is.

sudo iscsiadm -m discovery --type=st --portal=10.0.0.18:3260 sudo iscsiadm -m node -T iqn.2006-04.nfs.local:nfs --login --portal=10.0.0.18:3260 sudo iscsiadm -m node -p 10.0.0.18:3260 -T iqn.2006-04.nfs.local:nfs --op=update --name=node.startup --value=automatic[A] Ha több SBD-eszközt szeretne használni, csatlakozzon a harmadik iSCSI-célkiszolgálóhoz is.

sudo iscsiadm -m discovery --type=st --portal=10.0.0.19:3260 sudo iscsiadm -m node -T iqn.2006-04.nfs.local:nfs --login --portal=10.0.0.19:3260 sudo iscsiadm -m node -p 10.0.0.19:3260 -T iqn.2006-04.nfs.local:nfs --op=update --name=node.startup --value=automatic[A] Győződjön meg arról, hogy az iSCSI-eszközök elérhetők, és jegyezze fel az eszköz nevét (/dev/sde, az alábbi példában).

lsscsi # [2:0:0:0] disk Msft Virtual Disk 1.0 /dev/sda # [3:0:1:0] disk Msft Virtual Disk 1.0 /dev/sdb # [5:0:0:0] disk Msft Virtual Disk 1.0 /dev/sdc # [5:0:0:1] disk Msft Virtual Disk 1.0 /dev/sdd # [6:0:0:0] disk LIO-ORG sbdnfs 4.0 /dev/sdd # [7:0:0:0] disk LIO-ORG sbdnfs 4.0 /dev/sde # [8:0:0:0] disk LIO-ORG sbdnfs 4.0 /dev/sdf[A] Az iSCSI-eszközök azonosítóinak lekérése.

ls -l /dev/disk/by-id/scsi-* | grep sdd # lrwxrwxrwx 1 root root 9 Aug 9 13:20 /dev/disk/by-id/scsi-1LIO-ORG_sbdnfs:afb0ba8d-3a3c-413b-8cc2-cca03e63ef42 -> ../../sdd # lrwxrwxrwx 1 root root 9 Aug 9 13:20 /dev/disk/by-id/scsi-36001405afb0ba8d3a3c413b8cc2cca03 -> ../../sdd # lrwxrwxrwx 1 root root 9 Aug 9 13:20 /dev/disk/by-id/scsi-SLIO-ORG_sbdnfs_afb0ba8d-3a3c-413b-8cc2-cca03e63ef42 -> ../../sdd ls -l /dev/disk/by-id/scsi-* | grep sde # lrwxrwxrwx 1 root root 9 Feb 7 12:39 /dev/disk/by-id/scsi-1LIO-ORG_cl1:3fe4da37-1a5a-4bb6-9a41-9a4df57770e4 -> ../../sde # lrwxrwxrwx 1 root root 9 Feb 7 12:39 /dev/disk/by-id/scsi-360014053fe4da371a5a4bb69a419a4df -> ../../sde # lrwxrwxrwx 1 root root 9 Feb 7 12:39 /dev/disk/by-id/scsi-SLIO-ORG_cl1_3fe4da37-1a5a-4bb6-9a41-9a4df57770e4 -> ../../sde ls -l /dev/disk/by-id/scsi-* | grep sdf # lrwxrwxrwx 1 root root 9 Aug 9 13:32 /dev/disk/by-id/scsi-1LIO-ORG_sbdnfs:f88f30e7-c968-4678-bc87-fe7bfcbdb625 -> ../../sdf # lrwxrwxrwx 1 root root 9 Aug 9 13:32 /dev/disk/by-id/scsi-36001405f88f30e7c9684678bc87fe7bf -> ../../sdf # lrwxrwxrwx 1 root root 9 Aug 9 13:32 /dev/disk/by-id/scsi-SLIO-ORG_sbdnfs_f88f30e7-c968-4678-bc87-fe7bfcbdb625 -> ../../sdfA parancs három eszközazonosítót sorol fel minden SBD-eszközhöz. Azt javasoljuk, hogy használja az scsi-3 azonosítót. Az előző példában az azonosítók a következők:

- /dev/disk/by-id/scsi-36001405afb0ba8d3a3c413b8cc2cca03

- /dev/disk/by-id/scsi-360014053fe4da371a5a4bb69a419a4df

- /dev/disk/by-id/scsi-36001405f88f30e7c9684678bc87fe7bf

[1] Hozza létre az SBD-eszközt.

a. Az iSCSI-eszközök eszközazonosítójával hozza létre az új SBD-eszközöket az első fürtcsomóponton.

sudo sbd -d /dev/disk/by-id/scsi-36001405afb0ba8d3a3c413b8cc2cca03 -1 60 -4 120 createb. Ha több SBD-eszközt szeretne használni, hozza létre a második és a harmadik SBD-eszközt is.

sudo sbd -d /dev/disk/by-id/scsi-360014053fe4da371a5a4bb69a419a4df -1 60 -4 120 create sudo sbd -d /dev/disk/by-id/scsi-36001405f88f30e7c9684678bc87fe7bf -1 60 -4 120 create[A] Az SBD konfigurációjának adaptálása.

a. Nyissa meg az SBD konfigurációs fájlját.

sudo vi /etc/sysconfig/sbdb. Módosítsa az SBD-eszköz tulajdonságát, engedélyezze a Pacemaker-integrációt, és módosítsa az SBD indítási módját.

[...] SBD_DEVICE="/dev/disk/by-id/scsi-36001405afb0ba8d3a3c413b8cc2cca03;/dev/disk/by-id/scsi-360014053fe4da371a5a4bb69a419a4df;/dev/disk/by-id/scsi-36001405f88f30e7c9684678bc87fe7bf" [...] SBD_PACEMAKER="yes" [...] SBD_STARTMODE="always" [...]Feljegyzés

Ha a SBD_DELAY_START tulajdonság értéke "nem", módosítsa az értéket "igen" értékre. Az SBD szolgáltatásfájlt is ellenőriznie kell, hogy a TimeoutStartSec értéke nagyobb-e a SBD_DELAY_START értékénél. További információ: SBD-fájlkonfiguráció

[A] Hozza létre a

softdogkonfigurációs fájlt.echo softdog | sudo tee /etc/modules-load.d/softdog.conf[A] Töltse be a modult.

sudo modprobe -v softdog

SBD azure-beli megosztott lemezzel

Ez a szakasz csak akkor érvényes, ha SBD-eszközt szeretne használni egy Azure-beli megosztott lemezzel.

Megosztott Azure-lemez létrehozása és csatolása a PowerShell-lel

Módosítsa az erőforráscsoport, az Azure-régió, a virtuális gépek, a logikaiegység-számok (LUN-ok) stb. értékeit.

$ResourceGroup = "MyResourceGroup" $Location = "MyAzureRegion"Határozza meg a lemez méretét a Prémium SSD-k rendelkezésre álló lemezmérete alapján. Ebben a példában a 4G-s P1 lemezméret szerepel.

$DiskSizeInGB = 4 $DiskName = "SBD-disk1"A -MaxSharesCount paraméterrel adja meg az SBD-eszköz megosztott lemezének csatolásához szükséges fürtcsomópontok maximális számát.

$ShareNodes = 2Olyan SBD-eszközök esetében, amelyek LRS-t használnak egy Prémium szintű Azure-beli megosztott lemezhez, használja a következő tárterület-SkuName-t:

$SkuName = "Premium_LRS"A ZRS-t prémium szintű megosztott Azure-lemezhez használó SBD-eszközök esetében használja a következő tárterület-SkuName nevet:

$SkuName = "Premium_ZRS"Azure-beli megosztott lemez beállítása.

$diskConfig = New-AzDiskConfig -Location $Location -SkuName $SkuName -CreateOption Empty -DiskSizeGB $DiskSizeInGB -MaxSharesCount $ShareNodes $dataDisk = New-AzDisk -ResourceGroupName $ResourceGroup -DiskName $DiskName -Disk $diskConfigCsatolja a lemezt a fürt virtuális gépeihez.

$VM1 = "prod-cl1-0" $VM2 = "prod-cl1-1"a. Adja hozzá az Azure megosztott lemezt az 1. fürtcsomóponthoz.

$vm = Get-AzVM -ResourceGroupName $ResourceGroup -Name $VM1 $vm = Add-AzVMDataDisk -VM $vm -Name $DiskName -CreateOption Attach -ManagedDiskId $dataDisk.Id -Lun 0 Update-AzVm -VM $vm -ResourceGroupName $ResourceGroup -Verboseb. Adja hozzá az Azure megosztott lemezt a 2. fürtcsomóponthoz.

$vm = Get-AzVM -ResourceGroupName $ResourceGroup -Name $VM2 $vm = Add-AzVMDataDisk -VM $vm -Name $DiskName -CreateOption Attach -ManagedDiskId $dataDisk.Id -Lun 0 Update-AzVm -VM $vm -ResourceGroupName $ResourceGroup -Verbose

Ha az Azure CLI-vel vagy az Azure Portallal szeretne erőforrásokat üzembe helyezni, tekintse meg a ZRS-lemezek üzembe helyezését is.

Azure-beli megosztott lemez SBD-eszköz beállítása

[A] Engedélyezze az SBD-szolgáltatásokat.

sudo systemctl enable sbd[A] Győződjön meg arról, hogy a csatolt lemez elérhető.

# lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT fd0 2:0 1 4K 0 disk sda 8:0 0 30G 0 disk ├─sda1 8:1 0 2M 0 part ├─sda2 8:2 0 512M 0 part /boot/efi ├─sda3 8:3 0 1G 0 part /boot ├─sda4 8:4 0 28.5G 0 part / sdb 8:16 0 256G 0 disk ├─sdb1 8:17 0 256G 0 part /mnt sdc 8:32 0 4G 0 disk sr0 11:0 1 1024M 0 rom # lsscsi [1:0:0:0] cd/dvd Msft Virtual CD/ROM 1.0 /dev/sr0 [2:0:0:0] disk Msft Virtual Disk 1.0 /dev/sda [3:0:1:0] disk Msft Virtual Disk 1.0 /dev/sdb [5:0:0:0] disk Msft Virtual Disk 1.0 /dev/sdc[A] Kérje le a csatolt lemezek azonosítóit.

# ls -l /dev/disk/by-id/scsi-* | grep sdc lrwxrwxrwx 1 root root 9 Nov 8 16:55 /dev/disk/by-id/scsi-14d534654202020204208a67da80744439b513b2a9728af19 -> ../../sdc lrwxrwxrwx 1 root root 9 Nov 8 16:55 /dev/disk/by-id/scsi-3600224804208a67da8073b2a9728af19 -> ../../sdcA parancsok az SBD-eszköz eszközazonosítóit sorolják fel. Azt javasoljuk, hogy használja az scsi-3 azonosítót. Az előző példában az azonosító a /dev/disk/by-id/scsi-3600224804208a67da8073b2a9728af19.

[1] Hozza létre az SBD-eszközt.

A 2. lépés eszközazonosítójával hozza létre az új SBD-eszközöket az első fürtcsomóponton.

# sudo sbd -d /dev/disk/by-id/scsi-3600224804208a67da8073b2a9728af19 -1 60 -4 120 create[A] Az SBD konfigurációjának adaptálása.

a. Nyissa meg az SBD konfigurációs fájlját.

sudo vi /etc/sysconfig/sbdb. Módosítsa az SBD-eszköz tulajdonságát, engedélyezze a Pacemaker-integrációt, és módosítsa az SBD-eszköz indítási módját.

[...] SBD_DEVICE="/dev/disk/by-id/scsi-3600224804208a67da8073b2a9728af19" [...] SBD_PACEMAKER="yes" [...] SBD_STARTMODE="always" [...]Feljegyzés

Ha a SBD_DELAY_START tulajdonság értéke "nem", módosítsa az értéket "igen" értékre. Az SBD szolgáltatásfájlt is ellenőriznie kell, hogy a TimeoutStartSec értéke nagyobb-e a SBD_DELAY_START értékénél. További információ: SBD-fájlkonfiguráció

Hozza létre a

softdogkonfigurációs fájlt.echo softdog | sudo tee /etc/modules-load.d/softdog.confTöltse be a modult.

sudo modprobe -v softdog

Azure-beli kerítésügynök használata

Ez a szakasz csak akkor érvényes, ha kerítéseszközt szeretne használni egy Azure-beli kerítésügynökkel.

Azure-beli kerítésügynök-eszköz létrehozása

Ez a szakasz csak akkor érvényes, ha egy Azure-beli kerítésügynökön alapuló kerítéseszközt használ. A kerítéseszköz felügyelt identitással vagy szolgáltatásnévvel engedélyezi a Microsoft Azure-t.

Felügyelt identitás (MSI) létrehozásához hozzon létre egy rendszer által hozzárendelt felügyelt identitást a fürt minden virtuális gépéhez. Ha már létezik rendszer által hozzárendelt felügyelt identitás, a rendszer használni fogja. A felhasználó által hozzárendelt felügyelt identitásokat jelenleg nem szabad használni a Pacemakerrel. A felügyelt identitáson alapuló Azure-kerítésügynök az SLES 12 SP5 és az SLES 15 SP1 és újabb verziók esetében támogatott.

[1] Egyéni szerepkör létrehozása a kerítésügynökhöz

Alapértelmezés szerint sem a felügyelt identitás, sem a szolgáltatásnév nem rendelkezik engedélyekkel az Azure-erőforrások eléréséhez. A felügyelt identitásnak vagy szolgáltatásnévnek engedélyeket kell adnia a fürt összes virtuális gépének elindításához és leállításához (felszabadításához). Ha még nem hozta létre az egyéni szerepkört, ezt a PowerShell vagy az Azure CLI használatával teheti meg.

Használja a következő tartalmat a bemeneti fájlhoz. A tartalmat hozzá kell igazítania az előfizetéseihez. Vagyis cserélje le a xxxxxxxx-xxxx-xxxx-xxxxxxxxxxxx és a y-y-yy-yy-yy-t saját előfizetési azonosítóira. Ha csak egy előfizetéssel rendelkezik, távolítsa el a második bejegyzést az AssignableScopes területen.

{

"Name": "Linux fence agent Role",

"description": "Allows to power-off and start virtual machines",

"assignableScopes": [

"/subscriptions/xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxxxxxx",

"/subscriptions/yyyyyyyy-yyyy-yyyy-yyyy-yyyyyyyyyyyy"

],

"actions": [

"Microsoft.Compute/*/read",

"Microsoft.Compute/virtualMachines/powerOff/action",

"Microsoft.Compute/virtualMachines/start/action"

],

"notActions": [],

"dataActions": [],

"notDataActions": []

}

[A] Az egyéni szerepkör hozzárendelése

Felügyelt identitás vagy szolgáltatásnév használata.

Rendelje hozzá az utolsó fejezetben létrehozott "Linux kerítésügynök szerepkör" egyéni szerepkört a fürt virtuális gépeinek minden felügyelt identitásához. Minden virtuális gép rendszer által hozzárendelt felügyelt identitásához minden fürt virtuális gép erőforrásához hozzá kell rendelni a szerepkört. Részletes lépésekért lásd : Felügyelt identitáshozzáférés hozzárendelése egy erőforráshoz az Azure Portal használatával. Ellenőrizze, hogy az egyes virtuális gépek felügyelt identitásszerepkör-hozzárendelése tartalmazza-e az összes fürt virtuális gépet.

Fontos

Vegye figyelembe, hogy a felügyelt identitásokkal való engedélyezés hozzárendelése és eltávolítása a hatályba lépésig késleltethető .

A fürt telepítése

Feljegyzés

- [A]: Minden csomópontra vonatkozik.

- [1]: Csak az 1. csomópontra vonatkozik.

- [2]: Csak a 2. csomópontra vonatkozik.

[A] Az SLES frissítése.

sudo zypper updateFeljegyzés

Az SLES 15 SP4 esetében ellenőrizze a csomagok és

pacemakeracrmshcsomagok verzióit, hogy megfeleljenek a minimális verziókövetelményeknek:crmsh-4.4.0+20221028.3e41444-150400.3.9.1vagy újabbpacemaker-2.1.2+20211124.ada5c3b36-150400.4.6.1vagy újabb

Fontos

- SLES 12 SP5: Ha a Python-azure-core-1.23.1-2.12.8 telepítve van, előfordulhat, hogy az Azure kerítésügynöke nem indul el egy Pacemaker-fürtben, és az "Azure Resource Manager Python SDK nem található vagy nem érhető el" hibaüzenet jelenik meg a /var/log/messages alkalmazásban. További részletekért kövesse a SUSE KBA 21532 utasításait.

- SLES 15 SP4+: Az operációs rendszer frissítése után előfordulhat, hogy a Python Azure-kódtárai a Python 3.11-értelmezőt használják, ami miatt az Azure kerítésügynöke nem indul el egy Pacemaker-fürtben. Az "Azure Resource Manager Python SDK nem található vagy nem érhető el" hibaüzenet jelenik meg a /var/log/messages mappában. További részletekért kövesse a SUSE KBA 21504 utasításait.

[A] Telepítse a fürterőforrásokhoz szükséges összetevőt.

sudo zypper in socat[A] Telepítse az Azure-lb összetevőt, amelyre szüksége van a fürterőforrásokhoz.

sudo zypper in resource-agentsFeljegyzés

Ellenőrizze az erőforrás-ügynökök csomagjának verzióját, és győződjön meg arról, hogy a minimális verziókövetelmények teljesülnek:

- SLES 12 SP4/SP5: A verziónak resource-agents-4.3.018.a7fb5035-3.30.1 vagy újabb verziónak kell lennie.

- SLES 15/15 SP1: A verziónak resource-agents-4.3.0184.6ee15eb2-4.13.1 vagy újabb verziónak kell lennie.

[A] Konfigurálja az operációs rendszert.

a. A Pacemaker időnként számos folyamatot hoz létre, amelyek kimeríthetik az engedélyezett számot. Ha ez történik, a fürtcsomópontok közötti szívverés meghiúsulhat, és az erőforrások feladatátvételéhez vezethet. Az alábbi paraméter beállításával javasoljuk az engedélyezett folyamatok maximális számának növelését:

# Edit the configuration file sudo vi /etc/systemd/system.conf # Change the DefaultTasksMax #DefaultTasksMax=512 DefaultTasksMax=4096 # Activate this setting sudo systemctl daemon-reload # Test to ensure that the change was successful sudo systemctl --no-pager show | grep DefaultTasksMaxb. Csökkentse a piszkos gyorsítótár méretét. További információ: Alacsony írási teljesítmény nagy RAM-mal rendelkező SLES 11/12-kiszolgálókon.

sudo vi /etc/sysctl.conf # Change/set the following settings vm.dirty_bytes = 629145600 vm.dirty_background_bytes = 314572800c. Győződjön meg arról, hogy a vm.swappiness értéke 10, hogy csökkentse a felcserélési használatot, és előnyben részesítse a memóriát.

sudo vi /etc/sysctl.conf # Change/set the following setting vm.swappiness = 10[A] Ellenőrizze a cloud-netconfig-azure csomag verzióját.

Ellenőrizze a cloud-netconfig-azure csomag telepített verzióját a zypper info cloud-netconfig-azure futtatásával. Ha a verzió 1.3-nál korábbi, javasoljuk, hogy frissítse a cloud-netconfig-azure csomagot a legújabb elérhető verzióra.

Tipp.

Ha a környezetben a verzió 1.3-at vagy újabb verziót használ, többé nem szükséges letiltani a hálózati adapterek felhőbeli hálózati beépülő modul általi kezelését.

Csak akkor módosítsa a hálózati adapter konfigurációs fájlját, ha a cloud-netconfig-azure verziója kisebb, mint 1.3, módosítsa a hálózati adapter konfigurációs fájlját az alábbi kódban látható módon, hogy a felhőalapú hálózati beépülő modul ne távolítsa el a virtuális IP-címet (a Pacemakernek szabályoznia kell a hozzárendelést). További információ: SUSE KB 7023633.

# Edit the configuration file sudo vi /etc/sysconfig/network/ifcfg-eth0 # Change CLOUD_NETCONFIG_MANAGE # CLOUD_NETCONFIG_MANAGE="yes" CLOUD_NETCONFIG_MANAGE="no"[1] Engedélyezze az SSH-hozzáférést.

sudo ssh-keygen # Enter file in which to save the key (/root/.ssh/id_rsa), and then select Enter # Enter passphrase (empty for no passphrase), and then select Enter # Enter same passphrase again, and then select Enter # copy the public key sudo cat /root/.ssh/id_rsa.pub[2] Engedélyezze az SSH-hozzáférést.

sudo ssh-keygen # Enter file in which to save the key (/root/.ssh/id_rsa), and then select Enter # Enter passphrase (empty for no passphrase), and then select Enter # Enter same passphrase again, and then select Enter # Insert the public key you copied in the last step into the authorized keys file on the second server sudo vi /root/.ssh/authorized_keys # copy the public key sudo cat /root/.ssh/id_rsa.pub[1] Engedélyezze az SSH-hozzáférést.

# insert the public key you copied in the last step into the authorized keys file on the first server sudo vi /root/.ssh/authorized_keys[A] Telepítse a kerítésügynök-csomagot , ha kerítést használ az Azure kerítésügynöke alapján.

sudo zypper install fence-agentsFontos

A kerítésügynök-csomag telepített verziójának 4.4.0-s vagy újabb verziónak kell lennie ahhoz, hogy kihasználhassa az Azure kerítésügynökkel való gyorsabb feladatátvételi időket, amikor egy fürtcsomópont el van kerítve. Ha egy korábbi verziót futtat, javasoljuk, hogy frissítse a csomagot.

Fontos

Felügyelt identitás használata esetén a kerítésügynök-csomag telepített verziójának a következőnek kell lennie:

- SLES 12 SP5: kerítésügynökök 4.9.0+git.1624456340.8d746be9-3.35.2 vagy újabb

- SLES 15 SP1 és újabb: kerítésügynökök 4.5.2+git.1592573838.1e0863 vagy újabb.

A korábbi verziók nem működnek megfelelően a felügyelt identitáskonfigurációval.

[A] Telepítse a fence-agents-azure-arm csomagot.

SLES 12 SP5 esetén, ha verziót vagy újabb verziót

4.9.0+git.1624456340.8d746be9-3.41.3használfence-agents, és az SLES 15 SP4 és újabb verziók esetében telepítenie kell afence-agents-azure-armcsomagot. Ez a csomag tartalmazza az összes szükséges függőséget.# On SLES 12 SP5 with fence-agents version 4.9.0+git.1624456340.8d746be9-3.41.3 or higher. You might need to activate the public cloud extension first SUSEConnect -p sle-module-public-cloud/12/x86_64 sudo zypper install fence-agents-azure-arm # On SLES 15 SP4 and later. You might need to activate the public cloud extension first. In this example, the SUSEConnect SUSEConnect -p sle-module-public-cloud/15.4/x86_64 sudo zypper install fence-agents-azure-arm[A] Telepítse az Azure Python SDK és az Azure Identity Python modult.

Az SLES 12 SP5 esetén, ha a

fence-agentsverzió alacsonyabb, akkor4.9.0+git.1624456340.8d746be9-3.41.3az SLES 15 SP3-hoz és az alábbi verziókhoz további csomagokat kell telepítenie.# You might need to activate the public cloud extension first SUSEConnect -p sle-module-public-cloud/12/x86_64 sudo zypper install python-azure-mgmt-compute sudo zypper install python-azure-identity # You might need to activate the public cloud extension first. In this example, the SUSEConnect command is for SLES 15 SP1 SUSEConnect -p sle-module-public-cloud/15.1/x86_64 sudo zypper install python3-azure-mgmt-compute sudo zypper install python3-azure-identityFontos

A verziótól és a rendszerkép típusától függően előfordulhat, hogy az Azure Python SDK telepítése előtt aktiválnia kell a nyilvános felhőbővítményt az operációs rendszer kiadásához. A bővítményt a futtatással

SUSEConnect ---list-extensionsellenőrizheti. A gyorsabb feladatátvételi idő elérése az Azure kerítésügynökkel:- Az SLES 12 SP5-ben telepítse a Python-azure-mgmt-compute csomag 4.6.2-es vagy újabb verzióját.

- Ha a Python-azure-mgmt-compute vagy a Python3-azure-mgmt-compute csomag verziója 17.0.0-6.7.1, kövesse a SUSE KBA utasításait a kerítésügynökök verziójának frissítéséhez, és ha hiányzik, telepítse a Python-modulhoz készült Azure Identity-ügyfélkódtárat.

[A] Állítsa be a gazdagépnév felbontását.

Használhat DNS-kiszolgálót, vagy módosíthatja az /etc/hosts fájlt az összes csomóponton. Ez a példa a /etc/hosts fájl használatát mutatja be.

Cserélje le az IP-címet és a gazdagépnevet a következő parancsokban.

Fontos

Ha gazdagépneveket használ a fürtkonfigurációban, elengedhetetlen, hogy megbízható állomásnévfeloldás legyen. A fürt kommunikációja meghiúsul, ha a nevek nem érhetők el, és ez a fürt feladatátvételi késéséhez vezethet.

A /etc/gazdagépek használatának előnye, hogy a fürt függetlenné válik a DNS-étől, ami szintén egy meghibásodási pont lehet.

sudo vi /etc/hostsSzúrja be a következő sorokat a /etc/hosts fájlba. Módosítsa az IP-címet és a gazdagépnevet úgy, hogy megfeleljen a környezetének.

# IP address of the first cluster node 10.0.0.6 prod-cl1-0 # IP address of the second cluster node 10.0.0.7 prod-cl1-1[1] Telepítse a fürtöt.

Ha SBD-eszközöket használ a kerítéshez (az iSCSI-célkiszolgálóhoz vagy az Azure megosztott lemezhez):

sudo crm cluster init # ! NTP is not configured to start at system boot. # Do you want to continue anyway (y/n)? y # /root/.ssh/id_rsa already exists - overwrite (y/n)? n # Address for ring0 [10.0.0.6] Select Enter # Port for ring0 [5405] Select Enter # SBD is already configured to use /dev/disk/by-id/scsi-36001405639245768818458b930abdf69;/dev/disk/by-id/scsi-36001405afb0ba8d3a3c413b8cc2cca03;/dev/disk/by-id/scsi-36001405f88f30e7c9684678bc87fe7bf - overwrite (y/n)? n # Do you wish to configure an administration IP (y/n)? nHa nem SBD-eszközöket használ a kerítéshez:

sudo crm cluster init # ! NTP is not configured to start at system boot. # Do you want to continue anyway (y/n)? y # /root/.ssh/id_rsa already exists - overwrite (y/n)? n # Address for ring0 [10.0.0.6] Select Enter # Port for ring0 [5405] Select Enter # Do you wish to use SBD (y/n)? n # WARNING: Not configuring SBD - STONITH will be disabled. # Do you wish to configure an administration IP (y/n)? n

[2] Adja hozzá a csomópontot a fürthöz.

sudo crm cluster join # ! NTP is not configured to start at system boot. # Do you want to continue anyway (y/n)? y # IP address or hostname of existing node (for example, 192.168.1.1) []10.0.0.6 # /root/.ssh/id_rsa already exists - overwrite (y/n)? n[A] Módosítsa a hacluster jelszavát ugyanarra a jelszóra.

sudo passwd hacluster[A] Módosítsa a corosync beállításait.

sudo vi /etc/corosync/corosync.confa. Ellenőrizze a fájl alábbi szakaszát, és állítsa be, hogy az értékek nincsenek-e vagy eltérőek. A memóriamegőrző karbantartás érdekében mindenképpen módosítsa a jogkivonatot 30000-re. További információ: "Virtuális gépek karbantartása az Azure-ban" című cikk Linux vagy Windows rendszeren.

[...] token: 30000 token_retransmits_before_loss_const: 10 join: 60 consensus: 36000 max_messages: 20 interface { [...] } transport: udpu } nodelist { node { ring0_addr:10.0.0.6 } node { ring0_addr:10.0.0.7 } } logging { [...] } quorum { # Enable and configure quorum subsystem (default: off) # See also corosync.conf.5 and votequorum.5 provider: corosync_votequorum expected_votes: 2 two_node: 1 }b. Indítsa újra a corosync szolgáltatást.

sudo service corosync restart

Kerítéseszköz létrehozása a Pacemaker-fürtön

Tipp.

- A kétcsomópontos pacemaker-fürtön belüli kerítésversenyek elkerülése érdekében további "priority-fencing-delay" fürttulajdonságokat is konfigurálhat. Ez a tulajdonság további késést okoz egy olyan csomópont kerítésében, amely nagyobb erőforrás-prioritással rendelkezik felosztási forgatókönyv esetén. További részletekért tekintse meg a SUSE Linux Enterprise Server magas rendelkezésre állású bővítményfelügyeleti útmutatóját.

- A "priority-fencing-delay" fürttulajdonság beállítására vonatkozó utasítás a megfelelő SAP ASCS/ERS -ben található (csak az ENSA2-n alkalmazható) és az SAP HANA magas rendelkezésre állású dokumentumában.

[1] Ha SBD-eszközt (iSCSI-célkiszolgálót vagy Azure-beli megosztott lemezt) használ kerítéseszközként, futtassa az alábbi parancsokat. Engedélyezze a kerítéseszköz használatát, és állítsa be a kerítés késleltetését.

sudo crm configure property stonith-timeout=144 sudo crm configure property stonith-enabled=true # List the resources to find the name of the SBD device sudo crm resource list sudo crm resource stop stonith-sbd sudo crm configure delete stonith-sbd sudo crm configure primitive stonith-sbd stonith:external/sbd \ params pcmk_delay_max="15" \ op monitor interval="600" timeout="15"[1] Ha egy Azure-beli kerítésügynököt használ a kerítéshez, futtassa az alábbi parancsokat. Miután szerepköröket rendelt mindkét fürtcsomóponthoz, konfigurálhatja a fürtön lévő kerítéseszközöket.

sudo crm configure property stonith-enabled=true sudo crm configure property concurrent-fencing=trueFeljegyzés

A "pcmk_host_map" beállítás csak akkor szükséges a parancsban, ha a gazdagépnevek és az Azure-beli virtuális gépek nevei nem azonosak. Adja meg a leképezést a gazdagépnév:vm-name formátumban.

# Adjust the command with your subscription ID and resource group of the VM

sudo crm configure primitive rsc_st_azure stonith:fence_azure_arm \

params msi=true subscriptionId="subscription ID" resourceGroup="resource group" \

pcmk_monitor_retries=4 pcmk_action_limit=3 power_timeout=240 pcmk_reboot_timeout=900 pcmk_delay_max=15 pcmk_host_map="prod-cl1-0:prod-cl1-0-vm-name;prod-cl1-1:prod-cl1-1-vm-name" \

op monitor interval=3600 timeout=120

sudo crm configure property stonith-timeout=900

Ha kerítéseszközt használ, a szolgáltatásnév konfigurációja alapján olvassa el a Pacemaker-fürtök SPN-ről MSI-re váltását az Azure-kerítés használatával, és ismerje meg, hogyan konvertálható felügyelt identitáskonfigurációra.

Fontos

A monitorozási és kerítési műveletek deszerializálva vannak. Ennek eredményeképpen, ha hosszabb ideig futó monitorozási művelet és egyidejű kerítésesemény van, a fürt feladatátvétele nem késik, mert a figyelési művelet már fut.

Tipp.

Az Azure-beli kerítésügynökhöz a nyilvános végpontokhoz való kimenő kapcsolódás szükséges a dokumentált módon, a lehetséges megoldásokkal együtt a standard ILB-t használó virtuális gépek nyilvános végpontkapcsolatában.

Pacemaker konfigurálása azure-beli ütemezett eseményekhez

Az Azure ütemezett eseményeket kínál. Az ütemezett események a metaadat-szolgáltatáson keresztül érhetők el, és lehetővé teszik, hogy az alkalmazás felkészüljön az ilyen eseményekre. Az azure-events-az erőforrásügynök figyeli az ütemezett Azure-eseményeket. Ha eseményeket észlel, és az erőforrás-ügynök megállapítja, hogy egy másik fürtcsomópont érhető el, beállít egy fürtállapot-attribútumot. Ha a fürt állapotattribútuma egy csomóponthoz van beállítva, a helykorlátozás eseményindítói és az összes olyan erőforrás, amelynek a neve nem "állapottal" kezdődik, az ütemezett eseményekkel távol lesz a csomóponttól. Ha az érintett fürtcsomópont nem futtat fürterőforrásokat, a rendszer nyugtázza az ütemezett eseményt, és végrehajthatja a műveletet, például az újraindítást.

Fontos

Korábban ez a dokumentum az azure-events erőforrás-ügynök használatát ismertette. Az új azure-events-az erőforrásügynök teljes mértékben támogatja a különböző rendelkezésre állási zónákban üzembe helyezett Azure-környezeteket. Javasoljuk, hogy az azure-events-az ügynököt minden magas rendelkezésre állású SAP-rendszerhez használja a Pacemakerrel.

[A] Győződjön meg arról, hogy az Azure-events-ügynök csomagja már telepítve van és naprakész.

sudo zypper info resource-agentsMinimális verziókövetelmények:

- SLES 12 SP5:

resource-agents-4.3.018.a7fb5035-3.98.1 - SLES 15 SP1:

resource-agents-4.3.0184.6ee15eb2-150100.4.72.1 - SLES 15 SP2:

resource-agents-4.4.0+git57.70549516-150200.3.56.1 - SLES 15 SP3:

resource-agents-4.8.0+git30.d0077df0-150300.8.31.1 - SLES 15 SP4 és újabb:

resource-agents-4.10.0+git40.0f4de473-150400.3.19.1

- SLES 12 SP5:

[1] Konfigurálja az erőforrásokat a Pacemakerben.

#Place the cluster in maintenance mode sudo crm configure property maintenance-mode=true[1] Állítsa be a pacemaker-fürt állapotcsomópont-stratégiáját és korlátozását

sudo crm configure property node-health-strategy=custom sudo crm configure location loc_azure_health \ /'!health-.*'/ rule '#health-azure': defined '#uname'Fontos

Ne definiáljon más erőforrásokat a fürtben az "állapot" kezdetűtől kezdve a dokumentáció következő lépéseiben leírt erőforrásokon kívül.

[1] Állítsa be a fürtattribútumok kezdeti értékét. Futtassa az egyes fürtcsomópontokhoz. Kibővített környezetekhez, beleértve a többségi gyártó virtuális gépét is.

sudo crm_attribute --node prod-cl1-0 --name '#health-azure' --update 0 sudo crm_attribute --node prod-cl1-1 --name '#health-azure' --update 0[1] Konfigurálja az erőforrásokat a Pacemakerben. Fontos: Az erőforrásoknak "health-azure"-val kell kezdődniük.

sudo crm configure primitive health-azure-events ocf:heartbeat:azure-events-az \ meta allow-unhealthy-nodes=true failure-timeout=120s \ op start start-delay=60s \ op monitor interval=10s sudo crm configure clone health-azure-events-cln health-azure-eventsFeljegyzés

Az "health-azure-events" erőforrás konfigurálásakor a következő figyelmeztető üzenet figyelmen kívül hagyható.

FIGYELMEZTETÉS: health-azure-events: ismeretlen attribútum : "allow-unhealthy-nodes".

A Pacemaker-fürt karbantartási módból való kikapcsolása

sudo crm configure property maintenance-mode=falseTörölje az engedélyezés során felmerülő hibákat, és ellenőrizze, hogy az állapot-Azure-események erőforrásai sikeresen elindultak-e az összes fürtcsomóponton.

sudo crm resource cleanupAz ütemezett események lekérdezésének első végrehajtása akár 2 percet is igénybe vehet. Az ütemezett eseményekkel végzett pacemaker-tesztelés újraindítási vagy ismételt üzembe helyezési műveleteket használhat a fürt virtuális gépeihez. További információkért tekintse meg az ütemezett események dokumentációját.

Feljegyzés

Miután konfigurálta a Pacemaker-erőforrásokat az Azure-events-ügynökhöz, ha karbantartási módban vagy kívül helyezi a fürtöt, figyelmeztető üzeneteket kaphat, például:

FIGYELMEZTETÉS: cib-bootstrap-options: ismeretlen attribútum "hostName_hostname"

FIGYELMEZTETÉS: cib-bootstrap-options: ismeretlen "azure-events_globalPullState" attribútum

FIGYELMEZTETÉS: cib-bootstrap-options: ismeretlen attribútum "hostName_ gazdagépnév"

Ezek a figyelmeztető üzenetek figyelmen kívül hagyhatók.

Következő lépések

- Azure-beli virtuális gépek tervezése és implementálása az SAP-hoz

- Azure-beli virtuális gépek üzembe helyezése az SAP-hoz

- Azure Virtual Machines DBMS üzembe helyezése AZ SAP-hoz

- Magas rendelkezésre állás az NFS-hez azure-beli virtuális gépeken a SUSE Linux Enterprise Serveren

- Magas rendelkezésre állás Azure-beli virtuális gépeken lévő SAP NetWeaver esetében SUSE Linux Enterprise Server rendszeren SAP-alkalmazásokhoz

- Az SAP HANA azure-beli virtuális gépeken való vészhelyreállításának magas rendelkezésre állásáról és vészhelyreállításának megtervezéséről további információt az SAP HANA magas rendelkezésre állása az Azure-beli virtuális gépeken című témakörben talál .