Adatok importálása

Fontos

A (klasszikus) Machine Learning Studio támogatása 2024. augusztus 31-én megszűnik. Javasoljuk, hogy addig térjen át az Azure Machine Learning használatára.

2021. december 1-től kezdve nem fog tudni létrehozni új (klasszikus) Machine Learning Studio-erőforrásokat. 2024. augusztus 31-ig továbbra is használhatja a meglévő (klasszikus) Machine Learning Studio-erőforrásokat.

- A gépi tanulási projektek ML Studióból (klasszikus) Azure Machine Learning való áthelyezéséről olvashat.

- További információ a Azure Machine Learning.

A (klasszikus) ML Studio dokumentációjának kivezetése folyamatban van, és a jövőben nem várható a frissítése.

Adatok betöltése külső forrásokból a weben; az Azure-beli felhőalapú tárolás különböző formáiból, például táblákból, blobokból és SQL-adatbázisokból; helyszíni SQL Server adatbázisokból

Kategória: Adatbemenet és -kimenet

Megjegyzés

Csak a következőre vonatkozik: Machine Learning Studio (klasszikus)

Hasonló húzási modulok érhetők el Azure Machine Learning tervezőben.

A modul áttekintése

Ez a cikk azt ismerteti, hogyan használható az Adatok importálása modul a (klasszikus) Machine Learning Studióban az adatok gépi tanulási kísérletbe való betöltéséhez a meglévő felhőbeli adatszolgáltatásokból.

A modul egy varázslóval segíti a tárolási lehetőségek kiválasztását, és a meglévő előfizetések és fiókok közül választva gyorsan konfigurálhatja az összes beállítást. Szerkesztenie kell egy meglévő adatkapcsolatot? Nincs probléma; A varázsló betölti az összes korábbi konfigurációs részletet, hogy ne kelljen elölről kezdenie.

Miután meghatározta a kívánt adatokat, és csatlakozott a forráshoz, az Adatok importálása az egyes oszlopok adattípusát a benne található értékek alapján következteti, és betölti az adatokat a Machine Learning Studio (klasszikus) munkaterületére. Az Adatok importálása egy olyan adatkészlet, amely bármely kísérlethez használható.

Fontos

Jelenleg a támogatott tárfiókok típusai korlátozottak. További információ: Technikai megjegyzések.

Ha a forrásadatok megváltoznak, frissítheti az adathalmazt, és új adatokat adhat hozzá az Adatok importálása újrafuttatásával. Ha azonban nem szeretne a kísérlet minden futtatásakor újraolvasni a forrásból, válassza a Gyorsítótárazott eredmények használata beállítást IGAZ értékre. Ha ezt a beállítást választja, a modul ellenőrzi, hogy a kísérlet korábban ugyanazzal a forrással és ugyanazokkal a bemeneti beállításokkal futott-e. Ha egy korábbi futtatás található, a rendszer a gyorsítótárban lévő adatokat használja ahelyett, hogy újra betölti az adatokat a forrásból.

Megjegyzés

Ezt a modult korábban Olvasónak hívták. Ha korábban egy kísérletben használta az Olvasó modult, a rendszer átnevezi az Adatok importálása parancsra a kísérlet frissítésekor.

Adatforrások

Az Adatok importálása modul az alábbi adatforrásokat támogatja. A hivatkozásokra kattintva részletes útmutatást és példákat találhat az egyes adatforrások használatára.

Ha nem tudja biztosan, hogyan vagy hol kell tárolnia az adatokat, tekintse meg ezt az útmutatót az adatelemzési folyamat gyakori adatforgatókönyveihez: A Machine Learning fejlett elemzési forgatókönyvei.

| Adatforrás | Használat a következővel: |

|---|---|

| Webes URL-cím HTTP-en keresztül | A HTTP-t használó, CSV, TSV, ARFF vagy SvmLight formátumban megadott webes URL-címen tárolt adatok lekérése |

| Hive-lekérdezés | Adatok lekérése elosztott tárolóból a Hadoopban. A kívánt adatokat a HiveQL nyelv használatával adhatja meg |

| Azure SQL Database | Adatok lekérése Azure SQL Database vagy Azure SQL Data Warehouse |

| Azure Table | Az Azure Table Service-ben tárolt adatok lekérése |

| Importálás Azure Blob Storage | Az Azure Blob szolgáltatásban tárolt adatok lekérése |

| Adatcsatorna-szolgáltatók | Adatcsatornaként közzétett adatok lekérése OData formátumban |

| Importálás helyszíni SQL Server-adatbázisból | Adatok lekérése helyszíni SQL Server-adatbázisból a Microsoft adatkezelés Gateway használatával |

| Azure Cosmos DB | JSON formátumban tárolt adatok lekérése az Azure Cosmos DB-ben. |

Tipp

JSON formátumban szeretne adatokat importálni? Az R és Python egyaránt támogatják a REST API-kat, ezért az Adatok elemzéséhez és azure-ML-adatkészletként való mentéséhez használja az Execute Python Script vagy Execute R Script modult.

Vagy használja a CosmosDB-hez készült SQL DB API-t, amely több JSON-tárolót is támogat, beleértve a MongoDB is, hogy beolvassa az adatokat az Importálás az Azure Cosmos DB-ből lehetőséggel. További információ: Importálás az Azure Cosmos DB-ből.

Adatok importálása

Adja hozzá az Adatok importálása modult a kísérlethez. Ezt a modult a Studio (klasszikus) Adatbemenet és kimenet kategóriájában találja.

Kattintson az Adatimportálás indítása varázslóra az adatforrás varázslóval történő konfigurálásához.

A varázsló lekéri a fiók nevét és hitelesítő adatait, és segít más beállítások konfigurálásában. Ha egy meglévő konfigurációt szerkeszt, először betölti az aktuális értékeket.

Ha nem szeretné használni a varázslót, kattintson az Adatforrás elemre, és válassza ki, hogy milyen típusú felhőalapú tárolóból olvas.

A további beállítások attól függenek, hogy milyen típusú tárolót választ, és hogy a tárterület biztonságos-e vagy sem. Előfordulhat, hogy meg kell adnia a fiók nevét, fájltípusát vagy hitelesítő adatait. Egyes források nem igényelnek hitelesítést; mások számára előfordulhat, hogy ismernie kell a fiók nevét, kulcsát vagy tárolónevét.

Részletekért tekintse meg az adatforrások listáját.

Válassza a Gyorsítótárazott eredmények használata lehetőséget, ha az adathalmazt újra szeretné használni az egymást követő futtatásokhoz.

Feltételezve, hogy a modulparaméterek nem módosultak, a kísérlet csak a modul első futtatásakor tölti be az adatokat, és ezt követően az adathalmaz gyorsítótárazott verzióját használja.

Törölje ezt a jelölőnégyzetet, ha a kísérlet minden futtatásakor újra be kell töltenie az adatokat.

Futtassa a kísérletet.

Amikor az Adatok importálása betölti az adatokat a Studióba (klasszikus), az egyes oszlopok adattípusát a benne található értékek alapján( numerikus vagy kategorikus) következteti.

Ha van fejléc, a rendszer a kimeneti adathalmaz oszlopainak elnevezésére használja a fejlécet.

Ha nincsenek meglévő oszlopfejlécek az adatokban, a rendszer új oszlopneveket hoz létre col1, col2 formátumban,... ,coln.

Results (Eredmények)

Amikor az importálás befejeződött, kattintson a kimeneti adathalmazra, és válassza a Vizualizáció lehetőséget, és ellenőrizze, hogy az adatok importálása sikeres volt-e.

Ha a kísérlet minden futtatásakor új adatkészlet importálása helyett újra szeretné menteni az adatokat, kattintson a jobb gombbal a kimenetre, és válassza a Mentés adathalmazként parancsot. Válasszon nevet az adathalmaznak. A mentett adatkészlet a mentéskor megőrzi az adatokat, és az adatok nem frissülnek a kísérlet újrafuttatásakor, még akkor sem, ha a kísérlet adathalmaza megváltozik. Ez hasznos lehet az adatok pillanatképeinek készítéséhez.

Az adatok importálása után szükség lehet néhány további modellezési és elemzési előkészületre:

Az adatok statisztikai összegzéseinek létrehozása az adatok összegzése vagy a számítási alapstatisztika használatával.

A Metaadatok szerkesztése funkcióval módosíthatja az oszlopneveket, más adattípusként kezelhet egy oszlopot, vagy jelezheti, hogy egyes oszlopok címkék vagy szolgáltatások.

Az Adathalmaz oszlopainak kijelölése lehetőségével kiválaszthatja az oszlopok egy részhalmazát, amelyet átalakíthat vagy használhat a modellezés során. Az átalakított vagy eltávolított oszlopok könnyen újracsatlakozhatnak az eredeti adathalmazhoz az Oszlopok hozzáadása vagy az Adatillesztés modul használatával.

A Partíció és a Minta használatával ossza el az adathalmazt, végezzen mintavételezést, vagy kérje le a legfelső n sorokat.

Az SQL-átalakítás alkalmazásával összesítheti az adatokat, szűrheti vagy átalakíthatja AZ SQL-utasítások használatával.

Ezekkel a modulokkal törölheti a szövegoszlopokat, és új szövegszolgáltatásokat hozhat létre:

- Szöveg előfeldolgozása

- N-Gram-funkciók kinyerése szövegből

- Megnevezett entitások felismerése

- Hajtsa végre Python szkriptet, hogy egyéni NLP-t implementáljon az nltk alapján.

Technikai megjegyzések

Ez a szakasz az Adatok importálása modullal kapcsolatos ismert problémák listáját, valamint néhány olyan általános hibaelhárítási információt tartalmaz, amelyek nem a forrástípusra vonatkoznak.

Támogatott fióktípusok

Az Azure gyakran új szolgáltatásokat vagy új tárolási típusokat ad ki; az új fióktípusok támogatása azonban általában késik a Machine Learning Studióban (klasszikus).

Jelenleg Machine Learning támogatja az összes általános célú tárfiókot, kivéve a zónaredundáns tárolást (ZRS) használó fiókokat.

A helyileg redundáns tárolás (LRS) és a georedundáns tárolási lehetőségek támogatottak.

A blokkblobok támogatottak, de a hozzáfűző blobok nem.

Gyakori kérdések és problémák

Ez a szakasz ismert problémákat, gyakori kérdéseket és kerülő megoldásokat ismertet.

A fejléceknek egysorosnak kell lenniük

Ha CSV-fájlokból importál, vegye figyelembe, hogy Machine Learning lehetővé teszi egyetlen fejlécsor használatát. Többsoros fejlécek nem szúrhatók be.

Az importáláskor támogatott egyéni elválasztók, de nem exportálhatók

Az Adatok importálása modul támogatja az olyan adatok importálását, amelyek alternatív oszlopelválasztókat használnak, például a pontosvesszőt (;), amelyet gyakran használnak Európában. Amikor külső tárolóban lévő CSV-fájlokból importál adatokat, válassza ki a kódolási beállítással rendelkező CSV-t , és válasszon egy támogatott kódolást.

Az adatok exportálásra való előkészítésekor azonban nem hozhat létre alternatív elválasztókat a Konvertálás CSV-modullal .

Gyenge oszlopelválasztás vesszőt tartalmazó sztringadatokon

Az oszlopelválasztóként (tabulátorok, szóközök, vesszők stb.) megadható összes karakter véletlenszerűen is megtalálható a szövegmezőkben. A szöveg CSV-ből való importálása mindig körültekintően jár el, hogy elkerülje a szöveg felesleges új oszlopok közötti elválasztását. Ez egy gyakori probléma a szövegfeldolgozásban, amelyet valószínűleg különböző módokon észlelt és kezelt.

Problémák akkor is előfordulhatnak, ha vesszőt tartalmazó karakterlánc-oszlopot próbál exportálni. Machine Learning nem támogatja az ilyen adatok speciális kezelését vagy speciális fordítását, például a sztringek idézőjelek közé helyezését. A vesszők előtt nem használhat feloldó karaktereket is, hogy a vesszők literális karakterként legyenek kezelve. Ennek következtében a kimeneti fájlban új mezők jönnek létre a sztringmezőben észlelt egyes vesszőkhöz.

Az exportálási problémák elkerülése érdekében a Szöveg előfeldolgozása modullal távolítsa el az írásjelek karaktereit a sztringmezőkből.

Egyéni R-szkriptet vagy Python szkriptet is használhat összetett szövegek feldolgozásához, és biztosíthatja az adatok megfelelő importálását vagy exportálását.

UTF-8 kódolás szükséges

Machine Learning UTF-8 kódolást igényel. Ha az importált adatok más kódolást használnak, vagy más alapértelmezett kódolást használó adatforrásból lettek exportálva, különböző problémák jelentkezhetnek a szövegben.

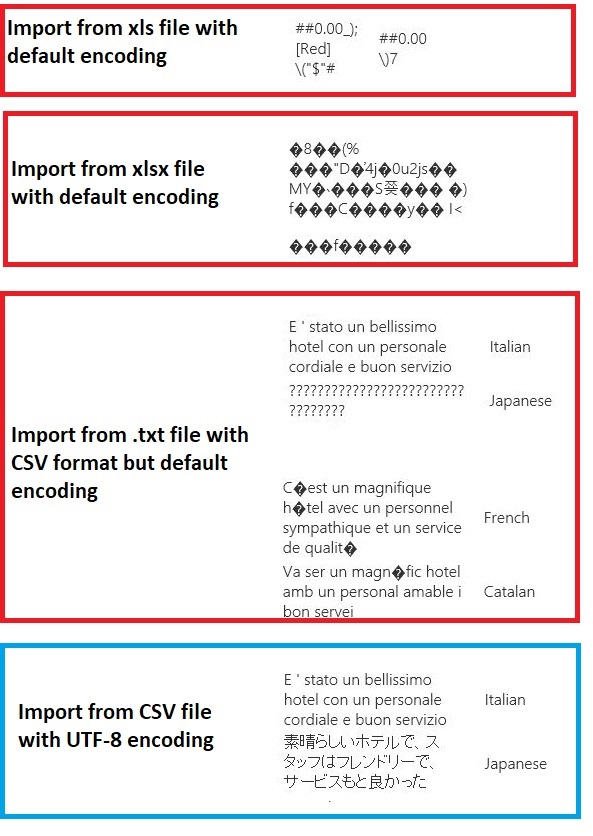

Az alábbi kép például ugyanazt a többnyelvű adatkészletet tartalmazza, amelyet Excel exportált, majd Machine Learning négy különböző fájltípus- és kódolási kombinációval importált.

A harmadik példa azokat az adatokat mutatja be, amelyek a Excel csv formátumban történő mentése során vesztek el, mivel a megfelelő kódolás nem volt megadva abban az időben. Ezért ha problémákba ütközik, ne csak azt a fájlt ellenőrizze, amelyből importálja, hanem azt is, hogy a fájl megfelelően lett-e exportálva a forrásból.

Az adathalmaz nem rendelkezik oszlopnevekkel

Ha az importált adathalmaz nem rendelkezik oszlopnevekkel, mindenképpen adja meg a "nincs fejléc" beállítás egyikét. Ha így tesz, az Adatok importálása az alapértelmezett oszlopneveket col1, Col2 stb. formátumban adja hozzá. Később a Metaadatok szerkesztése parancs használatával javítsa ki az oszlopneveket.

Ha egy adatkészletet CSV-fájlba exportál, a Metaadatok szerkesztése parancsot használva adjon hozzá oszlopneveket az átalakítás vagy exportálás előtt.

Megkerülő megoldások nem támogatott adatforrásokhoz

Ha olyan forrásból kell adatokat lekérnie, amely nem szerepel a listában, többféle kerülő megoldással próbálkozhat:

Ha a számítógépen lévő fájlból szeretne adatokat feltölteni, kattintson az Új a Studióban (klasszikus), válassza az Adatkészlet lehetőséget, majd válassza a Helyi fájlból lehetőséget. Keresse meg a fájlt, és adja meg a formátumot (TSV, CSV stb.). További információ: Betanítási adatok importálása a Studióba (klasszikus)

Használja az R vagy Python. Az R-szkript végrehajtása modul megfelelő R-csomaggal használható más felhőalapú adatbázisokból származó adatok lekéréséhez.

Az Execute Python Script modul lehetővé teszi az adatok különböző forrásokból való olvasását és konvertálását is. A Microsoft adatelemzőinek alábbi példáit a Cortana Intelligence Galleryben tekinti meg:

Adatok lekérése AWS-fürtökről. Lekérdezést futtathat egy általános Hive-fürtön, amelyen engedélyezve van a WebHCat vagy a HCatalog végpont. Vagy közzéteheti lapként, és elolvashatja a webes URL-címről.

Adatok lekérése MongoDB. Az Azure Cosmos DB adatmigrálási segédprogramja számos különböző forrást és formátumot támogat. További információk és példák: Azure Cosmos DB: Adatmigrálási eszköz

További ötletekért és kerülő megoldásokért tekintse meg a Machine Learning fórumot vagy az Azure AI-galériát.

Modulparaméterek

Minden adatforrást különböző beállításokkal kell konfigurálni. Ez a táblázat csak az összes adatforrásban gyakori beállításokat sorolja fel.

| Name | Tartomány | Típus | Alapértelmezett | Description |

|---|---|---|---|---|

| Adatforrás | Lista | Adatforrás vagy fogadó | Blobszolgáltatás az Azure Storage | Az adatforrás lehet HTTP, névtelen HTTPS, a Blob szolgáltatásban vagy a Table Service-ben található fájl, egy Azure-beli SQL-adatbázis, egy Azure SQL Data Warehouse, Egy Hive-tábla vagy egy OData-végpont. |

| Gyorsítótárazott eredmények használata | IGAZ/HAMIS | Logikai | HAMIS | Ha IGAZ, a modul ellenőrzi, hogy a kísérlet korábban ugyanazokkal a forrás- és beviteli beállításokkal futott-e, és ha egy korábbi futtatás található, a rendszer a gyorsítótárban lévő adatokat használja. Ha HAMIS, vagy ha módosításokat talál, az adatok újratöltődnek a forrásból. |

Kimenetek

| Név | Típus | Description |

|---|---|---|

| Eredmények adatkészlete | Adattábla | Letöltött adatokkal rendelkező adatkészlet |

Kivételek

| Kivétel | Description |

|---|---|

| 0027-s hiba | Kivételt képez, ha két objektumnak azonos méretűnek kell lennie, de nem. |

| 0003-os hiba | Kivétel történik, ha egy vagy több bemenet null értékű vagy üres. |

| 0029-s hiba | Kivétel akkor fordul elő, ha érvénytelen URI-t ad át. |

| 0030-ás hiba | kivétel jelenik meg abban az esetben, ha nem lehet letölteni egy fájlt. |

| 0002-s hiba | Kivétel történik, ha egy vagy több paraméter nem elemezhető vagy konvertálható a megadott típusból a célmetódus által megkövetelt típusra. |

| 0009-s hiba | Kivétel történik, ha az Azure Storage-fiók neve vagy a tároló neve helytelenül van megadva. |

| 0048-ás hiba | Kivétel történik, ha nem lehet megnyitni egy fájlt. |

| 0015-ös hiba | Kivétel történik, ha az adatbázis-kapcsolat meghiúsult. |

| 0046-os hiba | Kivétel történik, ha nem lehet könyvtárat létrehozni a megadott elérési úton. |

| 0049-s hiba | Kivétel akkor fordul elő, ha nem lehet elemezni egy fájlt. |

A Studio (klasszikus) modulokkal kapcsolatos hibák listáját Machine Learning hibakódok között találja.

Az API-kivételek listájáért lásd Machine Learning REST API hibakódjait.

Lásd még

Adatbemenet és -kimenet

Adatformátum-átalakítások

Adatok exportálása

A-Z modullista