Menyalin data dari Spark menggunakan Azure Data Factory atau Synapse Analytics

BERLAKU UNTUK:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Cobalah Data Factory di Microsoft Fabric, solusi analitik all-in-one untuk perusahaan. Microsoft Fabric mencakup semuanya mulai dari pergerakan data hingga ilmu data, analitik real time, kecerdasan bisnis, dan pelaporan. Pelajari cara memulai uji coba baru secara gratis!

Artikel ini menguraikan cara menggunakan Aktivitas Salin di alur Azure Data Factory atau Synapse Analytics untuk menyalin data dari Spark. Artikel tersebut dibuat berdasarkan artikel gambaran umum aktivitas salin yang menyajikan gambaran umum aktivitas salin.

Kemampuan yang didukung

Konektor Spark ini didukung untuk kemampuan berikut:

| Kemampuan yang didukung | IR |

|---|---|

| Aktivitas penyalinan (sumber/-) | (1) (2) |

| Aktivitas pencarian | (1) (2) |

① Runtime integrasi Azure ② Runtime integrasi yang dihost sendiri

Untuk daftar penyimpanan data yang didukung sebagai sumber/sink oleh aktivitas salin, lihat tabel Penyimpanan data yang didukung.

Layanan ini menyediakan driver bawaan untuk mengaktifkan konektivitas, oleh karena itu Anda tidak perlu memasang driver apa pun secara manual menggunakan konektor ini.

Prasyarat

Jika penyimpanan data Anda terletak di dalam jaringan lokal, jaringan virtual Azure, atau Amazon Virtual Private Cloud, Anda harus mengonfigurasi runtime integrasi yang dihosting sendiri untuk menghubungkannya.

Jika penyimpanan data Anda adalah layanan data cloud terkelola, Anda dapat menggunakan Azure Integration Runtime. Jika akses dibatasi untuk IP yang disetujui dalam aturan firewall, Anda dapat menambahkan IP Azure Integration Runtime ke daftar izinkan.

Anda juga dapat menggunakan fitur runtime integrasi jaringan virtual terkelola di Azure Data Factory untuk mengakses jaringan lokal tanpa menginstal dan mengonfigurasi runtime integrasi yang dihosting sendiri.

Untuk informasi selengkapnya tentang mekanisme dan opsi keamanan jaringan yang didukung oleh Data Factory, lihat Strategi akses data.

Memulai

Untuk melakukan aktivitas Salin dengan alur, Anda dapat menggunakan salah satu alat atau SDK berikut:

- Alat Penyalinan Data

- Portal Microsoft Azure

- SDK .NET

- SDK Python

- Azure PowerShell

- REST API

- Templat Azure Resource Manager

Membuat layanan tertaut ke Spark menggunakan UI

Gunakan langkah-langkah berikut untuk membuat layanan tertaut ke Spark di UI portal Azure.

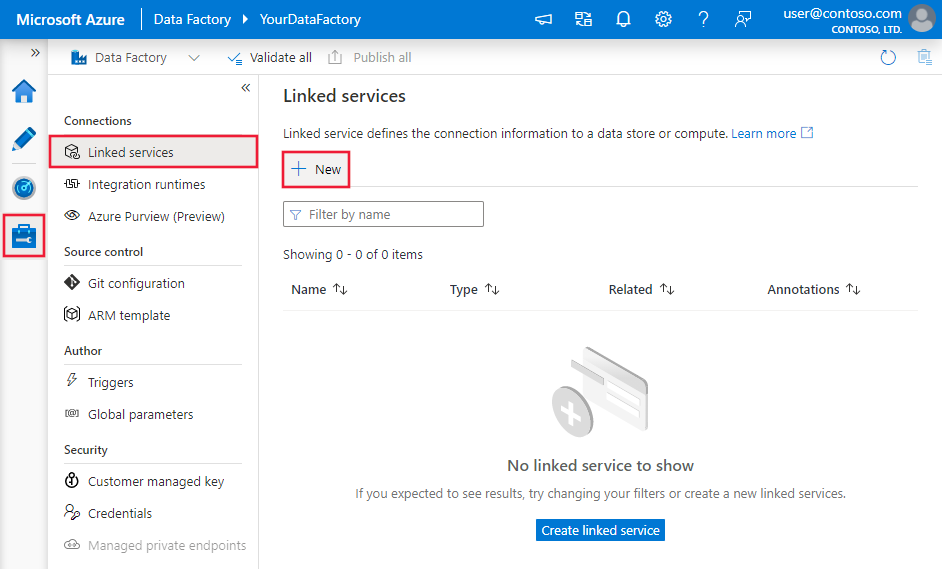

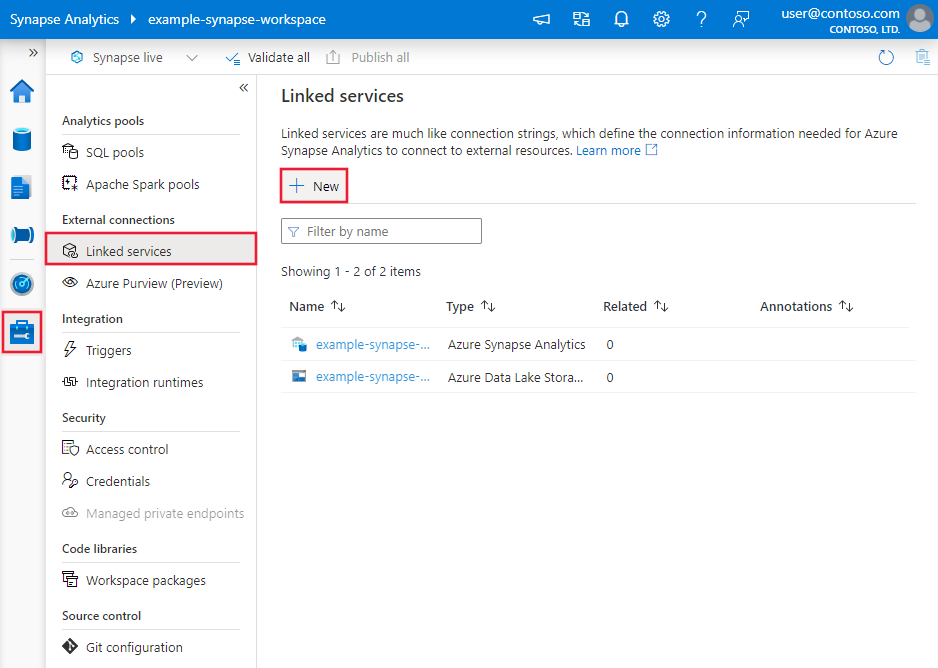

Telusuri ke tab Kelola di ruang kerja Azure Data Factory atau Synapse Anda dan pilih Layanan Tertaut, lalu klik Baru:

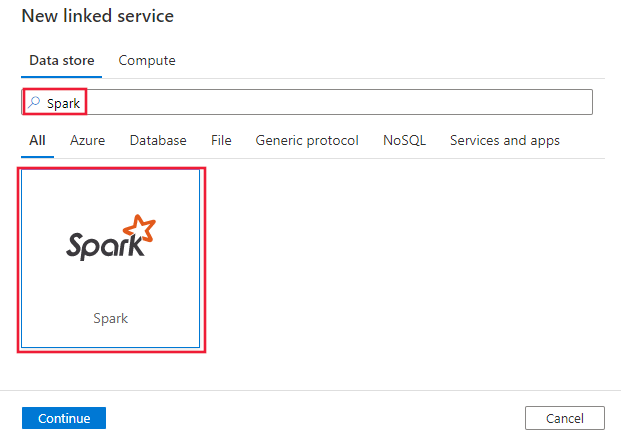

Cari Spark dan pilih konektor Spark.

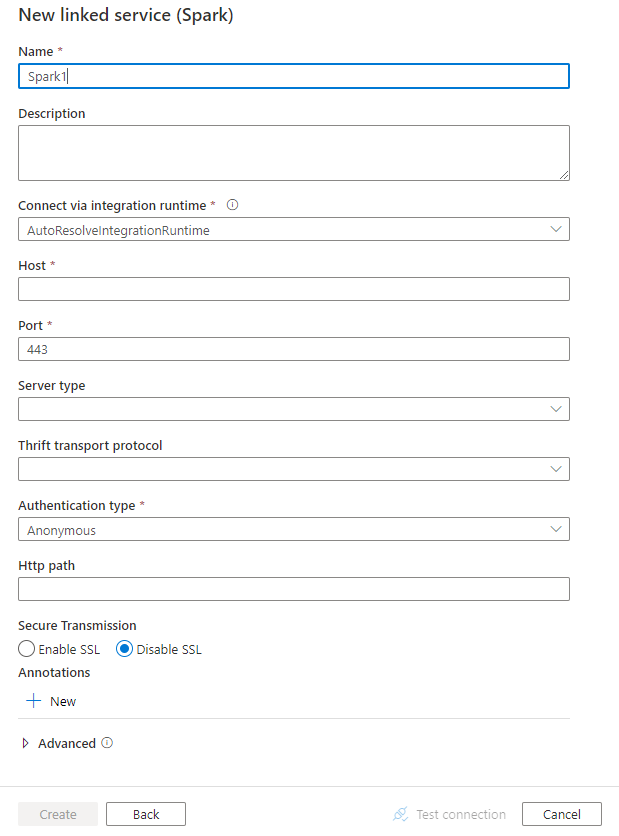

Konfigurasikan detail layanan, uji koneksi, dan buat layanan tertaut baru.

Detail konfigurasi konektor

Bagian berikut ini menyediakan detail tentang properti yang digunakan untuk menentukan entitas Data Factory khusus untuk konektor Spark.

Properti layanan tertaut

Properti berikut ini didukung untuk layanan tertaut Spark:

| Properti | Deskripsi | Wajib |

|---|---|---|

| jenis | Properti jenis harus diatur ke Spark | Ya |

| tuan rumah | Alamat IP atau nama host server Spark | Ya |

| pelabuhan | Port TCP yang digunakan server Spark untuk mendengarkan koneksi klien. Jika Anda tersambung ke Azure HDInsights, tentukan port sebagai 443. | Ya |

| serverType | Jenis server Spark. Nilai yang diperbolehkan adalah: SharkServer, SharkServer2, SparkThriftServer |

No |

| thriftTransportProtocol | Protokol transportasi untuk digunakan di lapisan Thrift. Nilai yang diperbolehkan adalah: Binary, SASL, HTTP |

No |

| authenticationType | Metode autentikasi yang digunakan untuk mengakses server Spark. Nilai yang diizinkan adalah: Anonymous, Username, UsernameAndPassword, WindowsAzureHDInsightService |

Ya |

| Nama pengguna | Nama pengguna yang Anda gunakan untuk mengakses Spark Server. | No |

| kata sandi | Kata sandi yang sesuai dengan pengguna. Tandai bidang ini sebagai SecureString untuk menyimpannya dengan aman, atau mereferensikan rahasia yang disimpan di Azure Key Vault. | No |

| httpPath | URL parsial yang sesuai dengan server Spark. | No |

| enableSsl | Menentukan apakah koneksi ke server dienkripsi menggunakan TLS. Nilai defaultnya adalah false. | No |

| trustedCertPath | Jalur lengkap file .pem yang berisi sertifikat OS tepercaya untuk memverifikasi server saat menyambungkan melalui TLS. Properti ini hanya dapat diatur saat menggunakan TLS pada Runtime integrasi yang dihost sendiri. Nilai defaultnya adalah file cacerts.pem yang diinstal dengan Runtime integrasi. | No |

| useSystemTrustStore | Menentukan apakah akan menggunakan sertifikat OS dari penyimpanan kepercayaan sistem atau dari file PEM yang ditentukan. Nilai defaultnya adalah false. | No |

| allowHostNameCNMismatch | Menentukan apakah akan mewajibkan nama sertifikat TLS/SSL yang diterbitkan OS agar sesuai dengan nama host server saat menghubungkan melalui TLS. Nilai defaultnya adalah false. | No |

| allowSelfSignedServerCert | Menentukan apakah akan mengizinkan sertifikat yang ditandatangani sendiri dari server. Nilai defaultnya adalah false. | No |

| connectVia | Runtime integrasi yang akan digunakan untuk menyambungkan ke penyimpanan data. Pelajari selengkapnya dari bagian Prasyarat. Jika tidak ditentukan, Azure Integration Runtime default akan digunakan. | No |

Contoh:

{

"name": "SparkLinkedService",

"properties": {

"type": "Spark",

"typeProperties": {

"host" : "<cluster>.azurehdinsight.net",

"port" : "<port>",

"authenticationType" : "WindowsAzureHDInsightService",

"username" : "<username>",

"password": {

"type": "SecureString",

"value": "<password>"

}

}

}

}

Properti himpunan data

Untuk daftar lengkap bagian dan properti yang tersedia untuk menentukan himpunan data, lihat artikel himpunan data. Bagian ini menyediakan daftar properti yang didukung oleh himpunan data Spark.

Untuk menyalin data dari Spark, atur properti jenis himpunan data ke SparkObject. Berikut adalah properti yang didukung:

| Properti | Deskripsi | Wajib |

|---|---|---|

| jenis | Properti jenis himpunan data harus diatur ke: SparkObject | Ya |

| skema | Nama skema. | Tidak (jika "kueri" di sumber aktivitas ditentukan) |

| tabel | Nama tabel. | Tidak (jika "kueri" di sumber aktivitas ditentukan) |

| tableName | Nama tabel dengan skema. Properti ini didukung untuk kompatibilitas mundur. Untuk beban kerja baru, gunakan schema dan table. |

Tidak (jika "kueri" di sumber aktivitas ditentukan) |

Contoh

{

"name": "SparkDataset",

"properties": {

"type": "SparkObject",

"typeProperties": {},

"schema": [],

"linkedServiceName": {

"referenceName": "<Spark linked service name>",

"type": "LinkedServiceReference"

}

}

}

Properti aktivitas salin

Untuk daftar lengkap bagian dan properti yang tersedia untuk menentukan aktivitas, lihat artikel Alur. Bagian ini menyediakan daftar properti yang didukung oleh himpunan data Spark.

Spark sebagai sumber

Untuk menyalin data dari Spark, atur jenis sumber dalam aktivitas salin ke SparkSource. Berikut ini properti yang didukung di bagian sumber aktivitas salin:

| Properti | Deskripsi | Wajib |

|---|---|---|

| jenis | Properti jenis sumber aktivitas salin harus diatur ke: SparkSource | Ya |

| pertanyaan | Gunakan kueri SQL kustom untuk membaca data. Misalnya: "SELECT * FROM MyTable". |

Tidak (jika "tableName" di himpunan data ditentukan) |

Contoh:

"activities":[

{

"name": "CopyFromSpark",

"type": "Copy",

"inputs": [

{

"referenceName": "<Spark input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "SparkSource",

"query": "SELECT * FROM MyTable"

},

"sink": {

"type": "<sink type>"

}

}

}

]

Properti aktivitas pencarian

Untuk mempelajari detail tentang properti, lihat Aktivitas pencarian.

Konten terkait

Untuk daftar penyimpanan data yang didukung sebagai sumber dan sink oleh aktivitas salin, lihat penyimpanan data yang didukung.