Menggunakan Azure Data Factory untuk memigrasikan data dari data lake atau gudang data Anda ke Azure

BERLAKU UNTUK:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Cobalah Data Factory di Microsoft Fabric, solusi analitik all-in-one untuk perusahaan. Microsoft Fabric mencakup semuanya mulai dari pergerakan data hingga ilmu data, analitik real time, kecerdasan bisnis, dan pelaporan. Pelajari cara memulai uji coba baru secara gratis!

Jika Anda ingin memigrasikan data lake atau gudang data perusahaan (EDW) ke Microsoft Azure, pertimbangkanlah untuk menggunakan Azure Data Factory. Azure Data Factory sangat cocok untuk skenario berikut:

- Migrasi beban kerja big data dari Amazon Simple Storage Service (Amazon S3) atau Hadoop Distributed File System (HDFS) lokal ke Azure

- Migrasi EDW dari Oracle Exadata, Netezza, Teradata, atau Amazon Redshift ke Azure

Azure Data Factory dapat memindahkan petabyte (PB) data untuk migrasi data lake, dan puluhan terabyte (TB) data untuk migrasi gudang data.

Alasan Azure Data Factory dapat digunakan untuk migrasi data

- Azure Data Factory dapat dengan mudah meningkatkan jumlah daya pemrosesan untuk memindahkan data tanpa server dengan kemampuan kinerja tinggii, ketahanan, dan skalabilitas. Anda hanya perlu membayar untuk fasilitas yang Anda gunakan. Perhatikan juga hal-hal berikut:

- Azure Data Factory tidak memiliki batasan volume data atau jumlah file.

- Azure Data Factory dapat sepenuhnya menggunakan bandwidth jaringan dan penyimpanan Anda untuk mencapai throughput pergerakan data dalam volume tertinggi di lingkungan Anda.

- Azure Data Factory menggunakan metode prabayar sehingga Anda hanya membayar untuk waktu sebenarnya yang Anda gunakan untuk menjalankan migrasi data ke Azure.

- Azure Data Factory dapat melakukan pemuatan historis satu kali dan pemuatan inkremental terjadwal.

- Azure Data Factory menggunakan runtime integrasi (IR) Azure untuk memindahkan data antara titik akhir data lake yang dapat diakses publik dan titik akhir gudang. Platform ini juga dapat memindahkan data untuk titik akhir data lake dan titik akhir gudang di dalam Virtual Network (VNet) Azure atau di belakang firewall menggunakan IR yang dihost sendiri.

- Azure Data Factory memiliki keamanan tingkat perusahaan: Anda dapat menggunakan Pemasang Windows (MSI) atau Service Identity untuk mengintegrasikan layanan ke layanan secara aman, atau menggunakan Azure Key Vault untuk manajemen kredensial.

- Azure Data Factory memberikan pengalaman penulisan kode bebas dan dasbor pemantauan bawaan yang kaya.

Migrasi data online vs. offline

Azure Data Factory adalah alat migrasi data online standar untuk mentransfer data melalui jaringan (internet, ER, atau VPN). Sedangkan dengan migrasi data offline, pengguna secara fisik mengirim perangkat transfer data dari organisasi mereka ke Pusat Data Azure.

Ada tiga hal yang harus dipertimbangkan saat Anda memilih antara pendekatan migrasi online dan offline:

- Ukuran data yang akan dimigrasikan

- Bandwidth jaringan

- Jangka waktu migrasi

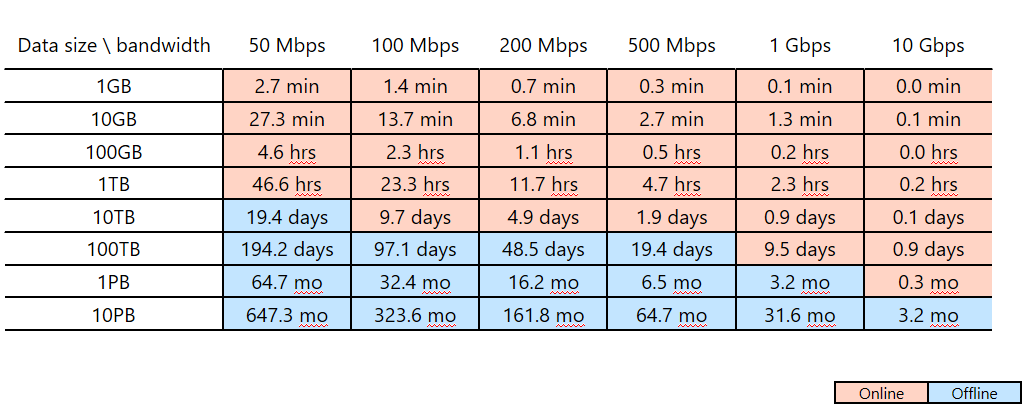

Misalnya, Anda berencana menggunakan Azure Data Factory untuk menyelesaikan migrasi data dalam waktu dua minggu (jangka waktu migrasi Anda). Perhatikan garis potong merah muda/biru dalam tabel berikut. Sel merah muda terendah untuk kolom tertentu menunjukkan ukuran data/pasangan bandwidth jaringan dengan jangka waktu migrasi yang paling dekat, tetapi kurang dari dua minggu. (Setiap ukuran/bandwidth yang dipasangkan dalam sel biru memiliki jangka waktu migrasi online lebih dari dua minggu.)

Tabel ini membantu Anda menentukan apakah Anda dapat memenuhi jendela migrasi yang dimaksudkan melalui migrasi online (Azure Data Factory) berdasarkan ukuran data dan bandwidth jaringan yang tersedia. Jika jangka waktu migrasi online memakan waktu lebih dari dua minggu, Anda mungkin ingin menggunakan migrasi offline.

Tabel ini membantu Anda menentukan apakah Anda dapat memenuhi jendela migrasi yang dimaksudkan melalui migrasi online (Azure Data Factory) berdasarkan ukuran data dan bandwidth jaringan yang tersedia. Jika jangka waktu migrasi online memakan waktu lebih dari dua minggu, Anda mungkin ingin menggunakan migrasi offline.

Catatan

Dengan menggunakan migrasi online, Anda dapat mencapai pemuatan data historis dan umpan inkremental secara menyeluruh melalui satu alat. Melalui pendekatan ini, data antara penyimpanan lama dan baru tetap dapat disinkronkan selama jangka waktu migrasi. Ini artinya Anda dapat membuat kembali logika ETL di penyimpanan baru dengan data yang telah disegarkan.