Muat data ke dalam Azure Data Lake Storage Gen1 dengan menggunakan Azure Data Factory

BERLAKU UNTUK:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Cobalah Data Factory di Microsoft Fabric, solusi analitik all-in-one untuk perusahaan. Microsoft Fabric mencakup semuanya mulai dari pergerakan data hingga ilmu data, analitik real time, kecerdasan bisnis, dan pelaporan. Pelajari cara memulai uji coba baru secara gratis!

Azure Data Lake Storage Gen1 (sebelumnya dikenal sebagai Azure Data Lake Store) adalah repositori hyper-scale di seluruh perusahaan untuk beban kerja analitik big data. Data Lake Storage Gen1 memungkinkan Anda mengambil data dengan ukuran, jenis, dan kecepatan penyerapan apa pun. Data ditangkap di satu tempat untuk analitik operasional dan eksploratif.

Azure Data Factory adalah layanan integrasi data berbasis cloud yang dikelola sepenuhnya. Anda dapat menggunakan layanan ini untuk mengisi lake dengan data dari sistem yang ada dan menghemat waktu saat membangun solusi analitik Anda.

Azure Data Factory menawarkan keuntungan berikut untuk memuat data ke dalam Data Lake Storage Gen1:

- Mudah diatur: Wizard intuitif 5 langkah tanpa memerlukan pembuatan skrip.

- Dukungan penyimpanan data yang kaya: Dukungan bawaan untuk set penyimpanan data lokal dan berbasis cloud yang kaya. Untuk daftar detailnya, lihat tabel Penyimpanan data yang didukung.

- Aman dan patuh: Data ditransfer melalui HTTPS atau ExpressRoute. Kehadiran layanan global memastikan bahwa data Anda tidak pernah meninggalkan batas geografis.

- Performa tinggi: Kecepatan pemuatan data hingga 1 GB/detik ke Data Lake Storage Gen1. Untuk detailnya, lihat Kinerja aktivitas salin.

Artikel ini menampilkan cara menggunakan alat Salin Data Azure Data Factory untuk memuat data dari Amazon S3 ke dalam Data Lake Storage Gen1. Anda dapat mengikuti langkah serupa untuk menyalin data dari jenis penyimpanan data lainnya.

Catatan

Untuk informasi selengkapnya, lihat Menyalin data ke atau dari Data Lake Storage Gen1 dengan menggunakan Azure Data Factory.

Prasyarat

- Langganan Azure: Jika Anda belum memiliki langganan Azure, buat akun gratis sebelum memulai.

- Akun Data Lake Storage Gen1: Jika Anda tidak memiliki akun Data Lake Storage Gen1, lihat instruksinya di Buat akun Data Lake Storage Gen1.

- Amazon S3: Artikel ini menampilkan cara menyalin data dari Amazon S3. Anda dapat menggunakan penyimpanan data lain dengan mengikuti langkah serupa.

Membuat pabrik data

Apabila Anda belum membuat pabrik data, ikuti langkah-langkah di Mulai Cepat: Membuat pabrik data menggunakan portal Azure dan Studio Azure Data Factory untuk membuatnya. Setelah membuat pabrik data, telusuri ke pabrik data di portal Azure.

Pilih Buka pada petak peta Buka Azure Data Factory Studio untuk meluncurkan Aplikasi Integrasi Data di tab terpisah.

Muat data ke dalam Azure Data Lake Storage Gen1

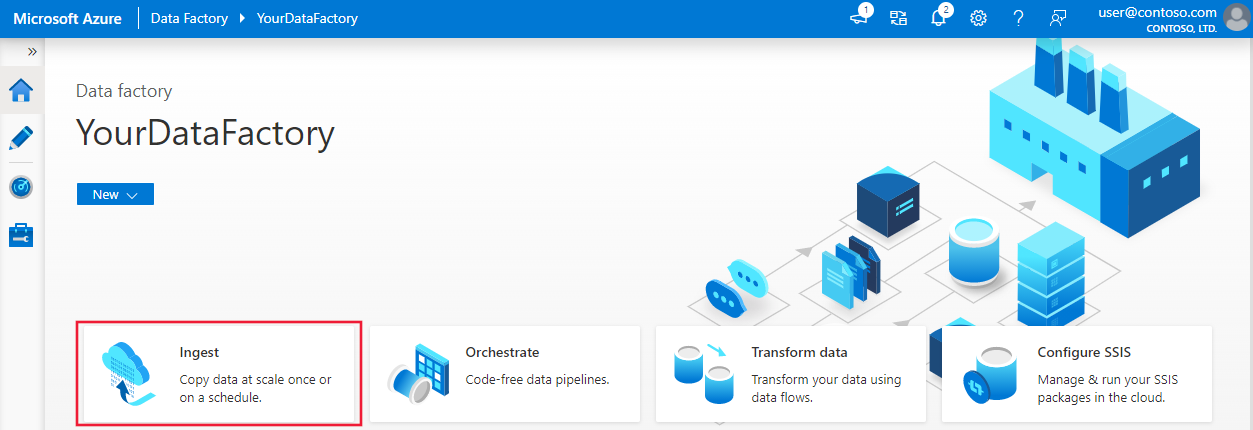

Di halaman beranda Azure Data Factory, pilih petak peta Penyerapan untuk meluncurkan alat Copy Data:

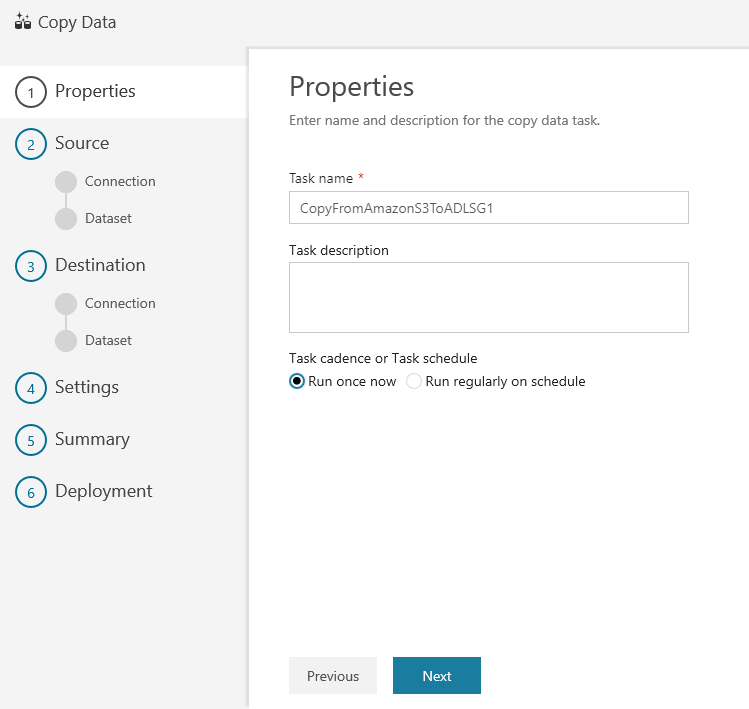

Pada halaman Properti, tentukan CopyFromAmazonS3ToADLS untuk bidang Nama tugas, dan pilih Berikutnya:

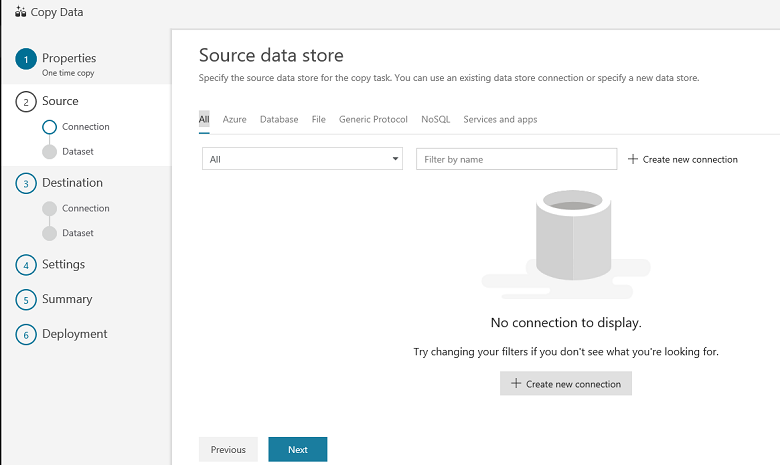

Pada halaman Penyimpanan data sumber, pilih + Buat koneksi baru:

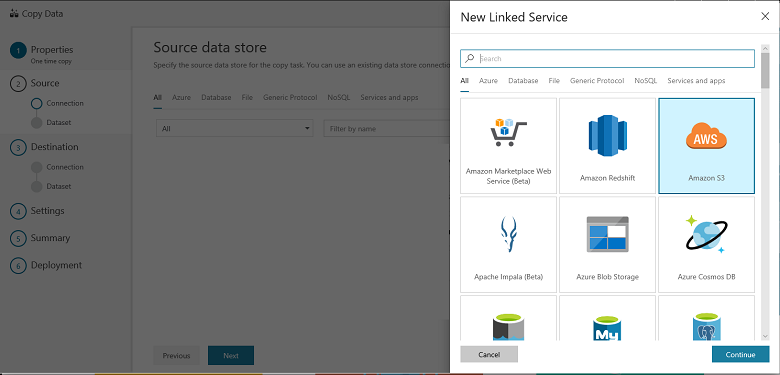

Pilih Amazon S3, dan pilih Lanjutkan

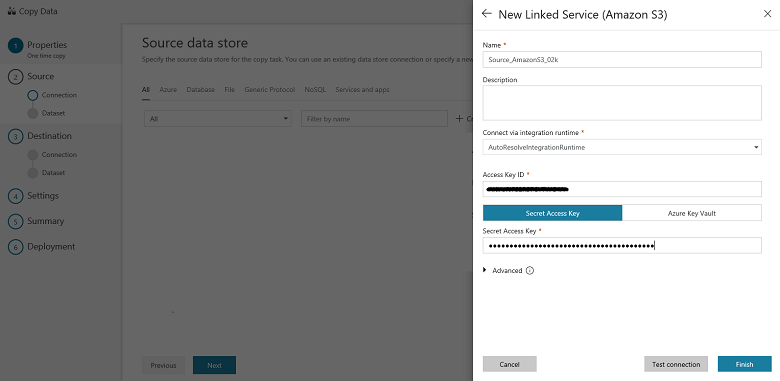

Di halaman Tentukan koneksi Amazon S3, lakukan langkah-langkah berikut:

Tentukan nilai ID Kunci Akses.

Tentukan nilai Kunci Akses Rahasia.

Pilih Selesai.

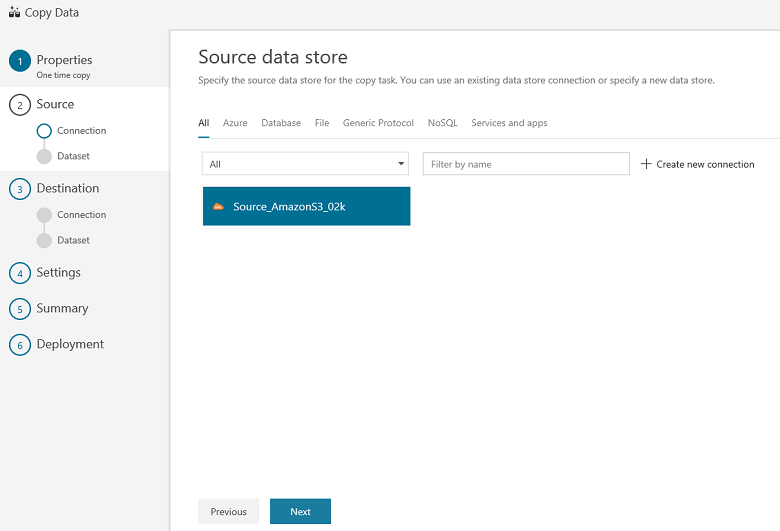

Anda akan melihat koneksi baru. Pilih Selanjutnya.

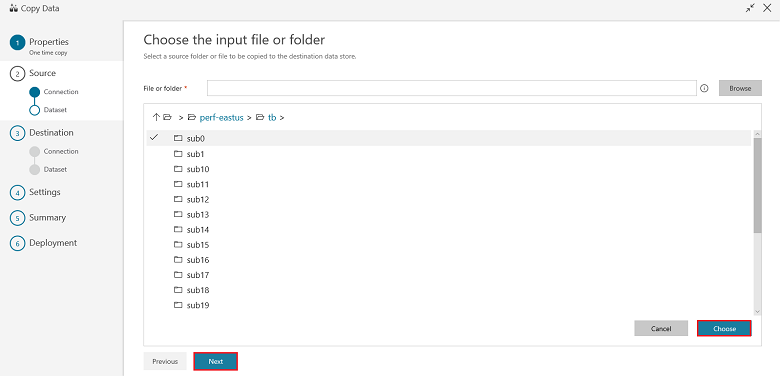

Di halaman Pilih file atau folder input, telusuri ke folder dan file yang ingin Anda salin. Pilih folder/file, pilih Pilih, lalu pilih Berikutnya:

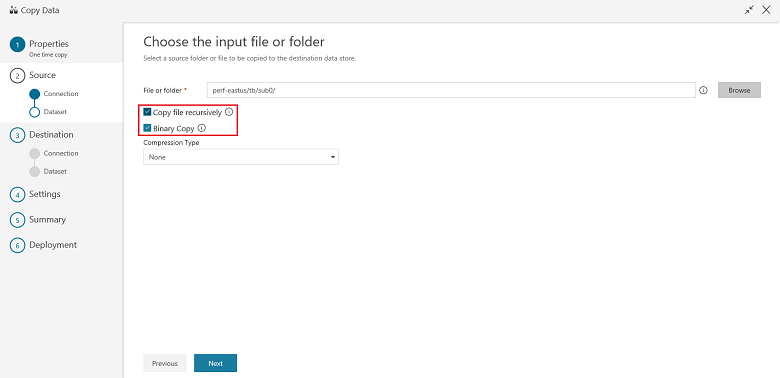

Pilih perilaku salin dengan memilih opsi Salin file secara rekursif dan Salinan biner (salin file apa adanya). Pilih Selanjutnya:

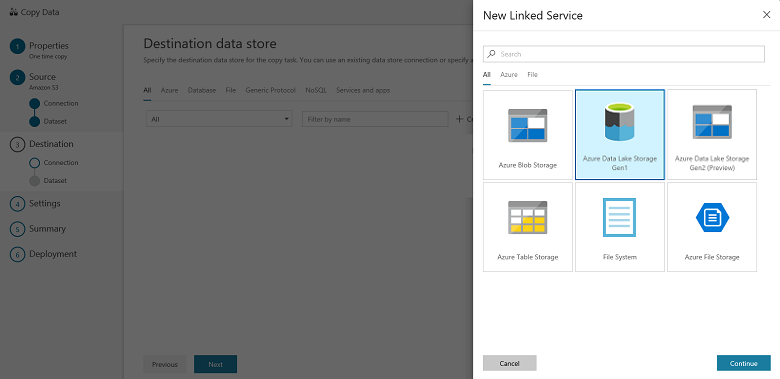

Di halaman Penyimpanan data tujuan, pilih + Buat koneksi baru, kemudian pilih Azure Data Lake Storage Gen1, dan pilih Lanjutkan:

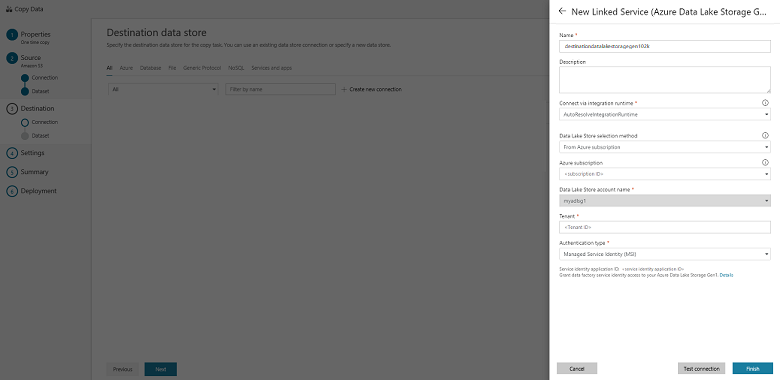

Di halaman Layanan Tertaut Baru (Azure Data Lake Storage Gen1), lakukan langkah-langkah berikut ini:

- Pilih akun Data Lake Storage Gen1 Anda untuk nama akun Data Lake Store.

- Tentukan Penyewa, dan pilih Selesai.

- Pilih Selanjutnya.

Penting

Dalam panduan ini, Anda menggunakan identitas terkelola untuk sumber daya Azure untuk mengautentikasi akun Data Lake Storage Gen1 Anda. Pastikan untuk memberi MSI izin yang tepat di Data Lake Storage Gen1 dengan mengikuti instruksi ini.

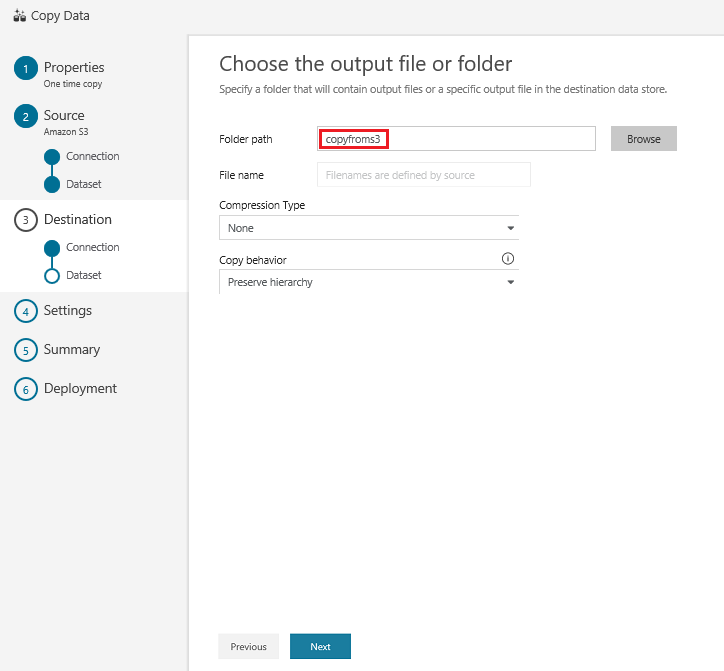

Di halaman Pilih file atau folder output, masukkan copyfroms3 sebagai nama folder output, dan pilih Berikutnya:

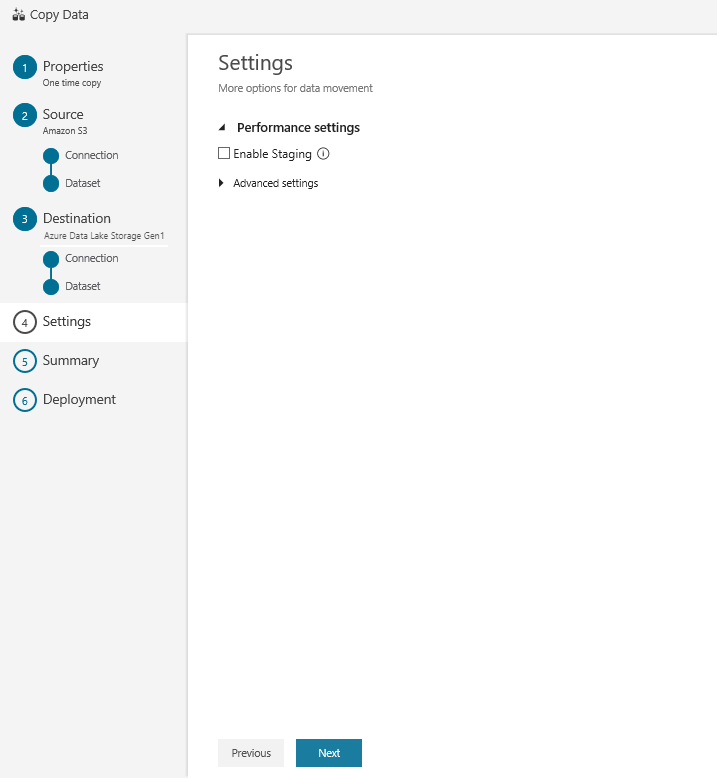

Pada halaman Pengaturan, pilih Berikutnya:

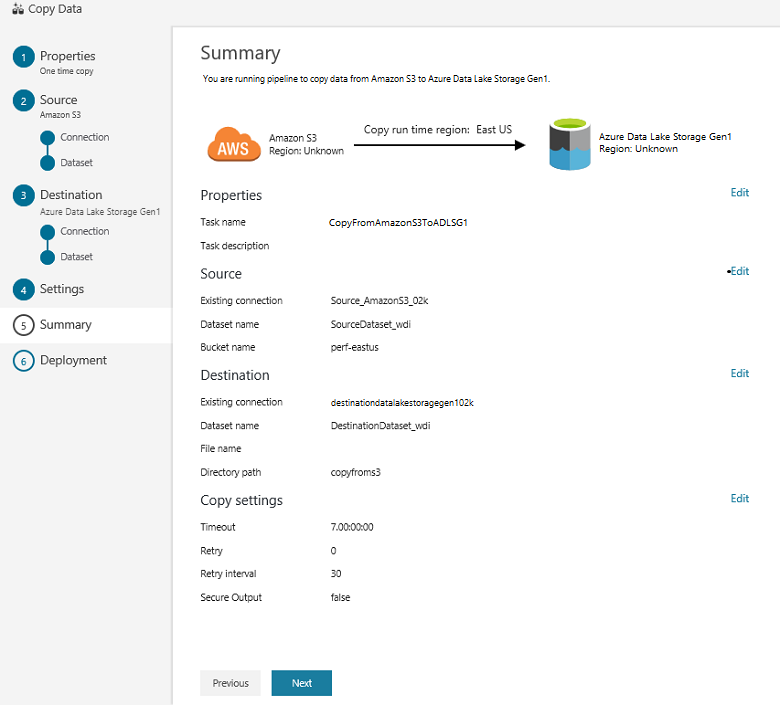

Pada halaman Ringkasan, tinjau semua pengaturan, dan pilih Berikutnya:

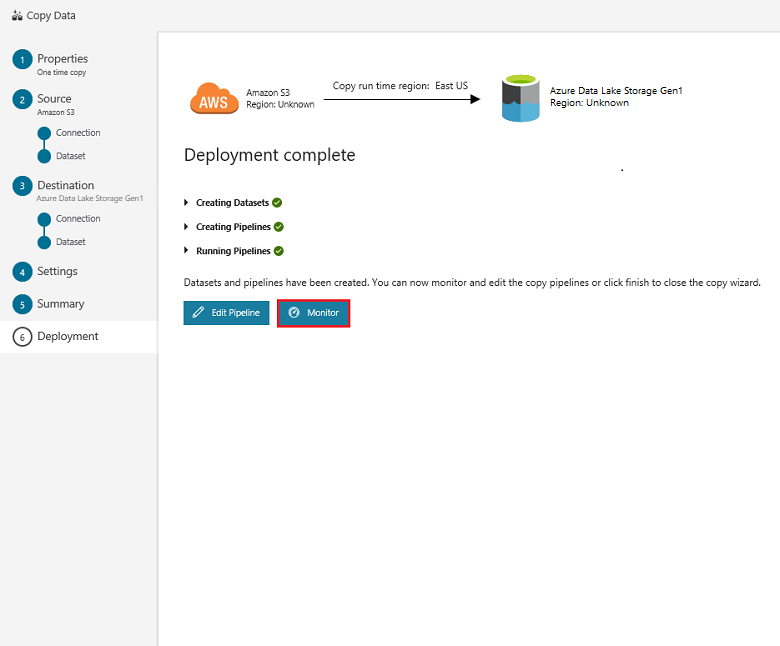

Pada Halaman penyebaran, pilih Pemantauan untuk memantau alur (tugas):

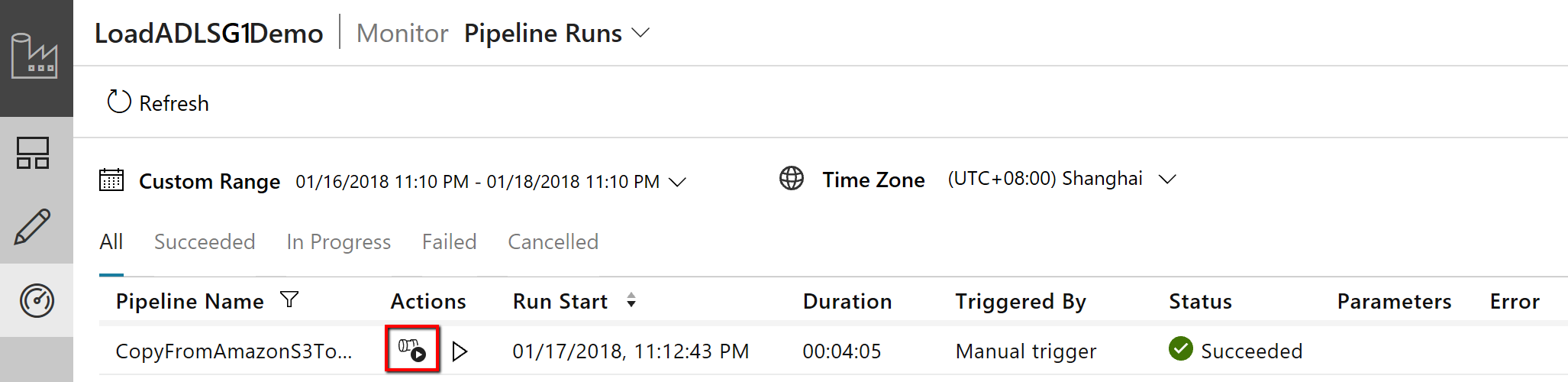

Perhatikan bahwa tab Pemantauan di sebelah kiri dipilih secara otomatis. Kolom Tindakan menyertakan tautan untuk melihat detail eksekusi aktivitas dan untuk menjalankan ulang alur:

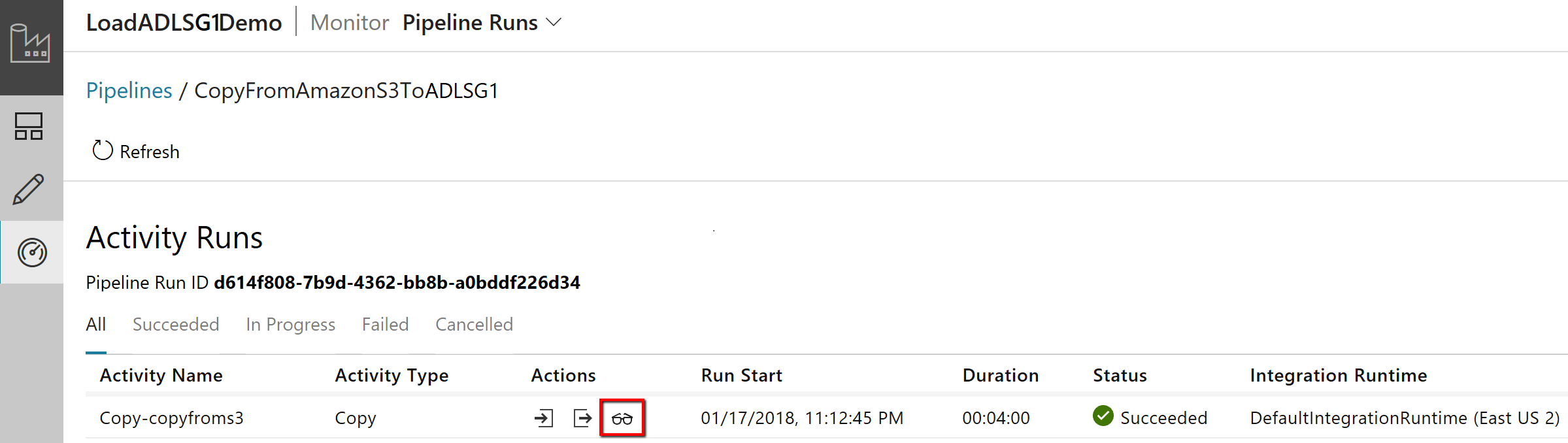

Untuk melihat aktivitas berjalan yang terkait dengan eksekusi alur, pilih tautan Tampilkan Aktivitas Berjalan di kolom Tindakan. Hanya ada satu aktivitas (aktivitas salin) dalam alur, jadi Anda hanya akan melihat satu entri. Untuk beralih kembali ke tampilan eksekusi alur, klik tautan Alur di bagian atas. Pilih Refresh untuk menyegarkan daftar.

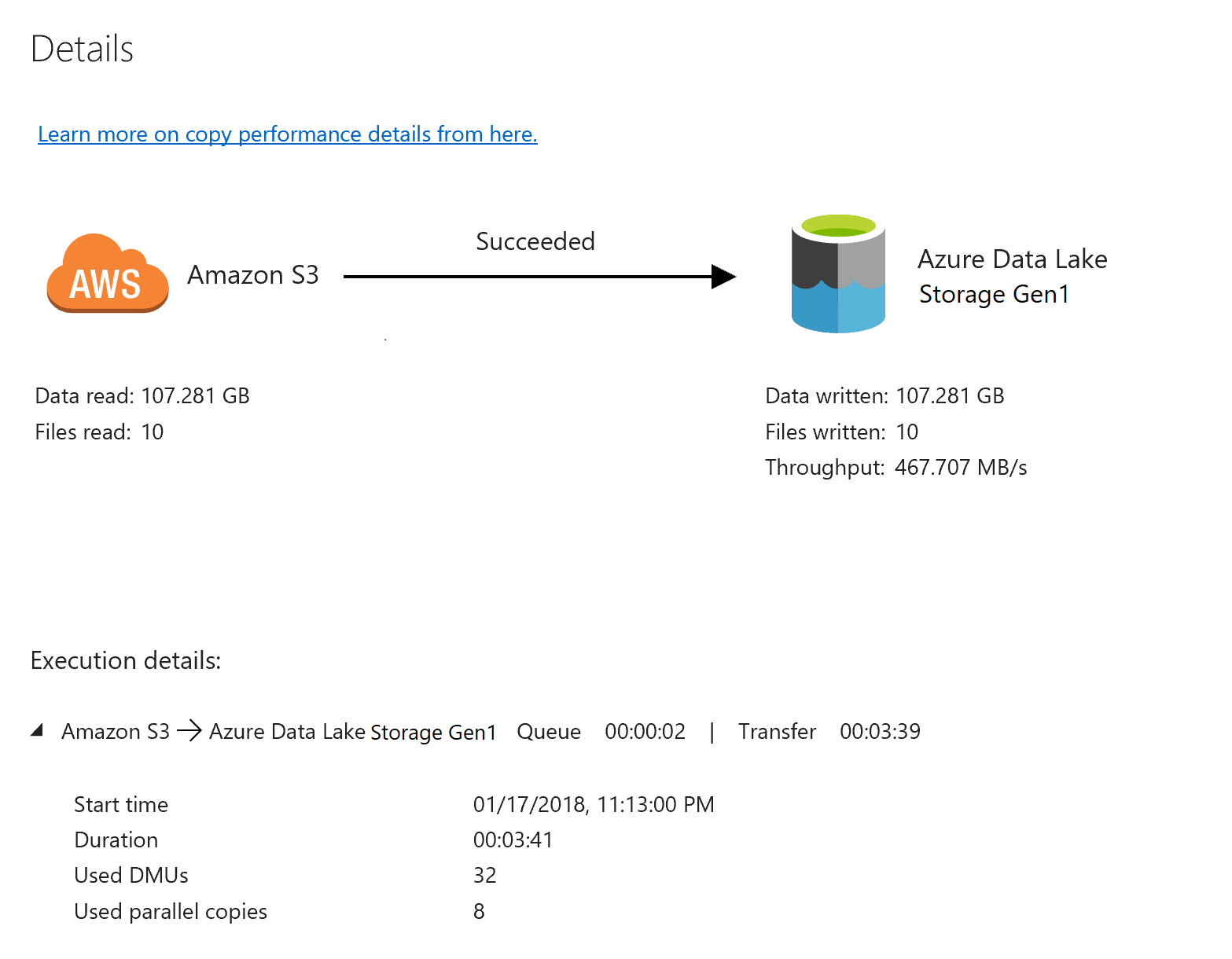

Untuk memantau detail eksekusi untuk setiap aktivitas salin, pilih tautan Detail di bawah Tindakan dalam tampilan pemantauan aktivitas. Anda dapat memantau detail seperti volume data yang disalin dari sumber ke sink, throughput data, langkah-langkah eksekusi dengan durasi terkait, dan konfigurasi yang digunakan:

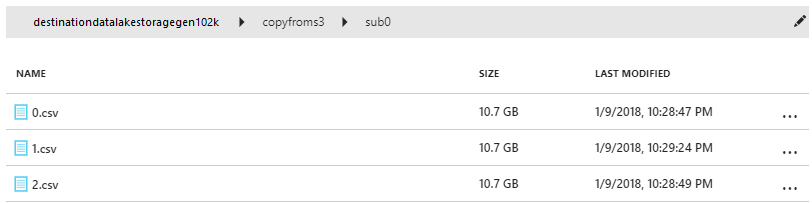

Memverifikasi bahwa data disalin ke akun Data Lake Storage Gen1 Anda:

Konten terkait

Lanjutkan ke artikel berikut untuk mempelajari tentang dukungan Data Lake Storage Gen1:

Saran dan Komentar

Segera hadir: Sepanjang tahun 2024 kami akan menghentikan penggunaan GitHub Issues sebagai mekanisme umpan balik untuk konten dan menggantinya dengan sistem umpan balik baru. Untuk mengetahui informasi selengkapnya, lihat: https://aka.ms/ContentUserFeedback.

Kirim dan lihat umpan balik untuk