Apakah itu AI yang Andal?

BERLAKU UNTUK: Ekstensi ml Azure CLI v2 (saat ini)

Ekstensi ml Azure CLI v2 (saat ini) Python SDK azure-ai-ml v2 (saat ini)

Python SDK azure-ai-ml v2 (saat ini)

Kecerdasan Buatan yang Bertanggung Jawab (AI yang Bertanggung Jawab) adalah pendekatan untuk mengembangkan, menilai, dan menyebarkan sistem AI dengan cara yang aman, dapat dipercaya, dan etis. Sistem AI adalah produk dari berbagai keputusan yang dibuat oleh orang yang mengembangkan dan menyebarkannya. Mulai dari tujuan sistem hingga cara orang berinteraksi dengan sistem AI, AI yang Bertanggung Jawab dapat secara proaktif memandu membuat keputusan dengan hasil yang lebih menguntungkan dan merata. Itu berarti menjaga orang dan tujuan mereka di pusat keputusan desain sistem dan menghormati nilai-nilai yang bertahan seperti keadilan, keandalan, dan transparansi.

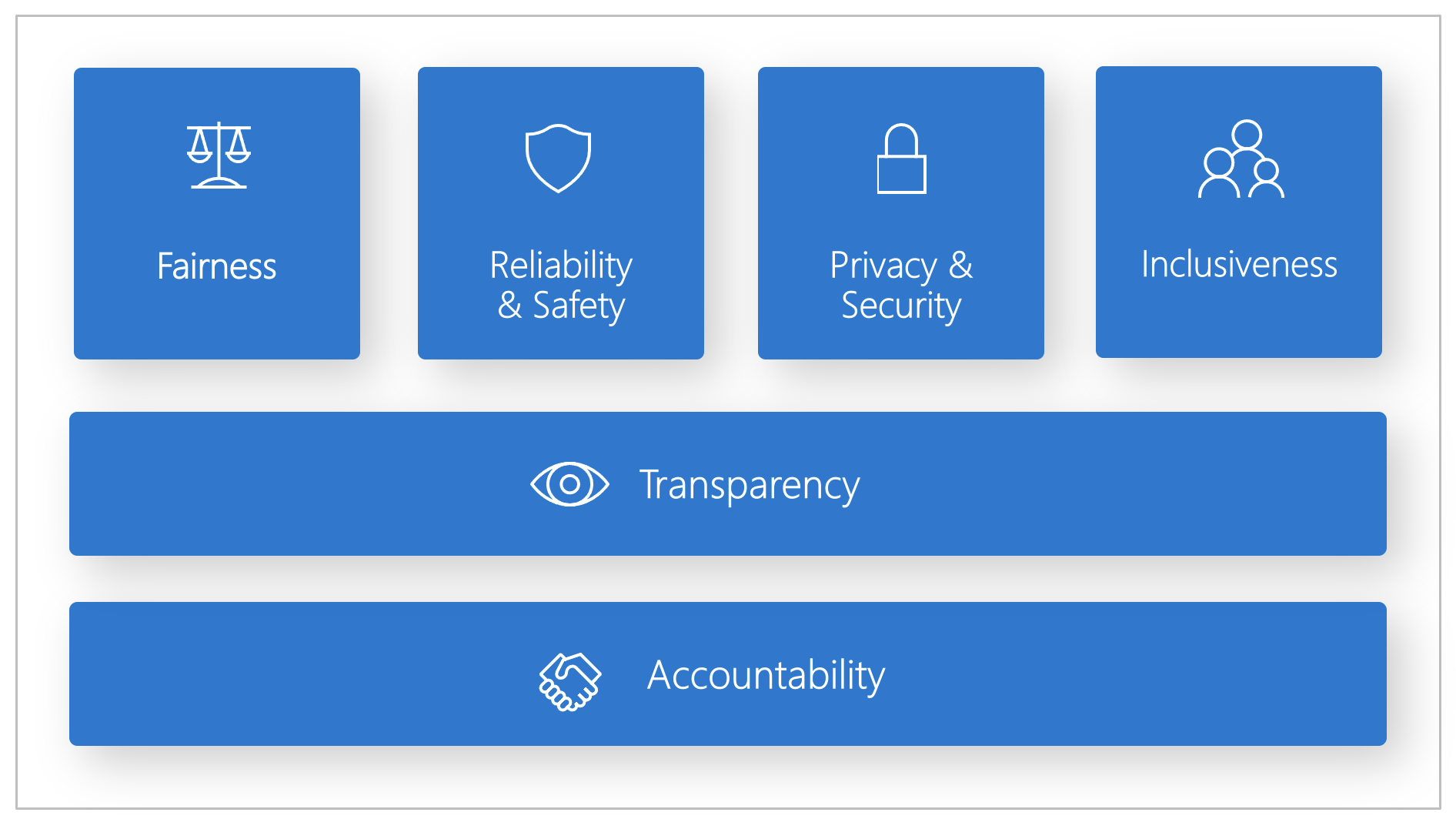

Microsoft mengembangkan Responsible AI Standard. Standar ini adalah kerangka kerja untuk membangun sistem AI sesuai dengan enam prinsip: keadilan, keandalan dan keselamatan, privasi dan keamanan, inklusivitas, transparansi, serta akuntabilitas. Bagi Microsoft, prinsip-prinsip ini adalah landasan pendekatan yang bertangguh jawab dan dapat dipercaya untuk AI, khususnya karena teknologi cerdas semakin umum digunakan pada produk dan layanan yang digunakan setiap hari.

Artikel ini menunjukkan bagaimana alat dukungan Azure Machine Learning dapat memungkinkan pengembang serta ilmuwan data menerapkan dan mengoperasionalkan enam prinsip tersebut.

Keadilan dan inklusivitas

Sistem AI harus memperlakukan semua orang secara adil dan menghindari memengaruhi kelompok orang yang berada dalam posisi yang sama dengan cara yang berbeda. Misalnya, ketika sistem AI memberikan panduan tentang perawatan medis, aplikasi pinjaman, atau perekrutan pekerja, sistem AI harus membuat rekomendasi yang sama bagi semua orang dengan gejala, kondisi keuangan, atau kualifikasi profesional yang serupa.

Keadilan dan inklusivitas dalam Azure Machine Learning: Komponen penilaian keadilan Azure Machine Learning pada dasbor AI yang Bertanggung Jawab memungkinkan ilmuwan data dan pengembang menilai keadilan model di seluruh kelompok sensitif yang didefinisikan dalam hal jenis kelamin, etnis, usia, dan karakteristik lainnya.

Keandalan dan keamanan

Untuk membangun kepercayaan, sangat penting bahwa sistem AI beroperasi dengan andal, aman, dan konsisten. Sistem ini harus dapat beroperasi sesuai dengan tujuan dari perancangan sistem, merespons dengan aman terhadap kondisi yang tidak terduga, dan menahan manipulasi yang berbahaya. Cara sistem berperilaku dan berbagai kondisi yang dapat ditangani sistem mencerminkan rentang situasi dan keadaan yang diantisipasi pengembang saat perancangan dan pengujian.

Keandalan dan keamanan di Azure Machine Learning: Komponen analisis kesalahan pada dasbor AI yang Bertanggung Jawab memungkinkan ilmuwan data dan pengembang untuk:

- Mendapatkan pemahaman mendalam mengenai bagaimana kegagalan tersebar untuk model.

- Mengidentifikasi kohor (subset) data dengan tingkat kesalahan yang lebih tinggi daripada tolok ukur keseluruhan.

Perbedaan ini mungkin terjadi ketika sistem atau model berperforma buruk untuk kelompok demografis tertentu atau kondisi input yang jarang diamati dalam data pelatihan.

Transparansi

Ketika sistem AI membantu menginformasikan keputusan yang memiliki dampak besar pada kehidupan banyak orang, sangat penting bagi orang-orang untuk memahami bagaimana keputusan tersebut dibuat. Misalnya, bank mungkin saja menggunakan sistem AI untuk memutuskan apakah seseorang layak menggunakan layanan kredit. Perusahaan mungkin menggunakan sistem AI untuk merekrut kandidat yang paling memenuhi syarat.

Bagian penting dari transparansi adalah interpretabilitas: penjelasan yang berguna tentang perilaku sistem AI dan komponennya. Meningkatkan interpretabilitas mengharuskan pemangku kepentingan untuk memahami cara dan alasan dibalik fungsi sistem. Para pemangku kepentingan kemudian dapat mengidentifikasi potensi masalah performa, masalah keadilan, praktik pengecualian, atau hasil yang tidak diinginkan.

Transparansi dalam Azure Machine Learning: Komponen interpretabilitas model dan kemungkinan kontrafaktual pada dasbor AI yang Bertanggung Jawab memungkinkan ilmuwan data dan pengembang menghasilkan deskripsi prediksi model yang dapat dipahami manusia.

Komponen interpretabilitas model menyediakan beberapa sudut pandang terhadap perilaku model:

- Penjelasan global. Misalnya, fitur apa yang memengaruhi perilaku keseluruhan model alokasi pinjaman?

- Penjelasan lokal. Misalnya, mengapa aplikasi pinjaman pelanggan disetujui atau ditolak?

- Penjelasan model untuk kohor titik data yang dipilih. Misalnya, fitur apa yang memengaruhi perilaku keseluruhan model alokasi pinjaman untuk pemohon berpenghasilan rendah?

Selain itu, komponen kemungkinan kontrafaktual memungkinkan pemahaman dan penelusuran kesalahan model pembelajaran mesin dalam aspek bagaimana reaksinya terhadap perubahan fitur dan gangguan.

Azure Machine Learning juga mendukung kartu skor AI yang Bertanggung Jawab. Kartu skor adalah laporan PDF yang dapat disesuaikan. Pengembang dapat dengan mudah mengonfigurasi, menghasilkan, mengunduh, dan membagi kartu skor dengan pemangku kepentingan teknis dan non-teknis untuk memaparkan himpunan data dan kondisi modelnya, mencapai kepatuhan, dan membangun kepercayaan. Kartu skor ini juga dapat digunakan dalam tinjauan audit untuk mengungkap karakteristik model pembelajaran mesin.

Privasi dan keamanan

Seiring AI lebih umum digunakan, perlindungan privasi serta pengamanan informasi pribadi dan bisnis semakin lebih penting dan kompleks. Dengan AI, aspek privasi dan keamanan data memerlukan perhatian khusus karena akses ke data sangat penting bagi sistem AI untuk membuat prediksi dan keputusan yang akurat bagi orang-orang. Sistem AI harus mematuhi hukum privasi yaitu:

- Mengharuskan transparansi tentang pengumpulan, penggunaan, dan penyimpanan data.

- Mengharuskan bahwa konsumen memiliki kontrol yang sesuai untuk memilih bagaimana data mereka digunakan.

Privasi dan Keamanan di Azure Machine Learning: Azure Machine Learning memungkinkan administrator dan pengembang membuat konfigurasi aman yang mematuhi kebijakan perusahaan mereka. Dengan Azure Machine Learning dan platform Azure, Anda dapat:

- Membatasi akses ke sumber daya dan operasi berdasarkan akun pengguna atau grup.

- Membatasi komunikasi jaringan masuk dan keluar.

- Mengenkripsi data saat transit dan tidak aktif.

- Memindai kerentanan.

- Menerapkan dan mengaudit kebijakan konfigurasi.

Microsoft juga membuat dua paket sumber terbuka yang dapat memungkinkan penerapan prinsip privasi dan keamanan lebih lanjut:

SmartNoise: Privasi diferensial adalah set sistem dan praktik yang membantu menjaga data individu tetap aman dan privat. Dalam solusi pembelajaran mesin, privasi diferensial mungkin diperlukan untuk mematuhi peraturan. SmartNoise adalah proyek sumber terbuka (dikembangkan bersama oleh Microsoft) yang berisi komponen untuk membangun sistem privat yang berbeda yang bersifat global.

Counterfit: Counterfit adalah proyek sumber terbuka yang terdiri dari alat baris perintah dan lapisan automasi umum untuk memungkinkan pengembang melakukan simulasi serangan siber terhadap sistem AI. Siapa pun dapat mengunduh alat ini dan menyebarkannya melalui Azure Cloud Shell untuk dijalankan di dalam browser atau menyebarkannya secara lokal di lingkungan Anaconda Python. Ini dapat menilai model AI yang dihosting di berbagai lingkungan cloud, lokal, atau di tepi. Alat ini agnostik terhadap model AI dan mendukung berbagai tipe data, termasuk teks, gambar, atau input umum.

Akuntabilitas

Orang-orang yang merancang dan menyebarkan sistem AI harus bertanggung jawab atas cara sistem mereka beroperasi. Organisasi harus memanfaatkan standar industri untuk mengembangkan norma akuntabilitas. Norma-norma ini dapat memastikan bahwa sistem AI bukanlah otoritas terakhir pada keputusan apa pun yang memengaruhi kehidupan orang-orang. Norma tersebut juga dapat memastikan manusia mempertahankan kontrol penting atas sistem AI yang sangat otonom.

Akuntabilitas dalam Azure Machine Learning: Operasi Pembelajaran Mesin (MLOps) didasarkan pada prinsip dan praktik DevOps yang meningkatkan efisiensi alur kerja AI. Azure Machine Learning menyediakan kemampuan MLOps berikut untuk akuntabilitas sistem AI Anda yang lebih baik:

- Mendaftar, mengemas, dan menyebarkan model dari mana saja. Anda juga dapat melacak metadata terkait yang diperlukan untuk menggunakan model.

- Mencatat data pengelolaan untuk siklus hidup pembelajaran mesin yang menyeluruh. Informasi silsilah data yang tercatat dapat termasuk siapa yang menerbitkan model, mengapa perubahan dibuat, dan kapan model disebarkan atau digunakan dalam produksi.

- Beri tahu dan ingatkan terkait peristiwa dalam siklus hidup pembelajaran mesin. Contohnya meliputi penyelesaian eksperimen, pendaftaran model, penyebaran model, dan deteksi penyimpangan model.

- Pantau aplikasi untuk mengantisipasi masalah operasional dan masalah terkait pembelajaran mesin. Membandingkan input model antara pelatihan dan inferensi, menjelajahi metrik khusus model, dan memberikan pemantauan dan peringatan pada infrastruktur pembelajaran mesin Anda.

Selain kemampuan MLOps, kartu skor AI yang Bertanggung Jawab di Azure Machine Learning juga membuat akuntabilitas dengan memungkinkan komunikasi antar pemangku kepentingan. Kartu skor juga membuat akuntabilitas dengan memberdayakan pengembang untuk mengonfigurasi, mengunduh, dan membagikan wawasan kesehatan model mereka dengan pemangku kepentingan teknis dan non-teknis mengenai data dan kesehatan model AI. Berbagi wawasan ini dapat membantu membangun kepercayaan.

Platform pembelajaran mesin juga memungkinkan pengambilan keputusan dengan menginformasikan keputusan bisnis melalui:

- Wawasan berbasis data, untuk membantu pemangku kepentingan memahami efek penanganan kausal pada hasil dengan hanya menggunakan data historis. Misalnya, "Bagaimana obat akan mempengaruhi tekanan darah pasien?" Wawasan ini diberikan melalui komponen inferensi kausal dasbor AI yang Bertanggung Jawab.

- Wawasan berbasis model, untuk menjawab pertanyaan pengguna (seperti “apa yang dapat saya lakukan untuk mendapatkan hasil yang berbeda dari AI Anda di lain waktu?”) sehingga mereka bisa mengambil tindakan. Wawasan semacam itu diberikan kepada ilmuwan data melalui komponen kemungkinan kontrafaktual dari dasbor AI yang Bertanggung Jawab.

Langkah berikutnya

- Untuk informasi selengkapnya tentang cara menerapkan AI yang Bertanggung Jawab dalam Azure Machine Learning, lihat Dasbor AI yang Bertanggung Jawab.

- Pelajari cara menghasilkan dasbor AI yang Bertanggung Jawab melalui CLI dan SDK atau UI studio Azure Machine Learning.

- Pelajari cara membuat kartu skor AI yang Bertanggung Jawab berdasarkan wawasan yang diamati di dasbor AI yang Bertanggung Jawab Anda.

- Pelajari Standar AI yang Bertanggung Jawab untuk membangun sistem AI menurut enam prinsip utama.