Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Notebook Python adalah pengalaman baru yang dibangun di atas notebook Fabric. Ini adalah alat serbaguna dan interaktif yang dirancang untuk analisis data, visualisasi, dan pembelajaran mesin. Ini memberikan pengalaman pengembangan yang mulus untuk menulis dan mengeksekusi kode Python. Kemampuan ini menjadikannya alat penting bagi ilmuwan data, analis, dan pengembang BI, terutama untuk tugas eksplorasi yang tidak memerlukan big data dan komputasi terdistribusi.

Dengan buku catatan Python, Anda bisa mendapatkan:

Beberapa kernel python bawaan: Notebook Python menawarkan lingkungan pengodoman Python murni tanpa Spark, dengan dua versi kernel Python - Python 3.10 dan 3.11 tersedia secara default, dan fitur ipython asli yang didukung seperti iPyWidget, perintah magic.

Hemat biaya: Notebook Python baru menawarkan manfaat hemat biaya dengan berjalan pada satu kluster node dengan memori 2vCores/16GB secara default. Penyiapan ini memastikan pemanfaatan sumber daya yang efisien untuk proyek eksplorasi data dengan ukuran data yang lebih kecil.

Sumber Daya & Lakehouse tersedia secara asli: Fabric Lakehouse bersama dengan Sumber Daya bawaan Notebook yang berfungsi penuh tersedia dalam notebook Python. Fitur ini memungkinkan pengguna untuk dengan mudah membawa data ke notebook python, cukup coba seret & drop untuk mendapatkan cuplikan kode.

Mix pemrograman dengan T-SQL: Notebook Python menawarkan cara mudah untuk berinteraksi dengan Gudang Data dan titik akhir SQL di penjelajah, dengan menggunakan konektor data notebookutils, Anda dapat dengan mudah menjalankan skrip T-SQL di bawah konteks python.

Dukungan untuk pustaka Analitik Data Populer: Notebook Python dilengkapi dengan pustaka yang telah diinstal sebelumnya seperti DuckDB, Polars, dan Scikit-learn, menyediakan toolkit komprehensif untuk manipulasi data, analisis, dan pembelajaran mesin.

Advanced intellisense: Notebook Python mengadopsi Pylance sebagai mesin intellisense, bersama dengan layanan bahasa yang disesuaikan Fabric lainnya, bertujuan untuk memberikan pengalaman pengkodian canggih bagi pengembang notebook.

NotebookUtils & tautan semantik: Toolkit API yang kuat memungkinkan Anda dengan mudah menggunakan kemampuan Fabric dan Power BI dengan pendekatan code-first.

Kemampuan Visualisasi Canggih: Selain fitur pratinjau dataframe yang canggih dan fungsi 'Bagan' yang populer, kami juga mendukung pustaka visualisasi populer seperti Matplotlib, Seaborn, serta Plotly. PowerBIClient juga mendukung pustaka ini untuk membantu pengguna lebih memahami pola dan wawasan data.

Kemampuan Umum untuk Fabric Notebook: Semua fitur tingkat Notebook secara alami berlaku untuk notebook Python, seperti fitur pengeditan, SimpanOtomatis, kolaborasi, manajemen berbagi dan izin, integrasi Git, impor/ekspor, dll.

Kemampuan Sains Data stack penuh: Alat Data Wrangler yang canggih dengan kode rendah, kerangka kerja pembelajaran mesin MLFlow, dan Copilot yang kuat semuanya tersedia di notebook Python.

Cara mengakses Python Notebook

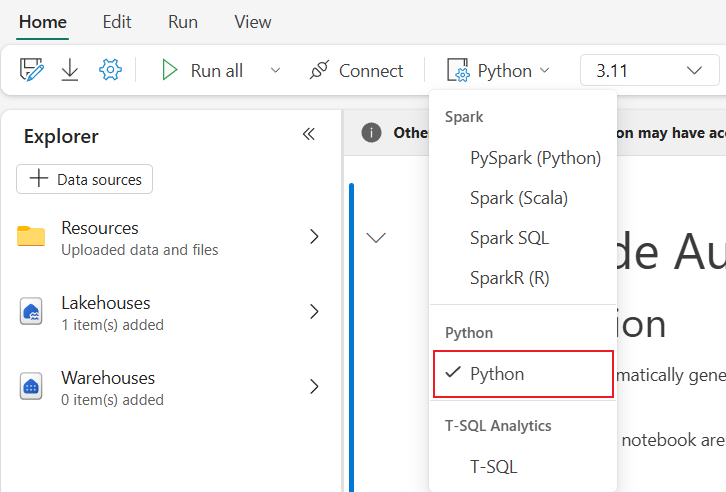

Setelah membuka Fabric Notebook, Anda dapat beralih ke Python di menu dropdown bahasa di tab Beranda dan mengonversi seluruh pengaturan notebook ke Python.

Sebagian besar fitur umum yang umum didukung pada tingkat notebook. Anda dapat merujuk pada Cara menggunakan notebook Microsoft Fabric dan Mengembangkan, menjalankan, dan mengelola notebook Microsoft Fabric untuk mempelajari penggunaan yang lebih terperinci. Di sini kita mencantumkan beberapa kemampuan utama khusus untuk skenario Python.

Menjalankan buku catatan Python

Notebook Python mendukung beberapa cara eksekusi pekerjaan:

- Eksekusi interaktif: Anda bisa menjalankan notebook Python secara interaktif seperti notebook Jupyter asli.

- Jalankan jadwal: Anda dapat menggunakan antarmuka penjadwal yang ringan di halaman pengaturan buku catatan untuk menjalankan buku catatan Python sebagai pekerjaan batch.

- Jalankan pipeline: Anda dapat mengatur notebook Python sebagai aktivitas notebook di Pipeline. Rekam jepret akan dihasilkan setelah eksekusi pekerjaan.

-

Eksekusi referensi: Anda bisa menggunakan

notebookutils.notebook.run()ataunotebookutils.notebook.runMultiple()untuk mereferensikan menjalankan buku catatan Python di buku catatan Python lain sebagai pekerjaan batch. Rekam jepret akan dihasilkan setelah eksekusi referensi selesai. - API publik dijalankan: Anda dapat menjadwalkan buku catatan python yang dijalankan dengan API publik untuk menjalankan notebook , pastikan properti bahasa dan kernel dalam metadata notebook dari payload API publik telah diatur dengan benar.

Anda bisa memantau detail eksekusi pekerjaan buku catatan Python pada tab pita Jalankan ->Tampilkan semua eksekusi.

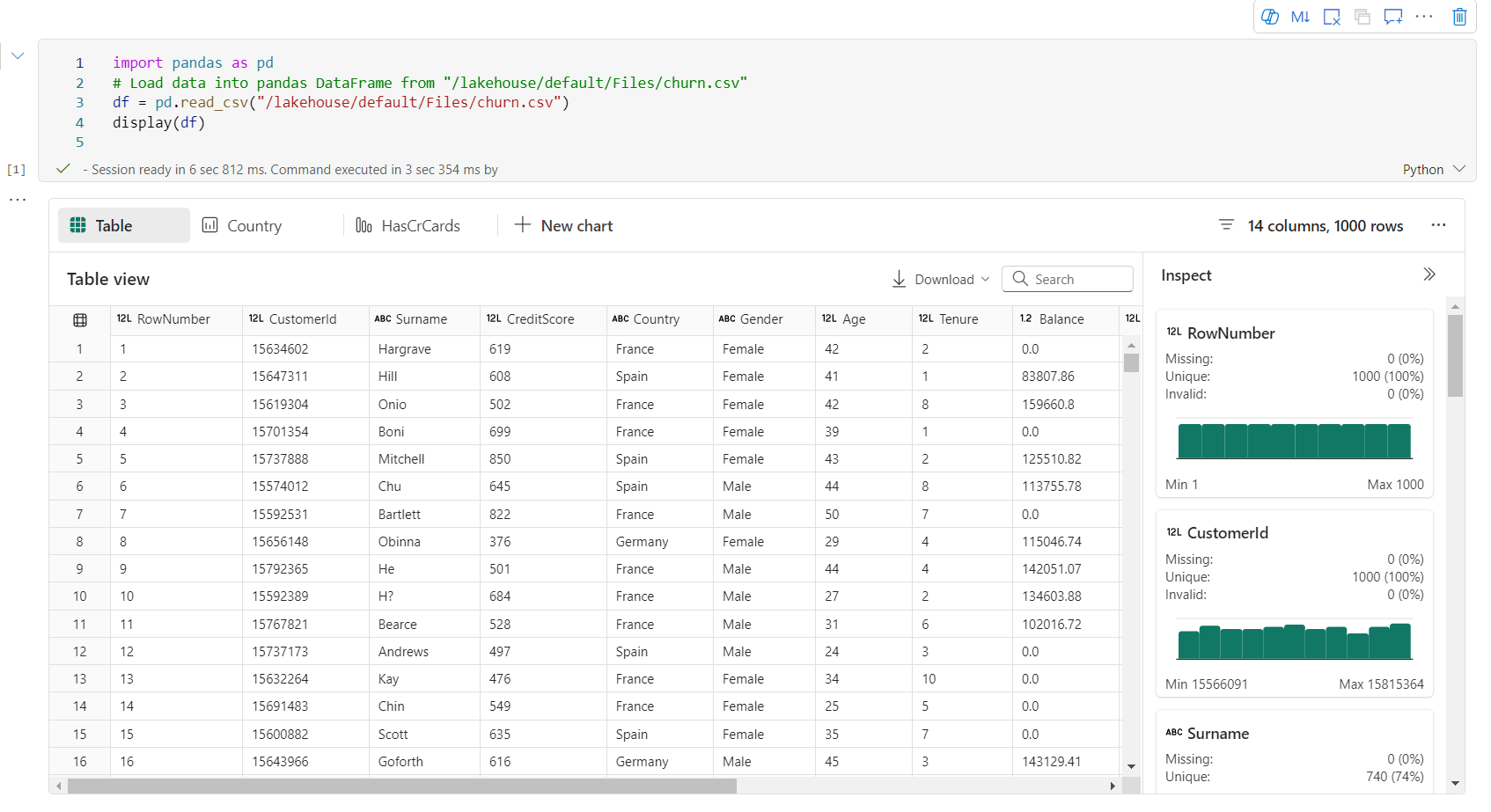

Interaksi data

Anda dapat berinteraksi dengan Lakehouse, Gudang, titik akhir SQL, dan folder sumber daya bawaan di notebook Python.

Note

- Python Notebook runtime telah diinstal sebelumnya dengan pustaka delta‑rs dan duckdb untuk mendukung membaca dan menulis data Delta Lake. Namun, perhatikan bahwa beberapa fitur Delta Lake mungkin tidak didukung sepenuhnya saat ini. Untuk detail selengkapnya dan pembaruan terbaru, silakan lihat situs web delta-rs dan duckdb resmi.

- Saat ini kami tidak mendukung deltalake(delta-rs) versi 1.0.0 atau lebih tinggi. Menantikan.

Interaksi Lakehouse

Anda dapat mengatur Lakehouse sebagai default, atau Anda juga dapat menambahkan beberapa Lakehouse untuk menjelajahi dan menggunakannya di buku catatan.

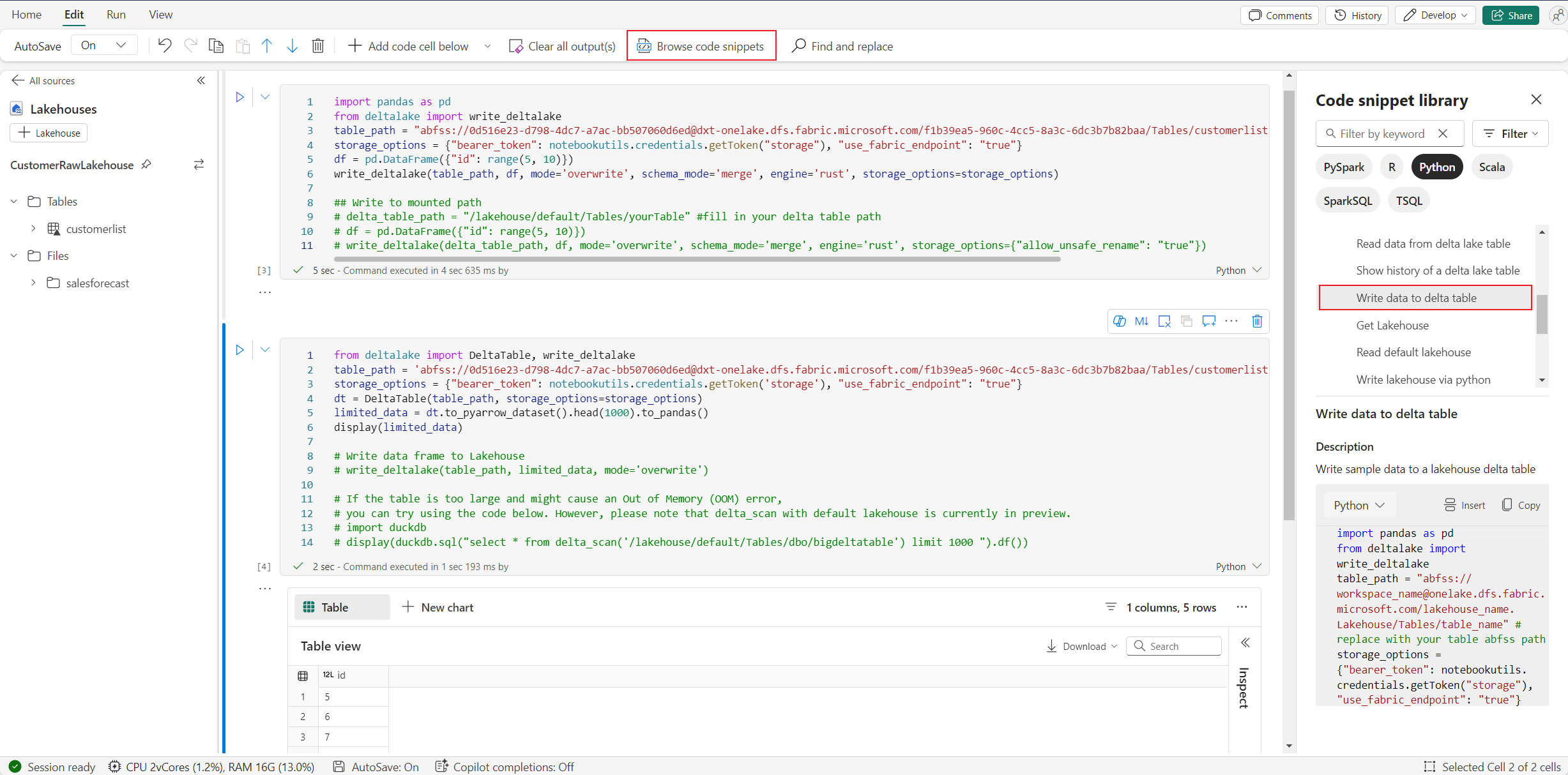

Jika Anda tidak terbiasa membaca objek data seperti tabel delta, coba seret dan letakkan file dan tabel delta ke kanvas buku catatan, atau gunakan menu dropdown Muat data di objek. Notebook secara otomatis menyisipkan cuplikan kode ke dalam sel kode dan menghasilkan kode untuk membaca objek data target.

Note

Jika Anda menemukan OOM saat memuat data dalam volume besar, coba gunakan dataframe DuckDB, Polars, atau PyArrow alih-alih Pandas.

Anda dapat menemukan operasi tulis Lakehouse di Menelusuri cuplikan kode ->Menulis data ke tabel delta.

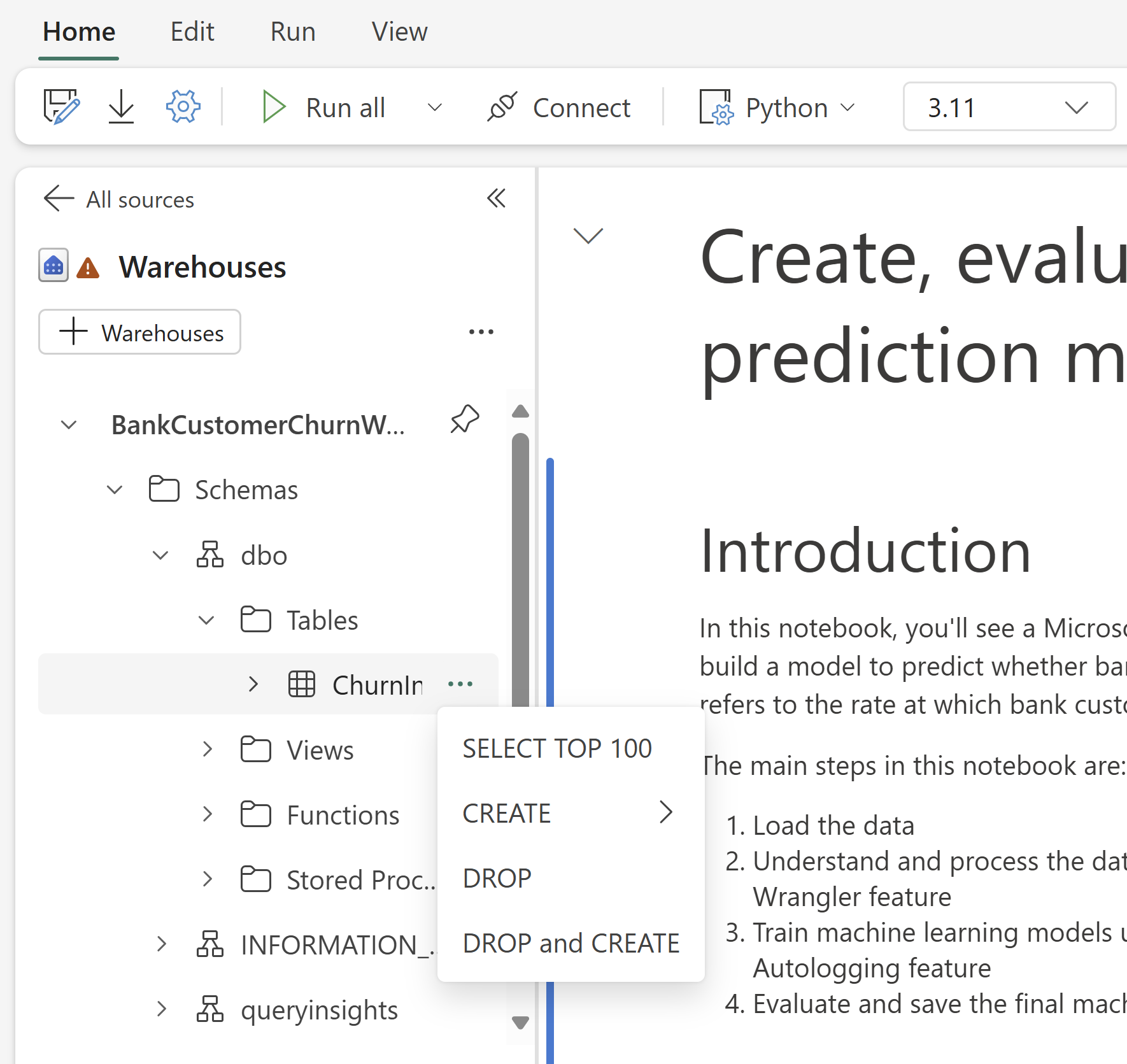

Interaksi gudang dan pemrograman campuran dengan T-SQL

Anda dapat menambahkan Gudang Data atau titik akhir SQL dari penjelajah Gudang Notebook. Demikian pula, Anda dapat menyeret dan menjatuhkan tabel ke kanvas buku catatan, atau menggunakan operasi pintasan di menu dropdown tabel. Notebook secara otomatis menghasilkan cuplikan kode untuk Anda. Anda dapat menggunakan utilitas notebookutils.data untuk membuat koneksi dengan Gudang dan mengkueri data menggunakan pernyataan T-SQL dalam konteks Python.

Note

Titik akhir SQL hanya-bisa dibaca di sini.

Folder sumber buku catatan

Folder sumber daya bawaan Notebook tersedia secara native di Python Notebook. Anda dapat dengan mudah berinteraksi dengan file dalam folder sumber daya bawaan menggunakan kode Python seolah-olah Anda bekerja dengan sistem file lokal Anda. Saat ini, folder sumber daya Lingkungan tidak didukung.

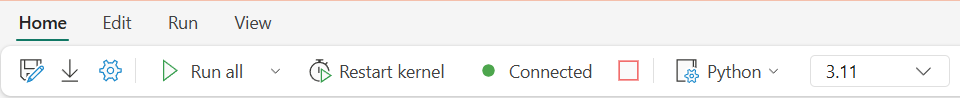

Operasi kernel

Notebook Python mendukung dua kernel bawaan saat ini, mereka adalah Python 3.10 dan Python 3.11, kernel default yang dipilih adalah Python 3.11. Anda dapat dengan mudah beralih di antara mereka.

Anda dapat menghentikan sementara, memulai ulang, atau beralih kernel pada tab Beranda dari menu pita. Menghentikan kernel di buku catatan Python sama dengan membatalkan sel di buku catatan Spark.

Keluarnya kernel abnormal menyebabkan eksekusi kode terganggu dan kehilangan variabel, tetapi tidak menghentikan sesi notebook.

Ada perintah yang dapat menyebabkan kernel mati. Misalnya, keluar(), exit().

Manajemen pustaka

Anda dapat menggunakan perintah %pip dan %conda untuk instalasi langsung, perintah ini mendukung pustaka-pustaka publik dan yang telah disesuaikan.

Untuk pustaka yang dikustomisasi, Anda dapat mengunggah file lib ke folder Sumber daya bawaan . Kami mendukung beberapa jenis pustaka, termasuk format seperti Wheel (.whl), JAR (.jar), DLL (.dll), dan Python (.py). Cukup coba seret&jatuhkan ke file dan cuplikan kode dihasilkan secara otomatis.

Anda mungkin perlu menghidupkan ulang kernel untuk menggunakan paket yang diperbarui.

Untuk lebih memahami dan menggunakan perintah serupa dengan jelas, lihat tabel di bawah ini.

| Command/Syntax | Tujuan utama | Cara kerjanya di Jupyter Notebook | Kasus penggunaan umum | Notes |

|---|---|---|---|---|

%pip install package |

Memasang paket Python | Menjalankan pip di kernel Python dari buku catatan | Cara yang disarankan untuk menginstal paket | Di Python Notebook, sama seperti !pip; tidak memulai ulang kernel secara otomatis |

!pip install package |

Menginstal paket Python melalui shell | Menjalankan pip sebagai perintah shell | Cara alternatif untuk menginstal paket | Di Python Notebook, sama seperti %pip; tidak memulai ulang kernel secara otomatis |

import sys; sys.exit(0) |

Menghidupkan ulang kernel buku catatan | Segera memulai ulang kernel | Mulai ulang kernel secara terprogram | Menghapus semua variabel dan status; tidak disarankan untuk menggunakan secara langsung |

notebookutils.session.restartPython() |

Menghidupkan ulang kernel buku catatan | Panggilan sys.exit(0) secara internal |

Cara yang disarankan untuk menghidupkan ulang kernel | API resmi, lebih aman dan lebih kompatibel daripada menggunakan sys.exit(0) secara langsung |

Note

- Di Python Notebook,

%pipdan!pipmemiliki perilaku yang sama: keduanya menginstal paket ke lingkungan kernel saat ini, dan tidak akan secara otomatis memulai ulang kernel setelah penginstalan. - Jika Anda perlu menghidupkan ulang kernel (misalnya, setelah menginstal paket tertentu), disarankan untuk menggunakan

notebookutils.session.restartPython()alih-alihimport sys; sys.exit(0).-

notebookutils.session.restartPython()adalah API resmi yang membungkussys.exit(0), dan lebih aman dan lebih kompatibel di lingkungan notebook.

-

-

Tidak disarankan untuk menggunakan

sys.exit(0)secara langsung kecuali diperlukan.

Pemantauan penggunaan sumber daya notebook Python waktu nyata

Penting

Fitur ini sedang dalam tahap pratinjau.

Dengan panel monitor sumber daya, Anda dapat melacak informasi runtime penting seperti durasi sesi, jenis komputasi, dan metrik sumber daya real time, termasuk konsumsi CPU dan memori, langsung di dalam notebook Anda. Fitur ini memberikan gambaran umum langsung tentang sesi aktif Anda dan sumber daya yang digunakan.

Monitor sumber daya meningkatkan visibilitas tentang bagaimana beban kerja Python menggunakan sumber daya sistem. Ini membantu Anda mengoptimalkan performa, mengelola biaya, dan mengurangi risiko kesalahan kehabisan memori (OOM). Dengan memantau metrik secara real time, Anda dapat mengidentifikasi operasi intensif sumber daya, menganalisis pola penggunaan, dan membuat keputusan berdasarkan informasi tentang menskalakan atau memodifikasi kode.

Untuk mulai menggunakannya, atur bahasa buku catatan Anda ke Python dan mulai sesi. Anda kemudian dapat membuka monitor dengan mengklik sumber daya komputasi di bilah status buku catatan atau dengan memilih Tampilkan penggunaan sumber daya dari toolbar. Panel monitor sumber daya akan muncul secara otomatis, memberikan pengalaman pemantauan terintegrasi untuk kode Python di notebook Fabric.

Perintah khusus konfigurasi sesi

Mirip dengan mempersonalisasi konfigurasi sesi Spark di notebook, Anda juga dapat menggunakan %%configure di buku catatan Python. Notebook Python mendukung penyesuaian ukuran node komputasi, titik pemasangan, dan lakehouse default untuk sesi notebook. Mereka dapat digunakan dalam notebook interaktif dan aktivitas notebook pipeline. Sebaiknya gunakan perintah %%configure di awal buku catatan Anda, atau Anda harus memulai ulang sesi buku catatan untuk membuat pengaturan berlaku.

Berikut adalah properti yang didukung di buku catatan Python %%configure:

%%configure -f

{

"vCores": 4, // Recommended values: [4, 8, 16, 32, 64], Fabric will allocate matched memory according to the specified vCores.

"defaultLakehouse": {

// Will overwrites the default lakehouse for current session

"name": "<lakehouse-name>",

"id": "<(optional) lakehouse-id>",

"workspaceId": "<(optional) workspace-id-that-contains-the-lakehouse>" // Add workspace ID if it's from another workspace

},

"mountPoints": [

{

"mountPoint": "/myMountPoint",

"source": "abfs[s]://<file_system>@<account_name>.dfs.core.windows.net/<path>"

},

{

"mountPoint": "/myMountPoint1",

"source": "abfs[s]://<file_system>@<account_name>.dfs.core.windows.net/<path1>"

},

],

}

Anda dapat melihat pembaruan sumber daya komputasi pada bilah status buku catatan, dan memantau penggunaan CPU dan Memori simpul komputasi secara real time.

NotebookUtils

Utilitas Notebook (NotebookUtils) adalah paket bawaan untuk membantu Anda melakukan tugas umum dengan mudah di Fabric Notebook. Ini telah diinstal sebelumnya pada runtime Python. Anda dapat menggunakan NotebookUtils untuk bekerja dengan sistem file, untuk mendapatkan variabel lingkungan, untuk menautkan buku catatan bersama-sama, mengakses penyimpanan eksternal, dan bekerja dengan rahasia.

Anda dapat menggunakan notebookutils.help() untuk mencantumkan API yang tersedia dan juga mendapatkan bantuan dengan metode, atau merujuk dokumen NotebookUtils.

Utilitas data

Note

Saat ini, fitur tersebut sedang dalam pratinjau.

Anda dapat menggunakan utilitas notebookutils.data untuk membuat koneksi dengan sumber data yang disediakan lalu membaca dan mengkueri data menggunakan pernyataan T-SQL.

Jalankan perintah berikut untuk mendapatkan gambaran umum metode yang tersedia:

notebookutils.data.help()

Output:

Help on module notebookutils.data in notebookutils:

NAME

notebookutils.data - Utility for read/query data from connected data sources in Fabric

FUNCTIONS

connect_to_artifact(artifact: str, workspace: str = '', artifact_type: str = '', **kwargs)

Establishes and returns an ODBC connection to a specified artifact within a workspace

for subsequent data queries using T-SQL.

:param artifact: The name or ID of the artifact to connect to.

:param workspace: Optional; The workspace in which the provided artifact is located, if not provided,

use the workspace where the current notebook is located.

:param artifactType: Optional; The type of the artifact, Currently supported type are Lakehouse, Warehouse and MirroredDatabase.

If not provided, the method will try to determine the type automatically.

:param **kwargs Optional: Additional optional configuration. Supported keys include:

- tds_endpoint : Allow user to specify a custom TDS endpoint to use for connection.

:return: A connection object to the specified artifact.

:raises UnsupportedArtifactException: If the specified artifact type is not supported to connect.

:raises ArtifactNotFoundException: If the specified artifact is not found within the workspace.

Examples:

sql_query = "SELECT DB_NAME()"

with notebookutils.data.connect_to_artifact("ARTIFACT_NAME_OR_ID", "WORKSPACE_ID", "ARTIFACT_TYPE") as conn:

df = conn.query(sql_query)

display(df)

help(method_name: str = '') -> None

Provides help for the notebookutils.data module or the specified method.

Examples:

notebookutils.data.help()

notebookutils.data.help("connect_to_artifact")

:param method_name: The name of the method to get help with.

DATA

__all__ = ['help', 'connect_to_artifact']

FILE

/home/trusted-service-user/jupyter-env/python3.10/lib/python3.10/site-packages/notebookutils/data.py

Mengkueri data dari Lakehouse

conn = notebookutils.data.connect_to_artifact("lakehouse_name_or_id", "optional_workspace_id", "optional_lakehouse_type")

df = conn.query("SELECT * FROM sys.schemas;")

Mengkueri data dari Gudang

conn = notebookutils.data.connect_to_artifact("warehouse_name_or_id", "optional_workspace_id", "optional_warehouse_type")

df = conn.query("SELECT * FROM sys.schemas;")

Mengkueri data dari database SQL

conn = notebookutils.data.connect_to_artifact("sqldb_name_or_id", "optional_workspace_id", "optional_sqldatabase_type")

df = conn.query("SELECT * FROM sys.schemas;")

Note

Utilitas Data di NotebookUtils hanya tersedia di notebook Python untuk saat ini.

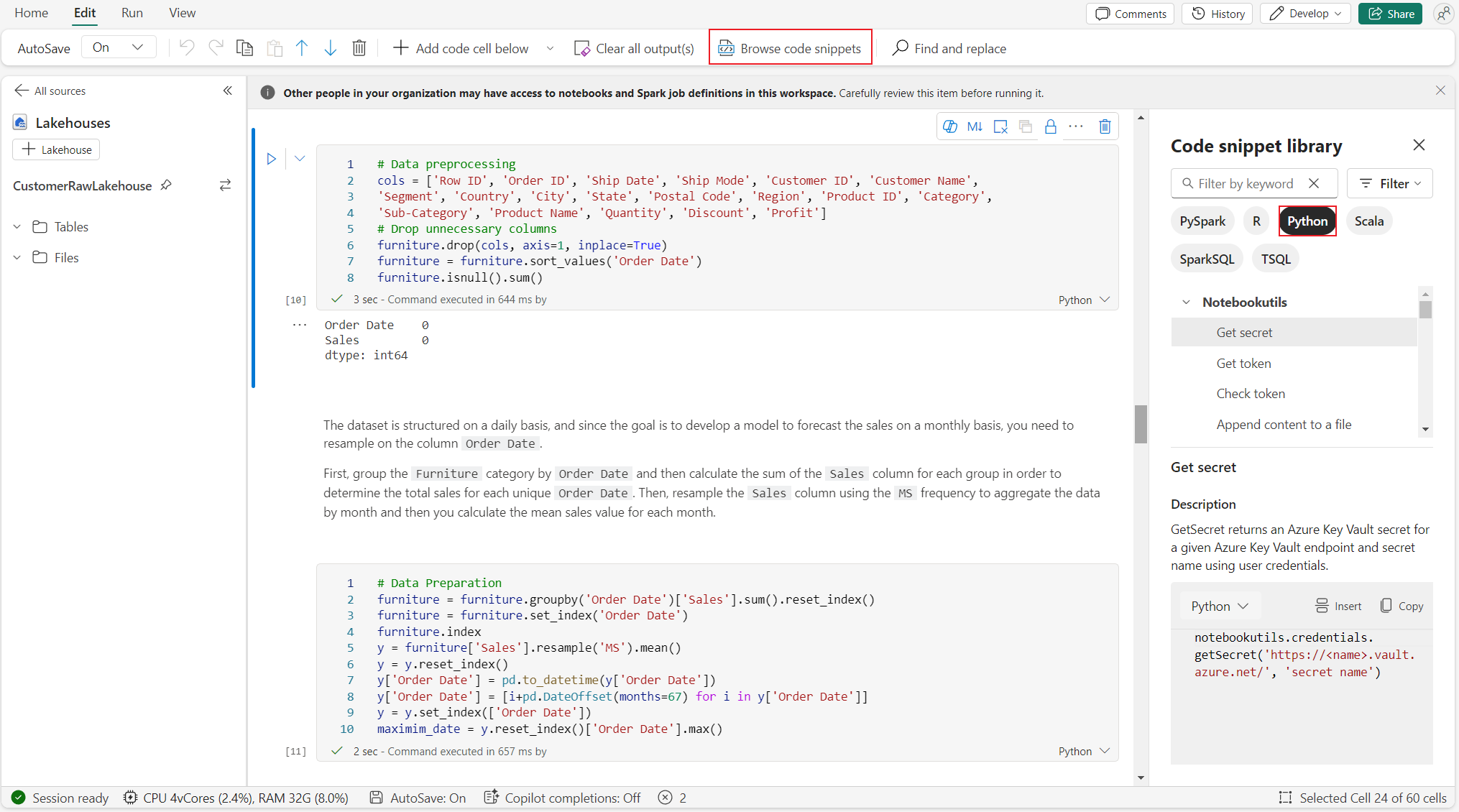

Menelusuri cuplikan kode

Anda dapat menemukan cuplikan kode Python yang berguna pada tab Edit - >, sampel Python baru kini tersedia. Anda dapat belajar dari cuplikan kode Python untuk mulai menjelajahi buku catatan.

Tautan semantik

Tautan semantik adalah fitur yang memungkinkan Anda membuat koneksi antara model semantik dan Synapse Data Science di Microsoft Fabric. Ini didukung secara asli pada notebook Python. Teknisi BI dan pengembang Power BI dapat menggunakan semantic link connect dan mengelola model semantik dengan mudah. Baca dokumen publik untuk mempelajari selengkapnya tentang tautan Semantik.

Visualization

Selain menggambar bagan dengan pustaka, fungsi visualisasi bawaan memungkinkan Anda mengubah DataFrame menjadi visualisasi data berformat kaya. Anda dapat menggunakan fungsi display() pada dataframe untuk menghasilkan tampilan tabel dataframe yang kaya dan tampilan bagan.

Note

Konfigurasi bagan akan bertahan di buku catatan Python, yang berarti setelah menjalankan ulang sel kode, jika skema dataframe target belum berubah, bagan yang disimpan masih bertahan.

Kode intelliSense

Notebook Python juga menggunakan Pylance sebagai server bahasa. Untuk informasi selengkapnya, lihat meningkatkan Pengembangan Python dengan Pylance.

Kemampuan ilmu data

Kunjungi dokumentasi Data Science di Microsoft Fabric untuk mempelajari lebih lanjut ilmu data dan pengalaman AI di Fabric. Di sini kami mencantumkan beberapa fitur sains data utama yang didukung secara asli pada buku catatan Python.

Data Wrangler: Data Wrangler adalah alat berbasis notebook yang menyediakan antarmuka imersif untuk analisis data eksplorasi. Fitur ini menggabungkan tampilan data seperti kisi dengan statistik ringkasan dinamis, visualisasi bawaan, dan pustaka operasi pembersihan data umum. Ini menyediakan pembersihan data, transformasi data, dan integrasi, yang mempercepat persiapan data dengan Data Wrangler.

MLflow: Eksperimen pembelajaran mesin adalah unit utama organisasi dan kontrol untuk semua eksekusi pembelajaran mesin terkait. Eksekusi mengacu pada satu kali pengoperasian kode model.

Fabric Auto Logging: Synapse Data Science di Microsoft Fabric mencakup autologging, yang secara signifikan mengurangi jumlah kode yang diperlukan untuk mencatat parameter, metrik, dan item model pembelajaran mesin secara otomatis selama pelatihan.

Autologging memperluas kemampuan Pelacakan MLflow. Autologging dapat mengambil berbagai metrik, termasuk akurasi, kehilangan, skor F1, dan metrik kustom yang Anda tentukan. Dengan menggunakan autologging, pengembang dan ilmuwan data dapat dengan mudah melacak dan membandingkan performa model dan eksperimen yang berbeda tanpa pelacakan manual.

Copilot: Buku catatan Copilot for Data Science and Data Engineering adalah asisten AI yang membantu Anda menganalisis dan memvisualisasikan data. Sistem ini bekerja dengan tabel lakehouse, dataset Power BI, dan dataframe pandas/spark, memberikan jawaban serta cuplikan kode secara langsung di dalam notebook. Anda dapat menggunakan panel obrolan Copilot dan Char-magics di notebook, dan AI menyediakan respons atau kode untuk disalin ke notebook Anda.

Batasan yang diketahui

Tidak ada jaminan pengalaman kolam langsung untuk setiap eksekusi buku catatan python. Waktu mulai sesi mungkin memerlukan hingga 3 menit jika eksekusi notebook tidak mencapai kolam aktif. Seiring pertumbuhan penggunaan notebook Python, metode pengumpulan cerdas kami bertahap meningkatkan alokasi kumpulan aktif untuk memenuhi permintaan.

Integrasi lingkungan tidak tersedia di notebook Python.

Pengaturan batas waktu sesi tidak tersedia untuk saat ini.

Copilot dapat menghasilkan pernyataan Spark, yang mungkin tidak dapat dieksekusi di notebook Python.

Saat ini, Copilot di notebook Python tidak sepenuhnya didukung di beberapa wilayah. Proses penyebaran masih berlangsung, tetap terhubung sambil kami terus meluncurkan dukungan di lebih banyak wilayah.