Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Berlaku untuk:✅ Rekayasa Data dan Ilmu Data di Microsoft Fabric

Saat Anda membuat ruang kerja di Microsoft Fabric, kumpulan pemula yang terkait dengan ruang kerja tersebut dibuat secara otomatis. Dengan penyiapan yang disederhanakan di Microsoft Fabric, Anda tidak perlu memilih simpul atau ukuran komputer, karena opsi ini ditangani untuk Anda di belakang layar. Konfigurasi ini memberikan pengalaman mulai sesi Apache Spark yang lebih cepat (5-10 detik) bagi pengguna untuk memulai dan menjalankan pekerjaan Apache Spark Anda dalam banyak skenario umum tanpa harus khawatir tentang menyiapkan komputasi. Untuk skenario tingkat lanjut dengan persyaratan komputasi tertentu, pengguna dapat membuat kumpulan Apache Spark kustom dan mengukur simpul berdasarkan kebutuhan performa mereka.

Untuk membuat perubahan pada pengaturan Apache Spark di ruang kerja, Anda harus memiliki peran admin untuk ruang kerja tersebut. Untuk mempelajari selengkapnya, lihat Peran di ruang kerja.

Untuk mengelola pengaturan Spark untuk kumpulan yang terkait dengan ruang kerja Anda:

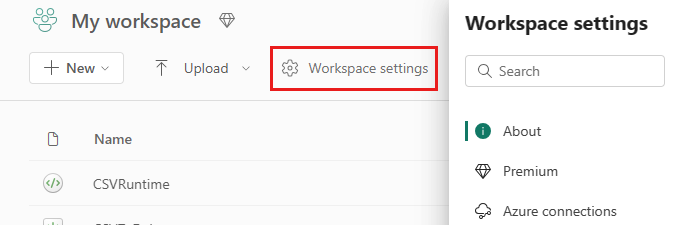

Buka pengaturan Ruang Kerja di ruang kerja Anda dan pilih opsi Rekayasa Data/Sains untuk memperluas menu:

Anda melihat opsi Komputasi Spark di menu sebelah kiri Anda:

Catatan

Jika Anda mengubah kumpulan default dari Kumpulan Pemula ke kumpulan Spark Kustom, Anda mungkin melihat awal sesi yang lebih lama (~3 menit).

Kumpulan

Kumpulan default untuk ruang kerja

Anda dapat menggunakan kumpulan pemula yang dibuat secara otomatis atau membuat kumpulan kustom untuk ruang kerja.

Kumpulan Pemula: Kumpulan langsung yang disiapkan secara otomatis dibuat untuk pengalaman Anda yang lebih cepat. Kluster ini berukuran sedang. Kumpulan pemula diatur ke konfigurasi default berdasarkan SKU kapasitas Fabric yang dibeli. Admin dapat menyesuaikan simpul dan pelaksana maksimum berdasarkan persyaratan skala beban kerja Spark mereka. Untuk mempelajari selengkapnya, lihat Mengonfigurasi Kumpulan Pemula

Kumpulan Spark Kustom: Anda dapat mengukur simpul, skala otomatis, dan mengalokasikan pelaksana secara dinamis berdasarkan persyaratan pekerjaan Spark Anda. Untuk membuat kumpulan Spark kustom, admin kapasitas harus mengaktifkan opsi Kumpulan ruang kerja yang dikustomisasi di bagian Komputasi Spark dari pengaturan Admin Kapasitas.

Catatan

Kontrol tingkat kapasitas untuk Kumpulan ruang kerja yang disesuaikan diaktifkan secara default. Untuk mempelajari selengkapnya, lihat Mengonfigurasi dan mengelola rekayasa data dan pengaturan ilmu data untuk kapasitas Fabric.

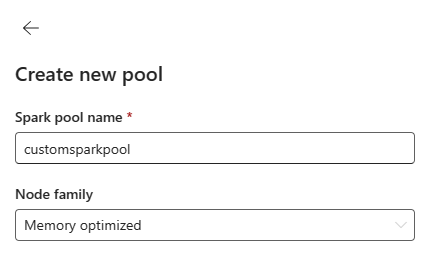

Admin dapat membuat kumpulan Spark kustom berdasarkan persyaratan komputasinya dengan memilih opsi Kumpulan Baru.

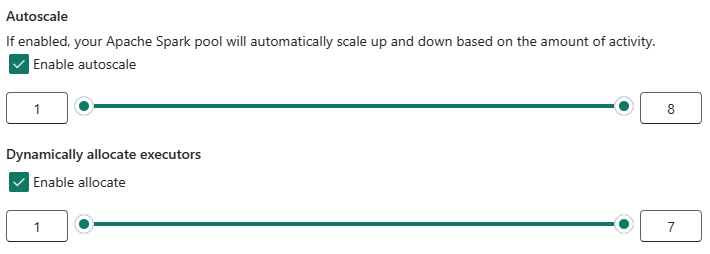

Apache Spark untuk Microsoft Fabric mendukung kluster simpul tunggal, yang memungkinkan pengguna untuk memilih konfigurasi node minimum 1 dalam hal ini driver dan eksekutor berjalan dalam satu simpul. Kluster node tunggal ini menawarkan ketersediaan tinggi yang dapat di-pemulihan selama kegagalan node dan keandalan pekerjaan yang lebih baik untuk beban kerja dengan persyaratan komputasi yang lebih kecil. Anda juga dapat mengaktifkan atau menonaktifkan opsi penskalaan otomatis untuk kumpulan Spark kustom Anda. Ketika diaktifkan dengan skala otomatis, kumpulan akan memperoleh simpul baru dalam batas simpul maks yang ditentukan oleh pengguna dan menghentikannya setelah eksekusi pekerjaan untuk performa yang lebih baik.

Anda juga dapat memilih opsi untuk mengalokasikan pelaksana secara dinamis untuk mengumpulkan jumlah pelaksana yang optimal secara otomatis dalam batas maksimum yang ditentukan berdasarkan volume data untuk performa yang lebih baik.

Pelajari selengkapnya tentang komputasi Apache Spark untuk Fabric.

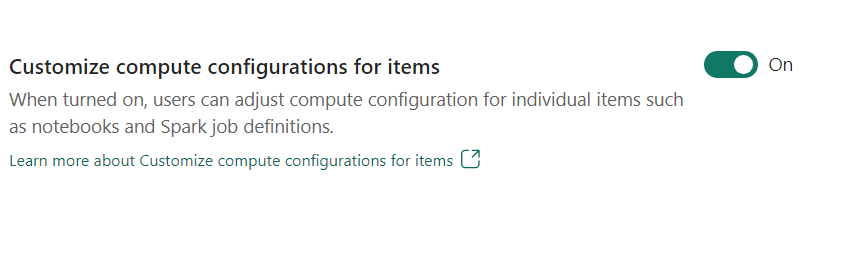

- Kustomisasi konfigurasi komputasi untuk item: Sebagai admin ruang kerja, Anda dapat mengizinkan pengguna untuk menyesuaikan konfigurasi komputasi (properti tingkat sesi yang mencakup Driver/Executor Core, Driver/Executor Memory) untuk item individual seperti notebook, definisi pekerjaan Spark menggunakan Lingkungan.

Jika pengaturan dinonaktifkan oleh admin ruang kerja, kumpulan Default dan konfigurasi komputasinya digunakan untuk semua lingkungan di ruang kerja.

Lingkungan

Lingkungan menyediakan konfigurasi fleksibel untuk menjalankan pekerjaan Spark Anda (notebook, definisi kerja Spark). Di Lingkungan Anda dapat mengonfigurasi properti komputasi, memilih runtime yang berbeda, menyiapkan dependensi paket pustaka berdasarkan persyaratan beban kerja Anda.

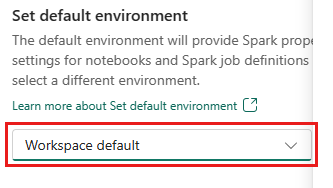

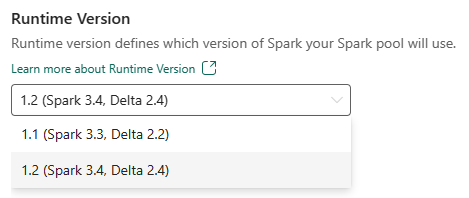

Di tab lingkungan, Anda memiliki opsi untuk mengatur lingkungan default. Anda dapat memilih versi Spark mana yang ingin Anda gunakan untuk ruang kerja.

Sebagai admin ruang kerja Fabric, Anda dapat memilih Lingkungan sebagai Lingkungan default ruang kerja.

Anda juga dapat membuat yang baru melalui menu dropdown Lingkungan .

Jika Anda menonaktifkan opsi untuk memiliki lingkungan default, Anda memiliki opsi untuk memilih versi runtime Fabric dari versi runtime yang tersedia yang tercantum dalam pilihan dropdown.

Pelajari selengkapnya tentang runtime Apache Spark.

Pekerjaan

Pengaturan pekerjaan memungkinkan admin mengontrol logika penerimaan pekerjaan untuk semua pekerjaan Spark di ruang kerja.

Secara default semua ruang kerja diaktifkan dengan Penerimaan Pekerjaan Optimis. Pelajari selengkapnya tentang Penerimaan pekerjaan untuk Spark di Microsoft Fabric.

Anda dapat mengaktifkan pemesanan inti maksimum untuk pekerjaan Spark yang aktif untuk menonaktifkan pendekatan berbasis penerimaan pekerjaan optimis dan memesan inti maksimum untuk pekerjaan Spark mereka.

Anda juga dapat mengatur batas waktu sesi Spark untuk menyesuaikan kedaluwarsa sesi untuk semua sesi interaktif buku catatan.

Catatan

Kedaluwarsa sesi default diatur ke 20 menit untuk sesi Spark interaktif.

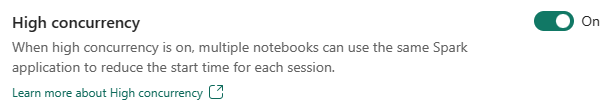

Konkurensi tinggi

Mode konkurensi tinggi memungkinkan pengguna untuk berbagi sesi Spark yang sama di Apache Spark untuk rekayasa data Fabric dan beban kerja ilmu data. Item seperti buku catatan menggunakan sesi Spark untuk eksekusinya dan saat diaktifkan memungkinkan pengguna berbagi satu sesi Spark di beberapa buku catatan.

Pelajari selengkapnya tentang Konkurensi tinggi di Apache Spark for Fabric.

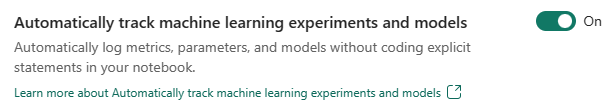

Pengelogan otomatis untuk model dan eksperimen Pembelajaran Mesin

Admin sekarang dapat mengaktifkan autologging untuk model dan eksperimen pembelajaran mesin mereka. Opsi ini secara otomatis mengambil nilai parameter input, metrik output, dan item output dari model pembelajaran mesin saat sedang dilatih. Pelajari selengkapnya tentang autologging.

Konten terkait

- Baca tentang Apache Spark Runtimes di Fabric - Gambaran Umum, Penerapan Versi, Dukungan Beberapa Runtime, dan Peningkatan Delta Lake Protocol.

- Pelajari selengkapnya dari dokumentasi publik Apache Spark.

- Temukan jawaban atas tanya jawab umum: Tanya Jawab Umum pengaturan administrasi ruang kerja Apache Spark.