Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Tutorial ini memasukkan data ke dalam Fabric lakehouses dalam format Delta Lake. Kami mendefinisikan beberapa istilah penting di sini:

Lakehouse - Lakehouse adalah kumpulan file, folder, dan/atau tabel yang mewakili database di atas data lake. Mesin Spark dan mesin SQL menggunakan sumber daya lakehouse untuk pemrosesan big data. Saat Anda menggunakan tabel berformat Delta sumber terbuka, pemrosesan tersebut menyertakan kemampuan transaksi ACID yang ditingkatkan.

Delta Lake - Delta Lake adalah lapisan penyimpanan sumber terbuka yang membawa transaksi ACID, manajemen metadata yang dapat diskalakan, dan pemrosesan data batch dan streaming ke Apache Spark. Sebagai format tabel data, Delta Lake memperluas file data Parquet dengan log transaksi berbasis file untuk transaksi ACID dan manajemen metadata yang dapat diskalakan.

Azure Open Datasets adalah himpunan data publik yang dikumpulkan yang menambahkan fitur khusus skenario ke solusi pembelajaran mesin. Ini mengarah pada model yang lebih akurat. Open Datasets adalah sumber daya cloud yang berada di Microsoft Azure Storage. Apache Spark, REST API, Data factory, dan alat lainnya dapat mengakses Open Datasets.

Dalam tutorial ini, Anda menggunakan Apache Spark untuk:

- Membaca data dari kontainer Azure Open Datasets.

- Tulis data ke dalam tabel delta Fabric lakehouse.

Prasyarat

Dapatkan langganan Microsoft Fabric . Atau, daftar untuk uji coba Microsoft Fabric gratis.

Masuk ke Microsoft Fabric.

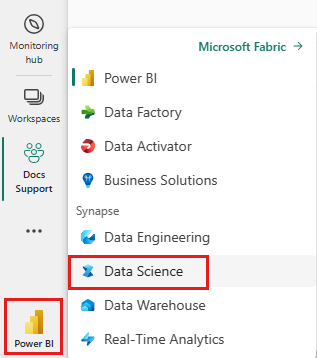

Beralih ke Fabric dengan menggunakan pengalih pengalaman di sisi kiri bawah halaman beranda Anda.

- Tambahkan lakehouse ke buku catatan ini. Dalam tutorial ini, Anda terlebih dahulu mengunduh data dari blob publik. Kemudian, data disimpan dalam sumber daya lakehouse tersebut.

Ikuti instruksi menggunakan buku catatan

Notebook 1-ingest-data.ipynb menyertai tutorial ini.

Untuk membuka buku catatan yang menyertai tutorial ini, ikuti instruksi dalam Menyiapkan sistem Anda untuk tutorial ilmu data untuk mengimpor buku catatan ke ruang kerja Anda.

Jika Anda lebih suka menyalin dan menempelkan kode dari halaman ini, Anda bisa membuat buku catatan baru.

Pastikan untuk melampirkan lakehouse ke buku catatan sebelum Anda mulai menjalankan kode.

Data churn pelanggan bank

Himpunan data berisi informasi status churn untuk 10.000 pelanggan. Ini juga mencakup atribut yang dapat mempengaruhi risiko berhenti berlangganan - contohnya:

- Skor kredit

- Lokasi geografis (Jerman, Prancis, Spanyol)

- Jenis kelamin (laki-laki, perempuan)

- Umur

- Tenure (jumlah tahun nasabah adalah klien di bank tersebut)

- Saldo akun

- Estimasi gaji

- Jumlah produk yang dibeli nasabah melalui bank

- Status kartu kredit (baik pelanggan memiliki kartu kredit atau tidak)

- Status anggota aktif (baik nasabah memiliki status nasabah bank aktif atau tidak)

Himpunan data juga menyertakan kolom ini:

- nomor baris

- ID pelanggan

- nama keluarga pelanggan

Kolom-kolom ini seharusnya tidak berpengaruh pada keputusan pelanggan untuk meninggalkan bank.

Penutupan rekening bank pelanggan menunjukkan perubahan status pelanggan tersebut. Kolom data exited mengacu pada kehilangan pelanggan. Konteks kecil tentang atribut ini tersedia, jadi Anda harus melanjutkan tanpa informasi latar belakang tentang himpunan data. Tujuan kami adalah untuk memahami bagaimana atribut ini berkontribusi pada exited status.

Contoh baris himpunan data:

| "CustomerID" | Nama Belakang | "CreditScore" | Geografi | "Jenis Kelamin" | Usia | Masa Jabatan | "Keseimbangan" | JumlahProduk | "HasCrCard" | ApakahAnggotaAktif | GajiPerkiraan | "Keluar" |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 15634602 | Hargrave | 619 | Prancis | Perempuan | 42 | 2 | 0.00 | 1 | 1 | 1 | 101348.88 | 1 |

| 15647311 | Bukit | 608 | Spanyol | Perempuan | 41 | 1 | 83807.86 | 1 | 0 | 1 | 112542.58 | 0 |

Mengunduh himpunan data dan mengunggah ke lakehouse

Saran

Saat Anda menentukan parameter berikut, Anda dapat dengan mudah menggunakan notebook ini dengan himpunan data yang berbeda:

IS_CUSTOM_DATA = False # if TRUE, dataset has to be uploaded manually

DATA_ROOT = "/lakehouse/default"

DATA_FOLDER = "Files/churn" # folder with data files

DATA_FILE = "churn.csv" # data file name

Cuplikan kode berikut mengunduh versi himpunan data yang tersedia untuk umum, lalu menyimpan sumber daya tersebut di Fabric lakehouse:

Penting

Pastikan Anda menambahkan lakehouse ke buku catatan sebelum menjalankannya. Kegagalan untuk melakukannya menghasilkan kesalahan.

import os, requests

if not IS_CUSTOM_DATA:

# Download demo data files into lakehouse if not exist

remote_url = "https://synapseaisolutionsa.z13.web.core.windows.net/data/bankcustomerchurn"

file_list = [DATA_FILE]

download_path = f"{DATA_ROOT}/{DATA_FOLDER}/raw"

if not os.path.exists("/lakehouse/default"):

raise FileNotFoundError(

"Default lakehouse not found, please add a lakehouse and restart the session."

)

os.makedirs(download_path, exist_ok=True)

for fname in file_list:

if not os.path.exists(f"{download_path}/{fname}"):

r = requests.get(f"{remote_url}/{fname}", timeout=30)

with open(f"{download_path}/{fname}", "wb") as f:

f.write(r.content)

print("Downloaded demo data files into lakehouse.")

Konten terkait

Anda menggunakan data yang baru saja Anda serap di: