Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Penting

Dukungan untuk Studio Azure Machine Learning (klasik) akan berakhir pada 31 Agustus 2024. Sebaiknya Anda transisi ke Azure Machine Learning sebelum tanggal tersebut.

Mulai 1 Desember 2021, Anda tidak akan dapat membuat sumber daya Studio Azure Machine Learning (klasik) baru. Hingga 31 Agustus 2024, Anda dapat terus menggunakan sumber daya Pembelajaran Mesin Studio (klasik) yang ada.

- Lihat informasi tentang memindahkan proyek pembelajaran mesin dari ML Studio (klasik) ke Azure Machine Learning.

- Pelajari selengkapnya tentang Azure Machine Learning.

ML Dokumentasi Studio (klasik) sedang berhenti dan mungkin tidak diperbarui di masa mendatang.

Artikel ini menjelaskan modul di Pembelajaran Mesin Studio (klasik) yang dapat Anda gunakan untuk mengevaluasi model pembelajaran mesin. Evaluasi model dilakukan setelah pelatihan selesai, untuk mengukur akurasi prediksi dan menilai kecocokan model.

Catatan

Berlaku untuk: hanya Pembelajaran Mesin Studio (klasik)

Modul seret dan letakkan serupa tersedia di perancang Azure Machine Learning.

Artikel ini juga menjelaskan proses keseluruhan di Pembelajaran Mesin Studio (klasik) untuk pembuatan model, pelatihan, evaluasi, dan penilaian.

Membuat dan menggunakan model pembelajaran mesin di Pembelajaran Mesin Studio (klasik)

Alur kerja umum untuk pembelajaran mesin mencakup fase ini:

- Pilih algoritma yang sesuai dan atur opsi awal.

- Latih model dengan menggunakan data yang kompatibel.

- Buat prediksi dengan menggunakan data baru yang didasarkan pada pola dalam model.

- Evaluasi model untuk menentukan apakah prediksi akurat, jumlah kesalahan, dan apakah overfitting terjadi.

Pembelajaran Mesin Studio (klasik) mendukung kerangka kerja yang fleksibel dan dapat disesuaikan untuk pembelajaran mesin. Setiap tugas dalam proses ini dilakukan oleh jenis modul tertentu. Modul dapat dimodifikasi, ditambahkan, atau dihapus tanpa merusak sisa eksperimen Anda.

Gunakan modul dalam kategori ini untuk mengevaluasi model yang ada. Evaluasi model biasanya memerlukan beberapa jenis himpunan data hasil. Jika Anda tidak memiliki himpunan data evaluasi, Anda dapat menghasilkan hasil dengan menilai. Anda juga dapat menggunakan himpunan data pengujian, atau sekumpulan data lain yang berisi "kebenaran dasar" atau hasil yang diharapkan yang diketahui.

Selengkapnya tentang evaluasi model

Secara umum, saat mengevaluasi model, opsi Anda bergantung pada jenis model yang Anda evaluasi, dan metrik yang ingin Anda gunakan. Topik-topik ini mencantumkan beberapa metrik yang paling sering digunakan:

Pembelajaran Mesin Studio (klasik) juga menyediakan berbagai visualisasi, tergantung pada jenis model yang Anda gunakan, dan berapa banyak kelas yang diprediksi model Anda. Untuk bantuan menemukan visualisasi ini, lihat Menampilkan metrik evaluasi.

Menafsirkan statistik ini sering membutuhkan pemahaman yang lebih besar tentang algoritma tertentu tempat model dilatih. Untuk penjelasan yang baik tentang cara mengevaluasi model, dan cara menginterpretasikan nilai yang dikembalikan untuk setiap pengukuran, lihat Cara mengevaluasi performa model di Pembelajaran Mesin.

Daftar modul

Kategori Pembelajaran Mesin - Evaluasi mencakup modul berikut:

Model Validasi Silang: Memvalidasi silang perkiraan parameter untuk model klasifikasi atau regresi dengan mempartisi data.

Gunakan modul Model Validasi Silang jika Anda ingin menguji validitas set pelatihan dan model Anda. Validasi silang mempartisi data ke dalam lipatan, lalu menguji beberapa model pada kombinasi lipatan.

Mengevaluasi Model: Mengevaluasi klasifikasi skor atau model regresi dengan menggunakan metrik standar.

Dalam kebanyakan kasus, Anda akan menggunakan modul Model Evaluasi generik. Ini terutama berlaku jika model Anda didasarkan pada salah satu algoritma klasifikasi atau regresi yang didukung.

Evaluasi Pemberi Rekomendasi: Mengevaluasi akurasi prediksi model pemberi rekomendasi.

Untuk model rekomendasi, gunakan modul Evaluasi Pemberi Rekomendasi .

Tugas terkait

- Untuk model pengklusteran, gunakan modul Tetapkan Data ke Kluster . Kemudian, gunakan visualisasi dalam modul tersebut untuk melihat hasil evaluasi.

- Anda dapat membuat metrik evaluasi kustom. Untuk membuat metrik evaluasi kustom, berikan kode R dalam modul Execute R Script , atau kode Python dalam modul Execute Python Script . Opsi ini berguna jika Anda ingin menggunakan metrik yang diterbitkan sebagai bagian dari pustaka sumber terbuka, atau jika Anda ingin merancang metrik Anda sendiri untuk mengukur akurasi model.

Contoh

Menafsirkan hasil evaluasi model pembelajaran mesin adalah seni. Ini membutuhkan pemahaman hasil matematika, selain data dan masalah bisnis. Kami menyarankan agar Anda meninjau artikel ini untuk penjelasan tentang cara menginterpretasikan hasil dalam skenario yang berbeda:

- Pilih parameter untuk mengoptimalkan algoritma Anda di Pembelajaran Mesin

- Menginterpretasikan hasil model dalam Pembelajaran Mesin

- Mengevaluasi performa model di Pembelajaran Mesin

Catatan teknis

Bagian ini berisi detail implementasi, tips, dan jawaban terkait pertanyaan yang sering diajukan.

Menampilkan metrik evaluasi

Pelajari tempat untuk melihat di Pembelajaran Mesin Studio (klasik) untuk menemukan bagan metrik untuk setiap jenis model.

Model klasifikasi dua kelas

Tampilan default untuk model klasifikasi biner mencakup bagan ROC interaktif dan tabel nilai untuk metrik utama.

Anda memiliki dua opsi untuk melihat model klasifikasi biner:

- Klik kanan output modul, lalu pilih Visualisasikan.

- Klik kanan modul, pilih Hasil evaluasi, lalu pilih Visualisasikan.

Anda juga dapat menggunakan penggeser untuk mengubah nilai Ambang Probabilitas . Ambang menentukan apakah hasil harus diterima sebagai benar atau tidak. Kemudian, Anda dapat melihat bagaimana nilai-nilai ini berubah.

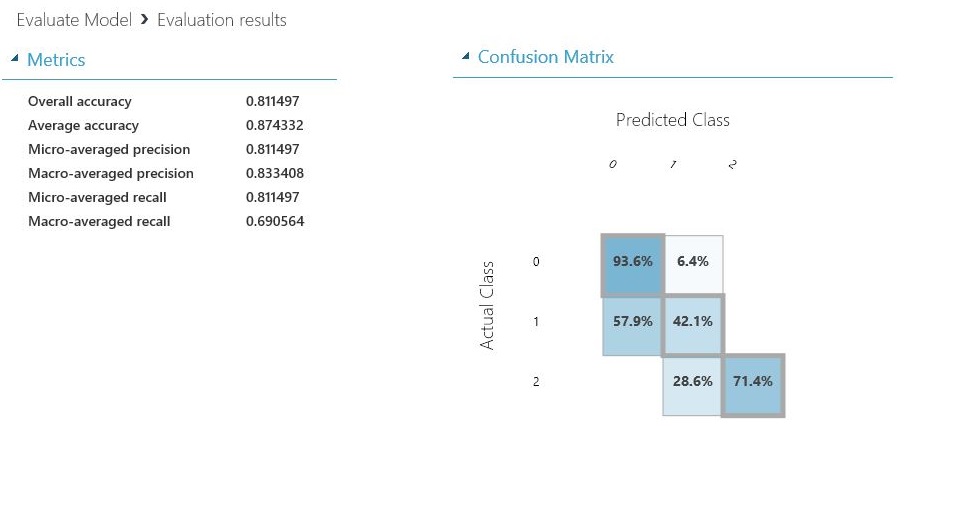

Model klasifikasi multikelas

Tampilan metrik default untuk model klasifikasi multi-kelas mencakup matriks kebingungan untuk semua kelas dan serangkaian metrik untuk model secara keseluruhan.

Anda memiliki dua opsi untuk melihat model klasifikasi multi-kelas:

- Klik kanan output modul, lalu pilih Visualisasikan.

- Klik kanan modul, pilih Hasil evaluasi, lalu pilih Visualisasikan.

Untuk kesederhanaan, berikut adalah dua hasilnya, yang ditunjukkan berdampingan:

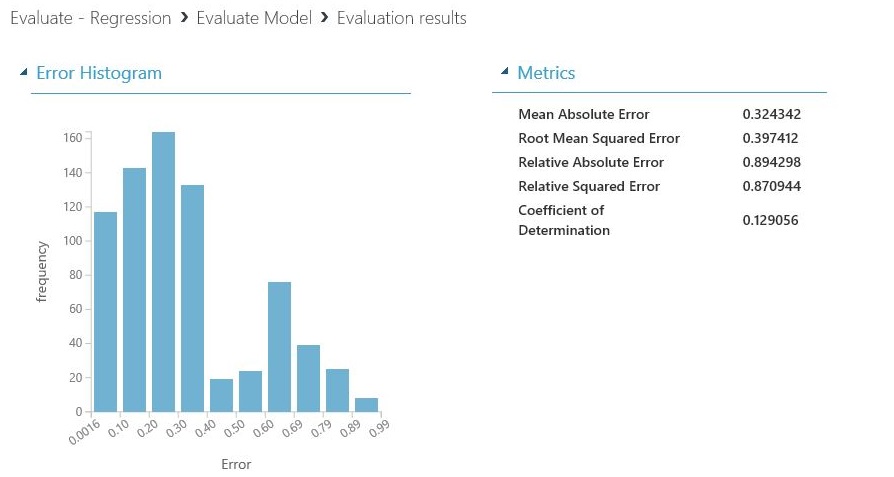

Model regresi

Tampilan metrik untuk model regresi bervariasi tergantung pada jenis model yang Anda buat. Tampilan metrik didasarkan pada antarmuka algoritma yang mendasar, dan paling cocok untuk metrik model.

Anda memiliki dua opsi untuk melihat model regresi:

- Untuk melihat metrik akurasi dalam tabel, klik kanan output modul Evaluasi Model , lalu pilih Visualisasikan.

- Untuk melihat histogram kesalahan dengan nilai, klik kanan modul, pilih Hasil evaluasi, lalu pilih Visualisasikan.

Tampilan Histogram Kesalahan dapat membantu Anda memahami bagaimana kesalahan didistribusikan. Ini disediakan untuk jenis model berikut, dan menyertakan tabel metrik default, seperti kesalahan kuadrat rata-rata akar (RMSE).

Model regresi berikut menghasilkan tabel metrik default, bersama dengan beberapa metrik kustom:

Tips untuk bekerja dengan data

Untuk mengekstrak angka tanpa menyalin dan menempelkan dari UI Pembelajaran Mesin Studio (klasik), Anda dapat menggunakan pustaka PowerShell baru untuk Pembelajaran Mesin. Anda bisa mendapatkan metadata dan informasi lainnya untuk seluruh eksperimen, atau dari modul individual.

Untuk mengekstrak nilai dari modul Evaluasi Model , Anda harus menambahkan komentar unik ke modul, untuk identifikasi yang lebih mudah. Kemudian, gunakan cmdlet Download-AmlExperimentNodeOutput untuk mendapatkan metrik dan nilainya dari visualisasi dalam format JSON.

Untuk informasi selengkapnya, lihat Membuat model pembelajaran mesin dengan menggunakan PowerShell.