Esempio di prezzi: copiare i dati e trasformarli con Azure Databricks

SI APPLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi all-in-one per le aziende. Microsoft Fabric copre tutto, dallo spostamento dati al data science, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Vedere le informazioni su come iniziare una nuova prova gratuita!

In questo scenario si desidera copiare dati da AWS S3 in Archiviazione BLOB di Azure e trasformare i dati con Azure Databricks secondo una pianificazione oraria, per 8 ore al giorno per 30 giorni.

I prezzi usati nell’esempio seguente sono ipotetici e non suggeriscono in alcun modo i prezzi effettivi esatti. I costi di lettura/scrittura e monitoraggio non vengono visualizzati perché in genere sono trascurabili e non influiscono significativamente sui costi complessivi. Le esecuzioni di attività vengono arrotondate anche ai 1.000 più vicini nelle stime del calcolatore dei prezzi.

Nota

Questa stima riguarda solo i costi di Azure Data Factory. Anche Azure Databricks comporta costi in questo scenario, ma è possibile stimarli usando il calcolatore prezzi di Azure.

Fare riferimento al Calcolatore prezzi di Azure per scenari più specifici e per stimare i costi futuri per l'uso del servizio.

Impostazione

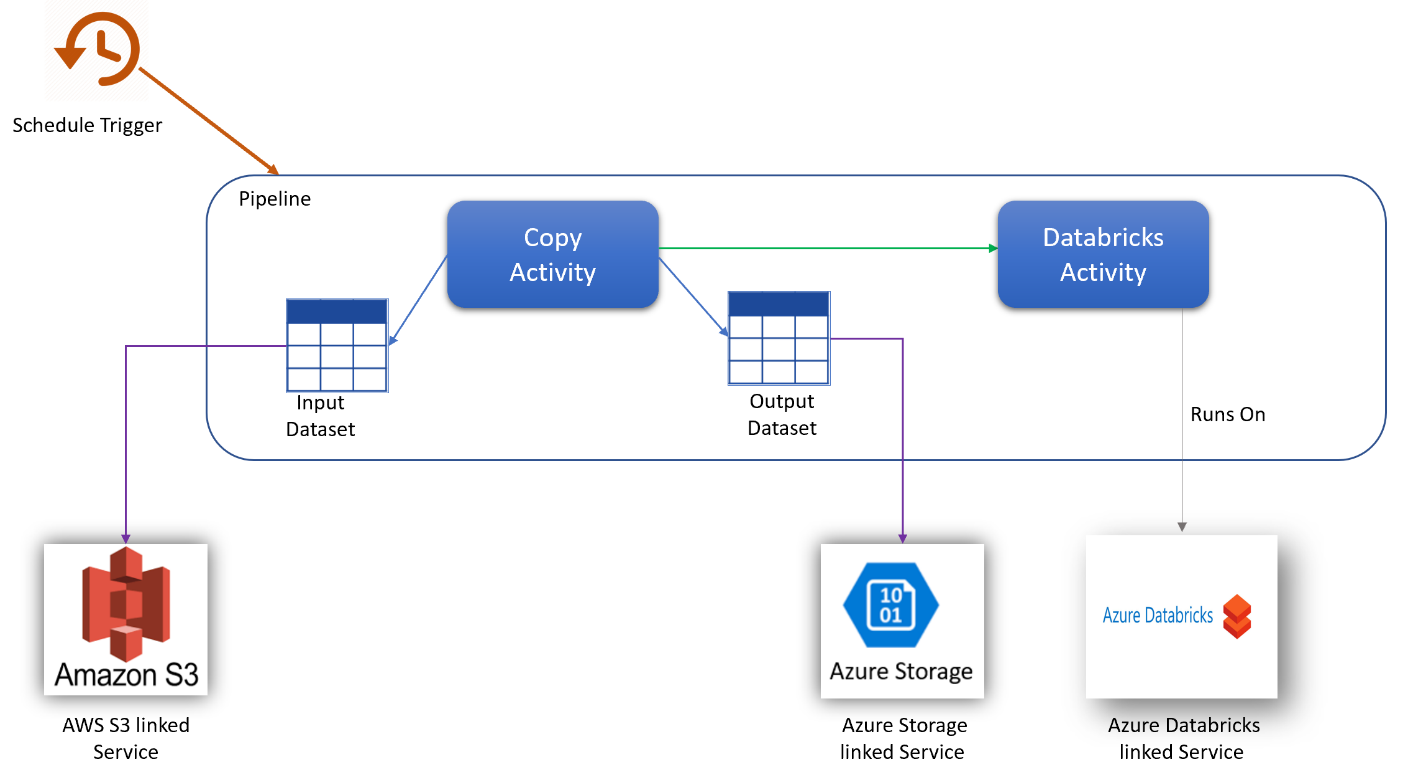

Per eseguire lo scenario è necessario creare una pipeline con gli elementi seguenti:

- Una sola attività di copia con un set di dati di input per i dati da copiare da AWS S3 e un set di dati di output per i dati in Archiviazione di Azure.

- Una sola attività di Azure Databricks per la trasformazione dei dati.

- Un solo trigger di pianificazione per eseguire la pipeline ogni ora. Quando si vuole eseguire una pipeline, è possibile attivarla immediatamente o pianificarla. Oltre alla pipeline stessa, ogni istanza del trigger viene conteggiata come singola esecuzione di attività.

Stima dei costi

| Operazioni | Tipi e unità |

|---|---|

| Eseguire la pipeline | 3 esecuzioni di attività per esecuzione (1 per l'esecuzione del trigger, 2 per le esecuzioni di attività) = 720 esecuzioni di attività, arrotondate poiché il calcolatore consente solo incrementi di 1.000. |

| Presupposto copia dati: ore DIU per esecuzione = 10 min | 10 min/60 min * 4 Azure Integration Runtime (impostazione DIU predefinita = 4) Per altre informazioni sulle unità di integrazione dati e l'ottimizzazione delle prestazioni di copia, vedere questo articolo |

| Esecuzione del presupposto dell'attività di Databricks: ore di esecuzione esterna per esecuzione = 10 min | 10 min/60 min Esecuzione di attività di pipeline esterna |

Esempio di calcolatore prezzi

Prezzi totali dello scenario per 30 giorni: $ 41,01

Contenuto correlato

- Esempio di prezzi: copiare i dati da AWS S3 in Archiviazione BLOB di Azure ogni ora per 30 giorni

- Esempio di prezzi: copiare i dati e trasformarli con parametri dinamici ogni ora per 30 giorni

- Esempio di prezzi: eseguire pacchetti SSIS in Azure-SSIS Integration Runtime

- Esempio di prezzi: usare il debug del flusso di dati per mapping per una giornata lavorativa normale

- Esempio di prezzi: trasformare i dati nell'archivio BLOB con flussi di dati per mapping

- Esempio di prezzi: integrazione dei dati nella rete virtuale gestita di Azure Data Factory

- Esempio di prezzi: ottenere dati differenziali da SAP ECC tramite SAP CDC nei flussi di dati per mapping

Commenti e suggerimenti

Presto disponibile: Nel corso del 2024 verranno gradualmente disattivati i problemi di GitHub come meccanismo di feedback per il contenuto e ciò verrà sostituito con un nuovo sistema di feedback. Per altre informazioni, vedere https://aka.ms/ContentUserFeedback.

Invia e visualizza il feedback per