Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Le seguenti funzionalità e miglioramenti di Databricks SQL sono stati rilasciati nel 2025.

Novembre 2025

Databricks SQL versione 2025.35 è in fase di implementazione in Current

20 novembre 2025

Databricks SQL versione 2025.35 viene distribuita nel canale Corrente. Vedere le funzionalità nel 2025.35.

Gli avvisi SQL di Databricks sono ora disponibili in anteprima pubblica

14 novembre 2025

- Avvisi sql di Databricks: La versione più recente degli avvisi SQL di Databricks, con una nuova esperienza di modifica, è ora disponibile in anteprima pubblica. Vedere Avvisi SQL di Databricks.

Correzione della visualizzazione dell'editor SQL

6 novembre 2025

- Correzione del problema di visualizzazione della descrizione comando: è stato risolto un problema per cui le descrizioni comando erano nascoste dietro la legenda nelle visualizzazioni del notebook e dell'editor SQL.

Ottobre 2025

Databricks SQL versione 2025.35 è ora disponibile in anteprima

30 ottobre 2025

Databricks SQL versione 2025.35 è ora disponibile nel canale di anteprima . Esamina la sezione seguente per conoscere le nuove funzionalità, i cambiamenti comportamentali e le correzioni di bug.

EXECUTE IMMEDIATE uso di espressioni costanti

È ora possibile passare espressioni costanti come stringa SQL e come argomenti ai marcatori di parametro nelle EXECUTE IMMEDIATE istruzioni.

LIMIT ALL supporto per le CTE ricorsive

È ora possibile usare LIMIT ALL per rimuovere la restrizione delle dimensioni totali per le espressioni di tabella comuni ricorsive .

st_dump supporto delle funzioni

È ora possibile usare la st_dump funzione per ottenere una matrice contenente le singole geometrie della geometria di input. Vedi la funzione st_dump.

Le funzioni dell'anello interno poligono sono ora supportate

È ora possibile usare le seguenti funzioni per lavorare con gli anelli interni di un poligono:

-

st_numinteriorrings: ottiene il numero di limiti interni (anelli) di un poligono. Vedi la funzionest_numinteriorrings. -

st_interiorringn: estrarre il confine interno n-esimo di un poligono e restituirlo come linestring. Vedi la funzionest_interiorringn.

Supporto per l'aggiornamento delle informazioni MV/ST in DESCRIBE EXTENDED AS JSON

Azure Databricks genera ora una sezione per la visualizzazione materializzata e le informazioni sull'aggiornamento della tabella di streaming nell'output, inclusi l'ora dell'ultimo DESCRIBE EXTENDED AS JSON aggiornamento, il tipo di aggiornamento, lo stato e la pianificazione.

Aggiungere una colonna di metadati a DESCRIBE QUERY e DESCRIBE TABLE

Azure Databricks include ora una colonna di metadati nell'output di DESCRIBE QUERY e DESCRIBE TABLE per i metadati semantici.

Per DESCRIBE QUERY, quando si descrive una query con viste metriche, i metadati semantici vengono propagati attraverso la query se si fa riferimento direttamente alle dimensioni e le misure utilizzano la funzione MEASURE().

Per DESCRIBE TABLE, la colonna dei metadati viene visualizzata solo per le visualizzazioni delle metriche, non per altri tipi di tabella.

Gestione corretta degli struct null durante la rimozione di colonne NullType

Quando si scrive in tabelle Delta, Azure Databricks mantiene ora correttamente i valori di struct Null quando si eliminano NullType colonne dallo schema. In precedenza, gli struct Null venivano sostituiti in modo non corretto con valori di struct non Null in cui tutti i campi erano impostati su Null.

Nuova esperienza di modifica degli avvisi

20 ottobre 2025

- Nuova esperienza di modifica degli avvisi: La creazione o la modifica di un avviso si apre ora nel nuovo editor a più schede, fornendo un flusso di lavoro di modifica unificato. Vedere Avvisi SQL di Databricks.

Correzione delle visualizzazioni

9 ottobre 2025

- Selezione della legenda per i nomi di serie con alias: La selezione della legenda ora funziona correttamente per i grafici con nomi di serie con alias nell'editor SQL e nei notebook.

Metadati semantici nelle visualizzazioni delle metriche

2 ottobre 2025

È ora possibile definire metadati semantici in una visualizzazione metrica. I metadati semantici consentono agli strumenti di intelligenza artificiale, ad esempio spazi genie e dashboard di intelligenza artificiale/BI, di interpretare e usare i dati in modo più efficace.

Per usare i metadati semantici, la visualizzazione delle metriche deve usare la specifica YAML versione 1.1 o successiva ed eseguire in Databricks Runtime 17.2 o versione successiva. La versione sql di Databricks corrispondente è 2025.30, disponibile nel canale di anteprima per SQL Warehouse.

Vedere Usare metadati semantici nelle visualizzazioni delle metriche e Aggiornare YAML a 1.1.

Settembre 2025

Databricks SQL versione 2025.30 è ora disponibile in anteprima

25 settembre 2025

Databricks SQL versione 2025.30 è ora disponibile nel canale di anteprima . Esamina la sezione seguente per conoscere le nuove funzionalità, i cambiamenti comportamentali e le correzioni di bug.

Le regole di confronto basate su UTF8 ora supportano l'operatore LIKE

È ora possibile usare LIKE con le colonne con una delle regole di confronto seguenti abilitate: UTF8_Binary, UTF8_Binary_RTRIMUTF8_LCASE, , UTF8_LCASE_RTRIM. Vedi regole di confronto.

ST_ExteriorRing la funzione è ora supportata

È ora possibile usare la ST_ExteriorRing funzione per estrarre il limite esterno di un poligono e restituirlo come lineare. Vedi la funzione st_exteriorring.

Dichiarare più variabili di sessione o locali in una singola DECLARE istruzione

È ora possibile dichiarare più variabili di sessione o locali dello stesso tipo e valore predefinito in una singola DECLARE istruzione. Vedere DECLARE VARIABLE e l'istruzione composta BEGIN END.

Parola chiave di supporto TEMPORARY per la creazione della visualizzazione delle metriche

È ora possibile usare la TEMPORARY parola chiave durante la creazione di una visualizzazione metrica. Le visualizzazioni delle metriche temporanee sono visibili solo nella sessione che le ha create e vengono eliminate al termine della sessione. Vedi CREATE VIEW.

DESCRIBE CONNECTION mostra le impostazioni di ambiente per le connessioni JDBC

Azure Databricks include ora impostazioni di ambiente definite dall'utente nell'output DESCRIBE CONNECTION per le connessioni JDBC che supportano driver personalizzati ed eseguiti in isolamento. Altri tipi di connessione rimangono invariati.

Sintassi SQL per le opzioni di lettura Delta nelle query di streaming

È ora possibile specificare le opzioni di lettura Delta per le query di streaming basate su SQL usando la WITH clausola . Per esempio:

SELECT * FROM STREAM tbl WITH (SKIPCHANGECOMMITS=true, STARTINGVERSION=X);

Risultati corretti per split con un'espressione regolare vuota e un limite positivo

Azure Databricks restituisce ora risultati corretti quando si usa split function con un'espressione regolare vuota e un limite positivo. In precedenza, la funzione troncava erroneamente la stringa rimanente anziché includerla nell'ultimo elemento.

Correzione url_decode e try_url_decode gestione degli errori in Photon

In Photon try_url_decode() e url_decode() con failOnError = false ora restituito NULL per stringhe con codifica URL non valide invece di non riuscire la query.

Agosto 2025

L'impostazione predefinita del warehouse è ora disponibile in Beta

28 agosto 2025

Impostare un warehouse predefinito che verrà selezionato automaticamente nel selettore di calcolo nell'editor SQL, nei dashboard di intelligenza artificiale/BI, intelligenza artificiale/BI Genie, Avvisi e Esplora cataloghi. I singoli utenti possono eseguire l'override di questa impostazione selezionando un warehouse diverso prima di eseguire una query. Possono anche definire il proprio warehouse predefinito a livello di utente da applicare tra le sessioni. Vedere Impostare un'istanza predefinita di SQL Warehouse per l'area di lavoro e Impostare un warehouse predefinito a livello di utente.

Databricks SQL versione 2025.25 è in fase di implementazione in Current

21 agosto 2025

Databricks SQL versione 2025.25 viene distribuito nel canale Corrente dal 20 agosto 2025 al 28 agosto 2025. Vedere le funzionalità nel 2025.25.

Databricks SQL versione 2025.25 è ora disponibile in anteprima

14 agosto 2025

Databricks SQL versione 2025.25 è ora disponibile nel canale di anteprima . Vedere la sezione seguente per informazioni sulle nuove funzionalità e sulle modifiche comportamentali.

Le espressioni di tabella comuni ricorsive (rCTE) sono disponibili a livello generale

Le espressioni di tabella comuni ricorsive (rCTEs) sono disponibili a livello generale. Esplorare i dati gerarchici usando un CTE auto referenziante con UNION ALL per seguire la relazione ricorsiva.

Supporto per le regole di confronto predefinite a livello di schema e catalogo

È ora possibile impostare regole di confronto predefinite per schemi e cataloghi. In questo modo è possibile definire regole di confronto applicabili a tutti gli oggetti creati all'interno dello schema o del catalogo, garantendo un comportamento coerente delle regole di confronto tra i dati.

Supporto per espressioni SQL spaziali e tipi di dati GEOMETRY e GEOGRAPHY

È ora possibile archiviare dati geospaziali in colonne e GEOMETRY predefinite GEOGRAPHY per migliorare le prestazioni delle query spaziali. Questa versione aggiunge più di 80 nuove espressioni SQL spaziali, incluse le funzioni per l'importazione, l'esportazione, la misurazione, la costruzione, la modifica, la convalida, la trasformazione e la determinazione di relazioni topologiche con join spaziali. Vedere Funzioni geospaziali st, GEOGRAPHY tipo e GEOMETRY tipo.

Supporto per le regole di confronto predefinite a livello di schema e catalogo

È ora possibile impostare regole di confronto predefinite per schemi e cataloghi. In questo modo è possibile definire regole di confronto applicabili a tutti gli oggetti creati all'interno dello schema o del catalogo, garantendo un comportamento coerente delle regole di confronto tra i dati.

Gestione migliore delle opzioni JSON con VARIANT

Le from_json funzioni e to_json ora applicano correttamente le opzioni JSON quando si utilizzano schemi di primo livello VARIANT . In questo modo si garantisce un comportamento coerente con altri tipi di dati supportati.

Supporto per la sintassi TIMESTAMP WITHOUT TIME ZONE

È ora possibile specificare TIMESTAMP WITHOUT TIME ZONE anziché TIMESTAMP_NTZ. Questa modifica migliora la compatibilità con SQL Standard.

Problema di correlazione delle sottoquery risolte

Azure Databricks non correla più in modo errato espressioni di aggregazione semanticamente uguali tra una sottoquery e la relativa query esterna. In precedenza, questo potrebbe causare risultati di query non corretti.

Errore generato per vincoli non validi CHECK

Azure Databricks genera ora un'eccezione se non è possibile risolvere un'espressione AnalysisExceptionCHECK di vincolo durante la convalida dei vincoli.

Regole più rigide per i join stream-stream in modalità di accodamento

Azure Databricks ora non consente le query di streaming in modalità di accodamento che usano un join di flusso seguito dall'aggregazione di finestre, a meno che non siano definite filigrane su entrambi i lati. Le query senza filigrane appropriate possono produrre risultati non finali, violando le garanzie di modalità di accodamento.

Il nuovo editor SQL è disponibile a livello generale

14 agosto 2025

Il nuovo editor SQL è ora disponibile a livello generale. Il nuovo editor SQL offre un ambiente di creazione unificato con supporto per più risultati di istruzioni, cronologia di esecuzione inline, collaborazione in tempo reale, integrazione avanzata di Databricks Assistant e funzionalità di produttività aggiuntive. Vedere Scrivere query ed esplorare i dati nel nuovo editor SQL.

Gestione del timeout fissa per viste materializzate e tabelle di streaming

14 agosto 2025

Nuovo comportamento di timeout per le viste materializzate e le tabelle di streaming create in Databricks SQL:

- Le viste materializzate e le tabelle di streaming create dopo il 14 agosto 2025 avranno automaticamente il timeout del magazzino.

- Per le viste materializzate e le tabelle di streaming create prima del 14 agosto 2025, eseguire

CREATE OR REFRESHper sincronizzare l'impostazione di timeout con la configurazione di timeout del warehouse. - Tutte le viste materializzate e le tabelle di streaming hanno ora un timeout predefinito di due giorni.

Luglio 2025

Intervalli di date predefiniti per i parametri nell'editor SQL

31 luglio 2025

Nel nuovo editor SQL è ora possibile scegliere tra intervalli di date predefiniti, ad esempio Questa settimana, Ultimi 30 giorni o Ultimo anno quando si usano parametri timestamp, data e intervallo di date. Questi set di impostazioni semplificano l'applicazione di filtri temporali comuni senza immettere manualmente le date.

L'elenco Jobs e pipeline include ora le pipeline SQL di Databricks

29 luglio 2025

L'elenco

Cronologia di esecuzione inline nell'editor SQL

24 luglio 2025

La cronologia di esecuzione inline è ora disponibile nel nuovo editor SQL, consentendo di accedere rapidamente ai risultati precedenti senza eseguire nuovamente le query. Fare facilmente riferimento alle esecuzioni precedenti, passare direttamente ai profili di query precedenti o confrontare i tempi di esecuzione e gli stati, tutti all'interno del contesto della query corrente.

Databricks SQL versione 2025.20 è ora disponibile in Current

17 luglio 2025

Databricks SQL versione 2025.20 è in fase di implementazione nel canale Corrente. Per le funzionalità e gli aggiornamenti in questa versione, vedere Funzionalità della versione 2025.20.

Aggiornamenti dell'editor SQL

17 luglio 2025

Miglioramenti ai parametri denominati: Sono ora supportati i parametri di intervallo di date e di selezione multipla. Per i parametri dell'intervallo di date, vedere Aggiungere un intervallo di date. Per i parametri a selezione multipla, vedere Usare più valori in una singola query.

Layout dell'intestazione aggiornato nell'editor SQL: Il pulsante Esegui e il selettore del catalogo sono stati spostati nell'intestazione, offrendo più spazio verticale per la scrittura di query.

Supporto Git per gli avvisi

17 luglio 2025

È ora possibile usare le cartelle Git di Databricks per tenere traccia e gestire le modifiche agli avvisi. Per tenere traccia degli avvisi con Git, inserirli in una cartella Git di Databricks. Gli avvisi appena clonati vengono visualizzati solo nella pagina dell'elenco degli avvisi o nell'API dopo che un utente interagisce con loro. Hanno sospeso le pianificazioni e devono essere riprese in modo esplicito dagli utenti. Vedere Funzionamento dell'integrazione di Git con gli avvisi.

Databricks SQL versione 2025.20 è ora disponibile in anteprima

3 luglio 2025

Databricks SQL versione 2025.20 è ora disponibile nel canale di anteprima . Vedere la sezione seguente per informazioni sulle nuove funzionalità e sulle modifiche comportamentali.

Supporto delle procedure SQL

Gli script SQL possono ora essere incapsulati in una procedura memorizzata archiviata come asset riutilizzabile nel catalogo Unity. È possibile creare una routine usando il comando CREATE PROCEDURE e quindi chiamarla usando il comando CALL .

Impostare regole di confronto predefinite per Funzioni SQL

L'uso della nuova DEFAULT COLLATION clausola nel CREATE FUNCTION comando definisce le regole di confronto predefinite usate per STRING i parametri, il tipo restituito e STRING i valori letterali nel corpo della funzione.

Supporto di espressioni di tabella comuni ricorsive (rCTE)

Azure Databricks supporta ora la navigazione dei dati gerarchici usando espressioni di tabella comuni ricorsive (rCTEs).

Usare un CTE autoreferenziale con UNION ALL per seguire la relazione ricorsiva.

Supporto ALL CATALOGS negli SHOW SCHEMI

La SHOW SCHEMAS sintassi viene aggiornata per accettare la sintassi seguente:

SHOW SCHEMAS [ { FROM | IN } { catalog_name | ALL CATALOGS } ] [ [ LIKE ] pattern ]

Quando ALL CATALOGS viene specificato in una SHOW query, l'esecuzione scorre tutti i cataloghi attivi che supportano gli spazi dei nomi usando il gestore dei cataloghi (DsV2). Per ogni catalogo, include i namespaces di primo livello.

Gli attributi di output e lo schema del comando sono stati modificati per aggiungere una catalog colonna che indica il catalogo dello spazio dei nomi corrispondente. La nuova colonna viene aggiunta alla fine degli attributi di output, come illustrato di seguito:

Output precedente

| Namespace |

|------------------|

| test-namespace-1 |

| test-namespace-2 |

Nuovo output

| Namespace | Catalog |

|------------------|----------------|

| test-namespace-1 | test-catalog-1 |

| test-namespace-2 | test-catalog-2 |

Il clustering liquido compatta ora i vettori di eliminazione in modo più efficiente

Le Tabelle Delta con il clustering Liquid ora applicano modifiche fisiche dai vettori di eliminazione in modo più efficiente quando OPTIMIZE è attivo. Per altri dettagli, vedere Applicare modifiche ai file di dati Parquet.

Consenti espressioni non deterministiche nei valori di colonna UPDATE/INSERT per operazioni MERGE

Azure Databricks consente ora l'uso di espressioni non deterministiche nei valori di colonna aggiornati e inseriti delle MERGE operazioni. Tuttavia, le espressioni non deterministiche nelle condizioni degli MERGE statement non sono supportate.

Ad esempio, è ora possibile generare valori dinamici o casuali per le colonne:

MERGE INTO target USING source

ON target.key = source.key

WHEN MATCHED THEN UPDATE SET target.value = source.value + rand()

Ciò può essere utile per la privacy dei dati offuscando i dati effettivi mantenendo al tempo stesso le proprietà dei dati ,ad esempio valori medi o altre colonne calcolate.

Supportare la parola chiave VAR per dichiarare ed eliminare variabili SQL

La sintassi SQL per la dichiarazione e l'eliminazione di variabili supporta ora la VAR parola chiave oltre a VARIABLE. Questa modifica unifica la sintassi in tutte le operazioni correlate alle variabili, migliorando la coerenza e riducendo la confusione per gli utenti che usano VAR già durante l'impostazione delle variabili.

CREATE VIEW Le clausole a livello di colonna generano ora errori quando la clausola si applica solo alle viste materializzate

CREATE VIEW i comandi che specificano una clausola a livello di colonna valida solo per MATERIALIZED VIEWs ora generano un errore. Le clausole interessate per i comandi CREATE VIEW sono:

NOT NULL- Tipo di dati specificato, ad esempio

FLOAToSTRING DEFAULTCOLUMN MASK

Giugno 2025

Aggiornamenti del motore SQL Serverless di Databricks

11 giugno 2025

Gli aggiornamenti del motore seguenti vengono ora implementati a livello globale, con disponibilità in espansione in tutte le aree nelle prossime settimane.

- Bassa latenza: i dashboard, i processi ETL e i carichi di lavoro misti vengono ora eseguiti più velocemente, con un massimo di 25% miglioramento. L'aggiornamento viene applicato automaticamente ai data warehouse SQL serverless senza costi o configurazioni aggiuntivi.

- Esecuzione di query predittive (PQE): PQE monitora le attività in tempo reale e regola in modo dinamico l'esecuzione delle query per evitare asimmetrie, spill e lavoro non necessario.

- Photon Shuffle vettorializzato: Mantiene i dati in formato colonnare compatto, li ordina nella cache ad alta velocità della CPU ed elabora più valori contemporaneamente usando istruzioni vettorializzate. Ciò migliora la capacità di elaborazione per i carichi di lavoro CPU-bound, come grandi join e aggregazioni estese.

Aggiornamenti dell'interfaccia utente

5 giugno 2025

-

Miglioramenti delle informazioni dettagliate sulle query: La pagina Cronologia query ora emette l'evento

listHistoryQueries. L'apertura di un profilo di query genera ora l'eventogetHistoryQuery.

Maggio 2025

Le visualizzazioni delle metriche sono in anteprima pubblica

29 maggio 2025

Le visualizzazioni delle metriche del catalogo unity offrono un modo centralizzato per definire e gestire metriche aziendali di base coerenti, riutilizzabili e regolate. Estraggono logica di business complessa in una definizione centralizzata, consentendo alle organizzazioni di definire indicatori di prestazioni chiave una sola volta e di usarli in modo coerente tra strumenti di creazione di report come dashboard, spazi Genie e avvisi. Usare un'istanza di SQL Warehouse in esecuzione nel canale di anteprima (2025.16) o in un'altra risorsa di calcolo che esegue Databricks Runtime 16.4 o versione successiva per lavorare con le visualizzazioni delle metriche. Vedere Viste delle metriche del catalogo Unity.

Aggiornamenti dell'interfaccia utente

29 maggio 2025

-

Miglioramenti del nuovo editor SQL:

- Nuove query nella cartella Bozze: Le nuove query vengono ora create per impostazione predefinita nella cartella Bozze. Quando vengono salvati o rinominati, vengono spostati automaticamente da Bozze.

-

Supporto dei frammenti di query: È ora possibile creare e riutilizzare frammenti di query, ovvero segmenti predefiniti di SQL, ad

JOINesempio oCASEespressioni, con il supporto per il completamento automatico e i punti di inserimento dinamici. Crea frammenti scegliendo Visualizza>Frammenti di query. - Eventi del log di controllo: Gli eventi del log di controllo vengono ora generati per le azioni eseguite nel nuovo editor SQL.

- I filtri influisce sulle visualizzazioni: I filtri applicati alle tabelle dei risultati ora influiscono anche sulle visualizzazioni, abilitando l'esplorazione interattiva senza modificare la query SQL.

Nuova versione dell'avviso nella versione beta

22 maggio 2025

Una nuova versione degli avvisi è ora disponibile in Versione beta. Questa versione semplifica la creazione e la gestione degli avvisi consolidando la configurazione delle query, le condizioni, le pianificazioni e le destinazioni di notifica in un'unica interfaccia. È comunque possibile usare avvisi legacy insieme alla nuova versione. Vedere Avvisi SQL di Databricks.

Aggiornamenti dell'interfaccia utente

22 maggio 2025

- Formattazione dei tooltip nei grafici: I tooltip nei grafici dell'editor SQL e dei notebook seguono ora la formattazione dei numeri definita nella scheda Etichette dati. Consultare Visualizzazioni nei notebook di Databricks e nell'editor SQL.

Databricks SQL versione 2025.16 è ora disponibile

15 maggio 2025

Databricks SQL versione 2025.16 è ora disponibile nel canale di anteprima . Esamina la sezione seguente per conoscere le nuove funzionalità, i cambiamenti comportamentali e le correzioni di bug.

IDENTIFIER supporto ora disponibile in Databricks SQL per le operazioni del catalogo

È ora possibile usare la IDENTIFIER clausola quando si eseguono le operazioni del catalogo seguenti:

CREATE CATALOGDROP CATALOGCOMMENT ON CATALOGALTER CATALOG

Questa nuova sintassi consente di specificare in modo dinamico i nomi di catalogo usando i parametri definiti per queste operazioni, abilitando flussi di lavoro SQL più flessibili e riutilizzabili. Come esempio della sintassi, considerare CREATE CATALOG IDENTIFIER(:param) dove param è un parametro fornito per specificare un nome di catalogo.

Per altri dettagli, vedere IDENTIFIER la clausola .

Le espressioni collegate ora forniscono alias transitori generati automaticamente

Gli alias generati automaticamente per le espressioni collate ora incorporeranno sempre in modo deterministico le informazioni di COLLATE. Gli alias generati automaticamente sono temporanei (instabili) e non bisogna farvi affidamento. In alternativa, come procedura consigliata, usare expression AS alias in modo coerente e esplicito.

UNION/EXCEPT/INTERSECT all'interno di una visualizzazione e EXECUTE IMMEDIATE ora restituiscono risultati corretti

Le query per le definizioni di visualizzazione temporanea e persistente con colonne di primo livello UNION/EXCEPT/INTERSECT e senza alias hanno restituito risultati non corretti perchéUNION/EXCEPT/INTERSECT le parole chiave sono state considerate alias. Ora queste query eseguiranno correttamente l'intera operazione di set.

EXECUTE IMMEDIATE ... INTO con una colonna di primo livello UNION/EXCEPT/INTERSECT e senza alias ha prodotto un risultato errato di un'operazione set nella variabile specificata a causa del parser che interpreta queste parole chiave come alias. Analogamente, sono state consentite anche query SQL con testo di coda non valido. Impostano le operazioni in questi casi ora scrivono un risultato corretto nella variabile specificata, oppure falliscono in caso di testo SQL non valido.

Nuove listagg e string_agg funzioni

È ora possibile usare le funzioni listagg o string_agg per aggregare i valori STRING e BINARY in un gruppo. Per altri dettagli, vedere string_agg .

Correzione del raggruppamento sui letterali interi con alias compromessi per alcune operazioni

Il raggruppamento di espressioni in un valore letterale intero con alias in precedenza non funzionava correttamente per determinate operazioni, ad esempio MERGE INTO. Ad esempio, questa espressione restituirà GROUP_BY_POS_OUT_OF_RANGE perché il valore (val) verrebbe sostituito con 202001:

merge into t

using

(select 202001 as val, count(current_date) as total_count group by val) on 1=1

when not matched then insert (id, name) values (val, total_count)

Questo problema è stato risolto. Per attenuare il problema nelle query esistenti, verificare che le costanti in uso non siano uguali alla posizione della colonna che deve trovarsi nelle espressioni di raggruppamento.

Abilitare il flag per impedire la disabilitazione della materializzazione della sorgente per le operazioni MERGE.

In precedenza, gli utenti potevano disabilitare la materializzazione di origine in MERGE impostando merge.materializeSource su none. Con il nuovo flag abilitato, questo non sarà consentito e genererà un errore. Databricks prevede di abilitare il flag solo per i clienti che non hanno usato questo flag di configurazione in precedenza, quindi nessun cliente deve notare alcuna modifica del comportamento.

Aprile 2025

Databricks SQL versione 2025.15 è ora disponibile

10 aprile 2025

Databricks SQL versione 2025.15 è ora disponibile nel canale di anteprima . Esamina la sezione seguente per conoscere le nuove funzionalità, i cambiamenti comportamentali e le correzioni di bug.

Modificare più colonne usando ALTER TABLE

È ora possibile modificare più colonne in una singola ALTER TABLE istruzione. Vedere ALTER TABLE la clausola ... COLUMN.

Il downgrade del protocollo della tabella Delta è ora generalmente disponibile con protezione dei punti di controllo.

DROP FEATURE è disponibile a livello generale per rimuovere le funzionalità della tabella Delta Lake e effettuare il downgrade del protocollo di tabella. Per impostazione predefinita, DROP FEATURE ora crea checkpoint protetti per un'esperienza di downgrade più ottimizzata e semplificata che non richiede alcun tempo di attesa o troncamento della cronologia. Vedere Eliminare una funzionalità di tabella Delta Lake e effettuare il downgrade del protocollo di tabella.

Scrivere script SQL procedurali basati su SQL/PSM ANSI (anteprima pubblica)

È ora possibile usare le funzionalità di scripting basate su SQL/PSM ANSI per scrivere logica procedurale con SQL, incluse istruzioni condizionali, cicli, variabili locali e gestione delle eccezioni. Consulta Scripting SQL.

Regole di collatione predefinite a livello di tabella e vista

È ora possibile specificare regole di confronto predefinite per tabelle e viste. Ciò semplifica la creazione di tabelle e viste in cui tutte o la maggior parte delle colonne condividono le stesse regole di confronto. Vedi regole di confronto.

Nuove funzioni H3

Sono state aggiunte le funzioni H3 seguenti:

Il supporto dei dashboard legacy è terminato

10 aprile 2025

Il supporto ufficiale per i dashboard legacy è terminato. Non è più possibile creare o clonare dashboard legacy usando l'interfaccia utente o l'API. Databricks continua a risolvere i problemi critici di sicurezza e le interruzioni del servizio, ma consiglia di usare i dashboard di intelligenza artificiale/BI per tutti i nuovi sviluppi. Per altre informazioni sui dashboard di intelligenza artificiale/BI, vedere Dashboard. Per informazioni sulla migrazione, vedere Clonare un dashboard legacy in un dashboard di intelligenza artificiale/BI e Usare le API del dashboard per creare e gestire i dashboard.

Opzioni di formattazione automatica personalizzate per le query SQL

3 aprile 2025

Personalizzare le opzioni di formattazione automatica per tutte le query SQL. Vedere Istruzioni SQL in formato personalizzato.

Problema di visualizzazione Boxplot risolto

3 aprile 2025

È stato risolto un problema per cui le visualizzazioni boxplot sql di Databricks con solo un asse x categorico non visualizzavano correttamente categorie e barre. Le visualizzazioni ora vengono visualizzate come previsto.

L'autorizzazione CAN VIEW per sql warehouse è disponibile in anteprima pubblica

3 aprile 2025

L'autorizzazione CAN VIEW è ora disponibile in anteprima pubblica. Questa autorizzazione consente agli utenti di monitorare i warehouse SQL, inclusi la cronologia delle query e i profili di query associati. Gli utenti con autorizzazione CAN VIEW non possono eseguire query nel warehouse SQL senza avere autorizzazioni aggiuntive. Vedere ACL di SQL Warehouse.

Marzo 2025

Aggiornamenti dell'interfaccia utente

27 marzo 2025

- Profili di query aggiornati per migliorare l'usabilità: I profili di query sono stati aggiornati per migliorare l'usabilità e consentono di accedere rapidamente alle informazioni dettagliate chiave. Consulta il profilo della query .

Aggiornamenti dell'interfaccia utente

20 marzo 2025

- Trasferire la proprietà di SQL Warehouse all'entità servizio: È ora possibile usare l'interfaccia utente per trasferire la proprietà del magazzino a un'entità servizio.

Aggiornamenti dell'interfaccia utente

6 marzo 2025

- i grafici a due assi supportano ora lo zoom: È ora possibile fare clic e trascinare per eseguire lo zoom avanti sui grafici a doppio asse.

- Blocca le colonne della tabella: Ora è possibile bloccare le colonne della tabella sul lato sinistro della visualizzazione della tabella. Le colonne rimangono visualizzate mentre si scorre verso destra nella tabella. Vedi Impostazioni colonna.

- È stato risolto un problema relativo ai grafici combinati: Risolto un errore di allineamento tra le etichette dell'asse x e le barre quando si usa un campo temporale sull'asse x.

Febbraio 2025

Databricks SQL versione 2025.10 è ora disponibile

21 febbraio 2025

Databricks SQL versione 2025.10 è ora disponibile nel canale Anteprima. Esamina la sezione seguente per conoscere le nuove funzionalità, i cambiamenti comportamentali e le correzioni di bug.

In Condivisione Delta la cronologia delle tabelle è abilitata per impostazione predefinita

Le condivisioni create con il comando SQL ALTER SHARE <share> ADD TABLE <table> ora hanno la condivisione della cronologia (WITH HISTORY) abilitata per impostazione predefinita. Vedi ALTER SHARE.

Le istruzioni SQL delle credenziali restituiscono un errore quando si verifica una mancata corrispondenza del tipo di credenziale

Con questa versione, se il tipo di credenziale specificato in un'istruzione SQL di gestione delle credenziali non corrisponde al tipo dell'argomento delle credenziali, viene restituito un errore e l'istruzione non viene eseguita. Ad esempio, per l'istruzione DROP STORAGE CREDENTIAL 'credential-name', se credential-name non è una credenziale di archiviazione, l'istruzione ha esito negativo con un errore.

Questa modifica viene apportata per evitare errori utente. In precedenza, queste istruzioni venivano eseguite correttamente, anche se è stata passata una credenziale che non corrisponde al tipo di credenziale specificato. Ad esempio, l'istruzione seguente elimina correttamente storage-credential: DROP SERVICE CREDENTIAL storage-credential.

Questa modifica influisce sulle dichiarazioni seguenti:

- DROP CREDENTIAL

- ALTER CREDENTIAL

- DESCRIBE CREDENTIAL

- GRANT… SU... CREDENZIALI

- REVOKE… SU... CREDENZIALI

- SHOW GRANTS SU... CREDENZIALE

Usare la timestampdiff & timestampadd nelle espressioni di colonna generate

Le espressioni delle colonne generate di Delta Lake supportano ora le funzioni timestampdiff e timestampadd.

Supporto per la sintassi della pipeline SQL

Ora puoi comporre pipeline SQL. Una pipeline SQL struttura una query standard, ad esempio SELECT c2 FROM T WHERE c1 = 5, in una sequenza dettagliata, come illustrato nell'esempio seguente:

FROM T

|> SELECT c2

|> WHERE c1 = 5

Per informazioni sulla sintassi supportata per le pipeline SQL, vedere Sintassi delle pipeline SQL.

Per informazioni generali su questa estensione tra settori, vedere SQL presenta problemi. Possiamo correggerli: sintassi pipe in SQL (di Google Research).

Effettuare una richiesta HTTP usando la http_request funzione

Ora puoi creare connessioni HTTP e attraverso di esse effettuare richieste HTTP utilizzando la funzione http_request.

L'aggiornamento a DESCRIBE TABLE restituisce i metadati come JSON strutturato

Ora puoi usare il comando DESCRIBE TABLE AS JSON per restituire i metadati della tabella come documento JSON. L'output JSON è più strutturato del report leggibile predefinito e può essere usato per interpretare lo schema di una tabella a livello di codice. Per altre informazioni, vedere DESCRIBE TABLE AS JSON.

Collazioni insensibili agli spazi finali

Aggiunta del supporto per le collazioni insensibili agli spazi finali. Ad esempio, queste regole di confronto considerano 'Hello' e 'Hello ' come uguali. Per altre informazioni, vedere regole di confronto RTRIM.

Miglioramento dell'elaborazione incrementale dei cloni

Questa versione include una correzione per un caso perimetrale in cui un CLONE incrementale potrebbe copiare nuovamente i file già copiati da una tabella di origine a una tabella di destinazione. Per ulteriori informazioni, vedi Clonare una tabella in Azure Databricks.

Aggiornamenti dell'interfaccia utente

13 febbraio 2025

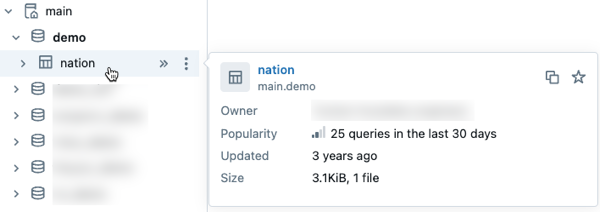

- Anteprima dei metadati del catalogo Unity nell'individuazione dei dati: Visualizzare in anteprima i metadati per gli asset del catalogo Unity passando il puntatore del mouse su un asset nel browser dello schema. Questa funzionalità è disponibile in Catalog Explorer e altre interfacce dove si usa il browser degli schemi, come i dashboard AI/BI e l'editor SQL.

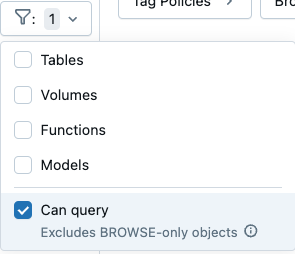

- Filtrare per trovare gli asset di dati su cui è possibile eseguire query: le impostazioni di filtro nel browser dello schema di Esplora cataloghi ora includono una casella di controllo "è possibile eseguire query". Selezionando questa opzione, verranno esclusi gli oggetti che puoi visualizzare ma non interrogare.

Gennaio 2025

Aggiornamenti dell'interfaccia utente

30 gennaio 2025

Grafico conteggio query completato per sql warehouse (anteprima pubblica): Un nuovo grafico Conteggio query completato è ora disponibile nell'interfaccia utente di monitoraggio di SQL Warehouse. Questo grafico mostra il numero di query completate in un intervallo di tempo, incluse le query annullate e non riuscite. Il grafico può essere usato con gli altri grafici e la tabella Cronologia query per valutare e risolvere i problemi relativi alle prestazioni del magazzino. La query è allocata nell'intervallo di tempo in cui viene completata. I conteggi vengono calcolati in media al minuto. Per altre informazioni, vedere Monitorare un magazzino SQL.

Dati espansi visualizzati nei grafici dell'editor SQL: Le visualizzazioni create nell'editor SQL supportano ora fino a 15.000 righe di dati.

Databricks SQL versione 2024.50 è ora disponibile

23 gennaio 2025

Databricks SQL versione 2024.50 è ora disponibile nel canale di anteprima . Esamina la sezione seguente per conoscere le nuove funzionalità, i cambiamenti comportamentali e le correzioni di bug.

Il tipo di dati VARIANT non può più essere usato con operazioni che richiedono confronti

Non è possibile utilizzare le clausole o gli operatori seguenti nelle query che includono un tipo di dati VARIANT:

DISTINCTINTERSECTEXCEPTUNIONDISTRIBUTE BY

Queste operazioni eseguono confronti e confronti che usano il tipo di dati VARIANT producono risultati non definiti e non sono supportati in Databricks. Se si usa il tipo VARIANT nei carichi di lavoro o nelle tabelle di Azure Databricks, Databricks consiglia le modifiche seguenti:

- Aggiornare query ed espressioni per effettuare un cast esplicito dei valori

VARIANTa tipi di dati nonVARIANT. - Se sono presenti campi che devono essere usati con una delle operazioni precedenti, estrarre tali campi dal tipo di dati

VARIANTe archiviarli usando tipi di dati nonVARIANT.

Per ulteriori informazioni, vedere i dati della variante di query .

Supporto per la parametrizzazione della clausola USE CATALOG with IDENTIFIER

La clausola IDENTIFIER è supportata per l'istruzione USE CATALOG. Con questo supporto, è possibile parametrizzare il catalogo corrente in base a una variabile stringa o a un marcatore di parametro.

COMMENT ON COLUMN supporto per tabelle e viste

L'istruzione COMMENT ON supporta la modifica dei commenti per le colonne di visualizzazione e tabella.

Nuove funzioni SQL

Sono disponibili le nuove funzioni SQL predefinite seguenti:

- dayname(expr) restituisce la sigla inglese di tre lettere per il giorno della settimana per la data specificata.

- uniform(expr1, expr2 [,seed]) restituisce un valore casuale con valori indipendenti e distribuiti in modo identico all'interno dell'intervallo di numeri specificato.

-

randstr(length) restituisce una stringa casuale di

lengthcaratteri alfanumerici.

Invocazione di parametri nominati per più funzioni

Le seguenti funzioni supportano l'invocazione con parametri nominati:

I tipi annidati ora accettano correttamente vincoli NULL

Questa versione corregge un bug che interessa alcune colonne di tipi annidati generate da Delta, ad esempio STRUCT. Queste colonne a volte rifiutano in modo non corretto le espressioni in base a vincoli di NULL o NOT NULL di campi annidati. Questo problema è stato risolto.

Aggiornamenti dell'interfaccia utente dell'editor SQL

15 gennaio 2025

Il nuovo editor SQL (anteprima pubblica) include i miglioramenti seguenti dell'interfaccia utente:

- Esperienza di download migliorata: Gli output delle query vengono denominati automaticamente dopo la query quando vengono scaricati.

-

Tasti di scelta rapida per il ridimensionamento dei tipi di carattere: Usare

Alt +eAlt -(Windows/Linux) oOpt +(Opt -macOS) per regolare rapidamente le dimensioni del carattere nell'editor SQL. -

Menzioni utente nei commenti: Contrassegnare utenti specifici con

@nei commenti per inviare notifiche tramite posta elettronica. - Spostamento con schede più veloce: Il passaggio da una scheda all'altra è ora fino a 80%% più veloce per le schede caricate e del 62%% più veloce per le schede scaricate.

- Selezione magazzino semplificata: Le informazioni sulle dimensioni di SQL Warehouse vengono visualizzate direttamente nel selettore di calcolo per semplificare la selezione.

-

Tasti di scelta rapida per la modifica dei parametri: Usare

Ctrl + Enter(Windows/Linux) oCmd + Enter(macOS) per eseguire query durante la modifica dei valori dei parametri. - Controllo della versione avanzato: I risultati delle query vengono mantenuti nella cronologia delle versioni per una migliore collaborazione.

Aggiornamenti della visualizzazione dei grafici

15 gennaio 2025

Il nuovo sistema grafico con prestazioni migliorate, combinazioni di colori migliorate e interattività più veloce è ora disponibile a livello generale. Vedere: Visualizzazioni nei notebook di Databricks e nell'editor SQL e Tipi di visualizzazione nell'editor SQL e nei notebook.