Raccolte e catalogo modelli

Il catalogo modelli nello studio di Azure Machine Learning è l'hub che consente di individuare e usare un'ampia gamma di modelli per la creazione di applicazioni di intelligenza artificiale generativa. Il catalogo modelli include centinaia di modelli di diversi provider, tra cui il servizio Azure OpenAI, Mistral, Meta, Cohere, Nvidia, Hugging Face, nonché alcuni modelli sottoposti a training da Microsoft. I modelli dei provider diversi da Microsoft sono prodotti non Microsoft, come definito nelle Condizioni per i prodotti Microsoft e sono soggetti alle condizioni fornite con il modello.

Raccolte di modelli

Nel catalogo modelli, i modelli sono organizzati in raccolte. Nel catalogo modelli sono disponibili tre tipi di raccolte:

- Modelli curati da Azure per intelligenza artificiale: i più diffusi modelli proprietà e open weight di terze parti disponibili in pacchetto e ottimizzati per un perfetto funzionamento sulla piattaforma di Azure per intelligenza artificiale. L'uso di questi modelli è soggetto alle condizioni di licenza del provider di modelli fornite con il modello. Quando si distribuisce in Azure Machine Learning, la disponibilità del modello è soggetta al contratto di servizio Azure in vigore e Microsoft fornisce il supporto per i problemi di distribuzione. I modelli di partner come Meta, NVIDIA, Mistral AI sono esempi di modelli disponibili nella raccolta "Curato da Azure per intelligenza artificiale" nel catalogo. Questi modelli possono essere identificati da una spunta verde nei riquadri del modello del catalogo oppure è possibile filtrare in base alla raccolta "Curato da Azure per intelligenza artificiale".

- Modelli OpenAI di Azure, disponibili esclusivamente in Azure: modelli del servizio OpenAI di Azure di punta inclusi nella raccolta "OpenAI di Azure" tramite un'integrazione con il servizio OpenAI di Azure. L'uso di questi modelli, supportati da Microsoft, è soggetto alle condizioni del prodotto e al Contratto di servizio per OpenAI di Azure.

- Modelli aperti dell'hub Hugging Face: centinaia di modelli dell'hub HuggingFace sono accessibili tramite la raccolta "Hugging Face" per l'inferenza in tempo reale con gli endpoint online. Hugging Face crea e gestisce i modelli elencati nella raccolta HuggingFace. Usare il forum HuggingFace o il supporto HuggingFace per assistenza. Altre informazioni su come distribuire modelli da Hugging Face.

Suggerimenti di aggiunte al catalogo modelli: è possibile chiedere di aggiungere un modello al catalogo usando questo modulo.

Panoramica delle funzionalità del catalogo modelli

Per informazioni sui modelli OpenAI di Azure, vedere Servizio OpenAI di Azure.

Alcuni modelli delle raccolte Curati da Azure per intelligenza artificiale e Modelli aperti dell'hub Hugging Face possono essere distribuiti con un’opzione di calcolo gestita, mentre altri sono disponibili per la distribuzione tramite API serverless con pagamento in base al consumo. Questi modelli possono essere individuati, confrontati, valutati, ottimizzati (se previsto), distribuiti su larga scala e integrati nelle applicazioni IA generative con sicurezza e governance dei dati di livello aziendale.

- Individuazione: esaminare le schede dei modelli, provare l'inferenza di esempio ed esplorare gli esempi di codice per valutare, ottimizzare o distribuire il modello.

- Confronto: confrontare i benchmark tra i modelli e i set di dati disponibili nel settore per valutare quale sia il più adatto al proprio scenario aziendale.

- Valutazione: valutare se il modello è adatto per il carico di lavoro specifico fornendo dati di test personalizzati. Le metriche di valutazione semplificano la visualizzazione dell'esecuzione del modello selezionato nello scenario.

- Ottimizzazione: personalizzare i modelli ottimizzabili usando i propri dati di training e scegliere il modello migliore confrontando le metriche di tutti i processi di ottimizzazione. Le ottimizzazioni predefinite accelerano la messa a punto e riducono le risorse di memoria e di calcolo necessarie.

- Distribuzione: è possibile distribuire facilmente per inferenza i modelli su cui è stato eseguito un training preliminare o i modelli ottimizzati. I modelli che possono essere distribuiti in un ambiente di calcolo gestito possono anche essere scaricati.

Distribuzione del modello: ambiente di calcolo gestito e API serverless (con pagamento in base al consumo)

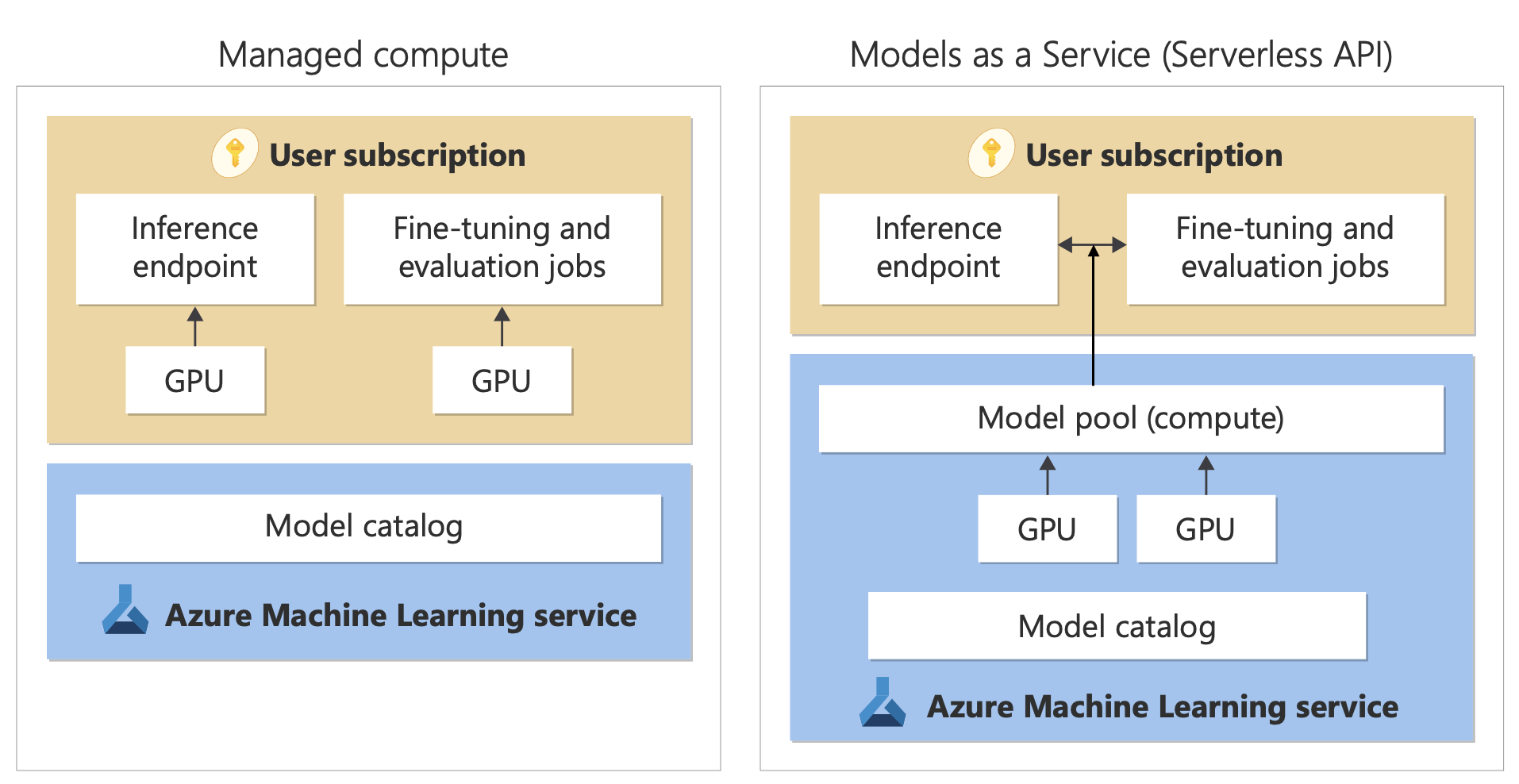

Il Catalogo modelli offre due modi distinti per distribuire modelli dal catalogo per l'uso: le API di calcolo gestite e serverless. Le opzioni di distribuzione disponibili per ogni modello variano. Altre informazioni sulle caratteristiche delle opzioni di distribuzione e sulle opzioni disponibili per modelli specifici sono riportate nelle tabelle seguenti. Altre informazioni sull'elaborazione dati con le opzioni di distribuzione.

| Funzionalità | Calcolo gestito | API serverless (con pagamento in base al consumo) |

|---|---|---|

| Esperienza di distribuzione e fatturazione | I pesi del modello vengono distribuiti in macchine virtuali dedicate con endpoint online gestiti. L'endpoint online gestito, che può avere una o più distribuzioni, rende disponibile un'API REST per l'inferenza. Vengono fatturate le ore core della macchina virtuale usate dalle distribuzioni. | L'accesso ai modelli avviene tramite una distribuzione che effettua il provisioning di un'API per accedere al modello. L'API fornisce l'accesso al modello ospitato in un pool di GPU centrale, gestito da Microsoft, per l'inferenza. Questa modalità di accesso viene definita "Models as a Service". Vengono addebitati input e output alle API, in genere nei token; le informazioni sui prezzi vengono fornite prima della distribuzione. |

| Autenticazione delle API | Chiavi e autenticazione con Microsoft Entra ID. Altre informazioni. | Solo chiavi. |

| Sicurezza dei contenuti | Usare le API del servizio Sicurezza dei contenuti di Azure. | I filtri di Sicurezza dei contenuti di Azure AI sono integrati nelle API di inferenza. I filtri di Sicurezza dei contenuti di Azure AI possono essere fatturati separatamente. |

| Isolamento della rete | Rete virtuale gestita con endpoint online. Altre informazioni. |

Opzioni di distribuzione

| Modello | Calcolo gestito | API serverless (con pagamento in base al consumo) |

|---|---|---|

| Modelli della famiglia Llama | Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-3-8B Llama-3-70B |

Llama-3-70B-Instruct Llama-3-8B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat |

| Modelli della famiglia Mistral | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large Mistral-small |

| Modelli della famiglia Cohere | Non disponibile | Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual |

| JAIS | Non disponibile | jais-30b-chat |

| Modelli della famiglia Phi3 | Phi-3-small-128k-Instruct Phi-3-small-8k-Instruct Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi3-medium-128k-instruct Phi3-medium-4k-instruct |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi3-medium-128k-instruct Phi3-medium-4k-instruct |

| Nixtla | Non disponibile | TimeGEN-1 |

| Altri modelli | Disponibile | Non disponibile |

Calcolo gestito

La possibilità di distribuire modelli nell’ambiente di calcolo gestito è fornita dalle funzionalità della piattaforma Azure Machine Learning che consentono di integrare facilmente, nell'intero ciclo di vita LLMOps, l'ampia gamma di modelli del catalogo.

Come vengono resi disponibili i modelli per il calcolo gestito?

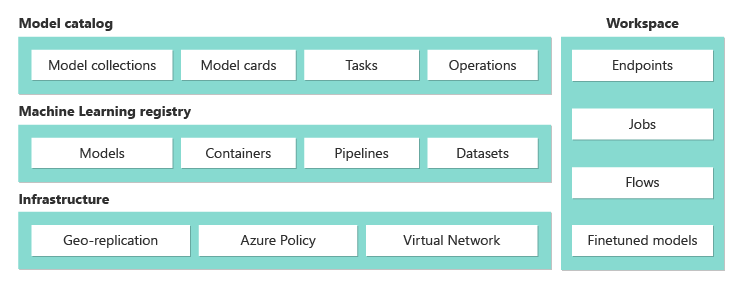

I modelli vengono resi disponibili tramite i registri di Azure Machine Learning, che consentono il primo approccio del Machine Learning all'hosting e alla distribuzione di asset di Machine Learning, ad esempio pesi modello, runtime di contenitori per l'esecuzione dei modelli, pipeline per la valutazione e l'ottimizzazione dei modelli e set di dati per benchmark ed esempi. Questi registri di Machine Learning si basano su un'infrastruttura di livello aziendale altamente scalabile che:

Offre artefatti del modello con accesso a bassa latenza a tutte le aree di Azure con replica geografica predefinita.

Supporta requisiti di sicurezza aziendali come la limitazione dell'accesso ai modelli con Criteri di Azure e la distribuzione sicura con reti virtuali gestite.

Valutare e ottimizzare i modelli distribuiti con un ambiente di calcolo gestito

È possibile valutare e ottimizzare i modelli della raccolta "A cura di Azure per intelligenza artificiale" in Azure Machine Learning usando le pipeline di Azure Machine Learning. È possibile scegliere di usare un codice di valutazione e ottimizzazione personale e limitarsi ad accedere ai pesi del modello oppure usare i componenti di Azure Machine Learning che offrono funzionalità di valutazione e ottimizzazione predefinite. Per altre informazioni, seguire questo collegamento.

Distribuire modelli per l'inferenza con un ambiente di calcolo gestito

I modelli disponibili per la distribuzione nell’ambiente di calcolo gestito possono essere distribuiti in endpoint online di Azure Machine Learning per l'inferenza in tempo reale oppure essere usati per l'inferenza in batch di Azure Machine Learning per l'elaborazione dei dati in batch. La distribuzione in un ambiente di calcolo gestito richiede una quota macchina virtuale nella sottoscrizione di Azure per gli SKU specifici necessari per eseguire il modello in modo ottimale. Alcuni modelli consentono la distribuzione in una quota condivisa temporaneamente per il test del modello. Altre informazioni sulla distribuzione di modelli:

- Distribuire modelli Meta Llama

- Distribuire modelli Open creati da Azure per intelligenza artificiale

- Distribuire modelli Hugging Face

Creare app di IA generativa con calcolo gestito

Il prompt flow offre funzionalità per la creazione di prototipi, l'esecuzione di esperimenti, l'iterazione e la distribuzione di applicazioni di intelligenza artificiale. È possibile usare i modelli distribuiti con il calcolo gestito nel flusso immediato con lo strumento Open Model LLM. È inoltre possibile usare l'API REST esposta dai calcoli gestiti nei più diffusi strumenti LLM, come LangChain, con l'estensione di Azure Machine Learning.

Sicurezza del contenuto per i modelli distribuiti con il calcolo gestito

Il servizio Sicurezza dei contenuti di Azure AI (AACS) può essere usato per i modelli distribuiti in un ambiente di calcolo gestito per filtrare varie categorie di contenuti dannosi (ad esempio contenuti sessualmente espliciti, che incitano alla violenza, all’odio e all’autolesionismo) e minacce avanzate, ad esempio per rilevare il rischio di jailbreak o la presenza di testo appartenente a materiale protetto. È possibile consultare questo notebook per informazioni sull'integrazione con il servizio AACS per Llama 2 oppure usare lo strumento Sicurezza dei contenuti (testo) nel prompt flow per passare risposte dal modello ad AACS per poter essere esaminate. In questo caso, i costi vengono addebitati separatamente in base ai prezzi di AACS.

Usare modelli non presenti nel catalogo modelli

Per i modelli non disponibili nel catalogo modelli, Azure Machine Learning offre una piattaforma aperta ed estendibile in cui è possibile usare i modelli desiderati. È possibile integrare un modello con qualsiasi framework o runtime usando le funzionalità offerte dalla piattaforma aperta ed estendibile di Azure Machine Learning, ad esempio gli ambienti di Azure Machine Learning per i contenitori, in grado di creare pacchetti di framework e runtime, e le pipeline di Azure Machine Learning per il codice, per la valutazione o l'ottimizzazione dei modelli. Fare riferimento a questo notebook per esempi di riferimento su come importare i modelli e usare le pipeline e i runtime predefiniti.

API serverless con fatturazione in base al consumo

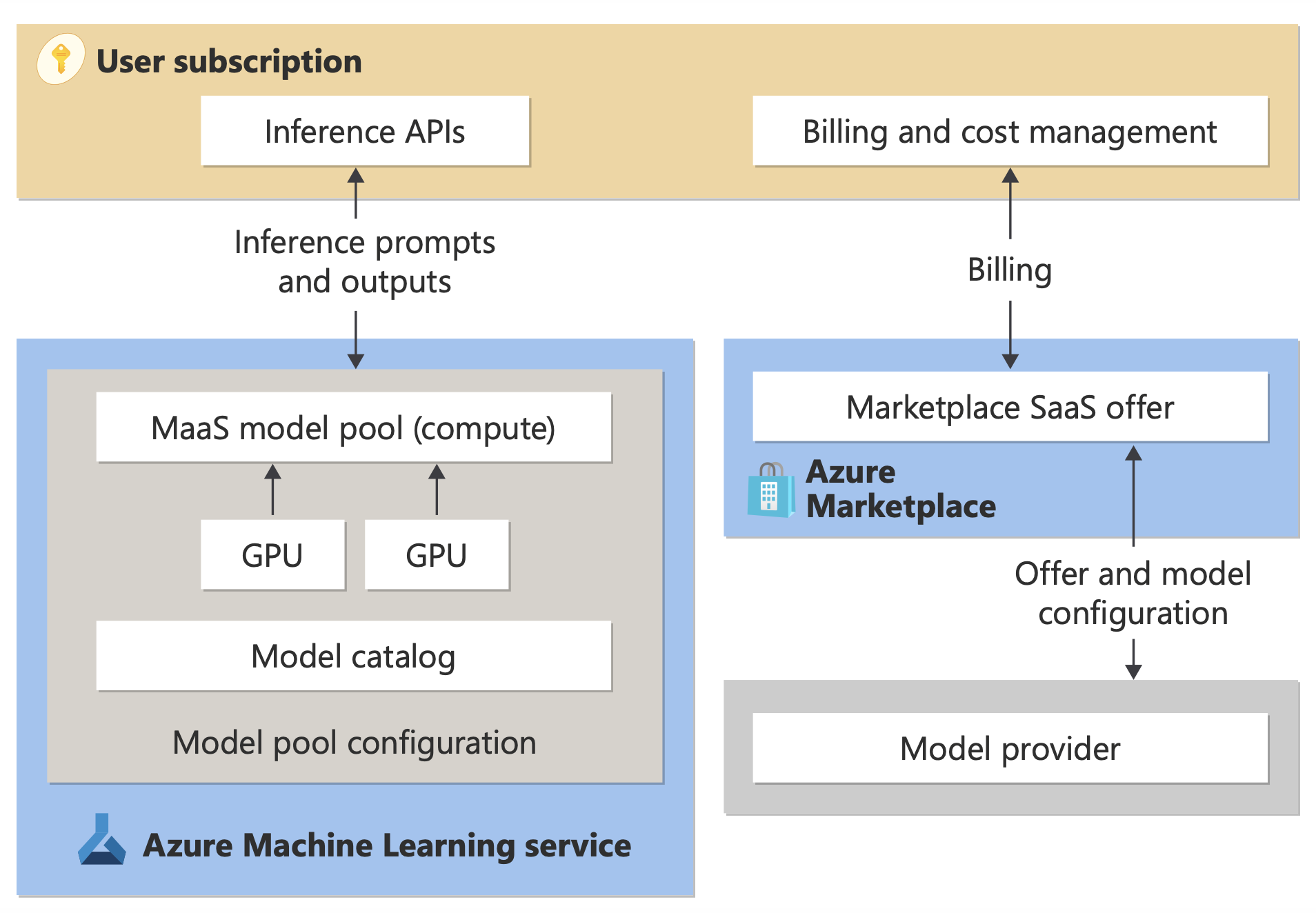

Alcuni modelli del catalogo possono essere distribuiti usando API serverless con fatturazione in base al consumo. Questo metodo di distribuzione viene definito Modelli come servizio (MaaS). I modelli disponibili tramite MaaS sono ospitati nell'infrastruttura gestita da Microsoft, che consente l'accesso basato su API al modello del provider di modelli. L'accesso basato su API può ridurre sensibilmente i costi di accesso a un modello e semplificare notevolmente l'esperienza di provisioning. La maggior parte dei modelli MaaS prevede prezzi basati su token.

In che modo i modelli di terze parti vengono resi disponibili in MaaS?

I modelli disponibili per la distribuzione come API serverless con fatturazione di pagamento in base al consumo sono offerti dal provider di modelli, ma ospitati nell'infrastruttura Azure gestita da Microsoft e accessibili tramite API. I provider di modelli definiscono le condizioni di licenza e impostano il prezzo per l'uso dei modelli, mentre il servizio Azure Machine Learning gestisce l'infrastruttura di hosting, rende disponibili le API di inferenza e svolge la funzione di elaboratore dati per le richieste inviate e i contenuti prodotti dai modelli distribuiti tramite MaaS. Per altre informazioni sull'elaborazione dati per MaaS, vedere l'articolo sulla privacy dei dati.

Pagare per l'utilizzo dei modelli in MaaS

L'esperienza di individuazione, sottoscrizione e utilizzo dei modelli distribuiti tramite MaaS si svolge nello studio AI della piattaforma Azure e nello studio di Azure Machine Learning. Gli utenti accettano le condizioni di licenza per l'uso dei modelli, e le informazioni sui prezzi per l'utilizzo vengono fornite durante la distribuzione. I modelli di provider di terze parti vengono fatturati tramite Azure Marketplace, in base alle Condizioni per l'utilizzo del Marketplace commerciale, mentre i modelli Microsoft vengono fatturati in base ai contatori di Azure come servizi di consumo di prima parte. Come descritto nelle Condizioni per i prodotti, i servizi di consumo di prima parte vengono acquistati usando i contatori di Azure, ma non sono soggetti alle condizioni di servizio di Azure. L'uso di questi modelli è soggetto alle condizioni di licenza fornite.

Distribuire modelli per l'inferenza tramite MaaS

La distribuzione di un modello tramite MaaS consente agli utenti di ottenere l'accesso pronto per l'uso delle API di inferenza senza la necessità di configurare l'infrastruttura o effettuare il provisioning delle GPU, risparmiando tempo e risorse di progettazione. Queste API possono essere integrate con diversi strumenti LLM e l'utilizzo viene addebitato secondo quanto descritto nella sezione precedente.

Ottimizzare i modelli tramite MaaS con pagamento in base al consumo

Per i modelli disponibili tramite MaaS e che supportano l'ottimizzazione, gli utenti possono sfruttare i vantaggi dell'hosted fine-tuning con fatturazione con pagamento in base al consumo per personalizzare i modelli tramite i dati forniti. Per altre informazioni, vedere come ottimizzare un modello Llama 2 nello studio AI della piattaforma Azure.

RAG con modelli distribuiti tramite MaaS

Lo studio AI della piattaforma Azure consente agli utenti di usare gli indici vettoriali e il processo RAG (Retrieval Augmented Generation). I modelli distribuibili tramite API serverless possono essere usati per generare incorporamenti e inferenze in base ai dati personalizzati e generare così risposte specifiche per il caso d'uso. Per altre informazioni, vedere Retrieval Augmented Generation e indici.

Disponibilità di offerte e modelli a livello di area

La distribuzione con pagamento in base al consumo è disponibile solo per gli utenti la cui sottoscrizione di Azure appartiene a un account di fatturazione in un paese in cui il provider di modelli ha reso disponibile l'offerta (vedi "area di disponibilità dell'offerta" nella tabella della sezione successiva). Se l'offerta è disponibile nell'area pertinente, l'utente deve avere un'area di lavoro all'interno dell'area di Azure in cui il modello è disponibile per la distribuzione o l'ottimizzazione, a seconda dei casi (vedere le colonne "Area geografiche delle aree di lavoro" nella tabella seguente).

| Modello | Area di disponibilità dell'offerta | Area di lavoro per la distribuzione | Area di lavoro per l'ottimizzazione |

|---|---|---|---|

| Llama-3-70B-Instruct Llama-3-8B-Instruct |

Paesi gestiti da Microsoft | Stati Uniti orientali 2, Svezia centrale, Stati Uniti centro-settentrionali, Stati Uniti centro-meridionali, Stati Uniti occidentali, Stati Uniti orientali, Stati Uniti occidentali 3 | Non disponibile |

| Llama-2-7b Llama-2-13b Llama-2-70b |

Paesi gestiti da Microsoft | Stati Uniti orientali 2, Stati Uniti orientali, Stati Uniti occidentali 3, Stati uniti occidentali, Stati uniti centro-settentrionali, Stati uniti centro-meridionali | Stati Uniti occidentali 3 |

| Llama-2-7b-chat Llama-2-13b-chat Llama-2-70b-chat |

Paesi gestiti da Microsoft | Stati Uniti orientali 2, Stati Uniti orientali, Stati Uniti occidentali 3, Stati uniti occidentali, Stati uniti centro-settentrionali, Stati uniti centro-meridionali | Non disponibile |

| Mistral Small | Paesi gestiti da Microsoft | Stati Uniti orientali 2, Svezia centrale, Stati Uniti centro-settentrionali, Stati Uniti centro-meridionali, Stati Uniti orientali, Stati Uniti occidentali 3, Stati Uniti occidentali | Non disponibile |

| Mistral-Large | Paesi gestiti da Microsoft Brasile RAS di Hong Kong Israele |

Stati Uniti orientali, Stati Uniti orientali 2, Stati Uniti centro-settentrionali, Stati Uniti centro-meridionali, Svezia centrale, Stati Uniti occidentali, Stati Uniti occidentali 3 | Non disponibile |

| Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual |

Paesi gestiti da Microsoft Giappone |

Stati Uniti orientali 2, Svezia centrale, Stati Uniti centro-settentrionali, Stati Uniti centro-meridionali, Stati Uniti orientali, Stati Uniti occidentali 3, Stati Uniti occidentali | Non disponibile |

| TimeGEN-1 | Paesi gestiti da Microsoft Messico Israele |

Stati Uniti orientali, Stati Uniti orientali 2, Stati Uniti centro-settentrionali, Stati Uniti centro-meridionali, Svezia centrale, Stati Uniti occidentali, Stati Uniti occidentali 3 | Non disponibile |

| jais-30b-chat | Paesi gestiti da Microsoft | Stati Uniti orientali 2, Svezia centrale, Stati Uniti centro-settentrionali, Stati Uniti centro-meridionali, Stati Uniti orientali, Stati Uniti occidentali 3, Stati Uniti occidentali | Non disponibile |

| Phi-3-mini-4k-instruct | Paesi gestiti da Microsoft | Stati Uniti orientali 2, Svezia centrale, Canada centrale, Stati Uniti occidentali 3 | Non disponibile |

| Phi-3-mini-128k-instruct | Paesi gestiti da Microsoft | Stati Uniti orientali 2, Svezia centrale | Non disponibile |

| Phi-3-medium-4k-instruct, Phi-3-medium-128k-instruct | Paesi gestiti da Microsoft | Stati Uniti orientali 2, Svezia centrale | Non disponibile |

Sicurezza dei contenuti per i modelli distribuiti tramite MaaS

Importante

Questa funzionalità è attualmente in anteprima pubblica. Questa versione di anteprima viene fornita senza contratto di servizio, pertanto se ne sconsiglia l’uso per i carichi di lavoro in ambienti di produzione. Alcune funzionalità potrebbero non essere supportate o potrebbero presentare funzionalità limitate.

Per altre informazioni, vedere le Condizioni supplementari per l'uso delle anteprime di Microsoft Azure.

Per i modelli linguistici distribuiti tramite API serverless, Azure per intelligenza artificiale implementa una configurazione predefinita dei filtri di moderazione del testo di Sicurezza dei contenuti di Azure AI che rileva i contenuti dannosi (ad esempio contenuti che incitano all’odio, all’autolesionismo, contenuti sessualmente espliciti e violenti). Per altre informazioni sul filtro dei contenuti (anteprima), vedere Categorie di danni in Sicurezza dei contenuti di Azure AI.

Suggerimento

Il filtro del contenuto (anteprima) non è disponibile per determinati tipi di modello distribuiti tramite API serverless. Questi tipi di modello includono modelli di incorporamento e modelli di serie temporali.

Il filtraggio dei contenuti (anteprima) avviene nel momento stesso in cui i processi del servizio richiedono di generare contenuti e possono essere fatturati separatamente in base ai prezzi AACS previsti per tale utilizzo. È possibile disabilitare il filtro dei contenuti (anteprima) per singoli endpoint serverless quando si distribuisce un modello linguistico per la prima volta o successivamente nella pagina dei dettagli della distribuzione facendo clic sul pulsante di attivazione/disattivazione del filtro dei contenuti.

Si supponga di decidere di usare un'API diversa dall'API di inferenza del modello di Azure per intelligenza artificiale allo scopo di usare un modello distribuito tramite un'API serverless. In una situazione di questo tipo, il filtro dei contenuti (anteprima) non è abilitato a meno che non venga implementato separatamente tramite Sicurezza dei contenuti di Azure AI. Per altre informazioni su come iniziare a usare Sicurezza dei contenuti di Azure AI, vedere Guida introduttiva: Analizzare il contenuto del testo. Se non si usa il filtro dei contenuti (anteprima) per i modelli distribuiti tramite API serverless, si corre un rischio maggiore di esporre gli utenti a contenuti dannosi.

Isolamento rete per i modelli distribuiti tramite API serverless

Gli endpoint per i modelli distribuiti come API serverless seguono l'impostazione del flag di accesso alla rete pubblica (PNA) dell’area di lavoro in cui è presente la distribuzione. Per proteggere l'endpoint MaaS, disabilitare il flag PNA nell'area di lavoro. È possibile proteggere la comunicazione in ingresso da un client all'endpoint usando un endpoint privato per l'area di lavoro.

Per impostare il flag PNA per l'area di lavoro:

- Vai al portale di Azure.

- Cercare Azure Machine Learninge selezionare l'area di lavoro dall'elenco delle aree di lavoro.

- Nella pagina Panoramica usare il riquadro di spostamento a sinistra per passare a Impostazioni>Rete.

- Nella scheda Accesso pubblico è possibile configurare le impostazioni per il flag di accesso alla rete pubblica.

- Salva le modifiche. La propagazione delle modifiche può richiedere fino a cinque minuti.

Limiti

- Se si dispone di un'area di lavoro con un endpoint privato creata prima del 11 luglio 2024, i nuovi endpoint MaaS aggiunti a tale area di lavoro non seguiranno la configurazione di rete. In questo caso, è invece necessario creare un nuovo endpoint privato per l'area di lavoro e creare nuove distribuzioni di API serverless nell’area di lavoro in modo che le nuove distribuzioni possano seguire la configurazione di rete dell’area di lavoro.

- Se si usa un’area di lavoro con distribuzioni MaaS creata prima del 11 luglio 2024 e si abilita un endpoint privato in tale area di lavoro, le distribuzioni MaaS esistenti non seguiranno la configurazione di rete dell’area di lavoro. È necessario creare di nuovo le distribuzioni per consentire alle distribuzioni di API serverless nell’area di lavoro di seguire la configurazione di tale area di lavoro.

- Attualmente il supporto per i dati non è disponibile per le distribuzioni MaaS nelle aree di lavoro private, poiché il flag PNA è disabilitato per le aree di lavoro private.

- La propagazione di qualsiasi modifica della configurazione di rete (ad esempio, l'abilitazione o la disabilitazione del flag PNA) può richiedere fino a cinque minuti.

Altre informazioni

- Informazioni su come usare i modelli di base in Azure Machine Learning per l'ottimizzazione, la valutazione e la distribuzione usando l'interfaccia utente dello studio di Azure Machine Learning o i metodi basati su codice.

- Esplorare il catalogo modelli nello studio di Azure Machine Learning. Per esplorare il catalogo, è necessaria un'area di lavoro di Azure Machine Learning.

- Valutare, ottimizzare e distribuire modelli curati da Azure Machine Learning.

Commenti e suggerimenti

Presto disponibile: Nel corso del 2024 verranno gradualmente disattivati i problemi di GitHub come meccanismo di feedback per il contenuto e ciò verrà sostituito con un nuovo sistema di feedback. Per altre informazioni, vedere https://aka.ms/ContentUserFeedback.

Invia e visualizza il feedback per