Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Importante

Il supporto dello studio di Azure Machine Learning (versione classica) terminerà il 31 agosto 2024. È consigliabile passare ad Azure Machine Learning entro tale data.

A partire dal 1° dicembre 2021 non sarà possibile creare nuove risorse dello studio di Azure Machine Learning (versione classica). Fino al 31 agosto 2024 sarà possibile continuare a usare le risorse dello studio di Azure Machine Learning (versione classica).

- Vedere leinformazioni sullo spostamento di progetti di Machine Learning da ML Studio (versione classica) ad Azure Machine Learning.

- Altre informazioni sulle Azure Machine Learning.

La documentazione relativa allo studio di Machine Learning (versione classica) è in fase di ritiro e potrebbe non essere aggiornata in futuro.

Valuta i risultati di un modello di classificazione o regressione con metriche standard

Categoria: Machine Learning/Evaluate

Nota

Si applica a: solo Machine Learning Studio (versione classica)

I moduli di trascinamento della selezione simili sono disponibili in Azure Machine Learning finestra di progettazione.

Panoramica del modulo

Questo articolo descrive come usare il modulo Evaluate Model in Machine Learning Studio (versione classica) per misurare l'accuratezza di un modello sottoposto a training. Sulla base di un set di dati contenente i punteggi generati da un modello, il modulo Evaluate Model calcola un set di metriche di valutazione standard del settore.

Le metriche restituite da Evaluate Model dipendono dal tipo di modello da valutare:

Per i modelli di raccomandazione, usare il modulo Evaluate Recommender .

Suggerimento

Se non si ha la novità della valutazione del modello, è consigliabile usare questi esempi in Azure AI Gallery, che creano un modello e quindi spiegano come usare le metriche correlate:

- Confrontare i modelli di regressione

- Confrontare classificatori binari

- Confrontare classificatori multiclasse

Ti consigliamo anche la serie di video di Dr. Stephen Elston, come parte del corso di Machine Learning di EdX.

Come usare Evaluate Model

Esistono tre modi per usare il modulo Evaluate Model :There are three ways to use the Evaluate Model module:

- Generare punteggi sui dati di training e valutare il modello in base a questi punteggi

- Generare punteggi nel modello, ma confrontare i punteggi con i punteggi in un set di test riservati

- Confrontare i punteggi per due modelli diversi ma correlati, usando lo stesso set di dati

Usare i dati di training

Per valutare un modello, è necessario connettere un set di dati contenente un set di colonne di input e punteggi. Se non sono disponibili altri dati, è possibile usare il set di dati originale.

- Connessione l'output del datset con punteggio del modello all'input di Evaluate Model.

- Fare clic su Evaluate Model module (Valuta modello ) e selezionare Esegui selezionato per generare i punteggi di valutazione.

Usare i dati di test

Uno scenario comune in Machine Learning consiste nel separare il set di dati originale in set di dati di training e test, usando il modulo Split o il modulo Partition and Sample .

- Connessione l'output del set di dati Con punteggio del modello all'input di Evaluate Model.

- Connessione l'output del modulo Split Data che contiene i dati di test all'input di destra di Evaluate Model.

- Fare clic su Evaluate Model module (Valuta modello ) e selezionare Esegui selezionato per generare i punteggi di valutazione.

Confrontare i punteggi di due modelli

È anche possibile connettere un secondo set di punteggi a Evaluate Model. I punteggi possono essere un set di valutazione condiviso con risultati noti o un set di risultati di un modello diverso per gli stessi dati.

Questa funzione è utile perché è possibile confrontare facilmente i risultati di due modelli diversi sugli stessi dati. In alternativa, è possibile confrontare i punteggi di due esecuzioni diverse sugli stessi dati con parametri diversi.

- Connessione l'output del datset con punteggio del modello all'input di Evaluate Model.

- Connessione l'output del modulo Score Model per il secondo modello all'input di destra di Evaluate Model.

- Fare clic con il pulsante destro del mouse su Valuta modello e scegliere Esegui selezionato per generare i punteggi di valutazione.

Risultati

Dopo aver eseguito Evaluate Model, fare clic con il pulsante destro del mouse sul modulo e scegliere Risultati valutazione per visualizzare i risultati. È possibile:

- Salvare i risultati come set di dati, per semplificare l'analisi con altri strumenti

- Generare una visualizzazione nell'interfaccia di Studio (versione classica)

Se si connettono i set di dati a entrambi gli input di Evaluate Model, i risultati conterranno le metriche per entrambi i set di dati o per entrambi i modelli. Il modello o i dati collegati alla porta sinistra vengono presentati per primi nel report, seguiti dalle metriche per il set di dati o il modello collegato sulla porta destra.

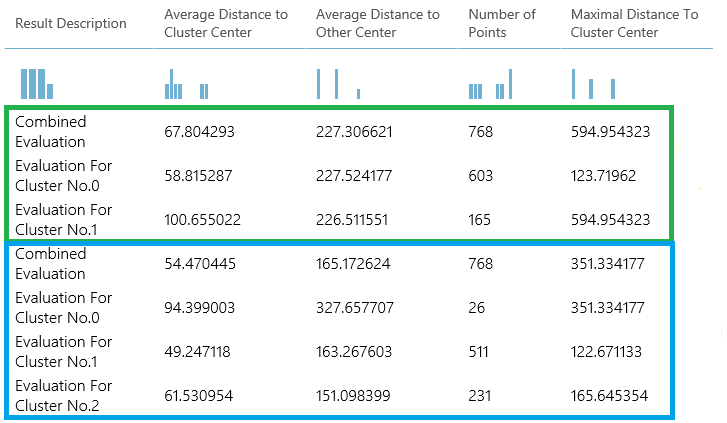

Ad esempio, l'immagine seguente rappresenta un confronto dei risultati di due modelli di clustering basati sugli stessi dati, ma con parametri diversi.

Poiché si tratta di un modello di clustering, i risultati della valutazione sono diversi rispetto ai punteggi di due modelli di regressione oppure a quelli di due modelli di classificazione. Tuttavia, la presentazione complessiva è la stessa.

Metriche

Questa sezione descrive le metriche restituite per i tipi specifici di modelli supportati per l'uso con Evaluate Model:

Metriche per i modelli di classificazione

Per la valutazione dei modelli di classificazione, vengono segnalate le metriche seguenti. Se si confrontano i modelli, questi vengono classificati in base alla metrica selezionata per la valutazione.

Accuratezza: misura la validità di un modello di classificazione come percentuale dei risultati effettivi rispetto al numero totale di casi.

Precisione: rappresenta la percentuale di risultati effettivi rispetto a tutti i risultati positivi.

Richiamo: corrisponde alla percentuale di tutti i risultati corretti restituiti dal modello.

Punteggio F: viene calcolato come media ponderata di precisione e richiamo con un numero compreso tra 0 e 1, dove il valore ideale è 1.

Area sotto la curva: misura l'area sotto la curva tracciata con i veri positivi sull'asse Y e i falsi positivi sull'asse X. Questa metrica è utile perché fornisce un singolo numero che consente di confrontare modelli di tipi diversi.

Perdita logaritmica media: è un singolo punteggio usato per esprimere la penalità per i risultati errati. Viene calcolata come differenza tra due distribuzioni di probabilità: quella vera e quella nel modello.

Perdita logaritmica del training: è un singolo punteggio che rappresenta il vantaggio del classificatore rispetto a una previsione casuale. La perdita logaritmica misura l'incertezza del modello confrontando le probabilità che restituisce con i valori noti (verità) nelle etichette. L'obiettivo è ridurre al minimo la perdita logaritmica per il modello nel suo complesso.

Metriche per i modelli di regressione

Le metriche restituite per i modelli di regressione sono in genere progettate per stimare la quantità di errore. Un modello viene considerato adatto ai dati se la differenza tra i valori osservati e quelli previsti è minima. Tuttavia, l'analisi del modello dei residui (la differenza tra un punto previsto qualunque e il valore effettivo corrispondente) può fornire molte indicazioni sulla potenziale distorsione del modello.

Per la valutazione dei modelli di regressione, vengono segnalate le metriche seguenti. Quando si confrontano i modelli, vengono classificati in base alla metrica selezionata per la valutazione.

La probabilità del log negativo misura la funzione di perdita, un punteggio inferiore è migliore. Si noti che questa metrica viene calcolata solo per la regressione lineare bayesiana e la regressione della foresta decisionale; per altri algoritmi, il valore è

Infinityil che significa nulla.Errore assoluto medio (MAE) : misura la distanza tra le previsioni e i risultati effettivi; pertanto un punteggio più basso è migliore.

Radice dell'errore quadratico medio (RMSE) : crea un singolo valore che riepiloga l'errore nel modello. Grazie alla quadratura della differenza, la metrica ignora la differenza tra previsioni per eccesso e per difetto.

Errore assoluto relativo (RAE) : è la differenza assoluta relativa tra i valori previsti e quelli effettivi; è relativo perché la differenza media viene divisa per la media aritmetica.

Errore quadratico relativo (RSE) : analogamente normalizza l'errore quadratico totale dei valori previsti dividendolo per l'errore quadratico totale dei valori effettivi.

Mean Zero One Error (MZOE) indica se la stima è stata corretta o meno. In altre parole:

ZeroOneLoss(x,y) = 1quandox!=y; in caso contrario0, .Coefficiente di determinazione: spesso definito R2, rappresenta la potenza predittiva del modello come valore compreso tra 0 e 1. Zero indica che il modello è casuale (non spiega niente); 1 indica una soluzione perfetta. Tuttavia, è consigliabile prestare attenzione nell'interpretazione dei valori R2 , perché i valori bassi possono essere del tutto normali e i valori alti possono essere sospetti.

Metriche per i modelli di clustering

Poiché i modelli di clustering sono significativamente diversi dai modelli di classificazione e di regressione per molti aspetti, Evaluate Model restituisce anche un set di statistiche diverso per i modelli di clustering.

Le statistiche restituite per un modello di clustering descrivono il numero di punti dati assegnati a ogni cluster, il grado di separazione tra i cluster e il livello di aggregazione dei punti dati all'interno di ogni cluster.

Le statistiche per il modello di clustering vengono calcolate come media dell'intero set di dati, con righe aggiuntive contenenti le statiche per ogni cluster.

Ad esempio, i risultati seguenti mostrano una parte dei risultati di un esperimento di esempio che raggruppa i dati nel set di dati PIMA Indian Diabetes Binary Classification, disponibile in Machine Learning Studio (versione classica).

| Descrizione dei risultati | Distanza media al Centro cluster | Distanza media verso altri centri | Numero di punti | Massima distanza al centro cluster |

|---|---|---|---|---|

| Valutazione combinata | 55.915068 | 169.897505 | 538 | 303.545166 |

| Valutazione per il cluster No.0 | 0 | 1 | 570 | 0 |

| Valutazione per il cluster No.1 | 0 | 1 | 178 | 0 |

| Valutazione per il cluster No.2 | 0 | 1 | 178 | 0 |

Da questi risultati si ottengono le informazioni seguenti:

Il modulo Sweep Clustering crea più modelli di clustering, elencati in ordine di accuratezza. Per semplicità, abbiamo mostrato solo il modello più classificato qui. I modelli vengono misurati usando tutte le metriche possibili, ma i modelli vengono classificati usando la metrica specificata. Se è stata modificata la metrica, un modello diverso potrebbe essere classificato più alto.

Il punteggio di valutazione combinata nella parte superiore di ogni sezione dei risultati elenca i punteggi medi per i cluster creati in tale particolare modello.

Questo modello classificato in alto è successo per creare tre cluster; altri modelli possono creare due cluster o quattro cluster. Pertanto, questo punteggio di valutazione combinato consente di confrontare i modelli con un numero diverso di cluster.

I punteggi della colonna Average Distance to Cluster Center rappresentano la distanza di tutti i punti di un cluster dal centroide di tale cluster.

I punteggi della colonna Average Distance to Other Center rappresentano la distanza, in media, di ogni punto del cluster dai centroidi di tutti gli altri cluster.

È possibile scegliere una delle quattro metriche per misurare questa distanza, ma tutte le misurazioni devono usare la stessa metrica.

La colonna Number of Points indica il numero di punti dati assegnati a ogni cluster, oltre al numero complessivo totale di punti dati inclusi in qualsiasi cluster.

Se il numero di punti dati assegnati ai cluster è minore del numero totale di punti dati disponibili, significa che a un cluster non è stato possibile assegnare punti dati.

I punteggi nella colonna, Maximal Distance to Cluster Center, rappresentano la somma delle distanze tra ogni punto e il centroid del cluster del punto.

Se questo numero è elevato, può indicare che il cluster è ampiamente distribuito. È necessario esaminare questa statistica insieme alla distanza media al Centro cluster per determinare la diffusione del cluster.

Esempio

Per esempi di come generare, visualizzare e interpretare le metriche di valutazione, vedere questi esperimenti di esempio nella raccolta di intelligenza artificiale di Azure. Questi esperimenti illustrano come compilare più modelli e come usare Evaluate Model per determinare il modello migliore.

Confrontare i classificatori binari: spiega come confrontare le prestazioni di diversi classificatori compilati usando gli stessi dati.

Confrontare i classificatori a più classi: illustra come confrontare l'accuratezza dei diversi modelli di classificazione basati sul set di dati di riconoscimento delle lettere.

Confrontare regressor: illustra il processo di valutazione di modelli di regressione diversi.

Stima della domanda: informazioni su come combinare le metriche di valutazione da più modelli.

Stima delle relazioni dei clienti: illustra come valutare più modelli correlati.

Input previsti

| Nome | Tipo | Descrizione |

|---|---|---|

| Set di dati con punteggio | Tabella dati | Set di dati con punteggio |

| Set di dati con punteggio con cui effettuare il confronto | Tabella dati | Set di dati con punteggio con cui effettuare il confronto (facoltativo) |

Output

| Nome | Tipo | Descrizione |

|---|---|---|

| Valutazione dei risultati | Tabella dati | Risultati della valutazione dei dati |

Eccezioni

| Eccezione | Descrizione |

|---|---|

| Errore 0003 | L'eccezione si verifica se uno o più input sono null o vuoti. |

| Errore 0013 | Si verifica un'eccezione se il tipo dello strumento di apprendimento passato al modulo non è valido. |

| Errore 0020 | L'eccezione si verifica se il numero di colonne in alcuni set di dati passati al modulo è troppo piccolo. |

| Errore 0021 | L'eccezione si verifica se il numero di righe in alcuni set di dati passati al modulo è troppo piccolo. |

| Errore 0024 | L'eccezione si verifica se il set di dati non contiene una colonna etichetta. |

| Errore 0025 | L'eccezione si verifica se il set di dati non contiene una colonna punteggio. |

Vedi anche

Cross-Validate Model

Evaluate Recommender (Valuta modelo di raccomandazione)

Valuta

Score Model (Punteggio modello)