Visione artificiale di Azure

Anche se è possibile eseguire il training di modelli di Machine Learning personalizzati per la visione artificiale, l'architettura per i modelli di visione artificiale può essere complessa; e sono necessari volumi significativi di immagini di training e potenza di calcolo per eseguire il processo di training.

Il servizio Visione artificiale di Azure di Microsoft offre modelli predefiniti e personalizzabili di visione artificiale basati sul modello di base di Firenze e offrono diverse potenti funzionalità. Con Visione artificiale di Azure è possibile creare soluzioni di visione artificiale sofisticate in modo rapido e semplice; sfruttando la funzionalità "off-the-shelf" per molti scenari comuni di visione artificiale, mantenendo al tempo stesso la possibilità di creare modelli personalizzati usando immagini personalizzate.

Risorse di Azure per il servizio Visione artificiale di Azure

Per usare Visione artificiale di Azure, è necessario creare una risorsa nella sottoscrizione di Azure. È possibile usare uno dei tipi di risorse seguenti:

- Visione artificiale di Azure: una risorsa specifica per il servizio Visione artificiale di Azure. Usare questo tipo di risorsa se non si intende usare altri servizi di Intelligenza artificiale di Azure o se si vuole tenere traccia separatamente dell'utilizzo e dei costi per la risorsa di Visione artificiale di Azure.

- i servizi di intelligenza artificiale di Azure: una risorsa generale che include Visione artificiale di Azure insieme a molti altri servizi di intelligenza artificiale di Azure; ad esempio Azure AI Language, Azure AI Custom Vision, Azure AI Translator e altri. Usare questo tipo di risorsa se si prevede di usare più servizi di intelligenza artificiale e si vuole semplificare l'amministrazione e lo sviluppo.

Analisi delle immagini con il servizio Visione artificiale di Azure

Dopo aver creato una risorsa appropriata nella sottoscrizione, è possibile inviare immagini al servizio Visione artificiale di Azure per eseguire un'ampia gamma di attività analitiche.

Visione artificiale di Azure supporta più funzionalità di analisi delle immagini, tra cui:

- Riconoscimento ottico dei caratteri (OCR): estrazione di testo dalle immagini.

- Generazione di didascalie e descrizioni delle immagini.

- Rilevamento di migliaia di oggetti comuni nelle immagini.

- Assegnazione di tag alle funzionalità visive nelle immagini

Queste attività e altro ancora possono essere eseguite in Azure AI Vision Studio.

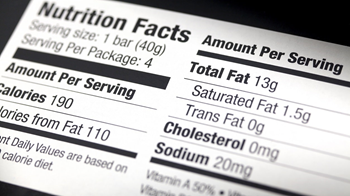

Riconoscimento ottico dei caratteri

Il servizio Visione artificiale di Azure può usare funzionalità di riconoscimento ottico dei caratteri (OCR) per rilevare il testo nelle immagini. Si consideri, ad esempio, l'immagine seguente di un'etichetta nutrizionale su un prodotto in un negozio di alimentari:

Il servizio Visione artificiale di Azure può analizzare questa immagine ed estrarre il testo seguente:

Nutrition Facts Amount Per Serving

Serving size:1 bar (40g)

Serving Per Package: 4

Total Fat 13g

Saturated Fat 1.5g

Amount Per Serving

Trans Fat 0g

calories 190

Cholesterol 0mg

ories from Fat 110

Sodium 20mg

ntDaily Values are based on

Vitamin A 50

calorie diet

Suggerimento

È possibile esplorare ulteriormente le funzionalità OCR di Visione artificiale di Azure nel modulo Leggere testo con Visione artificiale di Azure in Microsoft Learn.

Descrizione di un'immagine con didascalie

Azure AI Vision ha la capacità di analizzare un'immagine, valutare gli oggetti rilevati e generare una frase o una descrizione leggibile che può descrivere ciò che è stato rilevato nell'immagine. Si consideri ad esempio l'immagine seguente:

Visione artificiale di Azure restituisce la didascalia seguente per questa immagine:

Un uomo che salta su uno skateboard

Rilevamento di oggetti comuni in un'immagine

Visione artificiale di Azure può identificare migliaia di oggetti comuni nelle immagini. Ad esempio, quando viene usato per rilevare gli oggetti nell'immagine dello skateboarder descritta in precedenza, Visione artificiale di Azure restituisce le stime seguenti:

- Skateboard (90,40%)

- Persona (95,5%)

Le stime includono un punteggio di attendibilità che indica la probabilità che il modello abbia calcolato per gli oggetti stimati.

Oltre alle etichette degli oggetti rilevate e alle relative probabilità, Visione artificiale di Azure restituisce rettangolo di selezione coordinate che indicano le coordinate superiore, sinistra, larghezza e altezza dell'oggetto rilevato. È possibile usare queste coordinate per determinare dove è stato rilevato ogni oggetto nell'immagine, come illustrato di seguito:

Assegnazione di tag alle funzionalità visive

Visione artificiale di Azure può suggerire tag per un'immagine in base al relativo contenuto. Questi tag possono essere associati all'immagine come metadati che riepiloga gli attributi dell'immagine e possono essere utili se si vuole indicizzare un'immagine insieme a un set di termini chiave che potrebbero essere usati per cercare immagini con attributi o contenuti specifici.

Ad esempio, i tag restituiti per l'immagine dello skateboarder (con punteggi di attendibilità associati) includono:

- sport (99.60%)

- persona (99,56%)

- calzature (98,05%)

- pattinaggio (96,27%)

- boardsport (95,58%)

- attrezzature per skateboarding (94,43%)

- abbigliamento (94.02%)

- muro (93,81%)

- skateboarding (93,78%)

- skateboarder (93.25%)

- sport individuali (92,80%)

- street stunts (90,81%)

- saldo (90,81%)

- salto (89,87%)

- attrezzature sportive (88.61%)

- sport estremo (88,35%)

- kickflip (88,18%)

- stunt (87.27%)

- skateboard (86,87%)

- stuntman (85.83%)

- ginocchio (85,30%)

- sport (85,24%)

- longboard (84.61%)

- longboarding (84.45%)

- di guida (73.37%)

- pattino (67,27%)

- aria (64,83%)

- giovani (63,29%)

- all'aperto (61,39%)

Training di modelli personalizzati

Se i modelli predefiniti forniti da Visione artificiale di Azure non soddisfano le proprie esigenze, è possibile usare il servizio per eseguire il training di un modello personalizzato per la classificazione delle immagini o rilevamento oggetti. Azure AI Vision sviluppa modelli personalizzati sul modello di base preaddestrato, il che significa che è possibile addestrare modelli sofisticati utilizzando relativamente poche immagini di addestramento.

Classificazione delle immagini

Un modello di classificazione delle immagini viene usato per stimare la categoria o classe di un'immagine. Ad esempio, è possibile eseguire il training di un modello per determinare il tipo di frutta visualizzato in un'immagine, come illustrato di seguito:

| Mela | Banana | Arancia / Arancione |

|---|---|---|

|

|

|

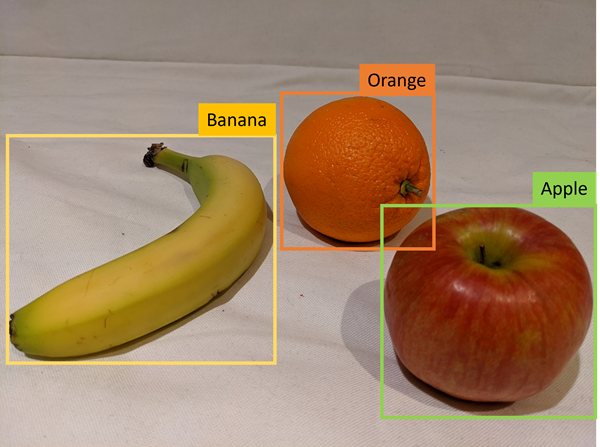

Rilevamento oggetti

I modelli di rilevamento di oggetti rilevano e classificano gli oggetti in un'immagine, restituendo le coordinate del rettangolo di selezione per localizzare ogni oggetto. Oltre alle funzionalità predefinite di rilevamento degli oggetti in Visione artificiale di Azure, è possibile eseguire il training di un modello di rilevamento oggetti personalizzato con le proprie immagini. Ad esempio, è possibile usare fotografie di frutta per eseguire il training di un modello che rileva più frutti in un'immagine, come illustrato di seguito:

Nota

I dettagli su come usare Visione artificiale di Azure per eseguire il training di un modello personalizzato non rientrano nell'ambito di questo modulo. È possibile trovare informazioni sul training di modelli personalizzati nella documentazione di Visione AI di Azure.