Data Lake Storage Gen1 を使用してビッグ データの要件に対応する

Note

Azure Data Lake Storage Gen1 は廃止されました。 廃止のお知らせはこちらを参照してください。リソースData Lake Storage Gen1アクセスできなくなります。 特別なサポートが必要な場合は、 お問い合わせください。

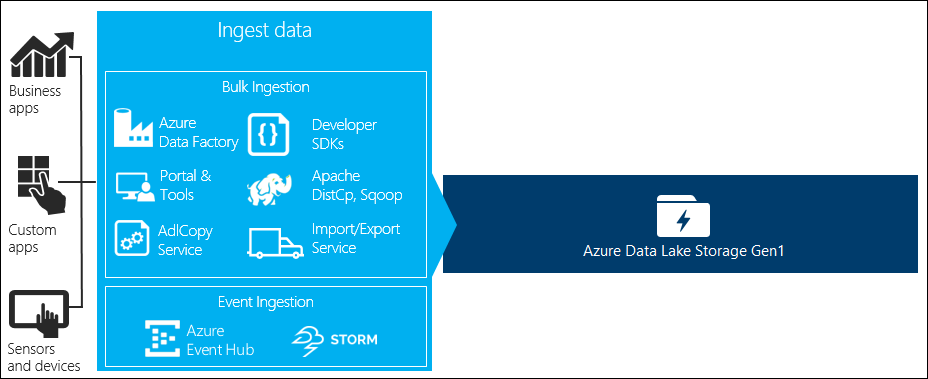

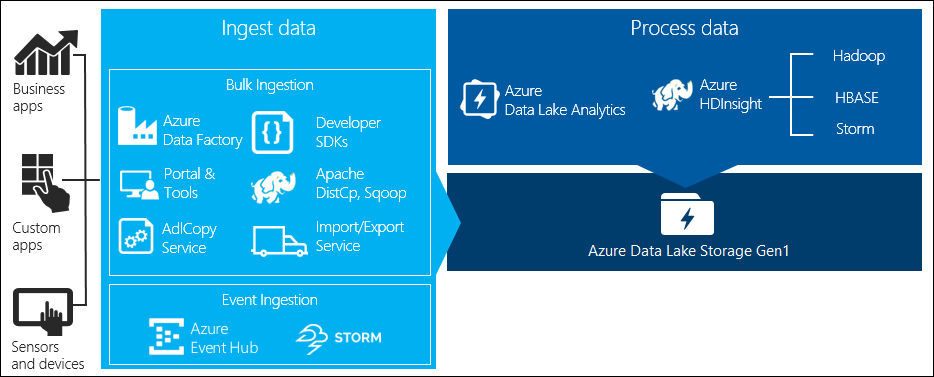

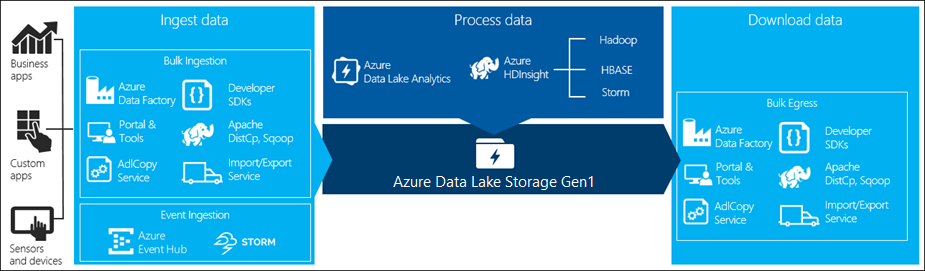

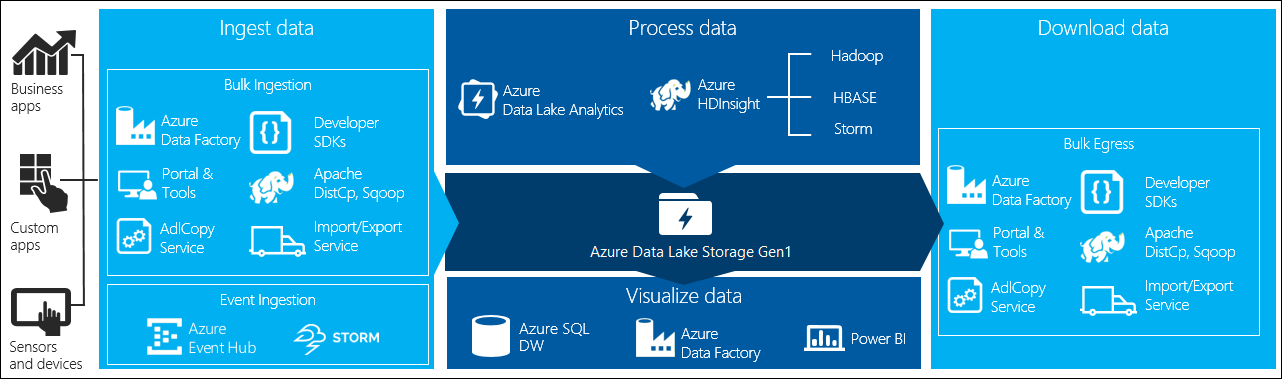

ビッグ データの処理には主に 4 つの段階があります。

- データ ストアへの大量のデータの取り込み (リアルタイムまたは一括)

- データの処理

- データのダウンロード

- データの視覚化

この記事では、Azure Data Lake Storage Gen1 に関してこれらの段階について説明し、お客様のビッグ データのニーズを満たすために使用できるオプションとツールを確認します。

Data Lake Storage Gen1 にデータを取り込む

このセクションでは、さまざまなデータ ソースと、そのデータを Data Lake Storage Gen1 アカウントに取り込む各種方法について説明します。

アドホック データ

これは、ビッグ データ アプリケーションのプロトタイプ作成に使用される小規模なデータ セットを表します。 アドホック データの取り込み方法は、データ ソースに応じてさまざまです。

| Data Source | 取り込みに使用するツール |

|---|---|

| ローカル コンピューター | |

| Azure Storage BLOB |

ストリーミングされたデータ

これは、アプリケーション、デバイス、センサーなどのさまざまなソースによって生成されるデータを表します。Data Lake Storage Gen1 へのこのデータの取り込みには各種ツールを使用できます。 これらのツールでは通常、イベントごとにリアルタイムでデータを取り込み、処理します。その後、さらにデータを処理できるように、Data Lake Storage Gen1 にイベントを一括で書き込みます。

使用できるツールは次のとおりです。

- Azure Stream Analytics。Event Hubs に取り込まれたイベントは、Azure Data Lake Storage Gen1 出力を使用して Azure Data Lake Storage Gen1 に書き込むことができます。

- EventProcessorHost。Event Hubs からイベントを受け取り、Data Lake Storage Gen1 .NET SDK を使用して Data Lake Storage Gen1 に書き込むことができます。

リレーショナル データ

リレーショナル データベースのデータもソースとして扱うことができます。 一定の期間を経て、リレーショナル データベースには大量のデータが収集されます。ビッグ データのパイプラインを介して処理すると、これらのデータから重要な知見が得られます。 このようなデータを Data Lake Storage Gen1 に移動する場合は、次のツールを使用できます。

Web サーバー ログ データ (カスタム アプリケーションを使用したアップロード)

Web サーバー ログ データの分析は、ビッグ データ アプリケーションの一般的な使用例で、大量のログ ファイルを Data Lake Storage Gen1 にアップロードすることを必要とするため、この種類のデータセットが特に呼び出されます。 このようなデータをアップロードするための独自のスクリプトまたはアプリケーションを記述するには、次のツールのいずれかを使用できます。

Web サーバー ログ データをアップロードする場合、または他の種類のデータ (ソーシャル センチメント データなど) をアップロードする場合には、独自のカスタム スクリプトやカスタム アプリケーションを記述することをお勧めします。 これにより、データをアップロードするコンポーネントをより大規模なビッグ データ アプリケーションの一部として含める柔軟性が得られるためです。 このコードは、スクリプトまたは単純なコマンド ライン ユーティリティの形をとる場合もあれば、ビッグ データの処理をビジネス アプリケーションまたはビジネス ソリューションに統合するために使用される場合もあります。

Azure HDInsight クラスターに関連付けられたデータ

ほとんどの種類の HDInsight クラスター (Hadoop、HBase、Storm) では、データ ストレージ リポジトリとして Data Lake Storage Gen1 がサポートされています。 HDInsight クラスターは Azure Storage Blob (WASB) のデータにアクセスします。 パフォーマンスを向上させるために、クラスターに関連付けられた Data Lake Storage Gen1 アカウントに WASB のデータをコピーできます。 データのコピーには次のツールを使用できます。

オンプレミスまたは IaaS Hadoop クラスターに格納されているデータ

大量のデータが既存の Hadoop クラスターの HDFS を使用するコンピューターにローカルに格納されている場合があります。 Hadoop クラスターは、オンプレミスのデプロイ内にある場合も、Azure の IaaS クラスター内にある場合もあります。 このようなデータを 1 回限りまたは定期的に Azure Data Lake Storage Gen1 にコピーする要件が存在します。 これを実現するために、さまざまな方法を使用できます。 以下の表に、それぞれの方法とそのトレードオフを示します。

| アプローチ | 詳細 | 長所 | 考慮事項 |

|---|---|---|---|

| Azure Data Factory (ADF) を使用して Hadoop クラスターから Azure Data Lake Storage Gen1 にデータを直接コピーする。 | ADF ではデータ ソースとして HDFS をサポートしている。 | ADF では、HDFS が最初からサポートされており、ファースト クラスのエンド ツー エンドの管理と監視が提供される。 | Data Management Gateway をオンプレミスまたは IaaS クラスターにデプロイする必要がある。 |

| Hadoop からデータをファイルとしてエクスポートする。 次に、適切なメカニズムを使用してファイルを Azure Data Lake Storage Gen1 にコピーする。 | 次のいずれかを使用してファイルを Azure Data Lake Storage Gen1 にコピーできます。

|

手軽に開始できる。 カスタマイズしたアップロードを行うことができる。 | 複数のテクノロジを含む複数ステップのプロセス。 カスタマイズされたツールという性質上、時間の経過と共に管理と監視が困難になる。 |

| Distcp を使用して、Hadoop から Azure Storage にデータをコピーする。 次に、適切なメカニズムを使用してデータを Azure Storage から Data Lake Storage Gen1 にコピーする。 | 次のいずれかを使用してデータを Azure Storage から Data Lake Storage Gen1 にコピーできます。 | オープン ソースのツールを使用できる。 | 複数のテクノロジを含む複数ステップのプロセス。 |

非常に大規模なデータセット

数 TB に及ぶデータセットをアップロードする場合、上記の方法では速度が遅く、コストがかかることがあります。 このような場合は、次のオプションを使用できます。

Azure ExpressRoute の使用。 Azure ExpressRoute を使用すると、Azure データ センターとお客様のオンプレミスのインフラストラクチャとの間でプライベート接続を作成できます。 これにより、大量のデータを転送するための信頼性の高いオプションが提供されます。 詳細については、 Azure ExpressRoute のドキュメントをご覧ください。

データの "オフライン" アップロード。 何らかの理由で Azure ExpressRoute が使用できない場合は、 Azure Import/Export サービス を利用して、データが格納されたハード ディスク ドライブを Azure データ センターに発送してください。 データはまず Azure Storage BLOB にアップロードされます。 その後、Azure Data Factory または AdlCopy ツールを使って、Azure Storage Blob から Data Lake Storage Gen1 にデータをコピーできます。

Note

Import/Export サービスを利用する場合、Azure データ センターに送るディスク上のファイル サイズは 195 GB 以下である必要があります。

Data Lake Storage Gen1 に格納されているデータを処理する

Data Lake Storage Gen1 でデータが利用できるようになったら、サポートされているビッグ データ アプリケーションを使用して、そのデータの分析を実行できます。 現在、Data Lake Storage Gen1 に格納されたデータに対してデータ分析ジョブを実行する場合は、Azure HDInsight と Azure Data Lake Analytics を使用できます。

次の例を参考にしてください。

- Data Lake Storage Gen1 をストレージとして使用して HDInsight クラスターを作成する

- Data Lake Storage Gen1 で Azure Data Lake Analytics を使用する

Data Lake Storage Gen1 からデータをダウンロードする

次のようなシナリオでは、Azure Data Lake Storage Gen1 からデータをダウンロードしたり、移動したりすることもできます。

- 既存のデータ処理パイプラインとのインターフェイスとなる他のリポジトリにデータを移動する。 たとえば、Data Lake Storage Gen1 から Azure SQL Database または SQL Server にデータを移動できます。

- アプリケーション プロトタイプの作成中に IDE 環境で処理するために、ローカル コンピューターにデータをダウンロードする。

このような場合、次のオプションのいずれかを使用できます。

次の方法を使用して、Data Lake Storage Gen1 からデータをダウンロードするための独自のスクリプトやアプリケーションを記述することもできます。

Data Lake Storage Gen1 のデータを視覚化する

複数のサービスを組み合わせて使用することで、Data Lake Storage Gen1 に格納されたデータを視覚的に表現することができます。

- まず、Azure Data Factory を使用して、Data Lake Storage Gen1 から Azure Synapse Analytics にデータを移動することができます。

- その後、Power BI を Azure Synapse Analytics と統合して、データを視覚的に表現できます。