빠른 시작: Azure Kinect 본문 추적 설정

이 빠른 시작에서는 Azure Kinect DK에서 실행되는 본문 추적을 가져오는 과정을 안내합니다.

시스템 요구 사항

본문 추적 SDK를 사용하려면 NVIDIA GPU가 호스트 PC에 설치되어 있어야 합니다. 권장되는 본문 추적 호스트 PC 요구 사항은 시스템 요구 사항 페이지에 설명되어 있습니다.

소프트웨어 설치

최신 NVIDIA 드라이버 설치

그래픽 카드용 최신 NVIDIA 드라이버를 다운로드하여 설치합니다. 이전 드라이버는 본문 추적 SDK를 사용하여 재배포된 CUDA 이진 파일과 호환되지 않을 수 있습니다.

Visual Studio 2015용 Visual C++ 재배포 가능 패키지

Visual Studio 2015용 Visual C++ 재배포 가능 패키지를 다운로드하여 설치합니다.

하드웨어 설정

Azure Kinect DK 설정

Azure Kinect 뷰어를 시작하여 Azure Kinect DK가 올바르게 설정되었는지 확인합니다.

본문 추적 SDK 다운로드

- 본문 추적 SDK 다운로드에 대한 링크를 선택합니다.

- PC에 본문 추적 SDK를 설치합니다.

본문 추적 확인

Azure Kinect 본문 추적 뷰어를 시작하여 본문 추적 SDK가 올바르게 설정되었는지 확인합니다. 뷰어는 SDK msi 설치 관리자를 사용하여 설치됩니다. 시작 메뉴 또는 <SDK Installation Path>\tools\k4abt_simple_3d_viewer.exe에서 찾을 수 있습니다.

충분한 GPU가 없지만 계속 결과를 테스트하려는 경우 <SDK Installation Path>\tools\k4abt_simple_3d_viewer.exe CPU 명령을 사용하여 Azure Kinect 본문 추적 뷰어 명령줄에서 Azure Kinect 본문 추적 뷰어를 시작할 수 있습니다.

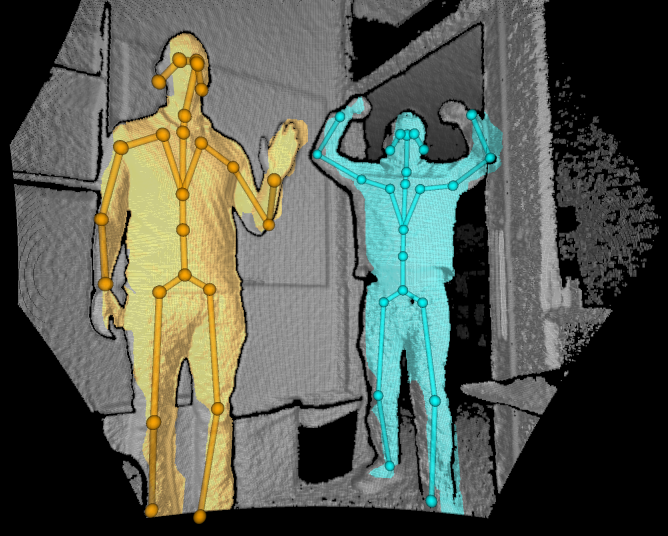

모든 항목이 올바르게 설정되면 3D 지점 클라우드와 추적된 본문이 있는 창이 표시됩니다.

ONNX 런타임 실행 환경 지정

신체 추적 SDK는 CPU, CUDA, DirectML(Windows에만 해당), TensorRT 실행 환경을 지원하여 포즈 예측 모델을 유추합니다. K4ABT_TRACKER_PROCESSING_MODE_GPU는 Linux에서의 CUDA 실행 및 Windows에서의 DirectML 실행에 대한 기본값입니다. 특정 실행 환경을 선택하기 위해 세 가지 모드(K4ABT_TRACKER_PROCESSING_MODE_GPU_CUDA, K4ABT_TRACKER_PROCESSING_MODE_GPU_DIRECTML, K4ABT_TRACKER_PROCESSING_MODE_GPU_TENSORRT)가 더 추가되었습니다.

참고 항목

ONNX 런타임은 가속화되지 않은 opcode에 대한 경고를 표시합니다. 이는 무시해도 괜찮습니다.

ONNX Runtime은 TensorRT 모델 캐싱을 제어하는 환경 변수를 포함합니다. 권장 값은 다음과 같습니다.

- ORT_TENSORRT_ENGINE_CACHE_ENABLE=1

- ORT_TENSORRT_CACHE_PATH="pathname"

신체 추적을 시작하기에 앞서 폴더를 만들어야 합니다.

Important

TensorRT는 유추에 앞서 모델을 미리 처리하여 다른 실행 환경에 비교했을 때 시작 시간이 확장되는 결과가 나옵니다. 엔진 캐싱은 이를 첫 실행으로 제한하지만 실험적이며 특정 모델(ONNX 런타임 버전, TensorRT 버전, GPU 모델)에만 해당됩니다.

TensorRT 실행 환경은 FP32(기본값) 및 FP16을 둘 다 지원합니다. FP16은 최소한의 정확도 감소로 최대 2배까지의 성능 향상을 제공합니다. FP16을 지정하려면:

- ORT_TENSORRT_FP16_ENABLE=1

ONNX 런타임 실행 환경에 필요한 DLL

| 모드 | ORT 1.10 | CUDA 11.4.3 | CUDNN 8.2.2.26 | TensorRT 8.0.3.4 |

|---|---|---|---|---|

| CPU | msvcp140 | - | - | - |

| onnxruntime | ||||

| CUDA | msvcp140 | cudart64_110 | cudnn64_8 | - |

| onnxruntime | cufft64_10 | cudnn_ops_infer64_8 | ||

| onnxruntime_providers_cuda | cublas64_11 | cudnn_cnn_infer64_8 | ||

| onnxruntime_providers_shared | cublasLt64_11 | |||

| DirectML | msvcp140 | - | - | - |

| onnxruntime | ||||

| directml | ||||

| TensorRT | msvcp140 | cudart64_110 | - | nvinfer |

| onnxruntime | cufft64_10 | nvinfer_plugin | ||

| onnxruntime_providers_cuda | cublas64_11 | |||

| onnxruntime_providers_shared | cublasLt64_11 | |||

| onnxruntime_providers_tensorrt | nvrtc64_112_0 | |||

| nvrtc-builtins64_114 |

예제

여기에서 본문 추적 SDK를 사용하는 방법에 대한 예제를 찾을 수 있습니다.