Modelcatalogus en verzamelingen

De modelcatalogus in Azure Machine Learning-studio is de hub om een breed scala aan modellen te ontdekken en te gebruiken waarmee u Generatieve AI-toepassingen kunt bouwen. De modelcatalogus bevat honderden modellen van modelproviders zoals Azure OpenAI-service, Mistral, Meta, Cohere, NVIDIA, Hugging Face, inclusief modellen die zijn getraind door Microsoft. Modellen van andere providers dan Microsoft zijn niet-Microsoft-producten, zoals gedefinieerd in de productvoorwaarden van Microsoft, en onderhevig aan de voorwaarden die bij het model worden geleverd.

Modelverzamelingen

Modellen worden ingedeeld op verzamelingen in de modelcatalogus. Er zijn drie typen verzamelingen in de modelcatalogus:

- Modellen gecureerd door Azure AI: De populairste open modellen van derden en eigen modellen verpakt en geoptimaliseerd om naadloos te werken op het Azure AI-platform. Het gebruik van deze modellen is onderhevig aan de licentievoorwaarden van de modelprovider die bij het model worden geleverd. Wanneer het model wordt geïmplementeerd in Azure Machine Learning, is de beschikbaarheid van het model onderhevig aan de toepasselijke Azure SLA en biedt Microsoft ondersteuning voor implementatieproblemen. Modellen van partners zoals Meta, NVIDIA, Mistral AI zijn voorbeelden van modellen die beschikbaar zijn in de verzameling 'Gecureerd door Azure AI' in de catalogus. Deze modellen kunnen worden geïdentificeerd met een groen vinkje op de modeltegels in de catalogus of u kunt filteren op de verzameling 'Gecureerd door Azure AI'.

- Azure OpenAI-modellen, exclusief beschikbaar in Azure: Flagship Azure OpenAI-modellen via de verzameling 'Azure OpenAI' via een integratie met de Azure OpenAI-service. Deze modellen worden ondersteund door Microsoft en hun gebruik is onderhevig aan de productvoorwaarden en SLA voor de Azure OpenAI Service.

- Open modellen van de Hugging Face-hub: Honderden modellen van de HuggingFace-hub zijn toegankelijk via de verzameling 'Hugging Face' voor realtime deductie met online eindpunten. Met Hugging Face worden modellen gemaakt en onderhouden die worden vermeld in de HuggingFace-verzameling. Gebruik HuggingFace-forum of HuggingFace-ondersteuning voor hulp. Meer informatie over het implementeren van modellen van Hugging Face.

Suggesties voor toevoegingen aan de modelcatalogus: u kunt een aanvraag indienen om een model toe te voegen aan de modelcatalogus met behulp van dit formulier.

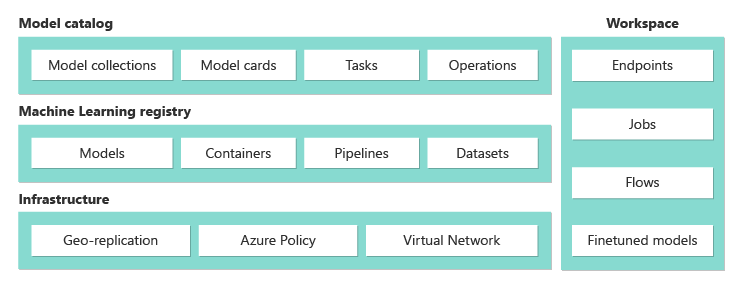

Overzicht van mogelijkheden voor modelcatalogus

Raadpleeg de Azure OpenAI Service voor informatie over Azure OpenAI-modellen.

Voor modellen gecureerd door Azure AI en Open-modellen van de Hugging Face-hub, kunnen sommige hiervan worden geïmplementeerd met een beheerde rekenoptie. Sommige hiervan zijn beschikbaar om te worden geïmplementeerd met behulp van serverloze API's met betalen per gebruik-facturering. Deze modellen kunnen worden gedetecteerd, vergeleken, geëvalueerd, verfijnd (indien ondersteund) en op schaal worden geïmplementeerd en geïntegreerd in uw Generatieve AI-toepassingen met beveiliging en gegevensgovernance op bedrijfsniveau.

- Ontdekken: Bekijk modelkaarten, probeer voorbeelddeductie en blader door codevoorbeelden om het model te evalueren, af te stemmen of te implementeren.

- Vergelijken: Vergelijk benchmarks tussen modellen en gegevenssets die beschikbaar zijn in de branche om te beoordelen welke voldoet aan uw bedrijfsscenario.

- Evalueren: Evalueren of het model geschikt is voor uw specifieke workload door uw eigen testgegevens op te geven. Metrische evaluatiegegevens maken het eenvoudig om te visualiseren hoe goed het geselecteerde model in uw scenario is uitgevoerd.

- Afstellen: Pas verfijnde modellen aan met behulp van uw eigen trainingsgegevens en kies het beste model door metrische gegevens te vergelijken in al uw taken voor het afstemmen van taken. Ingebouwde optimalisaties versnellen het afstemmen en verminderen het geheugen en de rekenkracht die nodig zijn voor het afstemmen.

- Implementeren: Implementeer vooraf getrainde modellen of nauwkeurig afgestemde modellen voor deductie. Modellen die kunnen worden geïmplementeerd voor beheerde berekeningen, kunnen ook worden gedownload.

Modelimplementatie: Beheerde compute en serverloze API (betalen per gebruik)

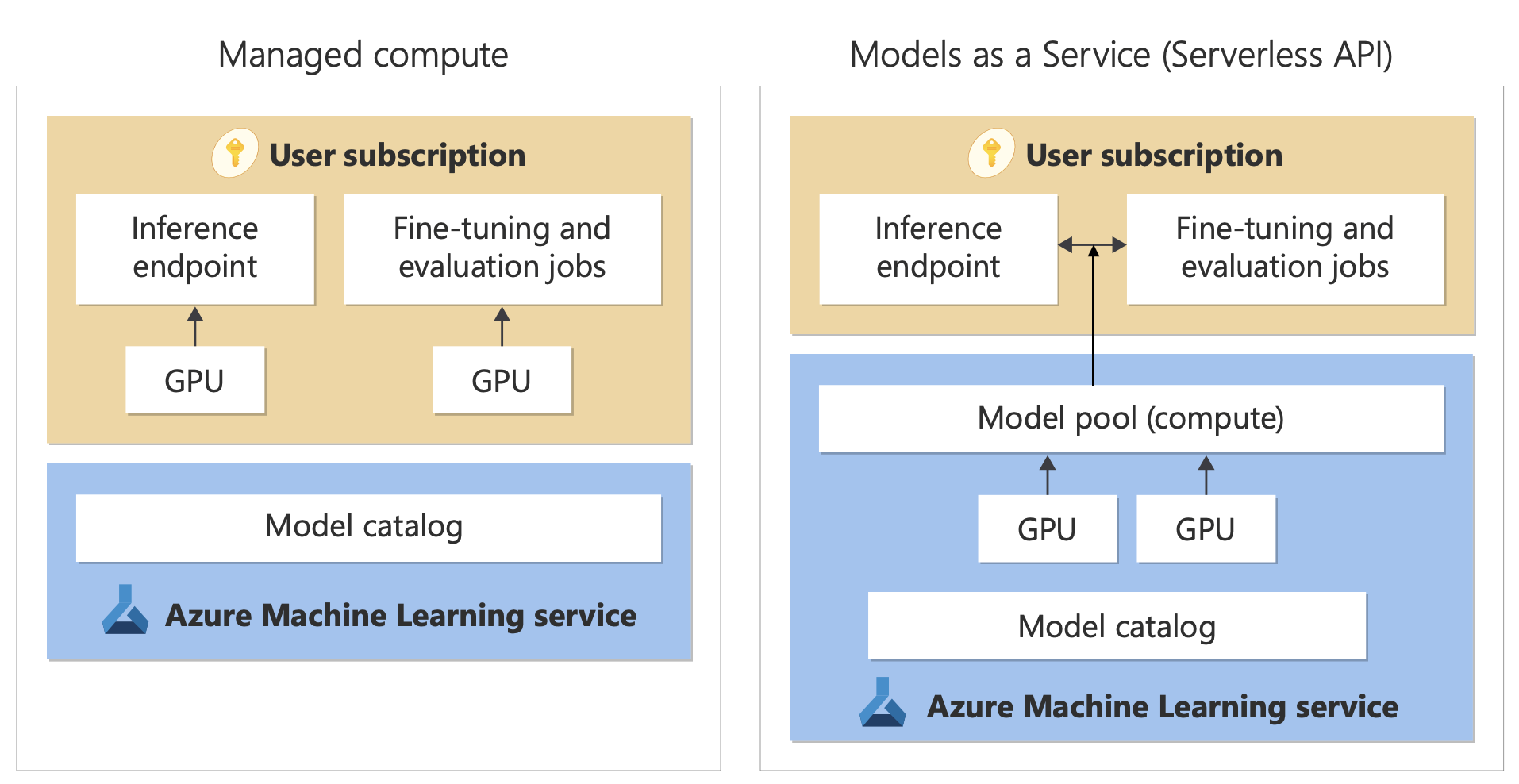

Modelcatalogus biedt twee verschillende manieren om modellen uit de catalogus te implementeren voor uw gebruik: beheerde compute- en serverloze API's. De beschikbare implementatieopties voor elk model variëren; meer informatie over de functies van de implementatieopties en de opties die beschikbaar zijn voor specifieke modellen, vindt u in de onderstaande tabellen. Meer informatie over gegevensverwerking met de implementatieopties.

| Functies | Volledig beheerde rekenprocessen | Serverloze API (betalen per gebruik) |

|---|---|---|

| Implementatie-ervaring en -facturering | Modelgewichten worden geïmplementeerd op toegewezen virtuele machines met beheerde online-eindpunten. Het beheerde online-eindpunt, dat een of meer implementaties kan hebben, maakt een REST API beschikbaar voor deductie. U wordt gefactureerd voor de core-uren van de virtuele machine die door de implementaties worden gebruikt. | Toegang tot modellen is via een implementatie die een API inricht voor toegang tot het model. De API biedt toegang tot het model voor deductie dat wordt gehost in een centrale GPU-pool, beheerd door Microsoft. Deze toegangsmodus wordt 'Modellen als een service' genoemd. U wordt gefactureerd voor invoer en uitvoer voor de API's, meestal in tokens; u krijgt prijsinformatie voordat u implementeert. |

| API-verificatie | Sleutels en verificatie van Microsoft Entra ID. Meer informatie. | Alleen sleutels. |

| Inhoudsveiligheid | API's van de Azure Content Safety-service gebruiken. | Azure AI Content Veiligheid-filters zijn geïntegreerd met deductie-API's. Azure AI Content Veiligheid-filters kunnen afzonderlijk worden gefactureerd. |

| Netwerkisolatie | Beheerd virtueel netwerk met online eindpunten. Meer informatie. |

Implementatieopties

| Modelleren | Volledig beheerde rekenprocessen | Serverloze API (betalen per gebruik) |

|---|---|---|

| Familiemodellen van Llama | Llama-3.3-70B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-3-8B Llama-3-70B |

Llama-3.3-70B-Instruct Llama-3-70B-Instruct Llama-3-8B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat |

| Mistral-familiemodellen | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large (2402) Mistral-large (2407) Mistral-small Ministral-3B Mistral-Nemo |

| Familiemodellen in cohere | Niet beschikbaar | Cohere-command-r-plus-08-2024 Cohere-command-r-08-2024 Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-meertalige Cohere-rerank-v3-english Cohere-rerank-v3-meertalige |

| JAIS | Niet beschikbaar | jais-30b-chat |

| Phi-3-familiemodellen | Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3-vision-128k-Instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-Moe-Instruct |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-Moe-Instruct |

| Nixtla | Niet beschikbaar | TimeGEN-1 |

| Andere modellen | Beschikbaar | Niet beschikbaar |

Volledig beheerde rekenprocessen

De mogelijkheid om modellen met beheerde berekeningen te implementeren, bouwt voort op platformmogelijkheden van Azure Machine Learning om naadloze integratie mogelijk te maken, in de gehele levenscyclus van GenAIOps (ook wel LLMOps genoemd) van de brede verzameling modellen in de modelcatalogus.

Hoe worden modellen beschikbaar gemaakt voor beheerde compute?

De modellen worden beschikbaar gesteld via Azure Machine Learning-registers, dit maakt een ML-gerichte aanpak voor het hosten en distribueren van machine learning-assets mogelijk, zoals modelgewichten, containerruntimes voor het uitvoeren van de modellen, automatiseringen voor het evalueren en verfijnen van de modellen en gegevenssets voor benchmarks en voorbeelden. Deze ML-registers worden gebouwd op een zeer schaalbare en bedrijfsklare infrastructuur die:

Toegangsmodelartefacten met lage latentie biedt voor alle Azure-regio's met ingebouwde geo-replicatie.

Bedrijfsbeveiligingsvereisten ondersteunt voor het beperken van de toegang tot modellen met Azure Policy en veilige implementatie met beheerde virtuele netwerken.

Modellen evalueren en verfijnen die zijn geïmplementeerd met beheerde compute

U kunt de verzameling 'Gecureerd door Azure AI' evalueren en afstemmen in Azure Machine Learning met gebruik van Azure Machine Learning-automatisering. U kunt ervoor kiezen om uw eigen evaluatie- en afstemmingsscode en alleen de gewichten van toegangsmodellen te gebruiken of Azure Machine Learning-onderdelen te gebruiken die ingebouwde evaluatie- en afstemmingsmogelijkheden bieden. Voor meer informatie volg deze koppeling.

Modellen implementeren voor deductie met beheerde rekenkracht

Modellen die beschikbaar zijn voor implementatie met beheerde berekeningen, kunnen worden geïmplementeerd op online Azure Machine Learning-eindpunten voor realtime deductie of kunnen worden gebruikt voor azure Machine Learning-batchdeductie om uw gegevens te verwerken. Voor implementatie in beheerde berekeningen moet u een quotum voor virtuele machines in uw Azure-abonnement hebben voor de specifieke SKU's die nodig zijn om het model optimaal uit te voeren. Met sommige modellen kunt u tijdelijk een gedeeld quotum implementeren voor het testen van het model. Meer informatie over het implementeren van modellen:

- Meta Llama-modellen implementeren

- Open modellen implementeren die zijn gemaakt door Azure AI

- Hugging Face-modellen implementeren

Generatieve AI-apps bouwen met beheerde compute

Promptstroom biedt mogelijkheden voor het maken van prototypen, experimenteren, herhalen en implementeren van uw AI-toepassingen. U kunt modellen gebruiken die zijn geïmplementeerd met beheerde compute in stroomlijning met het hulpprogramma Open Model LLM. U kunt ook de REST API gebruiken die beschikbaar wordt gesteld door de beheerde berekeningen in populaire LLM-hulpprogramma's zoals LangChain met de Azure Machine Learning-extensie.

Inhoudsveiligheid voor modellen die zijn geïmplementeerd met beheerde compute

De AACS-service (Azure AI Content Safety) is beschikbaar voor gebruik met modellen die zijn geïmplementeerd voor beheerde berekeningen voor verschillende categorieën schadelijke inhoud, zoals seksuele inhoud, geweld, haat en zelfbeschadigende en geavanceerde bedreigingen, zoals jailbreakrisicodetectie en detectie van beveiligde materiaalteksten. U kunt dit notebook raadplegen voor referentieintegratie met AACS voor Llama 2 of het hulpprogramma Content Safety (Text) in Prompt Flow gebruiken om reacties van het model door te geven aan AACS voor screening. U wordt afzonderlijk gefactureerd volgens de AACS-prijzen voor dergelijk gebruik.

Werken met modellen die zich niet in de modelcatalogus bevinden

Voor modellen die niet beschikbaar zijn in de modelcatalogus, biedt Azure Machine Learning een open en uitbreidbaar platform voor het werken met modellen van uw keuze. U kunt een model met elk framework of elke runtime gebruiken met behulp van de open en uitbreidbare platformmogelijkheden van Azure Machine Learning, zoals Azure Machine Learning-omgevingen voor containers die frameworks en runtimes en Azure Machine Learning-pijplijnen voor code kunnen verpakken om de modellen te evalueren of af te stemmen. Raadpleeg dit notebook voor voorbeeldverwijzing voor het importeren van modellen en het werken met de ingebouwde runtimes en pijplijnen.

Serverloze API's met betalen per gebruik-facturering

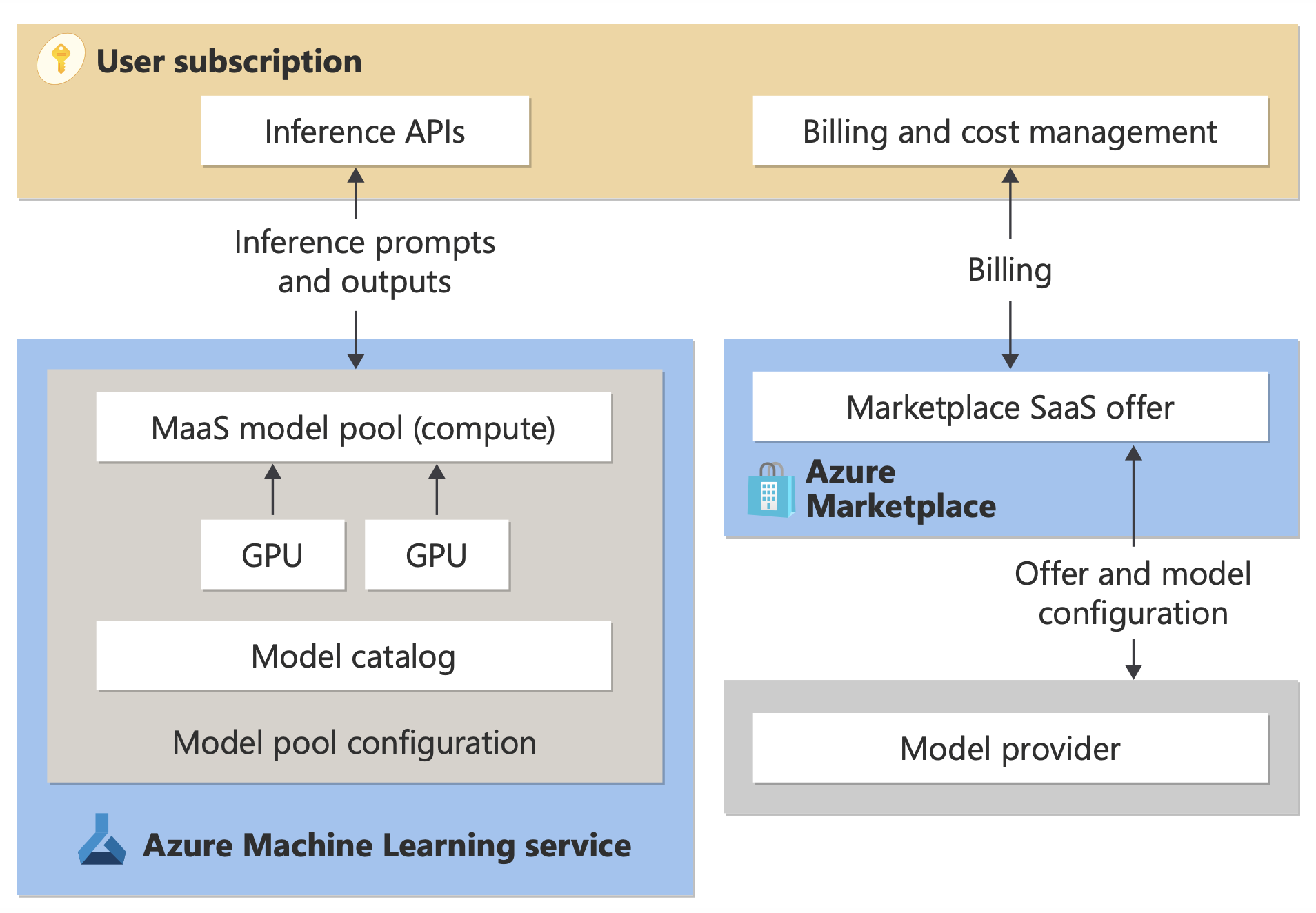

Bepaalde modellen in de modelcatalogus kunnen worden geïmplementeerd als serverloze API's met betalen per gebruik-facturering; deze implementatiemethode wordt Models-as-a Service (MaaS) genoemd. Modellen die beschikbaar zijn via MaaS, worden gehost in infrastructuur die wordt beheerd door Microsoft, waardoor api-gebaseerde toegang tot het model van de modelprovider mogelijk is. Api-toegang kan de kosten voor het openen van een model aanzienlijk verlagen en de inrichtingservaring aanzienlijk vereenvoudigen. De meeste MaaS-modellen worden geleverd met prijzen op basis van tokens.

Hoe worden modellen van derden beschikbaar gesteld in MaaS?

Modellen die beschikbaar zijn voor implementatie als serverloze API's met betalen per gebruik-facturering, worden aangeboden door de modelprovider, maar worden gehost in de door Microsoft beheerde Azure-infrastructuur en zijn toegankelijk via API. Modelproviders definiëren de licentievoorwaarden en stellen de prijs in voor het gebruik van hun modellen, terwijl Azure Machine Learning Service de hostinginfrastructuur beheert, de deductie-API's beschikbaar maakt en fungeert als de gegevensverwerker voor prompts die worden verzonden en inhoudsuitvoer door modellen die zijn geïmplementeerd via MaaS. Meer informatie over gegevensverwerking voor MaaS vindt u in het artikel over gegevensprivacy .

Betalen voor modelgebruik in MaaS

De detectie-, abonnements- en verbruikservaring voor modellen die zijn geïmplementeerd via MaaS, bevindt zich in de Azure AI Foundry-portal en Azure Machine Learning-studio. Gebruikers accepteren licentievoorwaarden voor het gebruik van de modellen en prijsinformatie voor verbruik wordt verstrekt tijdens de implementatie. Modellen van externe providers worden gefactureerd via Azure Marketplace, in overeenstemming met de gebruiksvoorwaarden van de commerciële marketplace. Modellen van Microsoft worden gefactureerd met behulp van Azure-meters als First Party Consumption Services. Zoals beschreven in de productvoorwaarden, worden First Party Consumption Services aangeschaft met behulp van Azure-meters, maar zijn ze niet onderworpen aan azure-servicevoorwaarden. Het gebruik van deze modellen is onderhevig aan de opgegeven licentievoorwaarden.

Modellen implementeren voor deductie via MaaS

Door een model te implementeren via MaaS, kunnen gebruikers toegang krijgen tot het voorbereiden op het gebruik van deductie-API's zonder dat ze de infrastructuur hoeven te configureren of GPU's hoeven in te richten, waardoor technische tijd en resources worden bespaard. Deze API's kunnen worden geïntegreerd met verschillende LLM-hulpprogramma's en het gebruik wordt gefactureerd zoals beschreven in de vorige sectie.

Modellen verfijnen via MaaS met betalen per gebruik

Voor modellen die beschikbaar zijn via MaaS en ondersteuning bieden voor afstemming, kunnen gebruikers profiteren van gehoste afstemming met betalen per gebruik-facturering om de modellen aan te passen aan de hand van gegevens die ze leveren. Zie een Llama 2-model verfijnen in de Azure AI Foundry-portal voor meer informatie.

RAG met modellen die zijn geïmplementeerd via MaaS

Met Azure AI Foundry kunnen gebruikers gebruikmaken van Vector Indexen en Augmented Generation ophalen. Modellen die kunnen worden geïmplementeerd als serverloze API's kunnen worden gebruikt voor het genereren van insluitingen en deductie op basis van aangepaste gegevens om antwoorden te genereren die specifiek zijn voor hun use-case. Zie Uitgebreide generatie en indexen ophalen voor meer informatie.

Regionale beschikbaarheid van aanbiedingen en modellen

PPay-as-you-go-facturering is alleen beschikbaar voor gebruikers van wie het Azure-abonnement deel uitmaakt van een factureringsrekening in een land/regio waar de modelprovider de aanbieding beschikbaar heeft gesteld. Als de aanbieding beschikbaar is in de relevante regio, moet de gebruiker een hub/project hebben in de Azure-regio waar het model beschikbaar is voor implementatie of afstemming, indien van toepassing. Zie Beschikbaarheid van regio's voor modellen in serverloze API-eindpunten voor gedetailleerde informatie.

Content veiligheid voor modellen die zijn geïmplementeerd via MaaS

Belangrijk

Deze functie is momenteel beschikbaar als openbare preview-versie. Deze preview-versie wordt geleverd zonder een service level agreement en we raden deze niet aan voor productieworkloads. Misschien worden bepaalde functies niet ondersteund of zijn de mogelijkheden ervan beperkt.

Zie Aanvullende gebruiksvoorwaarden voor Microsoft Azure-previews voor meer informatie.

Voor taalmodellen die zijn geïmplementeerd via serverloze API's, implementeert Azure AI een standaardconfiguratie van azure AI Content Safety-tekstbeheerfilters die schadelijke inhoud detecteren, zoals haat, zelfschadig, seksueel en gewelddadig inhoud. Zie Categorieën schade in Azure AI Content Safety voor meer informatie over inhoudsfiltering (preview).

Tip

Inhoudsfilters (preview) zijn niet beschikbaar voor bepaalde modeltypen die worden geïmplementeerd via serverloze API's. Deze modeltypen omvatten het insluiten van modellen en tijdreeksmodellen.

Inhoudsfilters (preview) worden synchroon uitgevoerd wanneer de service vraagt om inhoud te genereren. Mogelijk wordt u afzonderlijk gefactureerd op basis van azure AI Content Safety-prijzen voor dergelijk gebruik. U kunt het filteren van inhoud (preview) uitschakelen voor afzonderlijke serverloze eindpunten:

- Op het moment dat u voor het eerst een taalmodel implementeert

- Later selecteert u de wisselknop voor het filteren van inhoud op de pagina met implementatiedetails

Stel dat u besluit een andere API dan de Azure AI-modeldeductie-API te gebruiken om te werken met een model dat is geïmplementeerd via een serverloze API. In een dergelijke situatie is inhoudsfiltering (preview) niet ingeschakeld, tenzij u deze afzonderlijk implementeert met behulp van Azure AI Content Safety.

Zie quickstart: Tekstinhoud analyseren om aan de slag te gaan met Azure AI Content Safety. Als u geen inhoudsfilters (preview) gebruikt bij het werken met modellen die zijn geïmplementeerd via serverloze API's, loopt u een hoger risico om gebruikers bloot te stellen aan schadelijke inhoud.

Netwerkisolatie voor modellen die zijn geïmplementeerd via serverloze API's

Eindpunten voor modellen die zijn geïmplementeerd als serverloze API's, volgen de vlaginstelling voor openbare netwerktoegang (PNA) van de werkruimte waarin de implementatie bestaat. Als u uw MaaS-eindpunt wilt beveiligen, schakelt u de PNA-vlag in uw werkruimte uit. U kunt binnenkomende communicatie van een client naar uw eindpunt beveiligen met behulp van een privé-eindpunt voor de werkruimte.

De PNA-vlag voor de werkruimte instellen:

- Ga naar de Azure Portal.

- Zoek naar Azure Machine Learning en selecteer uw werkruimte in de lijst met werkruimten.

- Gebruik op de pagina Overzicht het linkernavigatiedeelvenster om naar Instellingennetwerken> te gaan.

- Op het tabblad Openbare toegang kunt u instellingen configureren voor de vlag voor openbare netwerktoegang.

- Sla uw wijzigingen op. Het kan vijf minuten duren voordat uw wijzigingen zijn doorgevoerd.

Beperkingen

- Als u een werkruimte hebt met een privé-eindpunt dat vóór 11 juli 2024 is gemaakt, volgen nieuwe MaaS-eindpunten die aan deze werkruimte zijn toegevoegd, niet de netwerkconfiguratie. In plaats daarvan moet u een nieuw privé-eindpunt voor de werkruimte maken en nieuwe serverloze API-implementaties maken in de werkruimte, zodat de nieuwe implementaties de netwerkconfiguratie van de werkruimte kunnen volgen.

- Als u een werkruimte hebt met MaaS-implementaties die vóór 11 juli 2024 zijn gemaakt en u een privé-eindpunt voor deze werkruimte inschakelt, volgen de bestaande MaaS-implementaties de netwerkconfiguratie van de werkruimte niet. Voor serverloze API-implementaties in de werkruimte om de configuratie van de werkruimte te volgen, moet u de implementaties opnieuw maken.

- Momenteel is er geen ondersteuning voor Uw gegevens beschikbaar voor MaaS-implementaties in privéwerkruimten, omdat de PNA-vlag is uitgeschakeld voor privéwerkruimten.

- Het kan vijf minuten duren voordat een netwerkconfiguratiewijziging (bijvoorbeeld het in- of uitschakelen van de PNA-vlag) is doorgevoerd.