Een SAP HANA-uitschaalsysteem met stand-byknooppunt implementeren op Azure-VM's met behulp van Azure NetApp Files in Red Hat Enterprise Linux

In dit artikel wordt beschreven hoe u een maximaal beschikbaar SAP HANA-systeem implementeert in een uitschaalconfiguratie met stand-by op virtuele Azure Red Hat Enterprise Linux-machines (VM's), met behulp van Azure NetApp Files voor de gedeelde opslagvolumes.

In de voorbeeldconfiguraties, installatieopdrachten, enzovoort, is het HANA-exemplaar 03 en is de HANA-systeem-id HN1. De voorbeelden zijn gebaseerd op HANA 2.0 SP4 en Red Hat Enterprise Linux voor SAP 7.6.

Notitie

Dit artikel bevat verwijzingen naar termen die Microsoft niet meer gebruikt. Wanneer deze voorwaarden uit de software worden verwijderd, worden deze uit dit artikel verwijderd.

Raadpleeg de volgende SAP-notities en -documenten voordat u begint:

- Documentatie voor Azure NetApp Files

- SAP Note 1928533 omvat:

- Een lijst met Azure VM-grootten die worden ondersteund voor de implementatie van SAP-software

- Belangrijke capaciteitsinformatie voor Azure VM-grootten

- Ondersteunde SAP-software en besturingssysteemcombinaties (OS) en databasecombinaties

- De vereiste SAP-kernelversie voor Windows en Linux in Microsoft Azure

- SAP-opmerking 2015553: bevat vereisten voor SAP-ondersteunde SAP-software-implementaties in Azure

- SAP-opmerking [2002167] heeft aanbevolen besturingssysteeminstellingen voor Red Hat Enterprise Linux

- SAP Note 2009879 heeft SAP HANA-richtlijnen voor Red Hat Enterprise Linux

- SAP-opmerking 3108302 heeft SAP HANA-richtlijnen voor Red Hat Enterprise Linux 9.x

- SAP-opmerking 2178632: bevat gedetailleerde informatie over alle metrische bewakingsgegevens die zijn gerapporteerd voor SAP in Azure

- SAP-opmerking 2191498: bevat de vereiste VERSIE van de SAP Host Agent voor Linux in Azure

- SAP-opmerking 2243692: bevat informatie over SAP-licenties in Linux in Azure

- SAP-opmerking 1999351: bevat aanvullende informatie over probleemoplossing voor de uitgebreide Azure-bewakingsextensie voor SAP

- SAP-opmerking 1900823: bevat informatie over sap HANA-opslagvereisten

- SAP Community Wiki: bevat alle vereiste SAP-notities voor Linux

- Azure Virtual Machines plannen en implementeren voor SAP in Linux

- Azure Virtual Machines-implementatie voor SAP in Linux

- DBMS-implementatie van Azure Virtual Machines voor SAP in Linux

- Algemene RHEL-documentatie

- Azure-specifieke RHEL-documentatie:

- NFS v4.1-volumes in Azure NetApp Files voor SAP HANA

Overzicht

Een methode voor het bereiken van hoge beschikbaarheid van HANA is door automatische failover van de host te configureren. Als u automatische failover van de host wilt configureren, voegt u een of meer virtuele machines toe aan het HANA-systeem en configureert u deze als stand-byknooppunten. Wanneer het actieve knooppunt mislukt, wordt automatisch een stand-byknooppunt overgenomen. In de gepresenteerde configuratie met virtuele Azure-machines bereikt u automatische failover met behulp van NFS in Azure NetApp Files.

Notitie

Het stand-byknooppunt heeft toegang nodig tot alle databasevolumes. De HANA-volumes moeten worden gekoppeld als NFSv4-volumes. Het verbeterde vergrendelingsmechanisme op basis van bestandslease in het NFSv4-protocol wordt gebruikt voor I/O fencing.

Belangrijk

Als u de ondersteunde configuratie wilt bouwen, moet u de HANA-gegevens en logboekvolumes implementeren als NFSv4.1-volumes en deze koppelen met behulp van het NFSv4.1-protocol. De configuratie voor automatische failover van de HANA-host met stand-byknooppunt wordt niet ondersteund met NFSv3.

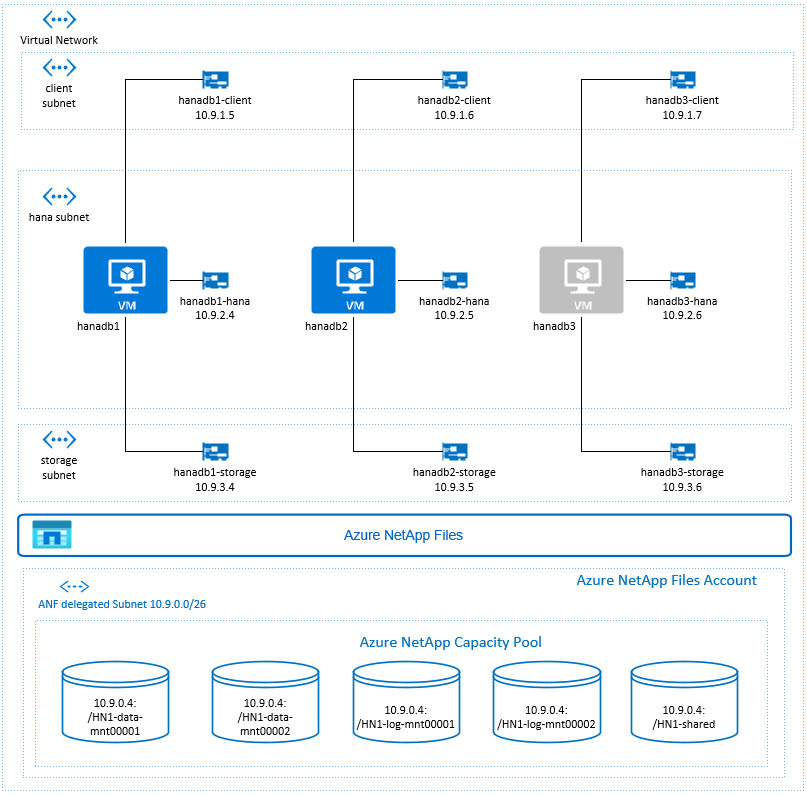

In het voorgaande diagram, dat volgt op aanbevelingen voor SAP HANA-netwerken, worden drie subnetten weergegeven in één virtueel Azure-netwerk:

- Voor clientcommunicatie

- Voor communicatie met het opslagsysteem

- Voor interne communicatie tussen HANA-knooppunten

De Azure NetApp-volumes bevinden zich in een afzonderlijk subnet, gedelegeerd aan Azure NetApp Files.

Voor deze voorbeeldconfiguratie zijn de subnetten:

client10.9.1.0/26storage10.9.3.0/26hana10.9.2.0/26anf10.9.0.0/26 (gedelegeerd subnet naar Azure NetApp Files)

De Azure NetApp Files-infrastructuur instellen

Voordat u verdergaat met de installatie van de Infrastructuur van Azure NetApp Files, moet u vertrouwd raken met de documentatie van Azure NetApp Files.

Azure NetApp Files is beschikbaar in verschillende Azure-regio's. Controleer of uw geselecteerde Azure-regio Azure NetApp Files biedt.

Belangrijke aandachtspunten

Wanneer u uw Azure NetApp Files-volumes voor SAP HANA-uitschaalt met scenario's met stand-by-knooppunten, moet u rekening houden met de belangrijke overwegingen die worden beschreven in NFS v4.1-volumes in Azure NetApp Files voor SAP HANA.

Grootte aanpassen voor HANA-database in Azure NetApp Files

De doorvoer van een Azure NetApp Files-volume is een functie van de volumegrootte en het serviceniveau, zoals beschreven in Serviceniveau voor Azure NetApp Files.

Houd tijdens het ontwerpen van de infrastructuur voor SAP HANA in Azure met Azure NetApp Files rekening met de aanbevelingen in NFS v4.1-volumes in Azure NetApp Files voor SAP HANA.

De configuratie in dit artikel bevat eenvoudige Azure NetApp Files-volumes.

Belangrijk

Voor productiesystemen, waarbij de prestaties een sleutel zijn, raden we u aan om azure NetApp Files-toepassingsvolumegroep voor SAP HANA te evalueren en te gebruiken.

Azure NetApp Files-resources implementeren

In de volgende instructies wordt ervan uitgegaan dat u uw virtuele Azure-netwerk al hebt geïmplementeerd. De Azure NetApp Files-resources en -VM's, waarbij de Azure NetApp Files-resources worden gekoppeld, moeten worden geïmplementeerd in hetzelfde virtuele Azure-netwerk of in gekoppelde virtuele Azure-netwerken.

Maak een NetApp-account in uw geselecteerde Azure-regio door de instructies in Een NetApp-account maken te volgen.

Stel een Azure NetApp Files-capaciteitsgroep in door de instructies te volgen in Een Azure NetApp Files-capaciteitspool instellen.

De HANA-architectuur die in dit artikel wordt gepresenteerd, maakt gebruik van één Azure NetApp Files-capaciteitspool op ultraserviceniveau. Voor HANA-workloads in Azure raden we u aan een Azure NetApp Files Ultra- of Premium-serviceniveau te gebruiken.

Een subnet delegeren naar Azure NetApp Files, zoals beschreven in de instructies in Een subnet delegeren aan Azure NetApp Files.

Implementeer Azure NetApp Files-volumes door de instructies te volgen in Een NFS-volume maken voor Azure NetApp Files.

Wanneer u de volumes implementeert, moet u de versie NFSv4.1 selecteren. Implementeer de volumes in het aangewezen Azure NetApp Files-subnet. De IP-adressen van de Azure NetApp-volumes worden automatisch toegewezen.

Houd er rekening mee dat de Azure NetApp Files-resources en de Azure-VM's zich in hetzelfde virtuele Azure-netwerk of in gekoppelde virtuele Azure-netwerken moeten bevinden. Bijvoorbeeld: HN1-data-mnt00001, HN1-log-mnt00001, enzovoort, zijn de volumenamen en nfs://10.9.0.4/ HN1-data-mnt00001, nfs://10.9.0.4/ HN1-log-mnt00001, enzovoort, de bestandspaden voor de Azure NetApp Files-volumes.

- volume HN1-data-mnt00001 (nfs://10.9.0.4/ HN1-data-mnt00001)

- volume HN1-data-mnt00002 (nfs://10.9.0.4/ HN1-data-mnt00002)

- volume HN1-log-mnt00001 (nfs://10.9.0.4/ HN1-log-mnt00001)

- volume HN1-log-mnt00002 (nfs://10.9.0.4/ HN1-log-mnt00002)

- volume HN1-shared (nfs://10.9.0.4/ HN1-shared)

In dit voorbeeld hebben we een afzonderlijk Azure NetApp Files-volume gebruikt voor elk HANA-gegevens- en logboekvolume. Voor een meer kostengeoptimeerde configuratie op kleinere of niet-productieve systemen is het mogelijk om alle gegevenskoppelingen op één volume te plaatsen en alle logboeken op een ander volume te koppelen.

Virtuele Linux-machines implementeren via Azure Portal

Eerst moet u de Azure NetApp Files-volumes maken. Voer vervolgens de volgende stappen uit:

Maak de subnetten van het virtuele Azure-netwerk in uw virtuele Azure-netwerk.

Implementeer de VM's.

Maak de extra netwerkinterfaces en koppel de netwerkinterfaces aan de bijbehorende VM's.

Elke virtuele machine heeft drie netwerkinterfaces die overeenkomen met de drie subnetten van het virtuele Azure-netwerk (

clientstorageenhana).Zie Een virtuele Linux-machine maken in Azure met meerdere netwerkinterfacekaarten voor meer informatie.

Belangrijk

Voor SAP HANA/workloads is lage latentie essentieel. Werk samen met uw Microsoft-vertegenwoordiger om ervoor te zorgen dat de virtuele machines en Azure NetApp Files-volumes dicht bij elkaar worden geïmplementeerd om een lage latentie te bereiken. Wanneer u een nieuw SAP HANA-systeem onboardt dat gebruikmaakt van SAP HANA Azure NetApp Files, dient u de benodigde gegevens in.

In de volgende instructies wordt ervan uitgegaan dat u de resourcegroep, het virtuele Azure-netwerk en de drie subnetten van het virtuele Azure-netwerk al hebt gemaakt: clienten storage hana. Wanneer u de VM's implementeert, selecteert u het clientsubnet, zodat de clientnetwerkinterface de primaire interface op de VM's is. U moet ook een expliciete route configureren naar het gedelegeerde subnet van Azure NetApp Files via de gateway van het opslagsubnet.

Belangrijk

Zorg ervoor dat het besturingssysteem dat u selecteert SAP-gecertificeerd is voor SAP HANA op de specifieke VM-typen die u gebruikt. Voor een lijst met door SAP HANA gecertificeerde VM-typen en besturingssysteemreleases voor deze typen gaat u naar de site met gecertificeerde IaaS-platformen van SAP HANA. Klik op de details van het vermelde VM-type om de volledige lijst met door SAP HANA ondersteunde besturingssysteemreleases voor dat type op te halen.

Maak een beschikbaarheidsset voor SAP HANA. Zorg ervoor dat u het maximale updatedomein instelt.

Maak drie virtuele machines (hanadb1, hanadb2, hanadb3) door de volgende stappen uit te voeren:

a. Gebruik een Red Hat Enterprise Linux-installatiekopie in de Azure-galerie die wordt ondersteund voor SAP HANA. In dit voorbeeld hebben we een RHEL-SAP-HA 7.6-afbeelding gebruikt.

b. Selecteer de beschikbaarheidsset die u eerder hebt gemaakt voor SAP HANA.

c. Selecteer het subnet van het virtuele Azure-clientnetwerk. Selecteer Versneld netwerk.

Wanneer u de virtuele machines implementeert, wordt de naam van de netwerkinterface automatisch gegenereerd. In deze instructies voor het gemak verwijzen we naar de automatisch gegenereerde netwerkinterfaces die zijn gekoppeld aan het subnet van het virtuele Azure-clientnetwerk, als hanadb1-client, hanadb2-client en hanadb3-client.

Maak drie netwerkinterfaces, één voor elke virtuele machine, voor het subnet van het

storagevirtuele netwerk (in dit voorbeeld hanadb1-storage, hanadb2-storage en hanadb3-storage).Maak drie netwerkinterfaces, één voor elke virtuele machine, voor het subnet van het

hanavirtuele netwerk (in dit voorbeeld hanadb1-hana, hanadb2-hana en hanadb3-hana).Koppel de zojuist gemaakte virtuele netwerkinterfaces aan de bijbehorende virtuele machines door de volgende stappen uit te voeren:

a. Ga naar de virtuele machine in Azure Portal.

b. Selecteer Virtuele machines in het linkerdeelvenster. Filter op de naam van de virtuele machine (bijvoorbeeld hanadb1) en selecteer vervolgens de virtuele machine.

c. Selecteer In het deelvenster Overzicht de optie Stoppen om de toewijzing van de virtuele machine ongedaan te maken.

d. Selecteer Netwerken en koppel vervolgens de netwerkinterface. Selecteer in de vervolgkeuzelijst Netwerkinterface koppelen de reeds gemaakte netwerkinterfaces voor de

storageenhanasubnetten.e. Selecteer Opslaan.

f. Herhaal stap b tot en met e voor de resterende virtuele machines (in ons voorbeeld hanadb2 en hanadb3).

g. Laat de virtuele machines voorlopig gestopt. Vervolgens schakelen we versneld netwerken in voor alle nieuw gekoppelde netwerkinterfaces.

Schakel versneld netwerken in voor de extra netwerkinterfaces voor de

storageenhanasubnetten door de volgende stappen uit te voeren:a. Open Azure Cloud Shell in Azure Portal.

b. Voer de volgende opdrachten uit om versneld netwerken in te schakelen voor de extra netwerkinterfaces die zijn gekoppeld aan de

storageenhanasubnetten.az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb1-storage --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb2-storage --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb3-storage --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb1-hana --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb2-hana --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb3-hana --accelerated-networking trueStart de virtuele machines door de volgende stappen uit te voeren:

a. Selecteer Virtuele machines in het linkerdeelvenster. Filter op de naam van de virtuele machine (bijvoorbeeld hanadb1) en selecteer deze.

b. Selecteer Start in het deelvenster Overzicht.

Configuratie en voorbereiding van het besturingssysteem

De instructies in de volgende secties worden voorafgegaan door een van de volgende opties:

- [A]: Van toepassing op alle knooppunten

- [1]: Alleen van toepassing op knooppunt 1

- [2]: Alleen van toepassing op knooppunt 2

- [3]: Alleen van toepassing op knooppunt 3

Configureer en bereid uw besturingssysteem voor door de volgende stappen uit te voeren:

[A] Onderhoud de hostbestanden op de virtuele machines. Vermeldingen opnemen voor alle subnetten. De volgende vermeldingen zijn toegevoegd aan

/etc/hostsdit voorbeeld.# Storage 10.9.3.4 hanadb1-storage 10.9.3.5 hanadb2-storage 10.9.3.6 hanadb3-storage # Client 10.9.1.5 hanadb1 10.9.1.6 hanadb2 10.9.1.7 hanadb3 # Hana 10.9.2.4 hanadb1-hana 10.9.2.5 hanadb2-hana 10.9.2.6 hanadb3-hana[A] Voeg een netwerkroute toe, zodat de communicatie met Azure NetApp Files via de netwerkinterface van de opslag gaat.

In dit voorbeeld wordt de

Networkmanagerextra netwerkroute geconfigureerd. In de volgende instructies wordt ervan uitgegaan dat de opslagnetwerkinterface iseth1.

Bepaal eerst de verbindingsnaam voor het apparaateth1. In dit voorbeeld isWired connection 1de verbindingsnaam voor het apparaateth1.# Execute as root nmcli connection # Result #NAME UUID TYPE DEVICE #System eth0 5fb06bd0-0bb0-7ffb-45f1-d6edd65f3e03 ethernet eth0 #Wired connection 1 4b0789d1-6146-32eb-83a1-94d61f8d60a7 ethernet eth1Configureer vervolgens extra route naar het gedelegeerde Azure NetApp Files-netwerk via

eth1.# Add the following route # ANFDelegatedSubnet/cidr via StorageSubnetGW dev StorageNetworkInterfaceDevice nmcli connection modify "Wired connection 1" +ipv4.routes "10.9.0.0/26 10.9.3.1"Start de VIRTUELE machine opnieuw op om de wijzigingen te activeren.

[A] Installeer het NFS-clientpakket.

yum install nfs-utils[A] Bereid het besturingssysteem voor op het uitvoeren van SAP HANA in Azure NetApp met NFS, zoals beschreven in SAP-opmerking 3024346 - Linux-kernelinstellingen voor NetApp NFS. Maak configuratiebestand /etc/sysctl.d/91-NetApp-HANA.conf voor de NetApp-configuratie-instellingen.

vi /etc/sysctl.d/91-NetApp-HANA.conf # Add the following entries in the configuration file net.core.rmem_max = 16777216 net.core.wmem_max = 16777216 net.ipv4.tcp_rmem = 4096 131072 16777216 net.ipv4.tcp_wmem = 4096 16384 16777216 net.core.netdev_max_backlog = 300000 net.ipv4.tcp_slow_start_after_idle=0 net.ipv4.tcp_no_metrics_save = 1 net.ipv4.tcp_moderate_rcvbuf = 1 net.ipv4.tcp_window_scaling = 1 net.ipv4.tcp_timestamps = 1 net.ipv4.tcp_sack = 1[A] Maak configuratiebestand /etc/sysctl.d/ms-az.conf met aanvullende optimalisatie-instellingen.

vi /etc/sysctl.d/ms-az.conf # Add the following entries in the configuration file net.ipv6.conf.all.disable_ipv6 = 1 net.ipv4.tcp_max_syn_backlog = 16348 net.ipv4.conf.all.rp_filter = 0 sunrpc.tcp_slot_table_entries = 128 vm.swappiness=10

Tip

Vermijd het instellen van net.ipv4.ip_local_port_range en net.ipv4.ip_local_reserved_ports expliciet in de sysctl-configuratiebestanden, zodat SAP Host Agent de poortbereiken kan beheren. Zie SAP-notitie 2382421 voor meer informatie.

[A] Pas de sunrpc-instellingen aan, zoals aanbevolen in SAP-opmerking 3024346 - Linux-kernelinstellingen voor NetApp NFS.

vi /etc/modprobe.d/sunrpc.conf # Insert the following line options sunrpc tcp_max_slot_table_entries=128[A] Red Hat voor HANA-configuratie.

Configureer RHEL zoals beschreven in SAP Note 2292690, 2455582, 2593824 en Red Hat-notitie 2447641.

Notitie

Als u HANA 2.0 SP04 installeert, moet u het pakket

compat-sap-c++-7installeren zoals beschreven in SAP-opmerking 2593824, voordat u SAP HANA kunt installeren.

De Azure NetApp Files-volumes koppelen

[A] Koppelpunten maken voor de HANA-databasevolumes.

mkdir -p /hana/data/HN1/mnt00001 mkdir -p /hana/data/HN1/mnt00002 mkdir -p /hana/log/HN1/mnt00001 mkdir -p /hana/log/HN1/mnt00002 mkdir -p /hana/shared mkdir -p /usr/sap/HN1[1] Maak knooppuntspecifieke mappen voor /usr/sap op HN1-shared.

# Create a temporary directory to mount HN1-shared mkdir /mnt/tmp # if using NFSv3 for this volume, mount with the following command mount 10.9.0.4:/HN1-shared /mnt/tmp # if using NFSv4.1 for this volume, mount with the following command mount -t nfs -o sec=sys,nfsvers=4.1 10.9.0.4:/HN1-shared /mnt/tmp cd /mnt/tmp mkdir shared usr-sap-hanadb1 usr-sap-hanadb2 usr-sap-hanadb3 # unmount /hana/shared cd umount /mnt/tmp[A] Controleer de NFS-domeininstelling. Zorg ervoor dat het domein is geconfigureerd als het standaarddomein van Azure NetApp Files, d.w.

defaultv4iddomain.comen dat de toewijzing is ingesteld op niemand.Belangrijk

Zorg ervoor dat u het NFS-domein instelt op

/etc/idmapd.confde VIRTUELE machine zodat dit overeenkomt met de standaarddomeinconfiguratie in Azure NetApp Files:defaultv4iddomain.com. Als er een onjuiste overeenkomst is tussen de domeinconfiguratie op de NFS-client (d.w.z. de VM) en de NFS-server, d.w.z. de Azure NetApp-configuratie, worden de machtigingen voor bestanden op Azure NetApp-volumes die zijn gekoppeld op de VM's weergegeven alsnobody.sudo cat /etc/idmapd.conf # Example [General] Domain = defaultv4iddomain.com [Mapping] Nobody-User = nobody Nobody-Group = nobody[A] Controleer

nfs4_disable_idmapping. Deze moet worden ingesteld op Y. Als u de mapstructuur wilt maken waarnfs4_disable_idmappingzich bevindt, voert u de koppelingsopdracht uit. U kunt de map niet handmatig maken onder /sys/modules, omdat toegang is gereserveerd voor de kernel/stuurprogramma's.# Check nfs4_disable_idmapping cat /sys/module/nfs/parameters/nfs4_disable_idmapping # If you need to set nfs4_disable_idmapping to Y mkdir /mnt/tmp mount 10.9.0.4:/HN1-shared /mnt/tmp umount /mnt/tmp echo "Y" > /sys/module/nfs/parameters/nfs4_disable_idmapping # Make the configuration permanent echo "options nfs nfs4_disable_idmapping=Y" >> /etc/modprobe.d/nfs.confZie https://access.redhat.com/solutions/1749883voor meer informatie over het wijzigen

nfs4_disable_idmappingvan de parameter.[A] Koppel de gedeelde Azure NetApp Files-volumes.

sudo vi /etc/fstab # Add the following entries 10.9.0.4:/HN1-data-mnt00001 /hana/data/HN1/mnt00001 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 10.9.0.4:/HN1-data-mnt00002 /hana/data/HN1/mnt00002 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 10.9.0.4:/HN1-log-mnt00001 /hana/log/HN1/mnt00001 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 10.9.0.4:/HN1-log-mnt00002 /hana/log/HN1/mnt00002 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 10.9.0.4:/HN1-shared/shared /hana/shared nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 # Mount all volumes sudo mount -aVoor workloads waarvoor een hogere doorvoer is vereist, kunt u overwegen de

nconnectkoppelingsoptie te gebruiken, zoals beschreven in NFS v4.1-volumes in Azure NetApp Files voor SAP HANA. Controleer ofnconnectdit wordt ondersteund door Azure NetApp Files in uw Linux-release.[1] Koppel de knooppuntspecifieke volumes op hanadb1.

sudo vi /etc/fstab # Add the following entries 10.9.0.4:/HN1-shared/usr-sap-hanadb1 /usr/sap/HN1 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 # Mount the volume sudo mount -a[2] Koppel de knooppuntspecifieke volumes op hanadb2.

sudo vi /etc/fstab # Add the following entries 10.9.0.4:/HN1-shared/usr-sap-hanadb2 /usr/sap/HN1 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 # Mount the volume sudo mount -a[3] Koppel de knooppuntspecifieke volumes op hanadb3.

sudo vi /etc/fstab # Add the following entries 10.9.0.4:/HN1-shared/usr-sap-hanadb3 /usr/sap/HN1 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 # Mount the volume sudo mount -a[A] Controleer of alle HANA-volumes zijn gekoppeld aan NFS-protocolversie NFSv4.

sudo nfsstat -m # Verify that flag vers is set to 4.1 # Example from hanadb1 /hana/data/HN1/mnt00001 from 10.9.0.4:/HN1-data-mnt00001 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /hana/log/HN1/mnt00002 from 10.9.0.4:/HN1-log-mnt00002 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /hana/data/HN1/mnt00002 from 10.9.0.4:/HN1-data-mnt00002 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /hana/log/HN1/mnt00001 from 10.9.0.4:/HN1-log-mnt00001 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /usr/sap/HN1 from 10.9.0.4:/HN1-shared/usr-sap-hanadb1 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /hana/shared from 10.9.0.4:/HN1-shared/shared Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4

Installatie

In dit voorbeeld voor het implementeren van SAP HANA in scale-outconfiguratie met stand-byknooppunt met Azure, hebben we HANA 2.0 SP4 gebruikt.

Voorbereiden op HANA-installatie

[A] Voordat de HANA-installatie wordt uitgevoerd, stelt u het hoofdwachtwoord in. U kunt het hoofdwachtwoord uitschakelen nadat de installatie is voltooid.

rootAls opdrachtpasswduitvoeren.[1] Controleer of u zich via SSH kunt aanmelden bij hanadb2 en hanadb3, zonder dat u om een wachtwoord wordt gevraagd.

ssh root@hanadb2 ssh root@hanadb3[A] Installeer extra pakketten die vereist zijn voor HANA 2.0 SP4. Zie SAP Note 2593824 voor meer informatie.

yum install libgcc_s1 libstdc++6 compat-sap-c++-7 libatomic1[2], [3] Eigendom van SAP HANA

dataenlogmappen wijzigen in hn1adm.# Execute as root sudo chown hn1adm:sapsys /hana/data/HN1 sudo chown hn1adm:sapsys /hana/log/HN1[A] Schakel de firewall tijdelijk uit, zodat deze de HANA-installatie niet verstoort. U kunt deze opnieuw inschakelen nadat de HANA-installatie is voltooid.

# Execute as root systemctl stop firewalld systemctl disable firewalld

HANA-installatie

[1] Installeer SAP HANA door de instructies te volgen in de installatie- en updatehandleiding van SAP HANA 2.0. In dit voorbeeld installeren we SAP HANA scale-out met master, één werkrol en één stand-byknooppunt.

a. Start het hdblcm-programma vanuit de HANA-installatiesoftwaremap. Gebruik de

internal_networkparameter en geef de adresruimte door voor het subnet, dat wordt gebruikt voor de interne communicatie tussen HANA-knooppunten../hdblcm --internal_network=10.9.2.0/26b. Voer bij de prompt de volgende waarden in:

- Voor Kies een actie: voer 1 in (voor installatie)

- Voor aanvullende onderdelen voor installatie: voer 2, 3 in

- Voor het installatiepad: druk op Enter (standaard ingesteld op /hana/gedeeld)

- Voor lokale hostnaam: druk op Enter om de standaardwaarde te accepteren

- Voer onder Wilt u hosts toevoegen aan het systeem?: voer y in

- Voor door komma's gescheiden hostnamen die moeten worden toegevoegd: voer hanadb2, hanadb3 in

- Voor hoofdgebruikersnaam [root]: druk op Enter om de standaardwaarde te accepteren

- Voor rollen voor host hanadb2: voer 1 (voor werkrol) in

- Voor hostfailovergroep voor host hanadb2 [standaard]: druk op Enter om de standaardinstelling te accepteren

- Voor opslagpartitienummer voor host hanadb2 [<<automatisch>> toewijzen]: druk op Enter om de standaardwaarde te accepteren

- Voor werkrolgroep voor host hanadb2 [standaard]: druk op Enter om de standaardinstelling te accepteren

- Voor Selecteer rollen voor host hanadb3: voer 2 in (voor stand-by)

- Voor hostfailovergroep voor host hanadb3 [standaard]: druk op Enter om de standaardinstelling te accepteren

- Voor werkrolgroep voor host hanadb3 [standaard]: druk op Enter om de standaardinstelling te accepteren

- Voor SAP HANA-systeem-id: voer HN1 in

- Bijvoorbeeld nummer [00]: voer 03 in

- Voor lokale hostwerkgroep [standaard]: druk op Enter om de standaardinstelling te accepteren

- Voer voor Systeemgebruik selecteren /Index invoeren [4]: voer 4 in (voor aangepast)

- Voor locatie van gegevensvolumes [/hana/data/HN1]: druk op Enter om de standaardwaarde te accepteren

- Voor locatie van logboekvolumes [/hana/log/HN1]: druk op Enter om de standaardinstelling te accepteren

- Voor Maximale geheugentoewijzing beperken? [n]: voer n in

- Voor de naam van de certificaathost voor Host hanadb1 [hanadb1]: druk op Enter om de standaardwaarde te accepteren

- Voor de naam van de certificaathost voor Host hanadb2 [hanadb2 ]: druk op Enter om de standaardwaarde te accepteren

- Voor certificaathostnaam voor Host hanadb3 [hanadb3 ]: druk op Enter om de standaardwaarde te accepteren

- Voor systeembeheerderswachtwoord (hn1adm): voer het wachtwoord in

- Voer het wachtwoord van de systeemdatabasegebruiker (systeem) in: voer het wachtwoord van het systeem in

- Voer het wachtwoord van systeemdatabasegebruiker (systeem) in als u het wachtwoord van de systeemdatabase (systeemgebruiker) wilt bevestigen: voer het wachtwoord van het systeem in

- Voor systeem opnieuw opstarten nadat de computer opnieuw is opgestart? [n]: voer n in

- For Do you want to continue (y/n): valideer de samenvatting en als alles er goed uitziet, voer y in

[1] Controleer global.ini

Geef global.ini weer en zorg ervoor dat de configuratie voor de interne communicatie tussen SAP HANA-knooppunten aanwezig is. Controleer de communicatiesectie . Deze moet de adresruimte voor het

hanasubnet hebben enlisteninterfacemoet worden ingesteld op.internal. Controleer de sectie internal_hostname_resolution . Het moet de IP-adressen hebben voor de virtuele HANA-machines die deel uitmaken van hethanasubnet.sudo cat /usr/sap/HN1/SYS/global/hdb/custom/config/global.ini # Example #global.ini last modified 2019-09-10 00:12:45.192808 by hdbnameserve [communication] internal_network = 10.9.2.0/26 listeninterface = .internal [internal_hostname_resolution] 10.9.2.4 = hanadb1 10.9.2.5 = hanadb2 10.9.2.6 = hanadb3[1] Voeg hosttoewijzing toe om ervoor te zorgen dat de IP-adressen van de client worden gebruikt voor clientcommunicatie. Voeg sectie

public_host_resolutiontoe en voeg de bijbehorende IP-adressen toe uit het clientsubnet.sudo vi /usr/sap/HN1/SYS/global/hdb/custom/config/global.ini #Add the section [public_hostname_resolution] map_hanadb1 = 10.9.1.5 map_hanadb2 = 10.9.1.6 map_hanadb3 = 10.9.1.7[1] Start SAP HANA opnieuw om de wijzigingen te activeren.

sudo -u hn1adm /usr/sap/hostctrl/exe/sapcontrol -nr 03 -function StopSystem HDB sudo -u hn1adm /usr/sap/hostctrl/exe/sapcontrol -nr 03 -function StartSystem HDB[1] Controleer of de clientinterface gebruikmaakt van de IP-adressen uit het

clientsubnet voor communicatie.# Execute as hn1adm /usr/sap/HN1/HDB03/exe/hdbsql -u SYSTEM -p "password" -i 03 -d SYSTEMDB 'select * from SYS.M_HOST_INFORMATION'|grep net_publicname # Expected result "hanadb3","net_publicname","10.9.1.7" "hanadb2","net_publicname","10.9.1.6" "hanadb1","net_publicname","10.9.1.5"Zie SAP Note 2183363 - Configuratie van intern SAP HANA-netwerk voor informatie over het controleren van de configuratie.

[A] Schakel de firewall opnieuw in.

HANA stoppen

sudo -u hn1adm /usr/sap/hostctrl/exe/sapcontrol -nr 03 -function StopSystem HDBDe firewall opnieuw inschakelen

# Execute as root systemctl start firewalld systemctl enable firewalldOpen de benodigde firewallpoorten

Belangrijk

Maak firewallregels om communicatie tussen HANA-knooppunten en clientverkeer toe te staan. De vereiste poorten worden vermeld op TCP/IP-poorten van alle SAP-producten. De volgende opdrachten zijn slechts een voorbeeld. In dit scenario met het gebruikte systeemnummer 03.

# Execute as root sudo firewall-cmd --zone=public --add-port={30301,30303,30306,30307,30313,30315,30317,30340,30341,30342,1128,1129,40302,40301,40307,40303,40340,50313,50314,30310,30302}/tcp --permanent sudo firewall-cmd --zone=public --add-port={30301,30303,30306,30307,30313,30315,30317,30340,30341,30342,1128,1129,40302,40301,40307,40303,40340,50313,50314,30310,30302}/tcpHANA starten

sudo -u hn1adm /usr/sap/hostctrl/exe/sapcontrol -nr 03 -function StartSystem HDB

Als u SAP HANA wilt optimaliseren voor de onderliggende Azure NetApp Files-opslag, stelt u de volgende SAP HANA-parameters in:

max_parallel_io_requests128async_read_submitopasync_write_submit_activeopasync_write_submit_blocksalle

Zie I/O-stackconfiguratie voor SAP HANA voor meer informatie.

Vanaf SAP HANA 2.0-systemen kunt u de parameters instellen in

global.ini. Zie SAP Note 1999930 voor meer informatie.Voor SAP HANA 1.0-systemen versies SPS12 en eerder kunnen deze parameters worden ingesteld tijdens de installatie, zoals beschreven in SAP Note 2267798.

De opslag die wordt gebruikt door Azure NetApp Files heeft een bestandsgrootte van 16 terabytes (TB). SAP HANA is niet impliciet op de hoogte van de opslagbeperking en er wordt niet automatisch een nieuw gegevensbestand gemaakt wanneer de maximale bestandsgrootte van 16 TB is bereikt. Naarmate SAP HANA het bestand groter probeert te maken dan 16 TB, leidt die poging tot fouten en uiteindelijk tot een crash van de indexserver.

Belangrijk

Stel de volgende parameters in

global.iniom te voorkomen dat SAP HANA gegevensbestanden groter probeert te maken dan de limiet van 16 TB van het opslagsubsysteem.

SAP HANA-failover testen

Simuleer een knooppuntcrash op een SAP HANA-werkknooppunt. Ga als volgt te werk:

a. Voordat u het vastlopen van het knooppunt simuleert, voert u de volgende opdrachten uit als hn1adm om de status van de omgeving vast te leggen:

# Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | yes | ignore | | | 0 | 0 | default | default | master 3 | slave | standby | standby | standby | standby | default | - | # Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREENb. Als u een knooppuntcrash wilt simuleren, voert u de volgende opdracht uit als root op het werkknooppunt. Dit is in dit geval hanadb2 :

echo b > /proc/sysrq-triggerc. Bewaak het systeem voor failovervoltooiing. Wanneer de failover is voltooid, legt u de status vast, die er als volgt uit moet zien:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GRAY hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | no | info | | | 2 | 0 | default | default | master 2 | slave | worker | standby | worker | standby | default | - | | hanadb3 | yes | info | | | 0 | 2 | default | default | master 3 | slave | standby | slave | standby | worker | default | default |Belangrijk

Wanneer een knooppunt kernel paniek ondervindt, voorkomt u vertragingen met SAP HANA-failover door deze in te stellen

kernel.panicop 20 seconden op alle virtuele HANA-machines. De configuratie wordt uitgevoerd in/etc/sysctl. Start de virtuele machines opnieuw op om de wijziging te activeren. Als deze wijziging niet wordt uitgevoerd, kan failover tien of meer minuten duren wanneer een knooppunt kernel paniek ondervindt.Dood de naamserver door het volgende te doen:

a. Controleer vóór de test de status van de omgeving door de volgende opdrachten uit te voeren als hn1adm:

#Landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | yes | ignore | | | 0 | 0 | default | default | master 3 | slave | standby | standby | standby | standby | default | - | # Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREENb. Voer de volgende opdrachten uit als hn1adm op het actieve hoofdknooppunt. Dit is in dit geval hanadb1 :

hn1adm@hanadb1:/usr/sap/HN1/HDB03> HDB killHet stand-byknooppunt hanadb3 neemt over als hoofdknooppunt. Dit is de resourcestatus nadat de failovertest is voltooid:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GRAY # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | no | info | | | 1 | 0 | default | default | master 1 | slave | worker | standby | worker | standby | default | - | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | yes | info | | | 0 | 1 | default | default | master 3 | master | standby | master | standby | worker | default | default |c. Start het HANA-exemplaar opnieuw op hanadb1 (dat wil gezegd, op dezelfde virtuele machine, waar de naamserver is gedood). Het hanadb1-knooppunt wordt opnieuw aan de omgeving toegewezen en behoudt de stand-byrol.

hn1adm@hanadb1:/usr/sap/HN1/HDB03> HDB startNadat SAP HANA is gestart op hanadb1, verwacht u de volgende status:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | no | info | | | 1 | 0 | default | default | master 1 | slave | worker | standby | worker | standby | default | - | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | yes | info | | | 0 | 1 | default | default | master 3 | master | standby | master | standby | worker | default | default |d. Sluit opnieuw de naamserver op het momenteel actieve hoofdknooppunt (dat wil gezegd, op knooppunt hanadb3).

hn1adm@hanadb3:/usr/sap/HN1/HDB03> HDB killNode hanadb1 hervat de rol van hoofdknooppunt. Nadat de failovertest is voltooid, ziet de status er als volgt uit:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GRAY hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | no | ignore | | | 0 | 0 | default | default | master 3 | slave | standby | standby | standby | standby | default | - |e. Start SAP HANA op hanadb3, dat klaar is om te fungeren als een stand-byknooppunt.

hn1adm@hanadb3:/usr/sap/HN1/HDB03> HDB startNadat SAP HANA is gestart op hanadb3, ziet de status er als volgt uit:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList & python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | no | ignore | | | 0 | 0 | default | default | master 3 | slave | standby | standby | standby | standby | default | - |

Volgende stappen

- Azure Virtual Machines plannen en implementeren voor SAP

- Azure Virtual Machines-implementatie voor SAP

- DBMS-implementatie van Azure Virtual Machines voor SAP

- NFS v4.1-volumes in Azure NetApp Files voor SAP HANA

- Zie Hoge beschikbaarheid van SAP HANA op virtuele Azure-machines (VM's) voor meer informatie over het tot stand brengen van hoge beschikbaarheid en het plannen van herstel na noodgevallen van SAP HANA op Virtuele Machines in Azure.