Notitie

Voor toegang tot deze pagina is autorisatie vereist. U kunt proberen u aan te melden of de directory te wijzigen.

Voor toegang tot deze pagina is autorisatie vereist. U kunt proberen de mappen te wijzigen.

In deze zelfstudies wordt een volledig end-to-end scenario gepresenteerd binnen de data science-ervaring van Fabric. Ze behandelen elke stap, van

- Gegevensopname

- Gegevens opschonen

- Gegevensvoorbereiding

naar

- Machine learning modeltraining

- Inzicht genereren

en vervolgens het verbruik van deze inzichten met visualisatiehulpprogramma's behandelen, bijvoorbeeld Power BI.

Personen die nieuw zijn bij Microsoft Fabric, moeten naar Wat is Microsoft Fabric? gaan.

Introductie

Een levenscyclus van een data science-project omvat doorgaans deze stappen:

- Inzicht in de bedrijfsregels

- De gegevens verkrijgen

- De gegevens verkennen, opschonen, voorbereiden en visualiseren

- Het model trainen en het experiment volgen

- Het model beoordelen en inzichten genereren

De stappen gaan vaak iteratief door. De doelstellingen en succescriteria van elke fase zijn afhankelijk van samenwerking, het delen van gegevens en documentatie. De data science-ervaring van Fabric omvat meerdere ingebouwde functies die naadloze samenwerking, gegevensverwerving, delen en verbruik mogelijk maken.

Deze zelfstudies stellen u in de rol van een data scientist die een gegevensset met de verloopstatus van 10.000 bankklanten moet verkennen, opschonen en transformeren. Vervolgens bouwt u een machine learning-model om te voorspellen welke bankklanten waarschijnlijk vertrekken.

Je voert de volgende activiteiten uit in de lessen:

- De Fabric-notebooks gebruiken voor data science-scenario's

- Apache Spark gebruiken om gegevens op te nemen in een Fabric Lakehouse

- Bestaande gegevens laden uit de Lakehouse Delta-tabellen

- Hulpprogramma's op basis van Apache Spark en Python gebruiken om gegevens op te schonen en te transformeren

- Experimenten maken en uitvoeren om verschillende Machine Learning-modellen te trainen

- MLflow en de Fabric-gebruikersinterface gebruiken om getrainde modellen te registreren en bij te houden

- Scoring uitvoeren op schaal en voorspellingen en inferentieresultaten opslaan in het lakehouse

- DirectLake gebruiken om voorspellingen te visualiseren in Power BI

Architectuur

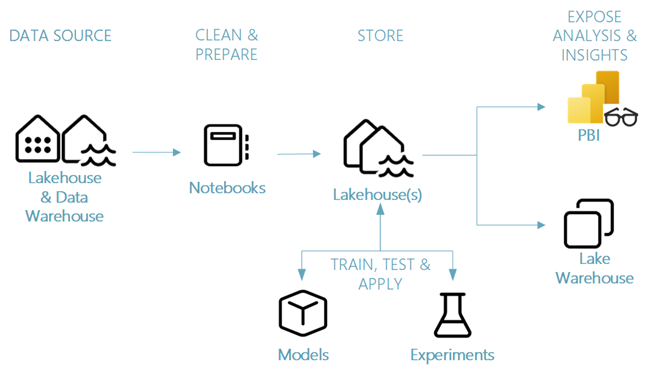

Deze zelfstudiecursus laat een vereenvoudigd end-to-end data science-scenario zien over:

- Gegevensopname van een externe gegevensbron.

- Gegevens verkennen en opschonen.

- Training en registratie van machine learning-modellen.

- Opslaan van batchgewijs scoren en voorspellingen.

- Visualisatie van voorspellingsresultaten in Power BI.

Verschillende onderdelen van het data science-scenario

Gegevensbronnen : als u gegevens wilt opnemen met Fabric, kunt u eenvoudig en snel verbinding maken met Azure Data Services, andere cloudplatforms en on-premises gegevensresources. Met Fabric Notebooks kunt u gegevens uit deze resources opnemen:

- Ingebouwde Lakehouses

- Dataopslagplaatsen

- Semantische modellen

- Verschillende Apache Spark-gegevensbronnen

- Verschillende gegevensbronnen die Ondersteuning bieden voor Python

Deze reeks zelfstudies richt zich op gegevensopname en -laden vanuit een lakehouse.

Verkennen, opschonen en voorbereiden - De data science-ervaring van Fabric ondersteunt het opschonen, transformeren, verkennen en het featuren van gegevens. Het maakt gebruik van ingebouwde Spark-ervaringen en Python-hulpprogramma's, bijvoorbeeld Data Wrangler en SemPy Library. In deze zelfstudie ziet u hoe u gegevens kunt verkennen met de seaborn Python-bibliotheek en gegevens opschonen en voorbereiden met Apache Spark.

Modellen en experimenten : met Fabric kunt u machine learning-modellen trainen, evalueren en beoordelen met ingebouwde experimenten. Om uw modellen te registreren en te implementeren en experimenten bij te houden, biedt MLflow naadloze integratie met Fabric als een manier om items te modelleren. Fabric biedt andere functies voor modelvoorspelling op schaal (PREDICT) om zakelijke inzichten te bouwen en te delen.

Storage - Fabric standaardiseert op Delta Lake, wat betekent dat alle Fabric-engines kunnen communiceren met dezelfde gegevensset die is opgeslagen in een lakehouse. Met deze opslaglaag kunt u zowel gestructureerde als ongestructureerde gegevens opslaan die zowel bestandsopslag als tabelindeling ondersteunen. U kunt eenvoudig toegang krijgen tot de gegevensverzamelingen en opgeslagen bestanden via alle Fabric-elementen, bijvoorbeeld notebooks en pijplijnen.

Analyse en inzichten beschikbaar maken: Power BI, een toonaangevende business intelligence tool, kan lakehouse-gegevens gebruiken voor het genereren van rapporten en visualisaties. In notebook-resources, Python- of Spark-systeemeigen visualisatiebibliotheken

matplotlibseabornplotly- Enzovoort.

kan gegevens visualiseren die in een lakehouse zijn opgeslagen. De SemPy-bibliotheek ondersteunt ook gegevensvisualisatie. Deze bibliotheek ondersteunt ingebouwde uitgebreide, taakspecifieke visualisaties voor

- Het semantische gegevensmodel

- Afhankelijkheden en hun schendingen

- Gebruiksvoorbeelden voor classificatie en regressie