Diagnostische logboeken openen voor Azure Data Lake Analytics

Belangrijk

Azure Data Lake Analytics op 29 februari 2024 buiten gebruik gesteld. Meer informatie over deze aankondiging.

Voor gegevensanalyse kan uw organisatie gebruikmaken van Azure Synapse Analytics of Microsoft Fabric.

Met diagnostische logboekregistratie kunt u audittrails voor gegevenstoegang verzamelen. Deze logboeken bieden informatie zoals:

- Een lijst met gebruikers die toegang hebben tot de gegevens.

- Hoe vaak de gegevens worden geopend.

- Hoeveel gegevens zijn opgeslagen in het account.

Logboekregistratie inschakelen

Meld u aan bij Azure Portal.

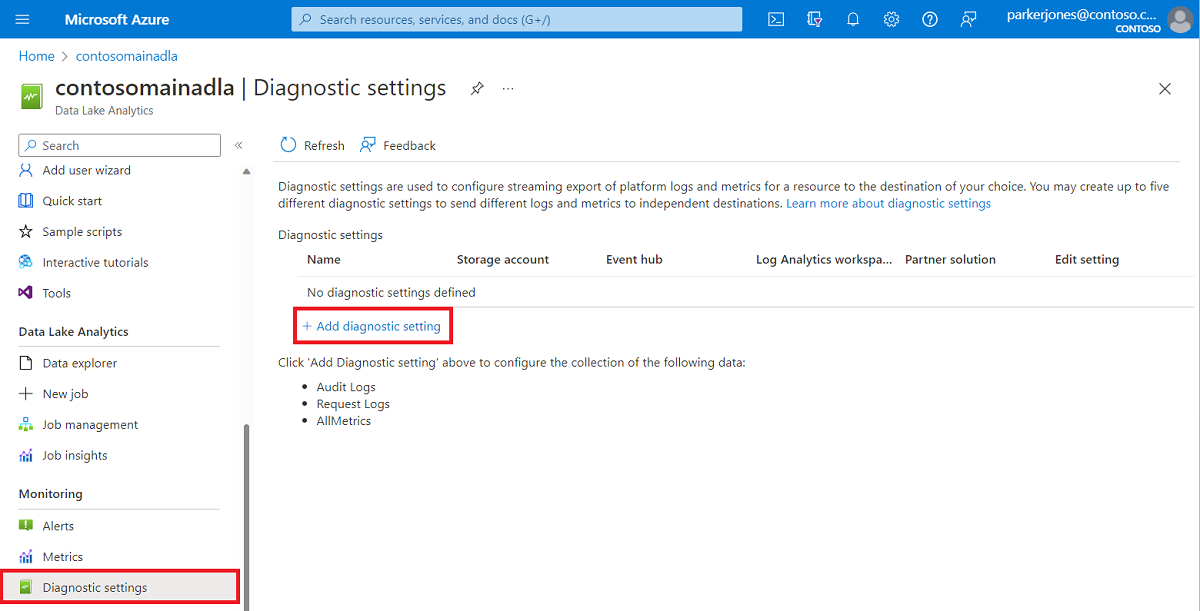

Open uw Data Lake Analytics-account en selecteer Diagnostische instellingen in de sectie Bewaking. Selecteer vervolgens + Diagnostische instelling toevoegen.

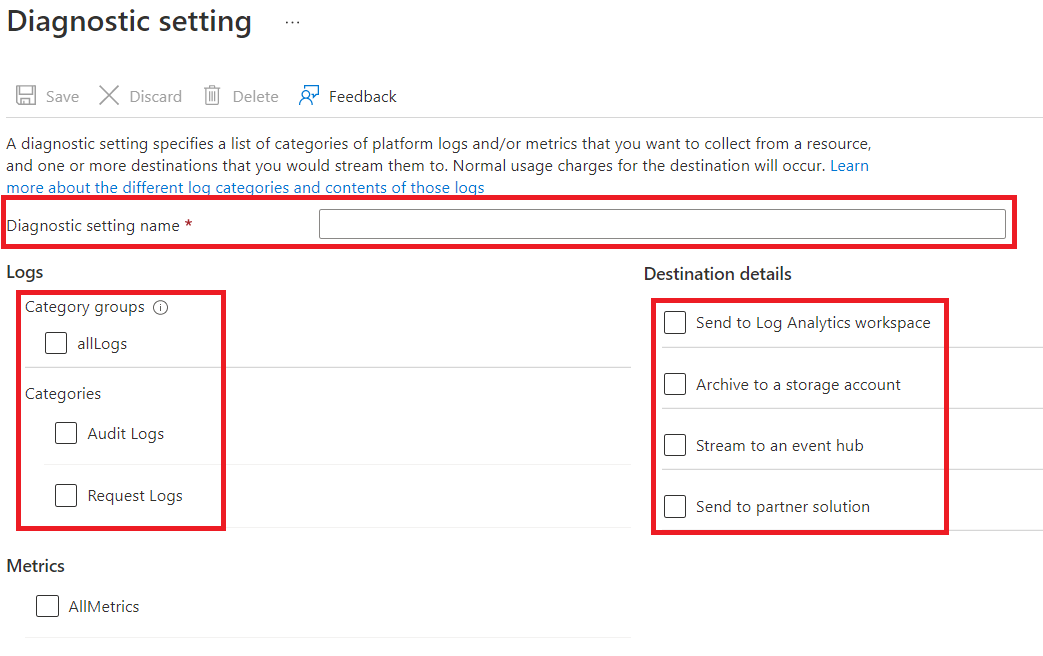

Voer in Diagnostische instelling een naam in voor deze logboekconfiguratie en selecteer vervolgens opties voor logboekregistratie.

U kunt ervoor kiezen om de gegevens op vier verschillende manieren op te slaan/te verwerken.

Selecteer Archiveren naar een opslagaccount om logboeken op te slaan in een Azure-opslagaccount. Gebruik deze optie als u de gegevens wilt archiveren. Als u deze optie selecteert, moet u een Azure-opslagaccount opgeven om de logboeken in op te slaan.

Selecteer Stream naar een Event Hub om logboekgegevens naar een Azure Event Hubs te streamen. Gebruik deze optie als u een downstreamverwerkingspijplijn hebt die binnenkomende logboeken in realtime analyseert. Als u deze optie selecteert, moet u de details opgeven voor de Azure Event Hubs u wilt gebruiken.

Selecteer Verzenden naar Log Analytics-werkruimte om de gegevens naar de Azure Monitor-service te verzenden. Gebruik deze optie als u Azure Monitor-logboeken wilt gebruiken om logboeken te verzamelen en te analyseren.

Selecteer verzenden naar partneroplossing als u onze partnerintegratie wilt gebruiken. Volg deze koppeling voor meer informatie.

Geef op of u auditlogboeken, aanvraaglogboeken of beide wilt ophalen. In een aanvraaglogboek wordt elke API-aanvraag vastgelegd. Een auditlogboek registreert alle bewerkingen die worden geactiveerd door die API-aanvraag.

Geef voor Archiveren naar een opslagaccount het aantal dagen op dat de gegevens moeten worden bewaard.

Selecteer Opslaan.

Notitie

U moet Archiveren naar een opslagaccount, Stream naar een Event Hub, Verzenden naar Log Analytics-werkruimte of Verzenden naar partneroplossing selecteren voordat u de knop Opslaan selecteert.

Het Azure Storage-account gebruiken dat logboekgegevens bevat

Als u de blobcontainers wilt weergeven die logboekgegevens bevatten, opent u het Azure Storage-account dat wordt gebruikt voor Data Lake Analytics voor logboekregistratie en selecteert u containers.

- De container insights-logs-audit bevat de auditlogboeken.

- De container insights-logs-requests bevat de aanvraaglogboeken.

In de containers worden de logboeken opgeslagen onder de volgende bestandsstructuur:

resourceId=/ SUBSCRIPTIONS/ <<SUBSCRIPTION_ID>>/ RESOURCEGROUPS/ <<RESOURCE_GRP_NAME>>/ PROVIDERS/ MICROSOFT.DATALAKEANALYTICS/ ACCOUNTS/ <DATA_LAKE_ANALYTICS_NAME>>/ y=####/ m=##/ d=##/ h=##/ m=00/ PT1H.jsonNotitie

De

##vermeldingen in het pad bevatten het jaar, de maand, de dag en het uur waarin het logboek is gemaakt. Data Lake Analytics maakt elk uur één bestand, dusm=bevat altijd de waarde00.Het volledige pad naar een auditlogboek kan bijvoorbeeld zijn:

https://adllogs.blob.core.windows.net/insights-logs-audit/resourceId=/SUBSCRIPTIONS/<sub-id>/RESOURCEGROUPS/myresourcegroup/PROVIDERS/MICROSOFT.DATALAKEANALYTICS/ACCOUNTS/mydatalakeanalytics/y=2016/m=07/d=18/h=04/m=00/PT1H.jsonOp dezelfde manier kan het volledige pad naar een aanvraaglogboek zijn:

https://adllogs.blob.core.windows.net/insights-logs-requests/resourceId=/SUBSCRIPTIONS/<sub-id>/RESOURCEGROUPS/myresourcegroup/PROVIDERS/MICROSOFT.DATALAKEANALYTICS/ACCOUNTS/mydatalakeanalytics/y=2016/m=07/d=18/h=14/m=00/PT1H.json

De logboekgegevens verwerken

Azure Data Lake Analytics biedt een voorbeeld van het verwerken en analyseren van de logboekgegevens. U vindt het voorbeeld op https://github.com/Azure/AzureDataLake/tree/master/Samples/AzureDiagnosticsSample.

Logboekstructuur

De audit- en aanvraaglogboeken hebben een gestructureerde JSON-indeling.

Aanvraaglogboeken

Hier volgt een voorbeeldvermelding in het aanvraaglogboek in JSON-indeling. Elke blob heeft één hoofdobject met de naam records dat een matrix van logboekobjecten bevat.

{

"records":

[

. . . .

,

{

"time": "2016-07-07T21:02:53.456Z",

"resourceId": "/SUBSCRIPTIONS/<subscription_id>/RESOURCEGROUPS/<resource_group_name>/PROVIDERS/MICROSOFT.DATALAKEANALYTICS/ACCOUNTS/<data_lake_analytics_account_name>",

"category": "Requests",

"operationName": "GetAggregatedJobHistory",

"resultType": "200",

"callerIpAddress": "::ffff:1.1.1.1",

"correlationId": "4a11c709-05f5-417c-a98d-6e81b3e29c58",

"identity": "1808bd5f-62af-45f4-89d8-03c5e81bac30",

"properties": {

"HttpMethod":"POST",

"Path":"/JobAggregatedHistory",

"RequestContentLength":122,

"ClientRequestId":"3b7adbd9-3519-4f28-a61c-bd89506163b8",

"StartTime":"2016-07-07T21:02:52.472Z",

"EndTime":"2016-07-07T21:02:53.456Z"

}

}

,

. . . .

]

}

Schema voor aanvraaglogboek

| Naam | Type | Description |

|---|---|---|

| tijd | Tekenreeks | Het tijdstempel (in UTC) van het logboek |

| resourceId | Tekenreeks | De id van de resource waarop de bewerking heeft plaatsgevonden |

| category | Tekenreeks | De logboekcategorie. Bijvoorbeeld Aanvragen. |

| operationName | Tekenreeks | Naam van de bewerking die wordt geregistreerd. Bijvoorbeeld GetAggregatedJobHistory. |

| resultType | Tekenreeks | De status van de bewerking, bijvoorbeeld 200. |

| callerIpAddress | Tekenreeks | Het IP-adres van de client die de aanvraag indient |

| correlationId | Tekenreeks | De id van het logboek. Deze waarde kan worden gebruikt om een set gerelateerde logboekvermeldingen te groepeer. |

| identity | Object | De identiteit die het logboek heeft gegenereerd |

| properties | JSON | Zie de volgende sectie (Schema voor aanvraaglogboekeigenschappen) voor meer informatie |

Schema voor eigenschappen van aanvraaglogboek

| Naam | Type | Description |

|---|---|---|

| HttpMethod | Tekenreeks | De HTTP-methode die voor de bewerking wordt gebruikt. Bijvoorbeeld GET. |

| Pad | Tekenreeks | Het pad waarop de bewerking is uitgevoerd |

| RequestContentLength | int | De inhoudslengte van de HTTP-aanvraag |

| ClientRequestId | Tekenreeks | De id die deze aanvraag uniek identificeert |

| StartTime | Tekenreeks | Het tijdstip waarop de server de aanvraag heeft ontvangen |

| EndTime | Tekenreeks | Het tijdstip waarop de server een antwoord heeft verzonden |

Auditlogboeken

Hier volgt een voorbeeldvermelding in het auditlogboek met JSON-indeling. Elke blob heeft één hoofdobject, records genaamd, dat een matrix met logboekobjecten bevat.

{

"records":

[

{

"time": "2016-07-28T19:15:16.245Z",

"resourceId": "/SUBSCRIPTIONS/<subscription_id>/RESOURCEGROUPS/<resource_group_name>/PROVIDERS/MICROSOFT.DATALAKEANALYTICS/ACCOUNTS/<data_lake_ANALYTICS_account_name>",

"category": "Audit",

"operationName": "JobSubmitted",

"identity": "user@somewhere.com",

"properties": {

"JobId":"D74B928F-5194-4E6C-971F-C27026C290E6",

"JobName": "New Job",

"JobRuntimeName": "default",

"SubmitTime": "7/28/2016 7:14:57 PM"

}

}

]

}

Schema van auditlogboek

| Naam | Type | Description |

|---|---|---|

| tijd | Tekenreeks | De tijdstempel (in UTC) van het logboek |

| resourceId | Tekenreeks | De id van de resource waarop de bewerking heeft plaatsgevonden |

| category | Tekenreeks | De logboekcategorie. Bijvoorbeeld Audit. |

| operationName | Tekenreeks | Naam van de bewerking die is geregistreerd. Bijvoorbeeld JobSubmitted. |

| resultType | Tekenreeks | Een substatus voor de taakstatus (operationName). |

| resultSignature | Tekenreeks | Extra informatie over de taakstatus (operationName). |

| identity | Tekenreeks | De gebruiker die de bewerking heeft aangevraagd. Bijvoorbeeld susan@contoso.com. |

| properties | JSON | Zie de volgende sectie (schema met eigenschappen van auditlogboek) voor meer informatie |

Notitie

resultType en resultSignature bieden informatie over het resultaat van een bewerking en bevatten alleen een waarde als een bewerking is voltooid. Ze bevatten bijvoorbeeld alleen een waarde wanneer operationName de waarde JobStarted of JobEnded bevat.

Schema voor eigenschappen van auditlogboek

| Naam | Type | Description |

|---|---|---|

| JobId | Tekenreeks | De id die is toegewezen aan de taak |

| JobName | Tekenreeks | De naam die is opgegeven voor de taak |

| JobRunTime | Tekenreeks | De runtime die wordt gebruikt om de taak te verwerken |

| SubmitTime | Tekenreeks | De tijd (in UTC) dat de taak is verzonden |

| StartTime | Tekenreeks | Het tijdstip waarop de taak is gestart na verzending (in UTC) |

| EndTime | Tekenreeks | De tijd waarop de taak is beëindigd |

| Parallelle uitvoering | Tekenreeks | Het aantal Data Lake Analytics eenheden dat voor deze taak is aangevraagd tijdens het indienen |

Notitie

SubmitTime, StartTime, EndTime en Parallellisme bieden informatie over een bewerking. Deze vermeldingen bevatten alleen een waarde als die bewerking is gestart of voltooid. SubmitTime bevat bijvoorbeeld alleen een waarde nadat operationName de waarde JobSubmitted heeft.