Gegevens importeren

Belangrijk

De ondersteuning voor Azure Machine Learning-studio (klassiek) eindigt op 31 augustus 2024. U wordt aangeraden om vóór die datum over te stappen naar Azure Machine Learning.

Vanaf 1 december 2021 kunt u geen nieuwe resources voor Azure Machine Learning-studio (klassiek) meer maken. Tot en met 31 augustus 2024 kunt u de bestaande resources van Azure Machine Learning-studio (klassiek) blijven gebruiken.

- Zie informatie over het verplaatsen van machine learning-projecten van ML Studio (klassiek) naar Azure Machine Learning.

- Meer informatie over Azure Machine Learning.

De documentatie van ML-studio (klassiek) wordt buiten gebruik gesteld en wordt in de toekomst mogelijk niet meer bijgewerkt.

Hiermee worden gegevens uit externe bronnen op internet geladen; van verschillende vormen van cloudopslag in Azure, zoals tabellen, blobs en SQL databases; en van on-premises SQL Server databases

Categorie: Gegevensinvoer en -uitvoer

Notitie

Van toepassing op: alleen Machine Learning Studio (klassiek)

Vergelijkbare modules voor slepen en neerzetten zijn beschikbaar in Azure Machine Learning designer.

Moduleoverzicht

In dit artikel wordt beschreven hoe u de module Gegevens importeren in Machine Learning Studio (klassiek) gebruikt om gegevens te laden in een machine learning-experiment van bestaande cloudgegevensservices.

De module bevat nu een wizard om u te helpen een opslagoptie te kiezen en een keuze te maken uit bestaande abonnementen en accounts om snel alle opties te configureren. Wilt u een bestaande gegevensverbinding bewerken? Geen probleem; met de wizard worden alle vorige configuratiegegevens geladen, zodat u niet opnieuw hoeft te beginnen.

Nadat u de gewenste gegevens hebt gedefinieerd en verbinding hebt gemaakt met de bron, wordt het gegevenstype van elke kolom afgeleid op basis van de waarden die deze bevat en laadt u de gegevens in uw Machine Learning Studio-werkruimte (klassiek). De uitvoer van Import Data is een gegevensset die kan worden gebruikt met elk experiment.

Belangrijk

Momenteel gelden er beperkingen voor de typen opslagaccounts die worden ondersteund. Zie Technische notities voor meer informatie.

Als uw brongegevens worden gewijzigd, kunt u de gegevensset vernieuwen en nieuwe gegevens toevoegen door importgegevens opnieuw uit te voeren. Als u echter niet telkens opnieuw wilt lezen uit de bron wanneer u het experiment uitvoert, selecteert u de optie Resultaten in de cache gebruiken op TRUE. Wanneer deze optie is geselecteerd, controleert de module of het experiment eerder is uitgevoerd met dezelfde bron en dezelfde invoeropties. Als er een eerdere uitvoering wordt gevonden, worden de gegevens in de cache gebruikt in plaats van de gegevens opnieuw te laden uit de bron.

Notitie

Deze module heette eerder Reader. Als u de reader-module eerder in een experiment hebt gebruikt, wordt de naam gewijzigd in Gegevens importeren wanneer u het experiment vernieuwt.

Gegevensbronnen

De module Import Data ondersteunt de volgende gegevensbronnen. Klik op de koppelingen voor gedetailleerde instructies en voorbeelden van het gebruik van elke gegevensbron.

Als u niet zeker weet hoe of waar u uw gegevens moet opslaan, raadpleegt u deze handleiding voor algemene gegevensscenario's in het data science-proces: Scenario's voor geavanceerde analyses in Machine Learning.

| Gegevensbron | Gebruiken met |

|---|---|

| Web-URL via HTTP | Gegevens ophalen die worden gehost op een web-URL die gebruikmaakt van HTTP en die zijn opgegeven in de indelingen CSV, TSV, ARFF of SvmLight |

| Hive-query | Gegevens ophalen uit gedistribueerde opslag in Hadoop. U geeft de gewenste gegevens op met behulp van de HiveQL-taal |

| Azure SQL Database | Gegevens ophalen uit Azure SQL Database of uit Azure SQL Data Warehouse |

| Azure Table | Gegevens ophalen die zijn opgeslagen in de Azure-tabelservice |

| Importeren uit Azure Blob Storage | Gegevens ophalen die zijn opgeslagen in de Azure Blob-service |

| Gegevensfeedproviders | Gegevens ophalen die beschikbaar zijn als een feed in OData-indeling |

| Importeren uit on-premises SQL Server database | Gegevens ophalen uit een on-premises SQL Server-database met behulp van de Microsoft Gegevensbeheer Gateway |

| Azure Cosmos DB | Gegevens ophalen die zijn opgeslagen in JSON-indeling in Azure Cosmos DB. |

Tip

Wilt u gegevens importeren in de JSON-indeling? Zowel R als Python ondersteunen REST API's, dus gebruik de modules Execute Python Script of Execute R Script om uw gegevens te parseren en op te slaan als een Azure ML-gegevensset.

Of gebruik de SQL DB-API voor CosmosDB, die ondersteuning biedt voor meerdere JSON-archieven, waaronder MongoDB, om uw gegevens te lezen met behulp van de optie Importeren uit Azure Cosmos DB. Zie Importeren uit Azure Cosmos DB voor meer informatie.

Gegevens importeren gebruiken

Voeg de module Gegevens importeren toe aan uw experiment. U vindt deze module in de categorie Gegevensinvoer en -uitvoer in Studio (klassiek).

Klik op Wizard Gegevens importeren starten om de gegevensbron te configureren met behulp van een wizard.

De wizard haalt de accountnaam en referenties op en helpt u bij het configureren van andere opties. Als u een bestaande configuratie bewerkt, worden eerst de huidige waarden geladen.

Als u de wizard niet wilt gebruiken, klikt u op Gegevensbron en kiest u het type cloudopslag waaruit u leest.

Aanvullende instellingen zijn afhankelijk van het type opslag dat u kiest en of de opslag al dan niet is beveiligd. Mogelijk moet u de accountnaam, het bestandstype of de referenties opgeven. Voor sommige bronnen is geen verificatie vereist; Voor anderen moet u mogelijk de accountnaam, een sleutel of containernaam kennen.

Zie de lijst met gegevensbronnen voor meer informatie.

Selecteer de optie Resultaten in de cache gebruiken als u de gegevensset wilt opslaan voor opnieuw gebruik bij opeenvolgende uitvoeringen.

Ervan uitgaande dat er geen andere wijzigingen in moduleparameters zijn aangebracht, worden de gegevens alleen geladen wanneer de module voor het eerst wordt uitgevoerd en daarna wordt een versie in de cache van de gegevensset gebruikt.

Schakel deze optie uit als u de gegevens telkens wanneer u het experiment uitvoert, opnieuw moet laden.

Voer het experiment uit.

Wanneer Gegevens importeren de gegevens in Studio (klassiek) laadt, wordt het gegevenstype van elke kolom afgeleid op basis van de waarden die deze bevat, numeriek of categorisch.

Als er een koptekst aanwezig is, wordt de header gebruikt om de kolommen van de uitvoergegevensset een naam te geven.

Als er geen bestaande kolomkoppen in de gegevens staan, worden nieuwe kolomnamen gegenereerd met de indeling col1, col2,... ,coln.

Resultaten

Wanneer het importeren is voltooid, klikt u op de uitvoergegevensset en selecteert u Visualiseren om te zien of de gegevens zijn geïmporteerd.

Als u de gegevens wilt opslaan voor hergebruik, in plaats van een nieuwe set gegevens te importeren telkens wanneer het experiment wordt uitgevoerd, klikt u met de rechtermuisknop op de uitvoer en selecteert u Opslaan als gegevensset. Kies een naam voor de gegevensset. De opgeslagen gegevensset behoudt de gegevens op het moment van opslaan en gegevens worden niet bijgewerkt wanneer het experiment opnieuw wordt uitgevoerd, zelfs niet als de gegevensset in het experiment wordt gewijzigd. Dit kan handig zijn voor het maken van momentopnamen van gegevens.

Na het importeren van de gegevens hebben deze mogelijk aanvullende voorbereidingen nodig voor modellering en analyse:

Genereer statistische samenvattingen van de gegevens met behulp van Summarize Data of Compute Elementary Statistics.

Gebruik Metagegevens bewerken om kolomnamen te wijzigen, om een kolom als een ander gegevenstype te verwerken of om aan te geven dat sommige kolommen labels of functies zijn.

Gebruik Select Columns in Dataset om een subset van kolommen te selecteren om te transformeren of te gebruiken in modellering. De getransformeerde of verwijderde kolommen kunnen eenvoudig opnieuw aan de oorspronkelijke gegevensset worden toegevoegd met behulp van de module Kolommen toevoegen of de module Join Data .

Gebruik Partition and Sample om de gegevensset te verdelen, steekproeven uit te voeren of de bovenste n rijen op te halen.

Gebruik Apply SQL Transformation om gegevens te aggregeren, te filteren of te transformeren met behulp van SQL instructies.

Gebruik deze modules om tekstkolommen op te schonen en nieuwe tekstfuncties te genereren:

- Tekst voorverwerken

- N-Gram-functies uit tekst halen

- Herkenning van benoemde entiteiten

- Voer Python Script uit om aangepaste NLP te implementeren op basis van nltk.

Technische opmerkingen

Deze sectie bevat een lijst met bekende problemen met de module Gegevens importeren , evenals enkele algemene informatie over probleemoplossing die niet specifiek is voor een brontype.

Ondersteunde accounttypen

Vaak brengt Azure nieuwe services of nieuwe opslagtypen uit; Er is echter meestal een vertraging terwijl ondersteuning voor nieuwe accounttypen wordt geïmplementeerd in Machine Learning Studio (klassiek).

Op dit moment ondersteunt Machine Learning alle opslagaccounts voor algemeen gebruik, met uitzondering van opslag met zone-redundante opslag (ZRS).

Lokaal redundante opslag (LRS) en geografisch redundante opslagopties worden ondersteund.

Blok-blobs worden ondersteund, maar toevoeg-blobs niet.

Veelvoorkomende vragen en problemen

In deze sectie worden enkele bekende problemen, veelgestelde vragen en tijdelijke oplossingen beschreven.

Kopteksten moeten één rij zijn

Als u importeert uit CSV-bestanden, moet u er rekening mee houden dat Machine Learning één veldnamenrij toestaat. U kunt geen kopteksten met meerdere regels invoegen.

Aangepaste scheidingstekens die worden ondersteund bij importeren, maar niet exporteren

De module Import Data ondersteunt het importeren van gegevens die gebruikmaken van alternatieve kolomscheidingstekens, zoals de puntkomma (;), die vaak in Europa worden gebruikt. Wanneer u gegevens importeert uit CSV-bestanden in externe opslag, selecteert u het CSV-bestand met coderingsoptie en kiest u een ondersteunde codering.

U kunt echter geen alternatieve scheidingstekens genereren wanneer u gegevens voorbereidt voor export met behulp van de module Converteren naar CSV .

Slechte kolomscheiding voor tekenreeksgegevens met komma's

Bijna elk teken dat kan worden opgegeven als een kolomscheidingsteken (tabbladen, spaties, komma's, enzovoort) kan ook willekeurig worden gevonden in tekstvelden. Als u tekst uit CSV importeert, moet u altijd voorzichtig zijn om te voorkomen dat u tekst over onnodige nieuwe kolommen scheidt. Het is een veelvoorkomend probleem bij het verwerken van tekst dat u waarschijnlijk op verschillende manieren hebt aangetroffen en verwerkt.

Er kunnen ook problemen optreden wanneer u probeert een kolom met tekenreeksgegevens met komma's te exporteren. Machine Learning biedt geen ondersteuning voor speciale verwerking of speciale vertaling van dergelijke gegevens, zoals het insluiten van tekenreeksen tussen aanhalingstekens. U kunt ook geen escapetekens voor een komma gebruiken om ervoor te zorgen dat komma's worden verwerkt als een letterlijk teken. Als gevolg hiervan worden nieuwe velden gemaakt in het uitvoerbestand voor elke komma die in het tekenreeksveld wordt aangetroffen.

Gebruik de module Tekst vooraf verwerken om leestekens uit tekenreeksvelden te verwijderen om problemen bij het exporteren te voorkomen.

U kunt ook aangepast R-script of Python-script gebruiken om complexe tekst te verwerken en ervoor te zorgen dat gegevens correct kunnen worden geïmporteerd of geëxporteerd.

UTF-8-codering vereist

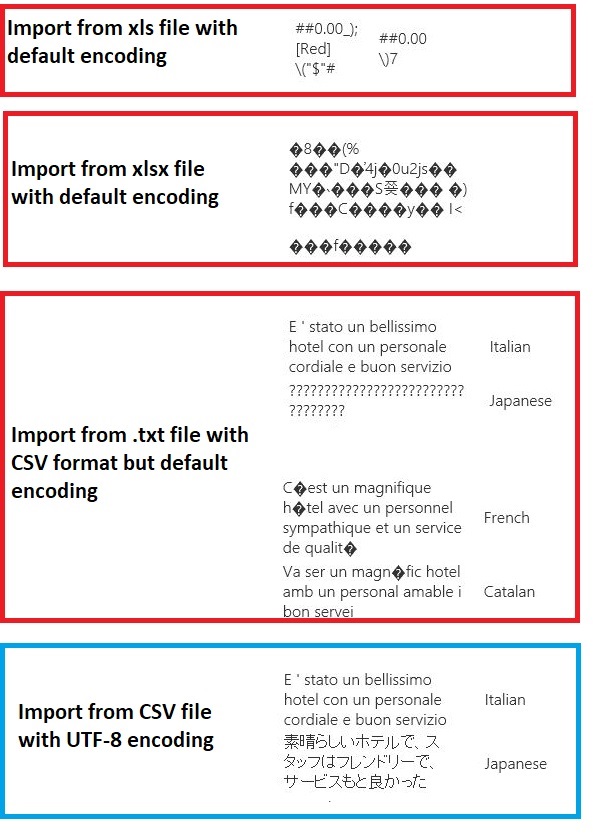

Machine Learning vereist UTF-8-codering. Als de gegevens die u importeert een andere codering gebruiken of zijn geëxporteerd uit een gegevensbron die gebruikmaakt van een andere standaardcodering, kunnen er verschillende problemen in de tekst worden weergegeven.

De volgende afbeelding bevat bijvoorbeeld dezelfde gegevensset met meerdere talen die is geëxporteerd uit Excel en vervolgens geïmporteerd in Machine Learning onder vier verschillende combinaties van bestandstype en codering.

Het derde voorbeeld vertegenwoordigt gegevens die verloren zijn gegaan tijdens het opslaan van Excel in CSV-indeling, omdat de juiste codering op dat moment niet is opgegeven. Als u problemen ondervindt, controleert u daarom niet alleen het bestand waaruit u importeert, maar of het bestand correct is geëxporteerd uit de bron.

De gegevensset heeft geen kolomnamen

Als de gegevensset die u importeert geen kolomnamen heeft, moet u een van de opties voor 'geen koptekst' opgeven. Als u dit doet, voegt Import Data standaardkolomnamen toe met de indeling Col1, Col2, enzovoort. Gebruik later Edit Metadata om de kolomnamen op te lossen.

Als u een gegevensset naar een CSV-bestand exporteert, gebruikt u Metagegevens bewerken om kolomnamen toe te voegen voordat u deze converteert of exporteert.

Tijdelijke oplossingen voor niet-ondersteunde gegevensbronnen

Als u gegevens wilt ophalen uit een bron die niet in de lijst staat, zijn er verschillende tijdelijke oplossingen die u kunt proberen:

Als u gegevens uit een bestand op uw computer wilt uploaden, klikt u op Nieuw in Studio (klassiek), selecteert u Gegevensset en selecteert u Vervolgens Lokaal bestand. Zoek het bestand en geef de indeling op (TSV, CSV, enzovoort). Zie Trainingsgegevens importeren in Studio (klassiek) voor meer informatie.

Gebruik R of Python. U kunt de Execute R Script-module met een geschikt R-pakket gebruiken om gegevens op te halen uit andere clouddatabases.

Met de module Execute Python Script kunt u ook gegevens uit verschillende bronnen lezen en converteren. Bekijk deze voorbeelden van Microsoft-gegevenswetenschappers in de Cortana Intelligence Gallery:

Gegevens ophalen uit AWS-clusters. U kunt een query uitvoeren op een algemeen Hive-cluster met WebHCat- of HCatalog-eindpunt ingeschakeld. Of publiceer als een pagina en lees vanuit de web-URL.

Gegevens ophalen uit MongoDB. Het hulpprogramma voor gegevensmigratie voor Azure Cosmos DB ondersteunt een groot aantal bronnen en indelingen. Zie Azure Cosmos DB: Hulpprogramma voor gegevensmigratie voor meer informatie en voorbeelden

Zie het Machine Learning forum of de Azure AI Gallery voor meer ideeën en tijdelijke oplossingen.

Moduleparameters

Elke gegevensbron moet worden geconfigureerd met verschillende opties. Deze tabel bevat alleen de opties die voor alle gegevensbronnen gelden.

| Name | Bereik | Type | Standaard | Beschrijving |

|---|---|---|---|---|

| Gegevensbron | Lijst | Gegevensbron of sink | Blob-service in Azure Storage | Gegevensbron kan HTTP, anoniem HTTPS zijn, een bestand in de Blob-service of Table-service, een SQL-database in Azure, een Azure SQL Data Warehouse, een Hive-tabel of een OData-eindpunt. |

| Resultaten in cache gebruiken | WAAR/ONWAAR | Booleaans | FALSE | Als WAAR is, controleert de module of het experiment eerder is uitgevoerd met dezelfde bron en dezelfde invoeropties. Als er een eerdere uitvoering wordt gevonden, worden de gegevens in de cache gebruikt. Als ONWAAR is of als er wijzigingen worden gevonden, worden gegevens opnieuw uit de bron geladen. |

Uitvoerwaarden

| Naam | Type | Beschrijving |

|---|---|---|

| Resultatengegevensset | Gegevenstabel | Gegevensset met gedownloade gegevens |

Uitzonderingen

| Uitzondering | Beschrijving |

|---|---|

| Fout 0027 | Er treedt een uitzondering op wanneer twee objecten dezelfde grootte moeten hebben, maar niet. |

| Fout 0003 | Er treedt een uitzondering op als een of meer invoerwaarden null of leeg zijn. |

| Fout 0029 | Er treedt een uitzondering op wanneer een ongeldige URI wordt doorgegeven. |

| Fout 0030 | er treedt een uitzondering op wanneer het niet mogelijk is om een bestand te downloaden. |

| Fout 0002 | Er treedt een uitzondering op als een of meer parameters niet kunnen worden geparseerd of geconverteerd van het opgegeven type naar het type dat is vereist door de doelmethode. |

| Fout 0009 | Er treedt een uitzondering op als de naam van het Azure-opslagaccount of de containernaam onjuist is opgegeven. |

| Fout 0048 | Er treedt een uitzondering op wanneer het niet mogelijk is om een bestand te openen. |

| Fout 0015 | Er treedt een uitzondering op als de databaseverbinding is mislukt. |

| Fout 0046 | Er treedt een uitzondering op wanneer het niet mogelijk is om een map te maken op het opgegeven pad. |

| Fout 0049 | Er treedt een uitzondering op wanneer het niet mogelijk is om een bestand te parseren. |

Zie Machine Learning Foutcodes voor een lijst met fouten die specifiek zijn voor Studio-modules (klassiek).

Zie Machine Learning REST API-foutcodes voor een lijst met API-uitzonderingen.

Zie ook

Gegevensinvoer en -uitvoer

Conversies van gegevensindelingen

Gegevens exporteren

A-Z-modulelijst