Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

DOTYCZY: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Napiwek

Wypróbuj usługę Data Factory w usłudze Microsoft Fabric — rozwiązanie analityczne typu all-in-one dla przedsiębiorstw. Usługa Microsoft Fabric obejmuje wszystko, od przenoszenia danych do nauki o danych, analizy w czasie rzeczywistym, analizy biznesowej i raportowania. Dowiedz się, jak bezpłatnie rozpocząć nową wersję próbną !

Jeśli jesteś nowym użytkownikiem usługi Azure Data Factory, zobacz Wprowadzenie do usługi Azure Data Factory.

W tym samouczku użyjesz interfejsu użytkownika usługi Data Factory, aby utworzyć potok, który kopiuje i przekształca dane ze źródła usługi Azure Data Lake Storage Gen2 do ujścia usługi Data Lake Storage Gen2 (zarówno zezwalając na dostęp do wybranych sieci) przy użyciu przepływu mapowania danych w zarządzanej sieci wirtualnej usługi Data Factory. Możesz rozwinąć wzorzec konfiguracji w tym samouczku podczas przekształcania danych przy użyciu przepływu danych mapowania.

W tym samouczku wykonasz następujące czynności:

- Tworzenie fabryki danych.

- Utwórz potok z działaniem przepływu danych.

- Utwórz przepływ danych mapowania z czterema przekształceniami.

- Testowe uruchamianie potoku.

- Monitorowanie działania przepływu danych.

Wymagania wstępne

- Subskrypcja platformy Azure. Jeśli nie masz subskrypcji platformy Azure, przed rozpoczęciem utwórz bezpłatne konto platformy Azure.

- Konto usługi Azure Storage. Usługa Data Lake Storage jest używana jako magazyny danych źródła i ujścia . Jeśli nie masz konta magazynu, utwórz je, wykonując czynności przedstawione w artykule Tworzenie konta magazynu platformy Azure. Upewnij się, że konto magazynu zezwala na dostęp tylko z wybranych sieci.

Plik, który przekształcimy w tym samouczku, jest moviesDB.csv, który można znaleźć w tej witrynie zawartości usługi GitHub. Aby pobrać plik z usługi GitHub, skopiuj zawartość do wybranego edytora tekstów, aby zapisać go lokalnie jako plik .csv. Aby przekazać plik na konto magazynu, zobacz Przekazywanie obiektów blob za pomocą witryny Azure Portal. Przykłady będą odwoływać się do kontenera o nazwie sample-data.

Tworzenie fabryki danych

W tym kroku utworzysz fabrykę danych i otworzysz interfejs użytkownika usługi Data Factory, aby utworzyć potok w fabryce danych.

Otwórz przeglądarkę Microsoft Edge lub Google Chrome. Obecnie tylko przeglądarki internetowe Microsoft Edge i Google Chrome obsługują interfejs użytkownika usługi Data Factory.

W menu po lewej stronie wybierz pozycję Utwórz zasób>Analiza>Data Factory.

Na stronie Nowa fabryka danych w polu Nazwa wprowadź wartość ADFTutorialDataFactory.

Nazwa fabryki danych musi być globalnie unikatowa. Jeśli zostanie wyświetlony komunikat o błędzie dotyczący wartości nazwy, wprowadź inną nazwę fabryki danych (na przykład yournameADFTutorialDataFactory). Reguły nazewnictwa dla artefaktów usługi Data Factory można znaleźć w artykule Data Factory — reguły nazewnictwa.

Wybierz subskrypcję platformy Azure, w której chcesz utworzyć fabrykę danych.

W obszarze Grupa zasobów wykonaj jedną z następujących czynności:

- Wybierz pozycję Użyj istniejącej, a następnie wybierz istniejącą grupę zasobów z listy rozwijanej.

- Wybierz pozycję Utwórz nową, a następnie wprowadź nazwę grupy zasobów.

Informacje na temat grup zasobów znajdują się w artykule Using resource groups to manage your Azure resources (Używanie grup zasobów do zarządzania zasobami platformy Azure).

W obszarze Wersja wybierz pozycję V2.

W obszarze Lokalizacja wybierz lokalizację fabryki danych. Na liście rozwijanej są wyświetlane tylko obsługiwane lokalizacje. Magazyny danych (na przykład Usługi Azure Storage i Azure SQL Database) i obliczenia (na przykład Usługa Azure HDInsight) używane przez fabrykę danych mogą znajdować się w innych regionach.

Wybierz pozycję Utwórz.

Po zakończeniu tworzenia zostanie wyświetlone powiadomienie w Centrum powiadomień. Wybierz pozycję Przejdź do zasobu , aby przejść do strony Fabryka danych .

Wybierz pozycję Otwórz program Azure Data Factory Studio , aby uruchomić interfejs użytkownika usługi Data Factory na osobnej karcie.

Tworzenie środowiska Azure IR w zarządzanej sieci wirtualnej usługi Data Factory

W tym kroku utworzysz środowisko Azure IR i włączysz zarządzaną sieć wirtualną usługi Data Factory.

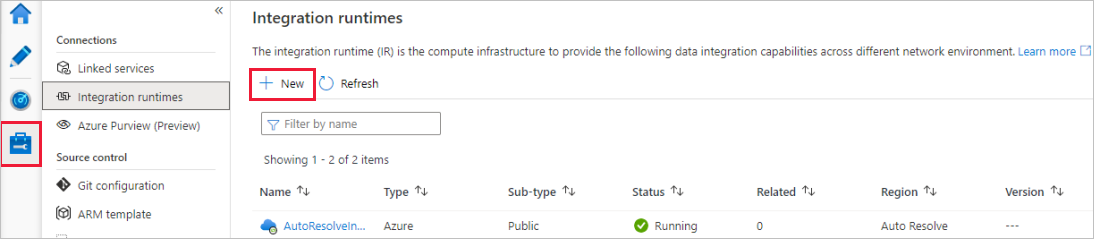

W portalu usługi Data Factory przejdź do pozycji Zarządzaj, a następnie wybierz pozycję Nowy , aby utworzyć nowe środowisko Azure IR.

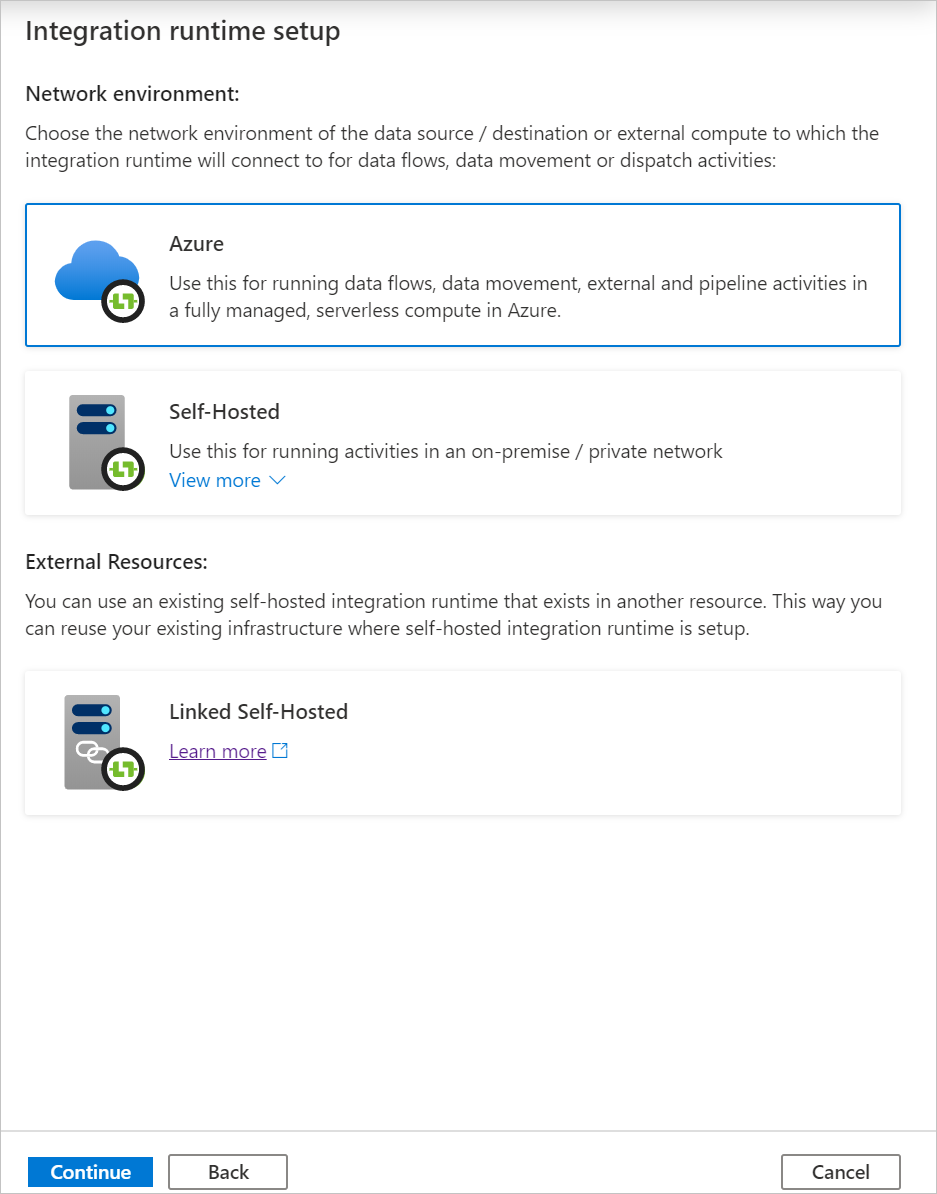

Na stronie Konfiguracja środowiska Integration Runtime wybierz środowisko Integration Runtime, które ma zostać utworzone na podstawie wymaganych możliwości. W tym samouczku wybierz pozycję Azure, Self-Hosted , a następnie kliknij przycisk Kontynuuj.

Wybierz pozycję Azure, a następnie kliknij przycisk Kontynuuj , aby utworzyć środowisko Azure Integration Runtime.

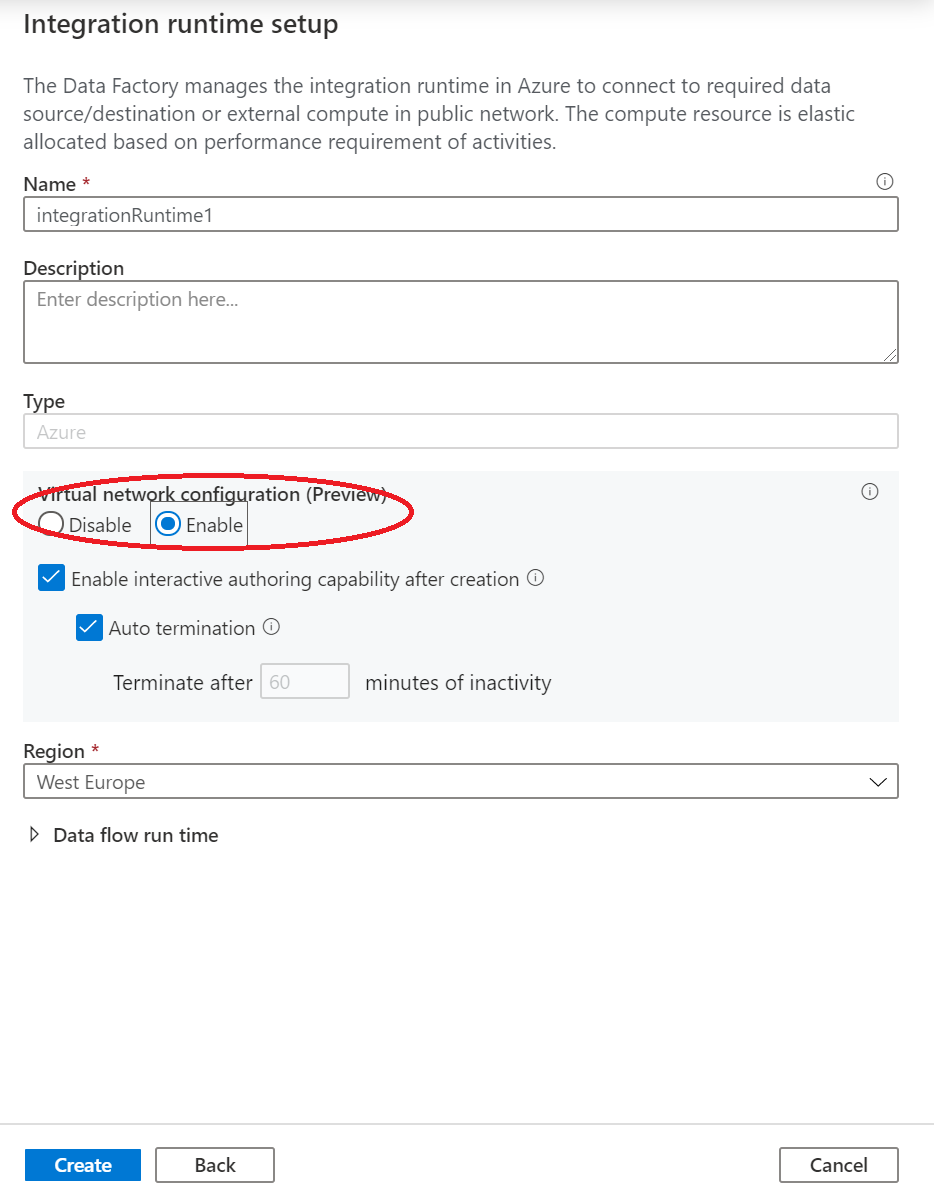

W obszarze Konfiguracja sieci wirtualnej (wersja zapoznawcza) wybierz pozycję Włącz.

Wybierz pozycję Utwórz.

Tworzenie potoku z działaniem przepływu danych

W tym kroku utworzysz potok zawierający działanie przepływu danych.

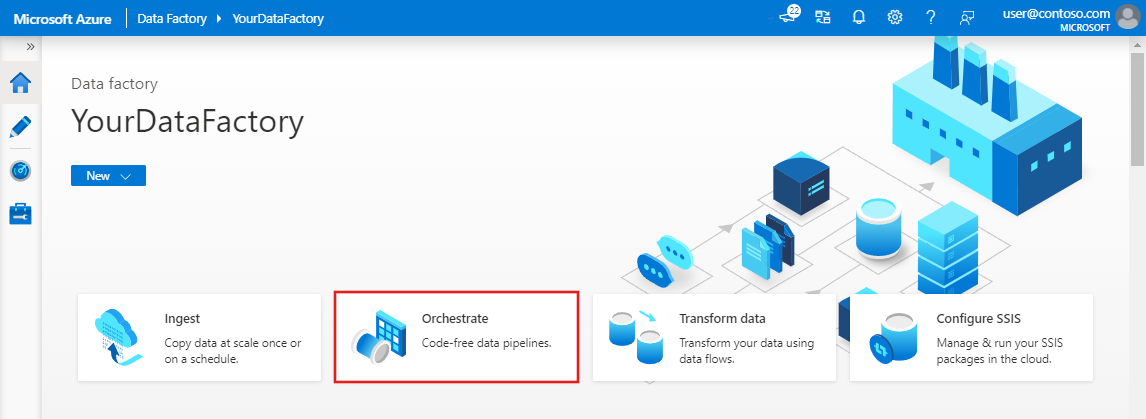

Na stronie głównej usługi Azure Data Factory wybierz pozycję Orkiestruj.

W okienku właściwości potoku wprowadź TransformFilmy jako nazwę potoku.

W okienku Działania rozwiń węzeł Przenieś i Przekształć. Przeciągnij działanie Przepływ danych z okienka do kanwy potoku.

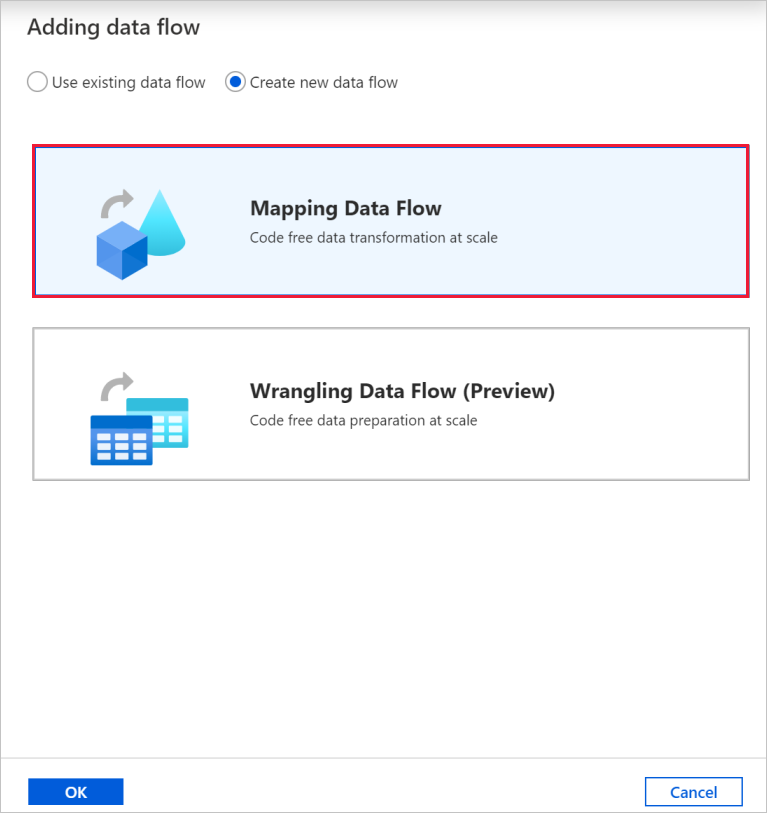

W oknie podręcznym Dodawanie przepływu danych wybierz pozycję Utwórz nowy przepływ danych, a następnie wybierz pozycję Mapowanie Przepływ danych. Po zakończeniu wybierz przycisk OK .

Nadaj przepływowi danych nazwę TransformFilms w okienku właściwości.

Na górnym pasku kanwy potoku przesuń suwak debugowania Przepływ danych. Tryb debugowania umożliwia interaktywne testowanie logiki transformacji względem dynamicznego klastra Spark. Przepływ danych klastry zajmują od 5 do 7 minut, a użytkownicy powinni najpierw włączyć debugowanie, jeśli planują wykonać Przepływ danych programowania. Aby uzyskać więcej informacji, zobacz Tryb debugowania.

Tworzenie logiki przekształcania na kanwie przepływu danych

Po utworzeniu przepływu danych nastąpi automatyczne wysłanie do kanwy przepływu danych. W tym kroku utworzysz przepływ danych, który pobiera plik moviesDB.csv w usłudze Data Lake Storage i agreguje średnią ocenę komedii z 1910 do 2000 roku. Następnie zapiszesz ten plik z powrotem do usługi Data Lake Storage.

Dodawanie przekształcenia źródłowego

W tym kroku skonfigurujesz usługę Data Lake Storage Gen2 jako źródło.

Na kanwie przepływu danych dodaj źródło, wybierając pole Dodaj źródło .

Nazwij źródłową bazę danych MoviesDB. Wybierz pozycję Nowy , aby utworzyć nowy źródłowy zestaw danych.

Wybierz pozycję Azure Data Lake Storage Gen2, a następnie wybierz pozycję Kontynuuj.

Wybierz pozycję RozdzielanyTekst, a następnie wybierz pozycję Kontynuuj.

Nadaj zestawowi danych nazwę MoviesDB. Z listy rozwijanej połączona usługa wybierz pozycję Nowy.

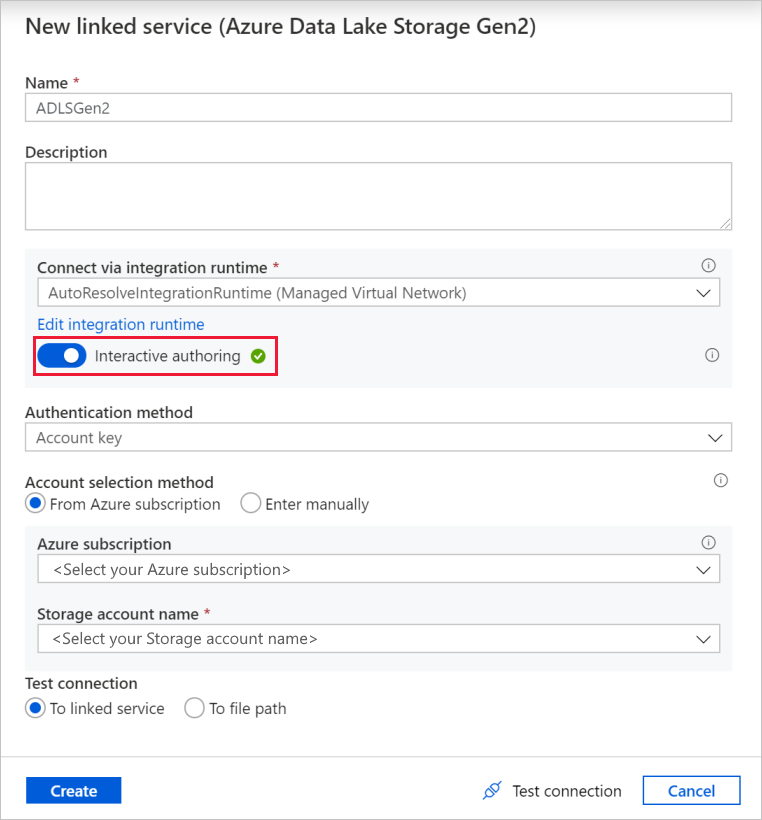

Na ekranie tworzenia połączonej usługi nazwij połączoną usługę ADLSGen2 usługi Data Lake Storage Gen2 i określ metodę uwierzytelniania. Następnie wprowadź poświadczenia połączenia. W tym samouczku używamy klucza konta do nawiązywania połączenia z naszym kontem magazynu.

Upewnij się, że włączono tworzenie interakcyjne. Włączenie tej opcji może potrwać minutę.

Wybierz pozycję Testuj połączenie. Powinno to zakończyć się niepowodzeniem, ponieważ konto magazynu nie umożliwia dostępu do niego bez tworzenia i zatwierdzania prywatnego punktu końcowego. W komunikacie o błędzie powinien zostać wyświetlony link umożliwiający utworzenie prywatnego punktu końcowego, który można wykonać, aby utworzyć zarządzany prywatny punkt końcowy. Alternatywą jest przejście bezpośrednio do karty Zarządzanie i wykonanie instrukcji w tej sekcji w celu utworzenia zarządzanego prywatnego punktu końcowego.

Pozostaw otwarte okno dialogowe, a następnie przejdź do konta magazynu.

Postępuj zgodnie z instrukcjami w tej sekcji , aby zatwierdzić link prywatny.

Wróć do okna dialogowego. Wybierz ponownie pozycję Testuj połączenie i wybierz pozycję Utwórz , aby wdrożyć połączoną usługę.

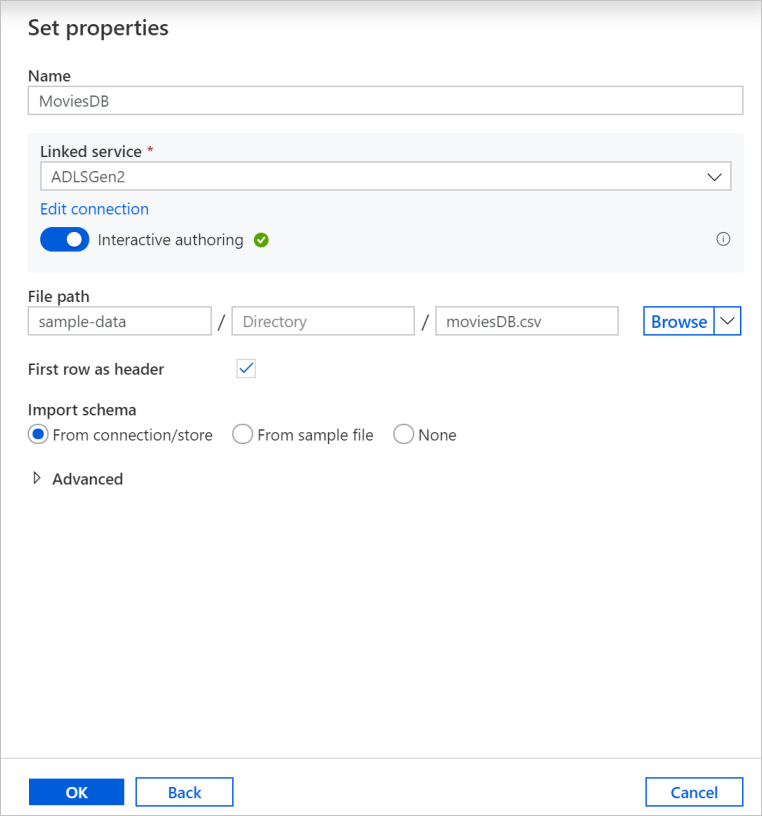

Na ekranie tworzenia zestawu danych wprowadź miejsce, w którym znajduje się plik w polu Ścieżka pliku. W tym samouczku plik moviesDB.csv znajduje się w przykładowych danych kontenera. Ponieważ plik ma nagłówki, zaznacz pole wyboru Pierwszy wiersz jako nagłówek . Wybierz pozycję Z połączenia/magazynu , aby zaimportować schemat nagłówka bezpośrednio z pliku w magazynie. Po zakończeniu wybierz przycisk OK .

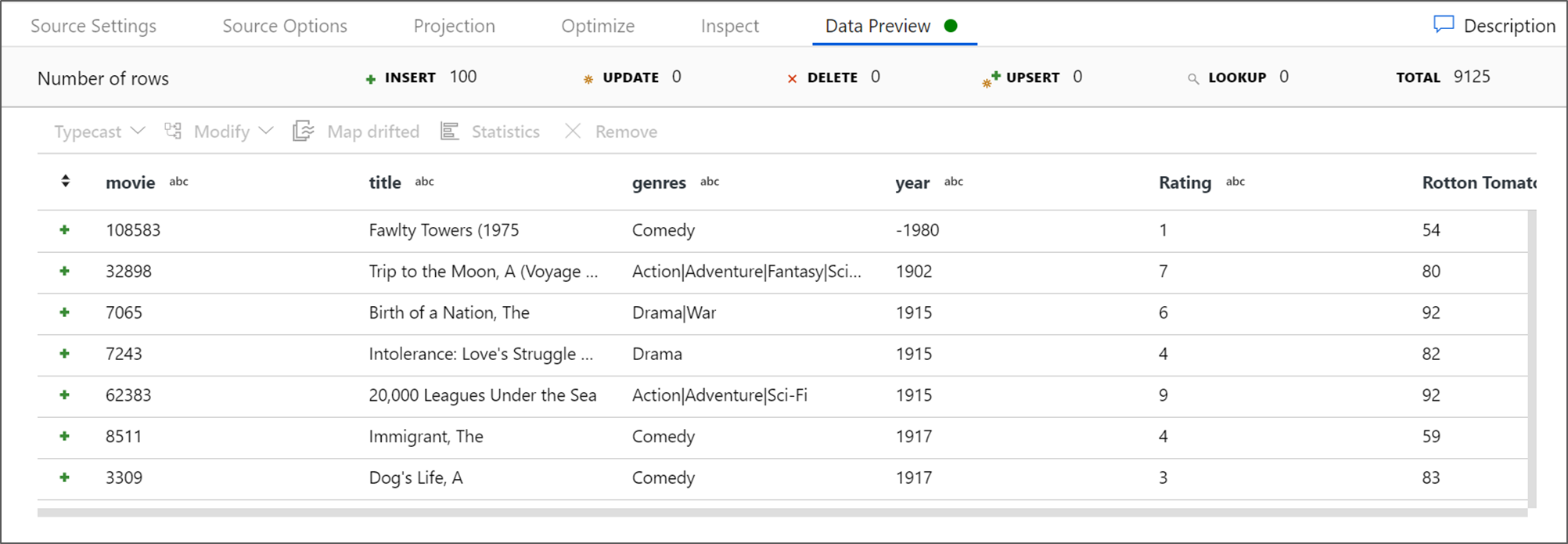

Jeśli klaster debugowania został uruchomiony, przejdź do karty Podgląd danych przekształcenia źródła i wybierz pozycję Odśwież , aby uzyskać migawkę danych. Możesz użyć podglądu danych, aby sprawdzić, czy transformacja jest poprawnie skonfigurowana.

Tworzenie zarządzanego prywatnego punktu końcowego

Jeśli nie użyto hiperlinku podczas testowania poprzedniego połączenia, postępuj zgodnie ze ścieżką. Teraz musisz utworzyć zarządzany prywatny punkt końcowy, który połączysz się z utworzoną usługą połączoną.

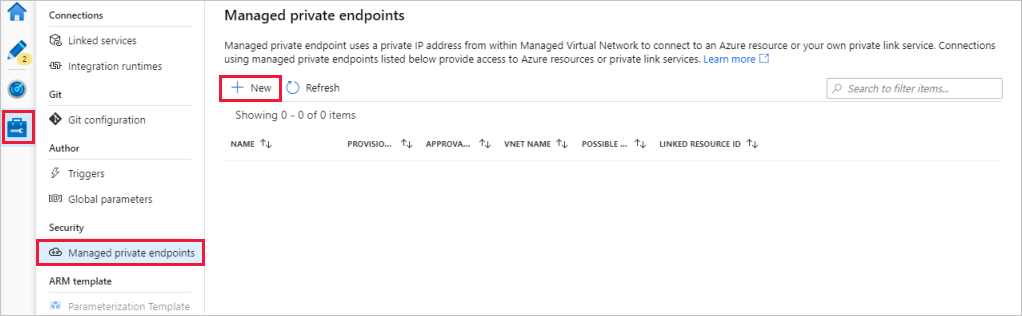

Przejdź do karty Zarządzanie .

Uwaga

Karta Zarządzanie może nie być dostępna dla wszystkich wystąpień usługi Data Factory. Jeśli nie widzisz tego punktu końcowego, możesz uzyskać dostęp do prywatnych punktów końcowych, wybierając pozycję Utwórz>>

Przejdź do sekcji Zarządzane prywatne punkty końcowe .

Wybierz pozycję + Nowy w obszarze Zarządzane prywatne punkty końcowe.

Wybierz kafelek Azure Data Lake Storage Gen2 z listy, a następnie wybierz pozycję Kontynuuj.

Wprowadź nazwę utworzonego konta magazynu.

Wybierz pozycję Utwórz.

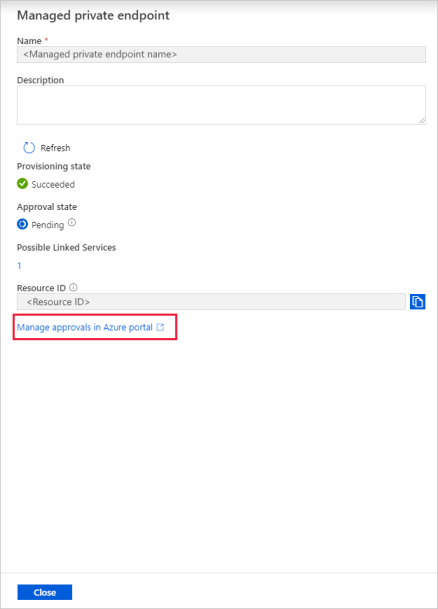

Po kilku sekundach powinno zostać wyświetlone, że utworzony link prywatny wymaga zatwierdzenia.

Wybierz utworzony prywatny punkt końcowy. Możesz zobaczyć hiperlink, który spowoduje zatwierdzenie prywatnego punktu końcowego na poziomie konta magazynu.

Zatwierdzanie łącza prywatnego na koncie magazynu

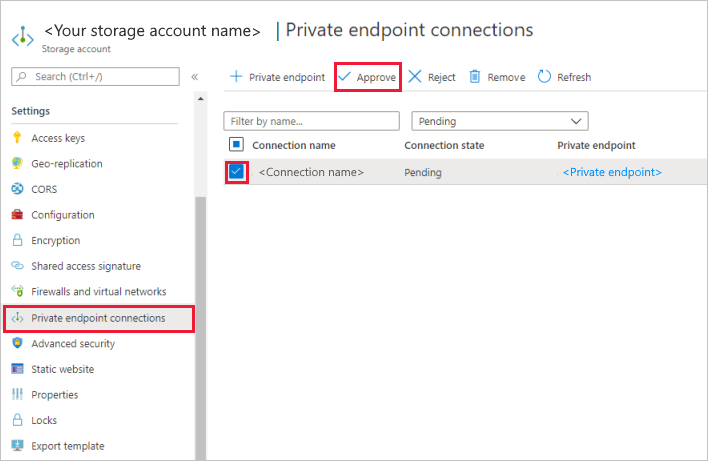

Na koncie magazynu przejdź do pozycji Połączenia prywatnego punktu końcowego w sekcji Ustawienia .

Zaznacz pole wyboru utworzonego prywatnego punktu końcowego, a następnie wybierz pozycję Zatwierdź.

Dodaj opis i wybierz pozycję Tak.

Wróć do sekcji Zarządzane prywatne punkty końcowe na karcie Zarządzanie w usłudze Data Factory.

Po około minucie powinno zostać wyświetlone zatwierdzenie dla prywatnego punktu końcowego.

Dodawanie przekształcenia filtru

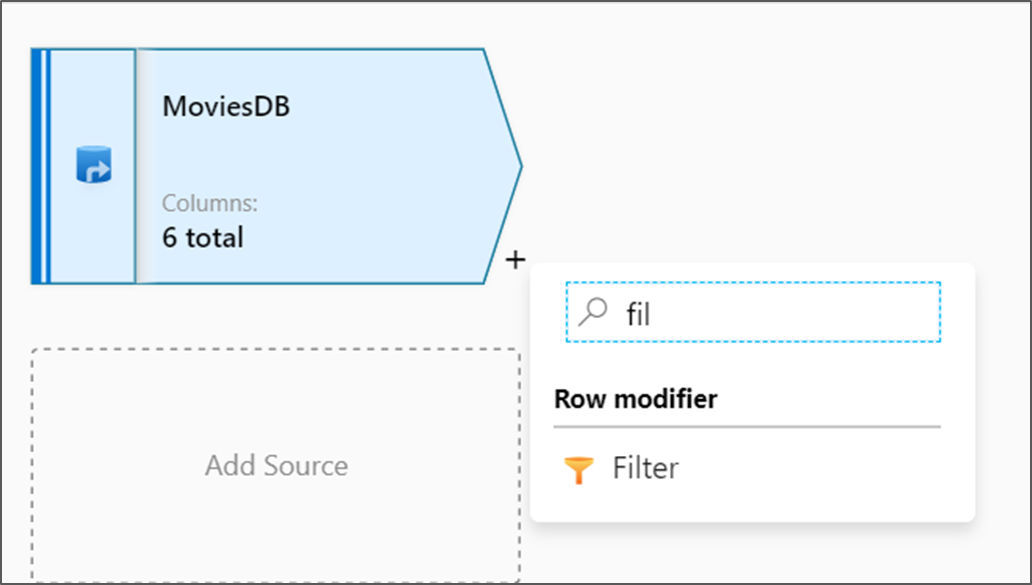

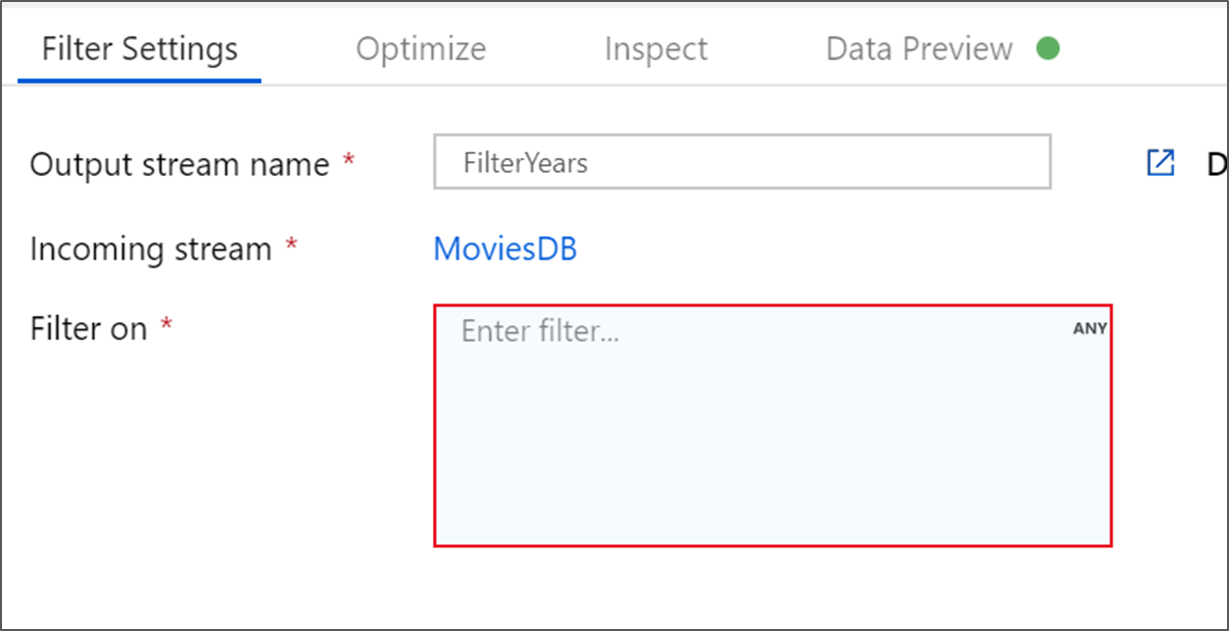

Obok węzła źródłowego na kanwie przepływu danych wybierz ikonę plusa, aby dodać nową transformację. Pierwszą dodaną transformacją jest filtr.

Nadaj transformacji filtrowi nazwę FilterYears. Wybierz pole wyrażenia obok pozycji Filtruj , aby otworzyć konstruktora wyrażeń. W tym miejscu określisz warunek filtrowania.

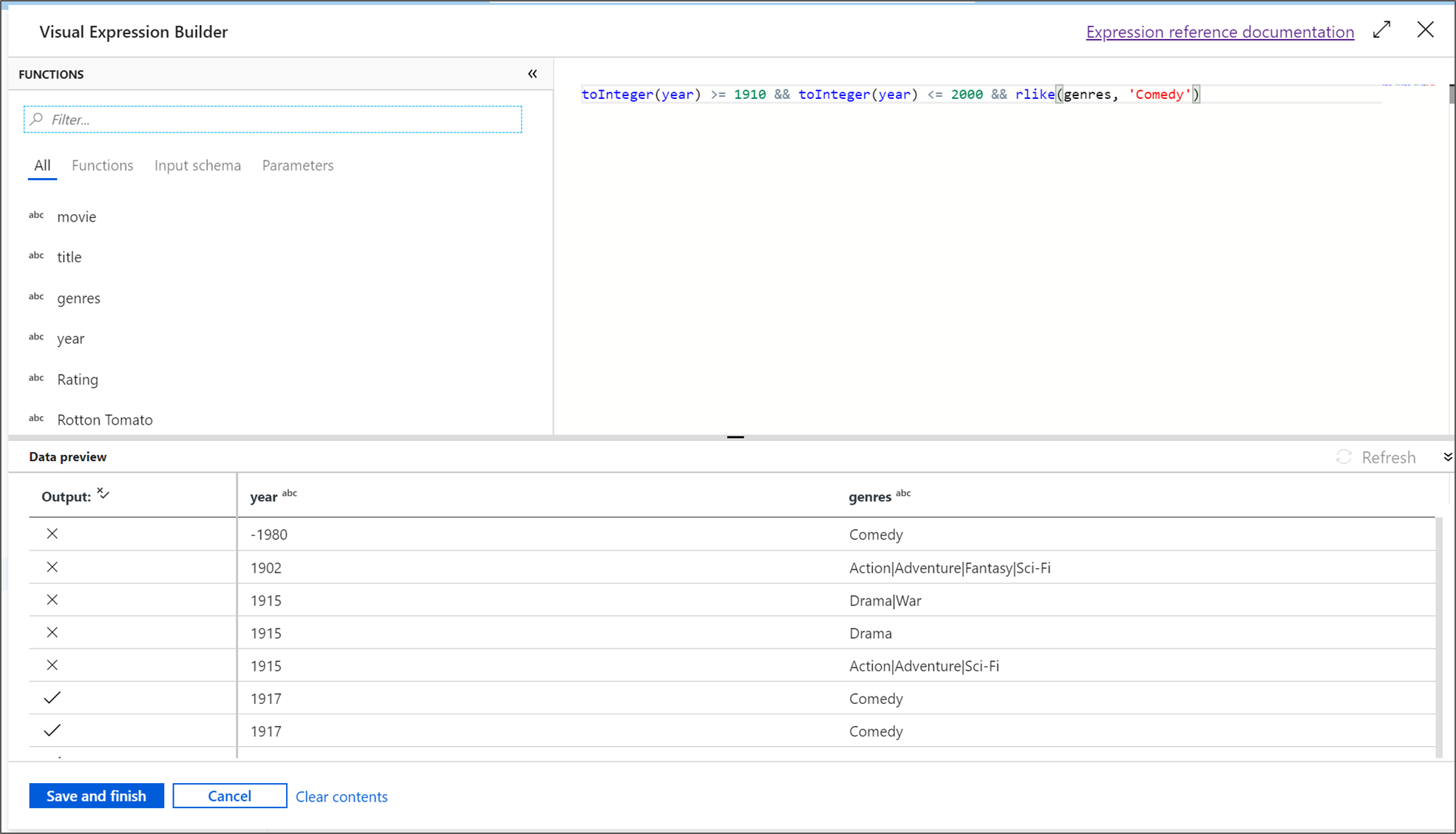

Konstruktor wyrażeń przepływu danych umożliwia interaktywne tworzenie wyrażeń używanych w różnych przekształceniach. Wyrażenia mogą zawierać wbudowane funkcje, kolumny ze schematu wejściowego i parametry zdefiniowane przez użytkownika. Aby uzyskać więcej informacji na temat tworzenia wyrażeń, zobacz Konstruktor wyrażeń przepływu danych.

W tym samouczku chcesz filtrować filmy w gatunku komediowym, który wyszedł między latami 1910 i 2000. Ponieważ rok jest obecnie ciągiem, należy przekonwertować go na liczbę całkowitą przy użyciu

toInteger()funkcji . Użyj operatorów większej lub równej (>=) i mniejszej lub równej (<=), aby porównać wartości roku literału 1910 i 2000. Połącz te wyrażenia razem z operatorem i (&&). Wyrażenie jest zwracane jako:toInteger(year) >= 1910 && toInteger(year) <= 2000Aby dowiedzieć się, które filmy są komediami, możesz użyć

rlike()funkcji , aby znaleźć wzorzec "Comedy" w gatunkach kolumn. Ujmij wyrażenie zrlikeporównaniem roku, aby uzyskać:toInteger(year) >= 1910 && toInteger(year) <= 2000 && rlike(genres, 'Comedy')Jeśli masz aktywny klaster debugowania, możesz zweryfikować logikę, wybierając pozycję Odśwież , aby wyświetlić dane wyjściowe wyrażenia w porównaniu z użytymi danymi wejściowymi. Istnieje więcej niż jedna właściwa odpowiedź na temat tego, jak można osiągnąć tę logikę przy użyciu języka wyrażeń przepływu danych.

Po zakończeniu pracy z wyrażeniem wybierz pozycję Zapisz i zakończ .

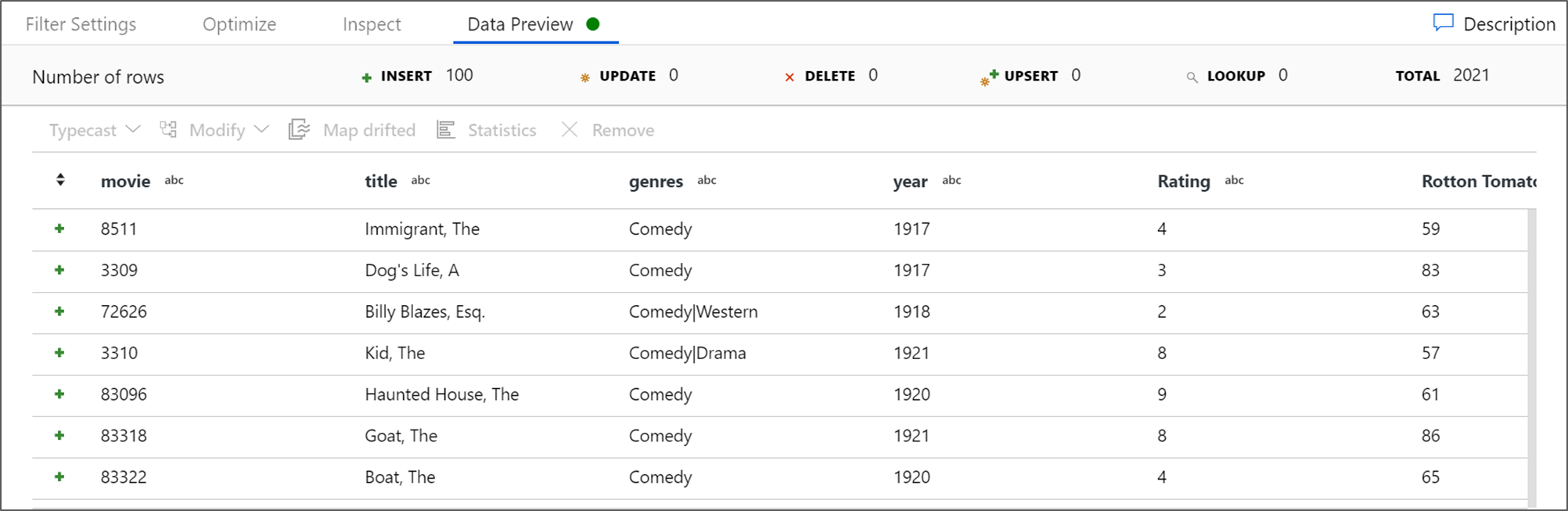

Pobierz podgląd danych, aby sprawdzić, czy filtr działa poprawnie.

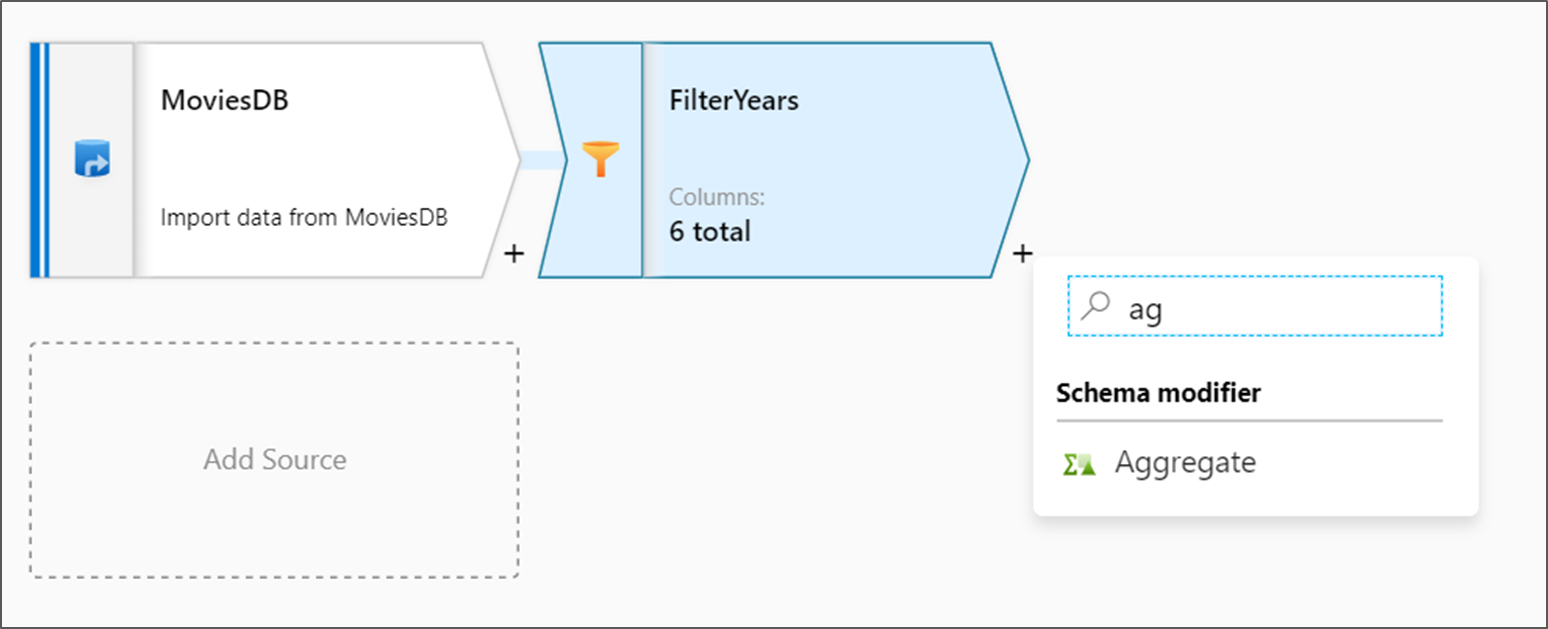

Dodawanie przekształcenia agregacji

Kolejną transformacją , którą dodasz, jest przekształcenie agregacji w obszarze Modyfikator schematu.

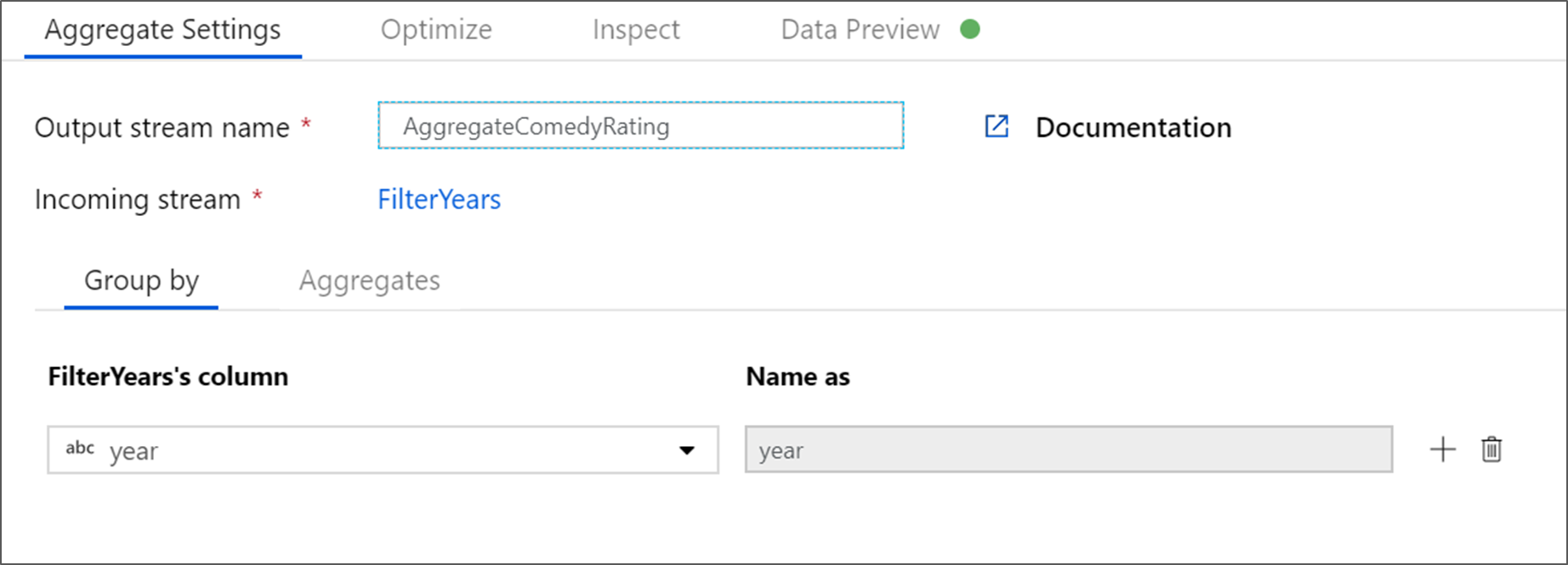

Nadaj agregacji nazwę AggregateComedyRating. Na karcie Grupuj według wybierz pozycję rok z listy rozwijanej, aby pogrupować agregacje według roku, w ramach których został wyświetlony film.

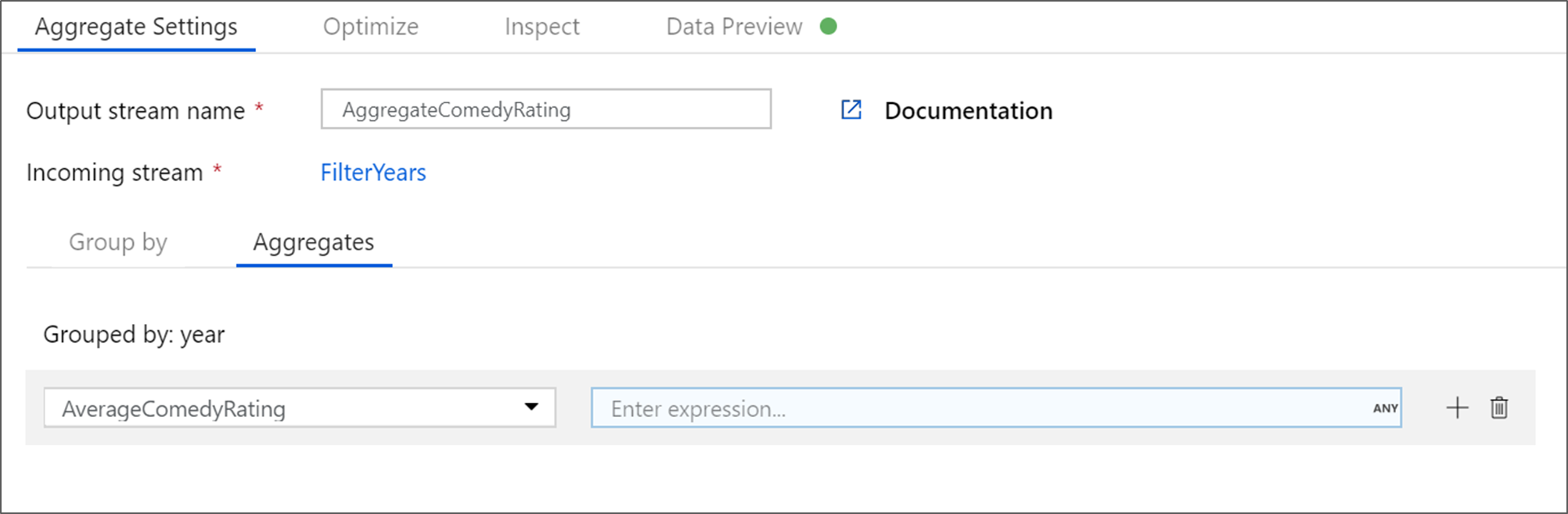

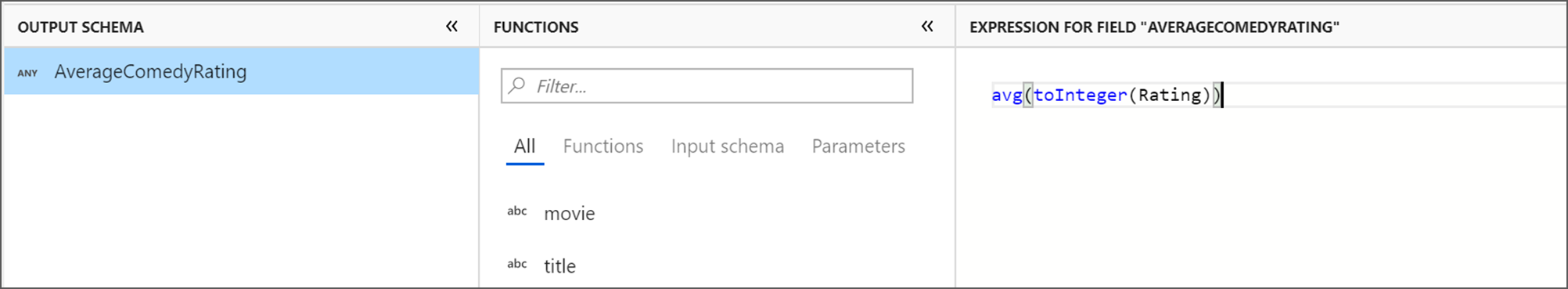

Przejdź do karty Agregacje . W polu tekstowym po lewej stronie nadaj kolumnie agregacji nazwę AverageComedyRating. Wybierz odpowiednie pole wyrażenia, aby wprowadzić wyrażenie agregacji za pomocą konstruktora wyrażeń.

Aby uzyskać średnią kolumny Ocena, użyj

avg()funkcji agregującej. Ponieważ ocena jest ciągiem iavg()przyjmuje dane wejściowe liczbowe, musimy przekonwertować wartość na liczbę za pośrednictwemtoInteger()funkcji. To wyrażenie wygląda następująco:avg(toInteger(Rating))Po zakończeniu wybierz pozycję Zapisz i zakończ .

Przejdź do karty Podgląd danych, aby wyświetlić dane wyjściowe przekształcenia. Zwróć uwagę, że istnieją tylko dwie kolumny: rok i AverageComedyRating.

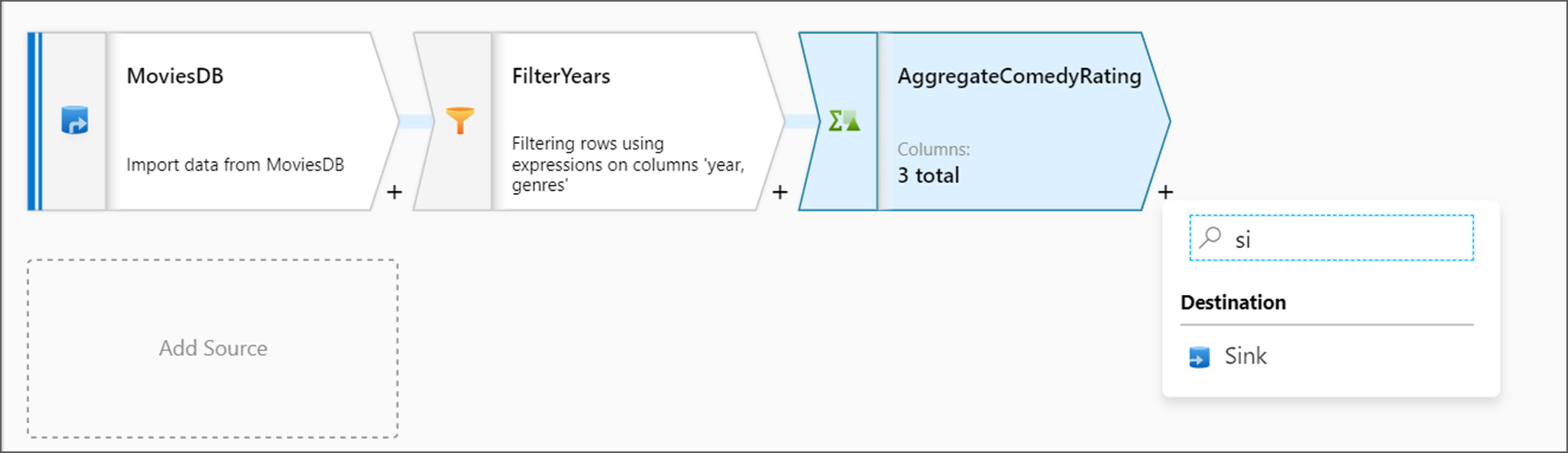

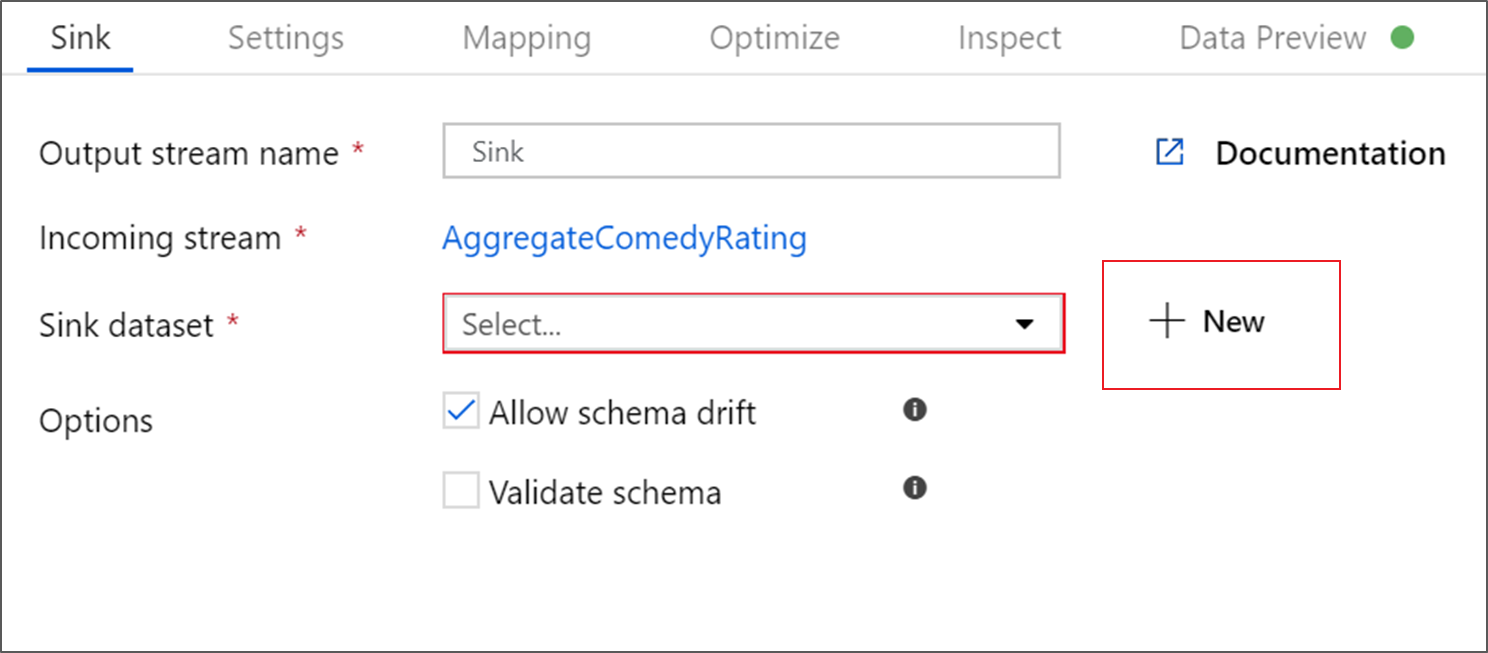

Dodawanie przekształcenia ujścia

Następnie chcesz dodać przekształcenie ujścia w obszarze Miejsce docelowe.

Nazwij ujście ujścia. Wybierz pozycję Nowy , aby utworzyć zestaw danych ujścia.

Na stronie Nowy zestaw danych wybierz pozycję Azure Data Lake Storage Gen2, a następnie wybierz pozycję Kontynuuj.

Na stronie Wybierz format wybierz pozycję RozdzielanyTekst , a następnie wybierz pozycję Kontynuuj.

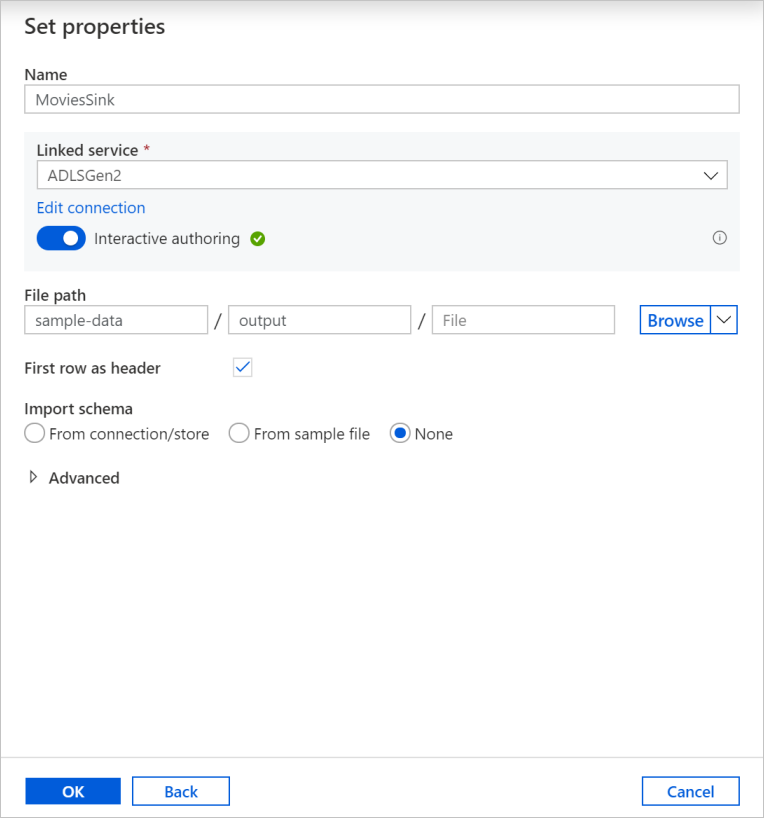

Nadaj zestawowi danych ujście nazwę MoviesSink. W przypadku połączonej usługi wybierz tę samą połączoną usługę ADLSGen2 utworzoną do przekształcania źródła. Wprowadź folder wyjściowy do zapisania danych. W tym samouczku zapisujemy dane wyjściowe folderu w danych przykładowych kontenera. Folder nie musi istnieć wcześniej i można go dynamicznie tworzyć. Zaznacz pole wyboru Pierwszy wiersz jako nagłówek i wybierz pozycję Brak w polu Importuj schemat. Wybierz przycisk OK.

Teraz zakończono tworzenie przepływu danych. Możesz go uruchomić w potoku.

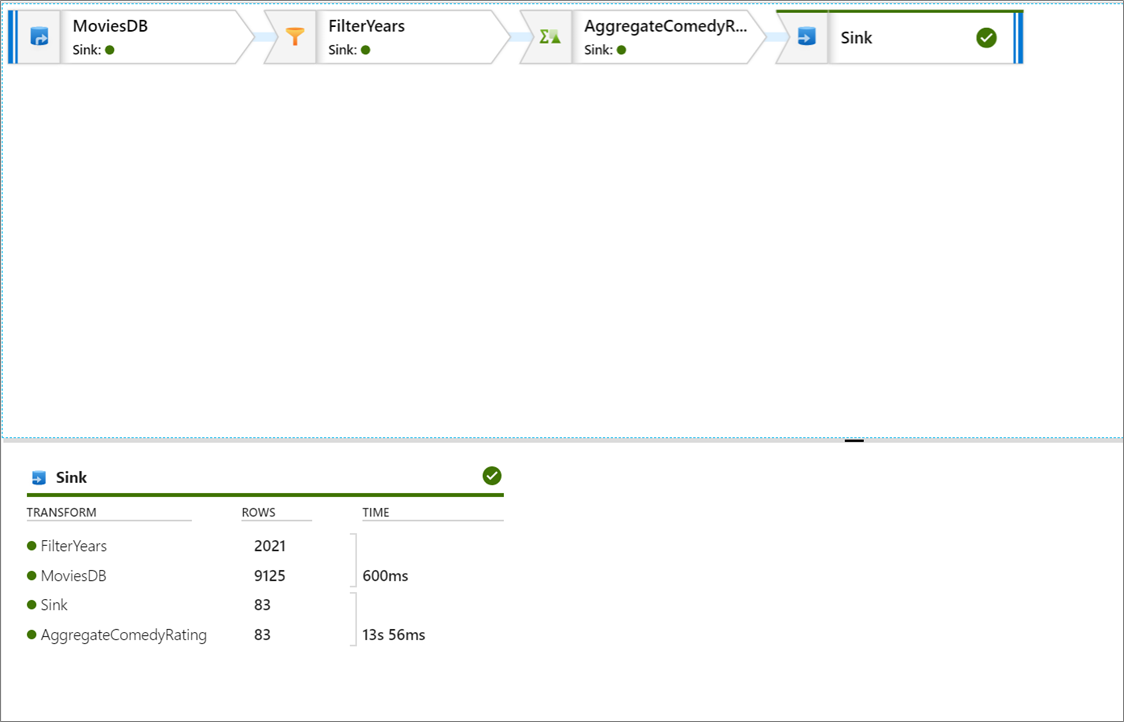

Uruchamianie i monitorowanie przepływu danych

Potok można debugować przed jego opublikowaniem. W tym kroku wyzwalasz przebieg debugowania potoku przepływu danych. Chociaż podgląd danych nie zapisuje danych, uruchomienie debugowania spowoduje zapisanie danych w miejscu docelowym ujścia.

Przejdź do kanwy potoku. Wybierz pozycję Debuguj , aby wyzwolić przebieg debugowania.

Debugowanie potoku działań przepływu danych używa aktywnego klastra debugowania, ale inicjowanie nadal trwa co najmniej minutę. Postęp można śledzić za pomocą karty Dane wyjściowe . Po pomyślnym zakończeniu przebiegu wybierz ikonę okularów, aby uzyskać szczegółowe informacje o przebiegu.

Na stronie szczegółów można zobaczyć liczbę wierszy i czas spędzony na każdym kroku transformacji.

Wybierz przekształcenie, aby uzyskać szczegółowe informacje o kolumnach i partycjonowaniu danych.

Jeśli wykonano czynności opisane w tym samouczku poprawnie, należy zapisać 83 wiersze i 2 kolumny w folderze ujścia. Możesz sprawdzić, czy dane są poprawne, sprawdzając magazyn obiektów blob.

Podsumowanie

W tym samouczku użyto interfejsu użytkownika usługi Data Factory do utworzenia potoku, który kopiuje i przekształca dane ze źródła usługi Data Lake Storage Gen2 do ujścia usługi Data Lake Storage Gen2 (zarówno zezwalając na dostęp do wybranych sieci) przy użyciu przepływu mapowania danych w zarządzanej sieci wirtualnej usługi Data Factory.