Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

DOTYCZY: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Wypróbuj usługę Data Factory w usłudze Microsoft Fabric — rozwiązanie analityczne typu all-in-one dla przedsiębiorstw. Usługa Microsoft Fabric obejmuje wszystko, od przenoszenia danych do nauki o danych, analizy w czasie rzeczywistym, analizy biznesowej i raportowania. Dowiedz się, jak bezpłatnie rozpocząć nową wersję próbną !

W świecie danych big data dane nieprzetworzone i niezorganizowane często są przechowywane w relacyjnych, nierelacyjnych i innych systemach magazynowania. Jednak same nieprzetworzone dane nie mają prawidłowego kontekstu ani znaczenia umożliwiającego zapewnienie istotnych informacji analitykom, specjalistom z zakresu danych i osobom podejmującym decyzje biznesowe.

Big data wymaga usługi, która umożliwia organizowanie i operacjonalizację procesów, aby przetworzyć te ogromne magazyny nieprzetworzonych danych na praktyczne wnioski biznesowe. Azure Data Factory to zarządzana usługa w chmurze, która została utworzona dla tych złożonych hybrydowych projektów wyodrębniania-transformacji-ładowania (ETL), wyodrębniania-ładowania-transformacji (ELT) oraz integracji danych.

Funkcje usługi Azure Data Factory

Kompresja danych: podczas działanie Kopiuj danych można skompresować dane i zapisać skompresowane dane do docelowego źródła danych. Ta funkcja ułatwia optymalizowanie użycia przepustowości podczas kopiowania danych.

Rozbudowana obsługa łączności dla różnych źródeł danych: usługa Azure Data Factory zapewnia szeroką obsługę łączności na potrzeby łączenia się z różnymi źródłami danych. Jest to przydatne, gdy chcesz ściągać lub zapisywać dane z różnych źródeł danych.

Niestandardowe wyzwalacze zdarzeń: usługa Azure Data Factory umożliwia automatyzowanie przetwarzania danych przy użyciu niestandardowych wyzwalaczy zdarzeń. Ta funkcja umożliwia automatyczne wykonywanie określonej akcji w przypadku wystąpienia określonego zdarzenia.

Podgląd i walidacja danych: podczas aktywności Kopiuj dane dostępne są narzędzia do wyświetlania podglądu i sprawdzania poprawności danych. Ta funkcja pomaga upewnić się, że dane są poprawnie kopiowane i zapisywane w docelowym źródle danych.

Konfigurowalne przepływy danych: usługa Azure Data Factory umożliwia tworzenie konfigurowalnych przepływów danych. Ta funkcja umożliwia dodawanie niestandardowych akcji lub kroków przetwarzania danych.

Zintegrowane zabezpieczenia: Usługa Azure Data Factory oferuje zintegrowane funkcje zabezpieczeń, takie jak integracja identyfikatora Entra i kontrola dostępu oparta na rolach w celu kontrolowania dostępu do przepływów danych. Ta funkcja zwiększa bezpieczeństwo przetwarzania danych i chroni dane.

Scenariusze użycia

Przykładowo wyobraź sobie, że firma zajmująca się grami gromadzi petabajty dzienników gier, które są tworzone przez gry w chmurze. Firma chce analizować te dzienniki w celu uzyskania wglądu w preferencje klientów, dane demograficzne i zachowania związane z użyciem. Dzięki temu firma będzie mogła identyfikować możliwości rozszerzania oferty i sprzedaży wiązanej, opracowywać nowe atrakcyjne funkcje, stymulować rozwój biznesu i oferować klientom lepsze doświadczenia.

Do analizy tych dzienników firma musi użyć danych referencyjnych, np. informacji o kliencie, grze i kampanii marketingowej, które znajdują się w lokalnym magazynie danych. Firma chce korzystać z tych danych z lokalnego magazynu danych, łącząc je z dodatkowymi danymi dzienników znajdującymi się w magazynie danych w chmurze.

Aby wyodrębnić szczegółowe informacje, ma nadzieję przetworzyć dołączone dane przy użyciu klastra Spark w chmurze (Azure HDInsight) i opublikować przekształcone dane w magazynie danych w chmurze, takim jak usługa Azure Synapse Analytics, aby łatwo utworzyć raport na jego podstawie. Firma chce zautomatyzować ten przepływ pracy oraz monitorować go i zarządzać nim zgodnie z codziennym harmonogramem. Chcą również wykonać go, gdy pliki pojawią się w kontenerze magazynu blobów.

Azure Data Factory to platforma, która umożliwia pracę z takimi scenariuszami danych. Jest to oparta na chmurze usługa ETL i integracji danych, która umożliwia tworzenie opartych na danych przepływów pracy do organizowania przenoszenia danych i przekształcania danych na dużą skalę. Za pomocą usługi Azure Data Factory można tworzyć oparte na danych przepływy pracy (nazywane potokami) i ustalać ich harmonogram. Możesz tworzyć złożone procesy ETL, które przekształcają dane wizualnie za pomocą przepływów danych lub przy użyciu usług obliczeniowych, takich jak Azure HDInsight Hadoop, Azure Databricks i Azure SQL Database.

Ponadto możesz opublikować przekształcone dane w magazynach danych, takich jak Azure Synapse Analytics, aby mogły być używane przez aplikacje analizy biznesowej (BI). Ostatecznie dzięki usłudze Azure Data Factory nieprzetworzone dane mogą być organizowane w praktyczne repozytoria i jeziora danych ułatwiające podejmowanie lepszych decyzji biznesowych.

Jak to działa?

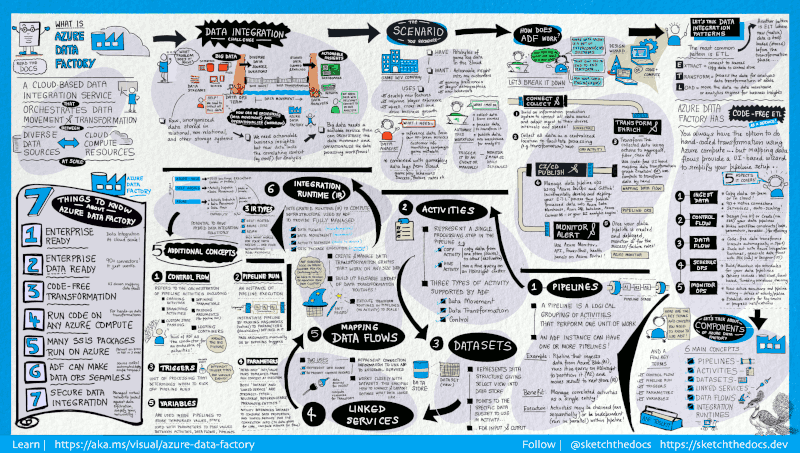

Usługa Data Factory zawiera szereg połączonych systemów, które tworzą kompleksową platformę dla inżynierów danych.

Ten przewodnik wizualny zawiera szczegółowe omówienie pełnej architektury usługi Data Factory:

Aby wyświetlić więcej szczegółów, wybierz powyższy obraz, aby powiększyć, lub przejdź do obrazu o wysokiej rozdzielczości. Dowiedz się więcej na temat opracowywania tego przewodnika wizualnego i szkicu projektu dokumentacji tutaj.

Łączenie i zbieranie

Przedsiębiorstwa dysponują danymi różnych typów, znajdującymi się w różnych magazynach lokalnych i w chmurze, ze strukturą pełną i częściową, przychodzącymi w różnych interwałach i w różnym tempie.

Pierwszy krok tworzenia systemu uzyskiwania informacji polega na połączeniu wszystkich wymaganych źródeł danych i systemów przetwarzania, takich jak usługi SaaS, bazy danych, udziały plików oraz internetowe usługi FTP. Następnym krokiem jest przeniesienie danych w miarę potrzeb do centralnej lokalizacji w celu ich dalszego przetwarzania.

Firmy, które nie korzystają z usługi Data Factory, muszą tworzyć niestandardowe składniki umożliwiające przepływ danych lub projektować własne usługi, aby zintegrować źródła danych i systemy przetwarzania. Takie podejście jest kosztowne, a integracja i utrzymanie systemów stwarza trudności. Ponadto rozwiązanie to rzadko zapewnia mechanizmy kontrolne oraz funkcje monitorowania i wysyłania alertów na poziomie korporacyjnym. Możliwości te są natomiast dostępne w przypadku w pełni zarządzanej usługi.

Usługa Data Factory udostępnia działanie kopiowania w potoku danych, które pozwala przenosić dane z lokalnych magazynów danych i źródeł danych w chmurze do centralnego magazynu danych w chmurze w celu przeprowadzenia kolejnych etapów analizy. Możesz na przykład zbierać dane w usłudze Azure Data Lake Storage i przekształcać je później przy użyciu usługi obliczeniowej Azure Data Lake Analytics. Można też pobrać dane z usługi Azure Blob Storage, aby przekształcić je później przy użyciu klastra usługi Azure HDInsight na platformie Hadoop.

Przekształcanie i wzbogacanie

Po umieszczeniu danych w scentralizowanym magazynie danych w chmurze, przetwarzaj lub przekształcaj zebrane dane za pomocą przepływów danych ADF. Przepływy danych umożliwiają inżynierom danych tworzenie i konserwowanie wykresów przekształcania danych wykonywanych na platformie Spark bez konieczności zrozumienia klastrów Spark lub programowania platformy Spark.

Jeśli wolisz ręcznie przekształcać kod, usługa ADF obsługuje działania zewnętrzne do wykonywania przekształceń w usługach obliczeniowych, takich jak HDInsight Hadoop, Spark, Data Lake Analytics i Machine Learning.

CI/CD i publikowanie

Usługa Data Factory oferuje pełne wsparcie dla CI/CD potoków danych przy użyciu usług Azure DevOps i GitHub. Dzięki temu można stopniowo opracowywać i dostarczać procesy ETL przed opublikowaniem gotowego produktu. Po przetworzeniu danych pierwotnych do postaci gotowej do użycia w działalności biznesowej, załaduj dane do usługi Azure Data Warehouse, Azure SQL Database, Azure Cosmos DB lub dowolnego aparatu analitycznego, na który użytkownicy biznesowi mogą wskazać przy użyciu swoich narzędzi analizy biznesowej.

Monitor

Po pomyślnym zbudowaniu i wdrożeniu potoku integracji danych, dostarczając wartość biznesową z przetworzonych danych, monitoruj zaplanowane działania i potoki pod kątem współczynników sukcesu i porażki. Usługa Azure Data Factory dysponuje wbudowaną obsługą monitorowania potoków przy użyciu narzędzi Azure Monitor, API, PowerShell, dzienników usługi Azure Monitor i paneli kondycji w witrynie Azure Portal.

Koncepcje najwyższego poziomu

Subskrypcja platformy Azure może zawierać jedno lub więcej wystąpień usługi Azure Data Factory (lub fabryk danych). Usługa Azure Data Factory składa się z następujących kluczowych składników:

- Pipelines

- Działania

- Zestawy danych

- Połączone usługi

- Przepływy danych

- Środowiska uruchomieniowe integracji

Ich współdziałanie pozwala udostępnić platformę umożliwiającą tworzenie opartych na danych przepływów pracy wraz z etapami służącymi do przenoszenia i przekształcania danych.

rurociąg

Fabryka danych może mieć jeden lub więcej potoków. Potok przetwarzania danych to logiczne grupowanie działań, które wykonują jednostkowe zadanie. Działania w rurociągu razem wykonują zadanie. Na przykład potok może zawierać grupę działań, które pozyskują dane z usługi Azure Blob, a następnie uruchamiają zapytanie Hive w klastrze HDInsight w celu partycjonowania danych.

Zaletą zastosowania pipeline'a jest możliwość zarządzania działaniami jako zestawem, zamiast zarządzać każdą czynnością osobno. Działania w potoku można połączyć w łańcuch, aby działały sekwencyjnie lub działać niezależnie.

Mapowanie przepływu danych

Tworzenie grafów logiki przekształcania danych i zarządzanie nimi, których można użyć do przekształcania danych o dowolnym rozmiarze. Możesz zbudować bibliotekę procedur przekształcania danych, która będzie wielokrotnego użytku, i uruchamiać te procesy w rozproszony sposób z poziomu potoków ADF. Usługa Data Factory wykona logikę w klastrze Spark, który uruchamia się i zatrzymuje, kiedy jest potrzebny. Nigdy nie trzeba zarządzać ani obsługiwać klastrów.

Działanie

Działania reprezentują krok przetwarzania w przepływie pracy. Można na przykład użyć działania kopiowania w celu skopiowania danych z jednego magazynu danych do drugiego. Podobnie można użyć działania programu Hive, które uruchomi zapytanie programu Hive w klastrze usługi Azure HDInsight, aby przekształcić lub przeanalizować dane. Usługa Data Factory obsługuje trzy typy działań: działania przenoszenia danych, działania przekształcania danych i działania sterowania.

Zestawy danych

Zestawy danych reprezentują struktury w magazynach danych. Struktury te po prostu wskazują na dane, które mają być używane w działaniach jako dane wejściowe lub wyjściowe.

Połączone usługi

Połączone usługi działają podobnie do parametrów połączenia, umożliwiając definiowanie informacji wymaganych przez usługę Data Factory do nawiązywania połączeń z zasobami zewnętrznymi. Mechanizm ten działa następująco: połączona usługa zawiera definicję połączenia ze źródłem danych, a zestaw danych reprezentuje strukturę danych. Na przykład połączona usługa Azure Storage określa parametry połączenia w celu nawiązania połączenia z kontem usługi Azure Storage. Natomiast zestaw danych usługi Azure Blob określa kontener obiektów blob oraz folder, który zawiera dane.

Połączone usługi w usłudze Fabryka danych służą do dwóch celów:

Aby reprezentować magazyn danych obejmujący, ale nie ograniczający się do bazy danych SQL Server, bazy danych Oracle, udostępniania plików lub konta usługi Azure Blob Storage. Listę obsługiwanych magazynów danych zamieszczono w artykule na temat działania kopiowania.

Reprezentowanie zasobu obliczeniowego, który może hostować wykonywanie działania. Na przykład działanie HDInsightHive jest wykonywane w klastrze HDInsight na platformie Hadoop. Listę działań przekształcania i obsługiwanych środowisk obliczeniowych zamieszczono w artykule dotyczącym przekształcania danych.

Integration Runtime

W usłudze Data Factory działanie definiuje akcję do wykonania. Połączona usługa definiuje docelowy magazyn danych lub usługę obliczeniową. Środowisko Integration Runtime zapewnia most między działaniem a połączonymi usługami. Odwołuje się do niej połączona usługa lub działanie i udostępnia środowisko obliczeniowe, w którym działanie jest uruchamiane lub wysyłane. Dzięki temu działanie można wykonać w regionie najbliższym docelowemu magazynowi danych lub usłudze obliczeniowej, w sposób najbardziej wydajny, jednocześnie spełniając wymagania dotyczące zabezpieczeń i zgodności.

Wyzwalacze

Wyzwalacze reprezentują jednostkę przetwarzania, która określa, kiedy należy uruchomić wykonanie potoku. Istnieją różne typy wyzwalaczy dla różnych typów zdarzeń.

Uruchomienia potoków

Uruchomienie potoku jest wystąpieniem wykonywania potoku. Inicjacje potoków są zwykle realizowane przez przekazanie argumentów do parametrów zdefiniowanych w potokach. Argumenty można przekazać ręcznie lub w ramach definicji wyzwalacza.

Parametry

Parametry to pary klucz-wartość w konfiguracji przeznaczonej tylko do odczytu. Parametry są definiowane w rurociągu. Argumenty dla zdefiniowanych parametrów są przekazywane podczas wykonania z kontekstu uruchomienia, który został stworzony przez wyzwalacz lub potok wykonany ręcznie. Działania w rurze używają wartości parametrów.

Zestaw danych to silnie typizowany parametr oraz obiekt wielokrotnego użytku, do którego można się odwoływać. Działanie może odwoływać się do zestawów danych oraz wykorzystywać właściwości określone w definicji zestawu danych.

Połączona usługa to również silnie typizowany parametr zawierający informacje o połączeniu z magazynem danych lub środowiskiem obliczeniowym. Również jest to obiekt wielokrotnego użytku, do którego można się odwoływać.

Sterowanie przebiegiem

Koordynacja przepływu sterowania to zestawienie działań potoku, które obejmuje łączenie działań w sekwencji, rozgałęzianie, definiowanie parametrów na poziomie potoku oraz przekazywanie argumentów podczas wywoływania potoku według potrzeby lub z wyzwalacza. Obejmuje również kontenery przekazujące stan niestandardowy i kontenery do iteracji, czyli iteratory typu For-each.

Variables

Zmienne mogą być używane wewnątrz potoków do przechowywania wartości tymczasowych i mogą być również używane w połączeniu z parametrami, aby umożliwić przekazywanie wartości między potokami, przepływami danych i innymi działaniami.

Powiązana zawartość

Oto ważne dokumenty dotyczące następnego kroku do zbadania:

- Dataset and linked services (Zestaw danych i połączone usługi)

- Linie i działania

- Integration Runtime

- Mapowanie przepływów danych

- Interfejs użytkownika usługi Data Factory w witrynie Azure Portal

- Narzędzie do kopiowania danych w witrynie Azure Portal

- PowerShell

- .NET

- Python

- REST

- Szablon usługi Azure Resource Manager