Co to jest Połączenie usługi Databricks?

Uwaga

W tym artykule opisano Połączenie databricks dla środowiska Databricks Runtime 13.0 lub nowszego.

Aby uzyskać informacje o starszej wersji usługi Databricks Połączenie, zobacz Databricks Połączenie for Databricks Runtime 12.2 LTS i poniżej.

- Aby pominąć ten artykuł i rozpocząć korzystanie z usługi Databricks Połączenie dla języka Python od razu, zobacz Databricks Połączenie dla języka Python.

- Aby pominąć ten artykuł i rozpocząć korzystanie z usługi Databricks Połączenie dla języka R od razu, zobacz Databricks Połączenie dla języka R.

- Aby pominąć ten artykuł i rozpocząć korzystanie z usługi Databricks Połączenie dla języka Scala od razu, zobacz Databricks Połączenie dla języka Scala.

Omówienie

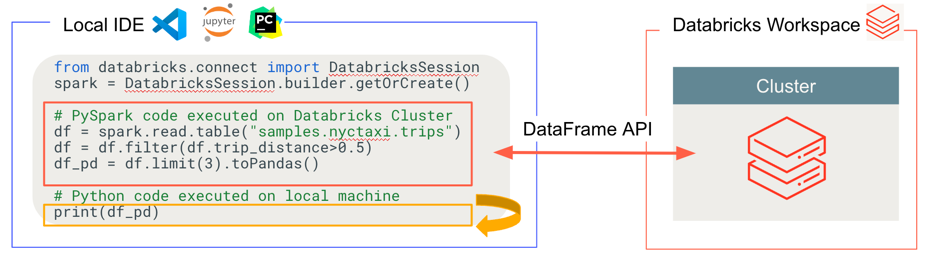

Usługa Databricks Połączenie umożliwia łączenie popularnych środowisk IDE, takich jak Visual Studio Code, PyCharm, RStudio Desktop, IntelliJ IDEA, serwery notesów i inne niestandardowe aplikacje do klastrów usługi Azure Databricks. W tym artykule wyjaśniono, jak działa Połączenie usługi Databricks.

Usługa Databricks Połączenie to biblioteka kliencka środowiska Databricks Runtime. Umożliwia pisanie kodu przy użyciu interfejsów API platformy Spark i zdalne uruchamianie ich w klastrze usługi Azure Databricks zamiast w lokalnej sesji platformy Spark.

Na przykład po uruchomieniu polecenia spark.read.format(...).load(...).groupBy(...).agg(...).show() DataFrame przy użyciu usługi Databricks Połączenie logiczna reprezentacja polecenia jest wysyłana do serwera Spark uruchomionego w usłudze Azure Databricks do wykonania w klastrze zdalnym.

Usługa Databricks Połączenie umożliwia:

Uruchamianie kodu Spark na dużą skalę z dowolnej aplikacji Python, R lub Scala. W dowolnym miejscu, w którym można

import pysparkużywać języka Python,library(sparklyr)języka R lubimport org.apache.sparkjęzyka Scala, możesz teraz uruchamiać kod spark bezpośrednio z aplikacji bez konieczności instalowania wtyczek IDE ani używania skryptów przesyłania platformy Spark.Uwaga

Usługa Databricks Połączenie dla środowiska Databricks Runtime 13.0 lub nowszego obsługuje uruchamianie aplikacji języka Python. Języki R i Scala są obsługiwane tylko w usłudze Databricks Połączenie dla środowiska Databricks Runtime 13.3 LTS i nowszych.

Wykonaj kroki i debuguj kod w środowisku IDE nawet podczas pracy z klastrem zdalnym.

Szybkie iterowanie podczas tworzenia bibliotek. Nie trzeba ponownie uruchamiać klastra po zmianie zależności biblioteki Języka Python lub Scala w usłudze Databricks Połączenie, ponieważ każda sesja klienta jest odizolowana od siebie w klastrze.

Zamknij bezczynne klastry bez utraty pracy. Ponieważ aplikacja kliencka jest oddzielona od klastra, nie ma to wpływu na ponowne uruchomienia klastra lub uaktualnienia, co zwykle spowodowałoby utratę wszystkich zmiennych, RDD i obiektów ramki danych zdefiniowanych w notesie.

W przypadku środowiska Databricks Runtime 13.3 LTS lub nowszego usługa Databricks Połączenie jest teraz oparta na platformie Spark typu open source Połączenie. Platforma Spark Połączenie wprowadza oddzieloną architekturę client-server dla platformy Apache Spark, która umożliwia zdalną łączność z klastrami Spark przy użyciu interfejsu API ramki danych i nierozwiązanych planów logicznych jako protokołu. Dzięki tej architekturze "V2" opartej na platformie Spark Połączenie usługa Databricks Połączenie staje się cienkim klientem, który jest prosty i łatwy w użyciu. Połączenie platformy Spark można osadzać wszędzie, aby łączyć się z usługą Azure Databricks: w środowiskach IDE, notesach i aplikacjach, co umożliwia poszczególnym użytkownikom i partnerom tworzenie nowych (interaktywnych) środowisk użytkownika na podstawie platformy Databricks. Aby uzyskać więcej informacji na temat platformy Spark Połączenie, zobacz Introducing Spark Połączenie (Wprowadzenie do platformy Spark Połączenie).

Usługa Databricks Połączenie określa miejsce uruchamiania i debugowania kodu, jak pokazano na poniższej ilustracji.

W przypadku uruchamiania kodu: cały kod jest uruchamiany lokalnie, a cały kod obejmujący operacje ramki danych jest uruchamiany w klastrze w zdalnym obszarze roboczym usługi Azure Databricks i są wysyłane z powrotem do lokalnego obiektu wywołującego.

W przypadku kodu debugowania: cały kod jest debugowany lokalnie, podczas gdy cały kod Spark nadal działa w klastrze w zdalnym obszarze roboczym usługi Azure Databricks. Nie można debugować podstawowego kodu aparatu Spark bezpośrednio z klienta.

Następne kroki

- Aby rozpocząć tworzenie rozwiązań usługi Databricks Połączenie przy użyciu języka Python, zacznij od samouczka dotyczącego usługi Databricks Połączenie for Python.

- Aby rozpocząć tworzenie rozwiązań usługi Databricks Połączenie za pomocą języka R, zacznij od samouczka dotyczącego usługi Databricks Połączenie for R.

- Aby rozpocząć opracowywanie rozwiązań usługi Databricks Połączenie za pomocą języka Scala, zacznij od samouczka dotyczącego usługi Databricks Połączenie for Scala.