Co to jest odpowiedzialna sztuczna inteligencja?

DOTYCZY: Rozszerzenie interfejsu wiersza polecenia platformy Azure w wersji 2 (current)

Rozszerzenie interfejsu wiersza polecenia platformy Azure w wersji 2 (current) Zestaw PYTHON SDK azure-ai-ml v2 (bieżąca)

Zestaw PYTHON SDK azure-ai-ml v2 (bieżąca)

Odpowiedzialne sztuczna inteligencja (Responsible AI) to podejście do opracowywania, oceniania i wdrażania systemów sztucznej inteligencji w bezpieczny, godny zaufania i etyczny sposób. Systemy sztucznej inteligencji są produktem wielu decyzji podejmowanych przez tych, którzy je opracowują i wdrażają. Od celu systemu po sposób, w jaki ludzie wchodzą w interakcje z systemami sztucznej inteligencji, odpowiedzialne użycie sztucznej inteligencji może pomóc aktywnie kierować tymi decyzjami w kierunku bardziej korzystnych i sprawiedliwych wyników. Oznacza to utrzymanie ludzi i ich celów w centrum decyzji projektowych systemu i przestrzeganie trwałych wartości, takich jak sprawiedliwość, niezawodność i przejrzystość.

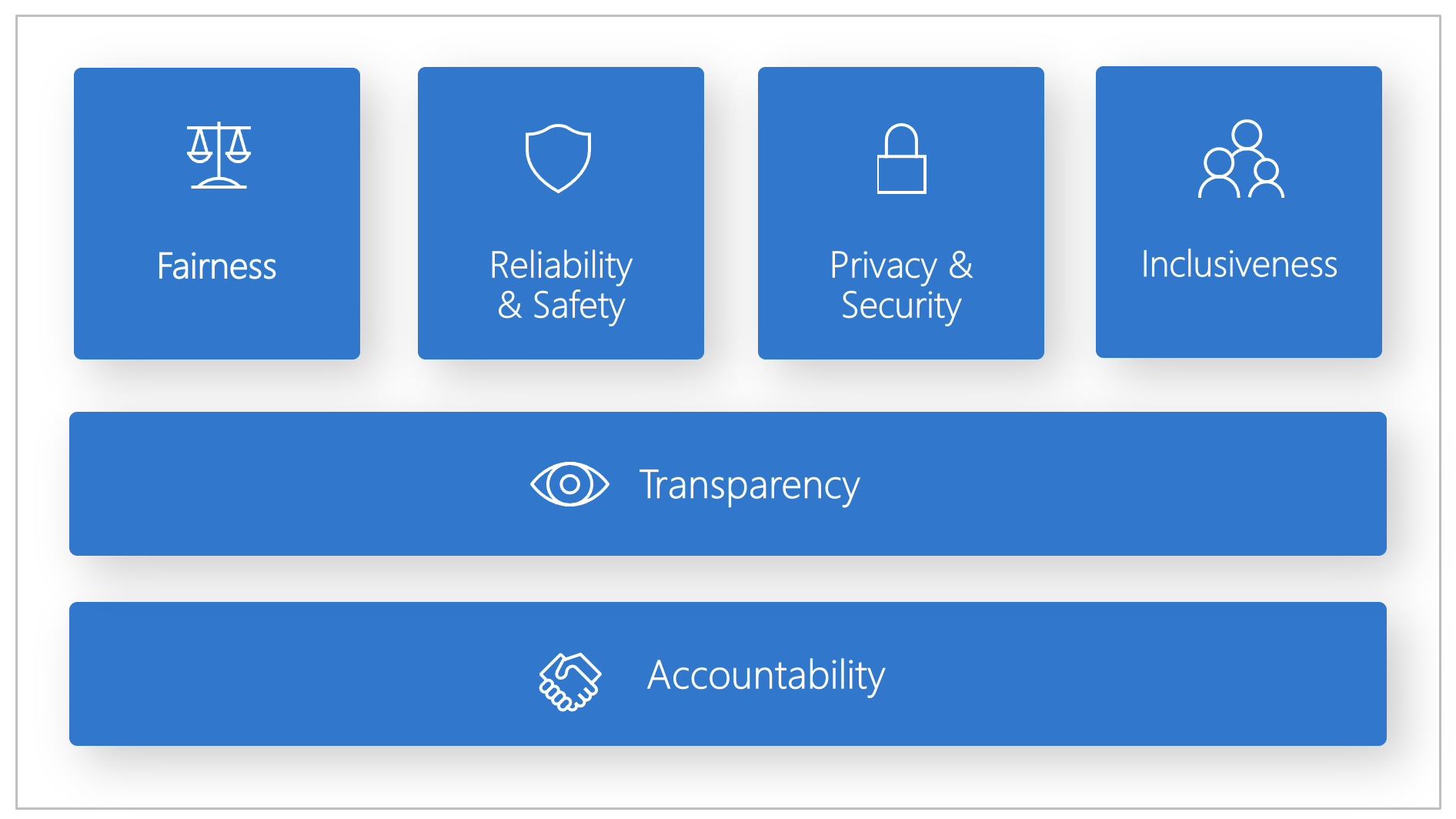

Firma Microsoft opracowała standard odpowiedzialnej sztucznej inteligencji. Jest to struktura tworzenia systemów sztucznej inteligencji zgodnie z sześcioma zasadami: sprawiedliwość, niezawodność i bezpieczeństwo, prywatność i bezpieczeństwo, inkluzywność, przejrzystość i odpowiedzialność. W przypadku firmy Microsoft te zasady są podstawą odpowiedzialnego i godnego zaufania podejścia do sztucznej inteligencji, zwłaszcza gdy inteligentna technologia staje się bardziej rozpowszechniona w produktach i usługach używanych codziennie przez ludzi.

W tym artykule pokazano, jak usługa Azure Machine Learning obsługuje narzędzia umożliwiające deweloperom i analitykom danych implementowanie i operacjonalizacja sześciu zasad.

Sprawiedliwość i inkluzywność

Systemy sztucznej inteligencji powinny traktować wszystkich sprawiedliwie i unikać wpływania na grupy osób w podobnej sytuacji na różne sposoby. Na przykład gdy systemy sztucznej inteligencji zawierają wskazówki dotyczące leczenia, wniosków o pożyczkę lub zatrudnienia, powinny one zawierać te same zalecenia dla wszystkich, którzy mają podobne objawy, okoliczności finansowe lub kwalifikacje zawodowe.

Sprawiedliwość i inkluzywność w usłudze Azure Machine Learning: składnik oceny sprawiedliwości pulpitu nawigacyjnego odpowiedzialnej sztucznej inteligencji umożliwia analitykom danych i deweloperom ocenę sprawiedliwości modelu między poufnymi grupami zdefiniowanymi pod względem płci, pochodzenia etnicznego, wieku i innych cech.

Niezawodność i bezpieczeństwo

Aby zapewnić zaufanie, ważne jest, aby systemy sztucznej inteligencji działały niezawodnie, bezpiecznie i spójnie. Systemy te powinny działać zgodnie z ich pierwotnym projektem, bezpiecznie reagować na nieoczekiwane warunki i być odporne na szkodliwe manipulacje. Sposób ich zachowania i różnorodność warunków, które mogą obsługiwać, odzwierciedlają zakres sytuacji i okoliczności, które deweloperzy przewidywali podczas projektowania i testowania.

Niezawodność i bezpieczeństwo w usłudze Azure Machine Learning: składnik analizy błędów pulpitu nawigacyjnego odpowiedzialnej sztucznej inteligencji umożliwia analitykom danych i deweloperom:

- Dowiedz się, jak awaria jest dystrybuowana dla modelu.

- Zidentyfikuj kohorty (podzestawy) danych z wyższym współczynnikiem błędów niż ogólny test porównawczy.

Te rozbieżności mogą wystąpić, gdy system lub model nie spełnia określonych grup demograficznych lub rzadko obserwowanych warunków wejściowych w danych treningowych.

Przezroczystość

Kiedy systemy sztucznej inteligencji pomagają informować o decyzjach, które mają ogromny wpływ na życie ludzi, ważne jest, aby ludzie zrozumieli, w jaki sposób te decyzje zostały podjęte. Na przykład bank może użyć systemu sztucznej inteligencji, aby zdecydować, czy dana osoba jest godna kredytu. Firma może użyć systemu sztucznej inteligencji, aby określić najbardziej wykwalifikowanych kandydatów do zatrudnienia.

Kluczową częścią przejrzystości jest możliwość interpretacji: przydatne wyjaśnienie zachowania systemów sztucznej inteligencji i ich składników. Poprawa możliwości interpretacji wymaga, aby uczestnicy projektu zrozumieli, jak i dlaczego systemy sztucznej inteligencji działają tak, jak działają. Uczestnicy projektu mogą następnie zidentyfikować potencjalne problemy z wydajnością, problemy z sprawiedliwością, praktyki wykluczające lub niezamierzone wyniki.

Przejrzystość w usłudze Azure Machine Learning: możliwość interpretowania modelu i sprzeczne składniki warunkowe pulpitu nawigacyjnego odpowiedzialnej sztucznej inteligencji umożliwiają analitykom danych i deweloperom generowanie zrozumiałych przez człowieka opisów przewidywań modelu.

Składnik możliwości interpretacji modelu udostępnia wiele widoków w zachowanie modelu:

- Wyjaśnienia globalne. Na przykład jakie funkcje wpływają na ogólne zachowanie modelu alokacji pożyczki?

- Wyjaśnienia lokalne. Na przykład dlaczego wniosek o pożyczkę klienta został zatwierdzony lub odrzucony?

- Objaśnienia modelu dla wybranej kohorty punktów danych. Na przykład jakie funkcje wpływają na ogólne zachowanie modelu alokacji kredytów dla wnioskodawców o niskich dochodach?

Składnik warunkowy analizy co-jeżeli umożliwia zrozumienie i debugowanie modelu uczenia maszynowego pod względem sposobu reagowania na zmiany funkcji i perturbacje.

Usługa Azure Machine Learning obsługuje również kartę wyników odpowiedzialnej sztucznej inteligencji. Karta wyników to dostosowywalny raport PDF, który deweloperzy mogą łatwo konfigurować, generować, pobierać i udostępniać uczestnikom projektu technicznego i nietechnowego, aby edukować ich o kondycji zestawów danych i modeli, osiągać zgodność i budować zaufanie. Ta karta wyników może być również używana w przeglądach inspekcji w celu odkrycia cech modeli uczenia maszynowego.

Prywatność i zabezpieczenia

W miarę jak sztuczna inteligencja staje się coraz bardziej rozpowszechniona, ochrona prywatności i zabezpieczanie informacji osobistych i biznesowych staje się coraz ważniejsza i złożona. Dzięki sztucznej inteligencji prywatność i bezpieczeństwo danych wymagają ścisłej uwagi, ponieważ dostęp do danych jest niezbędny dla systemów sztucznej inteligencji do podejmowania dokładnych i świadomych przewidywań i decyzji dotyczących osób. Systemy sztucznej inteligencji muszą przestrzegać przepisów dotyczących prywatności, które:

- Wymagaj przejrzystości w zakresie zbierania, używania i przechowywania danych.

- Umocuj, aby konsumenci mieli odpowiednie mechanizmy kontroli, aby wybrać sposób korzystania z ich danych.

Prywatność i zabezpieczenia w usłudze Azure Machine Learning: usługa Azure Machine Learning umożliwia administratorom i deweloperom tworzenie bezpiecznej konfiguracji zgodnej z zasadami firmy. Dzięki usłudze Azure Machine Learning i platformie Azure użytkownicy mogą wykonywać następujące czynności:

- Ogranicz dostęp do zasobów i operacji według konta użytkownika lub grupy.

- Ogranicz komunikację przychodzącą i wychodzącą.

- Szyfrowanie danych przesyłanych i magazynowanych.

- Skanuj pod kątem luk w zabezpieczeniach.

- Zastosuj i przeprowadź inspekcję zasad konfiguracji.

Firma Microsoft utworzyła również dwa pakiety open source, które mogą umożliwić dalszą implementację zasad ochrony prywatności i zabezpieczeń:

SmartNoise: Prywatność różnicowa to zestaw systemów i praktyk, które pomagają chronić dane osób fizycznych i prywatnych. W rozwiązaniach uczenia maszynowego prywatność różnicowa może być wymagana do zapewnienia zgodności z przepisami. SmartNoise to projekt typu open source (współtworzyny przez firmę Microsoft), który zawiera składniki do tworzenia różnicowo prywatnych systemów, które są globalne.

Counterfit: Counterfit to projekt typu open source, który składa się z narzędzia wiersza polecenia i ogólnej warstwy automatyzacji, aby umożliwić deweloperom symulowanie cyberataków w systemach sztucznej inteligencji. Każdy może pobrać narzędzie i wdrożyć je za pośrednictwem usługi Azure Cloud Shell w celu uruchomienia w przeglądarce lub wdrożyć je lokalnie w środowisku języka Python Anaconda. Może oceniać modele sztucznej inteligencji hostowane w różnych środowiskach chmury, lokalnie lub na brzegu sieci. Narzędzie jest niezależne od modeli sztucznej inteligencji i obsługuje różne typy danych, w tym tekst, obrazy lub ogólne dane wejściowe.

Odpowiedzialności

Osoby, które projektują i wdrażają systemy sztucznej inteligencji, muszą być odpowiedzialne za sposób działania ich systemów. Organizacje powinny ustalać normy odpowiedzialności na podstawie standardów branżowych. Te normy mogą zapewnić, że systemy sztucznej inteligencji nie są ostatecznym autorytetem w żadnej decyzji, która wpływa na życie ludzi. Mogą również zapewnić, że ludzie zachowują znaczącą kontrolę nad wysoce autonomicznymi systemami sztucznej inteligencji.

Odpowiedzialność w usłudze Azure Machine Learning: operacje uczenia maszynowego (MLOps) opierają się na zasadach i praktykach metodyki DevOps, które zwiększają wydajność przepływów pracy sztucznej inteligencji. Usługa Azure Machine Learning zapewnia następujące możliwości metodyki MLOps w celu uzyskania lepszej odpowiedzialności systemów sztucznej inteligencji:

- Rejestrowanie, pakowanie i wdrażanie modeli z dowolnego miejsca. Możesz również śledzić skojarzone metadane wymagane do korzystania z modelu.

- Przechwyć dane ładu dla kompleksowego cyklu życia uczenia maszynowego. Zarejestrowane informacje o pochodzenia mogą obejmować osoby publikujące modele, dlaczego wprowadzono zmiany oraz kiedy modele zostały wdrożone lub użyte w środowisku produkcyjnym.

- Powiadamianie i powiadamianie o zdarzeniach w cyklu życia uczenia maszynowego. Przykłady obejmują uzupełnianie eksperymentów, rejestrację modelu, wdrażanie modelu i wykrywanie dryfu danych.

- Monitorowanie aplikacji pod kątem problemów operacyjnych i problemów związanych z uczeniem maszynowym. Porównaj dane wejściowe modelu między trenowaniem i wnioskowaniem, eksplorowanie metryk specyficznych dla modelu oraz zapewnianie monitorowania i alertów w infrastrukturze uczenia maszynowego.

Oprócz możliwości metodyki MLOps karta wyników odpowiedzialnej sztucznej inteligencji w usłudze Azure Machine Learning tworzy odpowiedzialność, umożliwiając komunikację między uczestnikami projektu. Karta wyników tworzy również odpowiedzialność, umożliwiając deweloperom konfigurowanie, pobieranie i udostępnianie szczegółowych informacji o kondycji modelu osobom biorącym udział w projekcie technicznym i nietechnicznych na temat danych sztucznej inteligencji i kondycji modelu. Udostępnianie tych szczegółowych informacji może pomóc w budowaniu zaufania.

Platforma uczenia maszynowego umożliwia również podejmowanie decyzji przez informowanie o decyzjach biznesowych poprzez:

- Szczegółowe informacje oparte na danych, aby pomóc uczestnikom projektu zrozumieć wpływ leczenia przyczynowego na wynik przy użyciu tylko danych historycznych. Na przykład"Jak lek wpłynie na ciśnienie krwi pacjenta?" Te szczegółowe informacje są udostępniane za pośrednictwem składnika wnioskowania przyczynowego pulpitu nawigacyjnego odpowiedzialnej sztucznej inteligencji.

- Szczegółowe informacje oparte na modelu, aby odpowiedzieć na pytania użytkowników (takie jak "Co mogę zrobić, aby uzyskać inny wynik od sztucznej inteligencji przy następnym razem?"), aby mogli podjąć działania. Takie szczegółowe informacje są udostępniane analitykom danych za pośrednictwem alternatywnego składnika analizy warunkowej pulpitu nawigacyjnego odpowiedzialnej sztucznej inteligencji.

Następne kroki

- Aby uzyskać więcej informacji na temat implementowania odpowiedzialnej sztucznej inteligencji w usłudze Azure Machine Learning, zobacz Pulpit nawigacyjny odpowiedzialnej sztucznej inteligencji.

- Dowiedz się, jak wygenerować pulpit nawigacyjny odpowiedzialnej sztucznej inteligencji za pomocą interfejsu wiersza polecenia i zestawu SDK lub interfejsu użytkownika usługi Azure Machine Learning Studio.

- Dowiedz się, jak wygenerować kartę wyników odpowiedzialnej sztucznej inteligencji na podstawie szczegółowych informacji obserwowanych na pulpicie nawigacyjnym odpowiedzialnej sztucznej inteligencji.

- Dowiedz się więcej o standardzie Odpowiedzialnej sztucznej inteligencji na potrzeby tworzenia systemów sztucznej inteligencji zgodnie z sześcioma kluczowymi zasadami.

Opinia

Dostępne już wkrótce: W 2024 r. będziemy stopniowo wycofywać zgłoszenia z serwisu GitHub jako mechanizm przesyłania opinii na temat zawartości i zastępować go nowym systemem opinii. Aby uzyskać więcej informacji, sprawdź: https://aka.ms/ContentUserFeedback.

Prześlij i wyświetl opinię dla