Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Postawa bezpieczeństwa Twojej sztucznej inteligencji jest ważnym elementem Twojej ogólnej strategii bezpieczeństwa. Sztuczna inteligencja stawia priorytet na konkretne elementy strategii cyberbezpieczeństwa, takie jak ochrona danych. Ten artykuł ułatwia opracowywanie strategii i priorytetów dotyczących zabezpieczania sztucznej inteligencji. Kolejne artykuły w tej kolekcji ułatwiają zidentyfikowanie konkretnych elementów cyberbezpieczeństwa, które mają na celu określenie priorytetów podczas wdrażania towarzyszy, narzędzi i nowych aplikacji sztucznej inteligencji.

Stan zabezpieczeń jest definiowany jako ogólna funkcja ochrony przed cyberbezpieczeństwem w organizacji oraz poziom przygotowania i stanu operacyjnego w celu radzenia sobie z trwającymi zagrożeniami bezpieczeństwa cybernetycznego. Ta postawa powinna być kwantyfikowana i wymierna, podobnie jak każda inna główna metryka, która odnosi się do stanu operacyjnego lub dobrego samopoczucia organizacji.

Tworzenie silnego stanu zabezpieczeń dla sztucznej inteligencji obejmuje pracę w organizacji, zwłaszcza liderów w całej organizacji, opracowanie strategii i zestawu priorytetów i celów. Następnie określisz pracę techniczną niezbędną do osiągnięcia celów i poprowadzisz różne zespoły do ich realizacji. Artykuły w tej bibliotece zawierają metodologię ze wskazówkami specyficznymi dla sztucznej inteligencji:

- Przygotuj środowisko przy użyciu podstawowych zabezpieczeń. Prawdopodobnie masz już wiele z tych zabezpieczeń.

- Odkryj aplikacje sztucznej inteligencji używane w organizacji, w tym typy danych, z których korzystają aplikacje.

- Ochrona użycia narzędzi sztucznej inteligencji w organizacji. Obejmuje to możliwości ochrony danych specyficzne dla sztucznej inteligencji i zapewnienie, że organizacja wdrożyła silną ochronę przed zagrożeniami.

- Zarządzaj AI zgodnie z wymaganiami.

Użyj tej biblioteki razem z następującymi strukturami w środowisku Microsoft Learn:

Na obrazie:

- Użyj tej biblioteki (Security for AI library), aby dowiedzieć się, jak zaimplementować możliwości zabezpieczania aplikacji i danych sztucznej inteligencji w danym środowisku. Te zabezpieczenia pomagają w tworzeniu podstaw modelu Zero Trust.

- Skorzystaj z platformy wdrażania zero trust , aby kontynuować postęp w kierunku kompleksowego zabezpieczeń. Każdy z scenariuszy biznesowych zero trust zwiększa również bezpieczeństwo aplikacji i danych sztucznej inteligencji.

- Skorzystaj z przewodnika Cloud Adoption Framework for AI, aby opracować kompleksową mapę wdrożenia sztucznej inteligencji, w tym generatywna i niegeneratywna sztuczna inteligencja. Ta biblioteka zawiera strategie wybierania technologii sztucznej inteligencji, procesów zabezpieczania i zarządzania sztuczną inteligencją oraz zasobów na potrzeby projektowania i implementacji sztucznej inteligencji.

Zrozumienie motywacji liderów biznesowych

Silna postawa zabezpieczeń sztucznej inteligencji umożliwia innowacje — umożliwia organizacjom tworzenie i wdrażanie sztucznej inteligencji z ufnością i elastycznością. Celem jest umożliwienie organizacji pewnie tworzenia, wdrażania i skalowania systemów sztucznej inteligencji przy jednoczesnym zabezpieczeniu przed zagrożeniami, które mogłyby podważyć zaufanie, zgodność lub stabilność operacyjną. Dzięki osadzaniu zabezpieczeń na podstawie inicjatyw sztucznej inteligencji organizacje mogą w odpowiedzialny sposób odblokować pełny potencjał sztucznej inteligencji, zapewniając, że pozostaje ona strategicznym zasobem, a nie źródłem niezamierzonych szkód.

Zacznij rozwijać swoją strategię i priorytety, uzyskując dopasowanie do liderów biznesowych. Co motywuje liderów i dlaczego dbają o stan bezpieczeństwa dla sztucznej inteligencji? W poniższej tabeli przedstawiono przykładowe perspektywy, ale ważne jest, aby spotkać się z każdym z tych liderów i zespołów i zapoznać się ze wspólnym zrozumieniem motywacji.

| Rola | Dlaczego tworzenie silnego stanu zabezpieczeń dla sztucznej inteligencji jest ważne |

|---|---|

| Dyrektor generalny (CEO) | Systemy sztucznej inteligencji coraz częściej kształtuje strategiczne decyzje i interakcje z klientami. Naruszenie lub manipulowanie sztuczną inteligencją może prowadzić do złych decyzji, kontroli regulacyjnej, szkód w reputacji i utraty zaufania. Silne zabezpieczenia sztucznej inteligencji mają kluczowe znaczenie dla organizacji w celu ochrony reputacji firmy, zapewnienia zgodności z prawem i zapewnienia pomyślnej transformacji sztucznej inteligencji. |

| Dyrektor ds. marketingu (CMO) | Narzędzia sztucznej inteligencji napędzają wgląd w potrzeby klientów, celowanie do grup docelowych i personalizację. W przypadku kompromitacji te narzędzia mogą prowadzić do wycieków danych, stronniczych wyników lub uszczerbku na wizerunku marki z powodu niewłaściwej zawartości lub celowania. Zabezpieczanie sztucznej inteligencji zapewnia zaufanie do interakcji z klientami, utrzymanie integralności marki, zapobieganie katastrofom PR i pokazanie zaangażowania firmy w ochronę prywatności klientów. |

| Dyrektor ds. systemów informatycznych (CIO) | Bezpieczne środowisko sztucznej inteligencji jest niezbędne do zapewnienia niezawodności systemu, zapobiegania nieautoryzowanemu dostępowi i utrzymania odporności operacyjnej. To umożliwia CIOs bezpieczne zintegrowanie technologii sztucznej inteligencji, które zwiększają możliwości działania firmy, bez narażania przedsiębiorstwa na nadmierne ryzyko. |

| Dyrektor ds. zabezpieczeń informacji (CISO) | Sztuczna inteligencja wprowadza nowe powierzchnie ataków i nowe zagrożenia, a jednocześnie wzmacnia istniejące zagrożenia. Nowe wektory ataku obejmują monity, odpowiedzi, modele, dane RAG, protokół kontekstu modelu (MCP), dane szkoleniowe i zatrucia danych, ataki typu jailbreak, bezpieczeństwo danych i nie tylko. CiSO musi prowadzić wysiłki w zakresie modelowania zagrożeń i zabezpieczania potoków sztucznej inteligencji w celu zachowania stanu zabezpieczeń przedsiębiorstwa. Niezawodne zabezpieczenia sztucznej inteligencji to rozszerzenie ogólnej strategii cyberobrony w celu ochrony zasobów organizacji, zapewnienia zgodności ze strukturami zabezpieczeń oraz utrzymania zaufania klientów i uczestników projektu w wieku inteligentnych systemów. |

| Dyrektor ds. technologii (CTO) | Silna strategia bezpieczeństwa AI jest kluczowa dla CTO, aby chronić zasoby technologiczne organizacji i zapewnić, że systemy sztucznej inteligencji działają niezawodnie zgodnie z zamierzeniami. Wdrażając zabezpieczenia w cyklu rozwoju sztucznej inteligencji, CTO pomaga zapobiegać naruszeniom poufnych algorytmów oraz utrzymywać wysoką jakość i zaufanie do produktów opartych na sztucznej inteligencji. Dzięki temu innowacje mogą być kontynuowane bez nadmiernego ryzyka. |

| Dyrektor operacyjny (COO) | Sztuczna inteligencja automatyzuje krytyczne procesy w łańcuchu dostaw, logistyki i operacjach. Ataki na systemy sztucznej inteligencji mogą zakłócać usługi, zwiększać ryzyko operacyjne i powodować kosztowne opóźnienia. Silne zabezpieczenia sztucznej inteligencji zapewniają ciągłość działania i efektywność. |

| Dyrektor finansowy (CFO) | Dyrektorzy finansowy postrzegają niezawodny stan zabezpieczeń sztucznej inteligencji jako niezbędny do ochrony organizacji. Pomaga uniknąć nieprzewidzianych strat finansowych i zapewnia zgodność z przepisami i zobowiązaniami sprawozdawczymi. |

Rozwiązywanie zmieniających się zagrożeń dla sztucznej inteligencji

GenAI wprowadza nowe powierzchnie ataków, skutecznie zmieniając krajobraz ryzyka. Oprócz zarządzania tradycyjnymi wektorami zagrożeń, liderzy zabezpieczeń i ryzyka muszą również sprostać wzmocnionym zagrożeniom, takim jak wyciek danych i nadmierne udostępnianie danych, oraz nowe zagrożenia, takie jak wstrzyknięcia monitów, nieprawidłowe informacje, luki w zabezpieczeniach modelu i nieprawidłowe informacje. Rozwiązywanie zmieniających się zagrożeń ma kluczowe znaczenie dla umożliwienia wiarygodnej sztucznej inteligencji.

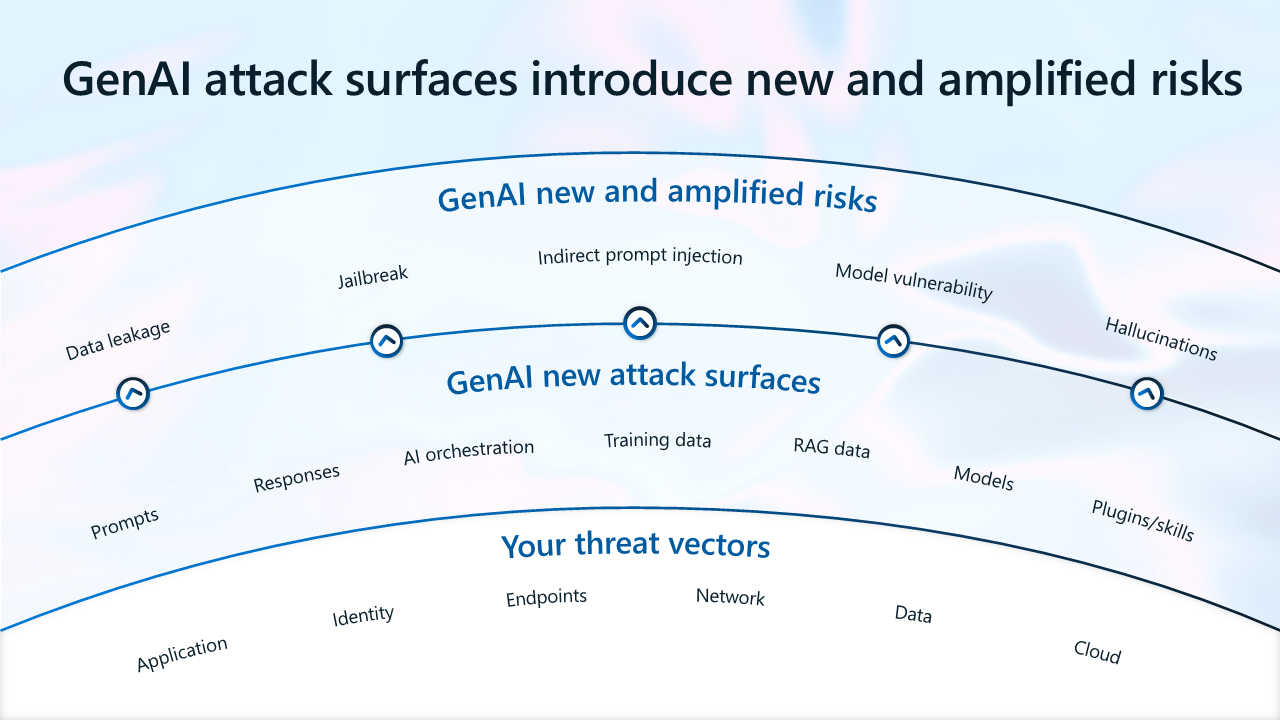

Na ilustracji:

- Powierzchnie ataków GenAI wprowadzają nowe i wzmocnione zagrożenia.

- Wektory zagrożeń, które pozostają niezmienione, obejmują aplikacje, tożsamości, punkty końcowe, sieć, dane i zasoby w chmurze.

- GenAI wprowadza nowe powierzchnie ataków, w tym monity, odpowiedzi, orkiestrację sztucznej inteligencji, dane szkoleniowe, dane RAG (dane generacji wspomaganej wyszukiwaniem, co oznacza dane wynikające z interakcji twoich danych lub innych zewnętrznych danych z modelami językowymi), modele sztucznej inteligencji i wtyczki sztucznej inteligencji.

- GenAI wprowadza nowe zwiększone zagrożenia, w tym wyciek danych, jailbreak (kompromitowanie urządzeń, które są inaczej zabezpieczone), pośrednie wstrzyknięcie monitu i podatność modelu.

Obecnie najbardziej typowe zdarzenia zabezpieczeń w sztucznej inteligencji obejmują:

- Wyciek danych i nadmierne udostępnianie — użytkownicy mogą wyciekać poufne dane do aplikacji sztucznej inteligencji w tle (aplikacje niezatwierdzone przez zespół IT). Użytkownicy mogą również uzyskiwać dostęp do poufnych danych przy użyciu aplikacji sztucznej inteligencji.

- Luki w zabezpieczeniach i pojawiające się zagrożenia — źli aktorzy mogą wykorzystywać luki w zabezpieczeniach w aplikacjach sztucznej inteligencji w celu uzyskania dostępu do cennych zasobów.

- Niezgodność — przepisy, w tym nowe przepisy dotyczące sztucznej inteligencji, mogą zwiększyć niepewność. Niezgodne wdrożenie sztucznej inteligencji może zwiększyć odpowiedzialność.

W poniższych dwóch przykładowych scenariuszach przedstawiono potrzebę tworzenia silnego poziomu zabezpieczeń dla sztucznej inteligencji.

Jak dochodzi do nadmiernego udostępniania i wycieku danych?

W tym przykładzie pracownik firmy Contoso, Adele, znajduje i używa poufnych danych za pomocą kilku aplikacji opartych na sztucznej inteligencji.

| Krok | Opis | Niezłagodzone zagrożenia |

|---|---|---|

| 1 | Adele podsłuchuje członka zespołu, który wspomina o projekcie Obsidian. Używa platformy Microsoft 365 Copilot, aby znaleźć więcej informacji na ten temat. Copilot udostępnia jej podsumowanie i link do dokumentów. | Copilot może przetwarzać poufne dane bez ograniczeń. Poufne dane są nadmiernie uwidoczone dla pracowników, w tym tych, którzy nie powinni mieć dostępu. |

| 2 | Adele kontynuuje korzystanie z Copilot, aby znaleźć i zebrać więcej informacji na temat projektu Obsidian. | Nie ma żadnych kontrolek do wykrywania anomalii w aplikacjach sztucznej inteligencji. |

| 3 | Z ciekawości, Adele chce zobaczyć, co ChatGPT podsumuje, więc wkleja zawartość pliku do ChatGPT. | Nie ma ochrony przed utratą danych (DLP), aby zapobiec wyciekowi danych do aplikacji sztucznej inteligencji konsumentów. |

| 4 | Szczegóły projektu zostały przedwcześnie ujawnione, co spowodowało naruszenie zabezpieczeń danych. Dlatego firma Contoso zablokowała wszystkie aplikacje sztucznej inteligencji w miejscu pracy. | Zakaz używania konsumenckiej sztucznej inteligencji może prowadzić do zwiększenia nielegalnego użycia. |

Firma Contoso mogła ograniczyć te zagrożenia, wykonując prace związane z przygotowywaniem, odnajdywaniem i ochroną użycia aplikacji sztucznej inteligencji.

| Faza | Opis |

|---|---|

| Przygotuj się | Korzystaj z usług Entra i SharePoint Advanced Management , aby uzyskać dostęp pracowników do zasobów o odpowiednim rozmiarze. Używanie usługi Purview Information Protection do klasyfikowania i etykietowania poufnych danych. |

| Odnajdywanie | Użyj narzędzia Purview DSPM dla sztucznej inteligencji, aby odnaleźć zagrożenia związane z danymi. Użyj raportu oceny nadmiernego udostępniania , aby ocenić ryzyko nadmiernego udostępniania. |

| Chroń | Wymuś zasady DLP usługi Purview dla platformy Microsoft 365 Copilot , aby uniemożliwić Copilotowi podsumowywanie poufnych danych. Użyj usługi Purview Insider Risk Management , aby wykrywać i badać działania anomalii. Funkcja adaptacyjnej ochrony umożliwia dynamiczne ograniczanie dostępu dla użytkowników wysokiego ryzyka. Użyj usługi Defender for Cloud Apps , aby zablokować aplikacje wysokiego ryzyka. Użyj warunkowego dostępu Entra, aby wymagać od Adele zaakceptowania warunków użytkowania przed przyznaniem dostępu do ChatGPT. Użyj funkcji DLP punktu końcowego usługi Purview, aby zablokować wklejanie poufnych danych do aplikacji AI dla konsumentów. |

Jak sztuczna inteligencja może powodować ryzyko zgodności?

W następnym przykładzie Jane jest przypisywana do kierowania nadzorem nad AI w firmie Contoso.

| Krok | Opis | Niezłagodzone zagrożenia |

|---|---|---|

| 1 | Jane stara się interpretować wymagania prawne na kontrole, które można wdrożyć, aby zespoły IT mogły je zaimplementować. | Brak ekspertów, którzy są dobrze zorientowani w wymaganiach regulacyjnych i technologii. |

| 2 | Jane zaczyna przygotowywać się do ocen ryzyka, ale nie zna systemów sztucznej inteligencji tworzonych i używanych w firmie Contoso. Nie ma również możliwości monitorowania użycia i potencjalnych ryzyk związanych z zgodnością. | Brak wglądu w systemy sztucznej inteligencji wdrożone w środowisku. Brak nadzoru nad użyciem sztucznej inteligencji. |

| 3 | Po kilku wywiadach wewnętrznych Jane zdaje sobie sprawę, że deweloperzy kompilują jednocześnie około 14 aplikacji sztucznej inteligencji, które implementują różne standardy zabezpieczeń, bezpieczeństwa i ochrony prywatności. | Brak wglądu w kontrolki wbudowane w systemy sztucznej inteligencji przez deweloperów. |

| 4 | Niektóre aplikacje sztucznej inteligencji używają danych osobowych bez standardowych barier zabezpieczających w celu oceny ryzyka. | Brak oceny ryzyka. |

| 5 | Klienci skarżą się na tworzenie szkodliwej i nieziemnej zawartości przez sztuczną inteligencję firmy Contoso. | Brak mechanizmów kontrolnych dla danych wyjściowych sztucznej inteligencji. |

Przepisy dotyczące sztucznej inteligencji przynoszą niepewność i przytłaczającą ryzyko odpowiedzialności liderom odpowiedzialnym za nadzór nad sztuczną inteligencją. Bez żadnych zmian firma Contoso ryzykuje naruszenie wymagań prawnych dotyczących sztucznej inteligencji i potencjalnie stoi przed karami i uszkodzeniem reputacji.

Firma Contoso mogła ograniczyć te zagrożenia, wykonując prace związane z przygotowywaniem, odnajdywaniem i ochroną użycia aplikacji sztucznej inteligencji.

| Faza | Opis |

|---|---|

| Przygotuj się | Skorzystaj z Menedżera zgodności usługi Purview , aby uzyskać wskazówki dotyczące implementowania kontrolek, które mogą pomóc spełnić wymagania dotyczące zgodności. |

| Odnajdywanie | Usługa Defender for Cloud umożliwia odnajdywanie zasobów sztucznej inteligencji wdrożonych w środowiskach chmury. Usługa Defender for Cloud Apps umożliwia odnajdywanie używanych aplikacji SaaS AI. |

| Rządzić | Nadzoruj użycie sztucznej inteligencji za pomocą audytu usługi Microsoft Purview, zarządzania cyklem życia danych, zgodności komunikacji i eDiscovery. Użyj raportów sztucznej inteligencji w usłudze Azure AI Foundry dla deweloperów, aby udokumentować szczegóły projektu sztucznej inteligencji. Użyj Priva Privacy Assessments, aby aktywnie ocenić zagrożenia prywatności w każdym projekcie sztucznej inteligencji. Użyj bezpieczeństwa zawartości sztucznej inteligencji platformy Azure , aby ograniczyć ryzyko szkodliwej lub niezaziemowanej zawartości. |

Dzięki proaktywnym wykorzystaniu możliwości zapewniania ładu organizacje mogą oceniać i rozwiązywać ryzyko podczas wdrażania sztucznej inteligencji.

Pięć kroków wdrażania skutecznych zabezpieczeń dla sztucznej inteligencji

W miarę zwiększania świadomości zagrożeń związanych z szybkim wdrożeniem usługi GenAI wiele organizacji aktywnie reaguje, poświęcając znaczne zasoby w celu zwiększenia środków bezpieczeństwa. Liderzy ds. zabezpieczeń i ryzyka mogą wykonać kilka praktycznych kroków, aby stworzyć ścieżkę do bezpiecznej i bezpiecznej innowacji w zakresie sztucznej inteligencji.

Te zalecane rozwiązania koncentrują się na wspieraniu środowiska współpracy i wdrażaniu skutecznych środków zabezpieczeń, które będą wspierać postęp genAI przy jednoczesnym zabezpieczeniu interesów organizacyjnych.

Krok 1. Tworzenie zespołu ds. zabezpieczeń dla sztucznej inteligencji

Większość firm uznaje potrzebę utworzenia dedykowanych, funkcjonalnych zespołów w celu zarządzania unikatowymi wyzwaniami dotyczącymi zabezpieczeń stwarzanymi przez sztuczną inteligencję. Dedykowane zespoły ds. zabezpieczeń zapewniają, że systemy sztucznej inteligencji są rygorystycznie testowane, luki w zabezpieczeniach są szybko identyfikowane i ograniczane, a protokoły zabezpieczeń są stale aktualizowane, aby nadążyć za zmieniającymi się zagrożeniami.

Osiemdziesiąt procent respondentów ankiety ma obecnie (45%) lub planuje mieć (35%) dedykowany zespół zajmujący się bezpieczeństwem sztucznej inteligencji. Ponad 6 na 10 powiedział, że ich zespoły będą zgłaszać się do twórcy decyzji o bezpieczeństwie, zapewniając nie tylko czujny nadzór, ale także strategiczną wizję i przywództwo w rozwiązywaniu ryzyka związanego ze sztuczną inteligencją.

W szczególności mediana rozmiaru zespołu lub zamierzonego rozmiaru zespołu tych dedykowanych zespołów ds. zabezpieczeń wynosiła 24 pracowników — podkreślając znaczne zasoby, które firmy zobowiązują się do ochrony inicjatyw sztucznej inteligencji. Gdy wielkość firmy została uwzględniona, rozmiary zespołów różnią się.

Poniżej przedstawiono kilka najlepszych rozwiązań, których organizacje mogą używać do pomyślnego utworzenia skutecznego zespołu ds. zabezpieczeń międzyfunkcyjnych dla sztucznej inteligencji.

Tworzenie komitetu sztucznej inteligencji w celu wspierania współpracy między działami

Zabezpieczenia sztucznej inteligencji to wspólny wysiłek wykraczający poza dział IT. Zachęcaj do współpracy między zespołami, takimi jak zabezpieczenia, dział IT, legalne, zgodność i zarządzanie ryzykiem, aby tworzyć kompleksowe strategie zabezpieczeń. Mając różne perspektywy i wiedzę, zwiększy efektywność protokołów zabezpieczeń.

Zatrudnianie różnych zestawów umiejętności

Utworzenie pomyślnego zespołu ds. zabezpieczeń dla sztucznej inteligencji wymaga równowagi umiejętności. Poszukaj członków zespołu z wiedzą w dziedzinie nauki o danych, cyberbezpieczeństwa, inżynierii oprogramowania i uczenia maszynowego. Ta różnorodność zapewnia, że są objęte różne aspekty zabezpieczeń, od rozwoju technicznego po zapobieganie zagrożeniom.

Określanie jasnych ról i obowiązków

Aby uzyskać efektywną produktywność, jasno zdefiniuj rolę każdego członka zespołu. Upewnij się, że wszyscy rozumieją swoje szczególne obowiązki, co promuje odpowiedzialność i unika nakładania się wysiłków.

Zainwestuj w ciągłe szkolenie i rozwój

Szybka ewolucja technologii sztucznej inteligencji nakazuje ciągłą edukację zespołów ds. zabezpieczeń. Zapewnianie dostępu do programów szkoleniowych i warsztatów, które koncentrują się na praktykach, pojawiających się zagrożeniach i zagadnieniach etycznych związanych z bezpieczeństwem sztucznej inteligencji. Ta inwestycja nie tylko wzmacnia członków zespołu, ale także zapewnia, że organizacja wyprzedza potencjalne zagrożenia.

Krok 2. Optymalizowanie zasobów w celu zabezpieczenia usługi GenAI

Wprowadzenie aplikacji sztucznej inteligencji w organizacjach nie tylko zrewolucjonizuje operacje, ale także wymaga znaczących zmian w alokacji zasobów i budżetu, zwłaszcza w zakresie zabezpieczeń IT.

Znaczna większość liderów ds. zabezpieczeń i ryzyka (78%) uważa, że ich budżet na bezpieczeństwo IT zwiększy się, aby sprostać unikatowym wyzwaniom i możliwościom związanym ze sztuczną inteligencją. To dostosowanie ma kluczowe znaczenie z kilku powodów. Systemy sztucznej inteligencji wymagają niezawodnej infrastruktury zabezpieczeń do bezpiecznego działania. Może to obejmować uaktualnienie istniejących systemów zabezpieczeń, wdrożenie bardziej rygorystycznych kontroli dostępu oraz zwiększenie bezpieczeństwa i ładu danych. Inne zasoby mogą być również potrzebne do spełnienia nowych wymagań prawnych dotyczących sztucznej inteligencji.

Wcześniej w tym artykule firma Microsoft zaleca wykonanie pracy, aby zrozumieć motywacje liderów biznesowych i różne jednostki biznesowe w całej organizacji. Identyfikowanie najważniejszych problemów i wspólnych celów biznesowych jest ważnym krokiem w kierunku negocjacji zasobów w celu osiągnięcia celów.

Przydzielanie funduszy na oceny zgodności, konsultacje prawne i inspekcje stają się niezbędne do dostosowania strategii sztucznej inteligencji organizacji do struktury branżowej i zapewnienia bezpieczniejszego, bezpiecznego i zgodnego użycia i systemów sztucznej inteligencji. Priorytetyzowanie funduszy na bieżące szkolenia pracowników i rozwój umiejętności, które mogą obejmować specjalistyczne szkolenia na temat narzędzi zabezpieczeń dla sztucznej inteligencji, strategii zarządzania ryzykiem i zagadnień etycznych w zakresie stosowania sztucznej inteligencji jest również ważne, aby wziąć pod uwagę przy przydzielaniu budżetu i zasobów.

Krok 3: Przyjmij podejście Zero Trust

Przygotowując się do wdrożenia sztucznej inteligencji, strategia Zero Trust zapewnia liderom zabezpieczeń i ryzyka zestaw zasad, które pomagają rozwiązać niektóre z ich najważniejszych problemów, w tym nadmierne udostępnianie danych, nadmierną ekspozycję i ukryte IT. Podejście Zero Trust przechodzi od skupienia na sieci do skupienia na zasobach i danych, traktując każde żądanie dostępu jako potencjalne zagrożenie, niezależnie od jego źródła.

Zero Trust stale weryfikuje tożsamości każdego użytkownika i urządzenia, zapewniając, że tylko osoby z wyraźnymi uprawnieniami mogą uzyskiwać dostęp do poufnych informacji. Dynamicznie dostosowując środki bezpieczeństwa na podstawie ocen w czasie rzeczywistym, zero trust minimalizuje ryzyko wycieku danych i chroni organizację przed zagrożeniami wewnętrznymi i zewnętrznymi. Ciągła weryfikacja, dostęp do najniższych uprawnień i dynamiczne zarządzanie ryzykiem są podstawą tego podejścia, zapewniając niezawodną i dostosowaną platformę zabezpieczeń, która wspiera sukces kompleksowego zabezpieczeń organizacji.

Dzięki użyciu rozwiązania Zero Trust organizacje mogą zabezpieczyć wdrożenia sztucznej inteligencji i wiedzieć, że ich zabezpieczenia są stale weryfikowane i chronione. Usługa Zero Trust umożliwia organizacjom bezpieczne korzystanie ze sztucznej inteligencji, zapewniając bezpieczne i efektywne wykorzystanie zaawansowanych funkcji sztucznej inteligencji.

Wszystkie wskazówki dotyczące zabezpieczeń sztucznej inteligencji udostępniane przez firmę Microsoft są zakotwiczone na podstawie zasad zero trust. Postępując zgodnie ze wskazówkami dotyczącymi zabezpieczeń zalecanymi dla usługi GenAI, tworzysz silną podstawę Zero Trust.

Krok 4. Inwestowanie w wspólną odpowiedzialność z partnerami, którym ufasz

Zasób, który jest często używany do informowania o strategii i priorytetach, jest wspólnym modelem odpowiedzialności. Twoja odpowiedzialność za zabezpieczanie użycia sztucznej inteligencji w organizacji zależy od typu używanych aplikacji. Partnerzy, w których inwestujesz, dzielą się odpowiedzialnością z Tobą.

Wspólny model odpowiedzialności pomaga zespołom ds. zabezpieczeń prowadzić swoją organizację w podejmowaniu decyzji.

- Aplikacje GenAI, które zmniejszają zakres odpowiedzialności w swoich organizacjach.

- Partnerzy, którzy zdobyli zaufanie.

Ten diagram zawiera podsumowanie równowagi obowiązków zarówno dla Ciebie, jak i firmy Microsoft. Wiele organizacji korzysta ze wspólnego modelu odpowiedzialności, aby określić priorytety korzystania z aplikacji SaaS we współpracy z zaufanymi dostawcami i zmniejszyć liczbę niestandardowych aplikacji.

Aby uzyskać więcej informacji, zobacz Model wspólnej odpowiedzialności za sztuczną inteligencję — Microsoft Azure.

Oprócz inwestowania z partnerami, którzy zdobyli zaufanie, wielu specjalistów ds. zabezpieczeń zaleca konsolidację narzędzi zabezpieczeń i dostawców. Firma Microsoft oferuje kompleksowe rozwiązanie zabezpieczeń dla sztucznej inteligencji z narzędziami, które współpracują ze sobą, znacznie zmniejszając ilość pracy integracji dla zespołów ds. zabezpieczeń.

Krok 5. Wdrażanie kompleksowego rozwiązania zabezpieczeń dla sztucznej inteligencji

Sztuczna inteligencja wprowadza konkretne zagrożenia, których tradycyjne środki bezpieczeństwa mogą nie być w pełni rozwiązane. Zabezpieczenia sztucznej inteligencji zostały zaprojektowane w celu ograniczenia tych zagrożeń.

Znaczna większość firm planuje pozyskać wyspecjalizowane narzędzia i platformy w celu zabezpieczenia zarówno użycia, jak i tworzenia aplikacji sztucznej inteligencji. Zapytany, w jaki sposób planują zabezpieczać i chronić użycie i rozwój aplikacji sztucznej inteligencji w swoich organizacjach, większość respondentów ankiet (72%) powiedziała, że planuje zakupić nowe dedykowane rozwiązanie zabezpieczeń w celu zabezpieczenia użycia i rozwoju sztucznej inteligencji, podczas gdy 64% stwierdziło, że planują używać istniejących rozwiązań zabezpieczeń do zabezpieczania sztucznej inteligencji.

Liderzy IT i bezpieczeństwa uważają, że głównymi współautorami budżetu dla nowych rozwiązań ochrony i zarządzania sztuczną inteligencją będą działy IT (63%) oraz działy bezpieczeństwa informacji/ cyberbezpieczeństwa (57%). Wyniki te pokazują, że oprócz dalszego korzystania z istniejących rozwiązań zabezpieczeń organizacje widzą konieczność wyszukiwania nowych rozwiązań, które mogą pomóc w rozwiązywaniu wzmocnionych i pojawiających się zagrożeń związanych ze sztuczną inteligencją.

Oprócz kompleksowej platformy zabezpieczeń firmy Microsoft firma Microsoft udostępnia kompleksowe narzędzia zabezpieczeń do zabezpieczania sztucznej inteligencji, od odnajdywania narzędzi sztucznej inteligencji i danych po ochronę, które zostały zaprojektowane specjalnie w celu wyeliminowania zagrożeń związanych ze sztuczną inteligencją. Narzędzia te obejmują zaawansowane pulpity nawigacyjne i zasoby związane ze zgodnością, pomagając ci w zarządzaniu ryzykiem i obowiązkami regulacyjnymi.

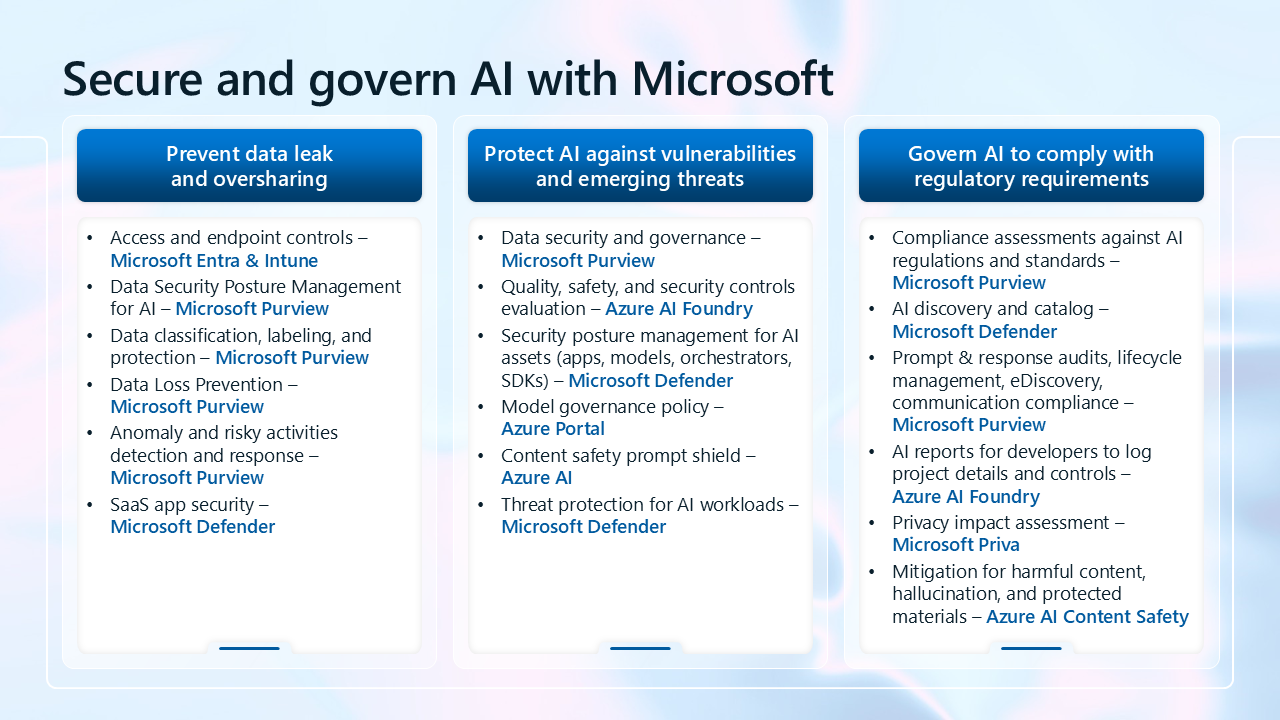

Na poniższej ilustracji przedstawiono podsumowanie wszystkich możliwości oferowanych przez firmę Microsoft w celu ochrony wdrażania sztucznej inteligencji. Te możliwości są również wymienione w poniższej tabeli.

| Najważniejsze problemy klientów | Możliwości |

|---|---|

| Zapobieganie wyciekowi danych i nadmiernemu udostępnianiu | — Kontrola dostępu i punktów końcowych — Microsoft Entra & Intune — Zarządzanie stanem zabezpieczeń danych dla sztucznej inteligencji — Microsoft Purview — Klasyfikacja, etykietowanie i ochrona danych — Microsoft Purview — Zapobieganie utracie danych — Microsoft Purview — Wykrywanie i reagowanie na ryzykowne działania — Microsoft Purview — Zabezpieczenia aplikacji SaaS — Microsoft Defender |

| Ochrona sztucznej inteligencji przed lukami w zabezpieczeniach i pojawiającymi się zagrożeniami | — Bezpieczeństwo danych i zarządzanie — Microsoft Purview - Ocena jakości, bezpieczeństwa i kontroli zabezpieczeń — Azure AI Foundry — Zarządzanie stanem zabezpieczeń zasobów sztucznej inteligencji (aplikacje, modele, orkiestratory, zestawy SDK) — Microsoft Defender — Zasady ładu modelu — Portal Azure — Osłona ostrzeżenia bezpieczeństwa treści — Azure AI — Ochrona przed zagrożeniami dla obciążeń sztucznej inteligencji — Microsoft Defender |

| Zarządzanie sztuczną inteligencją w celu zachowania zgodności z wymaganiami prawnymi | — Oceny zgodności z przepisami i standardami sztucznej inteligencji — Microsoft Purview — Odnajdywanie i wykaz sztucznej inteligencji — Microsoft Defender - Audyty odpowiedzi, zarządzanie cyklem życia, eDiscovery, zgodność komunikacji — Microsoft Purview — Raporty sztucznej inteligencji dla deweloperów służące do rejestrowania szczegółów i kontrolek projektu — Azure AI Foundry — Ocena wpływu na prywatność — Microsoft Priva - Środki zaradcze dotyczące szkodliwej zawartości, nieprawidłowych informacji i materiałów chronionych — Bezpieczeństwo zawartości sztucznej inteligencji platformy Azure |

Następne kroki dotyczące zabezpieczania sztucznej inteligencji

Ta biblioteka przeprowadzi Cię przez proces implementowania zabezpieczeń dla sztucznej inteligencji w podejściu etapowym.

Postępuj zgodnie ze wskazówkami w tej serii artykułów, aby dowiedzieć się więcej na temat zabezpieczania sztucznej inteligencji oraz identyfikowania i implementowania możliwości w celu osiągnięcia celów organizacji.

- Przygotowanie do sztucznej inteligencji

- Odnajdywanie aplikacji i danych sztucznej inteligencji

- Ochrona danych i aplikacji sztucznej inteligencji

- Zarządzanie sztuczną inteligencją pod kątem zgodności

Aby dowiedzieć się więcej na temat optymalizowania ogólnego stanu zabezpieczeń i zerowego zaufania, zobacz Szybkie modernizowanie stanu zabezpieczeń.

Zacznij od zapoznania się z zalecanymi zabezpieczeniami dla towarzyszy sztucznej inteligencji, zobacz Użyj zabezpieczeń Zero Trust, aby przygotować się na towarzyszy sztucznej inteligencji, w tym Microsoft Copilots.