Copiar arquivos novos e alterados de forma incremental com base em LastModifiedDate usando a ferramenta de Copiar Dados

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dica

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange desde movimentação de dados até ciência de dados, análise em tempo real, business intelligence e relatórios. Saiba como iniciar uma avaliação gratuita!

Neste tutorial, você usará o portal do Azure para criar um data factory. Em seguida, você usará a ferramenta Copiar Dados para criar um pipeline que copia de forma incremental somente arquivos novos e alterados, de e para o armazenamento de Blob do Azure. Ele usa LastModifiedDate para determinar os arquivos a copiar.

Depois de concluir as etapas aqui, o Azure Data Factory examinará todos os arquivos no repositório de origem, aplicará o filtro de arquivo por LastModifiedDate e copiará para o repositório de destino somente os arquivos novos ou que foram atualizados desde a última vez. Observe que, se o Data Factory examinar um grande número de arquivos, você deverá esperar longas durações. A verificação de arquivos é demorada, mesmo quando a quantidade de dados copiados é reduzida.

Observação

Se estiver se familiarizando com o Data Factory, confira a Introdução ao Azure Data Factory.

Neste tutorial, você concluirá estas tarefas:

- Criar um data factory.

- Usar a ferramenta Copy Data para criar um pipeline.

- Monitore as execuções de pipeline e de atividade.

Pré-requisitos

- Assinatura do Azure: Se você não tiver uma assinatura do Azure, crie uma conta gratuita antes de começar.

- Conta de Armazenamento do Azure: use o armazenamento de Blob para os armazenamentos de dados de origem e do coletor. Se você não tiver uma conta de Armazenamento do Azure, siga as instruções em Criar uma conta de armazenamento.

Criar dois contêineres no armazenamento de Blobs

Prepare seu armazenamento de Blob para o tutorial, concluindo estas etapas:

Crie um contêiner chamado origem. É possível usar várias ferramentas para executar esta tarefa, como o Gerenciador de Armazenamento do Azure.

Crie um contêiner chamado destino.

Criar uma data factory

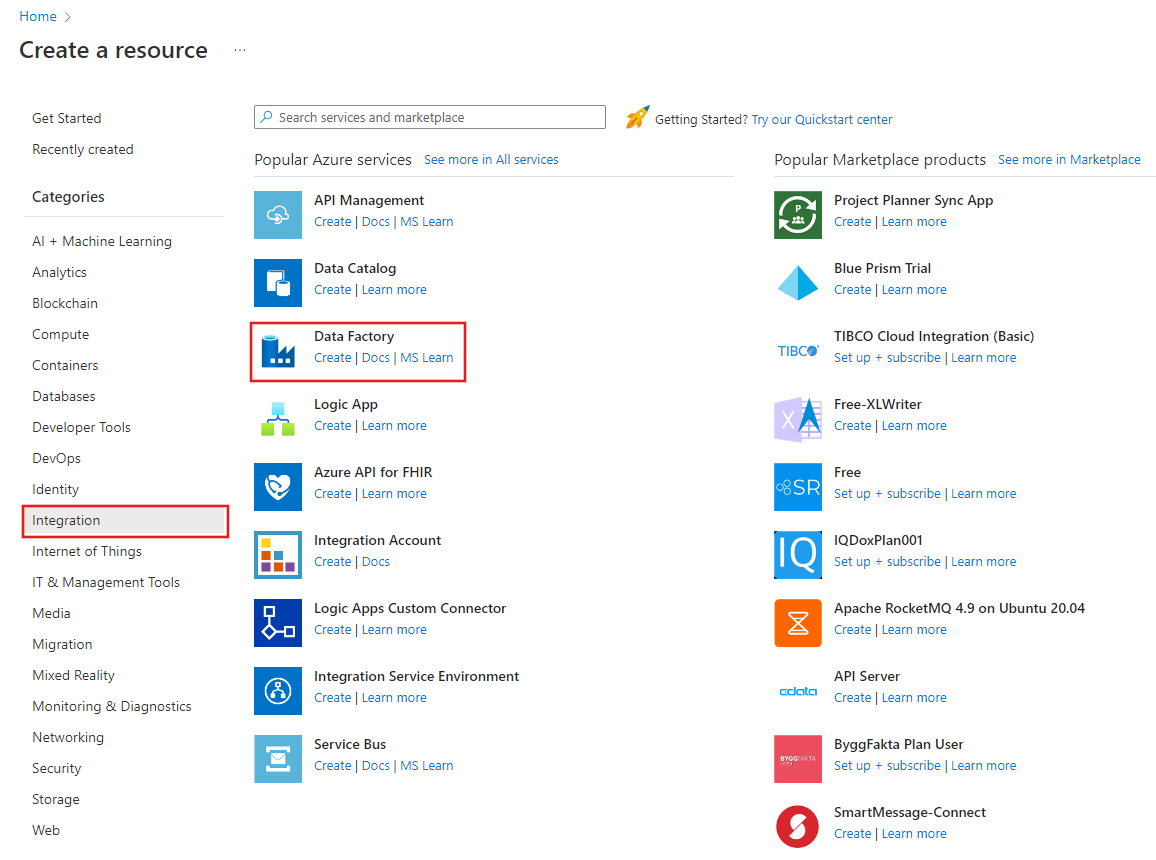

No painel esquerdo, selecione Criar um recurso. Selecione Integração>Data Factory:

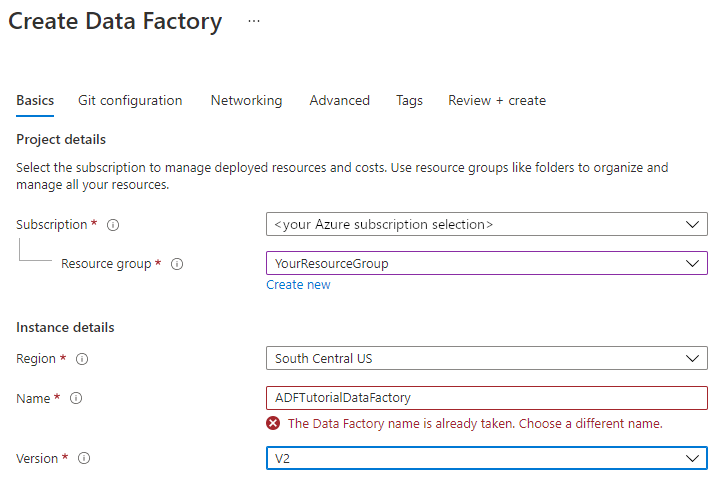

Na página Novo data factory, em Nome, insira ADFTutorialDataFactory.

O nome do seu data factory deve ser globalmente exclusivo. Você deve receber esta mensagem de erro:

Se você receber uma mensagem de erro sobre o valor do nome, insira um nome diferente para o data factory. Por exemplo, use o nome seunomeADFTutorialDataFactory. Para ver as regras de nomenclatura de artefatos do Data Factory, confira Regras de nomenclatura do Data Factory.

Em Assinatura, selecione a assinatura do Azure na qual você deseja criar o novo data factory.

Em Grupo de Recursos, execute uma destas etapas:

Selecione Usar existente e escolha um grupo de recursos existente na lista.

Selecione Criar novo e insira um nome para o grupo de recursos.

Para saber mais sobre grupos de recursos, confira Usar grupos de recursos para gerenciar recursos do Azure.

Em Versão, selecione V2.

Em Local, selecione o local para o data factory. Somente os locais com suporte aparecem na lista. Os armazenamentos de dados (por exemplo, Armazenamento do Azure e Banco de Dados SQL do Azure) e os serviços de computação (por exemplo, Azure HDInsight) que o seu data factory usa podem estar em outros locais e regiões.

Selecione Criar.

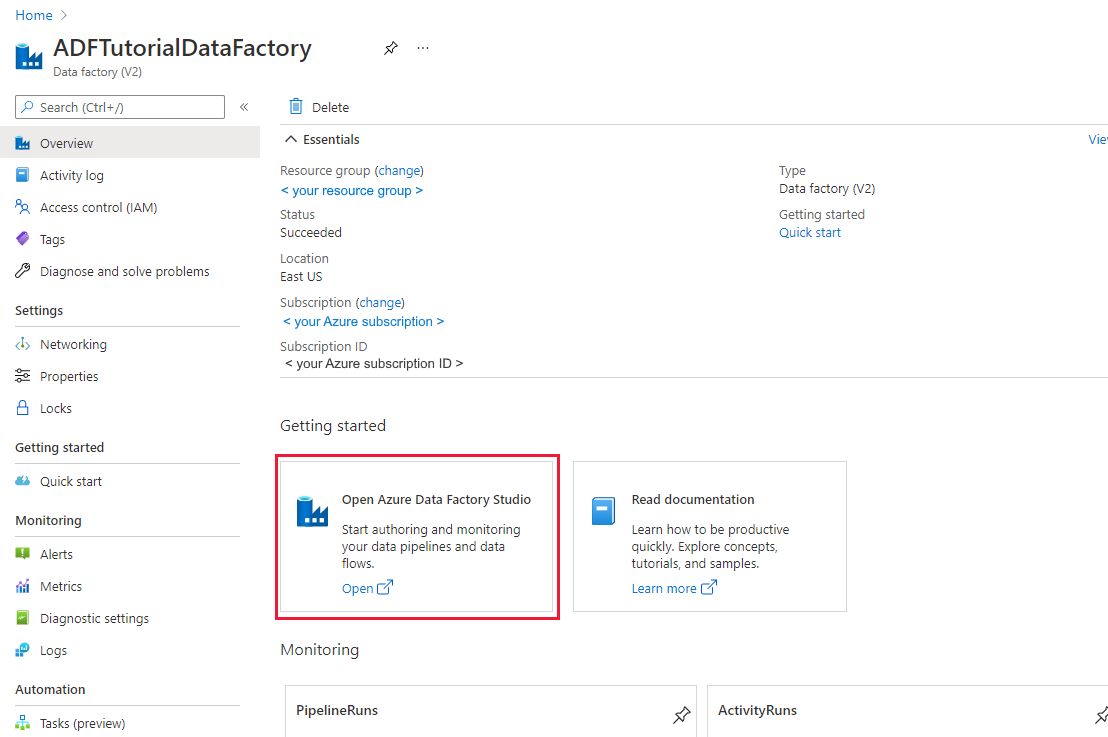

Depois que o data factory for criado, será exibida a página inicial do data factory.

Para abrir a UI (interface do usuário) do ADF (Azure Data Factory) em uma guia separada, selecione Abrir no bloco Abrir Azure Data Factory Studio:

Usar a ferramenta Copy Data para criar um pipeline

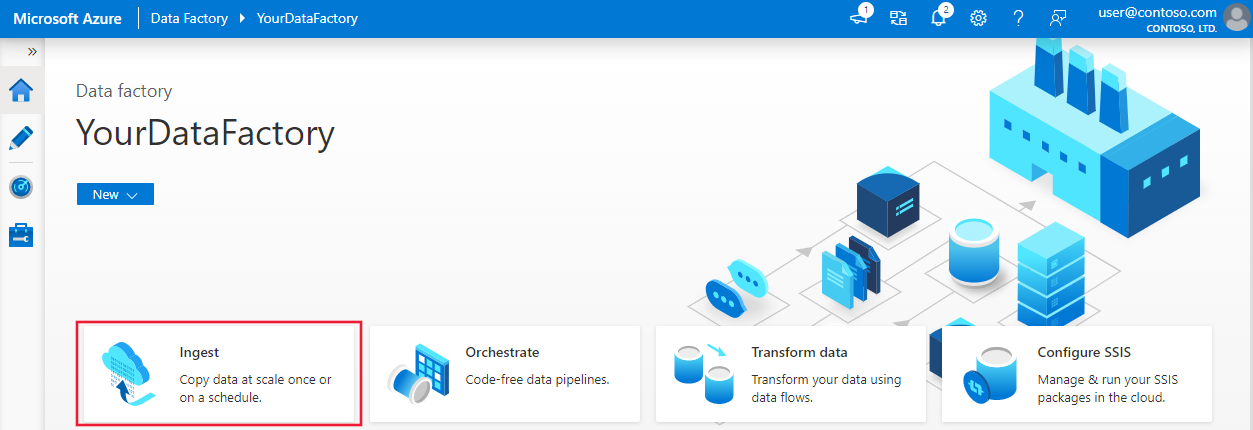

Na página inicial do ADF, selecione o bloco Ingerir para abrir a ferramenta Copiar Dados:

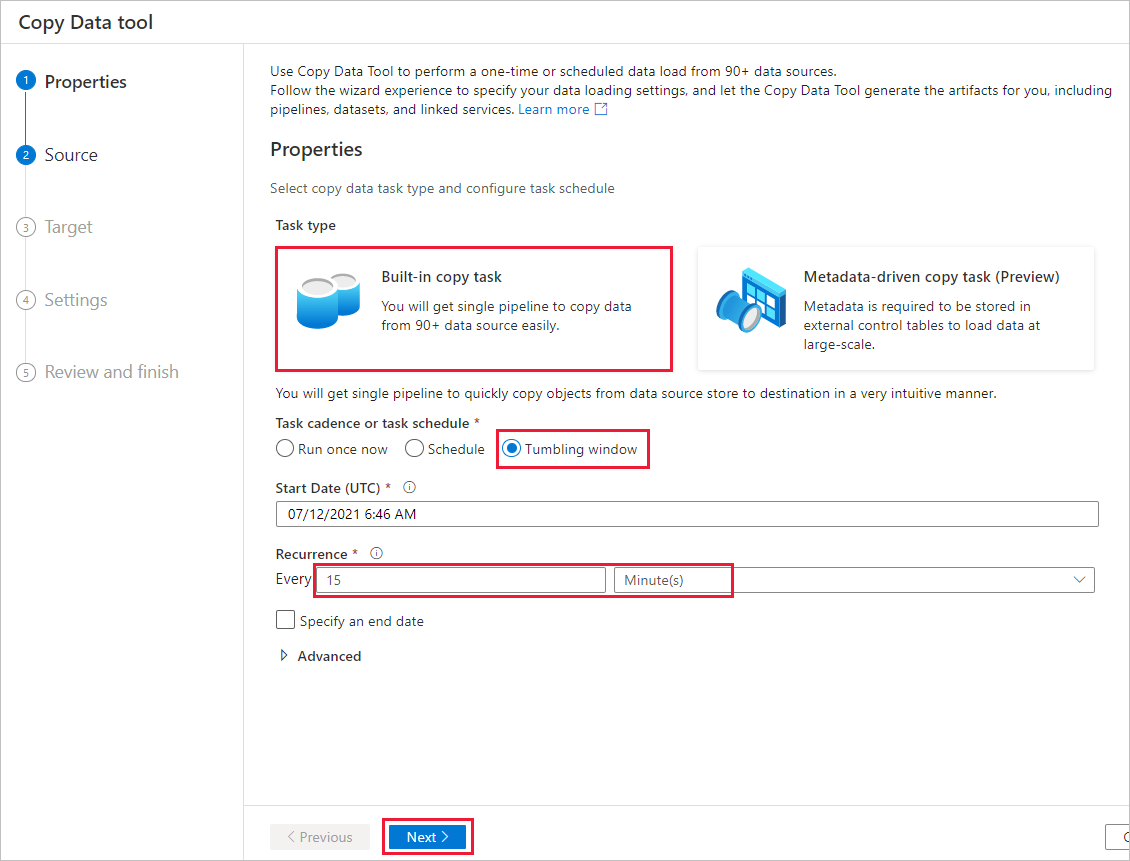

Na página Propriedades, execute as seguintes etapas:

Em Tipo de tarefa, selecione Tarefa de copiar interna.

Em Cadência da tarefa ou Agendamento da tarefa, selecione Janela em cascata.

Em Recorrência, insira 15 minuto(s) .

Selecione Avançar.

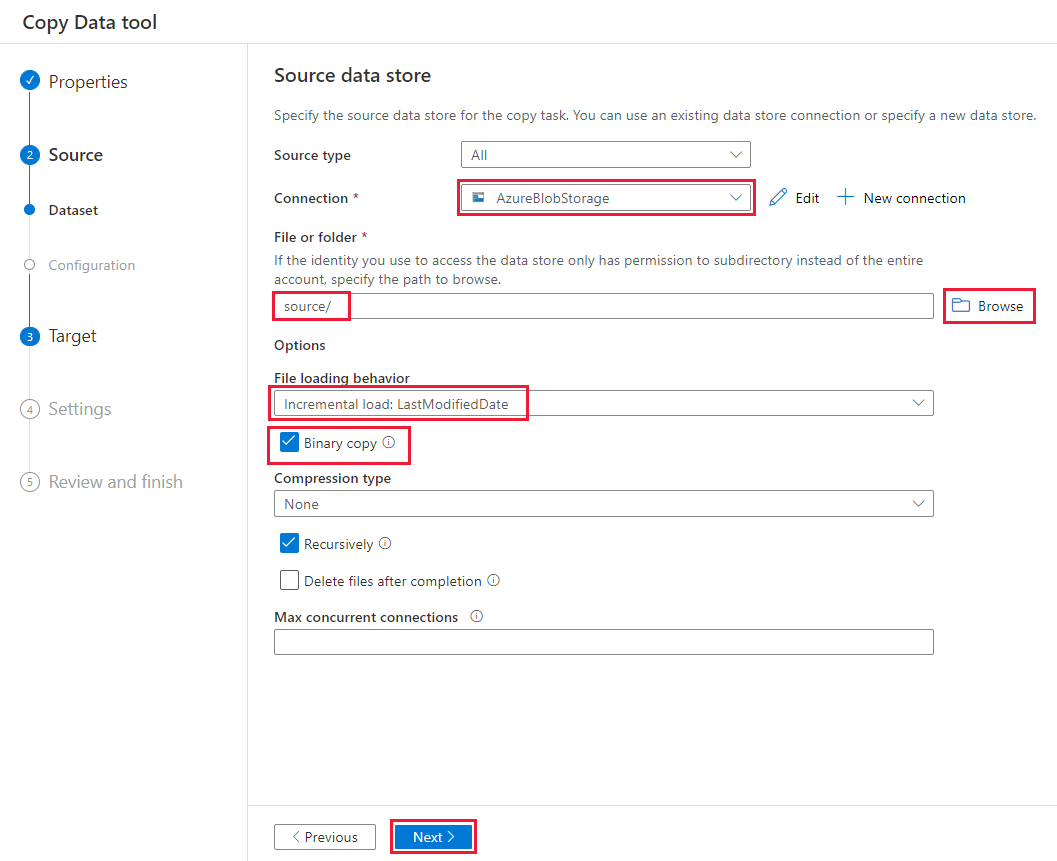

Na página Armazenamento de dados de origem, conclua as seguintes etapas:

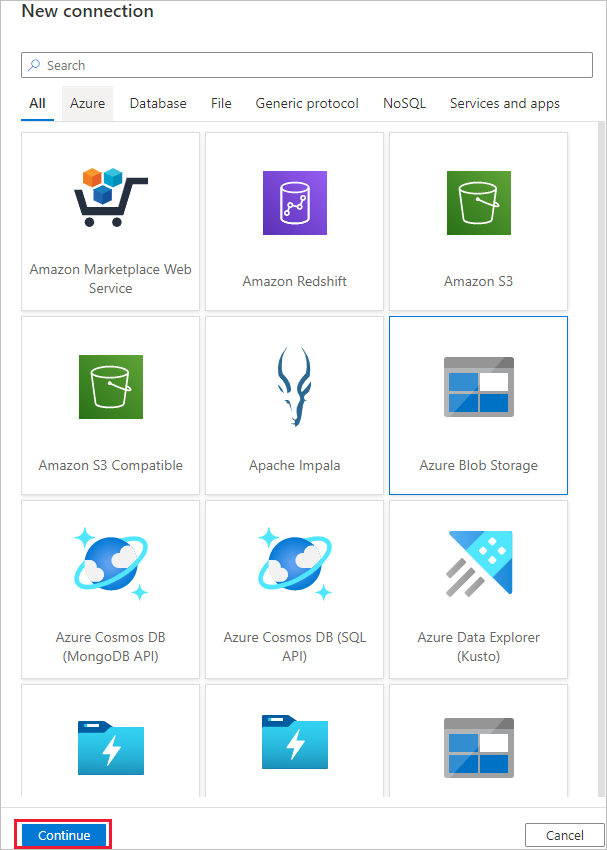

Selecione + Criar conexão para adicionar uma conexão.

Selecione Armazenamento de Blobs do Azure na galeria e, em seguida, selecione Continuar:

Na página Nova conexão (Armazenamento de Blobs do Azure) , selecione sua assinatura do Azure na lista Assinatura do Azure e sua conta de armazenamento na lista Nome da conta de armazenamento. Teste a conexão e selecione Criar.

Selecione a conexão criada recentemente no bloco de Conexão.

Na seção Arquivo ou pasta, selecione Navegar e selecione a pasta origem, e selecione OK.

Em Comportamento de carregamento de arquivo, selecione Carga incremental: LastModifiedDate, e escolha Cópia binária.

Selecione Avançar.

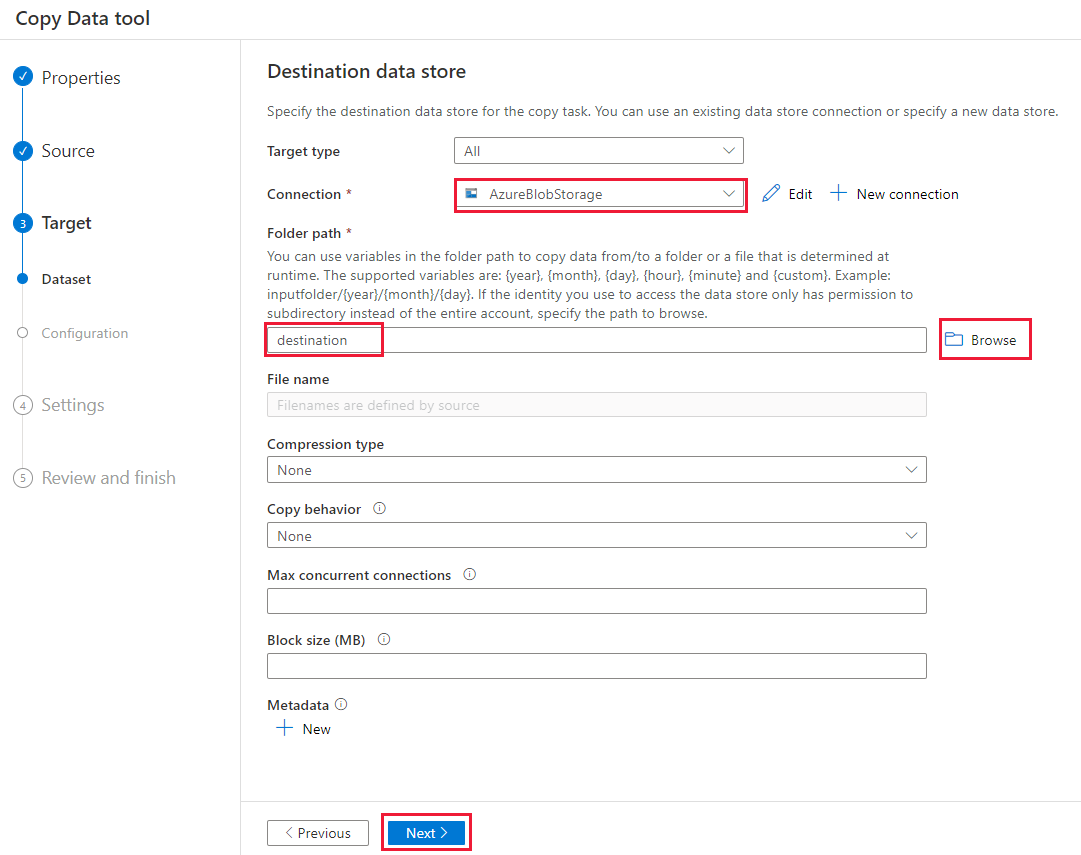

Na página Armazenamento de dados de destino, conclua as seguintes etapas:

Selecione a conexão AzureBlobStorage que você criou. Essa é a mesma conta de armazenamento que o armazenamento de dados de origem.

Na seção Caminho de pasta, navegue e selecione a pasta de destino e selecione OK.

Selecione Avançar.

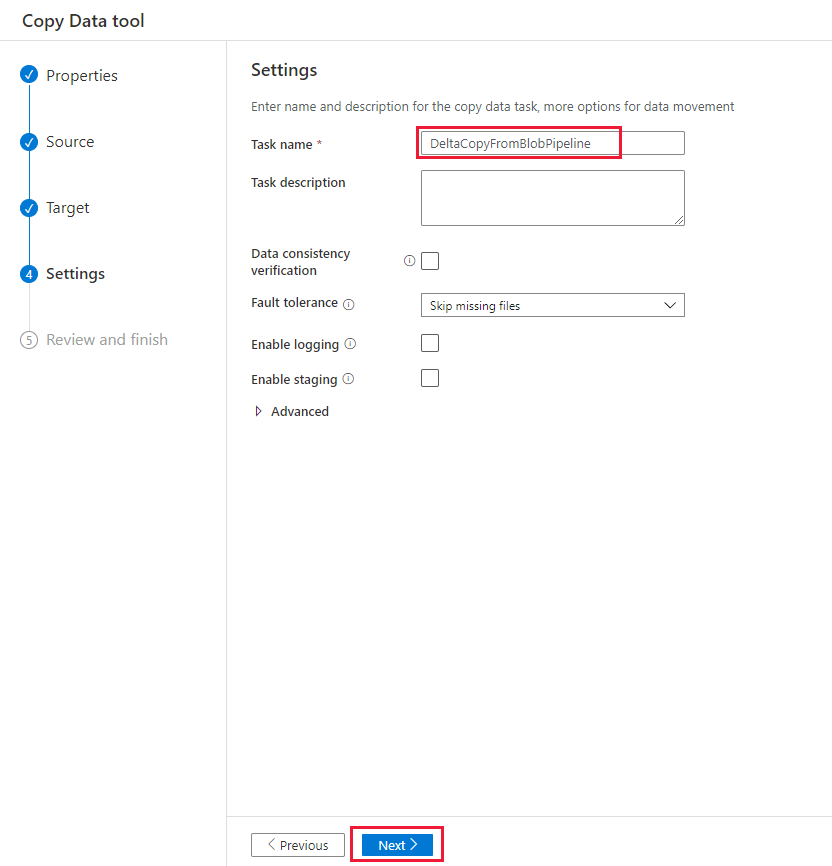

Na página Configurações, em Nome da tarefa, insira DeltaCopyFromBlobPipeline e selecione Avançar. O Data Factory cria um pipeline com o nome especificado da tarefa.

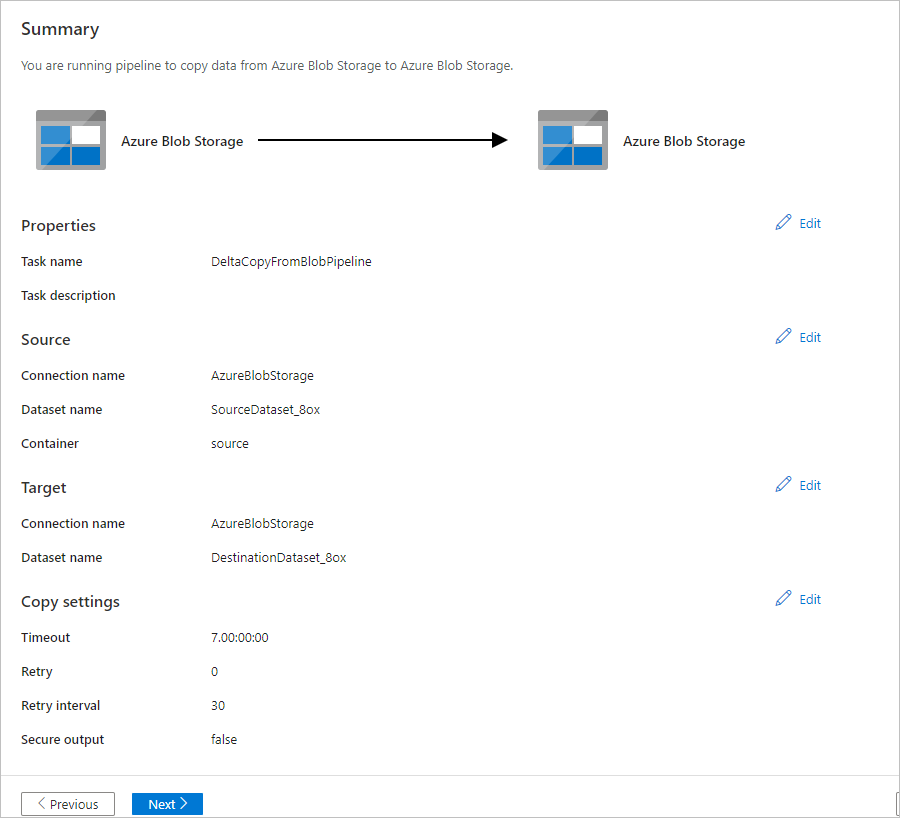

Na página Resumo, analise as configurações e selecione Avançar.

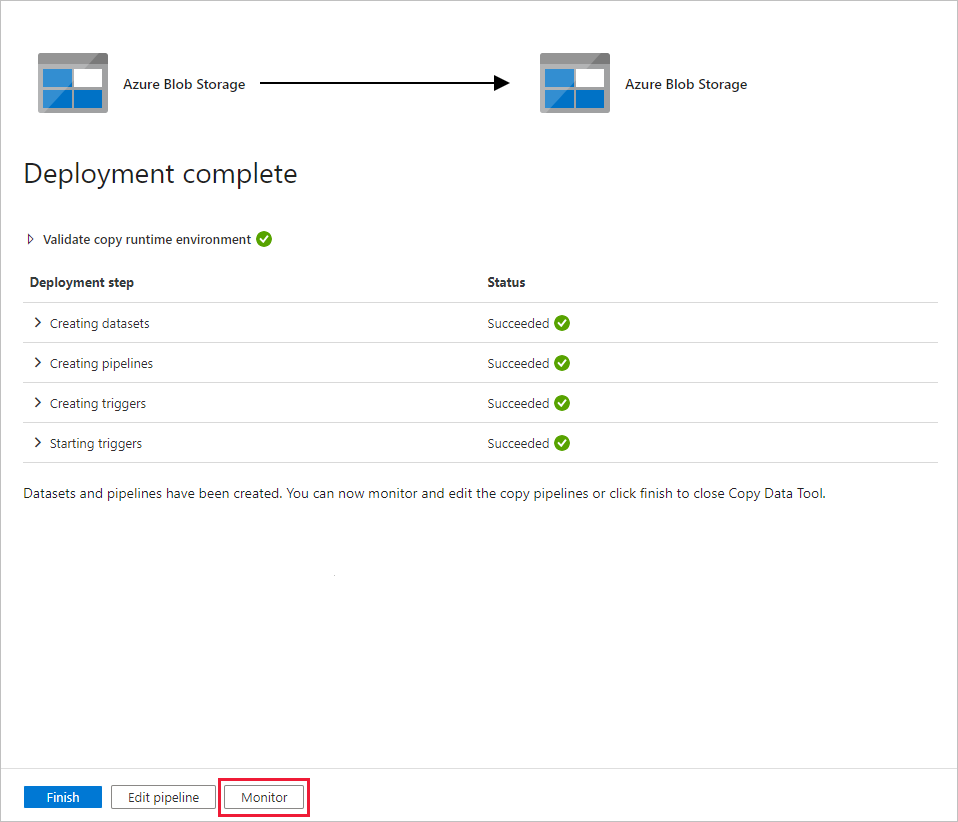

Na página Implantação, selecione Monitorar para monitorar o pipeline (tarefa).

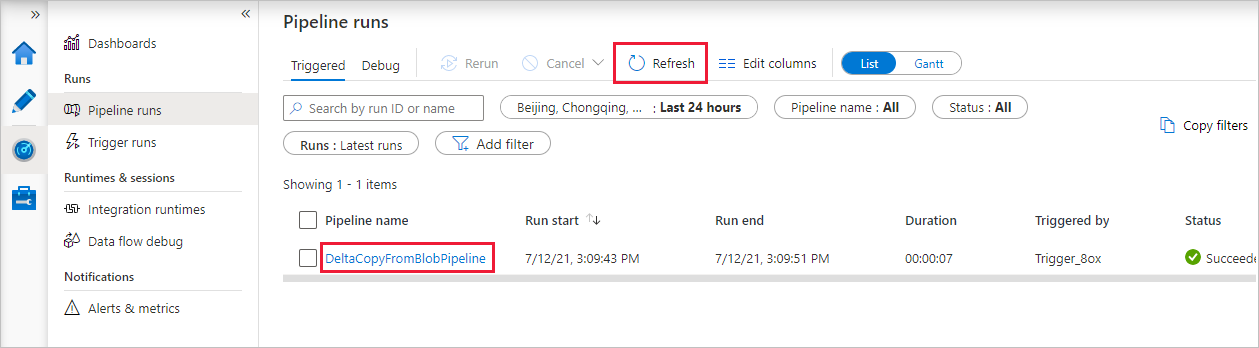

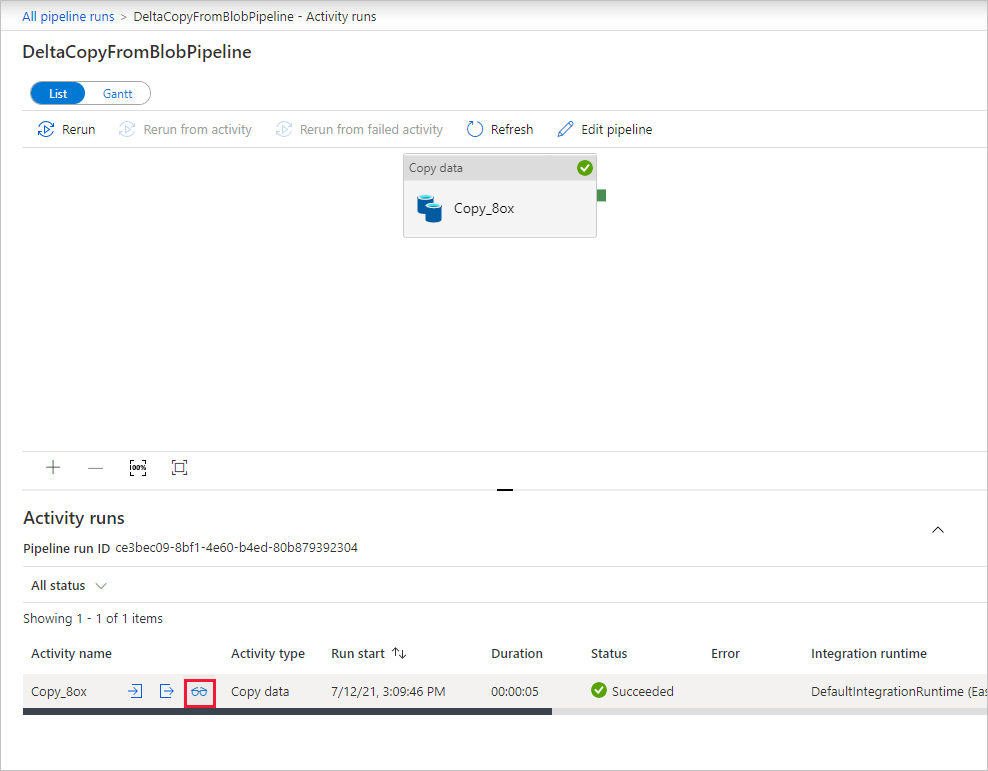

Observe que a guia Monitor à esquerda é selecionada automaticamente. O aplicativo alterna para a guia Monitor. Confira o status do pipeline. Selecione Atualizar para atualizar a lista. Selecione o link em Nome do pipeline para exibir os detalhes da execução da atividade ou execute o pipeline novamente.

Há apenas uma atividade (a atividade de cópia) no pipeline. Assim, você vê apenas uma entrada. Para obter detalhes sobre a operação de cópia, na página Execução de atividade, selecione o link Detalhes (ícone de óculos) na coluna Nome da atividade. Para obter detalhes sobre as propriedades, confira Visão geral da atividade Copy.

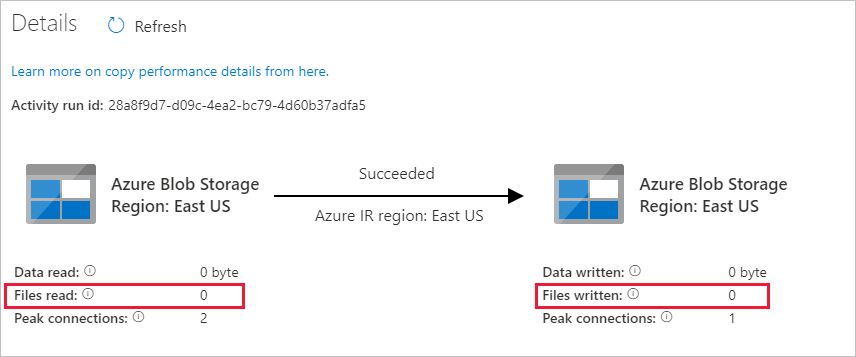

Como não há arquivos no contêiner de origem em sua conta de armazenamento de Blob, você não verá nenhum arquivo copiado para o contêiner de destino na conta:

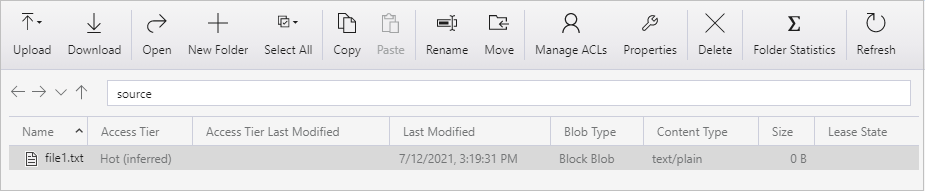

Crie um arquivo de texto vazio e nomeie-o arquivo1.txt. Carregue o arquivo de texto no contêiner de origem em sua conta de armazenamento. É possível usar várias ferramentas para executar estas tarefas, como o Gerenciador de Armazenamento do Azure.

Para voltar à exibição de Execuções de pipeline, selecione o link Todas as execuções de pipeline no menu barra de trilha na página Execução de atividade e aguarde até que o mesmo pipeline seja disparado automaticamente de novo.

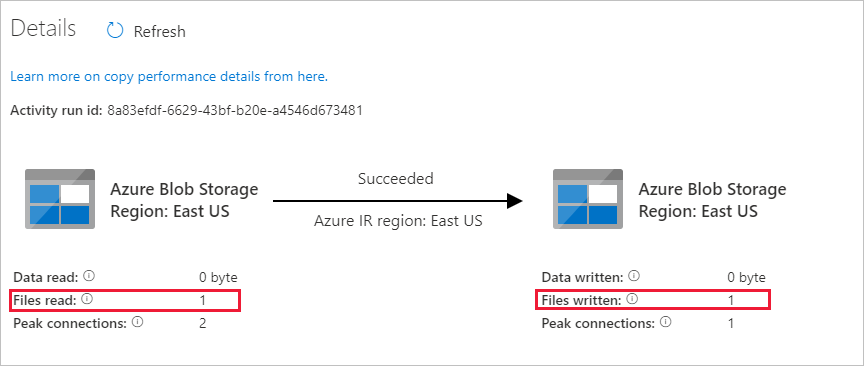

Quando a segunda execução de pipeline for concluída, siga as mesmas etapas mencionadas anteriormente para examinar os detalhes da execução da atividade.

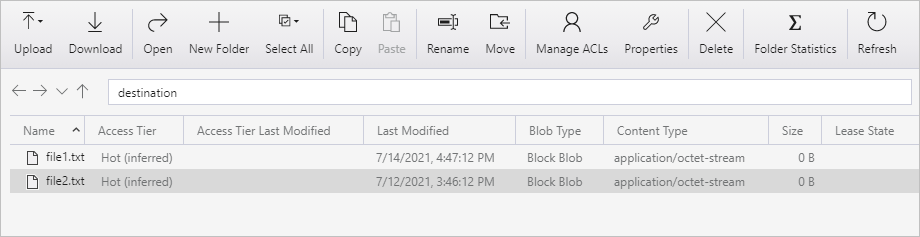

Você verá que o arquivo (arquivo1.txt) foi copiado do contêiner de origem para o contêiner de destino da sua conta de armazenamento de Blob:

Crie outro arquivo de texto vazio e nomeie-o arquivo2.txt. Carregue o arquivo de texto no contêiner de origem em sua conta de armazenamento de Blob.

Repita as etapas 11 e 12 para o segundo arquivo de texto. Você verá que apenas o novo arquivo (arquivo2.txt) foi copiado do contêiner de origem para o contêiner de destino da sua conta de armazenamento durante a execução desse pipeline.

Você também pode examinar se apenas um arquivo foi copiado usando o Gerenciador de Armazenamento do Azure para verificar os arquivos:

Conteúdo relacionado

Acesse o tutorial a seguir para saber como transformar dados usando um cluster Apache Spark no Azure: