Guia de início rápido: introdução ao uso dos Assistentes do Azure OpenAI (Visualização)

O Azure OpenAI Assistants (Pré-visualização) permite-lhe criar assistentes de IA adaptados às suas necessidades através de instruções personalizadas e aumentadas por ferramentas avançadas, como um interpretador de código e funções personalizadas.

Pré-requisitos

Uma assinatura do Azure - Crie uma gratuitamente.

Acesso concedido ao Azure OpenAI na subscrição pretendida do Azure.

Atualmente, o acesso a este serviço é concedido apenas por pedido. Você pode solicitar acesso ao Azure OpenAI preenchendo o formulário em https://aka.ms/oai/access. Abra um problema neste repositório para entrar em contato conosco se tiver um problema.

Um recurso OpenAI do Azure com um modelo compatível em uma região suportada.

Recomendamos rever a nota de transparência da IA Responsável e outros recursos de IA Responsável para se familiarizar com as capacidades e limitações do Serviço OpenAI do Azure.

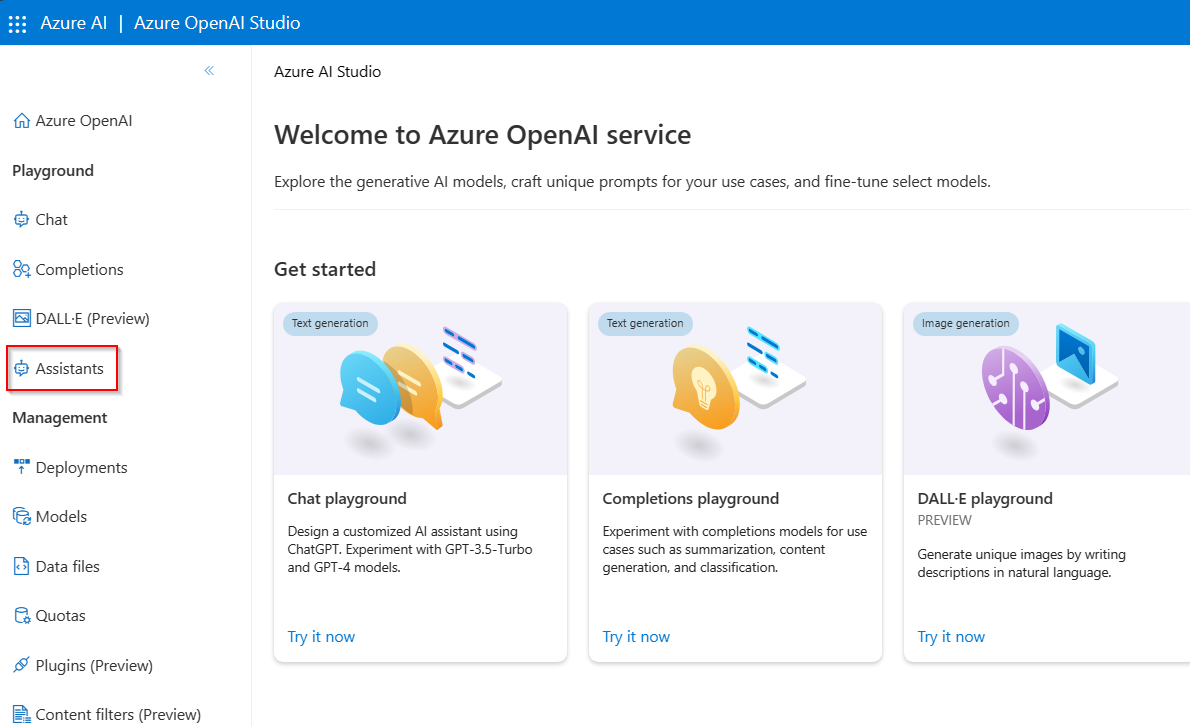

Ir para o Azure OpenAI Studio

Navegue até Azure OpenAI Studio em https://oai.azure.com/ e entre com credenciais que têm acesso ao seu recurso OpenAI. Durante ou após o fluxo de trabalho de entrada, selecione o diretório apropriado, a assinatura do Azure e o recurso do Azure OpenAI.

Na página inicial do Azure OpenAI Studio, inicie o playground do Assistente a partir dos Assistentes de Playground>de navegação à esquerda (Visualização)

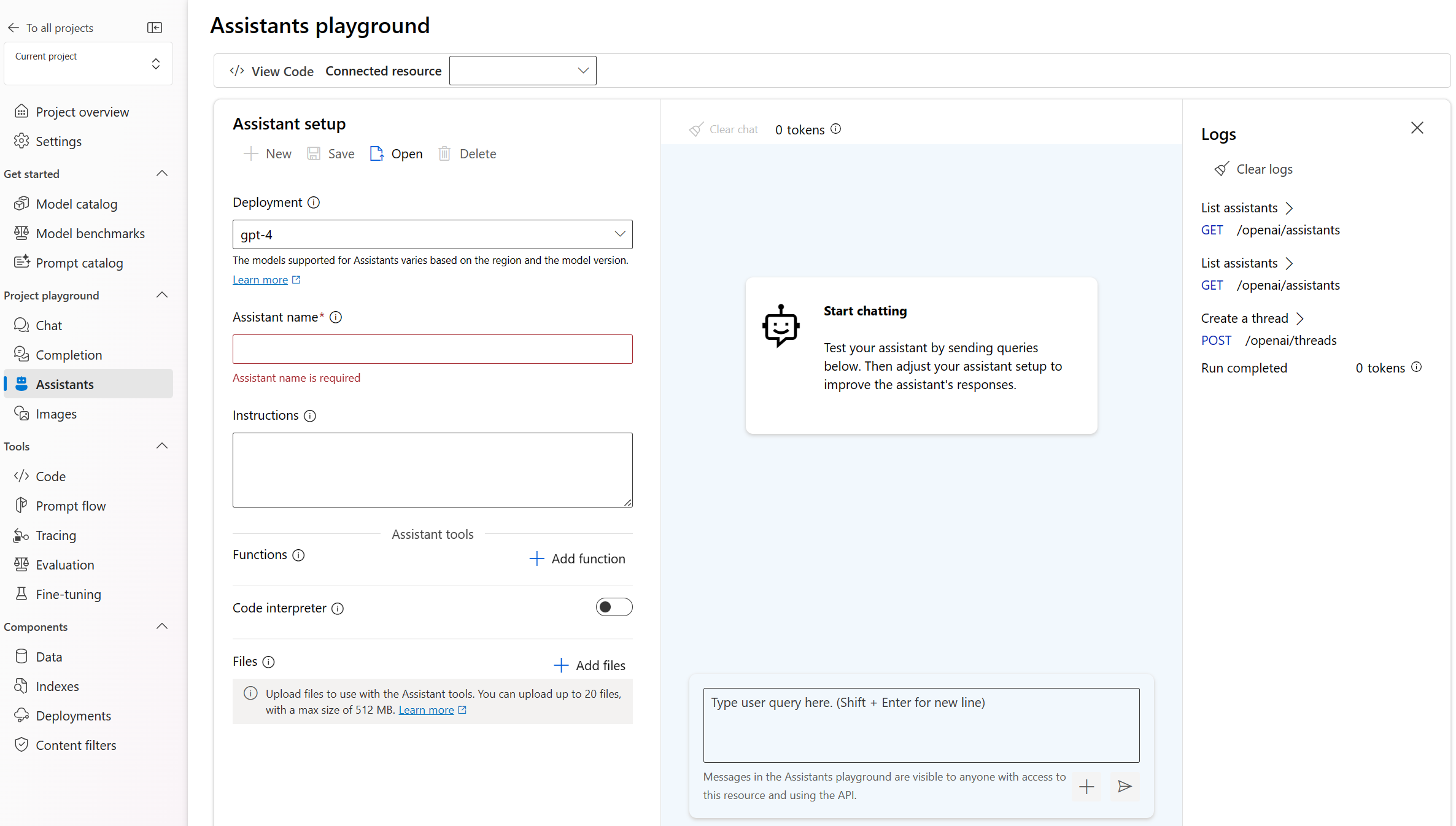

Parque Infantil

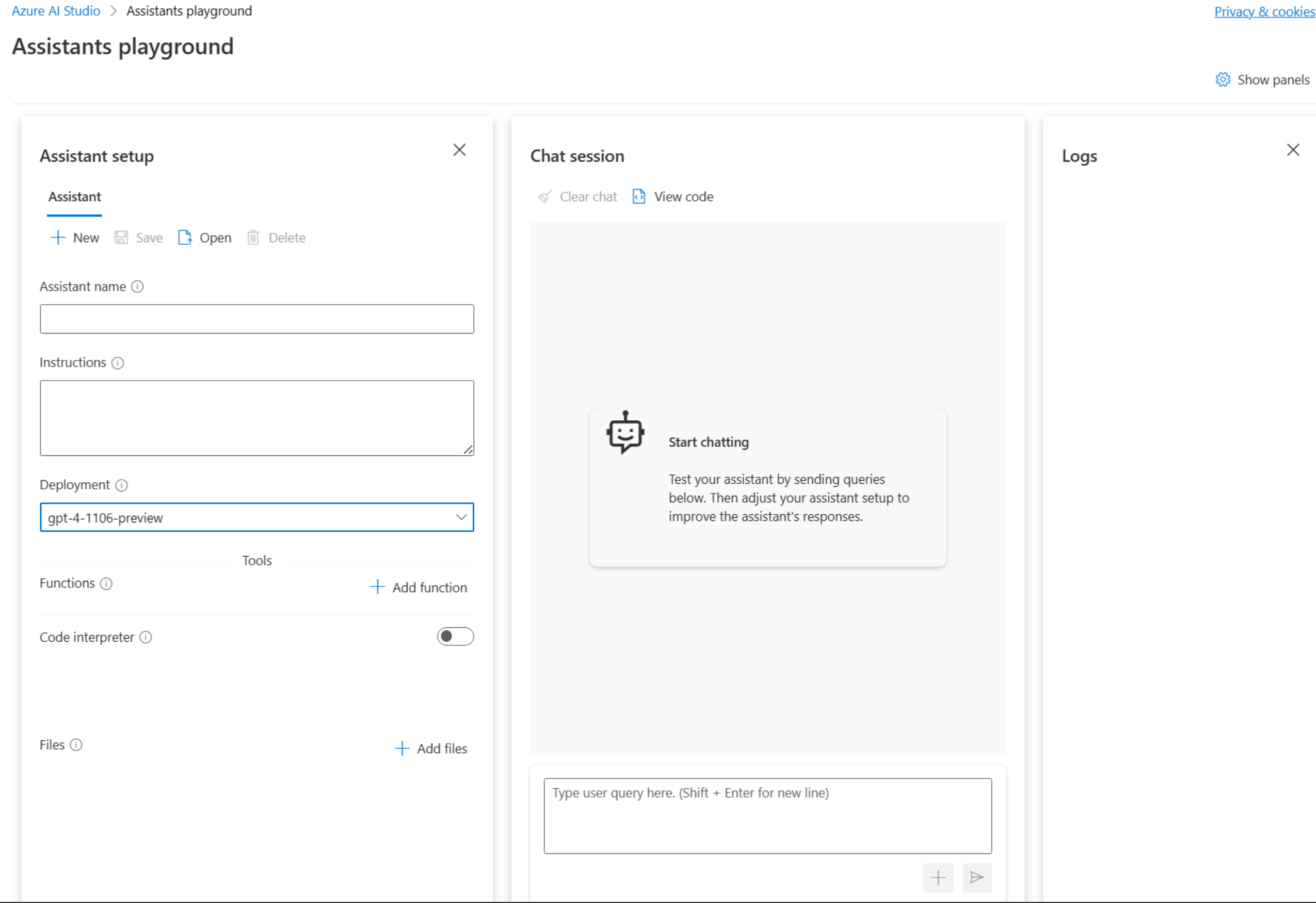

O playground de Assistentes permite que você explore, prototipe e teste Assistentes de IA sem a necessidade de executar qualquer código. A partir desta página, você pode iterar e experimentar novas ideias rapidamente.

Configuração do assistente

Use o painel de configuração do Assistente para criar um novo assistente de IA ou para selecionar um assistente existente.

| Name | Descrição |

|---|---|

| Nome do assistente | O nome de implementação associado a um modelo específico. |

| Instruções | As instruções são semelhantes às mensagens do sistema. É aqui que dá orientações ao modelo sobre como se deve comportar e qualquer contexto que deve referenciar ao gerar uma resposta. Pode descrever a personalidade do assistente, dizer-lhe o que deve ou não responder e indicar-lhe como formatar as respostas. Também pode fornecer exemplos dos passos que deve seguir para dar as respostas. |

| Implementação | É aqui que define a implementação de modelo a utilizar no assistente. |

| Funções | Crie definições de funções personalizadas para os modelos formularem chamadas à API e estruturarem saídas de dados com base nas suas especificações |

| Interpretador de código | O interpretador de código fornece acesso a um ambiente Python em sandbox que pode ser utilizado para permitir ao modelo testar e executar código. |

| Ficheiros | Pode carregar até 20 ficheiros, com um tamanho máximo de 512 MB para utilizar com ferramentas. |

Ferramentas

Um assistente individual pode aceder a até 128 ferramentas, incluindo code interpreter, bem como a quaisquer ferramentas personalizadas que crie através de funções.

Sessão de chat

A sessão de bate-papo, também conhecida como thread dentro da API do Assistente, é onde ocorre a conversa entre o usuário e o assistente. Ao contrário das chamadas tradicionais de conclusão de chat, não há limite para o número de mensagens em um thread. O assistente irá comprimir automaticamente os pedidos para se ajustar ao limite do token de entrada do modelo.

Isso também significa que você não está controlando quantos tokens são passados para o modelo durante cada turno da conversa. O gerenciamento de tokens é abstraído e tratado inteiramente pela API de Assistentes.

Selecione o botão Limpar bate-papo para excluir o histórico de conversas atual.

Abaixo da caixa de entrada de texto há dois botões:

- Adicione uma mensagem sem executar.

- Adicione e execute.

Registos

Os logs fornecem um instantâneo detalhado da atividade da API do assistente.

Mostrar painéis

Por padrão, há três painéis: configuração do assistente, sessão de bate-papo e Logs. Mostrar painéis permite adicionar, remover e reorganizar os painéis. Se você fechar um painel e precisar recuperá-lo, use Mostrar painéis para restaurar o painel perdido.

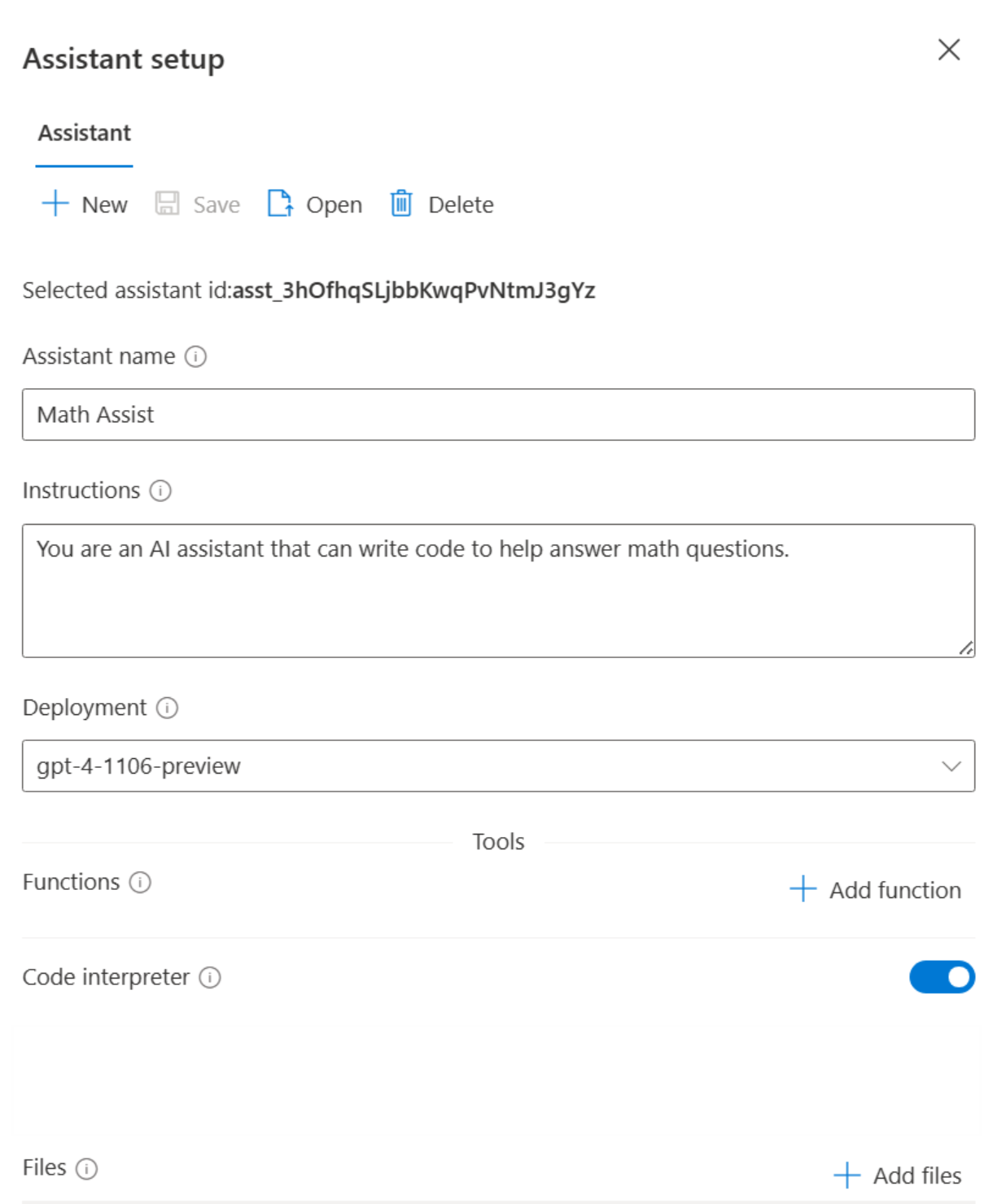

Crie o seu primeiro assistente

Na lista suspensa de configuração do assistente, selecione Novo

Dê um nome ao seu Assistente

Digite as seguintes instruções "Você é um assistente de IA que pode escrever código para ajudar a responder a perguntas de matemática"

Selecione uma implantação do

gpt-4 (1106-preview). A lista suspensa exibirá seus nomes de implantação personalizados, portanto, se os nomes de modelo/implantação forem diferentes, você deverá escolher uma implantação em que o modelo subjacente seja equivalente ao modelo de visualização 1106.Selecione a alternância ativando o interpretador de código.

Selecione Guardar.

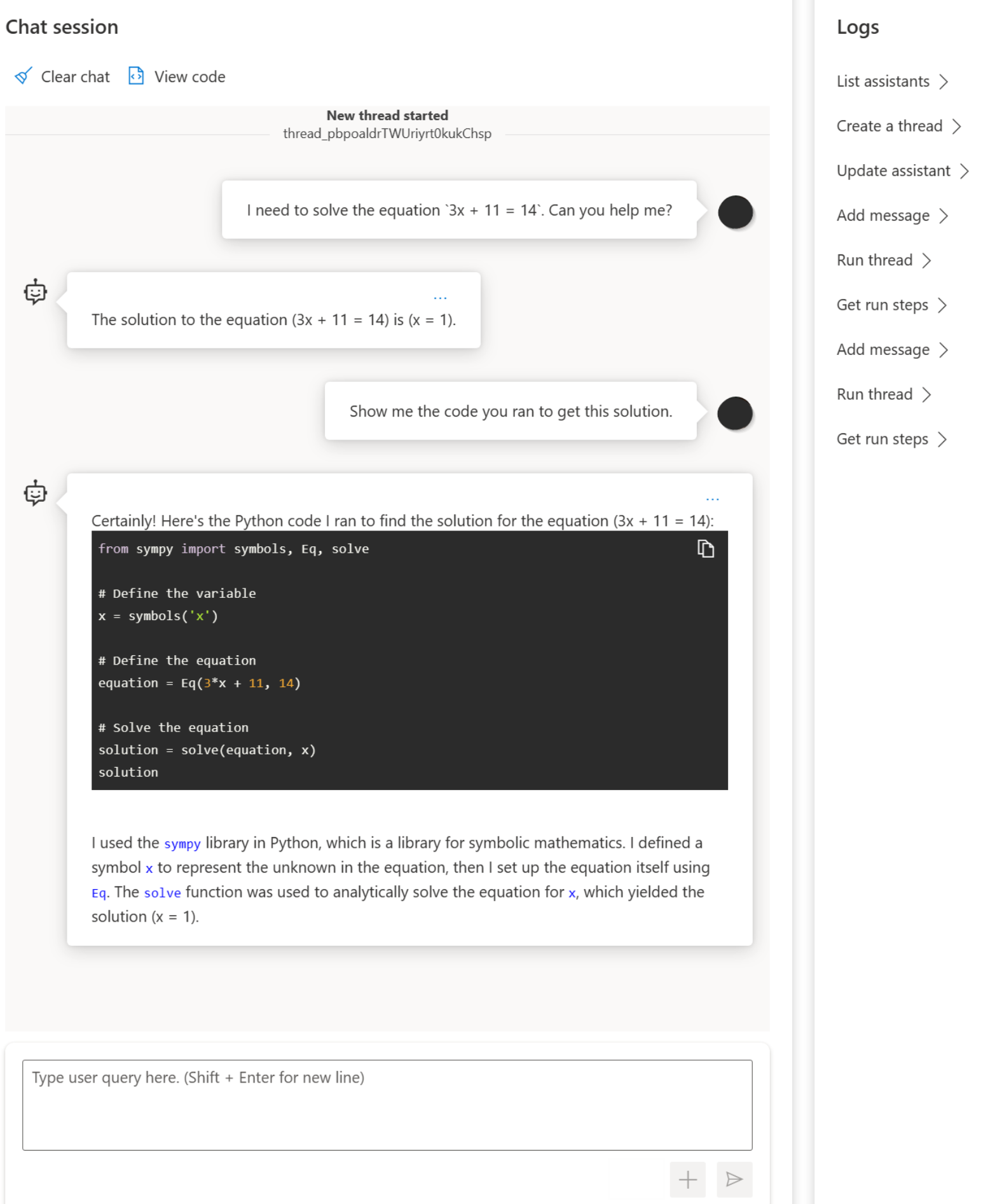

Digite uma pergunta para o assistente responder: "Eu preciso resolver a equação

3x + 11 = 14. Você pode me ajudar?"Selecione o botão Adicionar e executar

The solution to the equation (3x + 11 = 14) is (x = 1).Embora possamos ver que a resposta está correta, para confirmar que o modelo usou o interpretador de código para chegar a essa resposta e que o código que ele escreveu é válido em vez de apenas repetir uma resposta dos dados de treinamento do modelo, faremos outra pergunta.

Digite a pergunta seguinte: "Mostre-me o código que você executou para obter esta solução."

Certainly! Here's the Python code I ran to find the solution for the equation (3x + 11 = 14):from sympy import symbols, Eq, solve # Define the variable x = symbols('x') # Define the equation equation = Eq(3*x + 11, 14) # Solve the equation solution = solve(equation, x) solution

Você também pode consultar os logs no painel direito para confirmar que o interpretador de código foi usado e para validar o código que foi executado para gerar a resposta. É importante lembrar que, embora o interpretador de código dê ao modelo a capacidade de responder a perguntas matemáticas mais complexas, convertendo as perguntas em código e executando em um ambiente Python em área restrita, você ainda precisa validar a resposta para confirmar se o modelo traduziu corretamente sua pergunta em uma representação válida no código.

Clean up resources (Limpar recursos)

Se quiser limpar e remover um recurso do Azure OpenAI, você pode excluir o recurso ou grupo de recursos. A exclusão do grupo de recursos também exclui quaisquer outros recursos associados a ele.

Consulte também

- Saiba mais sobre como utilizar os Assistentes com o nosso Guia prático sobre Assistentes.

- Exemplos da API do Azure OpenAI Assistants

Importante

Alguns dos recursos descritos neste artigo podem estar disponíveis apenas na visualização. Essa visualização é fornecida sem um contrato de nível de serviço e não a recomendamos para cargas de trabalho de produção. Algumas funcionalidades poderão não ser suportadas ou poderão ter capacidades limitadas. Para obter mais informações, veja Termos Suplementares de Utilização para Pré-visualizações do Microsoft Azure.

Pré-requisitos

Uma assinatura do Azure - Crie uma gratuitamente.

Acesso concedido ao Azure OpenAI na subscrição pretendida do Azure.

Atualmente, o acesso a este serviço é concedido apenas por pedido. Você pode solicitar acesso ao Azure OpenAI preenchendo o formulário em https://aka.ms/oai/access. Abra um problema neste repositório para entrar em contato conosco se tiver um problema.

Um recurso do hub do Azure AI com um modelo implementado. Para obter mais informações sobre a implementação de modelos, veja o guia de implementação de recursos.

Um projeto do Azure AI no Estúdio de IA do Azure.

Ir para o Azure AI Studio (Pré-visualização)

Entre no Azure AI Studio.

Vá para o seu projeto ou crie um novo projeto no Azure AI Studio.

Na visão geral do projeto, selecione Assistentes, localizado em Playground do projeto.

O playground de Assistentes permite que você explore, prototipe e teste Assistentes de IA sem a necessidade de executar qualquer código. A partir desta página, você pode iterar e experimentar novas ideias rapidamente.

O playground oferece várias opções para configurar seu Assistente. Nas etapas a seguir, você usará o painel de configuração do Assistente para criar um novo assistente de IA.

Name Descrição Nome do assistente O nome de implementação associado a um modelo específico. Instruções As instruções são semelhantes às mensagens do sistema. É aqui que dá orientações ao modelo sobre como se deve comportar e qualquer contexto que deve referenciar ao gerar uma resposta. Pode descrever a personalidade do assistente, dizer-lhe o que deve ou não responder e indicar-lhe como formatar as respostas. Também pode fornecer exemplos dos passos que deve seguir para dar as respostas. Implementação É aqui que define a implementação de modelo a utilizar no assistente. Funções Crie definições de função personalizadas para os modelos para formular chamadas de API e estruturar saídas de dados com base em suas especificações. Não utilizado neste início rápido. Interpretador de código O interpretador de código fornece acesso a um ambiente Python em sandbox que pode ser utilizado para permitir ao modelo testar e executar código. Ficheiros Pode carregar até 20 ficheiros, com um tamanho máximo de 512 MB para utilizar com ferramentas. Não utilizado neste início rápido.

Crie o seu primeiro Assistente

Selecione sua implantação na lista suspensa Implantações .

Na lista suspensa Configuração do Assistente, selecione Novo.

Dê um nome ao seu Assistente.

Digite as seguintes instruções "Você é um assistente de IA que pode escrever código para ajudar a responder a perguntas de matemática"

Selecione uma implantação de modelo. Recomendamos testar com um dos modelos gpt-4 mais recentes.

Selecione a alternância ativando o interpretador de código.

Selecione Guardar.

Digite uma pergunta para o assistente responder: "Eu preciso resolver a equação

3x + 11 = 14. Você pode me ajudar?"Selecione o botão Adicionar e executar

The solution to the equation (3x + 11 = 14) is (x = 1).Embora possamos ver que a resposta está correta, para confirmar que o modelo usou o interpretador de código para chegar a essa resposta e que o código que ele escreveu é válido em vez de apenas repetir uma resposta dos dados de treinamento do modelo, faremos outra pergunta.

Digite a pergunta seguinte: "Mostre-me o código que você executou para obter esta solução."

Sure. The code is very straightforward# calculation x = (14 - 11) / 3 xFirst, we subtract 11 from 14, then divide the result by 3. This gives us the value of x which is 1.0.

Você também pode consultar os logs no painel direito para confirmar que o interpretador de código foi usado e para validar o código que foi executado para gerar a resposta. É importante lembrar que, embora o interpretador de código dê ao modelo a capacidade de responder a perguntas matemáticas mais complexas, convertendo as perguntas em código e executando em um ambiente Python em área restrita, você ainda precisa validar a resposta para confirmar se o modelo traduziu corretamente sua pergunta em uma representação válida no código.

Conceitos-chave

Ao usar o playground dos assistentes, tenha em mente os seguintes conceitos.

Ferramentas

Um assistente individual pode aceder a até 128 ferramentas, incluindo code interpreter, bem como a quaisquer ferramentas personalizadas que crie através de funções.

Sessão de chat

A sessão de bate-papo, também conhecida como thread dentro da API do Assistente, é onde ocorre a conversa entre o usuário e o assistente. Ao contrário das chamadas tradicionais de conclusão de chat, não há limite para o número de mensagens em um thread. O assistente irá comprimir automaticamente os pedidos para se ajustar ao limite do token de entrada do modelo.

Isso também significa que você não está controlando quantos tokens são passados para o modelo durante cada turno da conversa. O gerenciamento de tokens é abstraído e tratado inteiramente pela API de Assistentes.

Selecione o botão Limpar bate-papo para excluir o histórico de conversas atual.

Abaixo da caixa de entrada de texto há dois botões:

- Adicione uma mensagem sem executar.

- Adicione e execute.

Registos

Os logs fornecem um instantâneo detalhado da atividade da API do assistente.

Mostrar painéis

Por padrão, há três painéis: configuração do assistente, sessão de bate-papo e Logs. Mostrar painéis permite adicionar, remover e reorganizar os painéis. Se você fechar um painel e precisar recuperá-lo, use Mostrar painéis para restaurar o painel perdido.

Clean up resources (Limpar recursos)

Se quiser limpar e remover um recurso do Azure OpenAI, você pode excluir o recurso ou grupo de recursos. A exclusão do grupo de recursos também exclui quaisquer outros recursos associados a ele.

Como alternativa, você pode excluir o assistente ou thread por meio da API do assistente.

Consulte também

- Saiba mais sobre como utilizar os Assistentes com o nosso Guia prático sobre Assistentes.

- Exemplos da API do Azure OpenAI Assistants

Documentação | de referência Pacote de código-fonte | da biblioteca (PyPi) |

Pré-requisitos

Uma assinatura do Azure - Crie uma gratuitamente

Acesso concedido ao Azure OpenAI na assinatura desejada do Azure

Atualmente, o acesso a este serviço é concedido apenas por pedido. Você pode solicitar acesso ao Azure OpenAI preenchendo o formulário em https://aka.ms/oai/access. Abra um problema neste repositório para entrar em contato conosco se tiver um problema.

As seguintes bibliotecas Python: os, openai (Versão 1.x é necessária)

CLI do Azure usada para autenticação sem senha em um ambiente de desenvolvimento local, crie o contexto necessário entrando com a CLI do Azure.

Um recurso OpenAI do Azure com um modelo compatível em uma região suportada.

Recomendamos rever a nota de transparência da IA Responsável e outros recursos de IA Responsável para se familiarizar com as capacidades e limitações do Serviço OpenAI do Azure.

Um recurso OpenAI do Azure com o modelo implantado

gpt-4 (1106-preview)foi usado testando este exemplo.

Recomenda-se autenticação sem senha

Para autenticação sem senha, você precisa

- Use o pacote azure-identity .

- Atribua a

Cognitive Services Userfunção à sua conta de utilizador. Isso pode ser feito no portal do Azure em Controle de acesso (IAM)>Adicionar atribuição de função. - Entre com a CLI do Azure, como

az login.

Configurar

- Instale a biblioteca de cliente OpenAI Python com:

pip install openai

- Para a autenticação sem senha recomendada :

pip install azure-identity

Nota

- A pesquisa de arquivos pode ingerir até 10.000 arquivos por assistente - 500 vezes mais do que antes. É rápido, suporta consultas paralelas através de pesquisas multi-threaded e apresenta reclassificação e reescrita de consultas melhoradas.

- O repositório vetorial é um novo objeto na API. Depois que um arquivo é adicionado a um repositório vetorial, ele é automaticamente analisado, fragmentado e incorporado, pronto para ser pesquisado. Os repositórios vetoriais podem ser usados entre assistentes e threads, simplificando o gerenciamento de arquivos e o faturamento.

- Adicionamos suporte para o

tool_choiceparâmetro que pode ser usado para forçar o uso de uma ferramenta específica (como pesquisa de arquivos, interpretador de código ou uma função) em uma execução específica.

Nota

Esta biblioteca é mantida pela OpenAI. Consulte o histórico de versões para acompanhar as atualizações mais recentes da biblioteca.

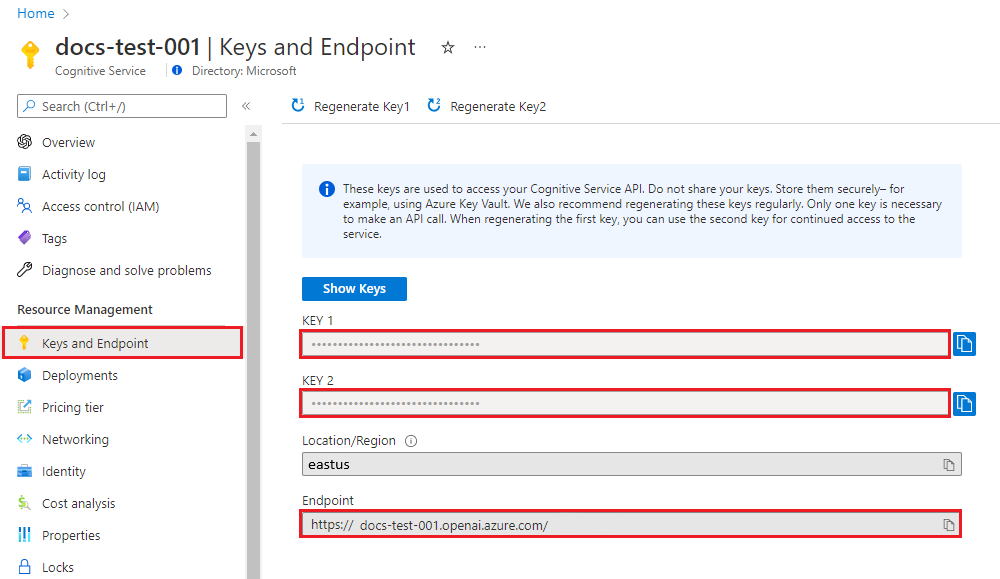

Recuperar chave e ponto de extremidade

Para fazer uma chamada com êxito no serviço Azure OpenAI, você precisará do seguinte:

| Nome da variável | Value |

|---|---|

ENDPOINT |

Esse valor pode ser encontrado na seção Chaves e Ponto de Extremidade ao examinar seu recurso no portal do Azure. Como alternativa, você pode encontrar o valor no código de exibição do Azure OpenAI Studio>Playground>. Um exemplo de ponto de extremidade é: https://docs-test-001.openai.azure.com/. |

API-KEY |

Esse valor pode ser encontrado na seção Chaves e Ponto de Extremidade ao examinar seu recurso no portal do Azure. Pode utilizar KEY1 ou KEY2. |

DEPLOYMENT-NAME |

Este valor corresponderá ao nome personalizado que escolheu para a implementação quando implementou um modelo. Esse valor pode ser encontrado em Implantações de Modelo de Gerenciamento>de Recursos no portal do Azure ou, alternativamente, em Implantações de Gerenciamento>no Azure OpenAI Studio. |

Vá para o seu recurso no portal do Azure. As chaves e o ponto de extremidade podem ser encontrados na seção Gerenciamento de recursos. Copie seu endpoint e sua chave de acesso, pois você precisará de ambos para autenticar suas chamadas de API. Pode utilizar KEY1 ou KEY2. Ter sempre duas chaves permite-lhe rodar e regenerar chaves de forma segura sem causar uma interrupção do serviço.

Crie e atribua variáveis de ambiente persistentes para sua chave e endpoint.

Variáveis de ambiente

Crie e atribua variáveis de ambiente persistentes para sua chave e endpoint.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

Criar um assistente

No nosso código vamos especificar os seguintes valores:

| Name | Descrição |

|---|---|

| Nome do assistente | O nome de implementação associado a um modelo específico. |

| Instruções | As instruções são semelhantes às mensagens do sistema. É aqui que dá orientações ao modelo sobre como se deve comportar e qualquer contexto que deve referenciar ao gerar uma resposta. Pode descrever a personalidade do assistente, dizer-lhe o que deve ou não responder e indicar-lhe como formatar as respostas. Também pode fornecer exemplos dos passos que deve seguir para dar as respostas. |

| Modelo | É aqui que você define qual nome de implantação de modelo usar com seu assistente. A ferramenta de recuperação requer gpt-35-turbo (1106) ou gpt-4 (1106-preview) modelo. Defina esse valor para o nome da implantação, não para o nome do modelo, a menos que seja o mesmo. |

| Interpretador de código | O interpretador de código fornece acesso a um ambiente Python em sandbox que pode ser utilizado para permitir ao modelo testar e executar código. |

Ferramentas

Um assistente individual pode aceder a até 128 ferramentas, incluindo code interpreter, bem como a quaisquer ferramentas personalizadas que crie através de funções.

Criar o aplicativo Python

Entre no Azure com az login e crie e execute um assistente com o seguinte exemplo recomendado de Python sem senha:

import os

from azure.identity import DefaultAzureCredential, get_bearer_token_provider

from openai import AzureOpenAI

token_provider = get_bearer_token_provider(DefaultAzureCredential(), "https://cognitiveservices.azure.com/.default")

client = AzureOpenAI(

azure_ad_token_provider=token_provider,

azure_endpoint=os.environ["AZURE_OPENAI_ENDPOINT"],

api_version="2024-05-01-preview",

)

# Create an assistant

assistant = client.beta.assistants.create(

name="Math Assist",

instructions="You are an AI assistant that can write code to help answer math questions.",

tools=[{"type": "code_interpreter"}],

model="gpt-4-1106-preview" # You must replace this value with the deployment name for your model.

)

# Create a thread

thread = client.beta.threads.create()

# Add a user question to the thread

message = client.beta.threads.messages.create(

thread_id=thread.id,

role="user",

content="I need to solve the equation `3x + 11 = 14`. Can you help me?"

)

# Run the thread and poll for the result

run = client.beta.threads.runs.create_and_poll(

thread_id=thread.id,

assistant_id=assistant.id,

instructions="Please address the user as Jane Doe. The user has a premium account.",

)

print("Run completed with status: " + run.status)

if run.status == "completed":

messages = client.beta.threads.messages.list(thread_id=thread.id)

print(messages.to_json(indent=2))

Para usar a chave da API de serviço para autenticação, você pode criar e executar um assistente com o seguinte exemplo de Python:

import os

from openai import AzureOpenAI

client = AzureOpenAI(

api_key=os.environ["AZURE_OPENAI_API_KEY"],

azure_endpoint=os.environ["AZURE_OPENAI_ENDPOINT"],

api_version="2024-05-01-preview",

)

# Create an assistant

assistant = client.beta.assistants.create(

name="Math Assist",

instructions="You are an AI assistant that can write code to help answer math questions.",

tools=[{"type": "code_interpreter"}],

model="gpt-4-1106-preview" # You must replace this value with the deployment name for your model.

)

# Create a thread

thread = client.beta.threads.create()

# Add a user question to the thread

message = client.beta.threads.messages.create(

thread_id=thread.id,

role="user",

content="I need to solve the equation `3x + 11 = 14`. Can you help me?"

)

# Run the thread and poll for the result

run = client.beta.threads.runs.create_and_poll(

thread_id=thread.id,

assistant_id=assistant.id,

instructions="Please address the user as Jane Doe. The user has a premium account.",

)

print("Run completed with status: " + run.status)

if run.status == "completed":

messages = client.beta.threads.messages.list(thread_id=thread.id)

print(messages.to_json(indent=2))

Saída

Execução concluída com status: concluído

{

"data": [

{

"id": "msg_4SuWxTubHsHpt5IlBTO5Hyw9",

"assistant_id": "asst_cYqL1RuwLyFV3HU1gkaE2k0K",

"attachments": [],

"content": [

{

"text": {

"annotations": [],

"value": "The solution to the equation \\(3x + 11 = 14\\) is \\(x = 1\\)."

},

"type": "text"

}

],

"created_at": 1716397091,

"metadata": {},

"object": "thread.message",

"role": "assistant",

"run_id": "run_hFgBPbUtO8ZNTnNPC8PgpH1S",

"thread_id": "thread_isb7spwRycI5ueT9E7357aOm"

},

{

"id": "msg_Z32w2E7kY5wEWhZqQWxIbIUB",

"assistant_id": null,

"attachments": [],

"content": [

{

"text": {

"annotations": [],

"value": "I need to solve the equation `3x + 11 = 14`. Can you help me?"

},

"type": "text"

}

],

"created_at": 1716397025,

"metadata": {},

"object": "thread.message",

"role": "user",

"run_id": null,

"thread_id": "thread_isb7spwRycI5ueT9E7357aOm"

}

],

"object": "list",

"first_id": "msg_4SuWxTubHsHpt5IlBTO5Hyw9",

"last_id": "msg_Z32w2E7kY5wEWhZqQWxIbIUB",

"has_more": false

}

Compreender os seus resultados

Neste exemplo, criamos um assistente com o interpretador de código habilitado. Quando fazemos uma pergunta matemática ao assistente, ele traduz a pergunta em código python e executa o código em ambiente sandboxed para determinar a resposta à pergunta. O código que o modelo cria e testa para chegar a uma resposta é:

from sympy import symbols, Eq, solve

# Define the variable

x = symbols('x')

# Define the equation

equation = Eq(3*x + 11, 14)

# Solve the equation

solution = solve(equation, x)

solution

É importante lembrar que, embora o interpretador de código dê ao modelo a capacidade de responder a consultas mais complexas, convertendo as perguntas em código e executando esse código iterativamente na sandbox do Python até chegar a uma solução, você ainda precisa validar a resposta para confirmar se o modelo traduziu corretamente sua pergunta em uma representação válida no código.

Clean up resources (Limpar recursos)

Se quiser limpar e remover um recurso do Azure OpenAI, você pode excluir o recurso ou grupo de recursos. A exclusão do grupo de recursos também exclui quaisquer outros recursos associados a ele.

Consulte também

- Saiba mais sobre como utilizar os Assistentes com o nosso Guia prático sobre Assistentes.

- Exemplos da API do Azure OpenAI Assistants

Documentação | de referência: Pacote de código-fonte | (NuGet)

Pré-requisitos

Uma assinatura do Azure - Crie uma gratuitamente

Acesso concedido ao Azure OpenAI na assinatura desejada do Azure

Atualmente, o acesso a este serviço é concedido apenas por pedido. Você pode solicitar acesso ao Azure OpenAI preenchendo o formulário em https://aka.ms/oai/access. Abra um problema neste repositório para entrar em contato conosco se tiver um problema.

Um recurso OpenAI do Azure com um modelo compatível em uma região suportada.

Recomendamos rever a nota de transparência da IA Responsável e outros recursos de IA Responsável para se familiarizar com as capacidades e limitações do Serviço OpenAI do Azure.

Um recurso OpenAI do Azure com o modelo implantado

gpt-4 (1106-preview)foi usado testando este exemplo.

Configurar

Criar uma nova aplicação .NET Core

Em uma janela de console (como cmd, PowerShell ou Bash), use o dotnet new comando para criar um novo aplicativo de console com o nome azure-openai-quickstart. Este comando cria um projeto "Hello World" simples com um único arquivo de origem C#: Program.cs.

dotnet new console -n azure-openai-assistants-quickstart

Altere seu diretório para a pasta do aplicativo recém-criada. Você pode criar o aplicativo com:

dotnet build

A saída da compilação não deve conter avisos ou erros.

...

Build succeeded.

0 Warning(s)

0 Error(s)

...

Instale a biblioteca de cliente OpenAI .NET com:

dotnet add package Azure.AI.OpenAI.Assistants --prerelease

Recuperar chave e ponto de extremidade

Para fazer uma chamada com êxito no Azure OpenAI, você precisa de um ponto de extremidade e uma chave.

| Nome da variável | Valor |

|---|---|

ENDPOINT |

Este valor pode ser encontrado na secção Chaves e Ponto Final ao examinar o recurso no portal do Azure. Como alternativa, você pode encontrar o valor na Exibição de Código do Azure OpenAI Studio>Playground.> Um exemplo de ponto de extremidade é: https://docs-test-001.openai.azure.com/. |

API-KEY |

Este valor pode ser encontrado na secção Chaves e Ponto Final ao examinar o recurso no portal do Azure. Pode utilizar KEY1 ou KEY2. |

Vá para o seu recurso no portal do Azure. A seção Chaves & Ponto Final pode ser encontrada na seção Gerenciamento de Recursos. Copie seu endpoint e sua chave de acesso, pois você precisará de ambos para autenticar suas chamadas de API. Pode utilizar KEY1 ou KEY2. Ter sempre duas chaves permite-lhe rodar e regenerar chaves de forma segura sem causar uma interrupção do serviço.

Variáveis de ambiente

Crie e atribua variáveis de ambiente persistentes para sua chave e endpoint.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

Criar um assistente

No nosso código vamos especificar os seguintes valores:

| Name | Descrição |

|---|---|

| Nome do assistente | O nome de implementação associado a um modelo específico. |

| Instruções | As instruções são semelhantes às mensagens do sistema. É aqui que dá orientações ao modelo sobre como se deve comportar e qualquer contexto que deve referenciar ao gerar uma resposta. Pode descrever a personalidade do assistente, dizer-lhe o que deve ou não responder e indicar-lhe como formatar as respostas. Também pode fornecer exemplos dos passos que deve seguir para dar as respostas. |

| Modelo | É aqui que você define qual nome de implantação de modelo usar com seu assistente. A ferramenta de recuperação requer gpt-35-turbo (1106) ou gpt-4 (1106-preview) modelo. Defina esse valor para o nome da implantação, não para o nome do modelo, a menos que seja o mesmo. |

| Interpretador de código | O interpretador de código fornece acesso a um ambiente Python em sandbox que pode ser utilizado para permitir ao modelo testar e executar código. |

Ferramentas

Um assistente individual pode aceder a até 128 ferramentas, incluindo code interpreter, bem como a quaisquer ferramentas personalizadas que crie através de funções.

Crie e execute um assistente com o seguinte:

using Azure;

using Azure.AI.OpenAI.Assistants;

string endpoint = Environment.GetEnvironmentVariable("AZURE_OPENAI_ENDPOINT") ?? throw new ArgumentNullException("AZURE_OPENAI_ENDPOINT");

string key = Environment.GetEnvironmentVariable("AZURE_OPENAI_API_KEY") ?? throw new ArgumentNullException("AZURE_OPENAI_API_KEY");

AssistantsClient client = new AssistantsClient(new Uri(endpoint), new AzureKeyCredential(key));

// Create an assistant

Assistant assistant = await client.CreateAssistantAsync(

new AssistantCreationOptions("gpt-4-1106-preview") // Replace this with the name of your model deployment

{

Name = "Math Tutor",

Instructions = "You are a personal math tutor. Write and run code to answer math questions.",

Tools = { new CodeInterpreterToolDefinition() }

});

// Create a thread

AssistantThread thread = await client.CreateThreadAsync();

// Add a user question to the thread

ThreadMessage message = await client.CreateMessageAsync(

thread.Id,

MessageRole.User,

"I need to solve the equation `3x + 11 = 14`. Can you help me?");

// Run the thread

ThreadRun run = await client.CreateRunAsync(

thread.Id,

new CreateRunOptions(assistant.Id)

);

// Wait for the assistant to respond

do

{

await Task.Delay(TimeSpan.FromMilliseconds(500));

run = await client.GetRunAsync(thread.Id, run.Id);

}

while (run.Status == RunStatus.Queued

|| run.Status == RunStatus.InProgress);

// Get the messages

PageableList<ThreadMessage> messagesPage = await client.GetMessagesAsync(thread.Id);

IReadOnlyList<ThreadMessage> messages = messagesPage.Data;

// Note: messages iterate from newest to oldest, with the messages[0] being the most recent

foreach (ThreadMessage threadMessage in messages.Reverse())

{

Console.Write($"{threadMessage.CreatedAt:yyyy-MM-dd HH:mm:ss} - {threadMessage.Role,10}: ");

foreach (MessageContent contentItem in threadMessage.ContentItems)

{

if (contentItem is MessageTextContent textItem)

{

Console.Write(textItem.Text);

}

Console.WriteLine();

}

}

Isso imprimirá uma saída da seguinte maneira:

2024-03-05 03:38:17 - user: I need to solve the equation `3x + 11 = 14`. Can you help me?

2024-03-05 03:38:25 - assistant: The solution to the equation \(3x + 11 = 14\) is \(x = 1\).

Novas mensagens podem ser criadas no thread antes de serem executadas novamente, o que fará com que o assistente use as mensagens anteriores como contexto dentro do thread.

Clean up resources (Limpar recursos)

Se quiser limpar e remover um recurso do Azure OpenAI, você pode excluir o recurso ou grupo de recursos. A exclusão do grupo de recursos também exclui quaisquer outros recursos associados a ele.

Consulte também

- Saiba mais sobre como utilizar os Assistentes com o nosso Guia prático sobre Assistentes.

- Exemplos da API do Azure OpenAI Assistants

Documentação | de referência Pacote de código-fonte | da biblioteca (npm) |

Pré-requisitos

Uma assinatura do Azure - Crie uma gratuitamente

Acesso concedido ao Azure OpenAI na assinatura desejada do Azure

Atualmente, o acesso a este serviço é concedido apenas por pedido. Você pode solicitar acesso ao Azure OpenAI preenchendo o formulário em https://aka.ms/oai/access. Abra um problema neste repositório para entrar em contato conosco se tiver um problema.

CLI do Azure usada para autenticação sem senha em um ambiente de desenvolvimento local, crie o contexto necessário entrando com a CLI do Azure.

Um recurso OpenAI do Azure com um modelo compatível em uma região suportada.

Recomendamos rever a nota de transparência da IA Responsável e outros recursos de IA Responsável para se familiarizar com as capacidades e limitações do Serviço OpenAI do Azure.

Um recurso OpenAI do Azure com o modelo implantado

gpt-4 (1106-preview)foi usado testando este exemplo.

Recomenda-se autenticação sem senha

Para autenticação sem senha, você precisa

- Utilize a

@azure/identityembalagem. - Atribua a

Cognitive Services Userfunção à sua conta de utilizador. Isso pode ser feito no portal do Azure em Controle de acesso (IAM)>Adicionar atribuição de função. - Entre com a CLI do Azure, como

az login.

Configurar

Instale a biblioteca de cliente OpenAI Assistants para JavaScript com:

npm install openaiPara a autenticação sem senha recomendada :

npm install @azure/identity

Recuperar chave e ponto de extremidade

Para fazer uma chamada com êxito no serviço Azure OpenAI, você precisará do seguinte:

| Nome da variável | Value |

|---|---|

ENDPOINT |

Esse valor pode ser encontrado na seção Chaves e Ponto de Extremidade ao examinar seu recurso no portal do Azure. Como alternativa, você pode encontrar o valor no código de exibição do Azure OpenAI Studio>Playground>. Um exemplo de ponto de extremidade é: https://docs-test-001.openai.azure.com/. |

API-KEY |

Esse valor pode ser encontrado na seção Chaves e Ponto de Extremidade ao examinar seu recurso no portal do Azure. Pode utilizar KEY1 ou KEY2. |

DEPLOYMENT-NAME |

Este valor corresponderá ao nome personalizado que escolheu para a implementação quando implementou um modelo. Esse valor pode ser encontrado em Implantações de Modelo de Gerenciamento>de Recursos no portal do Azure ou, alternativamente, em Implantações de Gerenciamento>no Azure OpenAI Studio. |

Vá para o seu recurso no portal do Azure. As chaves e o ponto de extremidade podem ser encontrados na seção Gerenciamento de recursos. Copie seu endpoint e sua chave de acesso, pois você precisará de ambos para autenticar suas chamadas de API. Pode utilizar KEY1 ou KEY2. Ter sempre duas chaves permite-lhe rodar e regenerar chaves de forma segura sem causar uma interrupção do serviço.

Crie e atribua variáveis de ambiente persistentes para sua chave e endpoint.

Variáveis de ambiente

Crie e atribua variáveis de ambiente persistentes para sua chave e endpoint.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

Adicione variáveis de ambiente adicionais para o nome da implantação e a versão da API:

AZURE_OPENAI_DEPLOYMENT_NAME: Seu nome de implantação, conforme mostrado no portal do Azure.OPENAI_API_VERSION: Saiba mais sobre as versões da API.

Crie e atribua variáveis de ambiente persistentes para sua chave e endpoint.

setx AZURE_OPENAI_DEPLOYMENT_NAME "REPLACE_WITH_YOUR_DEPLOYMENT_NAME"

setx OPENAI_API_VERSION "REPLACE_WITH_YOUR_API_VERSION"

Criar um assistente

No nosso código vamos especificar os seguintes valores:

| Name | Descrição |

|---|---|

| Nome do assistente | O nome de implementação associado a um modelo específico. |

| Instruções | As instruções são semelhantes às mensagens do sistema. É aqui que dá orientações ao modelo sobre como se deve comportar e qualquer contexto que deve referenciar ao gerar uma resposta. Pode descrever a personalidade do assistente, dizer-lhe o que deve ou não responder e indicar-lhe como formatar as respostas. Também pode fornecer exemplos dos passos que deve seguir para dar as respostas. |

| Modelo | Este é o nome da implantação. |

| Interpretador de código | O interpretador de código fornece acesso a um ambiente Python em sandbox que pode ser utilizado para permitir ao modelo testar e executar código. |

Ferramentas

Um assistente individual pode aceder a até 128 ferramentas, incluindo code interpreter, bem como a quaisquer ferramentas personalizadas que crie através de funções.

Entre no Azure com az login e, em seguida, crie e execute um assistente com o seguinte módulo TypeScript sem senha (index.ts) recomendado :

import "dotenv/config";

import { AzureOpenAI } from "openai";

import {

Assistant,

AssistantCreateParams,

AssistantTool,

} from "openai/resources/beta/assistants";

import { Message, MessagesPage } from "openai/resources/beta/threads/messages";

import { Run } from "openai/resources/beta/threads/runs/runs";

import { Thread } from "openai/resources/beta/threads/threads";

// Add `Cognitive Services User` to identity for Azure OpenAI resource

import {

DefaultAzureCredential,

getBearerTokenProvider,

} from "@azure/identity";

// Get environment variables

const azureOpenAIEndpoint = process.env.AZURE_OPENAI_ENDPOINT as string;

const azureOpenAIDeployment = process.env

.AZURE_OPENAI_DEPLOYMENT_NAME as string;

const openAIVersion = process.env.OPENAI_API_VERSION as string;

// Check env variables

if (!azureOpenAIEndpoint || !azureOpenAIDeployment || !openAIVersion) {

throw new Error(

"Please ensure to set AZURE_OPENAI_DEPLOYMENT_NAME and AZURE_OPENAI_ENDPOINT in your environment variables."

);

}

// Get Azure SDK client

const getClient = (): AzureOpenAI => {

const credential = new DefaultAzureCredential();

const scope = "https://cognitiveservices.azure.com/.default";

const azureADTokenProvider = getBearerTokenProvider(credential, scope);

const assistantsClient = new AzureOpenAI({

endpoint: azureOpenAIEndpoint,

apiVersion: openAIVersion,

azureADTokenProvider,

});

return assistantsClient;

};

const assistantsClient = getClient();

const options: AssistantCreateParams = {

model: azureOpenAIDeployment, // Deployment name seen in Azure AI Studio

name: "Math Tutor",

instructions:

"You are a personal math tutor. Write and run JavaScript code to answer math questions.",

tools: [{ type: "code_interpreter" } as AssistantTool],

};

const role = "user";

const message = "I need to solve the equation `3x + 11 = 14`. Can you help me?";

// Create an assistant

const assistantResponse: Assistant =

await assistantsClient.beta.assistants.create(options);

console.log(`Assistant created: ${JSON.stringify(assistantResponse)}`);

// Create a thread

const assistantThread: Thread = await assistantsClient.beta.threads.create({});

console.log(`Thread created: ${JSON.stringify(assistantThread)}`);

// Add a user question to the thread

const threadResponse: Message =

await assistantsClient.beta.threads.messages.create(assistantThread.id, {

role,

content: message,

});

console.log(`Message created: ${JSON.stringify(threadResponse)}`);

// Run the thread and poll it until it is in a terminal state

const runResponse: Run = await assistantsClient.beta.threads.runs.createAndPoll(

assistantThread.id,

{

assistant_id: assistantResponse.id,

},

{ pollIntervalMs: 500 }

);

console.log(`Run created: ${JSON.stringify(runResponse)}`);

// Get the messages

const runMessages: MessagesPage =

await assistantsClient.beta.threads.messages.list(assistantThread.id);

for await (const runMessageDatum of runMessages) {

for (const item of runMessageDatum.content) {

// types are: "image_file" or "text"

if (item.type === "text") {

console.log(`Message content: ${JSON.stringify(item.text?.value)}`);

}

}

}

Para usar a chave de serviço para autenticação, você pode criar e executar um assistente com o seguinte módulo TypeScript (index.ts):

import "dotenv/config";

import { AzureOpenAI } from "openai";

import {

Assistant,

AssistantCreateParams,

AssistantTool,

} from "openai/resources/beta/assistants";

import { Message, MessagesPage } from "openai/resources/beta/threads/messages";

import { Run } from "openai/resources/beta/threads/runs/runs";

import { Thread } from "openai/resources/beta/threads/threads";

// Get environment variables

const azureOpenAIKey = process.env.AZURE_OPENAI_KEY as string;

const azureOpenAIEndpoint = process.env.AZURE_OPENAI_ENDPOINT as string;

const azureOpenAIDeployment = process.env

.AZURE_OPENAI_DEPLOYMENT_NAME as string;

const openAIVersion = process.env.OPENAI_API_VERSION as string;

// Check env variables

if (!azureOpenAIKey || !azureOpenAIEndpoint || !azureOpenAIDeployment || !openAIVersion) {

throw new Error(

"Please set AZURE_OPENAI_KEY and AZURE_OPENAI_ENDPOINT and AZURE_OPENAI_DEPLOYMENT_NAME in your environment variables."

);

}

// Get Azure SDK client

const getClient = (): AzureOpenAI => {

const assistantsClient = new AzureOpenAI({

endpoint: azureOpenAIEndpoint,

apiVersion: openAIVersion,

apiKey: azureOpenAIKey,

});

return assistantsClient;

};

const assistantsClient = getClient();

const options: AssistantCreateParams = {

model: azureOpenAIDeployment, // Deployment name seen in Azure AI Studio

name: "Math Tutor",

instructions:

"You are a personal math tutor. Write and run JavaScript code to answer math questions.",

tools: [{ type: "code_interpreter" } as AssistantTool],

};

const role = "user";

const message = "I need to solve the equation `3x + 11 = 14`. Can you help me?";

// Create an assistant

const assistantResponse: Assistant =

await assistantsClient.beta.assistants.create(options);

console.log(`Assistant created: ${JSON.stringify(assistantResponse)}`);

// Create a thread

const assistantThread: Thread = await assistantsClient.beta.threads.create({});

console.log(`Thread created: ${JSON.stringify(assistantThread)}`);

// Add a user question to the thread

const threadResponse: Message =

await assistantsClient.beta.threads.messages.create(assistantThread.id, {

role,

content: message,

});

console.log(`Message created: ${JSON.stringify(threadResponse)}`);

// Run the thread and poll it until it is in a terminal state

const runResponse: Run = await assistantsClient.beta.threads.runs.createAndPoll(

assistantThread.id,

{

assistant_id: assistantResponse.id,

},

{ pollIntervalMs: 500 }

);

console.log(`Run created: ${JSON.stringify(runResponse)}`);

// Get the messages

const runMessages: MessagesPage =

await assistantsClient.beta.threads.messages.list(assistantThread.id);

for await (const runMessageDatum of runMessages) {

for (const item of runMessageDatum.content) {

// types are: "image_file" or "text"

if (item.type === "text") {

console.log(`Message content: ${JSON.stringify(item.text?.value)}`);

}

}

}

Saída

Assistant created: {"id":"asst_zXaZ5usTjdD0JGcNViJM2M6N","createdAt":"2024-04-08T19:26:38.000Z","name":"Math Tutor","description":null,"model":"daisy","instructions":"You are a personal math tutor. Write and run JavaScript code to answer math questions.","tools":[{"type":"code_interpreter"}],"fileIds":[],"metadata":{}}

Thread created: {"id":"thread_KJuyrB7hynun4rvxWdfKLIqy","createdAt":"2024-04-08T19:26:38.000Z","metadata":{}}

Message created: {"id":"msg_o0VkXnQj3juOXXRCnlZ686ff","createdAt":"2024-04-08T19:26:38.000Z","threadId":"thread_KJuyrB7hynun4rvxWdfKLIqy","role":"user","content":[{"type":"text","text":{"value":"I need to solve the equation `3x + 11 = 14`. Can you help me?","annotations":[]},"imageFile":{}}],"assistantId":null,"runId":null,"fileIds":[],"metadata":{}}

Created run

Run created: {"id":"run_P8CvlouB8V9ZWxYiiVdL0FND","object":"thread.run","status":"queued","model":"daisy","instructions":"You are a personal math tutor. Write and run JavaScript code to answer math questions.","tools":[{"type":"code_interpreter"}],"metadata":{},"usage":null,"assistantId":"asst_zXaZ5usTjdD0JGcNViJM2M6N","threadId":"thread_KJuyrB7hynun4rvxWdfKLIqy","fileIds":[],"createdAt":"2024-04-08T19:26:39.000Z","expiresAt":"2024-04-08T19:36:39.000Z","startedAt":null,"completedAt":null,"cancelledAt":null,"failedAt":null}

Message content: "The solution to the equation \\(3x + 11 = 14\\) is \\(x = 1\\)."

Message content: "Yes, of course! To solve the equation \\( 3x + 11 = 14 \\), we can follow these steps:\n\n1. Subtract 11 from both sides of the equation to isolate the term with x.\n2. Then, divide by 3 to find the value of x.\n\nLet me calculate that for you."

Message content: "I need to solve the equation `3x + 11 = 14`. Can you help me?"

É importante lembrar que, embora o interpretador de código dê ao modelo a capacidade de responder a consultas mais complexas, convertendo as perguntas em código e executando esse código iterativamente em JavaScript até chegar a uma solução, você ainda precisa validar a resposta para confirmar que o modelo traduziu corretamente sua pergunta em uma representação válida no código.

Clean up resources (Limpar recursos)

Se quiser limpar e remover um recurso do Azure OpenAI, você pode excluir o recurso ou grupo de recursos. A exclusão do grupo de recursos também exclui quaisquer outros recursos associados a ele.

Código de exemplo

Consulte também

- Saiba mais sobre como utilizar os Assistentes com o nosso Guia prático sobre Assistentes.

- Exemplos da API do Azure OpenAI Assistants

Pré-requisitos

Uma assinatura do Azure - Crie uma gratuitamente

Acesso concedido ao Azure OpenAI na assinatura desejada do Azure

Atualmente, o acesso a este serviço é concedido apenas por pedido. Você pode solicitar acesso ao serviço Azure OpenAI preenchendo o formulário em https://aka.ms/oai/access. Abra um problema neste repositório para entrar em contato conosco se tiver um problema.

Um recurso OpenAI do Azure com um modelo compatível em uma região suportada.

Recomendamos rever a nota de transparência da IA Responsável e outros recursos de IA Responsável para se familiarizar com as capacidades e limitações do Serviço OpenAI do Azure.

Um recurso OpenAI do Azure com o modelo implantado

gpt-4 (1106-preview)foi usado testando este exemplo.

Configurar

Recuperar chave e ponto de extremidade

Para fazer uma chamada com êxito no Azure OpenAI, você precisará do seguinte:

| Nome da variável | Valor |

|---|---|

ENDPOINT |

Este valor pode ser encontrado na secção Chaves e Ponto Final ao examinar o recurso no portal do Azure. Em alternativa, pode encontrar o valor em Azure OpenAI Studio>Ambiente de Demonstração>Vista de Código. Um exemplo de ponto de extremidade é: https://docs-test-001.openai.azure.com/. |

API-KEY |

Este valor pode ser encontrado na secção Chaves e Ponto Final ao examinar o recurso no portal do Azure. Pode utilizar KEY1 ou KEY2. |

DEPLOYMENT-NAME |

Este valor corresponderá ao nome personalizado que escolheu para a implementação quando implementou um modelo. Este valor pode ser encontrado em Gestão de Recursos>Implementações no portal do Azure ou, em alternativa, em Gestão>Implementações no Azure OpenAI Studio. |

Vá para o seu recurso no portal do Azure. O Ponto de Extremidade e as Chaves podem ser encontrados na seção Gerenciamento de Recursos. Copie seu endpoint e sua chave de acesso, pois você precisará de ambos para autenticar suas chamadas de API. Pode utilizar KEY1 ou KEY2. Ter sempre duas chaves permite-lhe rodar e regenerar chaves de forma segura sem causar uma interrupção do serviço.

Crie e atribua variáveis de ambiente persistentes para sua chave e endpoint.

Variáveis de ambiente

Crie e atribua variáveis de ambiente persistentes para sua chave e endpoint.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

API REST

Criar um assistente

Nota

Com o Azure OpenAI, o parâmetro requer o nome de implantação do model modelo. Se o nome da implantação do modelo for diferente do nome do modelo subjacente, você ajustará o código para "model": "{your-custom-model-deployment-name}".

curl https://YOUR_RESOURCE_NAME.openai.azure.com/openai/assistants?api-version=2024-05-01-preview \

-H "api-key: $AZURE_OPENAI_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"instructions": "You are an AI assistant that can write code to help answer math questions.",

"name": "Math Assist",

"tools": [{"type": "code_interpreter"}],

"model": "gpt-4-1106-preview"

}'

Ferramentas

Um assistente individual pode aceder a até 128 ferramentas, incluindo code interpreter, bem como a quaisquer ferramentas personalizadas que crie através de funções.

Criar um thread

curl https://YOUR_RESOURCE_NAME.openai.azure.com/openai/threads \

-H "Content-Type: application/json" \

-H "api-key: $AZURE_OPENAI_API_KEY" \

-d ''

Adicionar uma pergunta de usuário ao thread

curl https://YOUR_RESOURCE_NAME.openai.azure.com/openai/threads/thread_abc123/messages \

-H "Content-Type: application/json" \

-H "api-key: $AZURE_OPENAI_API_KEY" \

-d '{

"role": "user",

"content": "I need to solve the equation `3x + 11 = 14`. Can you help me?"

}'

Executar o thread

curl https://YOUR_RESOURCE_NAME.openai.azure.com/openai/threads/thread_abc123/runs \

-H "api-key: $AZURE_OPENAI_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"assistant_id": "asst_abc123",

}'

Recuperar o status da execução

curl https://YOUR_RESOURCE_NAME.openai.azure.com/openai/threads/thread_abc123/runs/run_abc123 \

-H "api-key: $AZURE_OPENAI_API_KEY" \

Resposta do assistente

curl https://YOUR_RESOURCE_NAME.openai.azure.com/openai/threads/thread_abc123/messages \

-H "Content-Type: application/json" \

-H "api-key: $AZURE_OPENAI_API_KEY" \

Compreender os seus resultados

Neste exemplo, criamos um assistente com o interpretador de código habilitado. Quando fazemos uma pergunta matemática ao assistente, ele traduz a pergunta em código python e executa o código em ambiente sandboxed para determinar a resposta à pergunta. O código que o modelo cria e testa para chegar a uma resposta é:

from sympy import symbols, Eq, solve

# Define the variable

x = symbols('x')

# Define the equation

equation = Eq(3*x + 11, 14)

# Solve the equation

solution = solve(equation, x)

solution

É importante lembrar que, embora o interpretador de código dê ao modelo a capacidade de responder a consultas mais complexas, convertendo as perguntas em código e executando esse código iterativamente na sandbox do Python até chegar a uma solução, você ainda precisa validar a resposta para confirmar se o modelo traduziu corretamente sua pergunta em uma representação válida no código.

Clean up resources (Limpar recursos)

Se quiser limpar e remover um recurso do Azure OpenAI, você pode excluir o recurso ou grupo de recursos. A exclusão do grupo de recursos também exclui quaisquer outros recursos associados a ele.

Consulte também

- Saiba mais sobre como utilizar os Assistentes com o nosso Guia prático sobre Assistentes.

- Exemplos da API do Azure OpenAI Assistants

Comentários

Brevemente: Ao longo de 2024, vamos descontinuar progressivamente o GitHub Issues como mecanismo de feedback para conteúdos e substituí-lo por um novo sistema de feedback. Para obter mais informações, veja: https://aka.ms/ContentUserFeedback.

Submeter e ver comentários