Copiar dados de um banco de dados do SQL Server para o armazenamento de Blob do Azure usando a ferramenta Copiar Dados

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Gorjeta

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange tudo, desde a movimentação de dados até ciência de dados, análises em tempo real, business intelligence e relatórios. Saiba como iniciar uma nova avaliação gratuitamente!

Neste tutorial, irá utilizar o portal do Azure para criar uma fábrica de dados. Em seguida, use a ferramenta Copiar Dados para criar um pipeline que copia dados de um banco de dados do SQL Server para o armazenamento de Blob do Azure.

Nota

- Se não estiver familiarizado com o Data Factory, veja Introdução ao Azure Data Factory.

Neste tutorial, vai executar os seguintes passos:

- Criar uma fábrica de dados.

- Utilizar a ferramenta Copiar Dados para criar um pipeline.

- Monitorizar o pipeline e execuções de atividades.

Pré-requisitos

Subscrição do Azure

Antes de começar, se não tiver uma subscrição do Azure, crie uma conta gratuita.

Funções do Azure

Para criar instâncias de fábricas de dados, a conta de utilizador que utiliza para iniciar sessão no Azure tem de ter atribuída a função Contribuidor ou Proprietário ou ser administradora da subscrição do Azure.

Para ver as permissões que tem na subscrição, aceda ao portal do Azure. Selecione o nome de utilizador no canto superior direito, e, em seguida, selecione Permissões. Se tiver acesso a várias subscrições, selecione a subscrição apropriada. Para obter instruções de exemplo sobre como adicionar um usuário a uma função, consulte Atribuir funções do Azure usando o portal do Azure.

SQL Server 2014, 2016 e 2017

Neste tutorial, você usa um banco de dados do SQL Server como um armazenamento de dados de origem . O pipeline no data factory criado neste tutorial copia dados desse banco de dados do SQL Server (origem) para o armazenamento de Blob (coletor). Vai criar uma tabela com o nome emp na sua base de dados do SQL Server e inserir algumas entradas de exemplo na tabela.

Inicie o SQL Server Management Studio. Se ainda não estiver instalado no seu computador, aceda a Transferir o SQL Server Management Studio.

Utilize as suas credenciais para se ligar à sua instância do SQL Server.

Crie uma base de dados de exemplo. Na vista de árvore, clique com o botão direito do rato em Bases de Dados e selecione Nova Base de Dados.

Na janela Nova Base de Dados, introduza um nome para a base de dados e selecione OK.

Para criar a tabela emp e inserir alguns dados de exemplo na mesma, execute o script de consulta seguinte na base de dados. Na vista de árvore, clique com o botão direito do rato na base de dados que criou e selecione Nova Consulta.

CREATE TABLE dbo.emp ( ID int IDENTITY(1,1) NOT NULL, FirstName varchar(50), LastName varchar(50) ) GO INSERT INTO emp (FirstName, LastName) VALUES ('John', 'Doe') INSERT INTO emp (FirstName, LastName) VALUES ('Jane', 'Doe') GO

Conta de armazenamento do Azure

Neste tutorial, utiliza uma conta de armazenamento do Azure para fins gerais (mais concretamente, o Armazenamento de blobs) como arquivo de dados de destino/sink. Se não tiver uma conta de armazenamento para fins gerais, veja Criar uma conta de armazenamento para instruções sobre como criar uma. O pipeline no data factory criado neste tutorial copia dados do banco de dados do SQL Server (origem) para esse armazenamento de Blob (coletor).

Obter o nome e a chave da conta de armazenamento

Utilize o nome e a chave da sua conta de armazenamento neste tutorial. Para obter o nome e a chave da sua conta de armazenamento, siga os passos seguintes:

Inicie sessão no portal do Azure com o seu nome de utilizador e a palavra-passe do Azure.

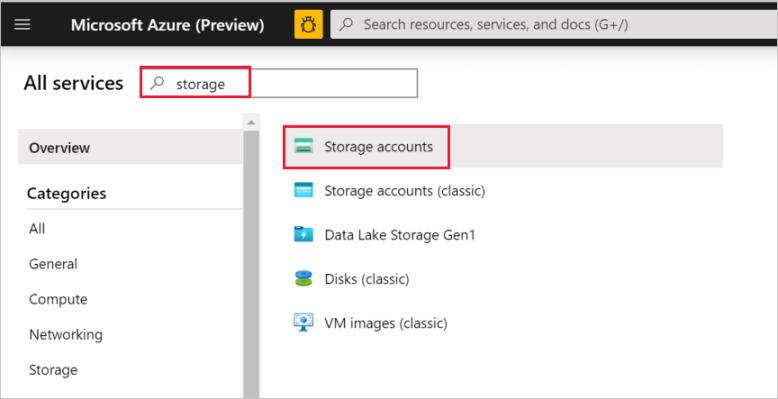

No painel esquerdo, selecione Todos os serviços. Utilize a palavra-chave Armazenamento para filtrar e selecione Contas de armazenamento.

Na lista de contas de armazenamento, filtre para encontrar a sua conta de armazenamento, se necessário. Em seguida, selecione a sua conta de armazenamento.

Na janela Conta de armazenamento, selecione Chaves de acesso.

Nas caixas Nome da conta de armazenamento e key1, copie os valores e cole-os no Bloco de notas ou noutro editor, para utilizar mais adiante no tutorial.

Criar uma fábrica de dados

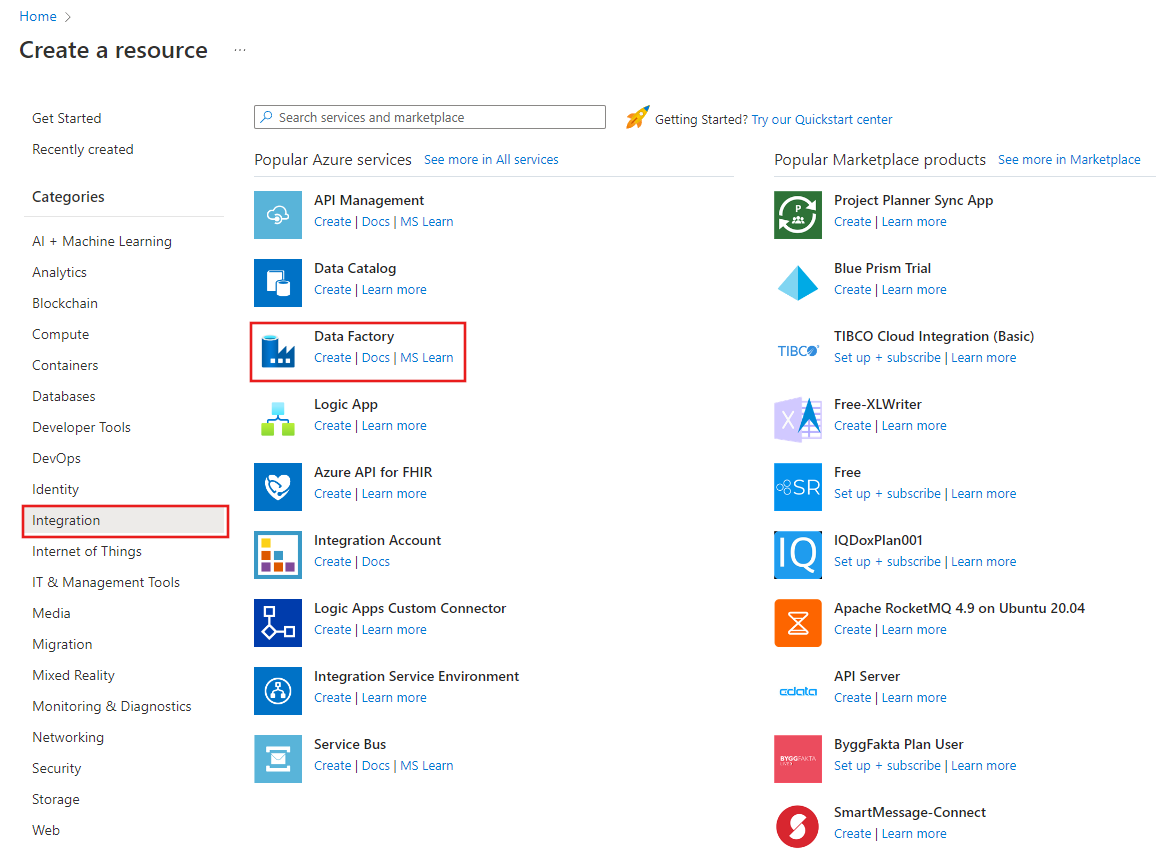

No menu à esquerda, selecione Criar um recurso>Integration>Data Factory.

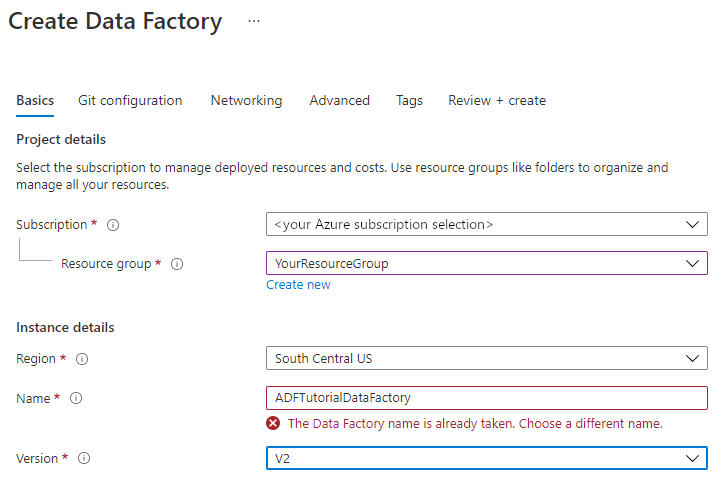

Na página Nova fábrica de dados, em Nome, introduza ADFTutorialDataFactory.

O nome da fábrica de dados tem de ser globalmente exclusivo. Se vir a seguinte mensagem de erro no campo de nome, altere o nome da fábrica de dados (por exemplo, oseunomeADFTutorialDataFactory). Para obter as regras de nomenclatura dos artefactos do Data Factory, veja Regras de nomenclatura do Data Factory.

Selecione a subscrição do Azure na qual quer criar a fábrica de dados.

Em Grupo de Recursos, efetue um destes passos:

Selecione Utilizar existente e selecione um grupo de recursos já existente na lista pendente.

Selecione Criar novo e introduza o nome de um grupo de recursos.

Para saber mais sobre grupos de recursos, veja Utilizar grupos de recursos para gerir os recursos do Azure.

Em Versão, selecione V2.

Em Localização, selecione a localização para a fábrica de dados. Só aparecem na lista pendente as localizações que são suportadas. Os arquivos de dados (por exemplo, o Armazenamento do Azure e a Base de Dados SQL) e as computações (por exemplo, o Azure HDInsight) que o Data Factory utiliza podem estar noutras localizações/regiões.

Selecione Criar.

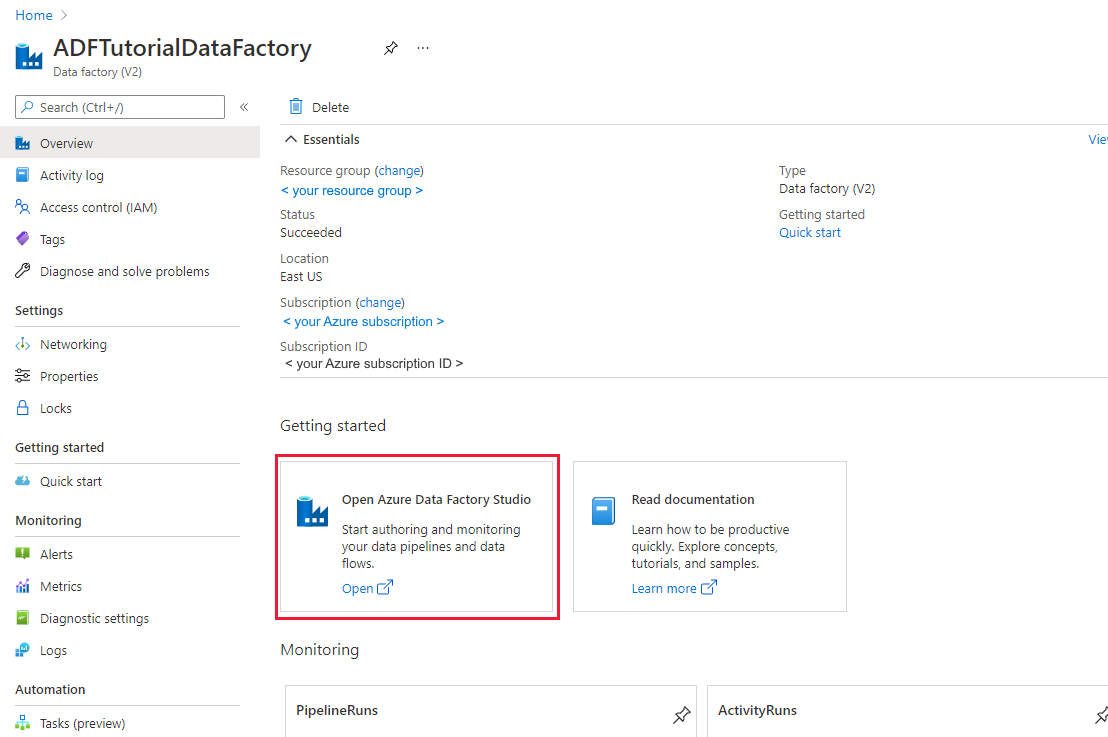

Depois de concluída a criação, vai ver a página Data Factory, conforme mostrado na imagem.

Selecione Abrir no bloco Abrir o Estúdio do Azure Data Factory para iniciar a interface do usuário do Data Factory em uma guia separada.

Utilizar a ferramenta Copiar Dados para criar um pipeline

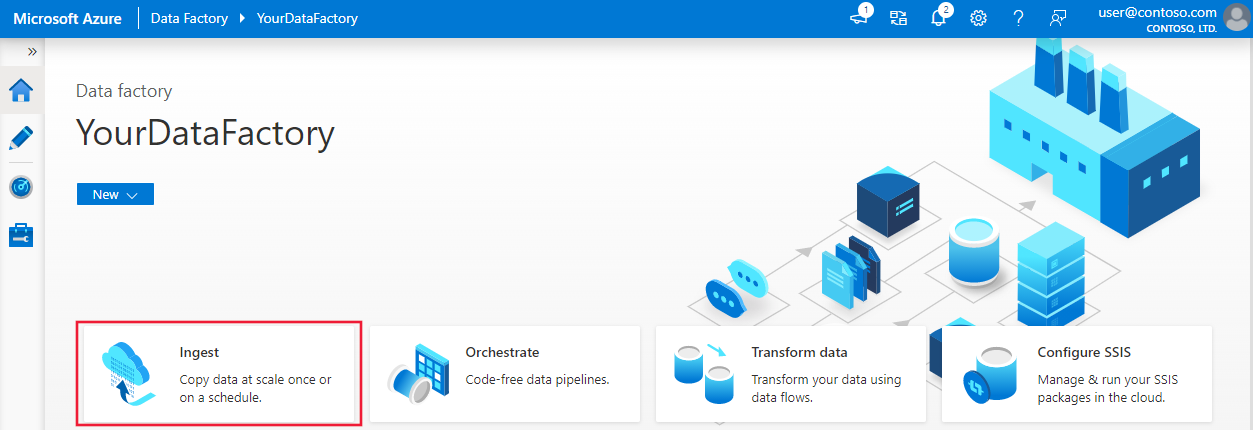

Na home page do Azure Data Factory, selecione Ingest para iniciar a ferramenta Copiar Dados.

Na página Propriedades da ferramenta Copiar Dados, escolha Tarefa de cópia interna em Tipo de tarefa, escolha Executar uma vez agora em Cadência da tarefa ou agendamento de tarefas e, em seguida, selecione Avançar.

Na página Armazenamento de dados de origem, selecione + Criar nova conexão.

Em Nova conexão, procure SQL Server e selecione Continuar.

Na caixa de diálogo Nova conexão (SQL server), em Nome, digite SqlServerLinkedService. Selecione +Novo em Ligar através do runtime de integração. Tem de criar um runtime de integração autoalojado, transferi-lo para o seu computador e registá-lo no Data Factory. O runtime de integração autoalojado copia dados entre o ambiente no local e a cloud.

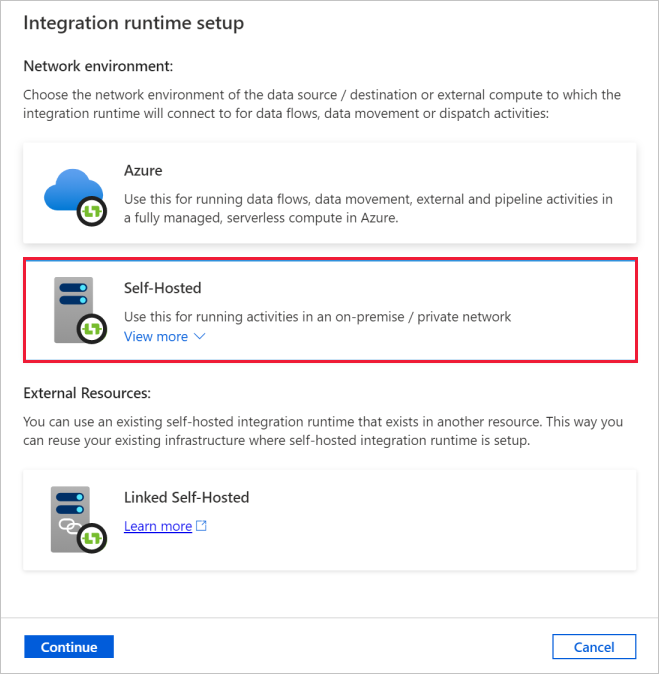

Na caixa de diálogo Configuração do tempo de execução da integração, selecione Auto-hospedado. Em seguida, selecione Continuar.

Na caixa de diálogo Configuração do tempo de execução da integração, em Nome, digite TutorialIntegrationRuntime. Depois, selecione Criar.

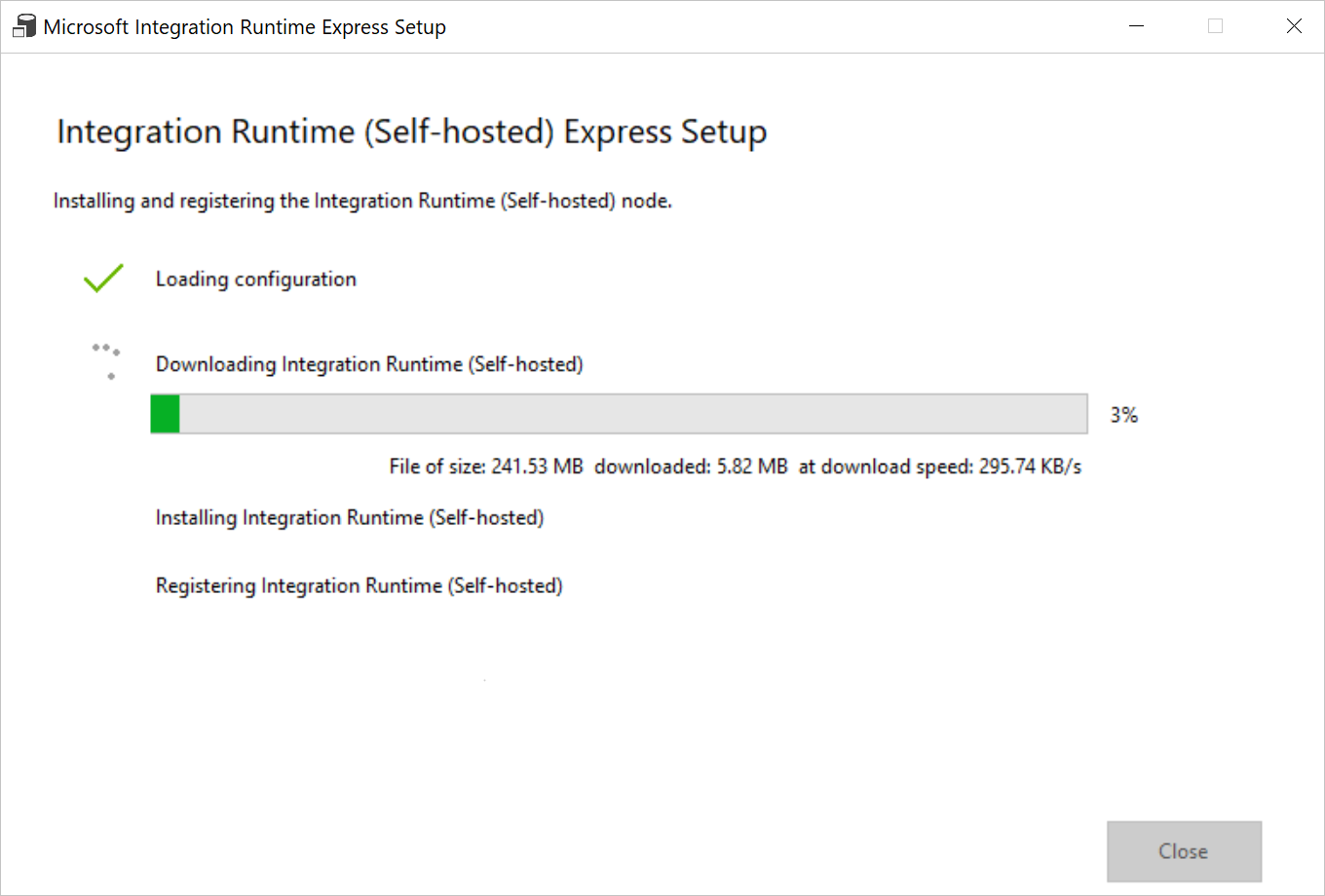

Na caixa de diálogo Configuração do tempo de execução da integração , selecione Clique aqui para iniciar a configuração expressa para este computador. Esta ação instala o runtime de integração no seu computador e regista-o no Data Factory. Em alternativa, pode utilizar a opção de configuração manual para transferir o ficheiro de instalação, executá-lo e utilizar a chave para registar o runtime de integração.

Execute a aplicação transferida. Pode ver o estado da configuração rápida na janela.

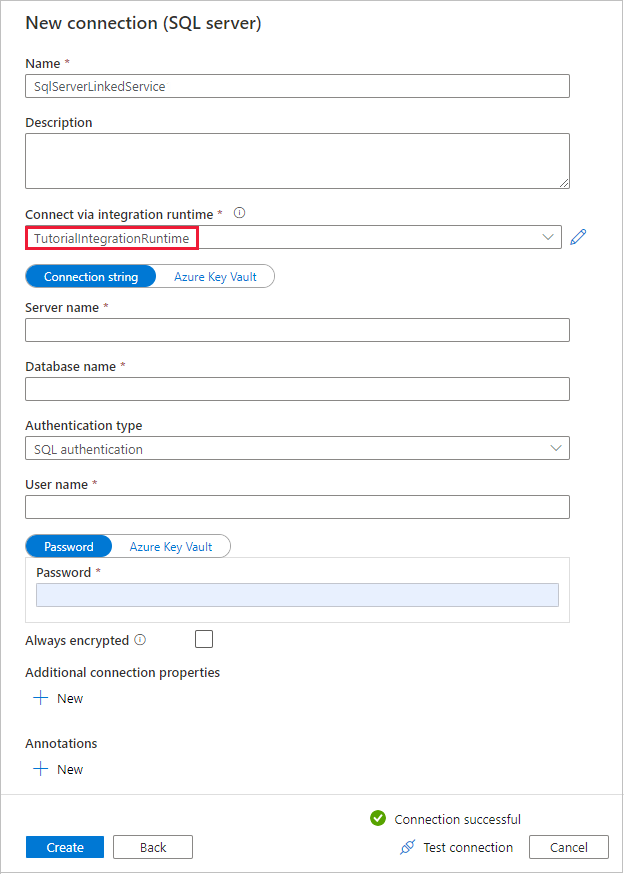

Na caixa de diálogo Nova Conexão (SQL Server), confirme se TutorialIntegrationRuntime está selecionado em Conectar via tempo de execução de integração. Em seguida, siga os seguintes passos:

a. Em Nome, introduza SqlServerLinkedService.

b. Em Nome do servidor, introduza o nome da instância do SQL Server.

c. Em Nome da base de dados, introduza o nome da base de dados no local.

d. Em Tipo de autenticação, selecione a autenticação adequada.

e. Em Nome de usuário, insira o nome do usuário com acesso ao SQL Server.

f. Digite a senha do usuário.

g. Teste a conexão e selecione Criar.

Na página Armazenamento de dados de origem, verifique se a conexão do SQL Server recém-criada está selecionada no bloco Conexão. Em seguida, na seção Tabelas de origem, escolha TABELAS EXISTENTES, selecione a tabela dbo.emp na lista e selecione Avançar. Pode selecionar qualquer outra tabela com base na sua base de dados.

Na página Aplicar filtro, você pode visualizar dados e exibir o esquema dos dados de entrada selecionando o botão Visualizar dados. Em seguida, selecione Seguinte.

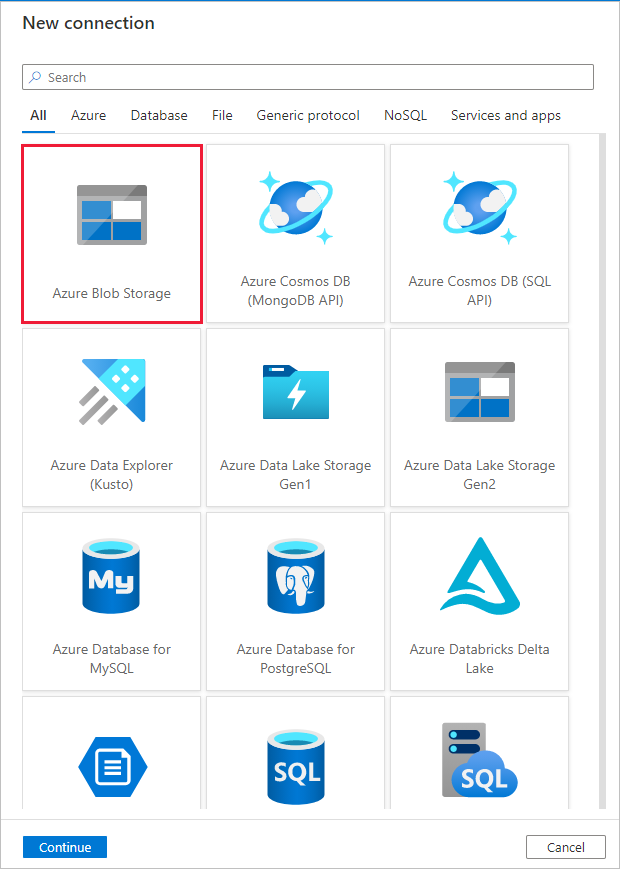

Na página Armazenamento de dados de destino, selecione + Criar nova conexão

Em Nova conexão, pesquise e selecione Armazenamento de Blobs do Azure e selecione Continuar.

Na caixa de diálogo Nova conexão (Armazenamento de Blob do Azure), execute as seguintes etapas:

a. Em Nome, introduza AzureStorageLinkedService.

b. Em Conectar via tempo de execução de integração, selecione TutorialIntegrationRuntime e selecione Chave de conta em Método de autenticação.

c. Em Assinatura do Azure, selecione sua assinatura do Azure na lista suspensa.

d. Em Nome da conta de armazenamento, selecione a conta de armazenamento da lista pendente.

e. Teste a conexão e selecione Criar.

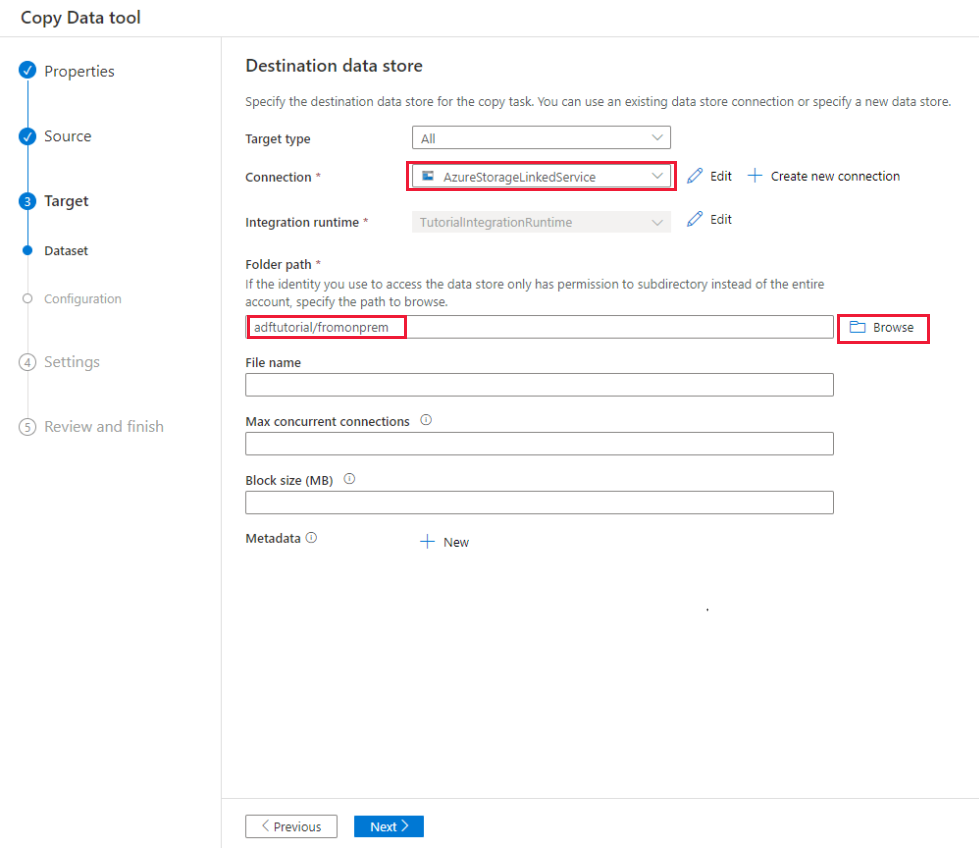

Na caixa de diálogo Armazenamento de dados de destino, verifique se a conexão recém-criada do Armazenamento de Blobs do Azure está selecionada no bloco Conexão. Em seguida, em Caminho da pasta, digite adftutorial/fromonprem. Criou o contentor adftutorial como parte dos pré-requisitos. Se a pasta de saída não existir (neste caso fromonprem), o Data Factory cria-a automaticamente. Você também pode usar o botão Procurar para procurar o armazenamento de blob e seus contêineres/pastas. Se não especificar qualquer valor em Nome de ficheiro, por predefinição o nome da origem deverá ser utilizado (neste caso dbo.emp).

Na caixa de diálogo Definições do formato do ficheiro, selecione Seguinte.

Na caixa de diálogo Configurações, em Nome da tarefa, digite CopyFromOnPremSqlToAzureBlobPipeline e selecione Avançar. A ferramenta Copiar Dados cria um pipeline com o nome que especificar para este campo.

Na caixa de diálogo Resumo, reveja os valores para todas definições e selecione Seguinte.

Na Página de implementação, selecione Monitorizar para monitorizar o pipeline (tarefa).

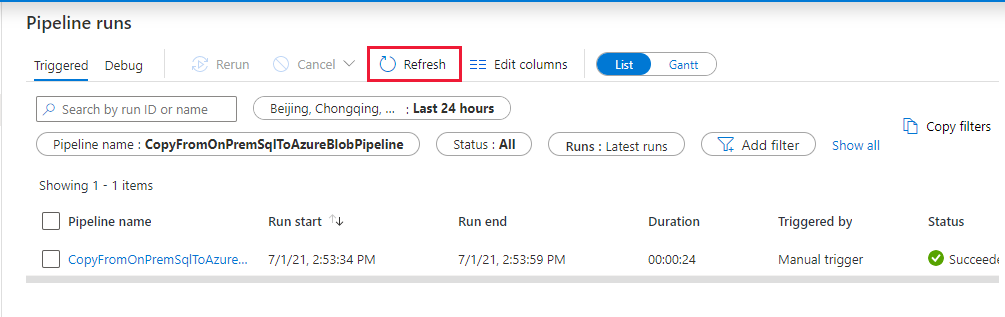

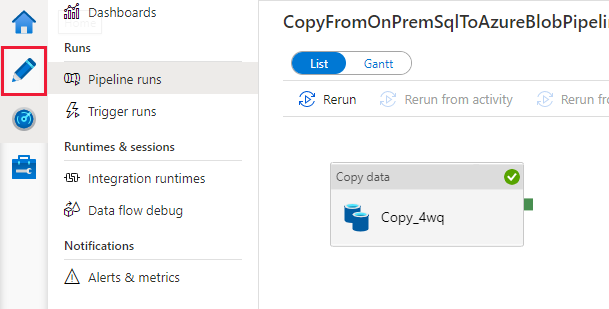

Quando a execução do pipeline for concluída, você poderá exibir o status do pipeline criado.

Na página "Pipeline runs", selecione Atualizar para atualizar a lista. Selecione o link em Nome do pipeline para exibir os detalhes da execução da atividade ou executar novamente o pipeline .

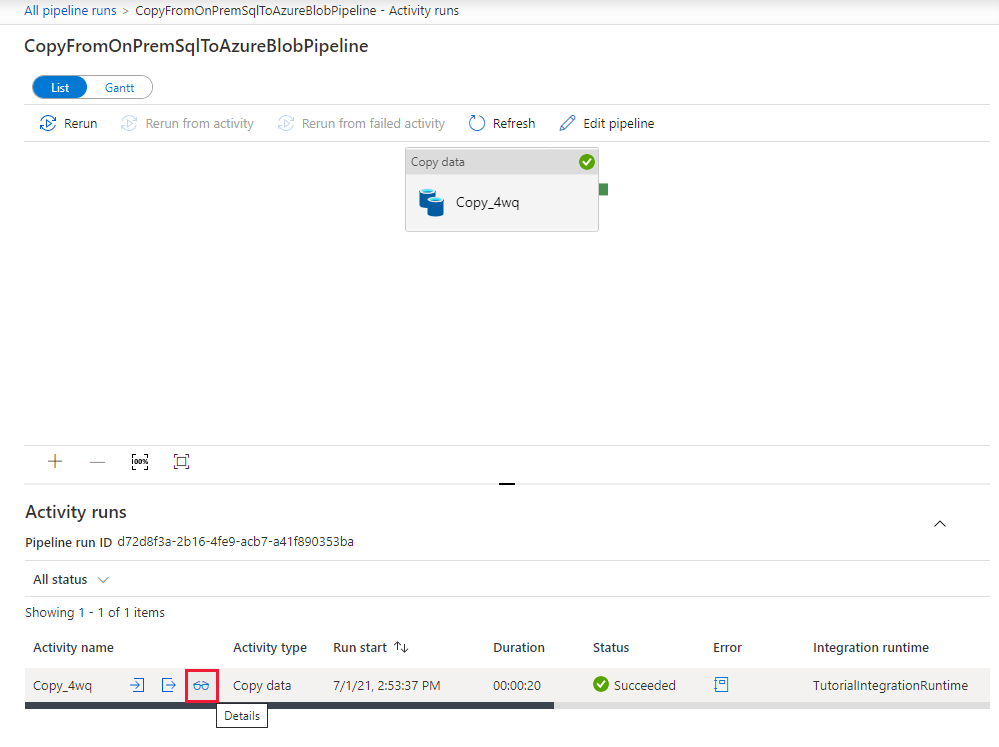

Na página "A atividade é executada", selecione o link Detalhes (ícone de óculos) na coluna Nome da atividade para obter mais detalhes sobre a operação de cópia. Para voltar à página "Pipeline runs", selecione o link All pipeline runs no menu breadcrumb. Para atualizar a vista, selecione Atualizar.

Confirme que vê um ficheiro de saída na pasta fromonprem do contentor adftutorial.

Selecione o separador Criar à esquerda para mudar para o modo de edição. Pode atualizar os serviços ligados, conjuntos de dados e pipelines criados pela ferramenta, utilizando o editor. Selecione Código para ver o código JSON associado à entidade aberta no editor. Para obter detalhes sobre como editar estas entidades na IU do Data Factory, veja a versão do portal do Azure deste tutorial.

Conteúdos relacionados

O pipeline neste exemplo copia dados de um banco de dados SQL Server para o armazenamento de Blob. Aprendeu a:

- Criar uma fábrica de dados.

- Utilizar a ferramenta Copiar Dados para criar um pipeline.

- Monitorizar o pipeline e execuções de atividades.

Para obter uma lista dos arquivos de dados que o Data Factory suporta, veja Arquivos de dados suportados.

Para saber como copiar dados em massa de uma origem para um destino, avance para o tutorial seguinte: