Componente Avaliar modelo

Este artigo descreve um componente no designer do Azure Machine Learning.

Use este componente para medir a precisão de um modelo treinado. Você fornece um conjunto de dados contendo pontuações geradas a partir de um modelo e o componente Avaliar modelo calcula um conjunto de métricas de avaliação padrão do setor.

As métricas retornadas pelo Modelo de Avaliação dependem do tipo de modelo que você está avaliando:

- Modelos de Classificação

- Modelos de regressão

- Modelos de clustering

Gorjeta

Se você é novo na avaliação de modelos, recomendamos a série de vídeos do Dr. Stephen Elston, como parte do curso de aprendizado de máquina da EdX.

Como usar o modelo de avaliação

Conecte a saída do conjunto de dados Score do modelo de pontuação ou da saída do conjunto de dados Assign Data to Clusters à porta de entrada esquerda do Evaluate Model.

Nota

Se usar componentes como "Selecionar colunas no conjunto de dados" para selecionar parte do conjunto de dados de entrada, verifique se a coluna Rótulo real (usado no treinamento), a coluna "Probabilidades pontuadas" e a coluna "Rótulos pontuados" existem para calcular métricas como AUC, Precisão para classificação binária/deteção de anomalias. A coluna de rótulo real, a coluna 'Rótulos pontuados' existem para calcular métricas para classificação/regressão de várias classes. Coluna 'Atribuições', colunas 'DistânciasToClusterCenter no.X' (X é índice centróide, variando de 0, ..., Número de centróides-1) existem para calcular métricas para clustering.

Importante

- Para avaliar os resultados, o conjunto de dados de saída deve conter nomes de colunas de pontuação específicos, que atendam aos requisitos do componente Avaliar modelo.

- A

Labelscoluna será considerada como rótulos reais. - Para a tarefa de regressão, o conjunto de dados a ser avaliado deve ter uma coluna, chamada

Regression Scored Labels, que representa os rótulos pontuados. - Para a tarefa de classificação binária, o conjunto de dados a ser avaliado deve ter duas colunas, denominadas

Binary Class Scored Labels,Binary Class Scored Probabilities, que representam rótulos pontuados e probabilidades, respectivamente. - Para a tarefa de classificação múltipla, o conjunto de dados a ser avaliado deve ter uma coluna, chamada

Multi Class Scored Labels, que representa os rótulos pontuados. Se as saídas do componente upstream não tiverem essas colunas, você precisará modificar de acordo com os requisitos acima.

[Opcional] Conecte a saída do conjunto de dados Score do modelo de pontuação ou da saída do conjunto de dados Assign Data to Clusters para o segundo modelo à porta de entrada direita do Evaluate Model. Você pode comparar facilmente os resultados de dois modelos diferentes nos mesmos dados. Os dois algoritmos de entrada devem ser do mesmo tipo de algoritmo. Ou, você pode comparar pontuações de duas execuções diferentes sobre os mesmos dados com parâmetros diferentes.

Nota

O tipo de algoritmo refere-se a 'Classificação de duas classes', 'Classificação de várias classes', 'Regressão', 'Clustering' em 'Algoritmos de aprendizado de máquina'.

Envie o pipeline para gerar as pontuações de avaliação.

Resultados

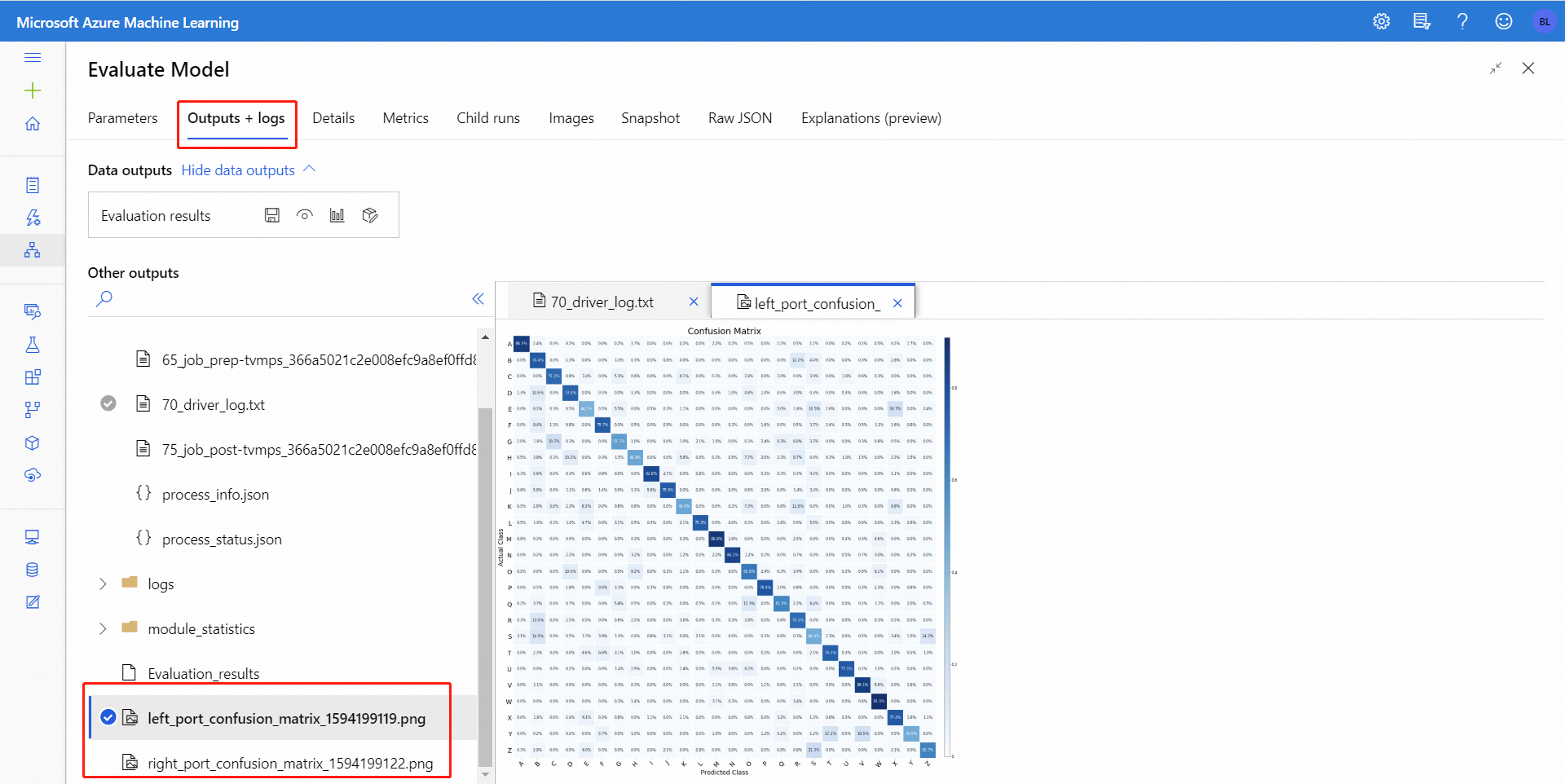

Depois de executar Avaliar modelo, selecione o componente para abrir o painel de navegação Avaliar modelo à direita. Em seguida, escolha a guia Saídas + Logs e, nessa guia, a seção Saídas de Dados tem vários ícones. O ícone Visualizar tem um ícone de gráfico de barras e é a primeira maneira de ver os resultados.

Para classificação binária, depois de clicar no ícone Visualizar , você pode visualizar a matriz de confusão binária. Para multiclassificação, você pode encontrar o arquivo de gráfico de matriz de confusão na guia Saídas + Logs , da seguinte forma:

Se você conectar conjuntos de dados a ambas as entradas do Modelo de Avaliação, os resultados conterão métricas para ambos os conjuntos de dados ou para ambos os modelos. O modelo ou dados anexados à porta esquerda são apresentados primeiro no relatório, seguidos pelas métricas para o conjunto de dados ou modelo anexado na porta direita.

Por exemplo, a imagem a seguir representa uma comparação dos resultados de dois modelos de clustering que foram criados com base nos mesmos dados, mas com parâmetros diferentes.

Como este é um modelo de agrupamento, os resultados da avaliação são diferentes do que se você comparasse pontuações de dois modelos de regressão ou comparasse dois modelos de classificação. No entanto, a apresentação geral é a mesma.

Métricas

Esta seção descreve as métricas retornadas para os tipos específicos de modelos suportados para uso com o Evaluate Model:

Métricas para modelos de classificação

As métricas a seguir são relatadas ao avaliar modelos de classificação binária.

A precisão mede a bondade de um modelo de classificação como a proporção de resultados verdadeiros para o total de casos.

Precisão é a proporção de resultados verdadeiros sobre todos os resultados positivos. Precisão = TP/(TP+FP)

Recall é a fração da quantidade total de instâncias relevantes que foram realmente recuperadas. Recall = TP/(TP+FN)

A pontuação F1 é calculada como a média ponderada de precisão e recordação entre 0 e 1, onde o valor ideal da pontuação F1 é 1.

A AUC mede a área sob a curva plotada com verdadeiros positivos no eixo y e falsos positivos no eixo x. Essa métrica é útil porque fornece um único número que permite comparar modelos de diferentes tipos. A AUC é classificada-limiar-invariante. Ele mede a qualidade das previsões do modelo, independentemente do limiar de classificação escolhido.

Métricas para modelos de regressão

As métricas retornadas para modelos de regressão são projetadas para estimar a quantidade de erro. Considera-se que um modelo se ajusta bem aos dados se a diferença entre os valores observados e previstos for pequena. No entanto, olhar para o padrão dos resíduos (a diferença entre qualquer ponto previsto e seu valor real correspondente) pode dizer muito sobre o potencial viés no modelo.

As métricas a seguir são relatadas para avaliar modelos de regressão linear. Outros modelos de regressão, como o Fast Forest Quantile Regression, podem ter métricas diferentes.

O erro absoluto médio (MAE) mede o quão próximas as previsões estão dos resultados reais, portanto, uma pontuação mais baixa é melhor.

O erro quadrático médio raiz (RMSE) cria um único valor que resume o erro no modelo. Ao fazer a quadratura da diferença, a métrica desconsidera a diferença entre sobreprevisão e subprevisão.

O erro absoluto relativo (RAE) é a diferença absoluta relativa entre os valores esperados e reais, relativo porque a diferença média é dividida pela média aritmética.

O erro quadrado relativo (RSE) normaliza similarmente o erro quadrado total dos valores previstos, dividindo pelo erro quadrado total dos valores reais.

O coeficiente de determinação, muitas vezes referido como R2, representa o poder preditivo do modelo como um valor entre 0 e 1. Zero significa que o modelo é aleatório (não explica nada); 1 significa que há um ajuste perfeito. No entanto, deve ter-se cuidado na interpretação dos valores de R2 , uma vez que valores baixos podem ser totalmente normais e valores elevados podem ser suspeitos.

Métricas para modelos de clustering

Como os modelos de agrupamento diferem significativamente dos modelos de classificação e regressão em muitos aspetos, o Modelo de Avaliação também retorna um conjunto diferente de estatísticas para modelos de clustering.

As estatísticas retornadas para um modelo de clustering descrevem quantos pontos de dados foram atribuídos a cada cluster, a quantidade de separação entre clusters e quão firmemente os pontos de dados estão agrupados dentro de cada cluster.

As estatísticas para o modelo de clustering são calculadas em média em todo o conjunto de dados, com linhas adicionais contendo as estatísticas por cluster.

As métricas a seguir são relatadas para avaliar modelos de clustering.

As pontuações na coluna, Distância média a outro centro, representam o quão perto, em média, cada ponto do cluster está dos centróides de todos os outros clusters.

As pontuações na coluna, Distância média ao centro do cluster, representam a proximidade de todos os pontos de um cluster com o centróide desse cluster.

A coluna Número de Pontos mostra quantos pontos de dados foram atribuídos a cada cluster, juntamente com o número total total de pontos de dados em qualquer cluster.

Se o número de pontos de dados atribuídos a clusters for menor do que o número total de pontos de dados disponíveis, isso significa que os pontos de dados não puderam ser atribuídos a um cluster.

As pontuações na coluna, Distância Máxima ao Centro do Cluster, representam o máximo das distâncias entre cada ponto e o centróide do cluster desse ponto.

Se esse número for alto, isso pode significar que o cluster está amplamente disperso. Você deve revisar essa estatística juntamente com a Distância média até o Centro de Cluster para determinar a propagação do cluster.

A pontuação da Avaliação Combinada na parte inferior de cada seção de resultados lista as pontuações médias para os clusters criados nesse modelo específico.

Próximos passos

Consulte o conjunto de componentes disponíveis para o Azure Machine Learning.