Nota

O acesso a esta página requer autorização. Podes tentar iniciar sessão ou mudar de diretório.

O acesso a esta página requer autorização. Podes tentar mudar de diretório.

Sua postura de segurança de IA é uma parte importante de sua estratégia geral de segurança. A IA dá prioridade a elementos específicos de uma estratégia de cibersegurança, como a proteção de dados. Este artigo ajuda você a desenvolver sua estratégia e prioridades para proteger a IA. Os artigos subsequentes desta coleção ajudam você a identificar os elementos específicos da segurança cibernética a serem priorizados à medida que você adota companheiros, ferramentas e novos aplicativos de IA.

Sua postura de segurança é definida como a capacidade geral de defesa de segurança cibernética de sua organização, juntamente com o nível de preparação e status operacional para lidar com ameaças contínuas à segurança cibernética. Esta postura deve ser quantificável e mensurável, à semelhança de qualquer outra métrica importante que diga respeito ao estado operacional ou bem-estar da sua organização.

Construir uma postura de segurança forte para IA envolve trabalhar dentro da sua organização, especialmente líderes em toda a sua organização, para desenvolver uma estratégia e um conjunto de prioridades e objetivos. Em seguida, você identifica o trabalho técnico necessário para atingir os objetivos e lidera as várias equipes para alcançá-los. Os artigos desta biblioteca fornecem uma metodologia com orientações específicas para IA:

- Prepare seu ambiente com proteções de segurança básicas. Você provavelmente já tem muitas dessas proteções em vigor.

- Descubra os aplicativos de IA que estão sendo usados em sua organização, incluindo os tipos de dados que os aplicativos estão usando.

- Proteja o uso de ferramentas de IA em sua organização. Isso envolve recursos de proteção de dados específicos de IA e a garantia de que sua organização implementou uma forte proteção contra ameaças.

- Governar a IA para assegurar conformidade.

Use esta biblioteca juntamente com as seguintes estruturas no Microsoft Learn:

Na imagem:

- Use esta biblioteca (Biblioteca de segurança para IA) para saber como implementar recursos para proteger aplicativos e dados de IA em seu ambiente. Essas proteções ajudam a construir a sua fundação de Zero Trust.

- Use a estrutura de adoção do Zero Trust para continuar a progredir em direção à segurança de ponta a ponta. Cada um dos cenários de negócios Zero Trust também aumenta sua segurança para aplicativos e dados de IA.

- Use o Cloud Adoption Framework for AI para desenvolver seu roteiro de ponta a ponta para a adoção de IA, incluindo IA generativa e não generativa. Esta biblioteca inclui estratégias para escolher tecnologias de IA, processos para proteger e governar a IA e recursos para design e implementação de IA.

Compreender as motivações dos seus líderes empresariais

Uma postura de segurança de IA forte permite a inovação — ela capacita as organizações a construir e implantar IA com confiança e agilidade. O objetivo é capacitar a organização a construir, implantar e dimensionar sistemas de IA com confiança, ao mesmo tempo em que protege contra riscos que possam minar a confiança, a conformidade ou a estabilidade operacional. Ao incorporar a segurança na base das iniciativas de IA, as organizações podem desbloquear todo o potencial da IA de forma responsável, garantindo que ela continue sendo um ativo estratégico em vez de uma fonte de danos não intencionais.

Comece a desenvolver a sua estratégia e prioridades, alinhando-se com os líderes do seu negócio. O que motiva seus líderes e por que eles se preocupam com sua postura de segurança para IA? A tabela a seguir fornece exemplos de perspetivas, mas é importante que você se reúna com cada um desses líderes e equipes e chegue a um entendimento compartilhado das motivações uns dos outros.

| Funções | Por que construir uma postura de segurança forte para IA é importante |

|---|---|

| Diretor Executivo (CEO) | Os sistemas de IA moldam cada vez mais as decisões estratégicas e as interações com os clientes. Uma violação ou manipulação da IA pode levar a más decisões, escrutínio regulatório, danos à reputação e perda de confiança. Uma forte segurança de IA é crucial para que a organização proteja a reputação da empresa, garanta a conformidade legal e garanta uma transformação de IA bem-sucedida. |

| Diretor de Marketing (CMO) | As ferramentas de IA impulsionam as perceções, a segmentação e a personalização dos clientes. Se comprometidas, essas ferramentas podem levar a vazamentos de dados, saídas tendenciosas ou danos à marca devido a conteúdo ou direcionamento inadequados. Garantir a IA garante a confiança no envolvimento do cliente, preservando a integridade da marca, prevenindo desastres de RP e demonstrando o compromisso da empresa em proteger a privacidade do cliente. |

| Diretor de Informação (CIO) | Um ambiente de IA seguro é essencial para garantir a confiabilidade do sistema, impedir o acesso não autorizado e manter a resiliência operacional. Isso permite que os CIOs integrem com confiança tecnologias de IA que aprimoram os negócios sem expor a empresa a riscos indevidos. |

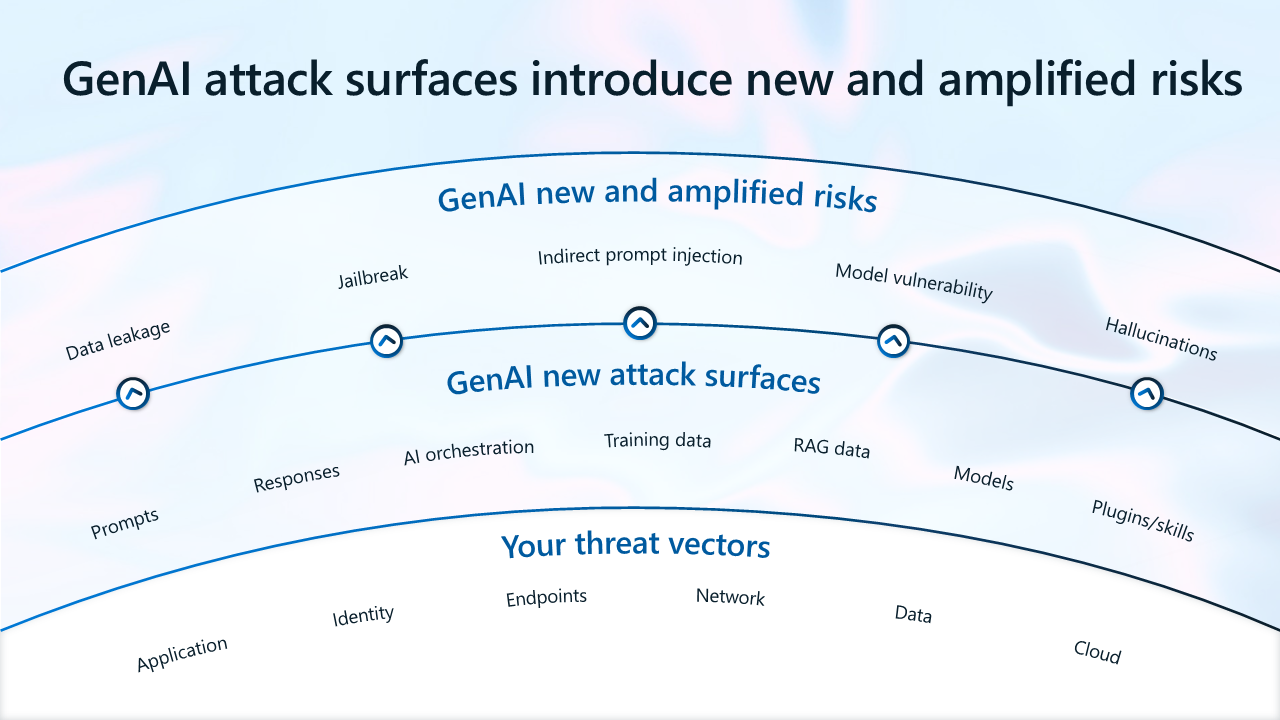

| Diretor de Segurança da Informação (CISO) | A IA introduz novas superfícies de ataque e novos riscos, ao mesmo tempo que amplifica os riscos existentes. As novas superfícies de ataque incluem prompts, respostas, modelos, dados RAG, protocolo de contexto de modelo (MCP), dados de treinamento e envenenamento de dados, ataques de jailbreak, segurança de dados e muito mais. O CISO deve liderar os esforços de modelagem de ameaças e proteção de pipelines de IA para manter a postura de segurança corporativa. A segurança robusta de IA é uma extensão da estratégia geral de defesa cibernética para proteger os ativos da organização, cumprir as estruturas de segurança e manter a confiança do cliente e das partes interessadas na era dos sistemas inteligentes. |

| Diretor de Tecnologia (CTO) | Uma forte postura de segurança de IA é fundamental para que os CTOs protejam os ativos tecnológicos da organização e garantam que os sistemas de IA tenham um desempenho confiável como pretendido. Ao incorporar a segurança no ciclo de vida de desenvolvimento de IA, o CTO ajuda a prevenir violações de algoritmos sensíveis e a manter alta qualidade e confiança em produtos orientados por IA. Isto permite que a inovação prossiga sem riscos indevidos. |

| Diretor de Operações (COO) | A IA automatiza processos críticos na cadeia de suprimentos, logística e operações. Os ataques a sistemas de IA podem interromper serviços, aumentar o risco operacional e causar atrasos dispendiosos. Uma forte postura de segurança de IA garante a continuidade e a eficiência dos negócios. |

| Diretor Financeiro (CFO) | Os CFOs veem uma postura robusta de segurança de IA como essencial para proteger a organização. Ajuda a evitar perdas financeiras imprevistas e garante a conformidade com as leis e obrigações de relatórios. |

Abordar o cenário de ameaças em evolução para a IA

A GenAI introduz novas superfícies de ataque, alterando efetivamente o cenário de risco. Além de gerenciar vetores de ameaças tradicionais, os líderes de segurança e risco também precisam lidar com riscos amplificados, como vazamento e compartilhamento excessivo de dados, e novos riscos, como injeções rápidas, informações incorretas, vulnerabilidades de modelo e informações incorretas. Lidar com o cenário de ameaças em evolução é crucial para permitir uma IA confiável.

Na ilustração:

- As superfícies de ataque GenAI introduzem riscos novos e amplificados.

- Os vetores de ameaça que permanecem inalterados incluem seus aplicativos, identidades, pontos de extremidade, rede, dados e recursos de nuvem.

- O GenAI introduz novas superfícies vulneráveis, incluindo prompts, respostas, orquestração de IA, dados de treinamento, dados de Geração Ampliada por Recuperação (ou seja, dados que resultam de interações de seus dados ou outros dados externos com modelos de linguagem), modelos de IA e plug-ins de IA.

- A GenAI introduz novos riscos amplificados, incluindo extravio de dados, jailbreak (comprometendo dispositivos que, de outra forma, são protegidos), injeção indireta de instruções e vulnerabilidade do modelo.

Atualmente, os incidentes de segurança mais comuns em IA incluem:

- Vazamento de dados e compartilhamento excessivo — os usuários podem vazar dados confidenciais para aplicativos de IA sombra (aplicativos não aprovados pela sua equipe de TI). Os usuários também podem acessar dados confidenciais usando aplicativos de IA.

- Vulnerabilidades e ameaças emergentes—Agentes mal-intencionados podem explorar vulnerabilidades em aplicativos de IA para acessar recursos valiosos.

- Não conformidade — as regulamentações, incluindo as regulamentações emergentes de IA, podem aumentar a incerteza. A adoção de IA não compatível pode aumentar a responsabilidade.

Os dois cenários de exemplo a seguir destacam a necessidade de construir uma postura de segurança forte para a IA.

Como acontece o compartilhamento excessivo e o vazamento de dados?

Neste exemplo, um funcionário da Contoso, Adele, localiza e usa dados confidenciais com vários aplicativos de IA.

| Passo | Descrição | Riscos não mitigados |

|---|---|---|

| 1 | Adele ouve um membro da equipe fazendo referência ao Projeto Obsidian. Ela usa o Microsoft 365 Copilot para encontrar mais informações sobre ele. O Copilot fornece-lhe um resumo e uma ligação para os documentos. | O Copilot pode processar dados confidenciais sem limitações. Os dados confidenciais estão superexpostos aos funcionários, incluindo aqueles que não deveriam ter acesso. |

| 2 | Adele continua usando o Copilot para encontrar e reunir mais informações sobre o Projeto Obsidian. | Não há controles em vigor para detetar anomalias em aplicativos de IA. |

| 3 | Por curiosidade, Adele quer ver o que o ChatGPT resumiria, então ela cola o conteúdo do arquivo no ChatGTP. | Não há prevenção de perda de dados (DLP) em vigor para evitar o vazamento de dados para aplicativos de IA do consumidor. |

| 4 | Os detalhes do projeto foram revelados prematuramente, resultando em violações de dados. Assim, a Contoso baniu todos os aplicativos de IA no local de trabalho. | Proibir completamente a IA do consumidor pode levar ao aumento do uso obscuro. |

A Contoso poderia ter mitigado esses riscos fazendo o trabalho de preparação, descoberta e proteção do uso de aplicativos de IA.

| Fase | Descrição |

|---|---|

| Preparação | Use o Entra e o Gerenciamento Avançado do SharePoint para dimensionar corretamente o acesso dos funcionários aos recursos. Use o Purview Information Protection para classificar e rotular dados confidenciais. |

| Descubra | Utilize o Purview DSPM for AI para identificar riscos de dados. Use um relatório de avaliação de compartilhamento excessivo para avaliar os riscos de compartilhamento excessivo. |

| Proteger | Imponha o Purview DLP para Microsoft 365 Copilot para impedir que o Copilot resuma dados confidenciais. Use o Purview Insider Risk Management para detetar e investigar atividades de anomalias. Use a Proteção Adaptável para restringir dinamicamente o acesso de usuários de alto risco. Use o Defender for Cloud Apps para bloquear aplicativos de alto risco. Use o Acesso Condicional do Entra para exigir que Adele aceite os Termos de Uso antes de conceder acesso ao ChatGPT. Use o Purview endpoint DLP para bloquear a colagem de dados confidenciais em aplicativos de IA do consumidor. |

Como a IA pode introduzir risco para a conformidade?

Neste próximo exemplo, Jane é designada para liderar a governança de IA da Contoso.

| Passo | Descrição | Riscos não mitigados |

|---|---|---|

| 1 | Jane se esforça para interpretar os requisitos normativos em controles acionáveis para as equipes de TI implementarem. | Falta de especialistas versados tanto em requisitos regulatórios quanto em tecnologia. |

| 2 | Jane começa a se preparar para avaliações de risco, mas não tem conhecimento dos sistemas de IA que estão sendo criados e usados na Contoso. Ela também não tem visibilidade sobre o uso e os potenciais riscos de conformidade. | Nenhuma visibilidade dos sistemas de IA implantados no ambiente. Nenhuma governança do uso de IA. |

| 3 | Depois de várias entrevistas internas, Jane percebe que os desenvolvedores estão construindo cerca de 14 aplicativos de IA simultaneamente, que vários padrões de segurança, proteção e controles de privacidade implementaram. | Nenhuma visibilidade sobre os controlos construídos pelos desenvolvedores em sistemas de IA. |

| 4 | Alguns aplicativos de IA usam dados pessoais sem guarda-corpos padrão para avaliar riscos. | Não existe uma avaliação de risco. |

| 5 | Os clientes estão reclamando que a IA da Contoso está criando conteúdo prejudicial e sem fundamento. | Falta de controles para saídas de IA. |

As regulamentações de IA trazem incerteza e riscos de responsabilidade esmagadores para os líderes responsáveis pela governança da IA. Sem alterações, a Contoso corre o risco de violar os requisitos regulatórios de IA e potencialmente enfrenta penalidades e danos à reputação.

A Contoso poderia ter mitigado esses riscos fazendo o trabalho de preparação, descoberta e proteção do uso de aplicativos de IA.

| Fase | Descrição |

|---|---|

| Preparação | Use o Purview Compliance Manager para obter orientação sobre a implementação de controles que podem ajudar a atender aos requisitos de conformidade. |

| Descubra | Use o Defender for Cloud para descobrir recursos de IA implantados em ambientes de nuvem. Use o Defender for Cloud Apps para descobrir aplicativos SaaS AI em uso. |

| Governação | Controle o uso da IA com o Microsoft Purview Audit, o Data Lifecycle Management, o Communication Compliance e o eDiscovery. Use relatórios de IA no Azure AI Foundry para que os desenvolvedores documentem os detalhes do projeto de IA. Use as Avaliações de Privacidade da Priva para avaliar proativamente os riscos de privacidade para cada projeto de IA. Use o Azure AI Content Safety para mitigar os riscos de conteúdo prejudicial ou infundado. |

Com o uso proativo de recursos de governança, as organizações podem avaliar e lidar com riscos ao adotar IA.

Cinco passos para implementar uma segurança eficaz para a IA

À medida que a consciência dos riscos associados à rápida implementação do GenAI aumenta, muitas organizações estão respondendo proativamente, dedicando recursos substanciais para melhorar suas medidas de segurança. Os líderes de segurança e risco podem tomar várias medidas acionáveis para criar um caminho para a inovação de IA segura e protegida.

Essas práticas recomendadas se concentram na promoção de um ambiente colaborativo e na implementação de medidas de segurança eficazes que apoiarão os avanços da GenAI enquanto salvaguardam os interesses organizacionais.

Etapa 1 — Crie uma equipe de segurança para IA

A maioria das empresas reconhece a necessidade de formar equipes dedicadas e multifuncionais para gerenciar os desafios de segurança exclusivos impostos pela IA. Equipes de segurança dedicadas garantem que os sistemas de IA sejam rigorosamente testados, as vulnerabilidades sejam rapidamente identificadas e mitigadas e os protocolos de segurança sejam continuamente atualizados para acompanhar a evolução das ameaças.

Oitenta por cento dos entrevistados têm atualmente (45%) ou planejam ter (35%) uma equipe dedicada para lidar com a segurança da IA. Mais de 6 em cada 10 disseram que suas equipes se reportarão a um tomador de decisões de segurança, garantindo não apenas supervisão vigilante, mas também visão estratégica e liderança na abordagem de riscos relacionados à IA.

Notavelmente, o tamanho médio da equipe, ou o tamanho pretendido da equipe, dessas equipes de segurança dedicadas era de 24 funcionários, ressaltando os recursos substanciais que as empresas estão se comprometendo a proteger suas iniciativas de IA. Quando o tamanho da empresa foi considerado, o tamanho das equipes variou.

Aqui estão algumas práticas recomendadas que as organizações podem usar para criar com sucesso uma equipe de segurança multifuncional eficaz para IA.

Formar um comitê de IA para promover a colaboração entre departamentos

Segurança para IA é um esforço coletivo que vai além do departamento de TI. Incentive a colaboração entre equipes como segurança, TI, jurídico, conformidade e gerenciamento de riscos para criar estratégias de segurança abrangentes. Ter diferentes perspetivas e conhecimentos aumentará a eficácia dos protocolos de segurança.

Contrate diversos conjuntos de habilidades

Formar uma equipe de segurança bem-sucedida para IA requer um equilíbrio de habilidades. Procure membros da equipe com experiência em ciência de dados, cibersegurança, engenharia de software e aprendizado de máquina. Esta diversidade garante a cobertura de vários aspetos da segurança, desde o desenvolvimento técnico até à prevenção de ameaças.

Estabeleça papéis e responsabilidades claros

Para uma produtividade eficaz, defina claramente o papel de cada membro da equipa. Garantir que todos compreendam as suas responsabilidades específicas, o que promove a responsabilização e evita a sobreposição de esforços.

Investir na formação e desenvolvimento contínuos

A rápida evolução das tecnologias de IA exige educação contínua para as equipes de segurança. Fornecer acesso a programas de treinamento e workshops que se concentram em práticas, ameaças emergentes e considerações éticas relacionadas à segurança da IA. Este investimento não só capacita os membros da equipa, mas também garante que a organização se mantém à frente de potenciais vulnerabilidades.

Etapa 2 — Otimizar recursos para proteger o GenAI

A introdução de aplicativos de IA dentro das organizações não está apenas revolucionando as operações, mas também exigindo mudanças significativas na alocação de recursos e orçamento, especialmente na segurança de TI.

Uma maioria significativa de líderes de segurança e risco (78%) acredita que seu orçamento de segurança de TI aumentará para acomodar os desafios e oportunidades únicos trazidos pela IA. Este ajustamento é crucial por várias razões. Os sistemas de IA exigem uma infraestrutura de segurança robusta para operar com segurança. Tal poderá implicar a modernização dos sistemas de segurança existentes, a implementação de controlos de acesso mais rigorosos e o reforço da segurança e da governação dos dados. Outros recursos também podem ser necessários para atender aos novos requisitos regulatórios emergentes de IA.

No início deste artigo, a Microsoft recomenda fazer o trabalho para entender as motivações dos líderes de negócios e das diferentes unidades de negócios em toda a sua organização. Identificar as principais preocupações e os objetivos de negócios compartilhados é um passo importante para negociar recursos para atingir os objetivos.

A alocação de fundos para avaliações de conformidade, consultas legais e auditorias torna-se essencial para alinhar a estratégia de IA de uma organização a uma estrutura do setor e permitir um uso e sistemas de IA mais seguros, seguros e compatíveis. Priorizar fundos para treinamento contínuo de funcionários e desenvolvimento de habilidades, que pode incluir treinamento especializado em ferramentas de segurança para IA, estratégias de gerenciamento de riscos e considerações éticas no uso de IA também é importante considerar ao alocar orçamento e recursos.

Etapa 3 — Adote uma abordagem Zero Trust

Ao se preparar para a adoção da IA, uma estratégia Zero Trust fornece aos líderes de segurança e risco um conjunto de princípios que ajudam a resolver algumas de suas principais preocupações, incluindo o compartilhamento excessivo ou superexposição de dados e a TI sombra. Uma abordagem Zero Trust muda de um foco centrado na rede para um foco centrado em ativos e dados e trata cada solicitação de acesso como uma ameaça potencial, independentemente de sua origem.

O Zero Trust valida constantemente as identidades de cada usuário e dispositivo, garantindo que apenas aqueles com permissões claras possam acessar informações confidenciais. Ao ajustar dinamicamente as medidas de segurança com base em avaliações em tempo real, o Zero Trust minimiza o risco de vazamento de dados e protege uma organização contra ameaças internas e externas. A verificação contínua, o acesso com privilégios mínimos e o gerenciamento dinâmico de riscos são as pedras angulares dessa abordagem, fornecendo uma estrutura de segurança robusta e adaptável que suporta o sucesso da segurança de ponta a ponta de uma organização.

Ao adotar o Zero Trust, as organizações podem proteger suas implantações de IA e saber que sua segurança é continuamente validada e protegida. O Zero Trust capacita as organizações a adotarem a IA com confiança, garantindo que os poderosos recursos da IA sejam aproveitados de forma segura e eficaz.

Todas as orientações de segurança para IA fornecidas pela Microsoft estão ancoradas nos princípios Zero Trust. Ao seguir as diretrizes de segurança recomendadas para a GenAI, você está construindo uma base sólida de Zero Trust.

Passo 4 — Invista na responsabilidade partilhada com parceiros em quem confia

Um recurso que é frequentemente utilizado para ajudar a informar a estratégia e as prioridades é o modelo de responsabilidade partilhada. Sua responsabilidade por proteger o uso de IA em sua organização é baseada no tipo de aplicativos usados. Os parceiros em que investe partilham a responsabilidade consigo.

Um modelo de responsabilidade compartilhada ajuda as equipes de segurança a orientar sua organização a escolher:

- Aplicativos GenAI que reduzem a responsabilidade para suas organizações.

- Parceiros que ganharam a sua confiança.

Este diagrama resume o equilíbrio de responsabilidades para você e para a Microsoft. Muitas organizações usam o modelo de responsabilidade compartilhada para priorizar o uso de aplicativos SaaS em parceria com provedores confiáveis e reduzir o número de aplicativos personalizados.

Para obter mais informações, consulte Modelo de responsabilidade compartilhada de IA - Microsoft Azure.

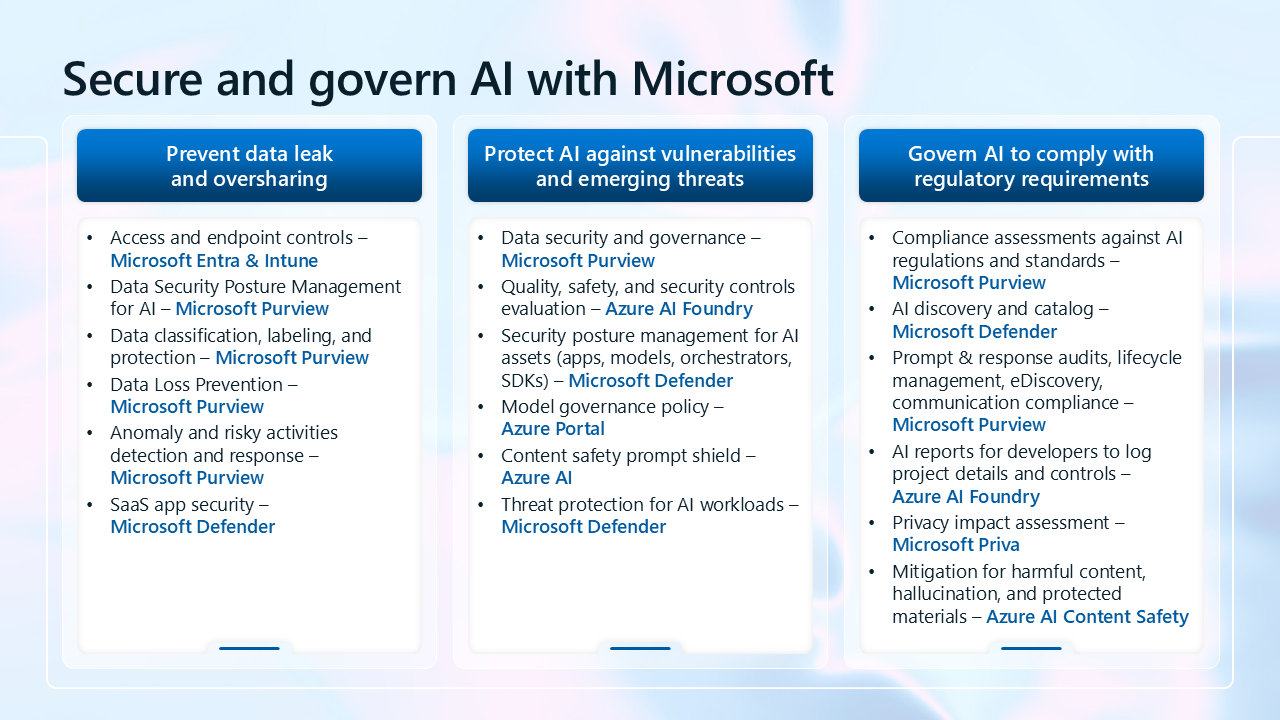

Além de investir com parceiros que conquistaram sua confiança, muitos profissionais de segurança recomendam a consolidação de ferramentas e fornecedores de segurança. A Microsoft oferece uma solução de segurança abrangente para IA com ferramentas que trabalham juntas, reduzindo consideravelmente o volume de trabalho de integração para as equipes de segurança.

Etapa 5 — Adotar uma solução de segurança abrangente para IA

A IA introduz riscos específicos que as medidas de segurança tradicionais podem não abordar totalmente. A segurança para IA foi projetada para mitigar esses riscos.

Uma maioria significativa de empresas planeja adquirir ferramentas e plataformas especializadas para proteger o uso e o desenvolvimento de aplicativos de IA. Quando questionados sobre como planejam proteger o uso e o desenvolvimento de aplicativos de IA em suas organizações, a maioria dos participantes da pesquisa (72%) disse que planeja adquirir uma nova solução de segurança dedicada para proteger o uso e o desenvolvimento de IA, enquanto 64% afirmaram que planejam usar soluções de segurança existentes para proteger a IA.

Os líderes de TI e segurança acreditam que os principais contribuintes do orçamento para novas soluções para a proteção e governança da IA serão os departamentos de TI (63%) e os departamentos de segurança da informação / cibersegurança (57%). Essas descobertas mostram que, além de continuar a usar as soluções de segurança existentes, as organizações veem a necessidade de procurar novas soluções que possam ajudar a lidar com os riscos amplificados e emergentes da IA.

Além da plataforma de segurança de ponta a ponta da Microsoft, a Microsoft fornece ferramentas de segurança abrangentes para proteger a IA, desde a descoberta de ferramentas e dados de IA até proteções projetadas especificamente para mitigar ameaças de IA. Essas ferramentas incluem painéis sofisticados e recursos de conformidade, ajudando você a ficar por dentro dos riscos e das obrigações regulamentares.

A imagem a seguir é uma visão resumida de todos os recursos que a Microsoft fornece para proteger a adoção de IA. Esses recursos também estão listados na tabela abaixo.

| Principal preocupação do cliente | Capacidades |

|---|---|

| Evite fugas de dados e partilha excessiva | - Controles de acesso e endpoint — Microsoft Entra & Intune - Gestão de Postura de Segurança de Dados para IA — Microsoft Purview - Classificação, rotulagem e proteção de dados — Microsoft Purview - Prevenção de perda de dados — Microsoft Purview - Deteção e resposta de anomalias e atividades de risco — Microsoft Purview - Segurança de aplicativos SaaS — Microsoft Defender |

| Proteja a IA contra vulnerabilidades e ameaças emergentes | - Segurança e governança de dados — Microsoft Purview - Avaliação de controles de qualidade, segurança e proteção — Azure AI Foundry - Gerenciamento de postura de segurança para ativos de IA (aplicativos, modelos, orquestradores, SDKs) — Microsoft Defender - Política de governança de modelo — Portal do Azure - Escudo de sinal de segurança de conteúdo — Azure AI - Proteção contra ameaças para cargas de trabalho de IA — Microsoft Defender |

| Governar a IA para cumprir os requisitos regulamentares | - Avaliações de conformidade com regulamentos e padrões de IA — Microsoft Purview - Descoberta e catálogo de IA — Microsoft Defender - Auditorias de resposta imediata, gerenciamento do ciclo de vida, eDiscovery, conformidade de comunicação — Microsoft Purview - Relatórios de IA para desenvolvedores registrarem detalhes e controles do projeto — Azure AI Foundry - Avaliação de impacto na privacidade — Microsoft Priva - Mitigação de conteúdo nocivo, informações incorretas e materiais protegidos — Azure AI Content Safety |

Próximos passos para proteger a IA

Esta biblioteca orienta você através do processo de implementação de segurança para IA em uma abordagem por etapas.

Siga as orientações desta série de artigos para saber mais sobre como proteger a IA e identificar e implementar recursos para alcançar os objetivos da sua organização.

- Prepare-se para a IA

- Descubra aplicativos e dados de IA

- Proteja dados e aplicativos de IA

- Governe a IA para fins de conformidade

Para saber mais sobre como otimizar sua postura geral de segurança e Zero Trust, consulte Modernizar rapidamente sua postura de segurança.

Para começar com as proteções de segurança recomendadas para companheiros de IA, consulte Usar segurança Zero Trust para se preparar para companheiros de IA, incluindo Microsoft Copilots.