LLM-verktyg för flöden i Azure AI Studio

Viktigt!

Vissa av de funktioner som beskrivs i den här artikeln kanske bara är tillgängliga i förhandsversionen. Den här förhandsversionen tillhandahålls utan ett serviceavtal och vi rekommenderar det inte för produktionsarbetsbelastningar. Vissa funktioner kanske inte stöds eller kan vara begränsade. Mer information finns i Kompletterande villkor för användning av Microsoft Azure-förhandsversioner.

Om du vill använda stora språkmodeller (LLM) för bearbetning av naturligt språk använder du LLM-verktyget för promptflöde.

Kommentar

Information om inbäddningar för att konvertera text till kompakta vektorrepresentationer för olika bearbetningsuppgifter för naturligt språk finns i Inbäddningsverktyget.

Förutsättningar

Förbered en fråga enligt beskrivningen i dokumentationen till promptverktyget . BÅDE VERKTYGET LLM och promptverktyget stöder Jinja-mallar . Mer information och metodtips finns i Fråga om teknik.

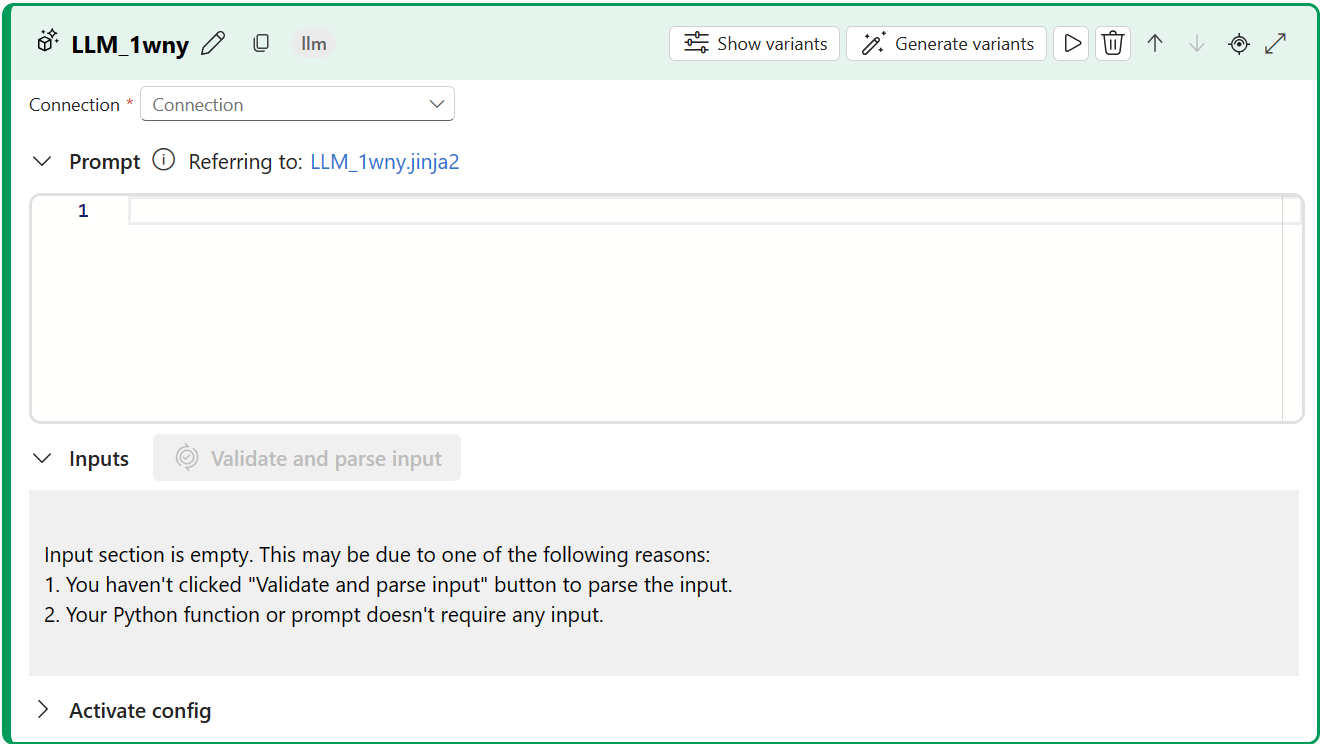

Skapa med LLM-verktyget

Skapa eller öppna ett flöde i Azure AI Studio. Mer information finns i Skapa ett flöde.

Välj + LLM för att lägga till LLM-verktyget i flödet.

Välj anslutningen till en av dina etablerade resurser. Välj till exempel Default_AzureOpenAI.

I listrutan Api väljer du chatt eller slutförande.

Ange värden för llm-verktygets indataparametrar som beskrivs i tabellen Textkompletteringsindata. Om du har valt chatt-API:et läser du tabellen Chattindata. Om du har valt API:et för slutförande läser du tabellen Textslutindata. Information om hur du förbereder promptindata finns i Krav.

Lägg till fler verktyg i ditt flöde efter behov. Eller välj Kör för att köra flödet.

Indata

Följande indataparametrar är tillgängliga.

Textkompletteringsindata

| Namn | Type | Beskrivning | Obligatoriskt |

|---|---|---|---|

| Snabb | sträng | Textprompt för språkmodellen. | Ja |

| modell, deployment_name | sträng | Den språkmodell som ska användas. | Ja |

| max_tokens | integer | Det maximala antalet token som ska genereras i slutförandet. Standardvärdet är 16. | Nej |

| temperatur | flyttal | Slumpmässigheten i den genererade texten. Standard är 1. | Nej |

| Stanna | lista | Stoppsekvensen för den genererade texten. Standardvärdet är null. | Nej |

| Suffix | sträng | Texten som läggs till i slutet av slutförandet. | Nej |

| top_p | flyttal | Sannolikheten att använda det översta valet från de genererade token. Standard är 1. | Nej |

| logprobs | integer | Antalet loggannolikheter som ska genereras. Standardvärdet är null. | Nej |

| eko | boolean | Värdet som anger om kommandot ska upprepas i svaret. Standardvärdet är falskt. | Nej |

| presence_penalty | flyttal | Värdet som styr modellens beteende när det gäller upprepade fraser. Standardvärdet är 0. | Nej |

| frequency_penalty | flyttal | Värdet som styr modellens beteende när det gäller att generera sällsynta fraser. Standardvärdet är 0. | Nej |

| best_of | integer | Antalet bästa slutföranden som ska genereras. Standard är 1. | Nej |

| logit_bias | Ordbok | Logit bias för språkmodellen. Standard är en tom ordlista. | Nej |

Chattindata

| Namn | Type | Beskrivning | Obligatoriskt |

|---|---|---|---|

| Snabb | sträng | Textprompten som språkmodellen ska svara på. | Ja |

| modell, deployment_name | sträng | Den språkmodell som ska användas. | Ja |

| max_tokens | integer | Det maximala antalet token som ska genereras i svaret. Standardvärdet är inf. | Nej |

| temperatur | flyttal | Slumpmässigheten i den genererade texten. Standard är 1. | Nej |

| Stanna | lista | Stoppsekvensen för den genererade texten. Standardvärdet är null. | Nej |

| top_p | flyttal | Sannolikheten att använda det översta valet från de genererade token. Standard är 1. | Nej |

| presence_penalty | flyttal | Värdet som styr modellens beteende när det gäller upprepade fraser. Standardvärdet är 0. | Nej |

| frequency_penalty | flyttal | Värdet som styr modellens beteende när det gäller att generera sällsynta fraser. Standardvärdet är 0. | Nej |

| logit_bias | Ordbok | Logit bias för språkmodellen. Standard är en tom ordlista. | Nej |

Utdata

Utdata varierar beroende på vilket API du har valt för indata.

| API | Returtyp | beskrivning |

|---|---|---|

| Slutförandet | sträng | Texten i ett förutsagt slutförande. |

| Chatt | sträng | Texten i ett konversationssvar. |

Nästa steg

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för