Den här lösningen visar hur du uppnår skalning mellan kluster av arbetsbelastningar som distribueras i en hybridinfrastruktur. Den här lösningen uppnås genom att tillämpa skalbarhets- och hanteringsfunktionerna i Azure Arc-aktiverade tjänster på Azure Stack HCI-kluster.

Arkitektur

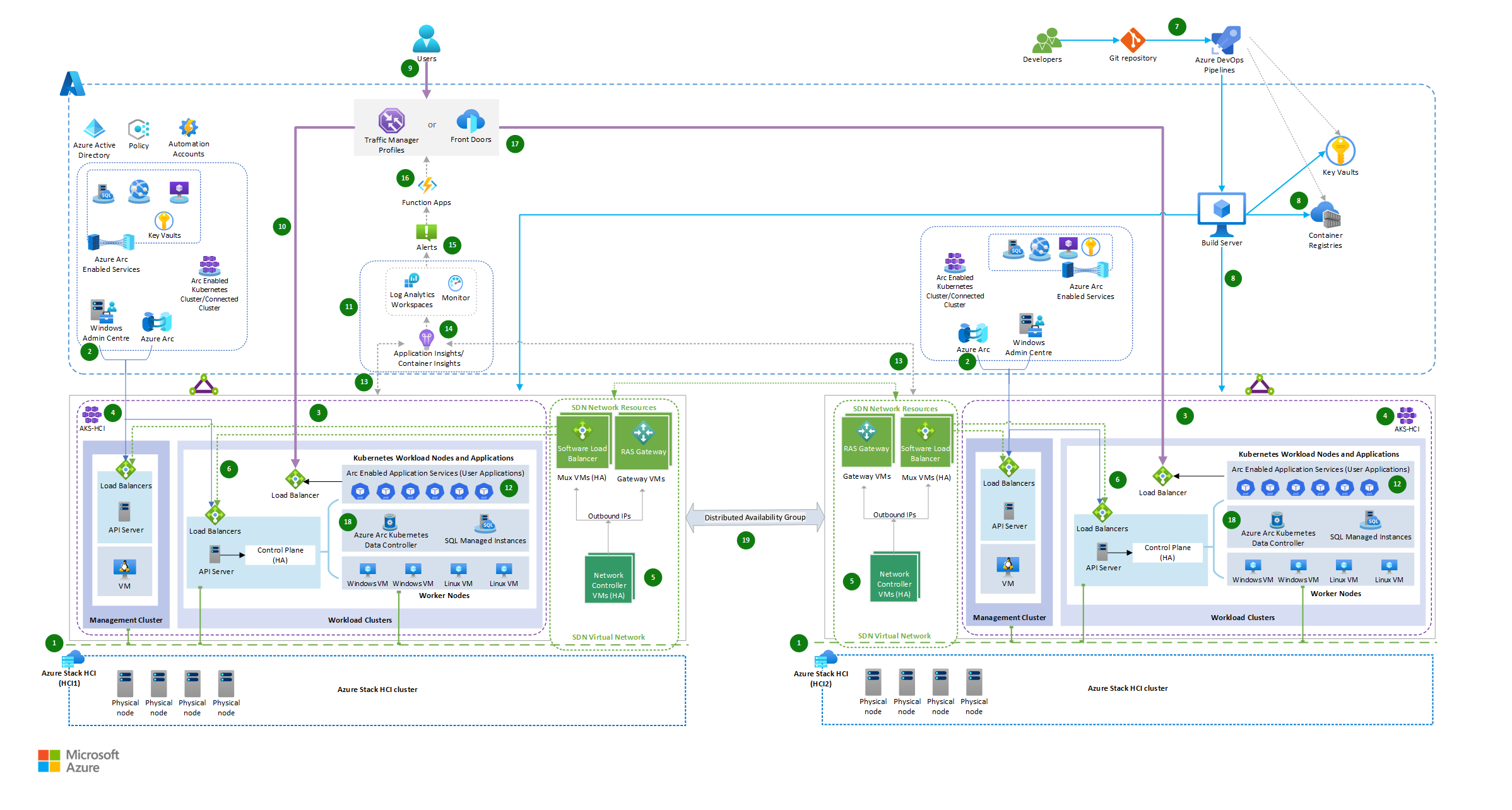

Arkitekturen visar distributionen av hybridlösningar med hjälp av Azure Arc-aktiverade tjänster på Azure Stack HCI, Azure Pipelines och integrering av en global lastbalanserare och en Azure-funktionsapp.

Ladda ned en Visio-fil med den här arkitekturen.

Arbetsflöde

Arkitekturen består av följande steg:

Två Azure Stack HCI-kluster har konfigurerats på två olika platser: Azure Stack HCI (HCI1) fungerar som primär lokal infrastruktur och Azure Stack HCI (HCI2) som sekundär lokal infrastruktur för körning av arbetsbelastningar.

Azure Stack HCI-kluster ansluter till Azure via SD-WAN och hanteras via Azure Arc och Windows Admin Center. Därför kan du utöka Azure-funktionerna till lokal infrastruktur och använda Azure-hanteringsverktyg och -tjänster för att hantera och övervaka lokal infrastruktur och arbetsbelastning.

Azure Kubernetes Service (AKS) som distribueras i Azure Stack HCI består av hanteringsklustret (AKS-värden) och arbetsbelastningskluster (även kallade målkluster) där containerbaserade program distribueras. Se Azure Kubernetes Service -baslinjearkitekturen (AKS) för AKS på Azure Stack HCI.

Azure Kubernetes Service-värd på Azure Stack HCI och arbetsbelastningskluster distribueras med hjälp av AksHci PowerShell-moduler. Se Använda PowerShell för att konfigurera Kubernetes i Azure Stack HCI- och Windows Server-kluster.

Virtualisering av nätverksresurser implementeras genom att använda SDN-funktioner i Azure Stack HCI-kluster. Den distribuerar de nödvändiga SDN-nätverksinfrastrukturresurserna, till exempel virtuella Mux Mux-datorer för software load balancer, virtuella RAS Gateway-datorer och nätverksstyrenheter för högre nätverkstillgänglighet. Se Programvarudefinierade nätverk (SDN) i Azure Stack HCI och Windows Server.

VIRTUELLA DATORER med AKS-infrastruktur och arbetsbelastning distribueras till ett virtuellt SDN-nätverk med hybridbelastningsutjämning som uppnås via SDN Software Load Balancer (SLB). Se Distribuera Microsoft Software Defined Networking (SDN) med AKS på Azure Stack HCI.

Azure Pipelines distribuerar klientdelsprogram med samma versioner av de containerbaserade program som distribueras i båda lokala Azure Stack HCI-miljöer.

Databaser finns i Arc-aktiverade SQL Managed Instances som distribueras i AKS-hybrid.

En utvecklare paketerar sina program som en container som ska distribueras till både AKS Hybrid-kluster med kubernetes-manifest och AksHci PowerShell-moduler och automatiserar distributionsuppgifter via Azure Pipelines.

En klientbegäran till programmet dirigeras av en global lastbalanserare som Azure Front Door eller Azure Traffic Manager, som dirigerar begäran till lämplig tjänstslutpunkt med hjälp av en viktad trafikroutningsmetod. Baserat på den tilldelade viktade procentandelen distribueras trafiken till tjänster som distribueras över de två AKS-hybridklusteren på Stack HCI.

Både Traffic Manager och Azure Front Door är användbara alternativ för att hantera globala belastningsutjämningsfunktioner på grund av förekomsten av kluster i flera regioner. Valet mellan Azure Front Door och Traffic Manager beror på olika faktorer, och beslutet att rekommendera det ena framför det andra kräver noggrant övervägande. Här följer några skäl att överväga olika belastningsutjämningstjänster:

- Om dina internetuppkopplade program använder HTTPS är Azure Front Door det bästa alternativet. I allmänhet är Traffic Manager inte det primära valet i sådana instanser. Det kan finnas undantag, men specifika scenarier ligger utanför omfånget för den här diskussionen.

- Om ditt primära mål är effektiv global belastningsutjämning kan Traffic Manager vara tillräckligt. Om du också behöver optimering av innehållsleverans, säkerhet på programnivå och mer avancerade routningsfunktioner kan Azure Front Door passa bättre.

- Traffic Manager är enklare att konfigurera och fokuserar främst på belastningsutjämning. Azure Front Door erbjuder fler funktioner men kan ha en brantare inlärningskurva.

- Överväg din programtyp. Om det är mer webbcentrerat och du behöver optimeringar som cachelagring och SSL-avslutning kan Azure Front Door vara fördelaktigt.

- När det gäller DNS-baserad routning minskar komplexiteten vid hantering av belastningsutjämning på programnivå. Det är dock viktigt att observera att om du enbart förlitar dig på DNS-baserad routning kan det leda till ökad stilleståndstid under ett fel, vilket kan påverka dina programs serviceavtal (SLA) negativt. Beslutet mellan Azure Front Door och Traffic Manager bör ta hänsyn till DNS-lösningens serviceavtal och om ditt program kan hantera de olika redundanstiderna mellan de två alternativen.

De distribuerade arbetsbelastningsprogrammen övervakas för belastning med hjälp av Azure Arc-aktiverade tjänster, Azure Monitor och Log Analytic Workspace.

Under normala belastningsförhållanden dirigeras klientbegäran till instansen av appen som finns lokalt i Azure Stack HCI-1-miljön (primär klustermiljö).

Arc-aktiverade AKS-klusterarbetsbelastningar är utformade för att skalas horisontellt till flera instanser med inbyggd autoskalning, som automatiskt skalar upp eller ned antalet noder i det distribuerade AKS-klustret baserat på efterfrågan.

Containerinsikter har aktiverats för att samla in diagnostik och övervaka arbetsbelastningsprestanda på Kubernetes-klustret som finns i Azure Stack HCIs.

När trafiken ökar och arbetsbelastningsklustret på Azure Stack HCI-1 når maximalt antal noder utan ytterligare skalningsalternativ för poddar, genereras en avisering för att utlösa en Azure-funktionsapp.

En aviseringsregel har konfigurerats för att övervaka resultatet av en anpassad Kusto-fråga, som söker efter maximalt antal noder och poddberedskap i procent från Tabellerna KubeNodeInventory och KubePodInventory Azure Monitor. Se Skapa loggaviseringar från Container Insights.

Kubernetes-övervakning kan också utföras med förkonfigurerade aviseringsregler från Kubernetes Container Insights. Du kan också använda kubePodNotReady- eller KubeHpaMaxedOut-måttreglerna från Container Insights för att konfigurera villkor för aviseringsregler. Se Måttaviseringsregler i Containerinsikter (förhandsversion) och anropa Azure-funktionsappen via aviseringens åtgärdsgrupp.

Azure Function App hanterar dynamiskt viktade trafikroutningsregler baserat på det primära klustrets villkor och omdirigerar trafiken till Azure Stack HCI-2-klustret.

- Du kan använda Azure Function för att beräkna procentandelen trafik som måste omdirigeras baserat på fördefinierade tröskelvärden för klusterberedskap och trafikförhållanden. Om du gör det kan du snabbt anpassa dig till ändringar, automatisera uppgifter, skala resurser effektivt och spara pengar.

- Azure Function hjälper till att hantera trafikroutningsregler dynamiskt. Den här funktionen säkerställer hög tillgänglighet, skalbarhet och prestanda och ger en sömlös användarupplevelse även under scenarier med hög trafik och redundans. Till exempel börjar den inledande trafikdistributionen med att dirigera 100 % av trafiken till det primära klustret när den presterar bra och kan hantera belastningen. När det primära klustret är nästan fullt eller får prestandaförsämring kan du justera trafikdirigeringsreglerna i Azure Function. Om du gör det omdirigeras en del av den skrivskyddade trafiken till det sekundära klustret.

Appinstanser som körs i båda klustermiljöerna ansluter till datatjänsterna, till exempel arcaktiverade SQL Managed Instances, lokalt i respektive kluster.

Datasynkronisering mellan kluster för Arc SQL Managed Instances styrs av Azure Failover Group, som i sin tur använder distribuerade tillgänglighetsgrupper. Synkronisering mellan kluster kan vara synkronisering eller asynkronisering. Se Azure Arc-aktiverad SQL Managed Instance.

I det här arbetsflödet ingår att skapa och distribuera program, belastningsutjämning, trafikhantering, automatisk skalning och datasynkronisering i flera klustermiljöer. Med den här konfigurationen kan du skala infrastrukturen horisontellt mellan kluster på två olika datacenter eller platser, vilket ger säkerhet, redundans, flexibilitet och effektiv resursanvändning.

Komponenter

Azure Front Door är en layer 7-lastbalanserare. I den här arkitekturen dirigerar den HTTP-begäranden till de webbprogram som distribueras i Stack HCI-kluster. Du kan också använda en brandvägg för webbprogram (WAF) med Azure Front Door som skyddar programmet från vanliga sårbarheter och en CDN-lösning (Content Delivery Network) i den här designen för att minska svarstiden och förbättra innehållsinläsningstiden genom att cachelagra innehållet på gränsenheter.

Traffic Manager är en DNS-baserad trafiklastbalanserare och ett genomförbart alternativ för belastningsutjämning. Använd den för att styra distributionen av programtrafik till tjänstslutpunkter i olika datacenter. Så här fungerar Traffic Manager-konfigurationen:

- Konfigurera Traffic Manager, en global belastningsutjämningslösning i Azure, för att distribuera inkommande trafik över dina Azure Stack HCI-kluster. Traffic Manager kan konfigureras för att använda olika belastningsutjämningsmetoder, till exempel prestanda, redundans eller viktad resursallokering, beroende på kraven.

- Skapa Traffic Manager-slutpunkter som motsvarar slutpunkterna för arbetsbelastningar som distribueras i Azure Stack HCI-kluster. Detta gör att Traffic Manager kan dirigera trafik till rätt slutpunkt. I det här scenariot dirigerar du trafik baserat på den viktade routningsmetoden för belastningsutjämning.

- Baserat på skalningsprinciperna som beräknas via en Azure-funktion kan Traffic Manager dynamiskt dirigera trafik till andra instanser baserat på routningsreglerna och deras viktade procentsatser när det finns behov av extra kapacitet eller hög tillgänglighet.

Application Insights samlar in telemetridata från olika komponenter som distribueras i den här hybridlösningen. Det ger insikter och analyser som kan användas för att identifiera problem, optimera prestanda och förbättra användarupplevelsen.

Azure Functions fungerar som orkestrerare för trafikdistribution. Den övervakar beredskapsvillkoren för varje kluster och utvärderar faktorer som resursanvändning, svarstid och hälsa. Baserat på den här utvärderingen bestämmer funktionsappen var inkommande trafik ska dirigeras.

Azure Stack HCI är en klusterlösning för hyperkonvergerad infrastruktur (HCI) som är värd för virtualiserade Windows- och Linux-arbetsbelastningar och deras lagring i en hybridmiljö som kombinerar lokal infrastruktur med Azure-tjänster.

- Lösningen använder Arc-Enabled Azure Kubernetes Service på Azure Stack HCI (AKS-HCI) som värd för webbappen eller API:erna, Arc-Enabled Azure Servers och Arc-Enabled Data Services i båda miljöerna.

Azure DevOps Services fungerar som ryggraden i den här distributionsstrategin för hybridlösningar, vilket ger den automatisering och orkestrering som krävs för att effektivisera hela livscykeln för programvaruleverans. Det gör det möjligt för utvecklingsteam att fokusera på att leverera kod av hög kvalitet medan pipelinen tar hand om att skapa, testa och distribuera program.

Om du vill distribuera ett AKS-kluster på Azure Stack HCI kan du konfigurera en byggserver i Azure Pipelines. Byggservern ansvarar för att köra distributionsprocessen.

a. Skapa en virtuell dator (VM) i Azure eller en virtuell dator från Stack HCI-miljön. Eller använd en befintlig lokal virtuell dator som byggserver om den har nätverksanslutning till hybridinfrastrukturerna.

b. Installera nödvändiga verktyg på byggservern, till exempel Git, Azure CLI och Azure PowerShell-moduler.

c. Konfigurera autentisering till Azure genom att konfigurera tjänstens huvudnamn eller använda hanterade identiteter.

Azure Pipelines är en tjänst som tillhandahåller CI/CD och hanterar värdbaserade bygg- och versionsagenter och definitioner. Utvecklingspipelinen kan använda olika kodlagringsplatser, inklusive GitHub, Bitbucket, Dropbox, OneDrive och Azure Repos.

Azure Monitor samlar in telemetridata och övervakar prestanda för kluster och arbetsbelastningar. Du kan också konfigurera aviseringar för att utlösa en Azure-funktion eller meddela en administratör om något kluster blir felfritt eller om fördefinierade tröskelvärden överskrids. Du kan använda Azure Automation eller Azure Logic Apps för att automatisera skalningsåtgärder baserat på övervakningsdata.

Azure Policy fungerar som en styrnings- och efterlevnadstvingande, vilket garanterar att Stack HCI-kluster och associerade SDN-resurser fungerar enligt de definierade riktlinjerna och standarderna. Här följer några exempel för att förbättra säkerheten i miljön via Azure Policy:

- Framtvinga Container Insight-tillägg

- Installation av viktiga tillägg i Stack HCI-kluster

- Framtvinga resurstaggning

- Principbaserad åtkomstkontroll

- Nätverks- och övervakningsrelaterade principer

Azure Container Registry är en hanterad, privat Docker-registertjänst i Azure. Använd Container Registry för att lagra privata Docker-avbildningar som distribueras till klustret.

Azure Arc utökar Azure-tjänster till lokala miljöer, vilket gör att organisationer kan dra nytta av molnfunktioner samtidigt som känsliga data bevaras i sin egen infrastruktur.

Containerinsikter är en övervaknings- och observerbarhetslösning som tillhandahålls av Azure Monitor och som gör att du kan få insikter om prestanda och hälsotillstånd för containrar som körs i AKS-kluster. Med Azure Arc aktiverat för AKS kan du utöka funktionerna i Container Insights för att övervaka och hantera dina AKS-kluster som körs utanför Azure, till exempel för lokala miljöer eller miljöer med flera moln.

Arc-Enabled SQL Managed Instances är en Azure SQL-datatjänst som kan skapas i Stack HCI-infrastrukturen och hanteras med hjälp av Azure Arc.

Med Azure Key Vault kan du lagra och hantera kryptografiska nycklar, hemligheter och certifikat på ett säkert sätt. Även om Azure Key Vault främst är en molntjänst kan det också användas med Azure Stack HCI-distributioner för att lagra och hantera känslig information på ett säkert sätt lokalt.

SDN-infrastruktur. I en AKS-hybriddistribution på Azure Stack HCI uppnås belastningsutjämning via SLB-SDN (Software Load Balancer). SLB hanterar AKS-HCI-infrastrukturen och programmen i det virtuella SDN-nätverket (programvarudefinierat nätverk), inklusive nödvändiga SDN-nätverksinfrastrukturresurser som virtuella Mux-lastbalanserare, virtuella gatewaydatorer och nätverksstyrenheter.

Här är en uppdelning av de komponenter som ingår:

- Software Load Balancer (SLB): SLB är en nyckelkomponent i AKS-HCI-infrastrukturen som tillhandahåller belastningsutjämningsfunktioner för att distribuera nätverkstrafik till de program som körs i klustret. Den körs på transportskiktet (Layer 4) och dirigerar trafik baserat på konfigurerade regler.

- Virtuella Mux Load Balancer-datorer: Virtuella Mux-lastbalanserare är virtuella datorer som hanterar inkommande nätverkstrafik från externa källor och distribuerar den till lämpliga serverdelspoddar eller tjänster i AKS-HCI-klustret. De arbetar med SLB för att utföra belastningsutjämning.

- Virtuella gatewaydatorer: Virtuella gatewaydatorer ger anslutning mellan AKS-HCI-klustret och externa nätverk. De fungerar som en brygga mellan det interna virtuella SDN-nätverket och externa nätverk, vilket gör att inkommande och utgående trafik flödar säkert.

- Nätverksstyrenheter: Nätverksstyrenheter ansvarar för att hantera SDN-infrastrukturen i AKS-HCI-klustret. De hanterar uppgifter som tvingande nätverksprinciper, nätverkskonfiguration och konfiguration av lastbalanserare.

Med SLB, virtuella Mux-lastbalanserare, virtuella gatewaydatorer och nätverksstyrenheter uppnår AKS-HCI belastningsutjämning för hybriddistributioner. Det säkerställer att inkommande nätverkstrafik effektivt distribueras över de program som körs i klustret, vilket ger hög tillgänglighet och skalbarhet.

Kommentar

Dessa komponenter hanteras och konfigureras av AKS-HCI, så att du kan fokusera på att distribuera och hantera dina program samtidigt som du använder de inbyggda funktionerna för belastningsutjämning på plattformen.

Alternativ

För webbprogram och händelsebaserade tjänster kan du köra App Service, Functions och Logic Apps på ett Azure Arc-aktiverat Kubernetes-kluster som finns på Azure Stack HCI. För databasen kan du använda ett annat lagringsalternativ, till exempel Azure Arc-aktiverad PostgreSQL-server.

För webbprogram kan du använda Azure Front Door. Azure Front Door fungerar på Layer 7, HTTP/HTTPS-lagret. Det använder anycast-protokollet med delad TCP och microsofts globala nätverk för att förbättra den globala anslutningen. Routningsmetoden kan se till att Azure Front Door dirigerar dina klientbegäranden till den snabbaste och mest tillgängliga programserverdelen.

Du kan använda Azure ExpressRoute för att ansluta ditt lokala nätverk direkt till Azure-resurser med hjälp av en dedikerad privat nätverksanslutning.

Om lagringsplatsen finns i GitHub kan du använda GitHub Actions i stället för Azure Pipelines.

Information om scenario

Det primära målet är att underlätta skalning mellan kluster genom att effektivt distribuera arbetsbelastningar mellan kluster på två olika datacenter eller platser. Den här metoden förhindrar överlagring av ett enskilt kluster och optimerar resursanvändningen i alla kluster. Azure-funktionsappen spelar en central roll när det gäller intelligent distribution av trafik baserat på klusterberedskapsförhållanden, vilket ökar effektiviteten, skalbarheten, tillgängligheten och prestandan.

Det här scenariot gäller för organisationer som hanterar en strikt uppsättning begränsningar, regler för datasuveränitet eller viktiga återhämtnings- och affärskontinuitetsbehov eller hantering av kritiska arbetsbelastningar i mycket begränsade och reglerade miljöer som banker, ekonomi, försvar och myndigheter. På grund av organisationers regler och efterlevnadsprinciper körs program och databaser lokalt för att förhindra att konfidentiella eller känsliga data exponeras i det offentliga molnet. Den här lösningen är användbar när:

Lokala appar upplever användningstoppar under högsäsong och autoskalning i klustret, men det primära klustret når 100 % kapacitet och vill omdirigera spilltrafik till ett annat datacenterkluster utan att avbryta några tjänstkörningar.

Du vill lösa omdistributionen av app-/API-trafik automatiskt till närmaste tillgängliga lokala miljö.

Du vill förenkla styrning och hantering av lokal installation och åtkomst till relevanta molntjänster som filtreras via en brandvägg eller proxyserver på ett konsekvent och säkert sätt via Azure Arc-aktiverade tjänster som distribueras på Azure Stack HCI.

Potentiella användningsfall

- Du vill implementera högtillgängliga, skalbara, skyddade och begränsade arbetsbelastningar i en lokal Azure Stack HCI-klustermiljö.

- Du vill ha dynamisk skalning av program som körs mellan datacenter när lokala appar får toppar i användningen.

- Du vill tillämpa molnbaserad automatisering med centraliserad hantering, styrning och övervakning.

- Du har lokala komponenter och vill använda en annan lokal installation för att skala dem.

- Du vill att dynamisk skalbarhet mellan kluster ska köra dina appar lokalt tills du kan utöka skalningen av dina arbetsbelastningar till molninstanser.

Att tänka på

Dessa överväganden implementerar grundpelarna i Azure Well-Architected Framework, som är en uppsättning vägledande grundsatser som kan användas för att förbättra kvaliteten på en arbetsbelastning. Mer information finns i Microsoft Azure Well-Architected Framework.

Tillförlitlighet

Tillförlitlighet säkerställer att ditt program kan uppfylla de åtaganden du gör gentemot dina kunder. Mer information finns i Översikt över tillförlitlighetspelare.

Ett företag kan använda en hybridmetod för att underhålla sina system genom att lagra appar och resurser lokalt av regel- och prestandaskäl. Om de vill använda Azure-molnfunktioner kan de distribuera samma version av program som finns i Azure HCI-kluster i flera regioner. Detta uppfyller deras efterlevnad av tjänster med hög tillgänglighet och skalbarhet.

Säkerhet

Säkerhet ger garantier mot avsiktliga attacker och missbruk av dina värdefulla data och system. Mer information finns i Översikt över säkerhetspelare.

När du distribuerar AKS-HCI är det viktigt att överväga säkerhetsrutiner för att skydda dina program och infrastruktur. Här följer några viktiga säkerhetsöverväganden för AKS-HCI:

Säker klusteråtkomst

- Begränsa åtkomsten till AKS-HCI-klustret genom att följa principen om lägsta behörighet. Bevilja endast nödvändiga behörigheter till användare, grupper eller tjänstkonton.

- Använd starka autentiseringsmekanismer, till exempel Microsoft Entra-integrering, Microsoft Entra Pod Identity eller Kubernetes rollbaserad åtkomstkontroll (Kubernetes RBAC) för att styra åtkomsten till klustret och dess resurser.

- Överväg att implementera multifaktorautentisering (MFA) för klusteråtkomst för att lägga till ett extra säkerhetslager.

Nätverkssäkerhet

- Implementera nätverkssegmentering och isolering i AKS-HCI-klustret med kubernetes-nätverksprinciper eller Azure-nätverkssäkerhetsgrupper.

- Kontrollera inkommande och utgående trafik med brandväggar på nätverksnivå, till exempel Azure Firewall, och begränsa åtkomsten baserat på listan över tillåtna IP-adresser eller peering för virtuella nätverk.

- Kryptera nätverkstrafik mellan tjänster med hjälp av TLS -autentisering (Transport Layer Security) eller ömsesidig TLS-autentisering (mTLS).

Säkerhet för containeravbildning

- Använd säkra containeravbildningar från betrodda källor och uppdatera dem regelbundet med de senaste säkerhetskorrigeringarna och sårbarhetskorrigeringarna.

- Implementera verktyg för bildgenomsökning och sårbarhetsbedömning för att identifiera och åtgärda eventuella säkerhetsproblem i containeravbildningar.

- Använd mekanismer för signering och verifiering av containeravbildningar för att säkerställa avbildningarnas integritet och äkthet.

Hantering av hemligheter

- Undvik hårdkodning av känslig information (till exempel lösenord, API-nycklar eller niska veze) i programkoden eller konfigurationsfilerna.

- Använd Azure Key Vault eller en säker lösning för hantering av hemligheter för att lagra och hämta känslig information på ett säkert sätt.

- Använd Kubernetes-hemligheter eller Azure Key Vault-integrering för att mata in hemligheter på ett säkert sätt i dina programcontainrar.

Loggning och övervakning

- Implementera centraliserad loggning och övervakning för AKS-HCI-kluster med hjälp av Azure Monitor eller lösningar från tredje part.

- Konfigurera granskningsloggar, containerloggar och systemloggar för att samla in kritiska säkerhetshändelser.

- Konfigurera aviserings- och meddelandemekanismer för att proaktivt identifiera och svara på säkerhetsincidenter eller avvikelser.

Regelbundna uppdateringar och korrigeringar

- Håll AKS-HCI-klusternoderna och den underliggande infrastrukturen uppdaterade med de senaste säkerhetskorrigeringarna och uppdateringarna.

- Upprätta en korrigeringshanteringsprocess för att säkerställa att säkerhetskorrigeringar tillämpas i rätt tid.

Efterlevnads- och regelöverväganden

- Förstå och följa relevanta branschspecifika säkerhets- och efterlevnadsregler (till exempel HIPAA eller PCI DSS) baserat på organisationens krav.

- Implementera säkerhetskontroller och metoder för att uppfylla de efterlevnadsstandarder som gäller för din bransch.

Kostnadsoptimering

Kostnadsoptimering handlar om att titta på sätt att minska onödiga utgifter och förbättra drifteffektiviteten. Mer information finns i Översikt över kostnadsoptimeringspelare.

Några kostnadsoptimeringsöverväganden för att distribuera Arc-aktiverade tjänster på Azure Stack HCI:

- Storleksanpassa AKS-HCI-klusternoderna korrekt baserat på faktiska arbetsbelastningskrav för att undvika överetablering eller underutnyttjande.

- AKS-HCI Autoscaling hjälper till att optimera resursallokering och minskar kostnaderna under perioder med låg efterfrågan. Konfigurera horisontell autoskalning av poddar (HPA) baserat på mönster för efterfrågan och arbetsbelastning för att automatiskt skala antalet poddar i AKS-HCI-klustret.

- Lagringsoptimering:

- Välj lämpliga lagringsalternativ baserat på dina arbetsbelastningskrav och prestandabehov.

- Överväg att använda Azure Disk Storage för beständiga volymer eller Azure Files för delad fillagring.

- Optimera lagringskonfigurationer, till exempel att justera storleken och typen av diskar baserat på arbetsbelastningskrav.

- Taggning och resursgruppshantering:

- Implementera konsekvent resurstaggning för att spåra och kategorisera resurser.

- Använd resursgrupper för att logiskt organisera resurser, vilket gör det enklare att hantera och spåra kostnader.

- Kontinuerlig kostnadsövervakning och optimering:

- Granska regelbundet kostnadsrapporter och instrumentpaneler som tillhandahålls av Microsoft Cost Management för att identifiera kostnadsbesparande affärsmöjligheter och optimera utgifter.

- Använd verktyg som Azure Advisor för att få rekommendationer för att optimera resursanvändningen, förbättra säkerheten och minska kostnaderna.

- Minska distributions- och underhållsinsatserna med Azure DevOps Services.

Driftsäkerhet

Driftskvalitet omfattar de driftsprocesser som distribuerar ett program och håller det igång i produktion. Mer information finns i Översikt över grundpelare för driftskvalitet.

Prestandaeffektivitet

Prestandaeffektivitet handlar om att effektivt skala arbetsbelastningen baserat på användarnas behov. Mer information finns i Översikt över grundpelare för prestandaeffektivitet.

Den största fördelen med skalning mellan kluster är möjligheten att leverera skalning på begäran med lokala miljöer tillsammans med fullständig kontroll över konfigurationen i organisationens skyddade nätverk.

Deltagare

Den här artikeln underhålls av Microsoft. Det har ursprungligen skrivits av följande medarbetare.

Huvudsakliga författare:

Mayuri Bhavsar | Senior Cloud Solution Architect

Vidya Narasimhan | Huvudarkitekt för molnlösning

Övriga medarbetare:

Himanshu Amodwala | Senior Cloud Solution Architect

Nakul Joshi | Principal Software Engineering Manager

Vineeth Marar | Senior Cloud Solution Architect

Om du vill se icke-offentliga LinkedIn-profiler loggar du in på LinkedIn.

Nästa steg

- Kubernetes-mönster med hög tillgänglighet med Hjälp av Azure och Azure Stack Hub

- Dokumentation om Azure Kubernetes Service (AKS)