Hantera Azure Data Lake Analytics med hjälp av Azure-portalen

Viktigt

Nya Azure Data Lake Analytics-konton kan inte längre skapas om inte prenumerationen har aktiverats. Om du behöver aktivera din prenumeration kontaktar du supporten och anger ditt affärsscenario.

Om du redan använder Azure Data Lake Analytics måste du skapa en migreringsplan för att Azure Synapse Analytics för din organisation senast den 29 februari 2024.

Den här artikeln beskriver hur du hanterar Azure Data Lake Analytics-konton, datakällor, användare och jobb med hjälp av Azure Portal.

Hantera Data Lake Analytics-konton

Skapa ett konto

- Logga in på Azure-portalen.

- Välj Skapa en resurs och sök efter Data Lake Analytics.

- Välj värden för följande objekt:

- Namn: Namnet på Data Lake Analytics-kontot.

- Prenumeration: Den Azure-prenumeration som används för kontot.

- Resursgrupp: Den Azure-resursgrupp där kontot ska skapas.

- Plats: Azure-datacentret för Data Lake Analytics-kontot.

- Data Lake Store: Standardarkivet som ska användas för Data Lake Analytics-kontot. Azure Data Lake Store-kontot och Data Lake Analytics-kontot måste finnas på samma plats.

- Välj Skapa.

Ta bort ett Data Lake Analytics konto

Innan du tar bort ett Data Lake Analytics-konto tar du bort standardkontot för Data Lake Store.

- I Azure Portal går du till ditt Data Lake Analytics-konto.

- Välj Ta bort.

- Ange kontonamnet.

- Välj Ta bort.

Hantera datakällor

Data Lake Analytics stöder följande datakällor:

- Data Lake Store

- Azure Storage

Du kan använda Data Explorer för att bläddra bland datakällor och utföra grundläggande filhanteringsåtgärder.

Lägga till en datakälla

I Azure Portal går du till ditt Data Lake Analytics-konto.

Välj Datautforskaren.

Välj Lägg till datakälla.

- Om du vill lägga till ett Data Lake Store-konto behöver du kontonamnet och åtkomsten till kontot för att kunna köra frågor mot det.

- Om du vill lägga till Azure Blob Storage behöver du lagringskontot och kontonyckeln. Du hittar dem genom att gå till lagringskontot i portalen och välja Åtkomstnycklar.

Konfigurera brandväggsregler

Du kan använda Data Lake Analytics för att ytterligare låsa åtkomsten till ditt Data Lake Analytics-konto på nätverksnivå. Du kan aktivera en brandvägg, ange en IP-adress eller definiera ett IP-adressintervall för dina betrodda klienter. När du har aktiverat dessa mått kan endast klienter som har IP-adresser inom det definierade intervallet ansluta till arkivet.

Om andra Azure-tjänster, till exempel Azure Data Factory eller virtuella datorer, ansluter till Data Lake Analytics-kontot kontrollerar du att Tillåt Azure-tjänster är aktiverat.

Konfigurera en brandväggsregel

- I Azure Portal går du till ditt Data Lake Analytics-konto.

- Välj Brandvägg på menyn till vänster.

Lägga till en ny användare

Du kan använda guiden Lägg till användare för att enkelt skapa nya Data Lake-användare.

- I Azure Portal går du till ditt Data Lake Analytics-konto.

- Till vänster under Komma igång väljer du Guiden Lägg till användare.

- Välj en användare och välj sedan Välj.

- Välj en roll och välj sedan Välj. Om du vill konfigurera en ny utvecklare att använda Azure Data Lake väljer du rollen Data Lake Analytics Utvecklare.

- Välj åtkomstkontrollistorna (ACL:er) för U-SQL-databaserna. När du är nöjd med dina val väljer du Välj.

- Välj ACL:er för filer. Ändra inte ACL:er för rotmappen "/" och för mappen /system för standardarkivet. välj Välj.

- Granska alla markerade ändringar och välj sedan Kör.

- När guiden är klar väljer du Klar.

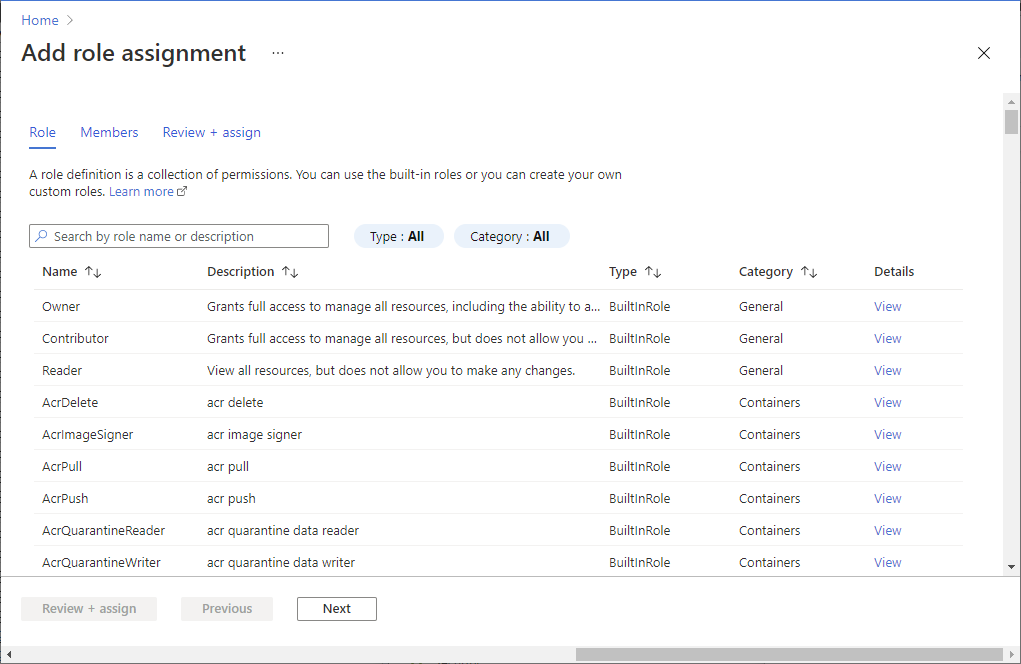

Hantera rollbaserad åtkomstkontroll i Azure

Precis som andra Azure-tjänster kan du använda rollbaserad åtkomstkontroll i Azure (Azure RBAC) för att styra hur användarna interagerar med tjänsten.

Azure-standardrollerna har följande funktioner:

- Ägare: Kan skicka jobb, övervaka jobb, avbryta jobb från valfri användare och konfigurera kontot.

- Deltagare: Kan skicka jobb, övervaka jobb, avbryta jobb från valfri användare och konfigurera kontot.

- Läsare: Kan övervaka jobb.

Använd rollen Data Lake Analytics Developer för att göra det möjligt för U-SQL-utvecklare att använda Data Lake Analytics-tjänsten. Du kan använda rollen Data Lake Analytics Developer för att:

- Skicka jobb.

- Övervaka jobbstatus och förloppet för jobb som skickas av en användare.

- Se U-SQL-skript från jobb som skickas av en användare.

- Avbryt endast dina egna jobb.

Lägga till användare eller säkerhetsgrupper i ett Data Lake Analytics konto

I Azure Portal går du till ditt Data Lake Analytics-konto.

Välj Åtkomstkontroll (IAM) .

Välj Lägg tillLägg till >rolltilldelning för att öppna sidan Lägg till rolltilldelning.

Tilldela en roll till en användare. Läs mer om att tilldela roller i Tilldela Azure-roller via Azure Portal.

Anteckning

Om en användare eller en säkerhetsgrupp behöver skicka jobb behöver de också behörighet för butikskontot. Mer information finns i Skydda data som lagras i Data Lake Store.

Hantera jobb

Skicka ett jobb

I Azure Portal går du till ditt Data Lake Analytics-konto.

Välj Nytt jobb. Konfigurera för varje jobb:

- Jobbnamn: Namnet på jobbet.

- Prioritet: Det här är under Fler alternativ. Lägre tal har högre prioritet. Om två jobb placeras i kö körs det med lägre prioritetsvärde först.

- Organisationsenheter: Det maximala antalet analysenheter eller beräkningsprocesser som ska reserveras för det här jobbet.

- Körning: Även under Fler alternativ. Välj standardkörningen om du inte har fått en anpassad körning.

Lägg till skriptet.

Välj Skicka jobb.

Övervaka jobb

- I Azure Portal går du till ditt Data Lake Analytics-konto.

- Välj Visa alla jobb överst på sidan. En lista över alla aktiva och nyligen slutförda jobb i kontot visas.

- Du kan också välja Filter för att hjälpa dig att hitta jobben efter tidsintervall, status, jobbnamn, jobb-ID, pipelinenamn eller pipeline-ID, upprepningsnamn eller upprepnings-ID och redigeringsvärden .

Övervaka pipelinejobb

Jobb som ingår i en pipeline fungerar tillsammans, vanligtvis sekventiellt, för att åstadkomma ett specifikt scenario. Du kan till exempel ha en pipeline som rensar, extraherar, transformerar, aggregerar användning för kundinsikter. Pipelinejobb identifieras med egenskapen "Pipeline" när jobbet skickades. Jobb som schemalagts med ADF V2 kommer automatiskt att ha den här egenskapen ifylld.

Så här visar du en lista över U-SQL-jobb som ingår i pipelines:

- I Azure Portal går du till dina Data Lake Analytics konton.

- Välj Job Insights. Fliken Alla jobb visas som standard och visar en lista över jobb som körs, köas och avslutas.

- Välj fliken Pipelinejobb . En lista över pipelinejobb visas tillsammans med aggregerad statistik för varje pipeline.

Övervaka återkommande jobb

Ett återkommande jobb är ett jobb som har samma affärslogik men som använder olika indata varje gång det körs. Helst bör återkommande jobb alltid lyckas och ha relativt stabil körningstid. övervakning av dessa beteenden hjälper till att säkerställa att jobbet är felfritt. Återkommande jobb identifieras med egenskapen "Upprepning". Jobb som schemalagts med ADF V2 kommer automatiskt att ha den här egenskapen ifylld.

Så här visar du en lista över U-SQL-jobb som är återkommande:

- I Azure Portal går du till dina Data Lake Analytics konton.

- Välj Job Insights. Fliken Alla jobb visas som standard och visar en lista över jobb som körs, köas och avslutas.

- Välj fliken Återkommande jobb . En lista över återkommande jobb visas tillsammans med aggregerad statistik för varje återkommande jobb.