Api:er för Databricks Foundation-modell

Den här artikeln innehåller en översikt över FOUNDATION Model API:er i Azure Databricks. Den innehåller krav för användning, modeller som stöds och begränsningar.

Vad är Api:er för Databricks Foundation-modell?

Databricks Model Serving har nu stöd för Foundation Model API:er som gör att du kan komma åt och köra frågor mot toppmoderna öppna modeller från en serveringsslutpunkt. Med API:er för Foundation Model kan du snabbt och enkelt skapa program som utnyttjar en generativ AI-modell av hög kvalitet utan att underhålla din egen modelldistribution.

API:erna för Foundation Model finns i två prislägen:

- Betala per token: Det här är det enklaste sättet att börja komma åt grundmodeller på Databricks och rekommenderas för att påbörja din resa med Foundation Model-API:er. Det här läget är inte utformat för program med högt dataflöde eller högpresterande produktionsarbetsbelastningar.

- Etablerat dataflöde: Det här läget rekommenderas för alla produktionsarbetsbelastningar, särskilt de som kräver högt dataflöde, prestandagarantier, finjusterade modeller eller har ytterligare säkerhetskrav. Etablerade dataflödesslutpunkter är tillgängliga med efterlevnadscertifieringar som HIPAA.

Med api:erna för Foundation Model kan du:

- Fråga en generaliserad LLM för att verifiera ett projekts giltighet innan du investerar fler resurser.

- Fråga en generaliserad LLM för att skapa ett snabbt konceptbevis för ett LLM-baserat program innan du investerar i träning och distribuerar en anpassad modell.

- Använd en grundmodell, tillsammans med en vektordatabas, för att skapa en chattrobot med hämtning av utökad generering (RAG).

- Ersätt egna modeller med öppna alternativ för att optimera för kostnader och prestanda.

- Jämför llm-datorer effektivt för att se vilken som är den bästa kandidaten för ditt användningsfall, eller byt ut en produktionsmodell mot en bättre presterande.

- Skapa ett LLM-program för utveckling eller produktion ovanpå en skalbar, SLA-backad LLM-serverlösning som kan stödja dina toppar i produktionstrafiken.

Krav

- Databricks API-token för att autentisera slutpunktsbegäranden.

- Serverlös beräkning (för etablerade dataflödesmodeller).

- En arbetsyta i en region som stöds:

Kommentar

Information om etablerade dataflödesarbetsbelastningar som använder DBRX-basmodellen finns i Api:erna för Foundation Model för regionens tillgänglighet.

Använda FOUNDATION Model-API:er

Du har flera alternativ för att använda API:er för Foundation Model.

API:erna är kompatibla med OpenAI, så du kan till och med använda OpenAI-klienten för att fråga. Du kan också använda användargränssnittet, Foundation Models API:erna Python SDK, MLflow Deployments SDK eller REST-API:et för att fråga efter modeller som stöds. Databricks rekommenderar att du använder MLflow Deployments SDK eller REST API för utökade interaktioner och användargränssnittet för att testa funktionen.

Se Frågegrundsmodeller för bedömningsexempel.

API:er för Foundation-modell för betala per token

Viktigt!

Den här funktionen finns som allmänt tillgänglig förhandsversion.

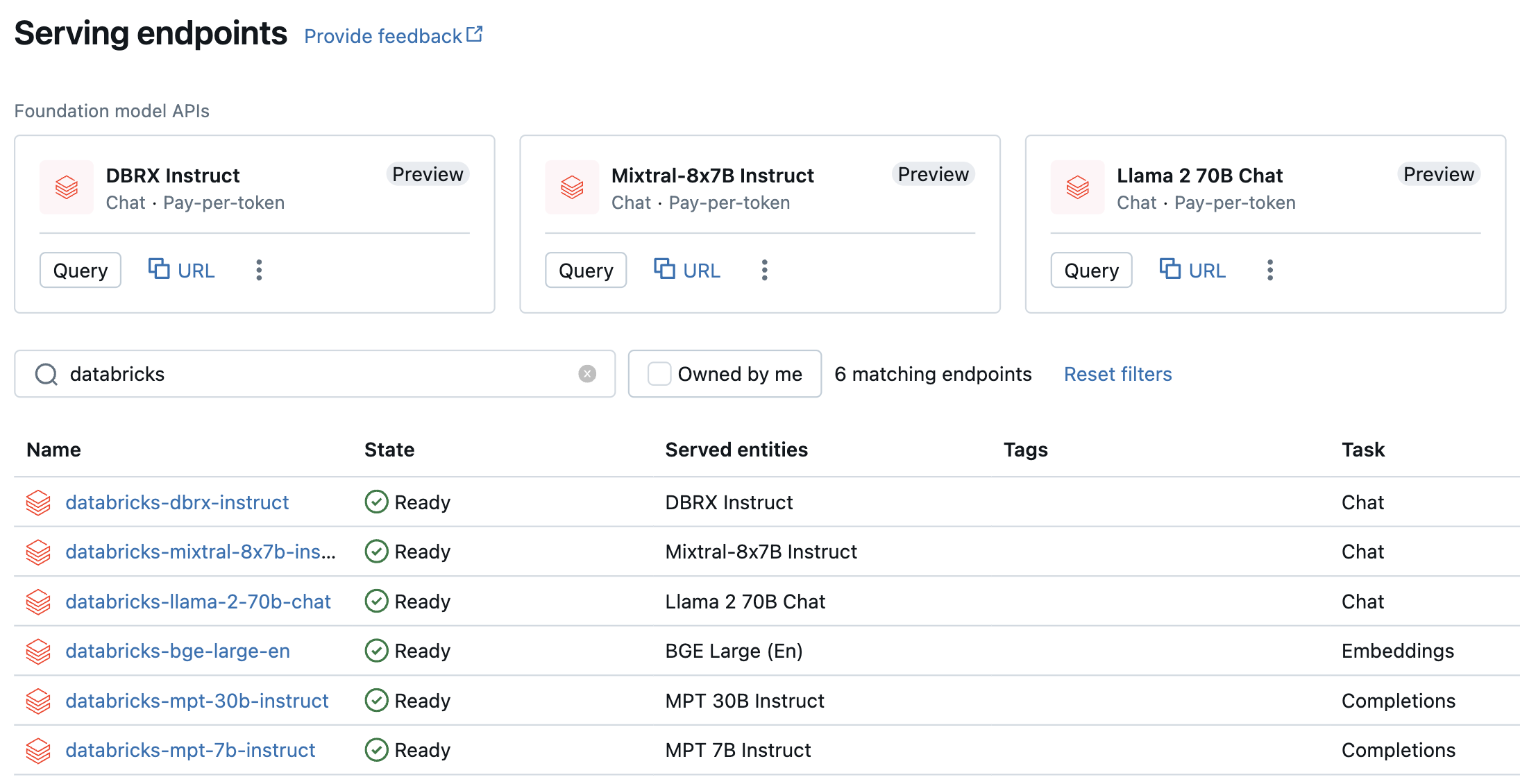

Modeller med betala per token är tillgängliga på din Azure Databricks-arbetsyta och rekommenderas för att komma igång. Om du vill komma åt dem på arbetsytan går du till fliken Servering i det vänstra sidofältet. API:erna för grundmodell finns överst i listvyn Slutpunkter.

I följande tabell sammanfattas de modeller som stöds för betala per token. Mer modellinformation finns i Modeller som stöds för betalning per token .

Om du vill testa och chatta med dessa modeller kan du göra det med hjälp av AI Playground. Se Chatta med LLM:er som stöds med AI Playground.

| Modell | Uppgiftstyp | Slutpunkt |

|---|---|---|

| DBRX-instruktioner | Chatt | databricks-dbrx-instruct |

| Meta-Llama-3-70B-Instruct | Chatt | databricks-meta-llama-3-70b-instruct |

| Meta-Llama-2-70B-Chat | Chatt | databricks-llama-2-70b-chat |

| Mixtral-8x7B Instruct | Chatt | databricks-mixtral-8x7b-instruct |

| MPT 7B-instruktion | Slutförandet | databricks-mpt-7b-instruct |

| MPT 30B-instruktion | Slutförandet | databricks-mpt-30b-instruct |

| BGE Large (engelska) | Inbäddning | databricks-bge-large-en |

- Mer information om hur du kör frågor mot Foundation Model-API:er finns i Frågegrundsmodeller .

- Se Rest API-referens för Foundation-modell för obligatoriska parametrar och syntax.

Api:er för grundmodell för etablerat dataflöde

Etablerat dataflöde är allmänt tillgängligt och Databricks rekommenderar etablerat dataflöde för produktionsarbetsbelastningar. Etablerat dataflöde ger slutpunkter med optimerad slutsatsdragning för grundläggande modellarbetsbelastningar som kräver prestandagarantier. En stegvis guide om hur du distribuerar API:er för Foundation Model i etablerat läge finns i Api:er för etablerad dataflödesmodell.

Stöd för etablerat dataflöde omfattar:

- Basmodeller av alla storlekar, till exempel DBRX Base. Basmodeller kan nås via Databricks Marketplace, eller så kan du ladda ned dem från Hugging Face eller en annan extern källa och registrera dem i Unity-katalogen. Den senare metoden fungerar med alla finjusterade varianter av de modeller som stöds, oavsett vilken finjusteringsmetod som används.

- Finjusterade varianter av basmodeller, till exempel LlamaGuard-7B. Detta inkluderar modeller som är finjusterade på proprietära data.

- Helt anpassade vikter och tokenizers, till exempel de som tränats från grunden eller fortsatt förtränade eller andra varianter med basmodellarkitekturen (till exempel CodeLlama, Yi-34B-Chat eller SOLAR-10.7B).

I följande tabell sammanfattas de modellarkitekturer som stöds för etablerat dataflöde.

| Modellarkitektur | Uppgiftstyper | Kommentar |

|---|---|---|

| DBRX | Chatt eller slutförande | Se Foundation Model-API:er för begränsningar för regiontillgänglighet. |

| Meta Llama 3 | Chatt eller slutförande | |

| Meta Llama 2 | Chatt eller slutförande | |

| Mistral | Chatt eller slutförande | |

| Mixtral | Chatt eller slutförande | |

| MPT | Chatt eller slutförande | |

| BGE v1.5 (engelska) | Inbäddning |

Begränsningar

Se Gränser och regioner för modellservering.