Vad är ansvarsfull AI?

GÄLLER FÖR: Azure CLI ml extension v2 (current)

Azure CLI ml extension v2 (current) Python SDK azure-ai-ml v2 (aktuell)

Python SDK azure-ai-ml v2 (aktuell)

Ansvarsfull artificiell intelligens (ansvarsfull AI) är en metod för att utveckla, utvärdera och distribuera AI-system på ett säkert, tillförlitligt och etiskt sätt. AI-system är resultatet av många beslut som fattas av dem som utvecklar och distribuerar dem. Från systemsyfte till hur människor interagerar med AI-system kan ansvarsfull AI hjälpa till att proaktivt vägleda dessa beslut mot mer fördelaktiga och rättvisa resultat. Det innebär att hålla människor och deras mål i centrum för systemdesignbeslut och respektera bestående värden som rättvisa, tillförlitlighet och transparens.

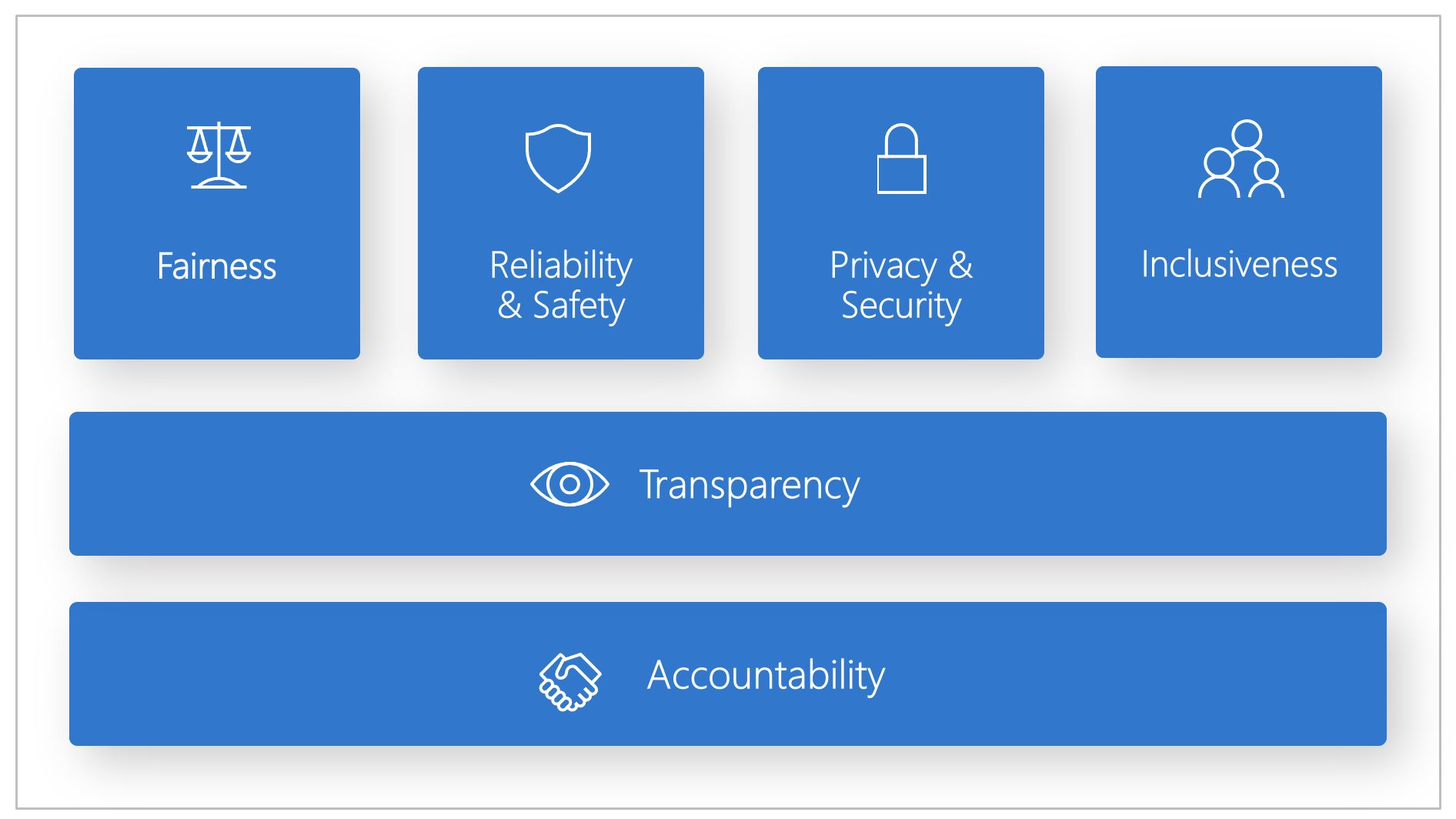

Microsoft har utvecklat en ansvarsfull AI-standard. Det är ett ramverk för att skapa AI-system enligt sex principer: rättvisa, tillförlitlighet och säkerhet, sekretess och säkerhet, inkludering, transparens och ansvarsskyldighet. För Microsoft är dessa principer hörnstenen i en ansvarsfull och pålitlig metod för AI, särskilt som intelligent teknik blir vanligare i produkter och tjänster som människor använder varje dag.

Den här artikeln visar hur Azure Mašinsko učenje stöder verktyg för att göra det möjligt för utvecklare och dataforskare att implementera och operationalisera de sex principerna.

Rättvisa och inkludering

AI-system bör behandla alla rättvist och undvika att påverka grupper av personer på liknande platser på olika sätt. När AI-system till exempel ger vägledning om medicinsk behandling, låneansökningar eller anställning bör de ge samma rekommendationer till alla som har liknande symtom, ekonomiska omständigheter eller yrkeskvalifikationer.

Rättvisa och inkludering i Azure Mašinsko učenje: Komponenten för rättvisebedömning i instrumentpanelen ansvarsfull AI gör det möjligt för dataforskare och utvecklare att bedöma modellens rättvisa mellan känsliga grupper som definieras när det gäller kön, etnicitet, ålder och andra egenskaper.

Tillförlitlighet och säkerhet

För att skapa förtroende är det viktigt att AI-system fungerar tillförlitligt, säkert och konsekvent. Dessa system bör kunna fungera som de ursprungligen utformades, svara på oväntade förhållanden på ett säkert sätt och motstå skadlig manipulering. Hur de beter sig och de olika villkor som de kan hantera återspeglar de olika situationer och omständigheter som utvecklare förväntade sig under design och testning.

Tillförlitlighet och säkerhet i Azure Mašinsko učenje: Komponenten för felanalys i instrumentpanelen ansvarsfull AI gör det möjligt för dataforskare och utvecklare att:

- Få en djup förståelse för hur fel distribueras för en modell.

- Identifiera kohorter (delmängder) av data med en högre felfrekvens än det övergripande riktmärket.

Dessa avvikelser kan inträffa när systemet eller modellen underpresterar för specifika demografiska grupper eller för sällan observerade indataförhållanden i träningsdata.

Transparency

När AI-system hjälper till att informera beslut som har en enorm inverkan på människors liv är det viktigt att människor förstår hur dessa beslut fattades. En bank kan till exempel använda ett AI-system för att avgöra om en person är kreditvärdig. Ett företag kan använda ett AI-system för att fastställa de mest kvalificerade kandidaterna att anställa.

En viktig del av transparensen är tolkning: den användbara förklaringen av beteendet hos AI-system och deras komponenter. För att förbättra tolkningen måste intressenterna förstå hur och varför AI-system fungerar som de gör. Intressenterna kan sedan identifiera potentiella prestandaproblem, rättvisefrågor, exkluderingsmetoder eller oavsiktliga resultat.

Transparens i Azure Mašinsko učenje: Modelltolkning och kontrafaktiska konsekvenskomponenter i instrumentpanelen ansvarsfull AI gör det möjligt för dataforskare och utvecklare att generera begripliga beskrivningar av förutsägelserna för en modell.

Modelltolkningskomponenten innehåller flera vyer i en modells beteende:

- Globala förklaringar. Vilka funktioner påverkar till exempel det övergripande beteendet för en låneallokeringsmodell?

- Lokala förklaringar. Varför godkändes eller avvisades till exempel en kunds låneansökan?

- Modellförklaringar för en vald kohort av datapunkter. Vilka funktioner påverkar till exempel det övergripande beteendet för en låneallokeringsmodell för låginkomstsökande?

Den kontrafaktiska konsekvenskomponenten gör det möjligt att förstå och felsöka en maskininlärningsmodell när det gäller hur den reagerar på funktionsändringar och störningar.

Azure Mašinsko učenje stöder också ett ansvarsfullt AI-styrkort. Styrkortet är en anpassningsbar PDF-rapport som utvecklare enkelt kan konfigurera, generera, ladda ned och dela med sina tekniska och icke-tekniska intressenter för att utbilda dem om deras datauppsättningar och modellers hälsa, uppnå efterlevnad och skapa förtroende. Det här styrkortet kan också användas i granskningsgranskningar för att upptäcka egenskaperna hos maskininlärningsmodeller.

Sekretess och säkerhet

I takt med att AI blir vanligare blir det allt viktigare och mer komplext att skydda sekretess och personlig information och affärsinformation. Med AI kräver sekretess och datasäkerhet stor uppmärksamhet eftersom åtkomst till data är viktigt för ATT AI-system ska kunna göra korrekta och välgrundade förutsägelser och beslut om människor. AI-system måste följa sekretesslagar som:

- Kräv transparens om insamling, användning och lagring av data.

- Ge konsumenterna rätt kontroller för att välja hur deras data ska användas.

Sekretess och säkerhet i Azure Mašinsko učenje: Med Azure Mašinsko učenje kan administratörer och utvecklare skapa en säker konfiguration som uppfyller företagets principer. Med Azure Mašinsko učenje och Azure-plattformen kan användarna:

- Begränsa åtkomsten till resurser och åtgärder per användarkonto eller grupp.

- Begränsa inkommande och utgående nätverkskommunikation.

- Kryptera data under överföring och i vila.

- Sök efter sårbarheter.

- Tillämpa och granska konfigurationsprinciper.

Microsoft har också skapat två paket med öppen källkod som kan möjliggöra ytterligare implementering av sekretess- och säkerhetsprinciper:

SmartNoise: Differentiell sekretess är en uppsättning system och metoder som hjälper till att hålla enskilda personers data säkra och privata. I maskininlärningslösningar kan differentiell sekretess krävas för regelefterlevnad. SmartNoise är ett projekt med öppen källkod (samutvecklat av Microsoft) som innehåller komponenter för att skapa differentiellt privata system som är globala.

Motanpassning: Counterfit är ett projekt med öppen källkod som består av ett kommandoradsverktyg och ett allmänt automatiseringslager som gör det möjligt för utvecklare att simulera cyberattacker mot AI-system. Vem som helst kan ladda ned verktyget och distribuera det via Azure Cloud Shell för att köra det i en webbläsare eller distribuera det lokalt i en Anaconda Python-miljö. Den kan utvärdera AI-modeller som finns i olika molnmiljöer, lokalt eller i gränsen. Verktyget är oberoende för AI-modeller och stöder olika datatyper, inklusive text, bilder eller allmänna indata.

Ansvar

De personer som utformar och distribuerar AI-system måste vara ansvariga för hur deras system fungerar. Organisationer bör utnyttja branschstandarder för att utveckla ansvarsnormer. Dessa normer kan säkerställa att AI-system inte är den slutliga auktoriteten för beslut som påverkar människors liv. De kan också se till att människor har meningsfull kontroll över annars mycket autonoma AI-system.

Ansvarstagande i Azure Mašinsko učenje: Maskininlärningsåtgärder (MLOps) baseras på DevOps-principer och metoder som ökar effektiviteten i AI-arbetsflöden. Azure Mašinsko učenje tillhandahåller följande MLOps-funktioner för bättre ansvarsskyldighet för dina AI-system:

- Registrera, paketera och distribuera modeller var som helst. Du kan också spåra de associerade metadata som krävs för att använda modellen.

- Samla in styrningsdata för maskininlärningslivscykeln från slutpunkt till slutpunkt. Den loggade ursprungsinformationen kan omfatta vem som publicerar modeller, varför ändringar har gjorts och när modeller har distribuerats eller använts i produktion.

- Meddela och varna om händelser i maskininlärningslivscykeln. Exempel är slutförande av experiment, modellregistrering, modelldistribution och identifiering av dataavvikelser.

- Övervaka program för driftsproblem och problem som rör maskininlärning. Jämför modellindata mellan träning och slutsatsdragning, utforska modellspecifika mått och tillhandahålla övervakning och aviseringar i maskininlärningsinfrastrukturen.

Förutom MLOps-funktionerna skapar styrkortet ansvarsfull AI i Azure Mašinsko učenje ansvar genom att möjliggöra kommunikation mellan intressenter. Styrkortet skapar också ansvar genom att ge utvecklare möjlighet att konfigurera, ladda ned och dela sina hälsoinsikter för modellen med sina tekniska och icke-tekniska intressenter om AI-data och modellhälsa. Genom att dela dessa insikter kan du skapa förtroende.

Maskininlärningsplattformen möjliggör också beslutsfattande genom att informera affärsbeslut genom att:

- Datadrivna insikter för att hjälpa intressenter att förstå orsakssambandseffekter på ett resultat, endast med hjälp av historiska data. Till exempel, "Hur skulle ett läkemedel påverka en patients blodtryck?" Dessa insikter tillhandahålls via komponenten kausal slutsatsdragning i instrumentpanelen ansvarsfull AI.

- Modelldrivna insikter för att besvara användarnas frågor (till exempel "Vad kan jag göra för att få ett annat resultat än din AI nästa gång?") så att de kan vidta åtgärder. Sådana insikter ges till dataforskare via den kontrafaktiska konsekvenskomponenten i instrumentpanelen ansvarsfull AI.

Nästa steg

- Mer information om hur du implementerar ansvarsfull AI i Azure Mašinsko učenje finns på instrumentpanelen för ansvarsfull AI.

- Lär dig hur du genererar instrumentpanelen ansvarsfull AI via CLI och SDK eller Azure Mašinsko učenje Studio UI.

- Lär dig hur du genererar ett ansvarsfullt AI-styrkort baserat på de insikter som observerats på instrumentpanelen för ansvarsfull AI.

- Lär dig mer om ansvarsfull AI-standard för att skapa AI-system enligt sex viktiga principer.