Not

Åtkomst till denna sida kräver auktorisation. Du kan prova att logga in eller byta katalog.

Åtkomst till denna sida kräver auktorisation. Du kan prova att byta katalog.

Anmärkning

Fabric Runtime 2.0 är för närvarande i en experimentell förhandsversionsfas. Mer information finns i begränsningarna och anteckningarna.

Fabric Runtime levererar sömlös integrering i Microsoft Fabric-ekosystemet och erbjuder en robust miljö för datateknik och datavetenskapsprojekt som drivs av Apache Spark.

Den här artikeln introducerar Fabric Runtime 2.0 Experimental (förhandsversion), den senaste körningen som är utformad för stordataberäkningar i Microsoft Fabric. Den belyser de viktigaste funktionerna och komponenterna som gör den här versionen till ett viktigt steg framåt för skalbar analys och avancerade arbetsbelastningar.

Fabric Runtime 2.0 innehåller följande komponenter och uppgraderingar som är utformade för att förbättra dina databehandlingsfunktioner:

- Apache Spark 4.0

- Operativsystem: Azure Linux 3.0 (Mariner 3.0)

- Java: 21

- Scala: 2.13

- Python: 3.12

- Delta lake: 4.0

Aktivera Runtime 2.0

Du kan aktivera Runtime 2.0 på antingen arbetsytenivå eller miljöobjektnivå. Använd arbetsyteinställningen för att tillämpa Runtime 2.0 som standard för alla Spark-arbetsbelastningar på din arbetsyta. Du kan också skapa ett miljöobjekt med Runtime 2.0 som ska användas med specifika notebook-filer eller Spark-jobbdefinitioner, vilket åsidosätter standardinställningen för arbetsytan.

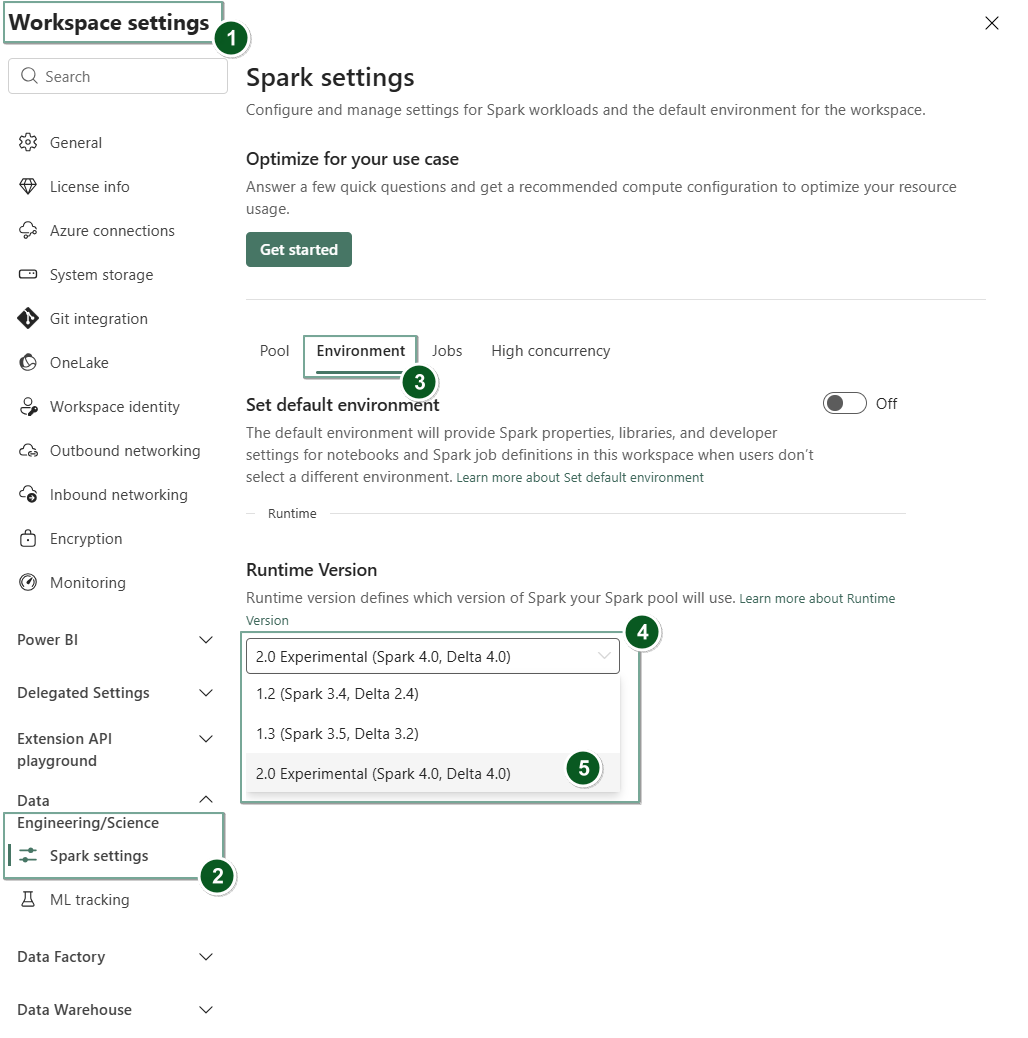

Aktivera Runtime 2.0 i arbetsyteinställningar

Så här anger du Runtime 2.0 som standard för hela arbetsytan:

Gå till fliken Inställningar för arbetsyta i arbetsytan Infrastruktur.

Gå till fliken Datateknik/vetenskap och välj Spark-inställningar.

Välj fliken Miljö.

Under listrutan Körningsversion väljer du 2.0 Experimental (Spark 4.0, Delta 4.0) och sparar ändringarna. Den här åtgärden anger Runtime 2.0 som standardmiljö för din arbetsyta.

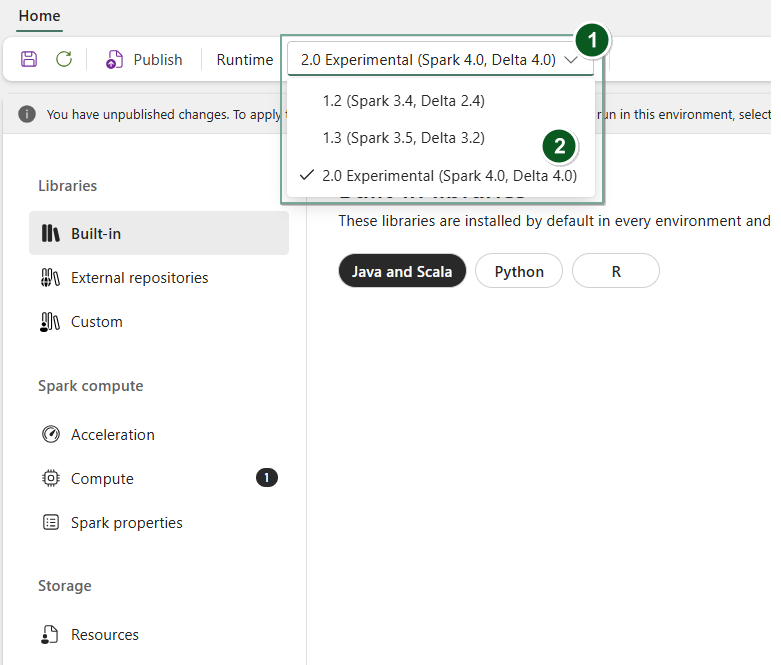

Aktivera Runtime 2.0 i ett miljöobjekt

För att använda Runtime 2.0 med specifika anteckningsböcker eller Spark-jobbdefinitioner:

Skapa ett nytt miljöobjekt eller öppna och befintligt.

Under listrutan Körning väljer du 2.0 Experimental (Spark 4.0, Delta 4.0)

SaveochPublishdina ändringar.Viktigt!

Det kan ta cirka 2–5 minuter innan Spark 2.0-sessioner startas eftersom startpooler inte ingår i den tidiga experimentella versionen.

Sedan kan du använda det här miljöobjektet med ditt

NotebookellerSpark Job Definition.

Nu kan du börja experimentera med de senaste förbättringarna och funktionerna som introducerades i Fabric Runtime 2.0 (Spark 4.0 och Delta Lake 4.0).

Experimentell offentlig förhandsversion

Den experimentella förhandsversionen av Fabric Runtime 2.0 ger dig tidig åtkomst till nya funktioner och API:er från både Spark 4.0 och Delta Lake 4.0. Med förhandsversionen kan du använda de senaste Spark-baserade förbättringarna direkt, vilket säkerställer en smidig beredskap och övergång för framtida ändringar som nyare Java-, Scala- och Python-versioner.

Tips/Råd

För uppdaterad information, en detaljerad lista över ändringar och specifika viktig information för Fabric-körningar, kontrollerar och prenumererar du på Spark Runtimes-versioner och -uppdateringar.

Begränsningar och anteckningar

Fabric Runtime 2.0 är för närvarande i en experimentell offentlig förhandsversion som är utformad för användare att utforska och experimentera med de senaste funktionerna och API:erna från Spark och Delta Lake i utvecklings- eller testmiljöerna. Även om den här versionen ger åtkomst till kärnfunktioner finns det vissa begränsningar:

Du kan använda Spark 4.0-sessioner, skriva kod i notebook-filer, schemalägga Spark-jobbdefinitioner och använda med PySpark, Scala och Spark SQL. R-språket stöds dock inte i den här tidiga versionen.

Du kan installera bibliotek direkt i koden med pip och conda. Du kan ange Spark-inställningar via %%configure-parametrar i notebooks och Spark-jobbdefinitioner (SJD).

Du kan läsa och skriva till Lakehouse med Delta Lake 4.0, men vissa avancerade funktioner som V-order, native Parquet-skrivning, autokompaction, skrivoptimering, sammanslagningsprocess med låg omfördelning, merge, schemautveckling och tidsresor ingår inte i den här tidiga versionen.

Spark Advisor är för närvarande inte tillgänglig. Övervakningsverktyg som Spark-användargränssnitt och loggar stöds dock i den här tidiga versionen.

Funktioner som Data Science-integreringar inklusive Copilot och anslutningsappar som Kusto, SQL Analytics, Cosmos DB och MySQL Java Connector stöds för närvarande inte i den här tidiga versionen. Data science-bibliotek stöds inte i PySpark-miljöer. PySpark fungerar bara med en grundläggande Conda-installation, som inkluderar PySpark ensamt utan extra bibliotek.

Integreringar med miljöobjekt och Visual Studio Code stöds inte i den här tidiga versionen.

Det stöder inte läsning och skrivning av data till Azure Storage-konton för allmänt ändamål v2 (GPv2) som använder WASB- eller ABFS-protokollen.

Anmärkning

Dela din feedback om Fabric Runtime på idéplattformen. Se till att nämna den version och versionsfas som du refererar till. Vi värdesätter feedback från communityn och prioriterar förbättringar baserat på röster, så att vi uppfyller användarnas behov.

Viktiga höjdpunkter

Apache Spark 4.0

Apache Spark 4.0 markerar en viktig milstolpe som den första versionen i 4.x-serien, som förkroppsligar den samlade ansträngningen i den livliga communityn med öppen källkod.

I den här versionen är Spark SQL avsevärt berikat med kraftfulla nya funktioner som är utformade för att öka uttryckskraften och mångsidigheten för SQL-arbetsbelastningar, till exempel stöd för VARIANT-datatyp, användardefinierade SQL-funktioner, sessionsvariabler, pipe-syntax och strängsortering. PySpark ser ett kontinuerligt engagemang för både dess funktionella bredd och den övergripande utvecklarupplevelsen, vilket ger ett inbyggt api för plottning, ett nytt API för Python-datakälla, stöd för Python-UDF:er och enhetlig profilering för PySpark-UDF:er, tillsammans med många andra förbättringar. Strukturerad strömning utvecklas med viktiga tilläggsfunktioner som ger bättre kontroll och enklare felsökning, särskilt införandet av det godtyckliga tillstånds-API v2 för mer flexibel tillståndshantering och State Data Source för enklare felsökning.

Du kan kontrollera hela listan och detaljerade ändringar här: https://spark.apache.org/releases/spark-release-4-0-0.html.

Anmärkning

I Spark 4.0 är SparkR inaktuellt och kan tas bort i en framtida version.

Delta lake 4.0

Delta Lake 4.0 markerar ett gemensamt åtagande att göra Delta Lake samverkande mellan format, enklare att arbeta med och mer högpresterande. Delta 4.0 är en milstolpeversion fullspäckad med kraftfulla nya funktioner, prestandaoptimeringar och grundläggande förbättringar för framtiden för öppna datasjöhus.

Du kan kontrollera hela listan och detaljerade ändringar som introduceras med Delta Lake 3.3 och 4.0 här: https://github.com/delta-io/delta/releases/tag/v3.3.0. https://github.com/delta-io/delta/releases/tag/v4.0.0.

Viktigt!

Delta Lake 4.0-specifika funktioner är experimentella och fungerar bara med Spark-upplevelser, till exempel notebook-filer och Spark-jobbdefinitioner. Om du behöver använda samma Delta Lake-tabeller i flera Microsoft Fabric-arbetsbelastningar ska du inte aktivera dessa funktioner. Mer information om vilka protokollversioner och funktioner som är kompatibla för alla Microsoft Fabric-upplevelser finns i Delta Lake-tabellformatets samverkan.

Relaterat innehåll

- Apache Spark-miljöer i Fabric – översikt, versionshantering och stöd för flera körmiljöer

- Migreringsguide för Spark Core

- Migreringsguider för SQL, datauppsättningar och DataFrame

- Migreringsguide för strukturerad direktuppspelning

- Migreringsguide för MLlib (Machine Learning)

- Migreringsguide för PySpark (Python på Spark)

- Migreringsguide för SparkR (R on Spark)